Azure Machine Learningの新機能「Prompt flow」を試したい方への解説記事です。

※この領域は変化が激しいです。内容は23年7月6日時点の情報となります

【本記事に関する前提知識】

・AzureMLサービスを使ったことがある

・AzureOpenAIサービスを使ったことがある

【記事の目次】

・準備その1:AzureOpenAIサービスでOpenAIのデプロイをしておく

・準備その2:Azure ML Studioとコンピューティングリソース作る

・準備その3:Azure ML Studioからプロンプトフローから「接続」を選択し、AzureOpenAIサービスと接続

・プロンプトフローから「フロー」を選択し「作成」。ギャラリーからお手本にしたいものを選ぶ(Chat With Wikipediaを本記事では使用)

・プロンプトフローのパラメータ、接続LLMを設定

・プロンプトフローを実行してみる

公式ドキュメント(英語)

準備その1:AzureOpenAIサービスでOpenAIのデプロイをしておく

AzureOpenAIスタジオで、「gpt-35-turbo」 のデプロイを作成しておいてください(gpt-3でも大丈夫かもしれませんが、35-turboで動作を確認しました)。

AzureOpenAIサービス以外に、直接OpenAIのAPIなども利用可能ですが、本記事ではAzureOpenAIを使用する手順で解説を進めます。

そして、「ChatGPT プレイグラウンド (プレビュー)」を開いておいて下さい。

のちほど、ここから接続情報を取得します。

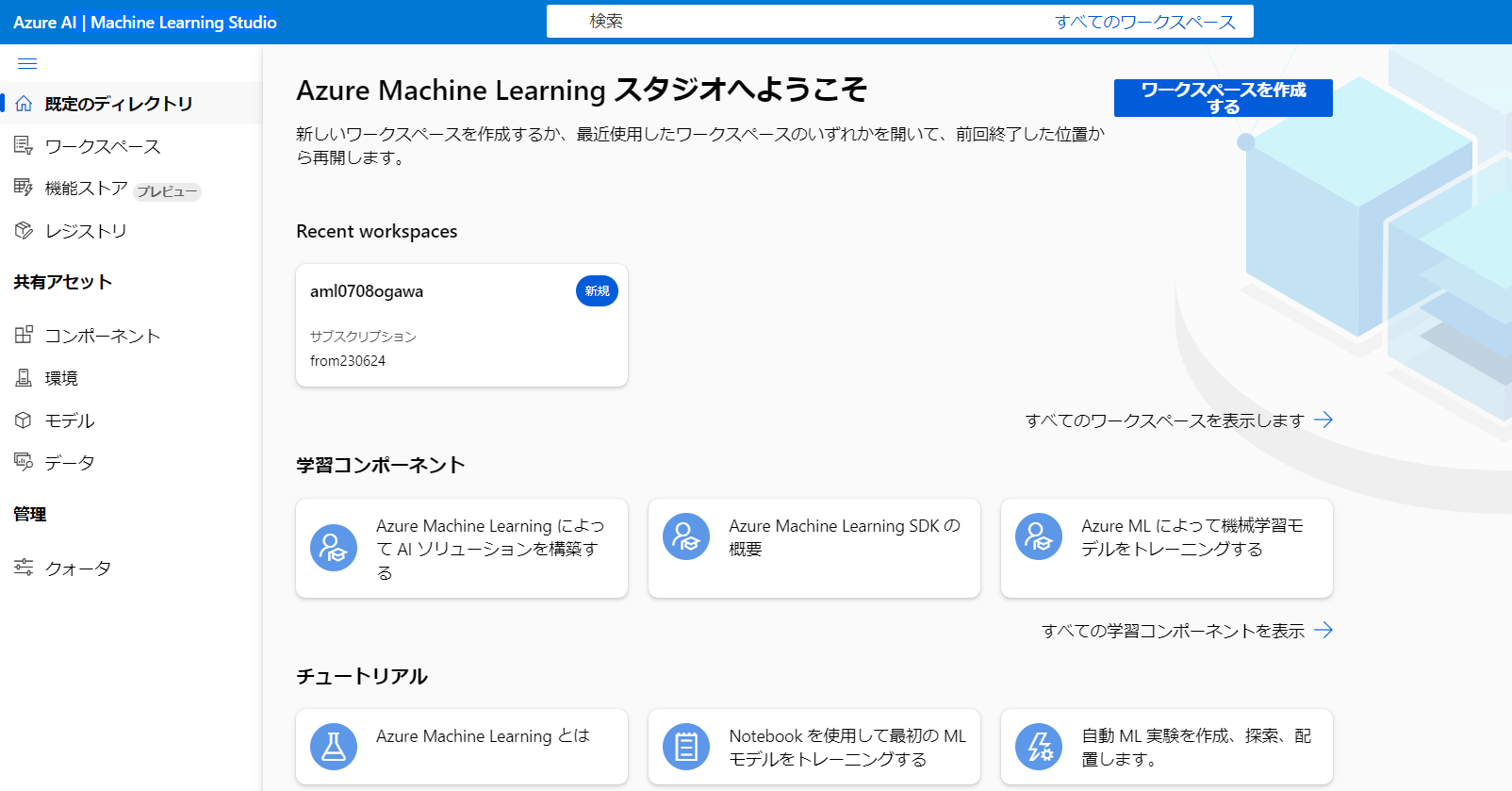

準備その2:Azure ML Studioとコンピューティングリソース作る

Azureポータル上で、「Azure MachineLearning」のリソースを作成し、Azure Machine Learning Studioを開きます

「ワークスペース」に入り、「管理」> 「コンピューティング」から、「コンピューティングインスタンス」を作成しておいてください。

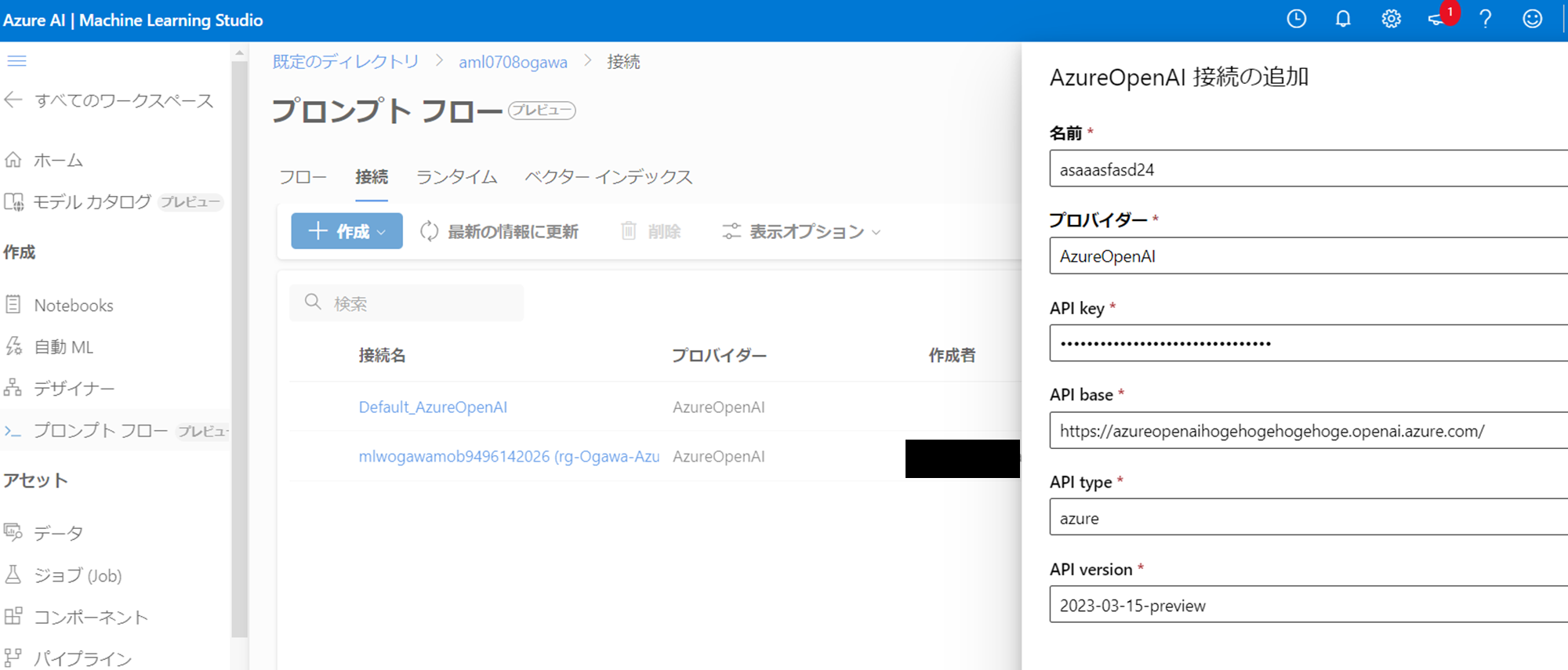

準備その3:Azure ML Studioからプロンプトフローから「接続」を選択し、AzureOpenAIサービスと接続

Azure Machine Learning Studioの左側メニューの「プロンプトフロー」を選択します。

そして、上部メニューの「接続」を選びます。

次に青い「作成」ボタンをクリックします。

OpenAIやAzureOpenAIなど、どのLLM(大規模言語モデル)のAPIを使用するのかを選択します。

本記事では「AzureOpenAI」を選択します。

すると以下のような、「名前」、「プロバイダー(これはAzureOpenAIのまま)」、「API Key」、「API base」、「API type」、「API version」を設定する画面になります。

準備で開いたAzureOpenAIスタジオで、「チャット セッション」の「コードの表示」をクリックします。

以下のように、「API base」、「API type」、「API version」が上側に表示されるので、その内容を書き込みます。

「API Key」は画面下側からコピーできます。

なお、「名前」はなんでも、自由に設定できます。

内容を入力すると、以下のような感じになります。

これで「作成」することで、「接続」に設定した新たな接続が追加されます。

「Prompt flow」のLLM部分はこの接続先を使用します。

なお、フロー内のPythonなどでの処理部分は、作成したコンピューティングインスタンスで処理されます。

プロンプトフローから「フロー」を選択し「作成」。ギャラリーからお手本にしたいものを選ぶ(Chat With Wikipediaを本記事では使用)

準備が完了したので、早速左側メニューの「プロンプトフロー」を選択し、上部メニューの「フロー」から、青い「+作成」ボタンをクリックします。

いろいろと作成内容が提案されますが、最初は、「ギャラリーから作成する」を選択し、構築済みの「Prompt flow」を動かしてみるのが良いでしょう。

本記事では、「Chat With Wikipedia」 を選択します。

「詳細の表示」をクリックし、「複製」をクリックします。

プロンプトフローのパラメータ、接続LLMを設定

「複製」をクリックすると、以下のような画面が表示されます。

右側にLLM処理とPython処理のフロー図、左側には各ブロックの内容が記載されています。

今回の「Chat With Wikipedia」の場合は、LLM処理が2箇所あり、そこに先ほど作成した「LLMの接続」を記載して、実行できるようにします。

また、上部「ランタイム」欄に、コンピューティングインスタンスも指定します。

次にフローのLLMブロックの「接続」を設定します。

最初に作成したDeployモデルと、プロンプトフローで設定した接続を選択して、以下のように設定します。

「Chat With Wikipedia」の場合は、LLM処理が2箇所あるので、下側でも同様に設定します。

設定が終われば、右上の「保存」をクリックします。

プロンプトフローを実行してみる

以上で「Chat With Wikipedia」のPrompt flowが使用できる状態になったので、実行してみます。

今回はテストとして簡易的に、画面右上の青い「チャット」ボタンをクリックしてください。

以下は「7月7日は何の日ですか」と尋ねてみた結果です。

Wikipediaからの要約が返ってくるとともに、引用元(さんしょうもと)のページリンクが記載されています

※うまく回答が返ってこない場合、一度、フロー一覧の画面に戻り、Chat With Wikipediaを再度選択して、「チャット」ボタンをクリックし、質問を再度実行してみてください

以上で、Azure Machine Learning「Prompt flow」(プロンプトフロー)をひとまず実行することができました。

さいごに

以上、簡単にでしたが、Azure ML Prompt flowの実行方法の解説でした。

所感としては、ギャラリーに現在5つほどflowの例があり、これを見ることで、

・LLMとPython処理をどのように組み合わせてシステムを構築する流れ

・どんなプロンプトを使用したり、どのようなPython処理を実装するのか

の具体例が学べるのが嬉しいです。

また、「Azure ML Prompt flow」「プロンプト」部分と「Python処理」部分とが逐次的に混ざる、LLMアプリの作成にも使いやすそうに感じました。

ただしこの点は、実際どこまで複雑なアプリ(フロー)がこのGUIベースで作成できるのかは不明です。

個人的には割とカバーできる範囲は広そうな気がしました。

(※最後に起動中のコンピューティングインスタンスをシャットダウンするのを忘れないように気をつけてください)

以上、ご一読いただき、ありがとうございました。

小川 雄太郎

【免責】

本記事の内容は執筆者の意見/発信であり、執筆者が属する企業等の公式見解ではございません