はじめに

既に試してみたことある人もいると思いますが、Copilot Studio で一括テストする機能を触ってみたので、備忘のため記事にしておきます。

まず、Copilot Studio では、従来から作りながらテストをすることができました。ただし、色々な質問でテストしたい場合、一つ一つチャットに入力する必要があり、数が多い場合、手間がかかっていました。

そのため、一括でテストする方法のニーズがあり、以前から以下のキット等で実現可能でした。しかし、市民開発者の方からするとライセンス面含めややハードルが高かったです。

そして、嬉しいことに、標準機能として、一括テストする機能が実装されました。以下、試してみたことです。

試してみたこと

まず、以下のメニューから新しい評価を選択します。

テストケースの作成方法がいくつかあります。

個人的には、CSV ファイルをアップロードするか、ナレッジから自動で作成する方法が使えそうな印象です。

以下は、ナレッジソースからの作成方法です。

生成すると、自動で想定質問を作成してくれます。

手動で追加も可能です。

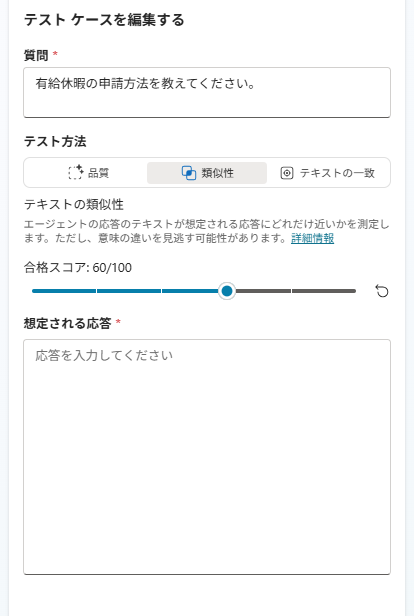

それぞれの質問に対する回答の品質を評価する方法 (テスト方法) は複数あります。既定の [品質] の場合、想定回答を入れなくても評価してくれるようです。

詳細は以下の記事を参照ください。

[類似性]、[テキストの一致] を選択した場合は、想定回答を入力して、そちらと比較するようです。一語一句同じにはならないと思うので、その点を踏まえてスコアの調整をするなどして評価するのがよいと思います。

※個人的に、テキスト完全一致は AI の応答の評価方法としては相性悪い気がします

一旦、[評価] ボタンを押してそのままテストしてみます。こんな感じで、AI が回答の品質を評価してくれます。

ただ、[類似性]、[テキストの一致] を選択した場合、想定回答を一つずつ入れるのは少し大変かもしれません。

この場合は、CSV アップロードするのがよいと思います。

こちらは、まず、以下の方法でテンプレートをダウンロードします。

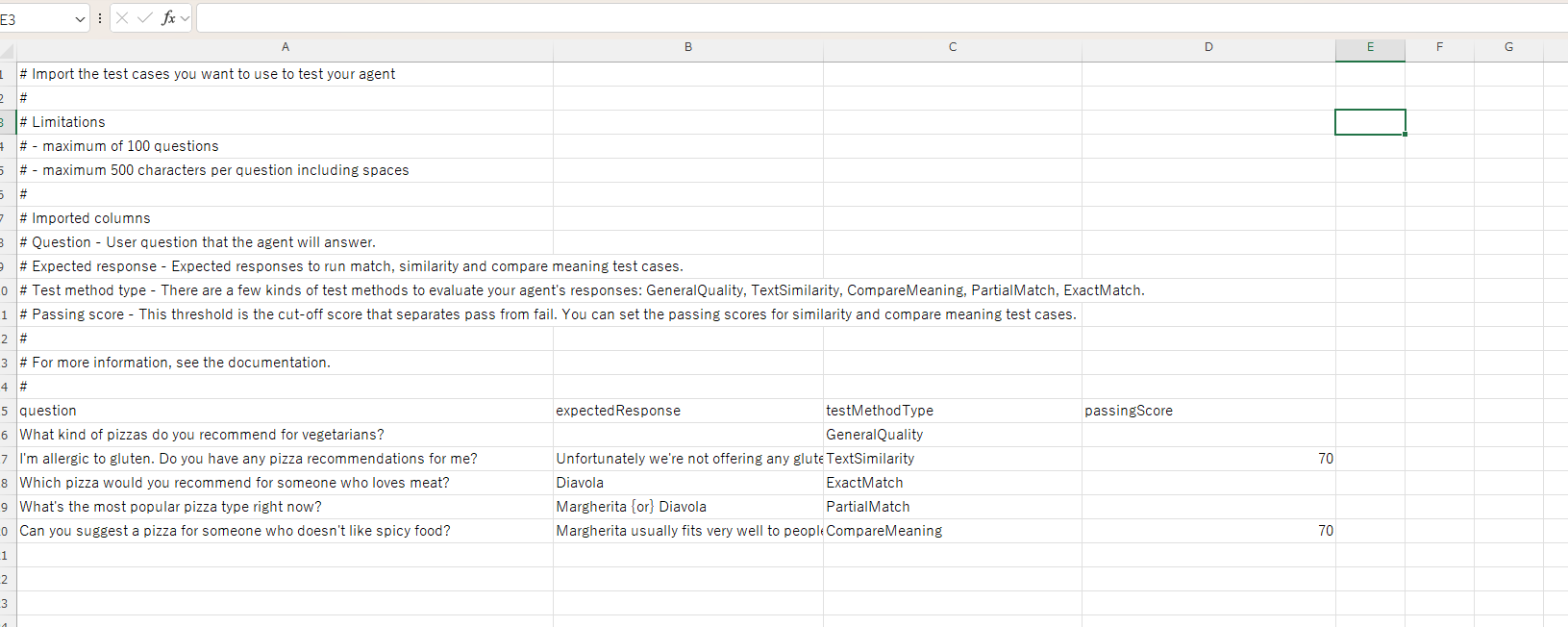

以下のようなファイルになっています。

想定質問 (question)、想定回答 (expectedResponse)、testMethodType、passingScore の列を以下のようにしてみます。

testMethodType に入れる値は以下も参考になります。今回は、既定で入っていたものから、「TextSimilarity」が、類似性を意味すると判断しています。

上記方法で作成したファイルをアップロードいたします。

以下のように文字化けしてしまう場合があります。文字コードが合っていないようなため、一度メモ帳で開いて、エンコードを「UTF-8 (BOM 付き)」で保存しなおします。

上手くアップロードできました。

そのまま [評価] ボタンを押して結果を確認してみます。

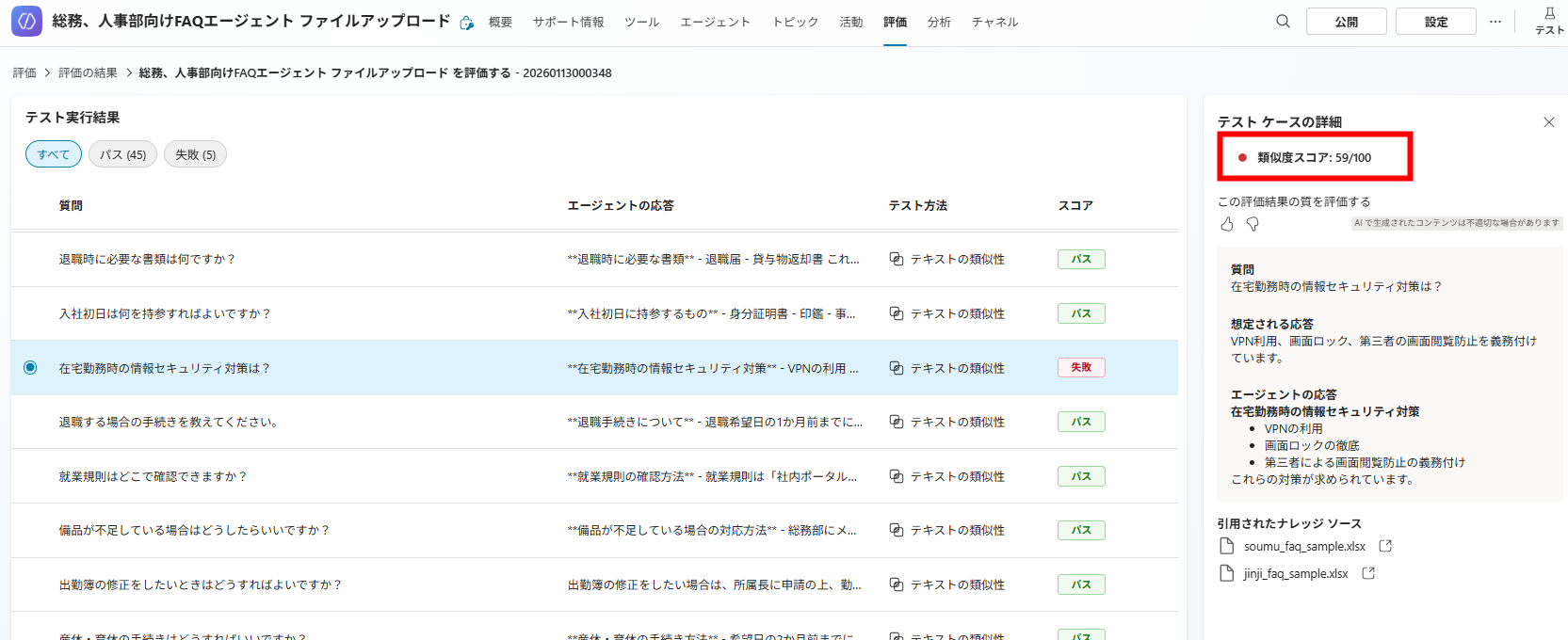

こんな感じで評価されるようです。まず、全体の評価結果が確認できます。

一つ一つの質問について、以下のような感じでスコア化されます。

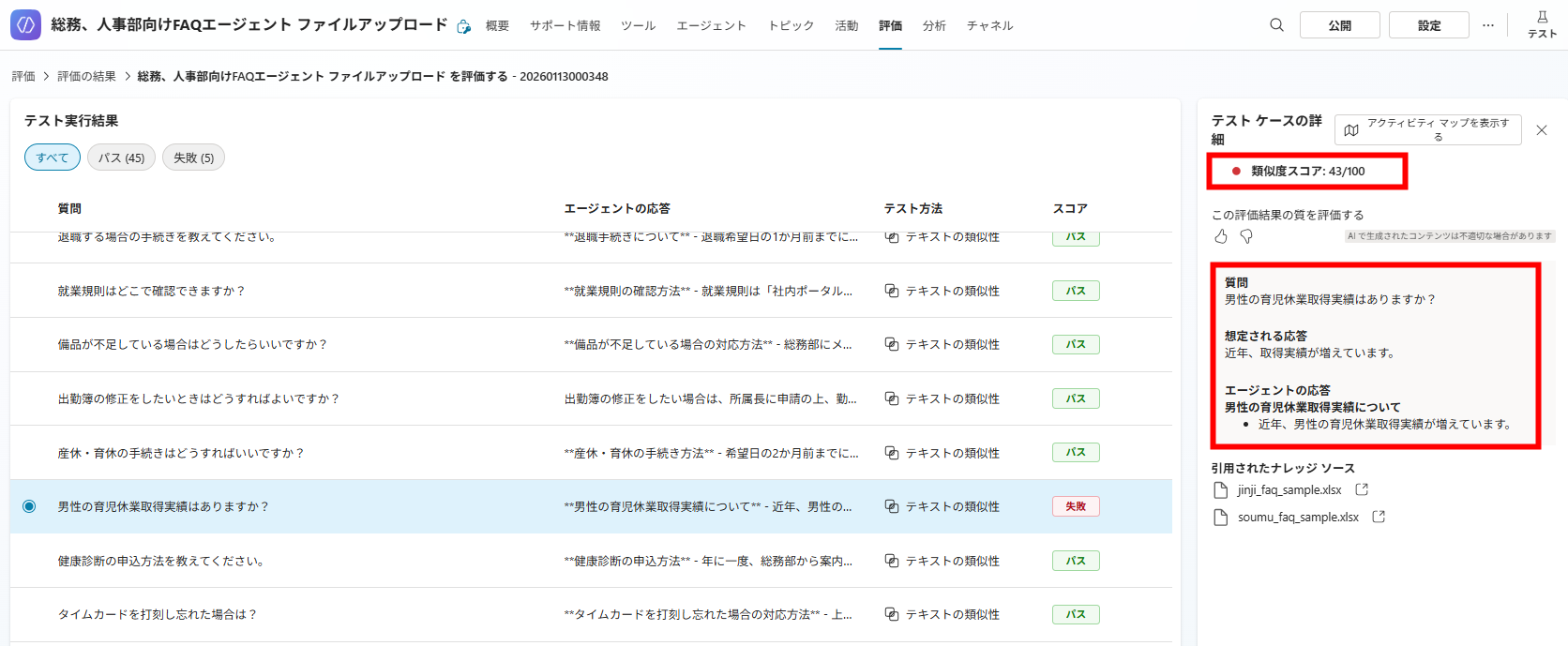

失敗となっているものも見てみます。こちらを見ると、それほどずれいているわけではなさそうです。そのため、スコアについてはもう少し下げてもいいかもしれません。

また、別件でやってみた際は、ある程度回答としては問題なさそうでも、失敗扱いになるため、「TextSimilarity」は使い勝手が結構難しいかもしれません。少なくとも、想定質問と想定回答はナレッジを基に、エージェントと同じ GPT モデルで作成しておいた方がよいと思います。

テスト結果のエクスポートもできます。

こちらも、文字化けしている場合はメモ帳で開いて保存しなおします。

無事に Excel で開けました。

まとめ

今回は、Copilot Studio で一括でチャット型エージェントのテストする機能を試してみました。非常に便利なため、是非活用してみてください。