#学習記録(33日目)

勉強開始:12/7(土)〜

教材等:

・大重美幸『詳細! Python3 入門ノート』(ソーテック社、2017年):12/7(土)〜12/19(木)読了

・Progate Python講座(全5コース):12/19(木)〜12/21(土)終了

・Andreas C. Müller、Sarah Guido『(邦題)Pythonではじめる機械学習』(オライリージャパン、2017年):12/21(土)〜12月23日(土)読了

・Kaggle : Real or Not? NLP with Disaster Tweets :12月28日(土)投稿〜1月3日(金)まで調整

・Wes Mckinney『(邦題)Pythonによるデータ分析入門』(オライリージャパン、2018年):1/4(水)〜1/13(月)読了

・斎藤康毅『ゼロから作るDeep Learning』(オライリージャパン、2016年):1/15(水)〜1/20(月)

・François Chollet『PythonとKerasによるディープラーニング』(クイープ、2018年):1/21(火)〜

#『PythonとKerasによるディープラーニング』

p.261 第6章 テキストとシーケンスのためのディープラーニング の途中まで読み終わり。

#学習済みの単語埋め込み(2日目)

昨日苦戦していたトークン化は完了しました。

#type : pandas.core.series.Series

#小文字に変換

X_l = X.str.lower()

#不要な文字を半角スペースに置き換える。

X_r = X_l.replace(',', ' ').replace('.', ' ').replace('#', ' ').replace('#', ' ').replace('!', ' ').replace('!', ' ').replace(' ', ' ')

#半角スペースをセパレータとして各単語に分割

X_s = X_r.str.split(' ')

#まとめて定義

def make_vector(df):

X_l = df.str.lower()

X_r = X_r = X_l.replace(',', ' ').replace('.', ' ').replace('#', ' ').replace('#', ' ').replace('!', ' ').replace('!', ' ').replace(' ', ' ')

X_s = X_r.str.split(' ')

return X_s

これでデータセットから取り出したtextについてのトークン化が終わったため、後は定義したモデルに学習させるのみです。(実施中)

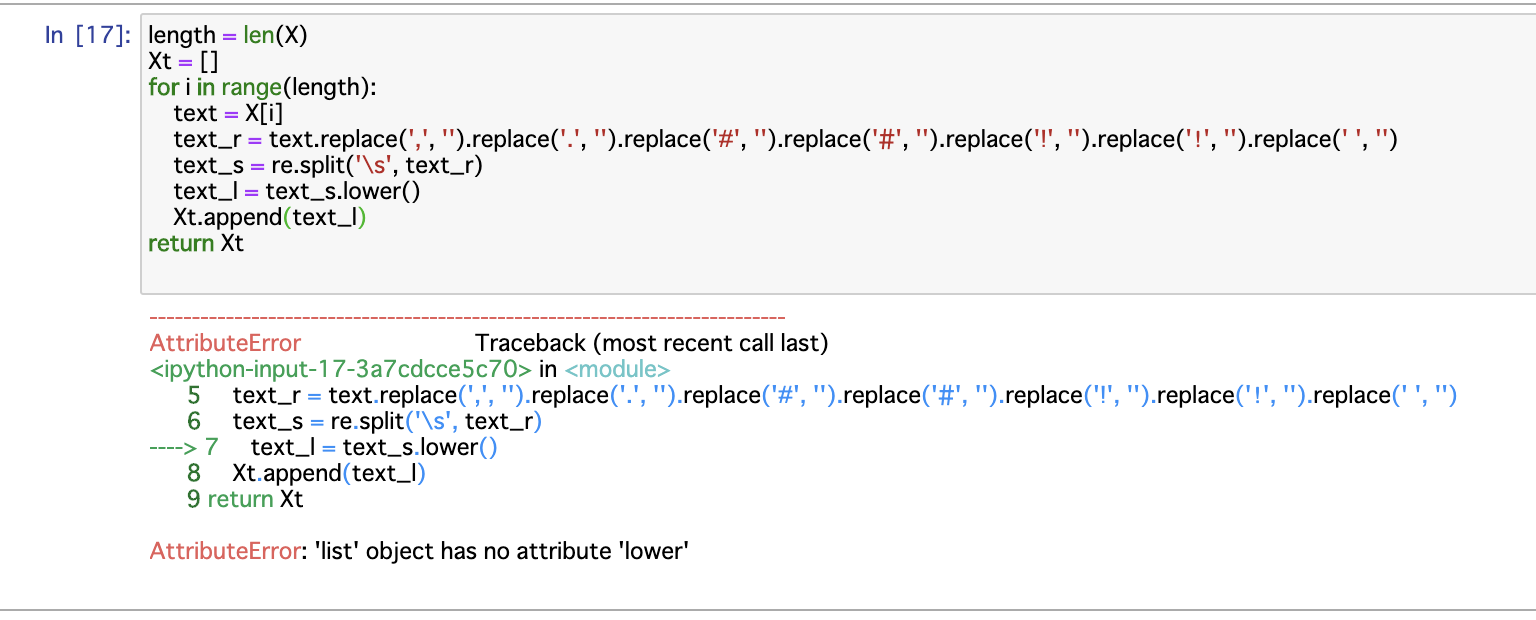

ちなみに最初は以下のとおり、一つずつ取り出してfor文で回そうとしてたんですけど、どうもうまくいかない。

わざわざ取り出さなくてもSeriesのまま前処理をすればいいんじゃないかとふと思ったため、調べてみたところ、やはり可能であることが判明。

pandas公式(API reference, Series)を参考にしつつ書き、前処理に成功しました。