はじめに:AIアプリ、最後の仕上げへ。その応答、本当に「最適」ですか?

皆さん、こんにちは!

このブログは、「PythonとOpenAI APIで実践!はじめてのモデルコントプロトコル(MCP)開発入門」シリーズの第18回です。

私たちは、この長いシリーズを通して、AIアプリケーション開発のあらゆる側面を旅してきました。

パート1〜3でアイデアを形にし、第14〜15回でコストを管理し、第16回でセキュリティを固め、そして前回の第17回ではレートリミットという実運用上の嵐を乗り越える術を学びました。

もはやあなたのアプリケーションは、ただ動くだけでなく、安全で、経済的で、安定しています。しかし、本当に「最高のユーザー体験」を提供できているでしょうか?

- 「AIの答えが、時々クリエイティブすぎて事実と異なる…」

- 「もっと簡潔に、要点だけを答えてほしいのに、いつも長文で返ってくる…」

- 「同じ質問なのに、毎回応答のトーンが違いすぎて安定しない…」

これらの悩みは、AIの応答がまるで予測不可能な「ガチャ」のように感じられることから生じます。しかし、断言します。AIの応答はガチャではありません。それは、私たちが「制御」できるものです。

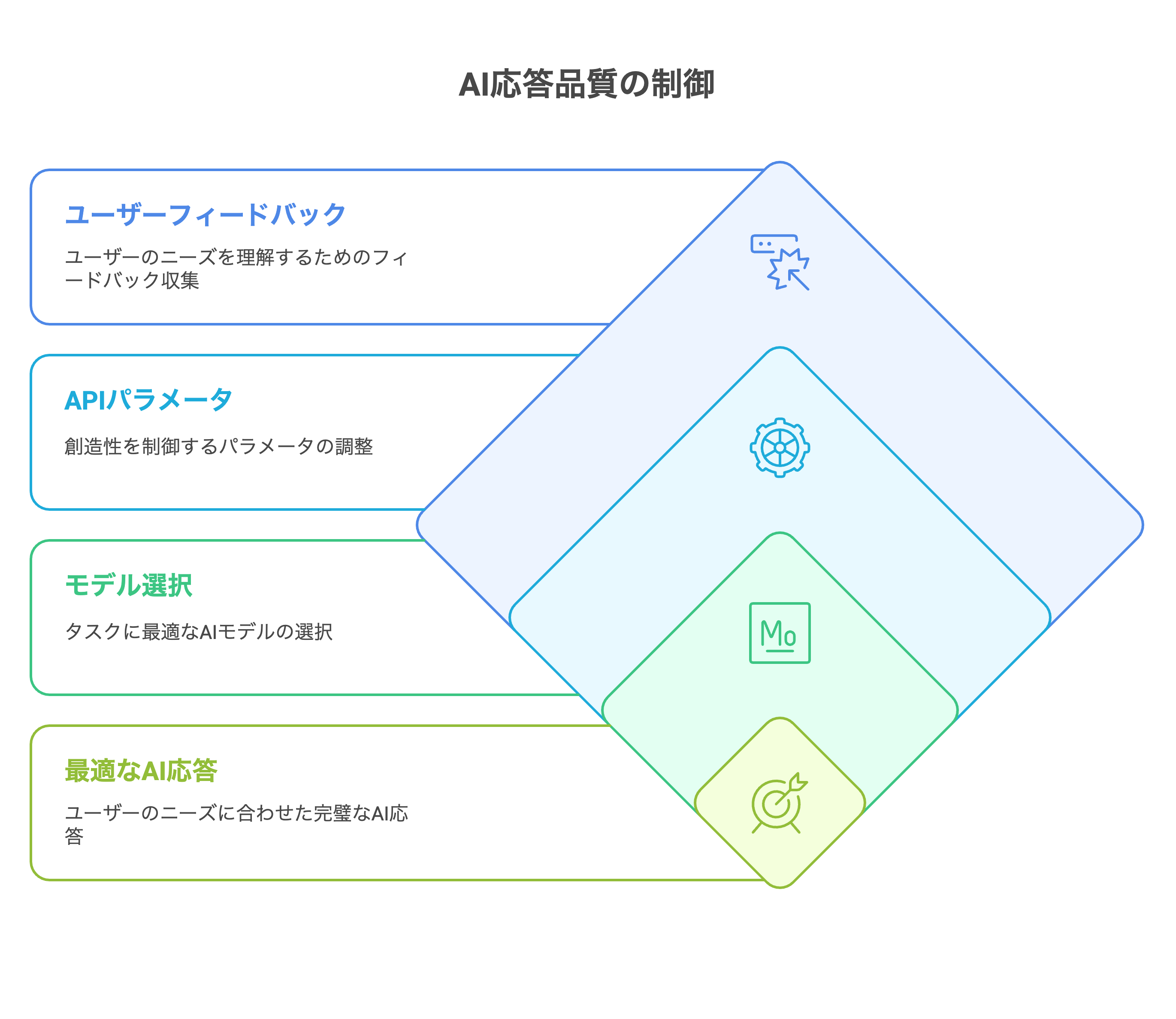

今回の第18回では、これまで築き上げてきたアプリケーションの「魂」とも言えるAIの応答品質を、自由自在にチューニングするための技術を徹底解説します。タスクに応じた最適なモデルの選び方から、応答の創造性を操るtemperatureやtop_pといった主要なAPIパラメータまで、具体的なPythonコードと共に深掘りしていきます。

この回をマスターすれば、あなたは単なるAPIの利用者から、AIの振る舞いを設計する「AIアーキテクト」へと進化できるはずです。さあ、AIとの対話を極めるための最後の仕上げに取り掛かりましょう!

1. モデル選択の再訪:コストと速度だけで選んでいませんか?

第15回のコスト削減術で、私たちはタスクの複雑さに応じてgpt-4oとgpt-3.5-turboを使い分ける「ルーター」という考え方を学びました。これはコストと速度の最適化には非常に有効です。しかし、「品質」という観点を加えると、モデル選択はさらに奥深くなります。

| モデル | 強み・特性 | 主な用途(推奨) |

|---|---|---|

| gpt-4o | 天才的オールラウンダー。複雑な推論、ニュアンスの理解、マルチモーダル(画像入力等)、創造性、速度のバランスが最も良い。 | 高度なチャットボット、複雑な指示に基づくコード生成、画像を含むドキュメント分析、ブレインストーミング。 |

| gpt-4-turbo | テキスト特化の専門家。非常に長いコンテキストの読解力と、複雑で厳密な指示への追従性が高い。 | 論文や契約書など長文の読解・要約、厳密なフォーマットでの出力が求められるタスク。 |

| gpt-3.5-turbo | 高速な仕事人。単純なタスクを驚異的な速度と低コストでこなす。 | テキスト分類、感情分析、単純な要約、キーワード抽出、第15回で実装したルーターの判断役。 |

戦略的選択

- ユーザーとの対話の根幹をなすチャットボットには、速度と性能のバランスが良いgpt-4oを。

- 内部的なバッチ処理で、大量の定型ドキュメントを処理するならgpt-3.5-turboを。

- ユーザーがアップロードしたPDF仕様書からコードを生成する、といった高難度タスクにはgpt-4-turboを。

このように、アプリケーションの機能ごとに最適なモデルを割り当てる視点が、品質とコストの両立に繋がります。

2. 応答の「創造性」を操る:temperatureとtop_pの完全理解

ここからが本題です。同じモデルでも、パラメータ一つで応答は劇的に変わります。特に重要なのが、応答の「ランダム性」を制御するtemperatureとtop_pです。

temperature:創造性のダイヤル

temperatureは、AIが次に出力する単語を選ぶ際の確率分布をどれだけ「なだらか」にするかを制御します。

-

temperatureが低い(例: 0.0〜0.3)- AIは最も確率の高い、手堅い単語を選びやすくなります。

- 結果: 決定的で、事実に基づいた、一貫性のある応答。

- 用途: 事実に基づくQ&A、コード生成、分類、厳密な要約。

-

temperatureが高い(例: 0.7〜1.0以上):- 確率の低い単語も選択肢に含まれやすくなります。

- 結果: 創造的で、多様性に富んだ、意外性のある応答。ただし、時に事実と異なる「ハルシネーション(幻覚)」や、意味の通らない文章を生成するリスクも高まります。

- 用途: ブレインストーミング、物語や詩の創作、マーケティングコピーの作成。

Pythonコードで体感するtemperatureの違い

from openai import OpenAI

client = OpenAI()

def compare_temperature(prompt: str):

temperatures = [0.1, 0.7, 1.2]

print(f"プロンプト: 「{prompt}」\n" + "="*50)

for temp in temperatures:

try:

response = client.chat.completions.create(

model="gpt-4o",

messages=[{"role": "user", "content": prompt}],

temperature=temp,

max_tokens=100

)

content = response.choices[0].message.content

print(f"\n🔥 Temperature: {temp}\n---")

print(content)

except Exception as e:

print(f"Temperature {temp} でエラーが発生: {e}")

# --- 実行例 ---

compare_temperature("AI時代の新しい学習方法について、斬新なアイデアを1つ提案してください。")

このコードを実行すると、temperatureの値によって応答の「お堅さ」や「斬新さ」が全く異なることが視覚的に理解できるはずです。

-

top_p(Nucleus Sampling):確率のプールを絞る-

top_pはtemperatureとは異なるアプローチでランダム性を制御します。AIが次に出力する単語候補の中から、確率の高い順に足し合わせていき、その合計がtop_pの値(例: 0.9)に達した時点で、それ以外の候補をすべて破棄します。 -

top_pが低い(例: 0.1): ごく一握りの最有力候補の中からしか単語を選ばないため、非常に決定的で安全な応答になります。

-

-

top_pが高い(例: 0.95): 幅広い単語が候補に残り、多様な応答が生まれます。

-temperatureとの使い分け:- 原則:

temperatureとtop_pは、どちらか一方のみを設定することが推奨されています。 両方を設定すると、予期せぬ挙動をすることがあります。 -

temperature: 応答全体の「雰囲気」を変えたい場合に適しています。創造性のレベルを直感的に調整できます。 -

top_p: 応答の多様性は持たせつつも、突拍子もない無関係な単語(確率が極めて低い単語)が出現するのを防ぎたい場合に有効です。より安全に多様性を確保したい場合に向いています。

- 原則:

- 実践的な指針

迷ったら、まずはtemperatureで調整を始めるのが直感的で分かりやすいでしょう。temperature=0.7あたりを基準に、タスクに応じて上下させるのが良いスタートです。

3. 応答の「多様性」と「形式」を制御するパラメータ群

創造性以外にも、応答の細かなニュアンスを調整するパラメータがあります。

frequency_penaltyとpresence_penalty:繰り返しの制御

-

frequency_penalty(頻度ペナルティ)- 正の値(0〜2.0)を設定すると、既に出力された単語が再度出現しにくくなります。値が大きいほどペナルティが強くなります。

- 用途: 同じ言い回しや単語の繰り返しを減らし、より多様な語彙を使った文章(特に長い要約など)を生成させたい場合に有効です。

-

presence_penalty(存在ペナルティ)- 正の値(0〜2.0)を設定すると、一度でも出力された単語(トピック)に対してペナルティを与え、新しいトピックについて話すよう促します。

- 用途: ブレインストーミングで、AIが同じようなアイデアばかり出すのを防ぎ、より広範なトピックを探求させたい場合に有効です。

-

max_tokensとstop:出力の終端制御

この2つは、第15回(コスト)や第16回(セキュリティ)、第17回(安定性)でも触れましたが、「品質」の観点からも極めて重要です。 -

max_tokens- コスト上限だけでなく、応答の「簡潔さ」を強制するツールとしても使えます。「一言で答えて」というプロンプトと共に

max_tokens=20のように設定すれば、AIは必然的に短い応答を生成せざるを得ません。

- コスト上限だけでなく、応答の「簡潔さ」を強制するツールとしても使えます。「一言で答えて」というプロンプトと共に

-

stop- 特定の文字列(例:

\n\nや###)が出現したら、そこで応答を強制的に終了させます。 - 用途

- JSONの生成: }が出たら必ず止めるようにし、余計な解説文が付与されるのを防ぐ。

- 箇条書き: 4.のような次の項目が生成される前に止める。

- 安全なパース: これにより、後続のプログラムがAIの応答を安全かつ確実にパースできるようになります。

- 特定の文字列(例:

4. 実践シナリオ別:最強のパラメータチューニング設定例

これまでの知識を総動員し、具体的なアプリケーションシナリオごとに最適なパラメータ設定を考えてみましょう。

シナリオ1:社内規定FAQチャットボット

- 目的: 常に正確で、一貫性のある事実に基づいた回答を返す。創造性は不要。

- 設定

response = client.chat.completions.create(

model="gpt-4o", # 正確性が求められるため

messages=[...],

temperature=0.0, # 創造性を完全にオフ

max_tokens=300 # 長すぎる回答を防ぐ

)

シナリオ2:新商品のブレインストーミング支援ツール

- 目的: 開発者の思考を刺激する、多様で斬新なアイデアをできるだけ多く引き出す。

- 設定

response = client.chat.completions.create(

model="gpt-4o",

messages=[...],

temperature=0.9, # 創造性を高く

presence_penalty=0.5, # 新しいトピックを促す

frequency_penalty=0.3 # 同じアイデアの繰り返しを少しだけ抑制

)

シナリオ3:議事録の要約&アクションアイテム抽出ツール

- 目的: 長い議事録から重要なポイントを抽出し、同じ内容を繰り返さず、指定したJSON形式で正確に出力する。

- 設定:

response = client.chat.completions.create(

model="gpt-4-turbo", # 長文読解が得意なモデルを選択

messages=[...],

temperature=0.2, # 事実ベースで

frequency_penalty=1.0, # 同じ内容の繰り返しを強く抑制

response_format={"type": "json_object"}, # JSONモードを活用

stop=["}"] # JSONオブジェクトの終わりで確実に停止

)

まとめ:AIを「育てる」という新たな開発者スキル

私たちは、このシリーズを通してAIアプリケーションの骨格を作り、安全対策を施し、安定運用する術を学んできました。そして今回、そのAIに「個性」と「知性」を吹き込むための、パラメータチューニングという名の繊細な作業を学びました。

モデル選択は、タスクの「難易度」と「性質」を見極める戦略眼。

temperature/top_pは、AIの「性格(創造的か、忠実か)」を決める教育方針。

各種ペナルティや停止条件は、AIの「話し方」を躾けるための細かな作法。

これらのパラメータを使いこなすことは、もはや単なるAPIのオプション設定ではありません。それは、アプリケーションの目的に合わせてAIの振る舞いをデザインし、ユーザーにとって最高の体験を創出するための、新しい時代の開発者にとって必須のスキルです。

次回予告

いよいよ最終章、 パート5「さらなるステップアップ」 に突入します。次回、第19回は 「MCP実装のネクストステップ - マルチモーダルAI、AIエージェントと未来のコンテキスト連携の可能性」 と題し、GPT-4oの画像入力機能の活用や、AIが自律的にツールを使いこなす「AIエージェント」の世界を探求します。お楽しみに!

この記事が、あなたのAIの「神調整」の一助となれば、これほど嬉しいことはありません。ぜひ Like で応援をよろしくお願いします!