はじめに:AI開発の「燃料費」を理解する - トークンとコスト管理の重要性

皆さん、こんにちは!AI開発の旅、第14回です。前回まで(第12回、第13回)で、高度なプロンプトエンジニアリングやAPIキーの鉄壁のセキュリティ対策について学び、より洗練されたAIアプリケーション開発の土台を築きました。AIの驚異的な能力を目の当たりにし、様々なアイデアが湧いてきていることでしょう。

しかし、素晴らしいAIアプリケーションを開発し、安定して運用していくためには、避けて通れない非常に現実的な側面があります。それが 「コスト」です。OpenAI APIは非常に強力ですが、その利用は(無料枠を超える場合)有料であり、その料金体系の核心をなすのが「トークン(Token)」 という概念です。

- 「トークンって何?文字数とどう違うの?」

- 「GPT-4oとGPT-3.5-Turboで、どれくらい料金が違うの?」

「自分のAPIコールがいくらかかるか、どうやって計算・確認するの?」

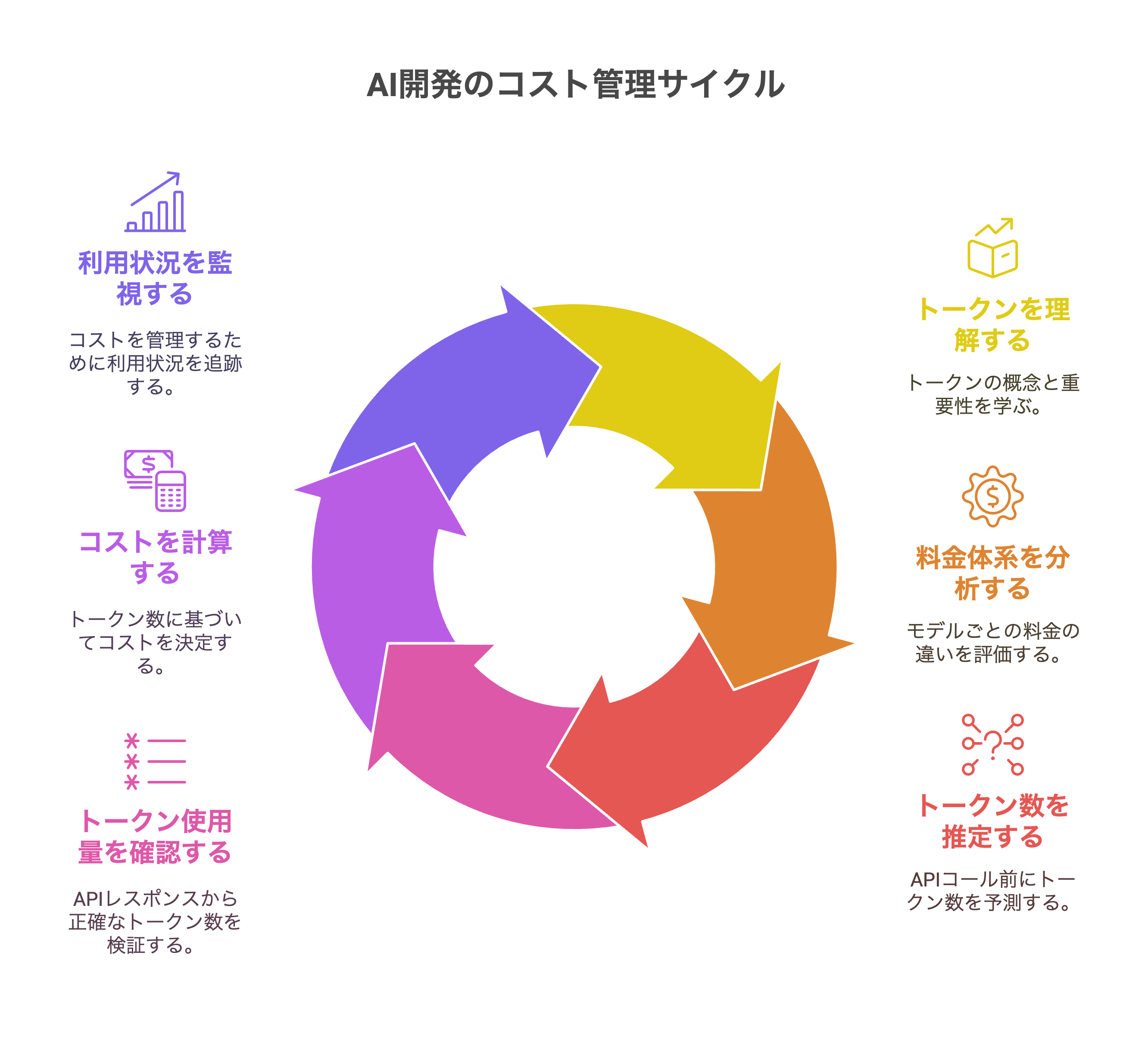

今回の記事では、これらの疑問に明確に答えるため、

- OpenAI APIにおける 「トークン」の技術的な意味(特に日本語のような非英語言語での注意点)

- 主要なAIモデル(GPT-4o, GPT-3.5-Turboなど)ごとの料金体系と、入力/出力トークンの違い

- Pythonライブラリ

tiktokenを使った 事前のトークン数推定方法 - APIレスポンスの

usageオブジェクト から正確なトークン数を確認する方法 - 具体的なコスト計算例と、OpenAIダッシュボードでの利用状況監視・予算設定テクニック

といった、APIコスト管理に不可欠な技術知識を徹底解説します。AI開発を持続可能なものにするために、この「燃料費」の仕組みをしっかりと理解しましょう!(2025年6月2日、ここ東京のような活気ある技術都市でも、コスト効率の良いAIソリューション開発は重要なテーマです。)

AIの「通貨」:OpenAIにおける「トークン」とは何か?

OpenAIのLLM(大規模言語モデル)がテキストを処理する際の基本単位、それが「トークン」です。

-

トークンの定義と特性

- トークンは、必ずしも「1単語=1トークン」ではありません。また、「1文字=1トークン」でもありません。LLMがテキストを効率的に処理するために、テキストを意味のある最小単位に分割したものです。

- 技術的背景:サブワード・トークナイゼーション(例:BPE - Byte Pair Encoding): GPTシリーズのような現代のLLMは、 サブワード・トークナイゼーション という技術を用いてテキストをトークンに分割します。これは、頻出する単語はそのまま1トークンとしつつ、稀な単語や未知語はさらに小さな意味のある部分(サブワード)に分割したり、あるいは文字レベルに近い単位に分割したりする手法です。例えば、「OpenAI」は1トークンかもしれませんが、「トークナイゼーション」は「トークン」「ナイ」「ゼーション」のように複数のトークンに分割されることがあります。

- 言語による違い: 一般的に、英語では「1トークン≒4文字」または「100トークン≒75単語」といった目安がありますが、これはあくまで近似値です。 日本語、中国語、韓国語のように単語の区切りが明確でない言語や、文字種が多い言語では、同じ意味内容でも英語より多くのトークンを消費する傾向があります。 例えば、ひらがな1文字が1トークン以上になることも珍しくありません。

- なぜトークンが重要なのか?

- OpenAI APIの多くのモデルでは、 処理したトークンの総数(入力プロンプトのトークン数+AIが生成した応答のトークン数)に基づいて料金が計算されます。 したがって、トークン数を正確に把握することが、コスト管理の第一歩となります。

OpenAI APIの料金体系:モデル別・インプット/アウトプット別の課金

OpenAI APIの料金は、使用するAIモデルの種類や、処理するデータの方向(入力か出力か)によって異なります。

-

必ず公式サイトで最新情報を確認

- APIの料金体系は変更される可能性があるため、常にOpenAIの公式ドキュメント内の 料金ページ(platform.openai.com/pricing) で最新の情報を確認する習慣をつけましょう。

-

料金を左右する主要因

- AIモデルの種類: 高機能なモデルほど高価になる傾向があります。例えば、一般的に gpt-4o は gpt-3.5-turbo よりもトークン単価が高く設定されています。画像生成モデル(DALL·E)や音声モデル(Whisper, TTS)、埋め込みモデル(Embedding models)なども、それぞれ独自の料金体系を持っています。 例(2025年6月時点の仮の料金。必ず公式サイトで確認を!): * gpt-3.5-turbo-0125 (16K context): 入力 $0.0005/1K tokens, 出力 $0.0015/1K tokens * gpt-4o: 入力 $0.005/1K tokens, 出力 $0.015/1K tokens

- 入力(プロンプト)トークン vs 出力(コンプリーション)トークン: 多くのモデルでは、AIに送るプロンプト(システムメッセージ、ユーザーメッセージ、会話履歴など)のトークン数(入力トークン)と、AIが生成する応答のトークン数(出力トークン)で、 異なる単価 が設定されています。多くの場合、出力トークンの方が高価です。

- 課金単位: 料金は通常「1000トークンあたり(per 1K tokens)」または「100万トークンあたり(per 1M tokens)」で表示されます。

-

コンテキストウィンドウとトークン数

各モデルには一度に処理できる最大のトークン数(コンテキストウィンドウ)が設定されています。送信するプロンプト(会話履歴を含む)がこの上限を超えないように注意が必要です。

ステップ1:APIコール前のトークン数推定 - 秘密兵器 tiktoken

APIを呼び出す前に、送信するテキストがおおよそ何トークンになるかを知ることは、コスト意識とコンテキストウィンドウ管理の両面で非常に重要です。そのための強力なツールが、OpenAIが提供するオープンソースのPythonライブラリtiktokenです。

1. tiktokenのインストール (仮想環境内で)

pip install tiktoken

2. Pythonコード例:tiktokenでトークン数をカウントする

import tiktoken

def count_tokens_for_model(text_string: str, model_name: str = "gpt-3.5-turbo") -> int:

"""指定されたモデルのエンコーディングを使用してテキストのトークン数をカウントする"""

try:

# 指定モデルのエンコーディングを取得

encoding = tiktoken.encoding_for_model(model_name)

except KeyError:

print(f"警告: モデル '{model_name}' のエンコーディングが見つかりません。'cl100k_base' をデフォルトとして使用します。")

# cl100k_base は GPT-3.5-turbo や GPT-4 シリーズで広く使われるエンコーディング

encoding = tiktoken.get_encoding("cl100k_base")

num_tokens = len(encoding.encode(text_string))

return num_tokens

# --- tiktoken 使用例 ---

sample_text_jp = "これはOpenAI APIのトークン数を数えるための日本語のサンプルテキストです。"

sample_text_en = "This is a sample English text to count tokens for OpenAI API."

# gpt-3.5-turbo でのトークン数を計算

tokens_jp_gpt35 = count_tokens_for_model(sample_text_jp, "gpt-3.5-turbo")

tokens_en_gpt35 = count_tokens_for_model(sample_text_en, "gpt-3.5-turbo")

print(f"日本語テキスト (gpt-3.5-turbo): 「{sample_text_jp}」\n -> トークン数: {tokens_jp_gpt35}")

print(f"英語テキスト (gpt-3.5-turbo): 「{sample_text_en}」\n -> トークン数: {tokens_en_gpt35}")

# gpt-4o でのトークン数を計算 (エンコーディングが異なる場合があるためモデル指定が望ましい)

tokens_jp_gpt4o = count_tokens_for_model(sample_text_jp, "gpt-4o")

print(f"日本語テキスト (gpt-4o): 「{sample_text_jp}」\n -> トークン数: {tokens_jp_gpt4o}")

# Chat Completions API の messages 配列全体のトークン数もカウント可能

# (詳細はOpenAIのクックブック等を参照。各メッセージに追加の制御トークンが付与されるため、単純な文字列結合とは異なる)

chat_messages_example = [

{"role": "system", "content": "あなたは親切なアシスタントです。"},

{"role": "user", "content": "今日の天気は?"}

]

# message_tokens = count_tokens_for_model(str(chat_messages_example), "gpt-4o") # これは不正確な方法

# 正しい方法は、tiktokenのドキュメントやOpenAIのCookbookを参照して、

# messages形式のトークンカウントを行う関数を実装する必要があります。

# 通常、メッセージ1つあたり数トークンのオーバーヘッドがあります。

技術TIPS

tiktokenは、プロンプトの最適化(できるだけ少ないトークンで意図を伝える)や、コンテキストウィンドウ超過の事前チェックに不可欠です。特に日本語はトークン数が多くなりがちなので、積極的に活用しましょう。Chat Completions APIのmessages形式全体のトークン数を正確に数えるには、各メッセージのroleとcontentだけでなく、メッセージ間の区切りなどにも内部的にトークンが使われるため、OpenAIの提供するサンプルコードなどを参考に専用の関数を実装するのが最も正確です。

ステップ2:APIレスポンスから正確なトークン数を確認 - usageオブジェクト

APIを実際に呼び出した後、OpenAIはレスポンスの中に、そのAPIコールで実際に消費されたトークン数を正確に教えてくれます。これは第8回でも触れた、レスポンスオブジェクト内のusage属性です。

completion.usage.prompt_tokens: 入力(プロンプト全体)で消費されたトークン数。

completion.usage.completion_tokens: AIが生成した応答で消費されたトークン数。

completion.usage.total_tokens: 上記2つの合計。これが課金の対象となります。

Pythonコードスニペット(再掲):

# ... (APIコール後、completionオブジェクトがあるとする) ...

# if completion and hasattr(completion, 'usage') and completion.usage:

# prompt_t = completion.usage.prompt_tokens

# completion_t = completion.usage.completion_tokens

# total_t = completion.usage.total_tokens

# print(f"API実行結果: Promptトークン={prompt_t}, Completionトークン={completion_t}, 合計トークン={total_t}")

tiktokenでの事前推定と、API応答のusageオブジェクトによる事後確認を両方行うことで、トークン数とコストへの理解が深まります。

ステップ3:実践的コスト計算 - あなたのAPIコールはいくら?

トークン数とモデルごとの単価が分かれば、具体的なコストを計算できます。

計算シナリオ例

- 使用モデル: gpt-4o

- 料金(仮、必ず最新情報を確認):

- 入力: $0.005 / 1K tokens

- 出力: $0.015 / 1K tokens

- APIレスポンスのusage:

- prompt_tokens = 1200

- completion_tokens = 300

コスト計算

- 入力コスト: (1200 / 1000) * $0.005 = 1.2 * $0.005 = $0.006

- 出力コスト: (300 / 1000) * $0.015 = 0.3 * $0.015 = $0.0045

- このAPIコールの合計コスト: $0.006 + $0.0045 = $0.0105 (日本円で約1.5円程度 ※為替による)

技術TIPS: この計算を自動化する簡単なPython関数を作っておくと便利です。

def calculate_openai_cost(prompt_tokens, completion_tokens, input_price_per_1k, output_price_per_1k):

"""APIコールのコストを計算する"""

input_cost = (prompt_tokens / 1000) * input_price_per_1k

output_cost = (completion_tokens / 1000) * output_price_per_1k

total_cost = input_cost + output_cost

return total_cost

# 例: GPT-4oの仮レート

# gpt4o_input_rate = 0.005 # $/1K tokens

# gpt4o_output_rate = 0.015 # $/1K tokens

# cost = calculate_openai_cost(1200, 300, gpt4o_input_rate, gpt4o_output_rate)

# print(f"このAPIコールの推定コスト: ${cost:.6f}")

ステップ4:利用状況の監視と予算管理 - OpenAIダッシュボードの活用

OpenAI Platformには、APIの利用状況を詳細に確認できるダッシュボードが用意されています。

- アクセス: platform.openai.com にログインし、「Usage」セクションへ。

- 確認できる情報

- 日別・月別の利用量(トークン数、金額)

- モデルごとの利用内訳

- 利用量のグラフ表示

- 最重要機能:利用制限(Usage Limits)の設定: ダッシュボードの「Billing」>「Usage limits」セクションで、 月間の利用上限額(ハードリミット)と、特定の金額に達した際に通知を受け取る通知設定(ソフトリミット) を設定できます。 これは、予期せぬ高額請求を防ぐために絶対に設定しておくべき、極めて重要な技術的コントロールです。 特に開発初期や個人プロジェクトでは、まず低い金額でハードリミットを設定し、必要に応じて徐々に上げていくのが賢明です。

コストを意識したAI開発の第一歩(次回への布石)

APIの料金体系とコスト計算・監視方法を理解した上で、コストを抑えるための基本的な考え方にも触れておきましょう。(詳細は第15回で!)

- 適切なモデル選択: タスクの複雑性と求められる品質に応じて、最もコスト効率の良いモデルを選びます。常に最新・最高性能のモデルが必要とは限りません。

- プロンプトの簡潔化: 無駄な情報を含まず、意図が明確に伝わる簡潔なプロンプトは、入力トークン数を削減します。

- max_tokensパラメータの活用: AIの応答の最大長を適切に制限することで、出力トークン数をコントロールします。

おわりに:コスト管理はAI開発の「サステナビリティ」

今回は、OpenAI APIを利用する上で避けては通れない「料金」について、その核心である「トークン」の技術的な意味から、具体的なコスト計算、そしてOpenAIダッシュボードでの利用状況監視と予算管理テクニックまでを詳しく解説しました。

サブワード・トークナイゼーション の概念、tiktoken ライブラリ による事前推定、APIレスポンスのusage オブジェクト からの正確な数値把握、そして ダッシュボードでの利用制限設定。 これらの技術的知識とツールを駆使することが、AI開発プロジェクトを持続可能なものにし、安心してイノベーションに挑戦するための基盤となります。

コストを意識し、コントロールすることは、開発者としての重要な責任の一つです。特に、ここ東京のように多くのスタートアップや開発者がAI技術の活用を目指す環境では、限られたリソースを最大限に活かすためのコスト管理能力が、プロジェクトの成否を左右することもあるでしょう。

次回予告

API料金の仕組みは理解できました。では、具体的にどうすればAPI利用料金を「節約」できるのでしょうか?

次回、第15回「AI開発費を賢く節約!API利用料金を最小化するプロンプト最適化とモデル選択術」では、プロンプトの書き方、コンテキストの与え方、モデルの選び方など、APIコール料金を抑えるための、より踏み込んだ実践的なテクニック集をお届けします。お楽しみに!

Written by A.H.