子育てとvibeコーディング:寝かしつけ30分で開発するために、音声 × Whisper で片手コーディング環境を作る

最近子どもが生まれまして、生活サイクルが大きく変わりました。

夜型で深夜に作業することが多かったのですが、今は寝かしつけ&授乳時間に。

常に片手が塞がっています。

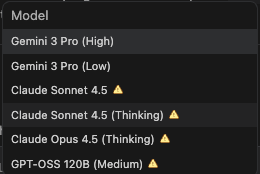

日々現れるAIツール。都度試したい。GoogleがリリースしたAntigravityを使い始めましたが、ある程度使うとスマホゲーのスタミナの如く制限がかかるので、1日に時間を分散して触りたい。

最近のAIエディタは抽象的なプロンプトでもある程度形にしてくれますし、AntigravityはChromeを勝手に立ち上げてデバッグしてくれるモードもあります。

「これ片手で音声だけでもある程度操作できるのでは…?」と思い立ちました。

いつもの寝かしつけの流れはこのパターン

- お歌を歌いながらあやす

- 子どもが目を閉じる

- 深い眠りに入る

- ベッドへ移動

② → ③の間約30分あり、ゆさゆさゆらすだけなので、声と片手だけは使える。

ここをVibeコーディングの時間にしてみることにしました。

音声コーディング環境を作ってみた(開発環境レベル)

「Aqua」というツールを使って、キー入力で音声認識。

かなり精度がいい!

しかしAquaの無料枠が切れた関係で2日と継続できず。

月20ドル払うか、?Apple製の音声認識は微妙だし

いや、これは同時にツール開発してしまえばいいのでは、

と思い、Antigravityの別のウィンドウで作り始めました、

Whisper を使って文字起こし

- キーボードのキーを割り当ててOpenAIのwhisperに音声を送る

- 返ってきたテキストをペーストする

このシンプルな連携を、まだアプリ化せず開発環境上で実行しただけですが、

試した限りでは十分実用レベルで動きました。

実際にやってみてどうだったか

正直、「完全ハンズフリーでの大規模実装」は難しいですが、

ちょっとしたコード修正や補助的な作業なら十分できる。

寝かしつけ中でも「作業が一切できない」状態を脱せるだけで、

精神的ハードルがかなり下がりました。

「今必要だ!」と思って1時間ほどでツールを自作できるのは新しい体験でした。

まとめ

AI時代は、自分の環境・生活に合わせて即席ツールを作れる。

開発環境だけでなく、例えば子育てで必要だと思ったツールを即時開発できる未来も遠くないと感じた。