1.はじめに

コンテナーオーケストレーションにKubernetesを使用する主な利点の1つは、アプリケーションを水平方向にスケーリングした際に、負荷の増加に対応することが非常に簡単になることです。 本来、水平ポッドオートスケーラーは、CPUとメモリの使用量に基づいてデプロイをスケーリングできますが、より複雑なシナリオでは、スケーリングの決定を行う前に他のメトリックを考慮したいと思います。

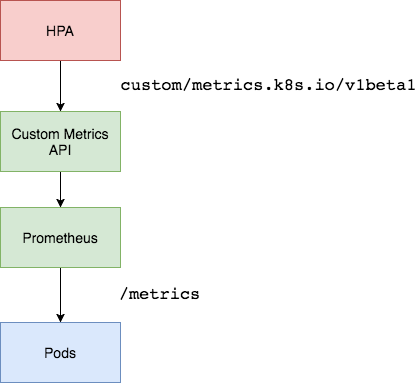

始めにPrometheusアダプターを入力します。 Prometheusは、デプロイされたワークロードとKubernetesクラスター自体をモニタリングするための標準ツールです。 Prometheusアダプターは、Prometheusによって収集されたメトリックを活用し、それらを使用してスケーリングの決定を行うのに役立ちます。 これらの指標はAPIサービスによって公開され、Horizontal Pod Autoscalingオブジェクトですぐに使用できます。

2.導入

2.1アーキテクチャの概要

Prometheusアダプターを使用して、Prometheusインストールからカスタムメトリックを取得し、水平ポッドオートスケーラーがそれを使用してポッドを拡大または縮小できるようにします。 Prometheusアダプターは、クラスター内のサービスを使用して公開されたデプロイメントとして実行されます。 通常、中小規模のクラスターには、アダプターのレプリカが1つあれば十分です。 ただし、非常に大規模なクラスターがある場合は、ノードアフィニティプロパティとPod-AntiAffinityプロパティを使用して、ノード全体に分散されたPrometheusアダプターの複数のレプリカを実行できます。

2.2 前提条件

- 少なくとも3つのノードでKubernetesクラスタ環境で実行して、このチュートリアルではGKEクラスタを使用します。

- 水平ポッドの自動スケーリングに関する基本的な知識。

- クラスタ内にデプロイされた、またはエンドポイントを使用してアクセス可能なPrometheus。

ここでは、Prometheus-Thanos Highly Availabilityデプロイメントを使用します。 詳細については、こちらをご覧ください。

2.3 サンプルアプリケーションのデプロイ

まず、Prometheusメトリックの自動スケーリングをテストするサンプルアプリをデプロイしましょう。 以下のマニフェストを使用して実行できます。

apiVersion: v1

kind: Namespace

metadata:

name: nginx

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

namespace: nginx

name: nginx-deployment

spec:

replicas: 1

template:

metadata:

annotations:

prometheus.io/path: "/status/format/prometheus"

prometheus.io/scrape: "true"

prometheus.io/port: "80"

labels:

app: nginx-server

spec:

affinity:

podAntiAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 100

podAffinityTerm:

labelSelector:

matchExpressions:

- key: app

operator: In

values:

- nginx-server

topologyKey: kubernetes.io/hostname

containers:

- name: nginx-demo

image: vaibhavthakur/nginx-vts:1.0

imagePullPolicy: Always

resources:

limits:

cpu: 2500m

requests:

cpu: 2000m

ports:

- containerPort: 80

name: http

---

apiVersion: v1

kind: Service

metadata:

namespace: nginx

name: nginx-service

spec:

ports:

- port: 80

targetPort: 80

name: http

selector:

app: nginx-server

type: LoadBalancer

これにより、nginxという名前空間が作成され、そこにサンプルのnginxアプリケーションがデプロイされます。 アプリケーションはサービスを使用してアクセスでき、ポート80を介してエンドポイント/ status / format / prometheusでnginx vtsメトリックを公開します。セットアップのために、nginx.gotham.comにマップするExternalIPのdnsエントリを作成しました。

root$ kubectl get deploy

NAME READY UP-TO-DATE AVAILABLE AGE

nginx-deployment 1/1 1 1 43d

root$ kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-deployment-65d8df7488-c578v 1/1 Running 0 9h

root$ kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

nginx-service ClusterIP 10.63.253.154 35.232.67.34 80/TCP 43d

root$ kubectl describe deploy nginx-deployment

Name: nginx-deployment

Namespace: nginx

CreationTimestamp: Tue, 08 Oct 2019 11:47:36 -0700

Labels: app=nginx-server

Annotations: deployment.kubernetes.io/revision: 1

kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"extensions/v1beta1","kind":"Deployment","metadata":{"annotations":{},"name":"nginx-deployment","namespace":"nginx"},"spec":...

Selector: app=nginx-server

Replicas: 1 desired | 1 updated | 1 total | 1 available | 0 unavailable

StrategyType: RollingUpdate

MinReadySeconds: 0

RollingUpdateStrategy: 1 max unavailable, 1 max surge

Pod Template:

Labels: app=nginx-server

Annotations: prometheus.io/path: /status/format/prometheus

prometheus.io/port: 80

prometheus.io/scrape: true

Containers:

nginx-demo:

Image: vaibhavthakur/nginx-vts:v1.0

Port: 80/TCP

Host Port: 0/TCP

Limits:

cpu: 250m

Requests:

cpu: 200m

Environment: <none>

Mounts: <none>

Volumes: <none>

Conditions:

Type Status Reason

---- ------ ------

Available True MinimumReplicasAvailable

OldReplicaSets: <none>

NewReplicaSet: nginx-deployment-65d8df7488 (1/1 replicas created)

Events: <none>

root$ curl nginx.gotham.com

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

<style>

body {

width: 35em;

margin: 0 auto;

font-family: Tahoma, Verdana, Arial, sans-serif;

}

</style>

</head>

<body>

<h1>Welcome to nginx!</h1>

<p>If you see this page, the nginx web server is successfully installed and

working. Further configuration is required.</p>

<p>For online documentation and support please refer to

<a href="http://nginx.org/">nginx.org</a>.<br/>

Commercial support is available at

<a href="http://nginx.com/">nginx.com</a>.</p>

<p><em>Thank you for using nginx.</em></p>

</body>

</html>

これらは、アプリケーションによって現在公開されているすべてのメトリックです。

$ curl nginx.gotham.com/status/format/prometheus

# HELP nginx_vts_info Nginx info

# TYPE nginx_vts_info gauge

nginx_vts_info{hostname="nginx-deployment-65d8df7488-c578v",version="1.13.12"} 1

# HELP nginx_vts_start_time_seconds Nginx start time

# TYPE nginx_vts_start_time_seconds gauge

nginx_vts_start_time_seconds 1574283147.043

# HELP nginx_vts_main_connections Nginx connections

# TYPE nginx_vts_main_connections gauge

nginx_vts_main_connections{status="accepted"} 215

nginx_vts_main_connections{status="active"} 4

nginx_vts_main_connections{status="handled"} 215

nginx_vts_main_connections{status="reading"} 0

nginx_vts_main_connections{status="requests"} 15577

nginx_vts_main_connections{status="waiting"} 3

nginx_vts_main_connections{status="writing"} 1

# HELP nginx_vts_main_shm_usage_bytes Shared memory [ngx_http_vhost_traffic_status] info

# TYPE nginx_vts_main_shm_usage_bytes gauge

nginx_vts_main_shm_usage_bytes{shared="max_size"} 1048575

nginx_vts_main_shm_usage_bytes{shared="used_size"} 3510

nginx_vts_main_shm_usage_bytes{shared="used_node"} 1

# HELP nginx_vts_server_bytes_total The request/response bytes

# TYPE nginx_vts_server_bytes_total counter

# HELP nginx_vts_server_requests_total The requests counter

# TYPE nginx_vts_server_requests_total counter

# HELP nginx_vts_server_request_seconds_total The request processing time in seconds

# TYPE nginx_vts_server_request_seconds_total counter

# HELP nginx_vts_server_request_seconds The average of request processing times in seconds

# TYPE nginx_vts_server_request_seconds gauge

# HELP nginx_vts_server_request_duration_seconds The histogram of request processing time

# TYPE nginx_vts_server_request_duration_seconds histogram

# HELP nginx_vts_server_cache_total The requests cache counter

# TYPE nginx_vts_server_cache_total counter

nginx_vts_server_bytes_total{host="_",direction="in"} 3303449

nginx_vts_server_bytes_total{host="_",direction="out"} 61641572

nginx_vts_server_requests_total{host="_",code="1xx"} 0

nginx_vts_server_requests_total{host="_",code="2xx"} 15574

nginx_vts_server_requests_total{host="_",code="3xx"} 0

nginx_vts_server_requests_total{host="_",code="4xx"} 2

nginx_vts_server_requests_total{host="_",code="5xx"} 0

nginx_vts_server_requests_total{host="_",code="total"} 15576

nginx_vts_server_request_seconds_total{host="_"} 0.000

nginx_vts_server_request_seconds{host="_"} 0.000

nginx_vts_server_cache_total{host="_",status="miss"} 0

nginx_vts_server_cache_total{host="_",status="bypass"} 0

nginx_vts_server_cache_total{host="_",status="expired"} 0

nginx_vts_server_cache_total{host="_",status="stale"} 0

nginx_vts_server_cache_total{host="_",status="updating"} 0

nginx_vts_server_cache_total{host="_",status="revalidated"} 0

nginx_vts_server_cache_total{host="_",status="hit"} 0

nginx_vts_server_cache_total{host="_",status="scarce"} 0

nginx_vts_server_bytes_total{host="*",direction="in"} 3303449

nginx_vts_server_bytes_total{host="*",direction="out"} 61641572

nginx_vts_server_requests_total{host="*",code="1xx"} 0

nginx_vts_server_requests_total{host="*",code="2xx"} 15574

nginx_vts_server_requests_total{host="*",code="3xx"} 0

nginx_vts_server_requests_total{host="*",code="4xx"} 2

nginx_vts_server_requests_total{host="*",code="5xx"} 0

nginx_vts_server_requests_total{host="*",code="total"} 15576

nginx_vts_server_request_seconds_total{host="*"} 0.000

nginx_vts_server_request_seconds{host="*"} 0.000

nginx_vts_server_cache_total{host="*",status="miss"} 0

nginx_vts_server_cache_total{host="*",status="bypass"} 0

nginx_vts_server_cache_total{host="*",status="expired"} 0

nginx_vts_server_cache_total{host="*",status="stale"} 0

nginx_vts_server_cache_total{host="*",status="updating"} 0

nginx_vts_server_cache_total{host="*",status="revalidated"} 0

nginx_vts_server_cache_total{host="*",status="hit"} 0

nginx_vts_server_cache_total{host="*",status="scarce"} 0

これらの中で、特にnginx_vts_server_requests_totalが興味深いものです。 このメトリックの値を使用して、nginxデプロイメントをスケーリングするかどうかを決定します。

2.4 PrometheusアダプターのSSL証明書とKubernetesシークレットを作成する

以下のMakefileを使用して、openssl証明書と対応するKubernetesシークレットを生成できます。

# Makefile for generating TLS certs for the Prometheus custom metrics API adapter

SHELL=bash

UNAME := $(shell uname)

PURPOSE:=metrics

SERVICE_NAME:=custom-metrics-apiserver

ALT_NAMES:="custom-metrics-apiserver.monitoring","custom-metrics-apiserver.monitoring.svc"

SECRET_FILE:=custom-metrics-api/cm-adapter-serving-certs.yaml

certs: gensecret rmcerts

.PHONY: gencerts

gencerts:

@echo Generating TLS certs

@docker pull cfssl/cfssl

@mkdir -p output

@touch output/apiserver.pem

@touch output/apiserver-key.pem

@openssl req -x509 -sha256 -new -nodes -days 365 -newkey rsa:2048 -keyout $(PURPOSE)-ca.key -out $(PURPOSE)-ca.crt -subj "/CN=ca"

@echo '{"signing":{"default":{"expiry":"43800h","usages":["signing","key encipherment","'$(PURPOSE)'"]}}}' > "$(PURPOSE)-ca-config.json"

@echo '{"CN":"'$(SERVICE_NAME)'","hosts":[$(ALT_NAMES)],"key":{"algo":"rsa","size":2048}}' | docker run -v ${HOME}:${HOME} -v ${PWD}/metrics-ca.key:/go/src/github.com/cloudflare/cfssl/metrics-ca.key -v ${PWD}/metrics-ca.crt:/go/src/github.com/cloudflare/cfssl/metrics-ca.crt -v ${PWD}/metrics-ca-config.json:/go/src/github.com/cloudflare/cfssl/metrics-ca-config.json -i cfssl/cfssl gencert -ca=metrics-ca.crt -ca-key=metrics-ca.key -config=metrics-ca-config.json - | docker run --entrypoint=cfssljson -v ${HOME}:${HOME} -v ${PWD}/output:/go/src/github.com/cloudflare/cfssl/output -i cfssl/cfssl -bare output/apiserver

.PHONY: gensecret

gensecret: gencerts

@echo Generating $(SECRET_FILE)

@echo "apiVersion: v1" > $(SECRET_FILE)

@echo "kind: Secret" >> $(SECRET_FILE)

@echo "metadata:" >> $(SECRET_FILE)

@echo " name: cm-adapter-serving-certs" >> $(SECRET_FILE)

@echo " namespace: monitoring" >> $(SECRET_FILE)

@echo "data:" >> $(SECRET_FILE)

ifeq ($(UNAME), Darwin)

@echo " serving.crt: $$(cat output/apiserver.pem | base64)" >> $(SECRET_FILE)

@echo " serving.key: $$(cat output/apiserver-key.pem | base64)" >> $(SECRET_FILE)

endif

ifeq ($(UNAME), Linux)

@echo " serving.crt: $$(cat output/apiserver.pem | base64 -w 0)" >> $(SECRET_FILE)

@echo " serving.key: $$(cat output/apiserver-key.pem | base64 -w 0)" >> $(SECRET_FILE)

endif

.PHONY: rmcerts

rmcerts:

@rm -f apiserver-key.pem apiserver.csr apiserver.pem

@rm -f metrics-ca-config.json metrics-ca.crt metrics-ca.key

.PHONY: deploy

deploy:

kubectl create -f ./custom-metrics-api

makeファイルを作成したら、次のコマンドを実行します。

make certs

また、SSL証明書と対応するKubernetesシークレットが作成されます。 シークレットを作成する前に、監視ネームスペースが存在することを確認してください。 このシークレットは、次にデプロイするPrometheusアダプターを使用します。

2.5 PrometheusアダプターConfigMapの作成

以下のマニフェストを使用して、Prometheusアダプター構成マップを作成します。

apiVersion: v1

kind: ConfigMap

metadata:

name: adapter-config

namespace: monitoring

data:

config.yaml: |

rules:

- seriesQuery: 'nginx_vts_server_requests_total'

resources:

overrides:

kubernetes_namespace:

resource: namespace

kubernetes_pod_name:

resource: pod

name:

matches: "^(.*)_total"

as: "${1}_per_second"

metricsQuery: (sum(rate(<<.Series>>{<<.LabelMatchers>>}[1m])) by (<<.GroupBy>>))

この構成マップは、単一のメトリックのみを指定します。 ただし、いつでもメトリックを追加できます。 このリンクを参照して、メトリックをさらに追加できます。 水平ポッドオートスケーラーに必要なメトリックのみをフェッチすることを強くお勧めします。 これはデバッグに役立ちます。また、これらのアドオンは非常に詳細なログを生成し、ログバックエンドによって取り込まれます。 不要な指標を取得すると、サービスが読み込まれるだけでなく、不要なログがログバックエンドに送信されます。 設定マップの詳細については、こちらをご覧ください。

2.6 Prometheusアダプターデプロイメントの作成

次のマニフェストを使用して、Prometheusアダプターをデプロイします。

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: custom-metrics-apiserver

name: custom-metrics-apiserver

namespace: monitoring

spec:

replicas: 1

selector:

matchLabels:

app: custom-metrics-apiserver

template:

metadata:

labels:

app: custom-metrics-apiserver

name: custom-metrics-apiserver

spec:

serviceAccountName: monitoring

containers:

- name: custom-metrics-apiserver

image: quay.io/coreos/k8s-prometheus-adapter-amd64:v0.4.1

args:

- /adapter

- --secure-port=6443

- --tls-cert-file=/var/run/serving-cert/serving.crt

- --tls-private-key-file=/var/run/serving-cert/serving.key

- --logtostderr=true

- --prometheus-url=http://thanos-querier.monitoring:9090/

- --metrics-relist-interval=30s

- --v=10

- --config=/etc/adapter/config.yaml

ports:

- containerPort: 6443

volumeMounts:

- mountPath: /var/run/serving-cert

name: volume-serving-cert

readOnly: true

- mountPath: /etc/adapter/

name: config

readOnly: true

volumes:

- name: volume-serving-cert

secret:

secretName: cm-adapter-serving-certs

- name: config

configMap:

name: adapter-config

これにより、Prometheusアダプターポッドを生成してPrometheusからメトリックをプルするデプロイメントが作成されます。 引数--prometheus-url = http://thanos-querier.monitoring:9090 /を設定することに注意してください。 これは、Prometheusアダプターと同じKubernetesクラスター内のモニタリング名前空間にThanosが支援するPrometheusクラスターをデプロイしたためです。 この引数を変更して、Prometheusデプロイメントを指すようにすることができます。

このコンテナのログに気付いた場合は、設定ファイルで定義されている指標をフェッチしていることがわかります。

I1122 00:26:53.228394 1 api.go:74] GET http://thanos-querier.monitoring:9090/api/v1/series?match%5B%5D=nginx_vts_server_requests_total&start=1574381213.217 200 OK

I1122 00:26:53.234234 1 api.go:93] Response Body: {"status":"success","data":[{"__name__":"nginx_vts_server_requests_

total","app":"nginx-server","cluster":"prometheus-ha","code":"1xx","host":"*","instance":"10.60.64.39:80","job":"kubernetes

-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df

7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"1xx","host":"*"

,"instance":"10.60.64.8:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-

65d8df7488-mwzxg","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server",

"cluster":"prometheus-ha","code":"1xx","host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace

":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_

vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"1xx","host":"_","instance":"10.60.64.8:80

","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg",

"pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-

ha","code":"2xx","host":"*","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_

pod_name":"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_

total","app":"nginx-server","cluster":"prometheus-ha","code":"2xx","host":"*","instance":"10.60.64.8:80","job":"kubernetes-

pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"2xx",

"host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"2xx","host":"_","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"3xx",

"host":"*","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"3xx","host":"*","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"3xx",

"host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"3xx","host":"_","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"4xx",

"host":"*","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"4xx","host":"*","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"4xx",

"host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"4xx","host":"_","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"5xx",

"host":"*","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"5xx","host":"*","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"5xx",

"host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":

"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total",

"app":"nginx-server","cluster":"prometheus-ha","code":"5xx","host":"_","instance":"10.60.64.8:80","job":"kubernetes-pods"

,"kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg","pod_template_hash":

"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":

"total","host":"*","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_

name":"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total"

,"app":"nginx-server","cluster":"prometheus-ha","code":"total","host":"*","instance":"10.60.64.8:80","job":

"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-mwzxg",

"pod_template_hash":"65d8df7488"},{"__name__":"nginx_vts_server_requests_total","app":"nginx-server","cluster":

"prometheus-ha","code":"total","host":"_","instance":"10.60.64.39:80","job":"kubernetes-pods","kubernetes_namespace":

"nginx","kubernetes_pod_name":"nginx-deployment-65d8df7488-sbp95","pod_template_hash":"65d8df7488"},{"__name__":

"nginx_vts_server_requests_total","app":"nginx-server","cluster":"prometheus-ha","code":"total","host":"_","instance":

"10.60.64.8:80","job":"kubernetes-pods","kubernetes_namespace":"nginx","kubernetes_pod_name":"nginx-deployment-

65d8df7488-mwzxg","pod_template_hash":"65d8df7488"}]}

2.7 PrometheusアダプターAPIサービスの作成

以下のマニフェストはAPIサービスを作成するため、Kubernetes APIからPrometheusアダプターにアクセスできるようになり、水平ポッドオートスケーラーによって指標をフェッチできるようになります。

apiVersion: v1

kind: Service

metadata:

name: custom-metrics-apiserver

namespace: monitoring

spec:

ports:

- port: 443

targetPort: 6443

selector:

app: custom-metrics-apiserver

---

apiVersion: apiregistration.k8s.io/v1beta1

kind: APIService

metadata:

name: v1beta1.custom.metrics.k8s.io

spec:

service:

name: custom-metrics-apiserver

namespace: monitoring

group: custom.metrics.k8s.io

version: v1beta1

insecureSkipTLSVerify: true

groupPriorityMinimum: 100

versionPriority: 100

3.セットアップのテスト

利用可能なすべてのカスタム指標を確認してみましょう。

root$ kubectl get --raw "/apis/custom.metrics.k8s.io/v1beta1" | jq .

{

"kind": "APIResourceList",

"apiVersion": "v1",

"groupVersion": "custom.metrics.k8s.io/v1beta1",

"resources": [

{

"name": "pods/nginx_vts_server_requests_per_second",

"singularName": "",

"namespaced": true,

"kind": "MetricValueList",

"verbs": [

"get"

]

},

{

"name": "namespaces/nginx_vts_server_requests_per_second",

"singularName": "",

"namespaced": false,

"kind": "MetricValueList",

"verbs": [

"get"

]

}

]

}

nginx_vts_server_requests_per_secondメトリックが使用可能であることがわかります。

次に、このメトリックの現在の値を確認します。

root$ kubectl get --raw "/apis/custom.metrics.k8s.io/v1beta1/namespaces/nginx/pods/*/nginx_vts_server_requests_per_second" | jq .

{

"kind": "MetricValueList",

"apiVersion": "custom.metrics.k8s.io/v1beta1",

"metadata": {

"selfLink": "/apis/custom.metrics.k8s.io/v1beta1/namespaces/nginx/pods/%2A/nginx_vts_server_requests_per_second"

},

"items": [

{

"describedObject": {

"kind": "Pod",

"namespace": "nginx",

"name": "nginx-deployment-65d8df7488-v575j",

"apiVersion": "/v1"

},

"metricName": "nginx_vts_server_requests_per_second",

"timestamp": "2019-11-19T18:38:21Z",

"value": "1236m"

}

]

}

これらのメトリックを利用するHPAを作成します。 以下のマニフェストを使用して実行できます。

apiVersion: autoscaling/v2beta1

kind: HorizontalPodAutoscaler

metadata:

name: nginx-custom-hpa

namespace: nginx

spec:

scaleTargetRef:

apiVersion: extensions/v1beta1

kind: Deployment

name: nginx-deployment

minReplicas: 2

maxReplicas: 10

metrics:

- type: Pods

pods:

metricName: nginx_vts_server_requests_per_second

targetAverageValue: 4000m

このマニフェストを適用したら、次のようにHPAの現在のステータスを確認できます。

root$ kubectl describe hpa

Name: nginx-custom-hpa

Namespace: nginx

Labels: <none>

Annotations: autoscaling.alpha.kubernetes.io/metrics:

[{"type":"Pods","pods":{"metricName":"nginx_vts_server_requests_per_second","targetAverageValue":"4"}}]

kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"autoscaling/v2beta1","kind":"HorizontalPodAutoscaler","metadata":{"annotations":{},"name":"nginx-custom-hpa","namespace":"n...

CreationTimestamp: Thu, 21 Nov 2019 11:11:05 -0800

Reference: Deployment/nginx-deployment

Min replicas: 2

Max replicas: 10

Deployment pods: 0 current / 0 desired

Events: <none>

それでは、サービスに負荷をかけましょう。 これにはvegetaというユーティリティを使用します。

別のターミナルで、次のコマンドを実行します。

echo "GET http://nginx.gotham.com/" | vegeta attack -rate=5 -duration=0 | vegeta report

nginxポッドと水平ポッドオートスケーラーを同時に監視すると、次のようになります。

root$ kubectl get -w pods

NAME READY STATUS RESTARTS AGE

nginx-deployment-65d8df7488-mwzxg 1/1 Running 0 9h

nginx-deployment-65d8df7488-sbp95 1/1 Running 0 4m9s

NAME AGE

nginx-deployment-65d8df7488-pwjzm 0s

nginx-deployment-65d8df7488-pwjzm 0s

nginx-deployment-65d8df7488-pwjzm 0s

nginx-deployment-65d8df7488-pwjzm 2s

nginx-deployment-65d8df7488-pwjzm 4s

nginx-deployment-65d8df7488-jvbvp 0s

nginx-deployment-65d8df7488-jvbvp 0s

nginx-deployment-65d8df7488-jvbvp 1s

nginx-deployment-65d8df7488-jvbvp 4s

nginx-deployment-65d8df7488-jvbvp 7s

nginx-deployment-65d8df7488-skjkm 0s

nginx-deployment-65d8df7488-skjkm 0s

nginx-deployment-65d8df7488-jh5vw 0s

nginx-deployment-65d8df7488-skjkm 0s

nginx-deployment-65d8df7488-jh5vw 0s

nginx-deployment-65d8df7488-jh5vw 1s

nginx-deployment-65d8df7488-skjkm 2s

nginx-deployment-65d8df7488-jh5vw 2s

nginx-deployment-65d8df7488-skjkm 3s

nginx-deployment-65d8df7488-jh5vw 4s

root$ kubectl get hpa

NAME REFERENCE TARGETS MINPODS MAXPODS REPLICAS AGE

nginx-custom-hpa Deployment/nginx-deployment 5223m/4 2 10 3 5m5s

水平ポッドオートスケーラーがポッドをスケールアップしてニーズを満たすことがはっきりとわかります。vegetaコマンドを中断すると、vegetaレポートが表示されます。 すべてのリクエストがアプリケーションによって処理されたことを明確に示しています。

root$ echo "GET http://nginx.gotham.com/" | vegeta attack -rate=5 -duration=0 | vegeta report

^CRequests [total, rate, throughput] 224, 5.02, 5.02

Duration [total, attack, wait] 44.663806863s, 44.601823883s, 61.98298ms

Latencies [mean, 50, 95, 99, max] 63.3879ms, 60.867241ms, 79.414139ms, 111.981619ms, 229.310088ms

Bytes In [total, mean] 137088, 612.00

Bytes Out [total, mean] 0, 0.00

Success [ratio] 100.00%

Status Codes [code:count] 200:224

Error Set:

4.まとめ

この設定は、Prometheusアダプターを使用して、いくつかのカスタム指標に基づいてデプロイメントを自動スケーリングする方法を説明してきました。簡単に実行するために、Prometheusサーバーから取得したメトリックは1つだけです。ただし、アダプター構成マップを拡張して、使用可能なメトリックの一部またはすべてをフェッチし、それらを自動スケーリングに使用できます。

PrometheusインストールがKubernetesクラスターの外部にある場合は、クラスターからクエリエンドポイントにアクセスできることを確認し、アダプターデプロイメントマニフェストで更新するだけです。複数のメトリックをフェッチして組み合わせてスケーリングの決定を行うことができる複雑なシナリオが考えられます。

Prometheusの使用に関心があるが、その設定と管理にリソースを消費しすぎる場合は、デモを予約し、Hosted Prometheusが監視環境にどのように適合するかについてお問い合わせください。また、無料トライアルに直接アクセスして、今すぐ確認することもできますので、是非チェックしてみてください!

この記事は、ゲストブロガーのVaibhav Thakurによって書かれました。この記事が気に入った際は、LinkedInで詳細を彼を確認してみてください。

それでは、またの記事で!