気象予測は極めて複雑な課題です。特に風力や太陽光などの再生可能エネルギーでは、予測精度が電力供給の安定性に直結します。AI スタートアップ企業を支援する Intel® Liftoff プログラムの参加メンバーの 1 社であり、Catalyst Track (特別支援枠) の対象となっている Amplify Renewables は、再生可能エネルギーの確実かつ効率的な送電網への供給を目指し、エネルギー予測精度の向上を図りました。

では、予測精度を高めるために、Amplify Renewables はどのようなテクノロジー革新を実現したのでしょうか。

AI スタートアップやエンタープライズ企業に提供されているインテルのパブリック・クラウドであるインテル® Tiber™ AI クラウドを通じて Intel® Liftoff チームと連携し、複数のインテル® Gaudi® 2 アクセラレーターで大規模な気象モデルをトレーニングすることで、送電網への給電量予測の高速化と精度向上を実現しました。

大規模モデルをビッグデータでトレーニング

マシンラーニングは気象予測のアプローチを根本から変えつつあります。Amplify Renewables はグローバル規模で展開している独自の気象モデルをトレーニングし、さらに一歩前進したいと考えていましたが、これには公的 / 民間のソースから収集した数テラバイトもの気象パターンという、膨大な量のデータ処理が必要です。

Amplify Renewables は 2023年12月から 2024年1月にかけて、インテル® Tiber™ AI クラウドを通じて Intel® Liftoff チームと連携し、モデルのトレーニング規模を拡大しました。ワークロードには高負荷のデータ処理が含まれ、インテル® Gaudi® 2 アクセラレーター当たり 90GB を超える VRAM を使い、ベアメタルシステムに搭載した 8 枚のインテル® Gaudi® 2 アクセラレーター・カードへデータ並列トレーニングを分散する必要があります。このベアメタル環境には 1TB の RAM と複数の高速 NVMe ドライブが備わっており、ファイルシステム・ベースのストレージサービスを介して大規模データセットを効率的に処理できます。これは相当な演算能力です。

実現する仕組み

モデルの構築にはインテル® Tiber™ AI クラウドに Habana PyTorch フレームワークと Hugging Face エコシステムのライブラリー群を組み合わせ、3 つの実行モード「Lazy モード」、「Eager モード」、「Eager モードと torch.compile の併用」で検証しました。各モードそれぞれに以下のような特長があります。

- Lazy モード: 演算処理をグラフに蓄積し、後から一括で実行。グラフ・コンパイラーが演算子の融合やデータのレイアウト管理といった拡張機能によってデバイスの実行を最適化します。詳しく読む

- Eager モード: 演算処理を 1 つずつ即座に実行。デバッグとモデルのイテレーションを円滑化します。詳しく読む

- Eager モードと torch.compile の併用: PyTorch 2.0 で導入されたモード。モデルの一部分をグラフにラップしてパフォーマンスを向上。Eager モードの即時実行とグラフ実行の最適化機能が組み合わされました。詳しく読む

インテル® Gaudi® ソフトウェアの次回のリリース以降、Lazy モードは「Eager モードと torch.compile の併用」に置き換わる予定です。イテレーションごとにグラフを再形成する必要なく、同等のパフォーマンスを提供します。インテル® Gaudi® アクセラレーターは Habana SynapseAI SDK により PyTorch や TensorFlow といった主要な AI フレームワークとシームレスに統合できます。Hugging Face モデルを導入しているスタートアップ企業は、Optimum Habana を有効活用することで、コード変更を最小限に抑えながら、インテル® Gaudi® アクセラレーター上でモデルのパフォーマンスを最適化できます。

データが証明した成果

成果は出力データから分かるとおりです。Amplify Renewables は複数のモデルをトレーニングした結果、主に次のようなメリットを確認しました。

- 簡単なセットアップ: PyTorch モデルは最小限の修正のみでインテル® Gaudi® AI アクセラレーターに実装可能。

- 柔軟な実行モード: 3 つのモードがすべて推論に対応。また Lazy モードと Eager モードではスムーズなトレーニングに有効です。

- 拡張性: 推論パフォーマンスの直線的な向上。分散型トレーニングでも、ほぼ直線的に拡大しました。

- 高いメモリー効率: インテル® Gaudi® 2 アクセラレーターに備わる大容量 VRAM が複雑な演算処理に大きな違いをもたらしました。

実際の動作データ

AI ベースの気象予測における進歩

下のグラフは、最先端 AI モデルの気象予測パフォーマンスを時系列で示したものです。Z300 RMSE スキルを ECMWF HRES (高解像度の気象予測ベンチマーク) で比較しています。

オレンジ色の線グラフは基準となる ECMWF HRES で、グローバル規模の予測に広く利用されている、上述の高解像度数値気象予測モデルを示しています。Y 軸 (Z300 RMSE スキルと ECMWF HRES の比較) は、AI ベースのモデルを ECMWF HRES と比較した相対パフォーマンスです。値が大きいほど予測精度が向上していることを示しています。

ECMWF HRES と比較してベンチマーク評価を行った結果、このグラフから従来の気象予測手法を大きく上回る進歩が明らかになりました。

グラフでの注目ポイント

- 時間の経過とともに進歩

- 2019年以降、AI ベースの気象予測モデルは着実に精度向上を続け、2022年ごろに飛躍的な進歩を遂げました。

- Dueben & Bauer、WeatherBench、Weyn et al. といった初期のモデルが中程度のパフォーマンスを示していた一方で、FourCastNet、Keisler、Pangu などの比較的最近のモデルでは予測精度の大幅な向上が見られています。

2. 最新の飛躍的進歩 (2023年 ~ 2024年):

- Pangu (2023年) は、それまでのモデルを大きく上回り、AI 気象予測精度の新たな基準を打ち立てました。

- 以降、GraphCast、FengWu、SFNO、FuXi が精度をさらに押し上げて、AI ベースの予測能力に磨きをかけています。

- 2024年には、NeuralGCM、HEAL-ViT、WindBorne、GenCast Aurora、ArchesWeather のような最新モデルが次々と登場し、予測精度と信頼度を向上し続けています。

トレーニングと推論時間のグラフを読み取る

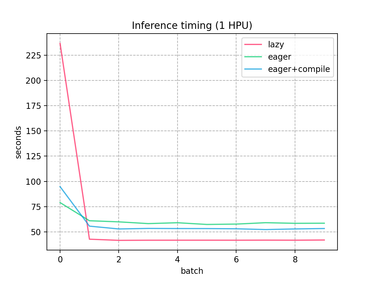

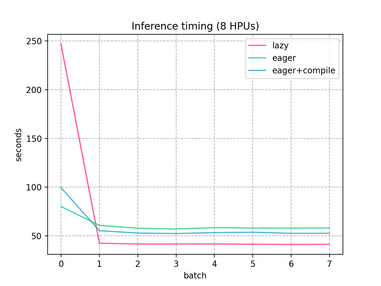

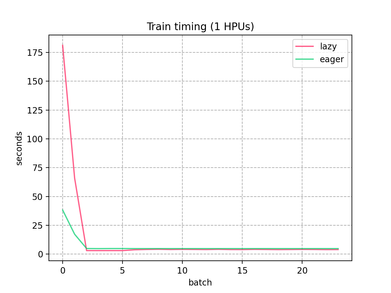

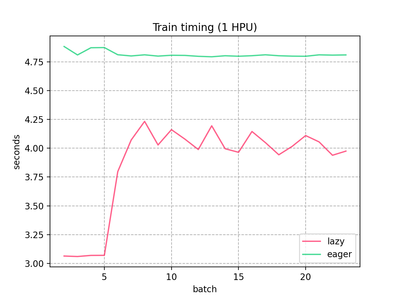

下の 4 つのグラフは、実行モード (Lazy、Eager、Eager と torch.compile の併用) 別にインテル® Gaudi® 2 アクセラレーター上でのトレーニングと推論パフォーマンスを図示したものです。この比較実験は、HPU x1 構成と HPU x8 構成の両方で実施しました。

主な測定結果

推論パフォーマンス:

グラフでは、1 HPU と 8 HPU のトレーニング時間を比較しています。1 HPU での推論はコンパイル遅延が顕著に見られるものの、コンパイル・オーバーヘッドに起因する初期のばらつきを考えたとしても、Lazy モードは一貫して Eager モードのパフォーマンスを上回っていることが分かります。この過剰なコンパイル遅延は一見マイナス面のようにも思えますが、最終的に高速化すれば、多くの場合そのトレードオフに見合うだけの価値がもたらされると言えます。8 HPU に拡張した場合、効率性とパフォーマンスの直線的な伸びから、Lazy モードの方が Eager モードよりも性能面のメリットが大きいことは明白ですが、直線的ではない部分もわずかに見られます。1 HPU のトレーニングでは初期のばらつきが大きく、これはグラフのコンパイルと初期化による影響と考えられ、とはいっても Lazy モードと Eager モードの差はほぼありません。一方、8 HPU のトレーニングはほぼ直線的に拡大しており、Lazy モードが継続して優位なパフォーマンスを示しました。

Lazy モードの方がトレーニング時間が短縮する理由

Lazy モードでは、演算処理をグラフにコンパイルし、最適化してからバッチ処理を実行するため、実行時間の短縮につながります。これに対して Eager モードは即座に演算処理を実行するため、演算処理のたびに余計なオーバーヘッドが発生します。

拡張によりパフォーマンスが向上する理由

複数 HPU (8 HPU) 構成の場合、デバイス全体で並列化が可能になり、1 HPU 構成よりもバッチ当たりの実行時間が短縮します。この効果は、レイテンシーの影響を受けやすい推論ワークロードにおいて特に顕著です。

この飛躍的進歩を注視すべき理由

こうして進歩を遂げた Amplify Renewables の独自モデルは、すでに展開されている公的 / 民間の予測モデルとの比較検証が可能になりました。太陽光や風力発電の予測精度が向上すれば、送電網への給電量の信頼度が高まります。これは再生可能エネルギーの未来に不可欠です。

Amplify Renewables チームからの見解

Amplify Renewables 独自の PyTorch モデルをインテル® Gaudi® アクセラレーターへ移植し、新しい Eager モードは特に、大変満足しています。大容量 VRAM のおかげでスムーズに開始でき、Habana PyTorch フレームワークでのモデル実行に大きな問題も発生しませんでした」 — Amplify Renewables 最高技術責任者 (CTO)、Rachit Singh 氏

次のステップ

独自の学習フレームワークが確立され実際に動き始めた今、Amplify Renewables はさらなる拡張を見据えています。次の展開として考えられるのは、幅広い種類のモデルと新たな事前トレーニング手法の検証です。多様なモデル、予測精度の向上、再生可能エネルギー送電網の強化… 輝かしい未来が待っています。

Intel® Liftoff プログラムについて

Intel® Liftoff プログラムは、AI や ML 分野の初期段階にあるスタートアップ企業にイノベーションを前進させるために必要なツールやサポートを提供する、オンラインのプログラムです。

Intel® Liftoff プログラムに参加するスタートアップ企業は、インテルが提供しているパブリック・クラウドのインテル® Tiber™ AI クラウドを通じて最先端のハードウェアを利用できるほか、エキスパートからアドバイスを受けたり、開発者コミュニティーとのつながりを築くこともできます。ディープラーニング・ワークロードの最適化から大規模モデルのトレーニングまで、このプログラムに参加すれば、短時間で効率的に進めることが可能です。

もっとスマートに規模を拡大したいなら、こちらからプログラムにご参加ください。

関連リソース

このような成果を再現したいと考えている皆さんに、インテル® Gaudi® 2 プラットフォームのエコシステムとインテルのクラウド環境を深く知るための役立つリンクを提供します。

- Intel® Liftoff プログラム: 一部の AI スタートアップ企業を対象としたスタートアップ・パッケージを入手できます。

- インテル® Gaudi® 2 AI アクセラレーター: ディープラーニング・ワークロード向けに設計された高性能の AI トレーニング・プロセッサー。

- インテル® Gaudi® 3 AI アクセラレーター: 高効率のインテル® Gaudi® プラットフォームを基盤に、MLPerf ベンチマーク評価によりパフォーマンスが実証済みの、高負荷トレーニングと推論処理のために構築された AI アクセラレーター。

- Optimum Habana (Hugging Face) : 修正を最小限に抑えて Hugging Face モデルをインテル® Gaudi® アクセラレーター上で実行するための最適化されたライブラリー。

元記事

筆者:Eugenie_Wirz , Rachit Singh, Rahul Unnikrishnan Nair

所属:インテル

投稿日:2025年3月26日