はじめに

WindowsServer2016でのネットワークチーミング(ボンディング)設定の方法、および設定後の動作確認について記載します。

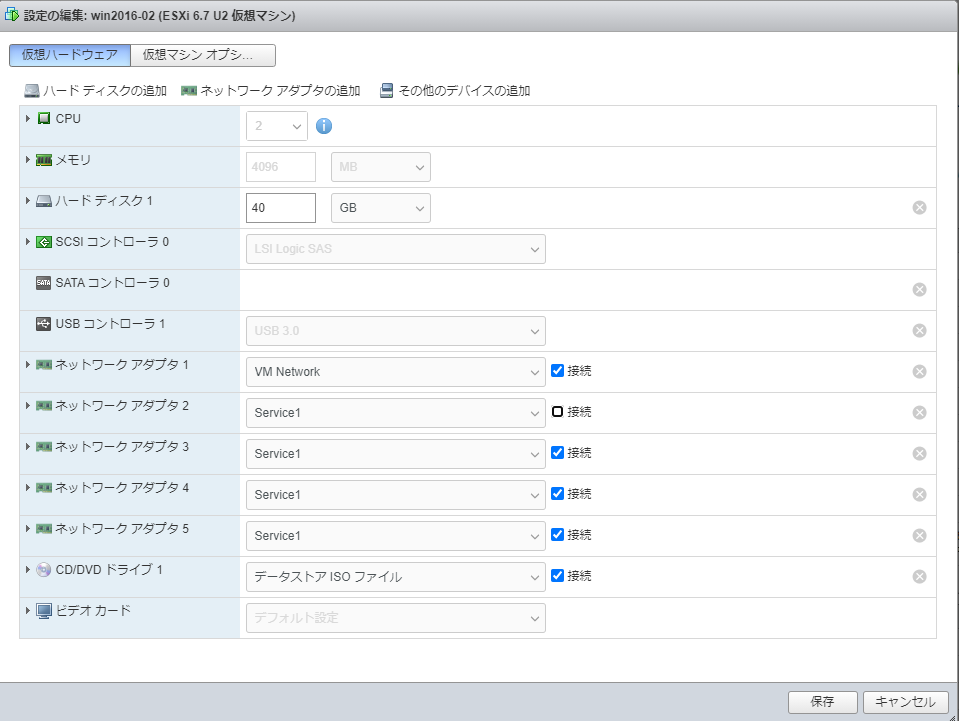

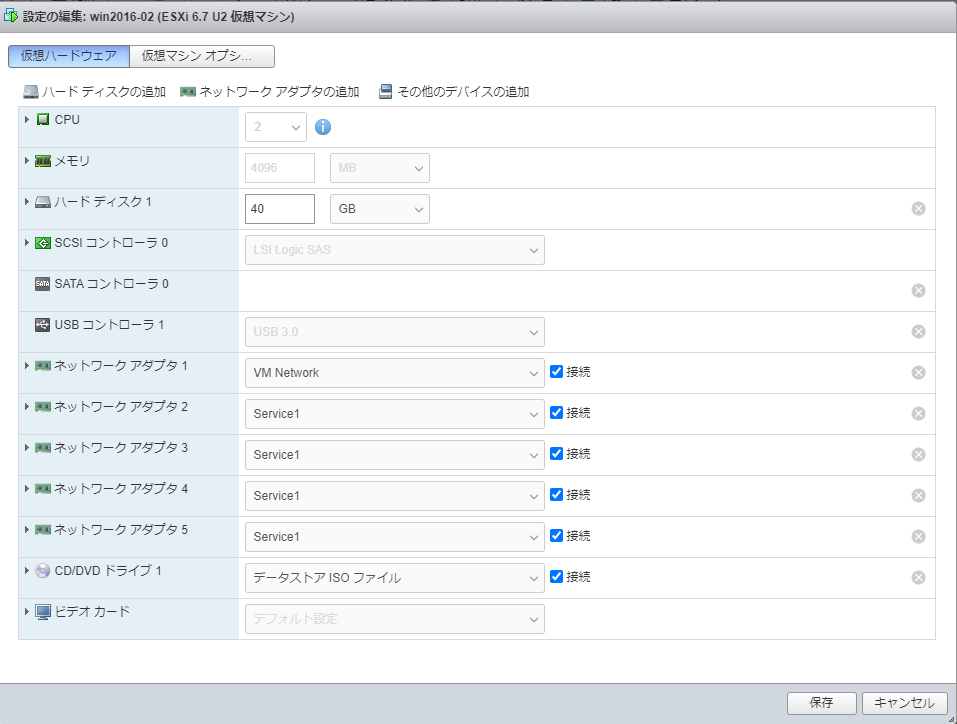

なお、物理マシンではなく仮想マシン(ESXi仮想マシン6.7)にて行った内容となります。

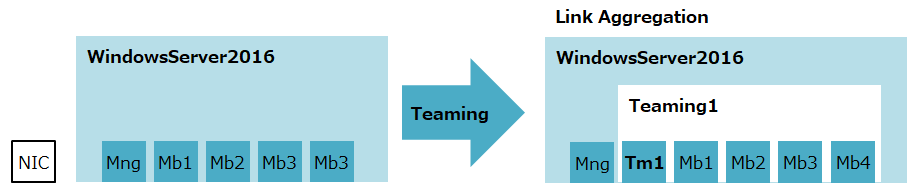

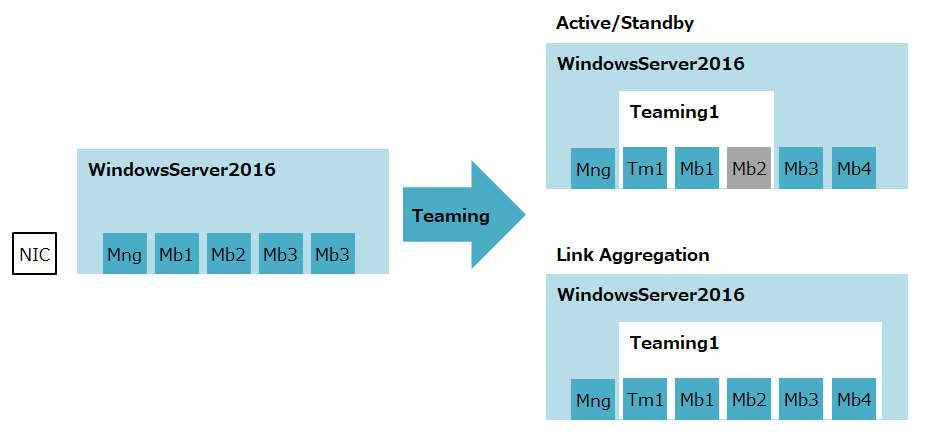

チーミング方式

以下の2通りの設定/確認を記載します。

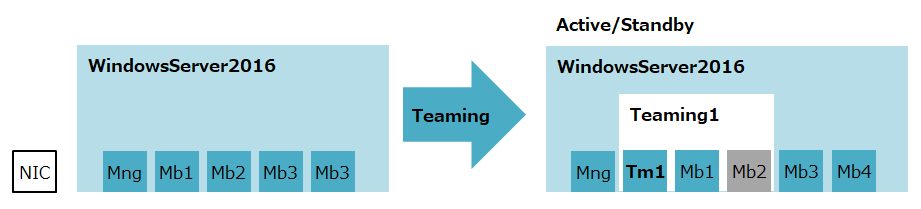

①Active/Standby構成

2つの物理ポートを利用し、片方がアクティブ側となり通信で利用し、もう片方は予備としてホットスタンバイしておく設定。アクティブ側のポートが断線等停止すると、スタンバイ側のポートがアクティブに昇格します。

②Link-Aggregation構成

2つ以上の物理ポートを利用し、全てのポートをアクティブとして利用します。全てのポートを利用するため、通信帯域が増倍するメリットがあります。また、チーミング内のポートが断線等停止すると、通信帯域が減少していく縮退構成となります。

Active/Standby構成の設定

以下の物理ポートを利用し、チーミングアダプタを作成します。

Member1: Active側のメンバー物理ポート。10Mbps。

Member2: Standby側のメンバー物理ポート。10Mbps。

Teaming1: チーミングアダプタ。10Mbps。

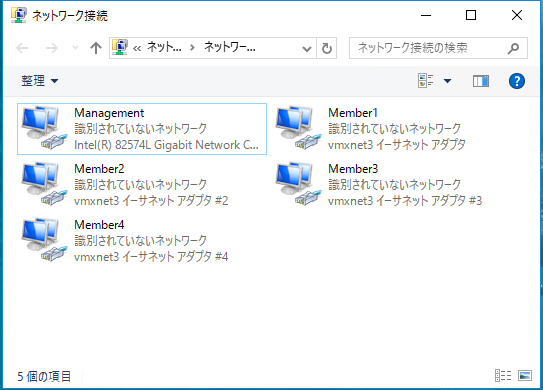

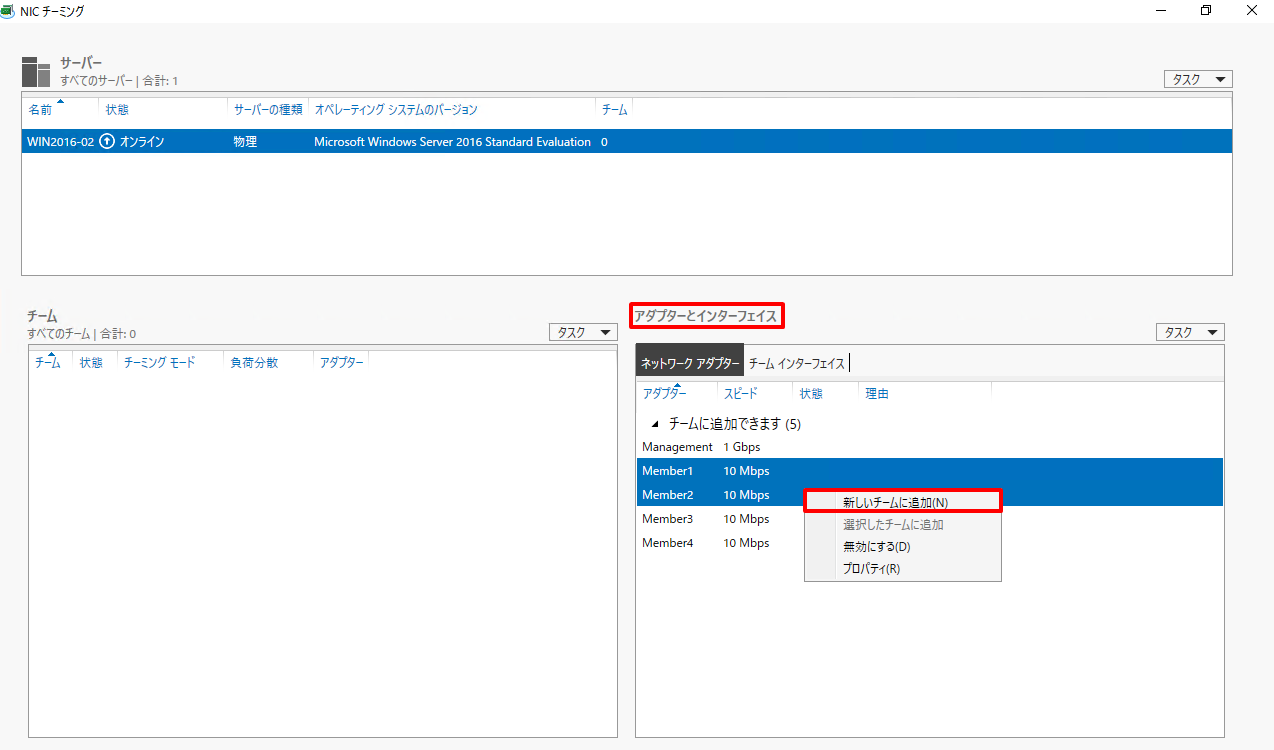

①[サーバーマネージャ]を起動し、[ローカルサーバー]の[NICチーミング] - [無効(または有効)]を選択します。

②[NICチーミング]の[アダプターとインターフェース]からチーミングのメンバーとなる物理アダプタを複数選択し、右クリックして[新しいチームに追加]を選択します。

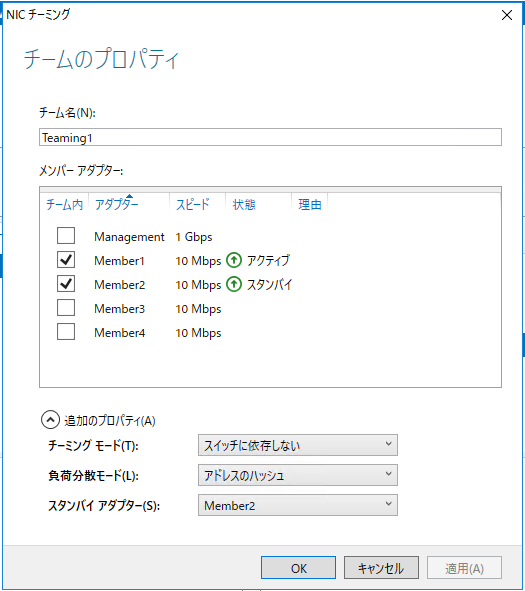

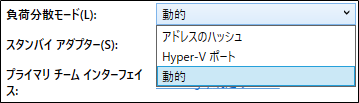

③[チームの新規作成]から各種設定を投入し、[OK]を押下します。

・チーム名 Teaming1

・メンバーアダプタ Member1,Member2

・チーミングモード スイッチに依存しない

・負荷分散モード アドレスのハッシュ

・スタンバイアダプター Member2

なお、設定項目についは以下の通りです。

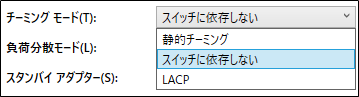

###チーミングモード

スイッチに依存しない(既定)

対向のNW機器に依存せず、WindowsServer側でチーミング設定を行う。

WindowsServer→NW機器への負荷分散のみ行う。

静的チーミング

対向のNW機器に依存するため、NW機器側も設定が必要(静的リンクアグリゲーション)。

WindowsServer⇔NW機器の相互での負荷分散を行う。

LACP

対向のNW機器に依存するため、NW機器側も設定が必要(動的リンクアグリゲーション)。

WindowsServer⇔NW機器の相互での負荷分散を行う。

###負荷分散モード

アドレスのハッシュ

MACアドレス、IPアドレス、TCPポート等で通信させるポートを決定して負荷分散を行う。

Hyper-Vポート

仮想NICごとに負荷分散を決定する。

動的(既定)

チームを構成している物理ポートの負荷状態を確認して負荷分散を行う。

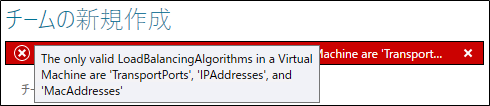

なお、ESXi仮想マシンで動的またはHyper-Vポートを選択すると、以下エラーが発生するため、アドレスのハッシュを設定しています。

The only vaild LoadBalancingAlgorithms in a Virtual Machine are 'TransportPorts', 'IPAddresses', and 'MacAddresses'

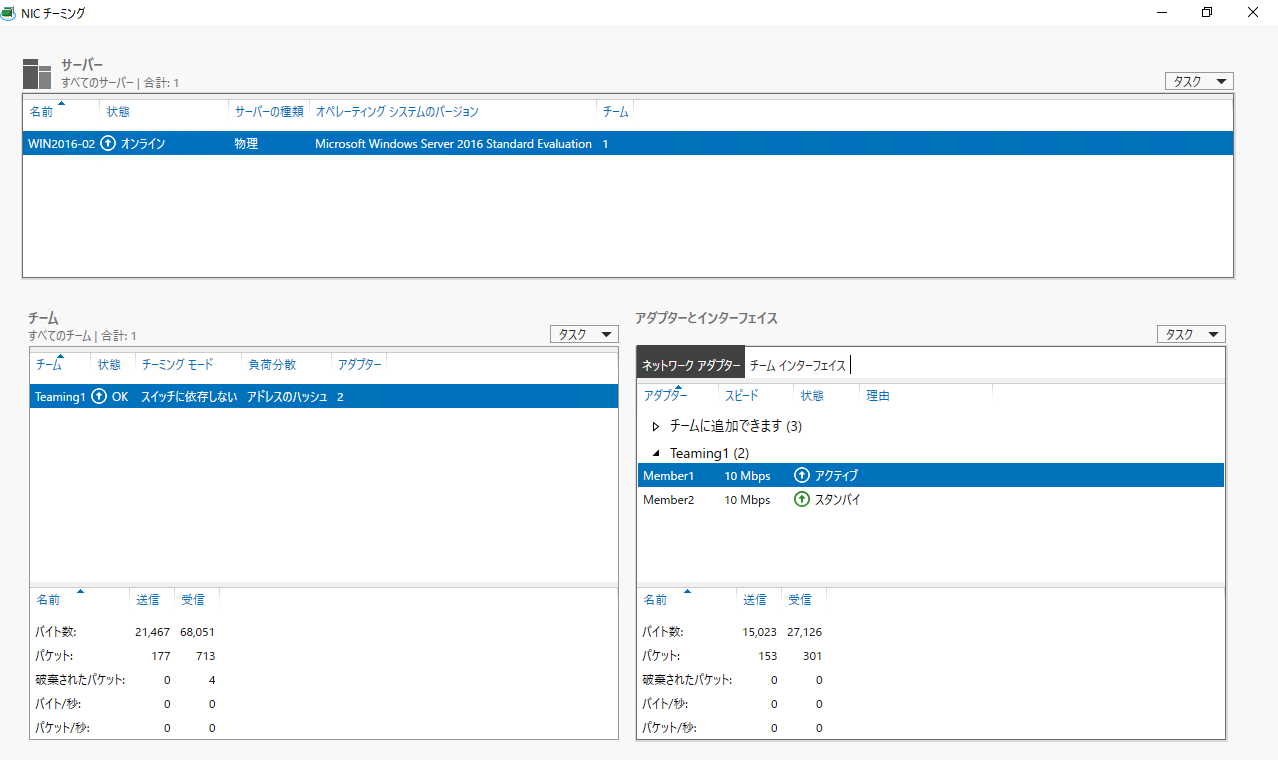

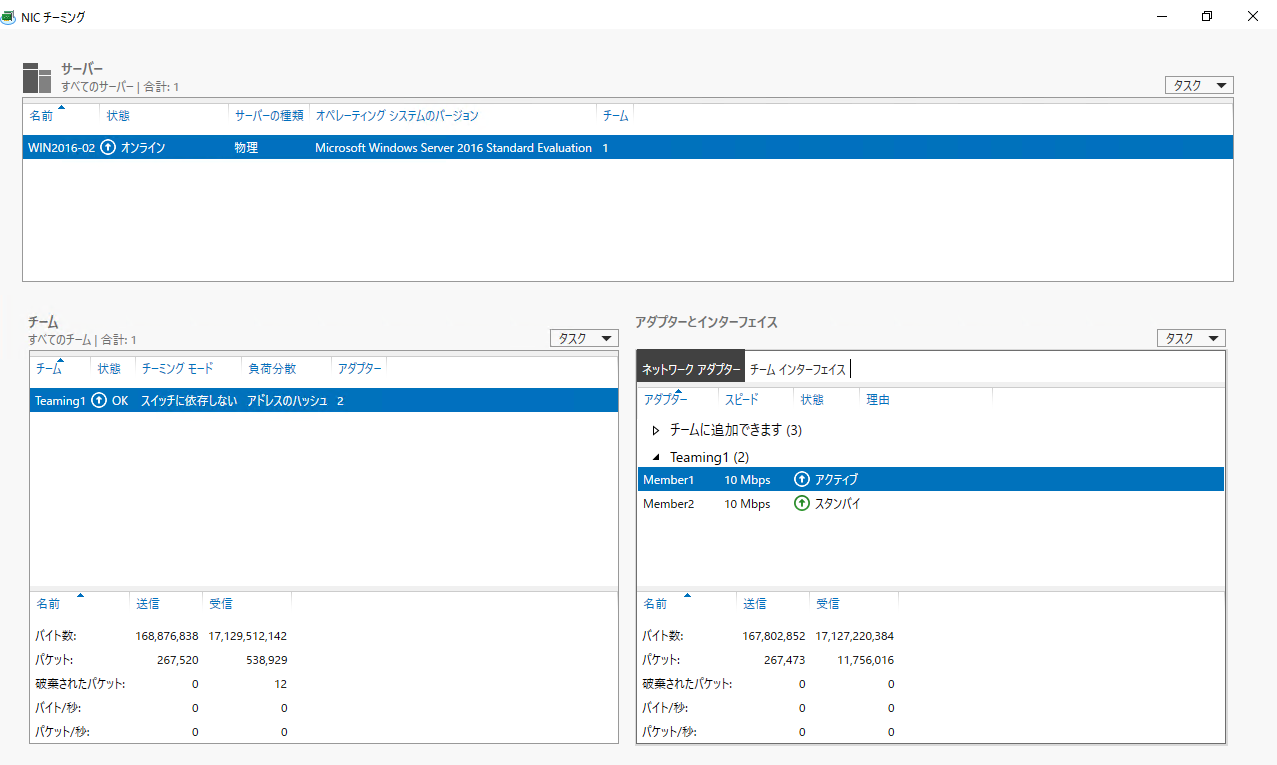

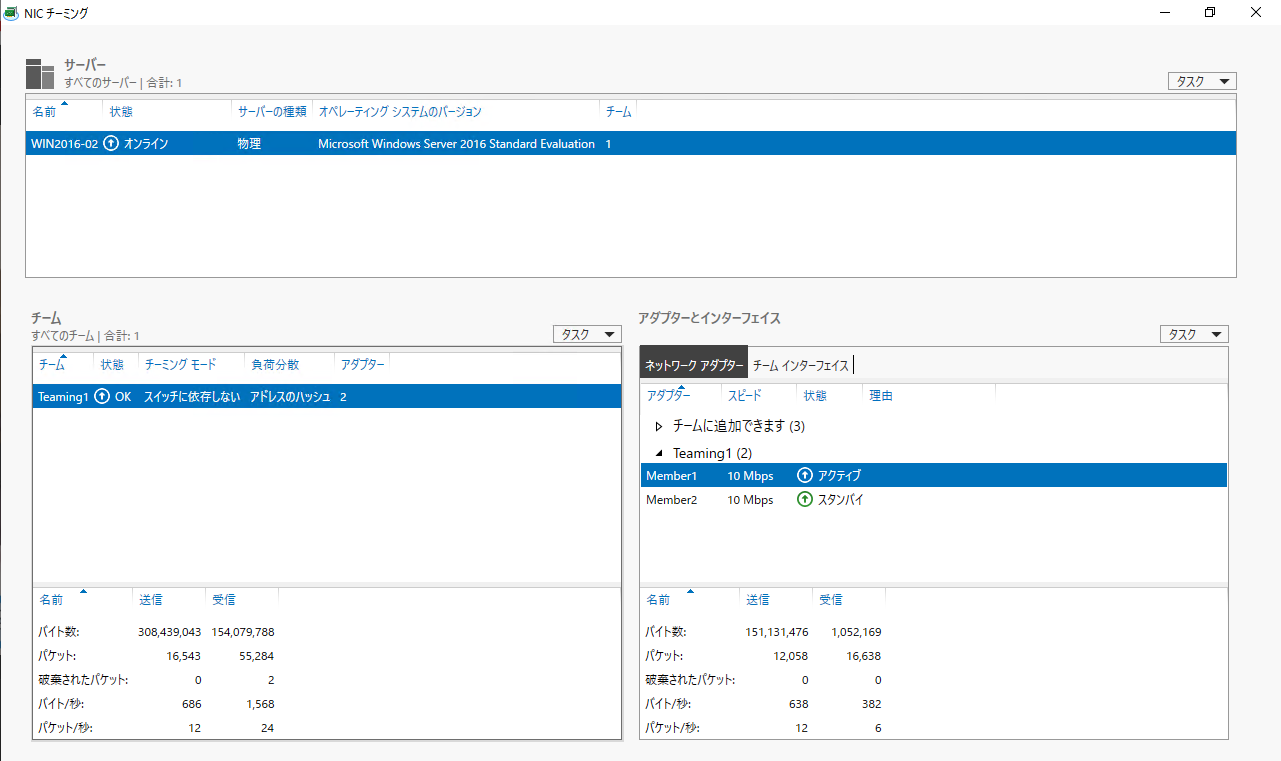

④[NICチーミング]にて、チーミングアダプタが表示されていることを確認します。

なお、設定完了までにしばらくチームおよびアダプターとインターフェース内にエラーが表示されますが、1分程度まてば解消されます。

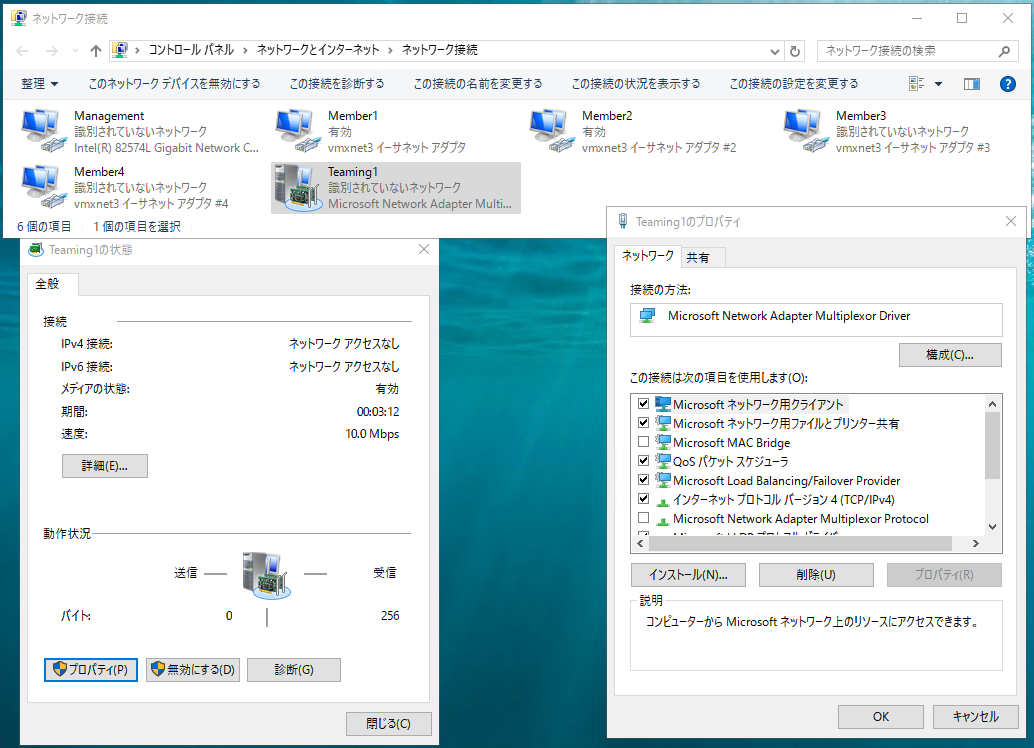

IPアドレス等の設定は、アダプタ画面から通常の物理ポートと同様に設定が出来ます。

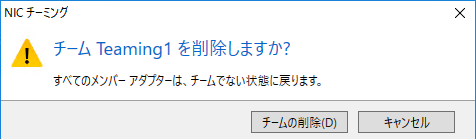

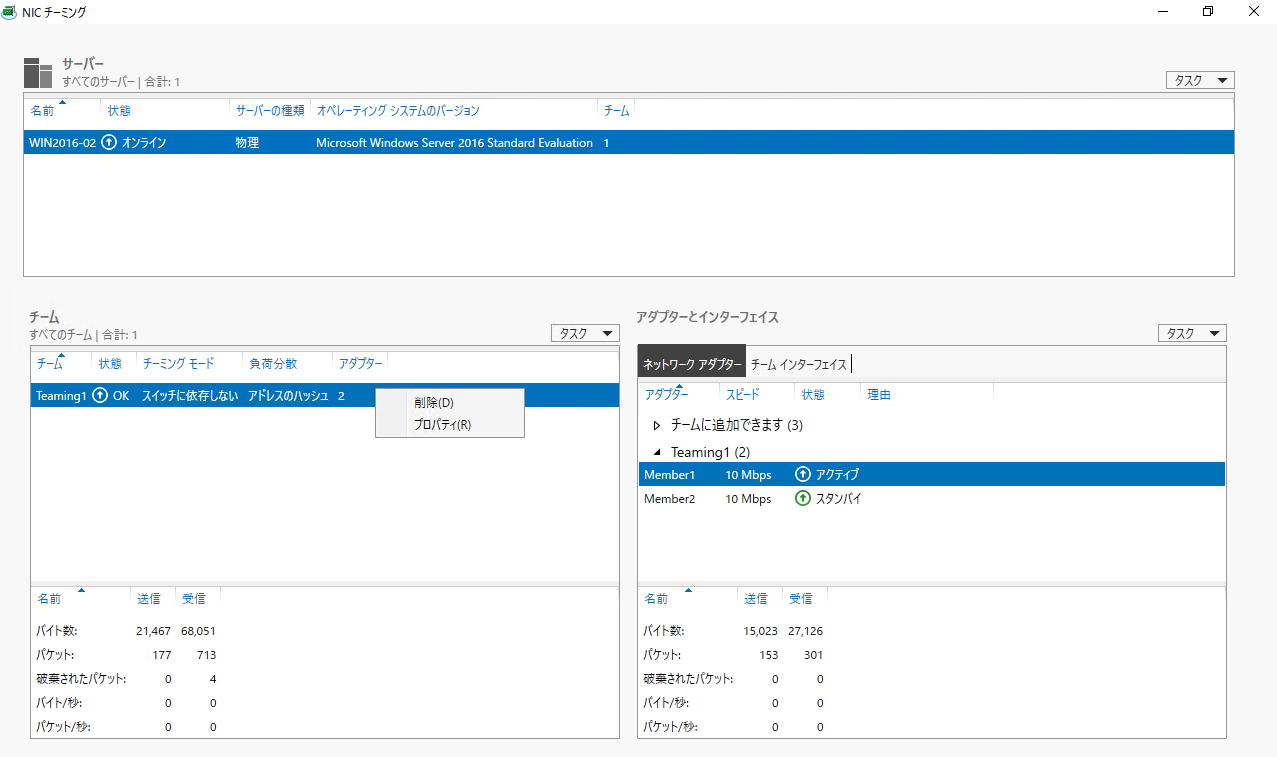

⑤チーミングアダプタを削除する場合、[チーム]の[(チーミングアダプタ)]を右クリックし、[削除]を選択します。

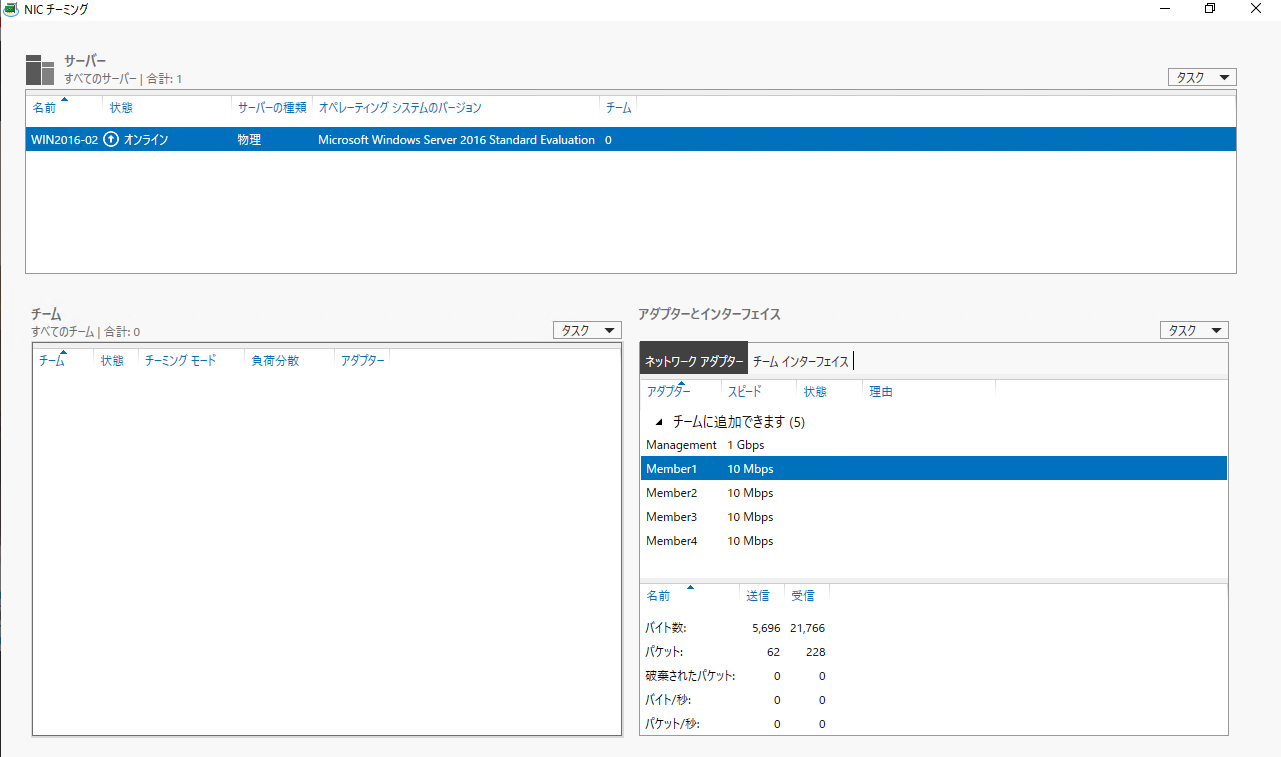

⑦[NICチーミング]にて、チーミングアダプタが表示されていないことを確認します。

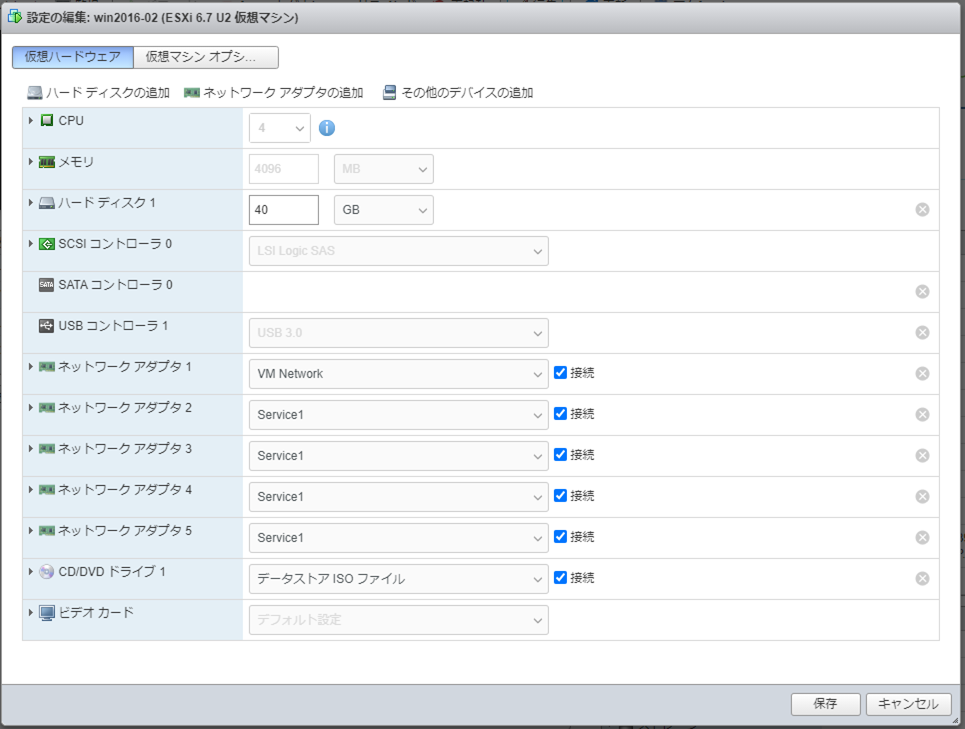

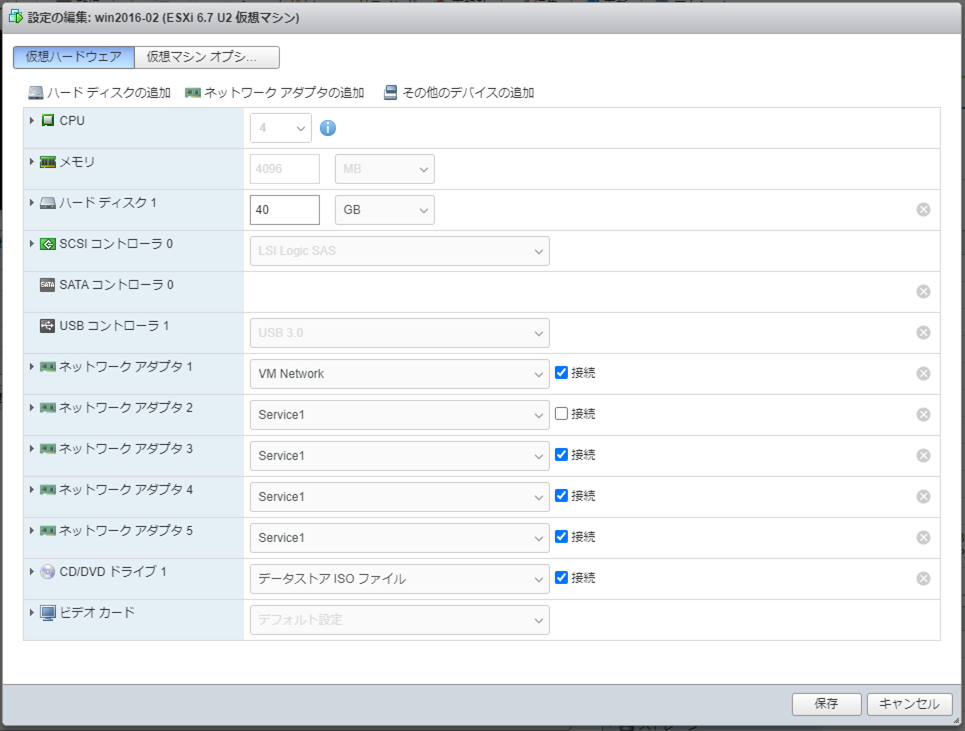

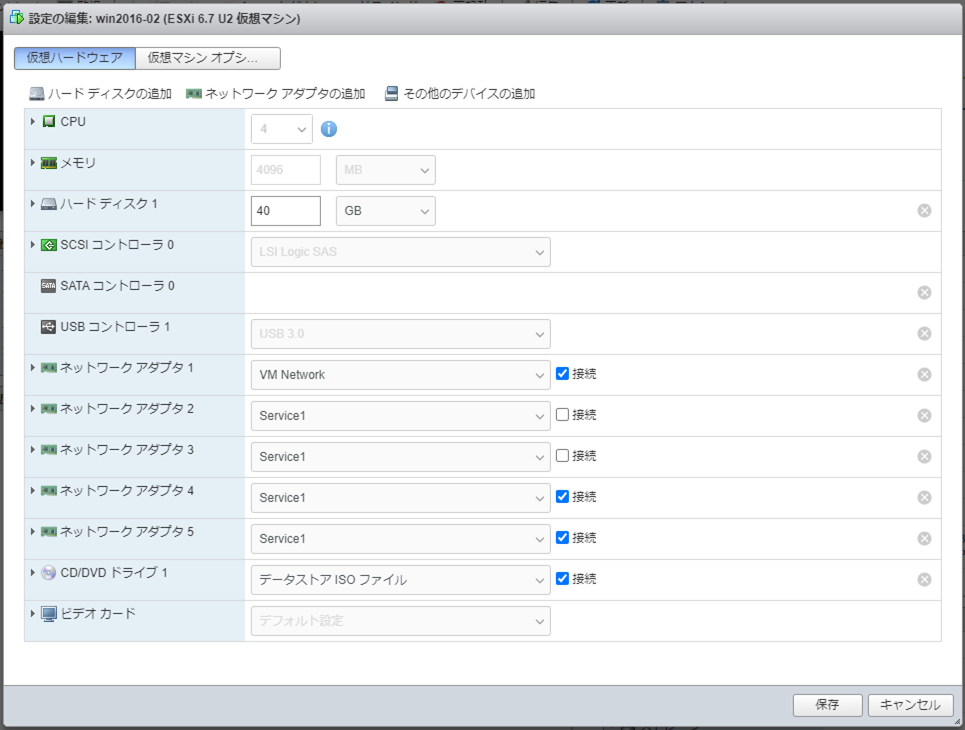

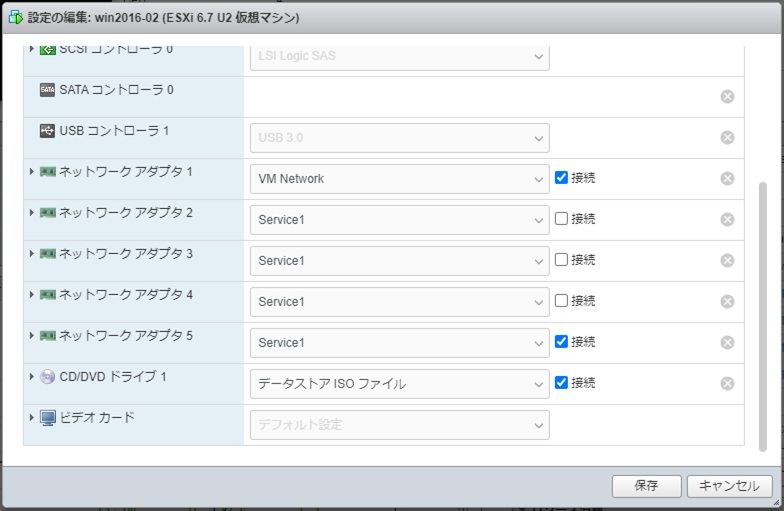

Link-Aggregation構成の設定

以下の物理ポートを利用し、チーミングアダプタを作成します。

Member1: Active側のメンバー物理ポート。10Mbps。

Member2: Active側のメンバー物理ポート。10Mbps。

Member3: Active側のメンバー物理ポート。10Mbps。

Member4: Active側のメンバー物理ポート。10Mbps。

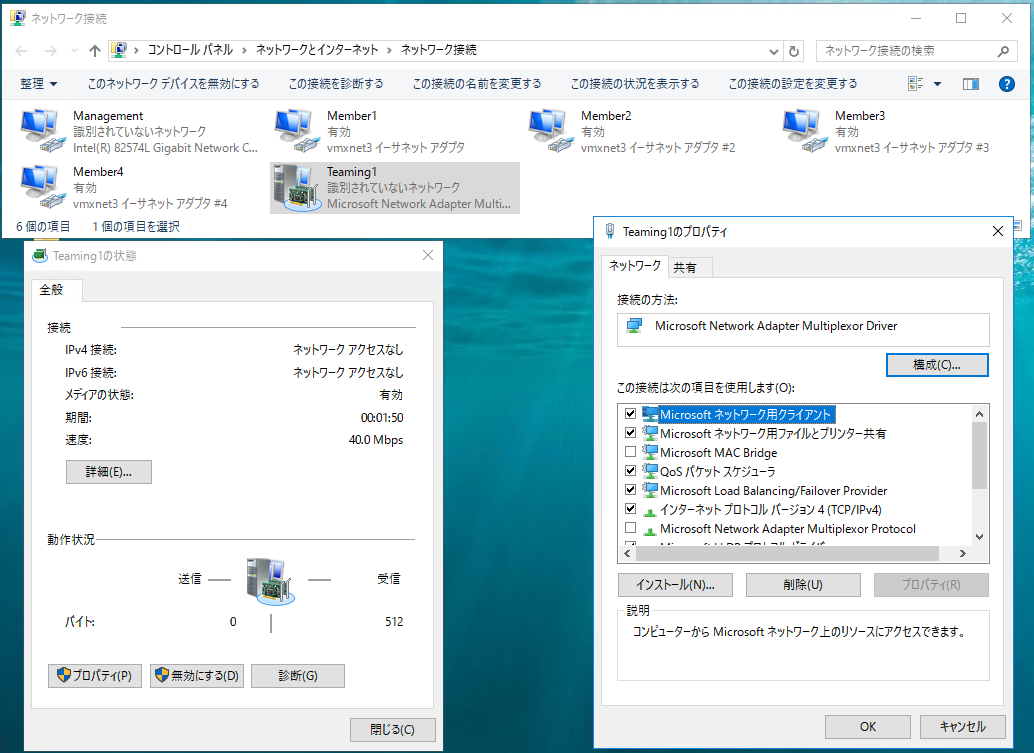

Teaming1: チーミングアダプタ。40Mbps。

①[サーバーマネージャ]を起動し、[ローカルサーバー]の[NICチーミング] - [無効(または有効)]を選択します。

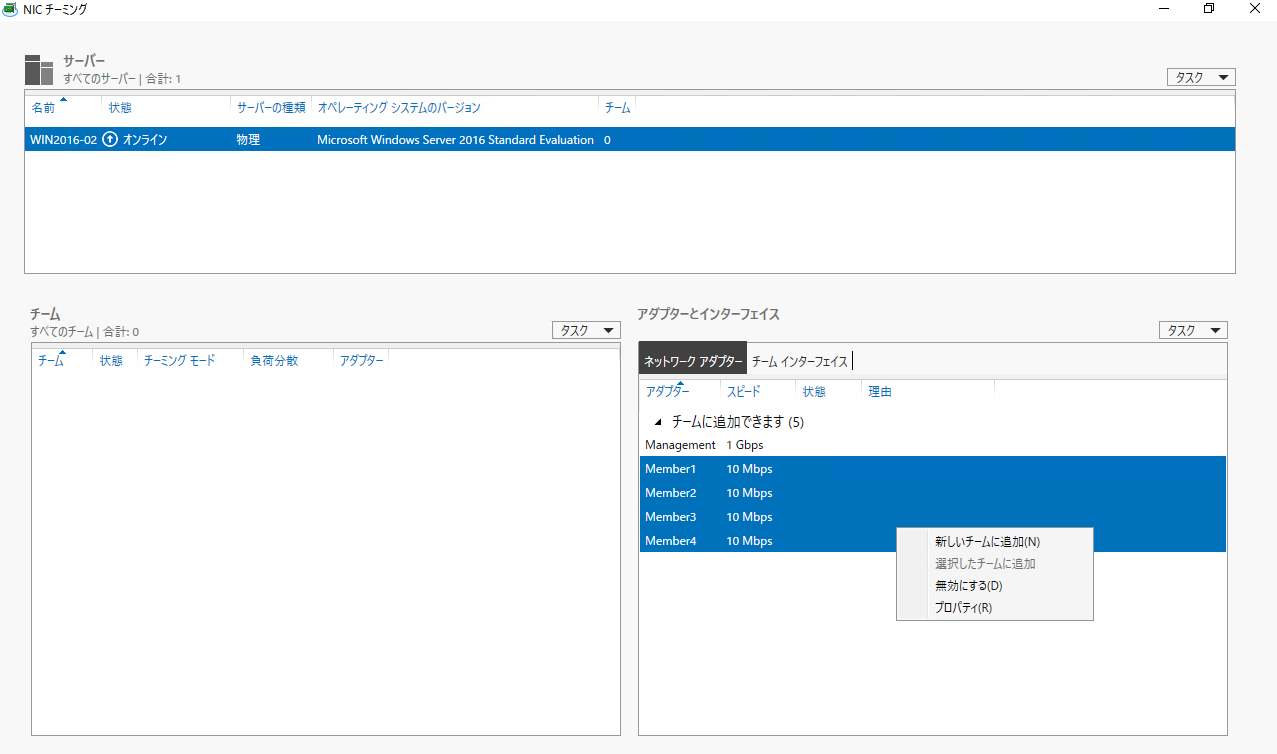

②[NICチーミング]の[アダプターとインターフェース]からチーミングのメンバーとなる物理アダプタを複数選択し、右クリックして[新しいチームに追加]を選択します。

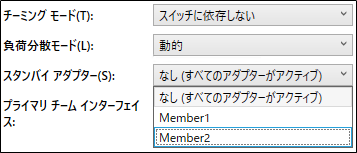

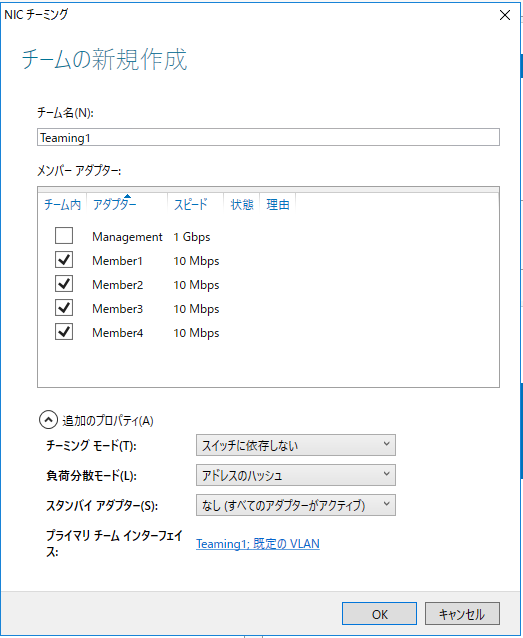

③[チームの新規作成]から各種設定を投入し、[OK]を押下します。

・チーム名 Teaming1

・メンバーアダプタ Member1,Member2,Member3,Member4

・チーミングモード スイッチに依存しない

・負荷分散モード アドレスのハッシュ

・スタンバイアダプター なし(すべてのアダプターがアクティブ)

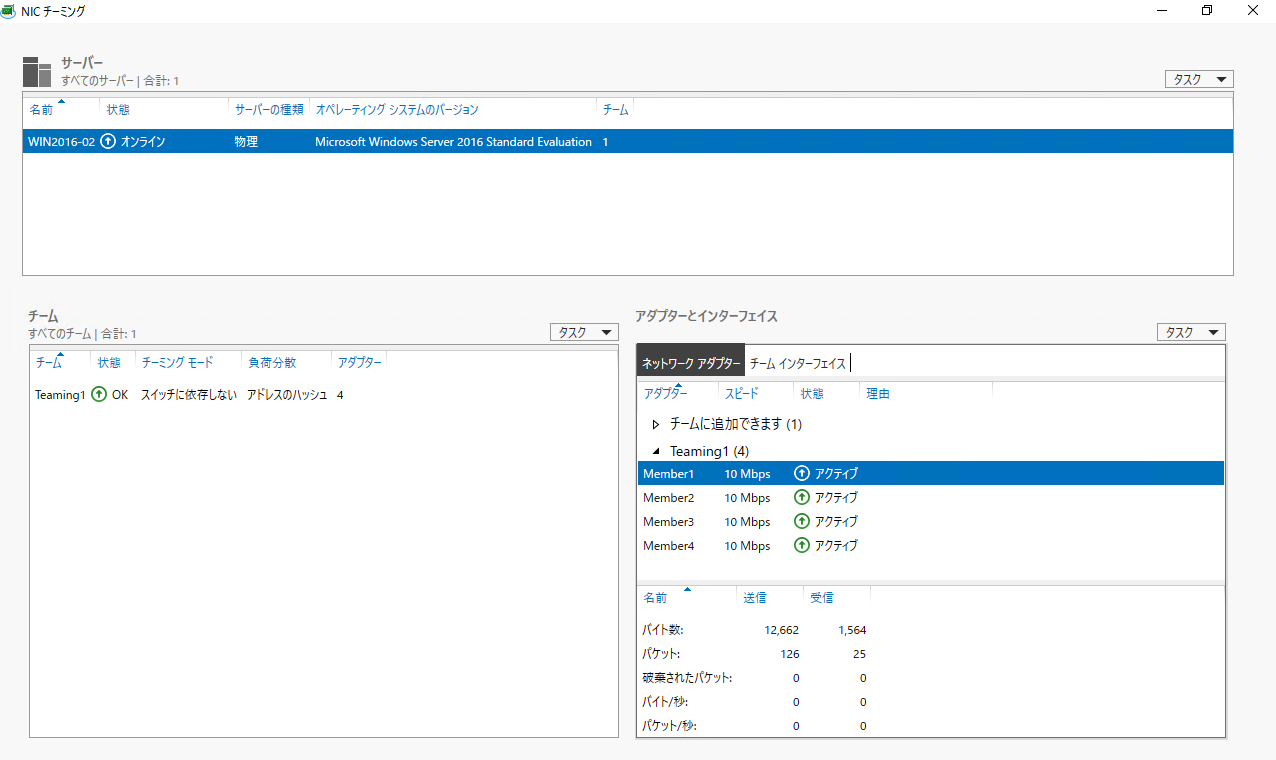

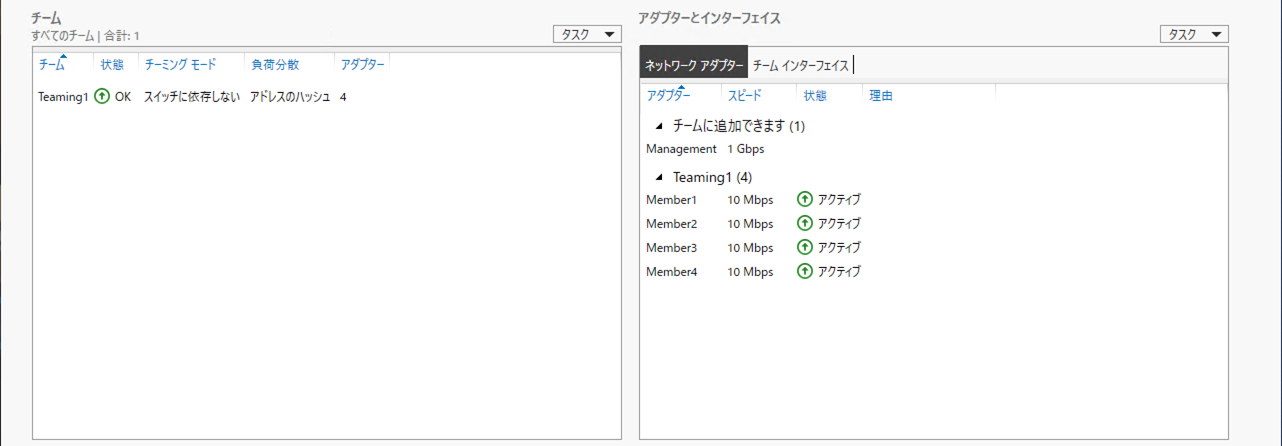

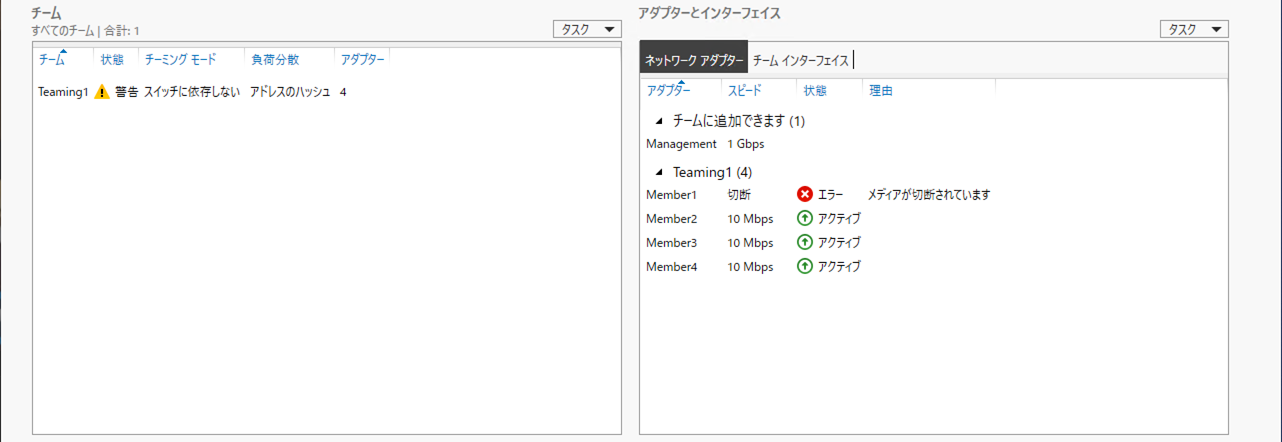

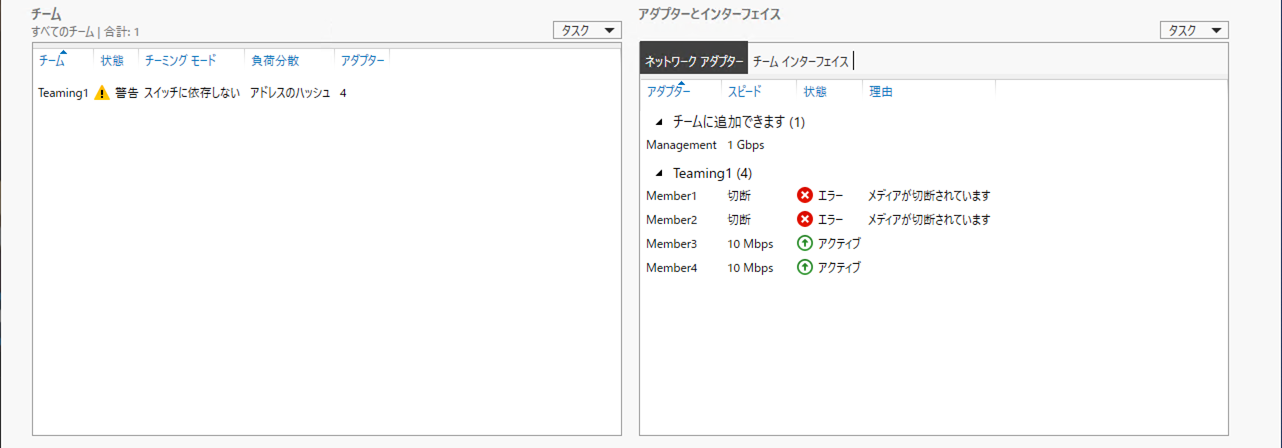

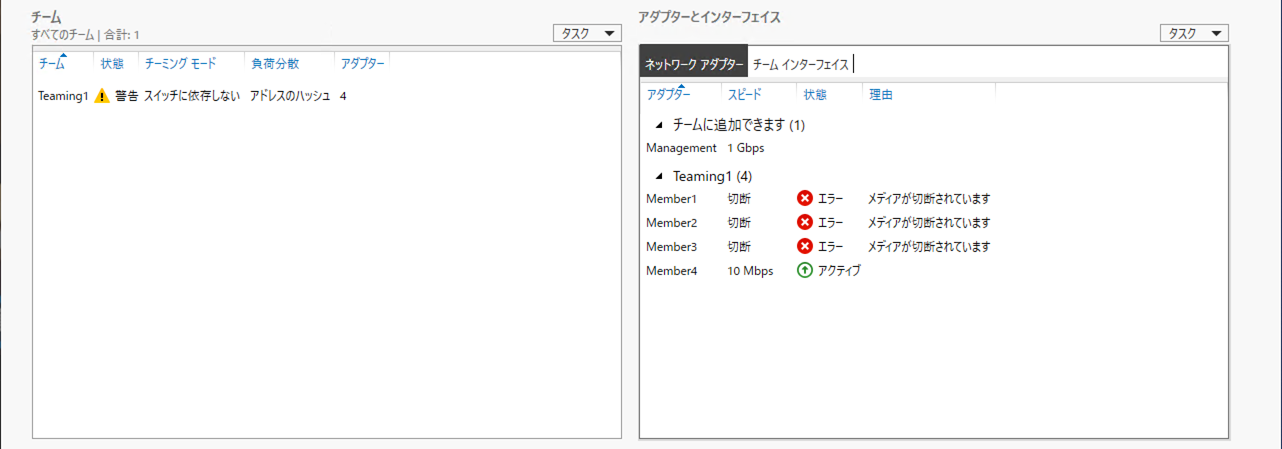

④[NICチーミング]にて、チーミングアダプタが表示されていることを確認します。

なお、設定完了までにしばらくチームおよびアダプターとインターフェース内にエラーが表示されますが、1分程度まてば解消されます。

IPアドレス等の設定は、アダプタ画面から通常の物理ポートと同様に設定が出来ます。

また、10Mbpsの物理ポートを4本束ねているため、40.0 Mbpsと表示されています。

(補足)Active/Standby構成のstandby数について

Active/Standby構成にて、設定できるstandby数は1となります。

詳細は以下にて。

(記事作成中)

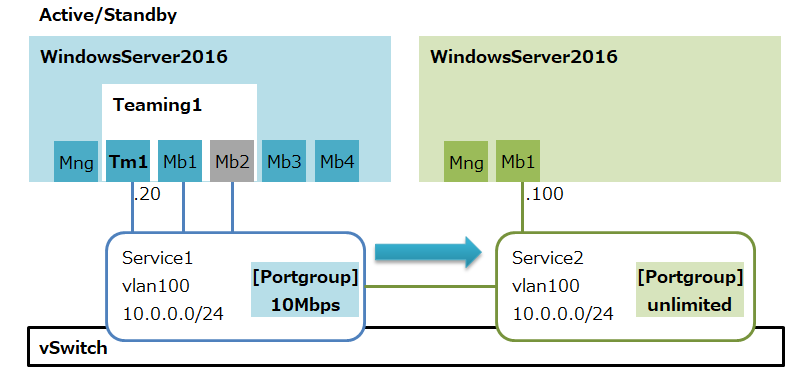

動作確認(Active/Standby構成)

以下の3パターンについて動作確認します。

①通常時(Active)

②切断時(Standby→Active)

③復旧時(Error→Active)

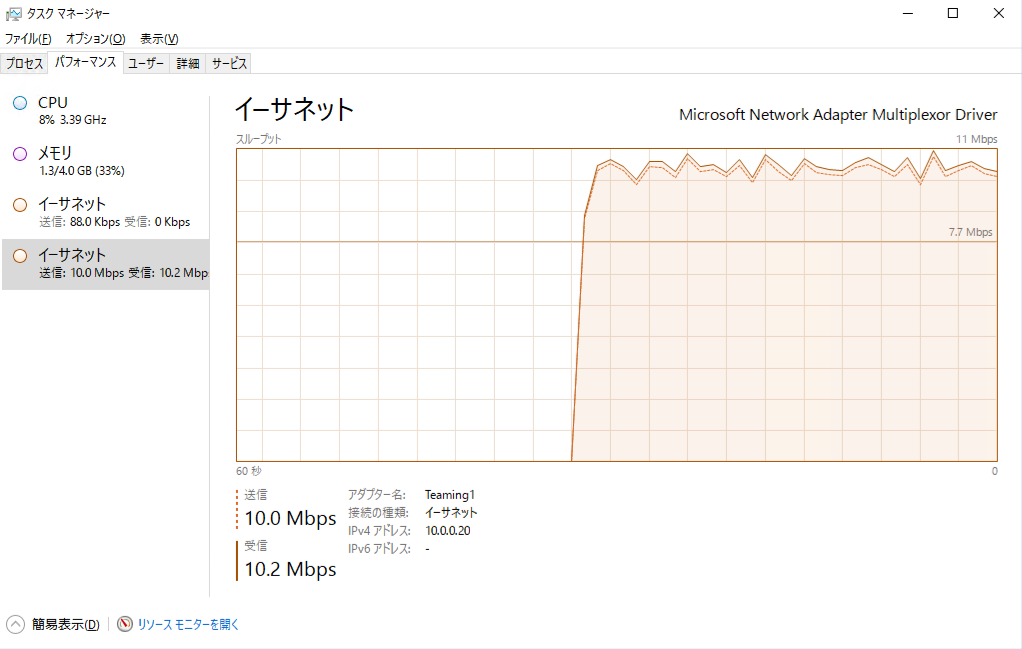

①通常時(Active)

通常時の確認をします。Active側の物理ポートが利用されます。

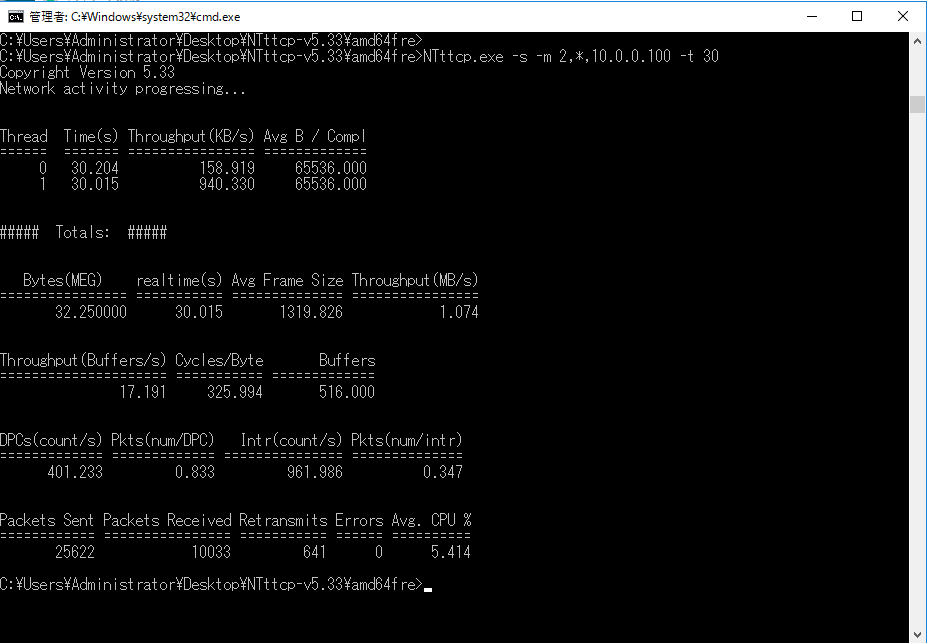

疎通確認/帯域量確認にはNTttcpにて行います。

Microsoft NTttcpを利用したNW帯域幅/スループットの測定(Windows)

https://qiita.com/Higemal/items/93af04f9bbdc8b681c0b

NIC:Member1:Active

NIC:Member2:Standby

ThroughtPut:1.074(MB/s)≒8.6Mbps

画面確認結果はここを展開

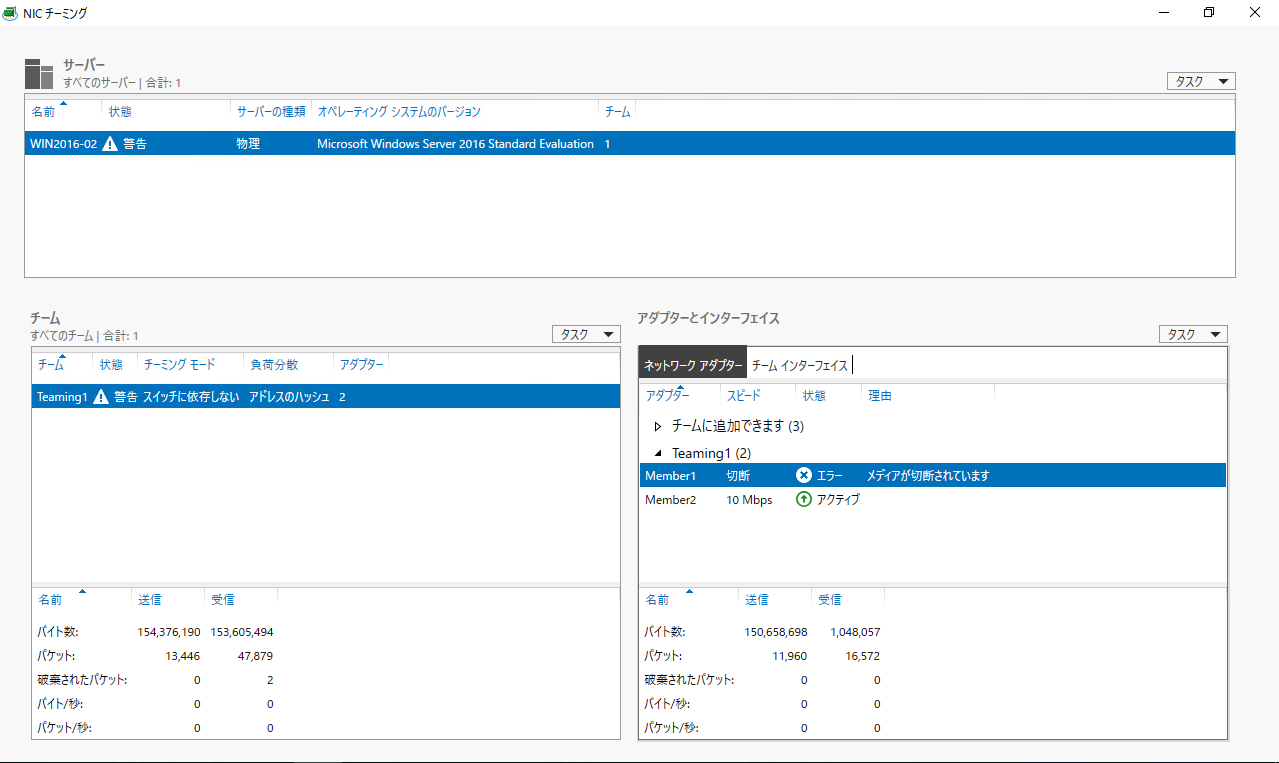

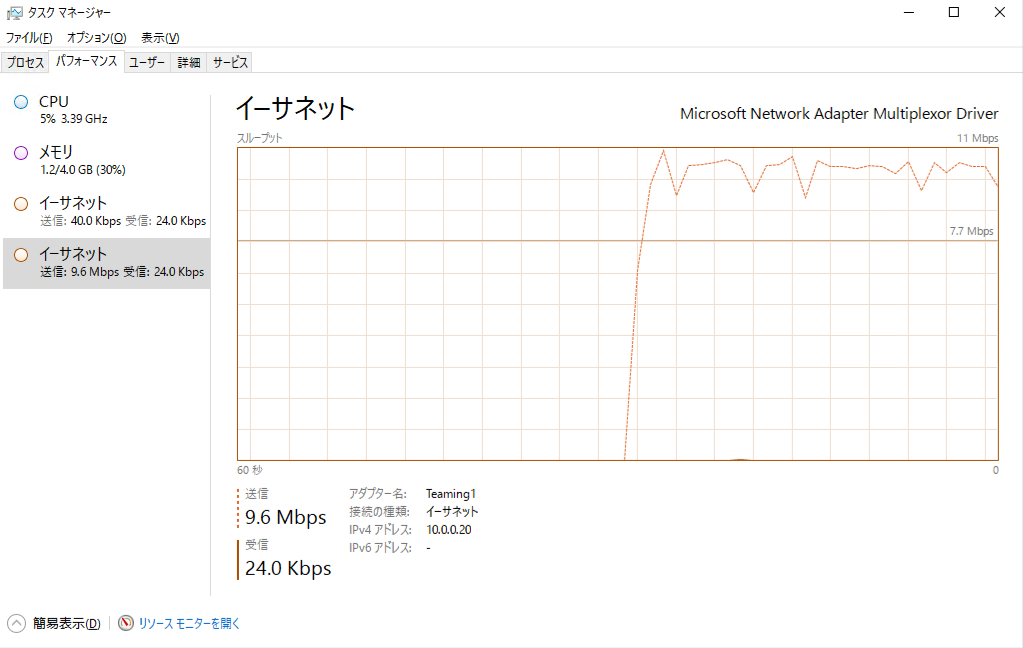

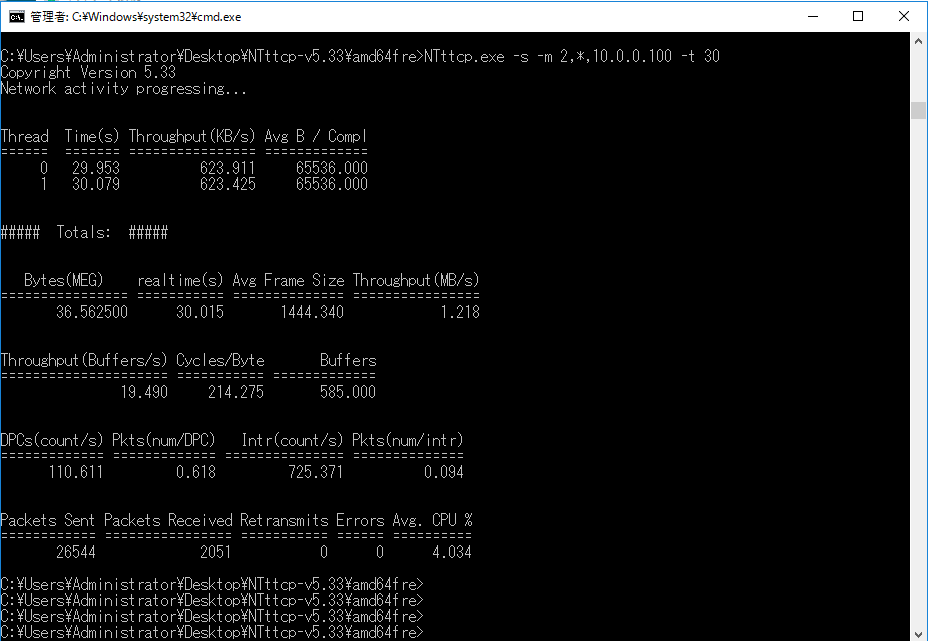

②切断時(Standby→Active)

NIC:Member2をvmware esxi側から切断しました。

NIC:Member1:Error(切断)

NIC:Member2:Standby->Active

ThroughtPut:1.218(MB/s)≒9.7Mbps

画面確認結果はここを展開

vmware esxi側からnicを切断    ③復旧時(Error→Active)

NIC:Member2をvmware esxi側から再接続しました。

NIC:Member1:Error->Active

NIC:Member2:Active->Standby

画面確認結果はここを展開

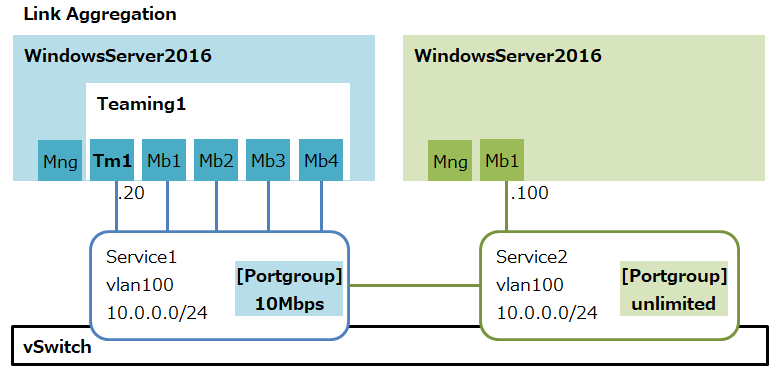

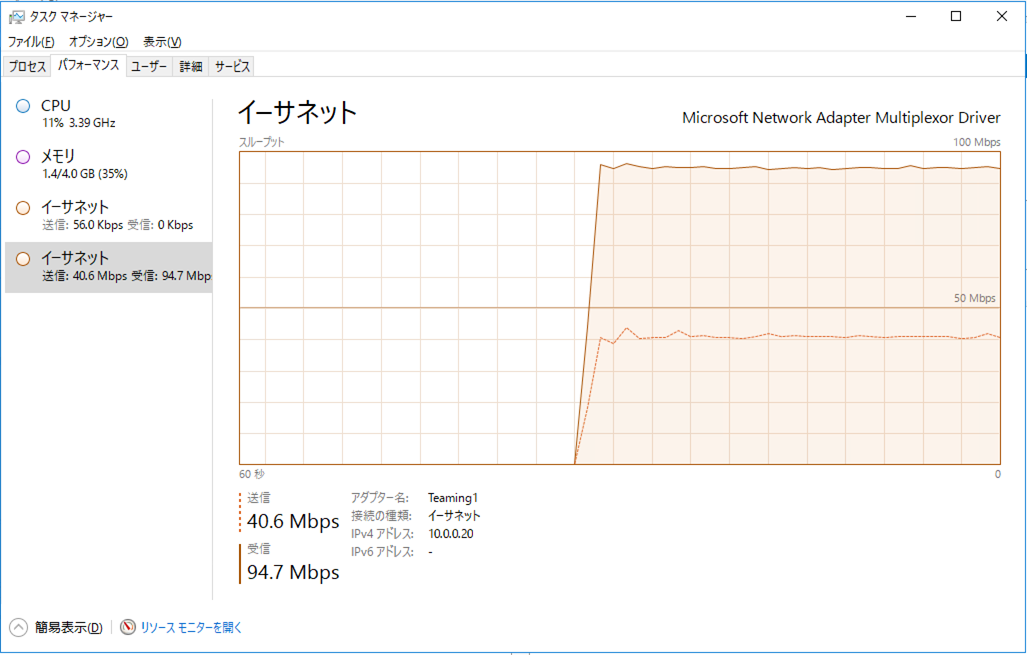

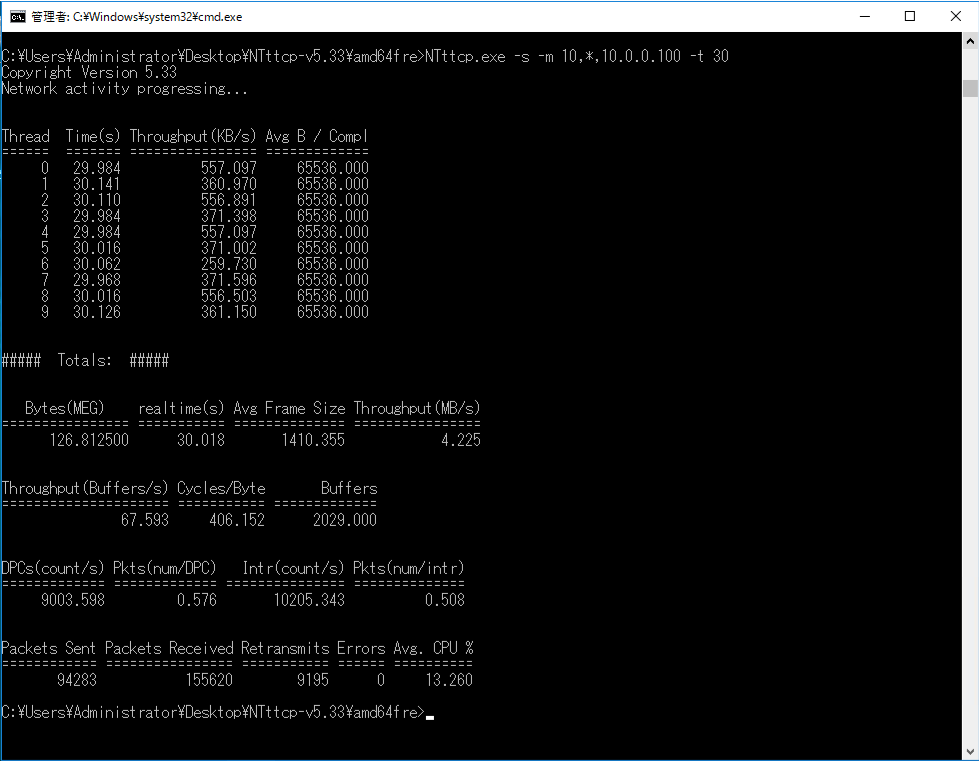

動作確認(Link-Aggregation構成)

以下の4パターンについて動作確認します。

①通常時(4-Active)

②切断時(3-Active)

③切断時(2-Active)

④切断時(1-Active)

10MbpsのNICを4個Link-Aggregationしているため、

最大40Mbpsが出る設定となります。

疎通確認/帯域量確認にはNTttcpにて行います。

Microsoft NTttcpを利用したNW帯域幅/スループットの測定(Windows)

https://qiita.com/Higemal/items/93af04f9bbdc8b681c0b

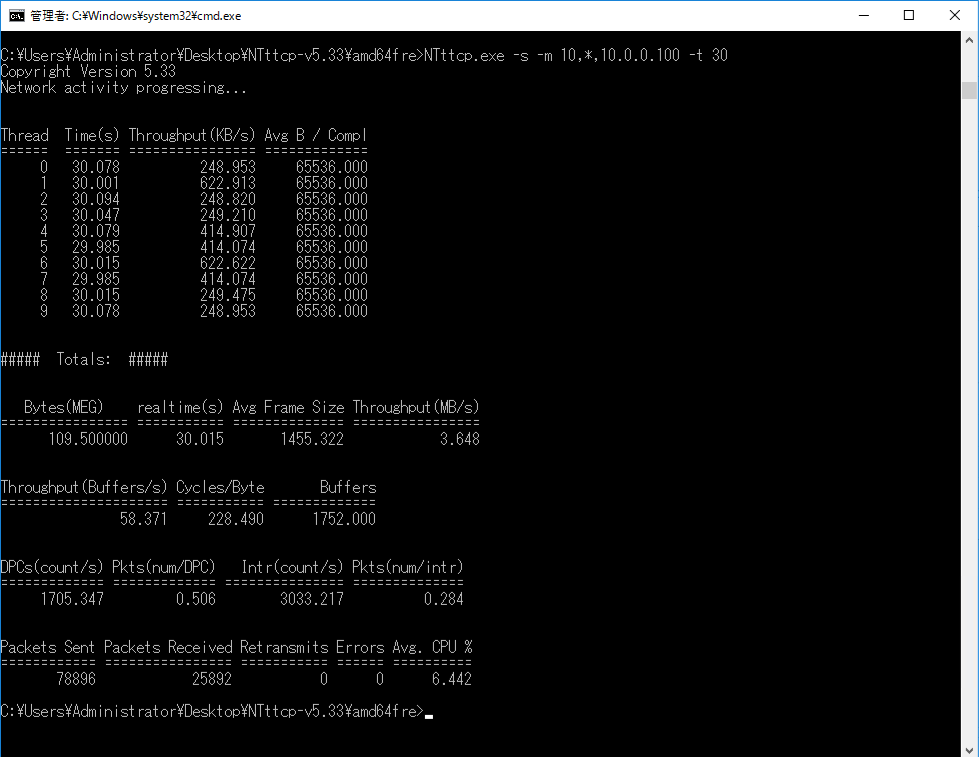

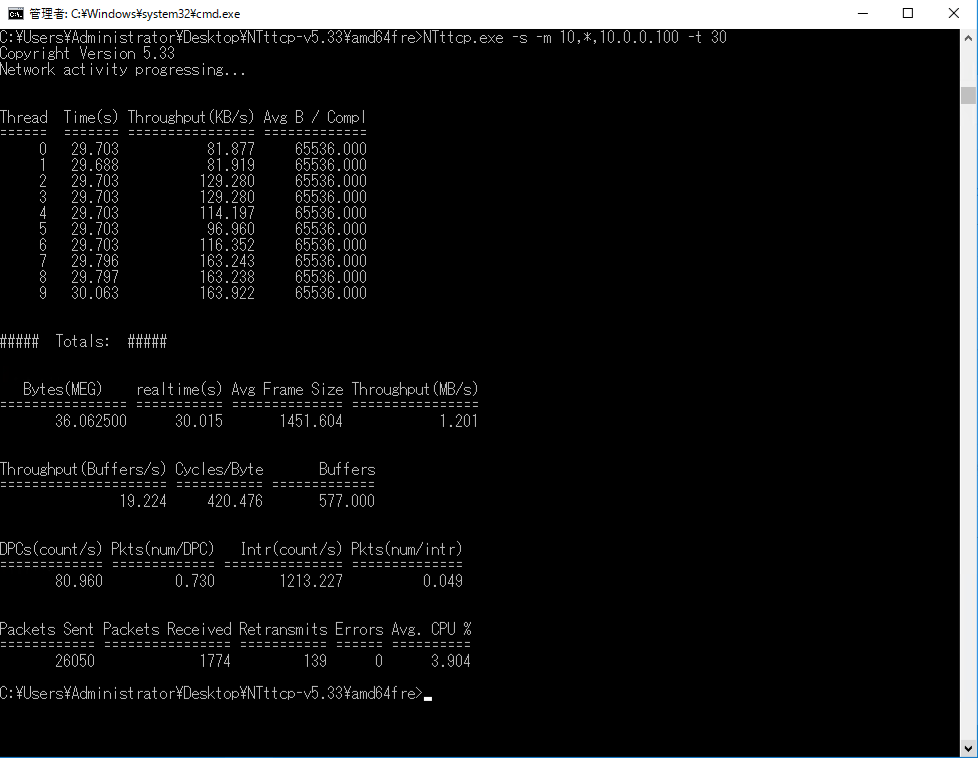

なお、複数NICを利用するため、以下の設定を行っています。

・NICごとに並列処理するためCPU-Coreは4コア

・処理多重度をNIC以上にするため、NTttcpの多重度は10

結論

長くなるので、先に結論のみ記載します。

| Test Type | NIC Speed | Throught Put | Throught Put |

|---|---|---|---|

| 4-Active | 40 Mbps | 4.225 MBps | 33.8 Mbps |

| 3-Active | 30 Mbps | 3.648 MBps | 29.2 MBps |

| 2-Active | 20 Mbps | 2.439 MBps | 19.5 MBps |

| 1-Active | 10 Mbps | 1.201 MBps | 9.6 Mbps |

①通常時(4-Active)

通常時の確認をします。4つのNICがActiveとして利用されます。

NIC:Member1:Active

NIC:Member2:Active

NIC:Member3:Active

NIC:Member4:Active

ThroughtPut:4.225(MB/s)≒33.8Mbps

※何回か試行しましたが、40Mbpsまでは出ませんでした。

画面確認結果はここを展開

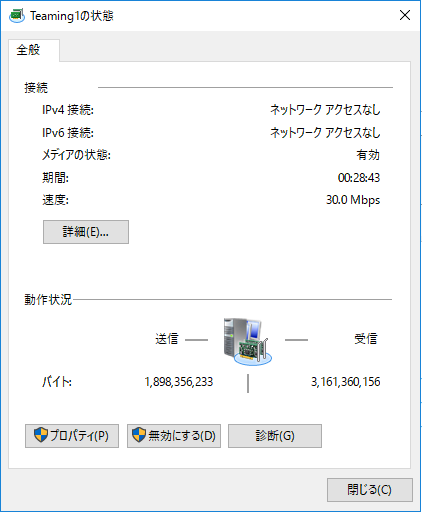

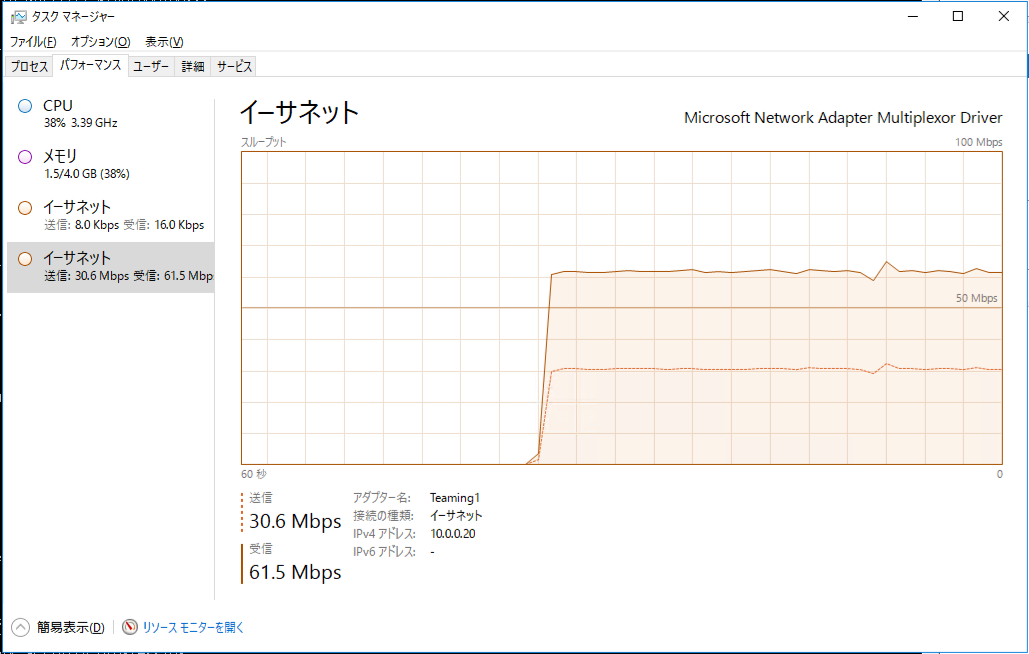

②切断時(3-Active)

NIC:Member1をvmware esxi側から切断しました。

NIC:Member1:Active->Standby

NIC:Member2:Active

NIC:Member3:Active

NIC:Member4:Active

ThroughtPut:3.648(MB/s)≒29.2Mbps

画面確認結果はここを展開

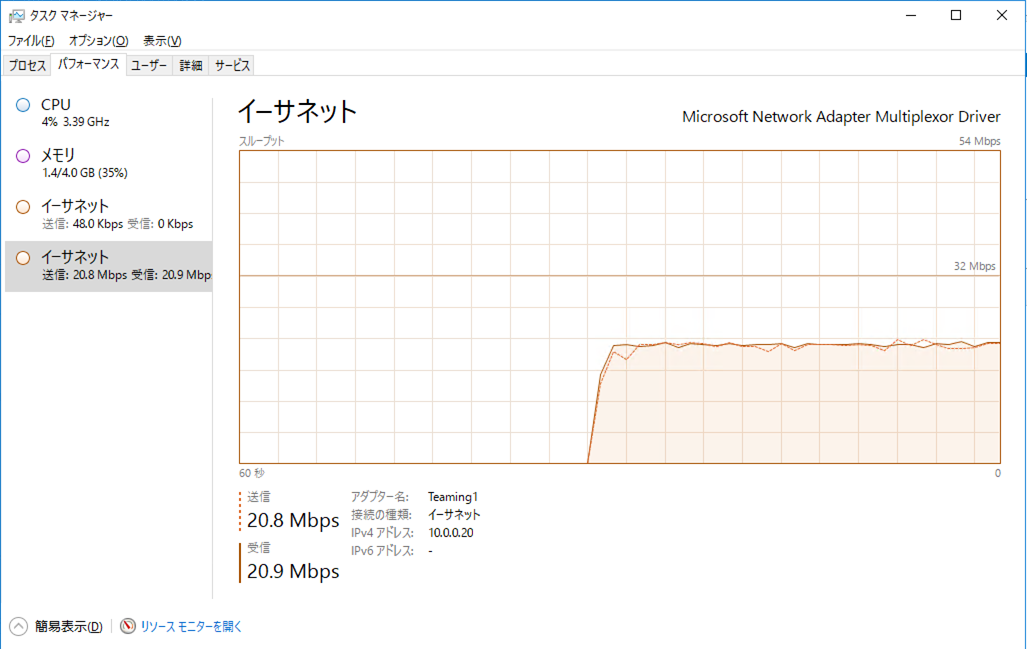

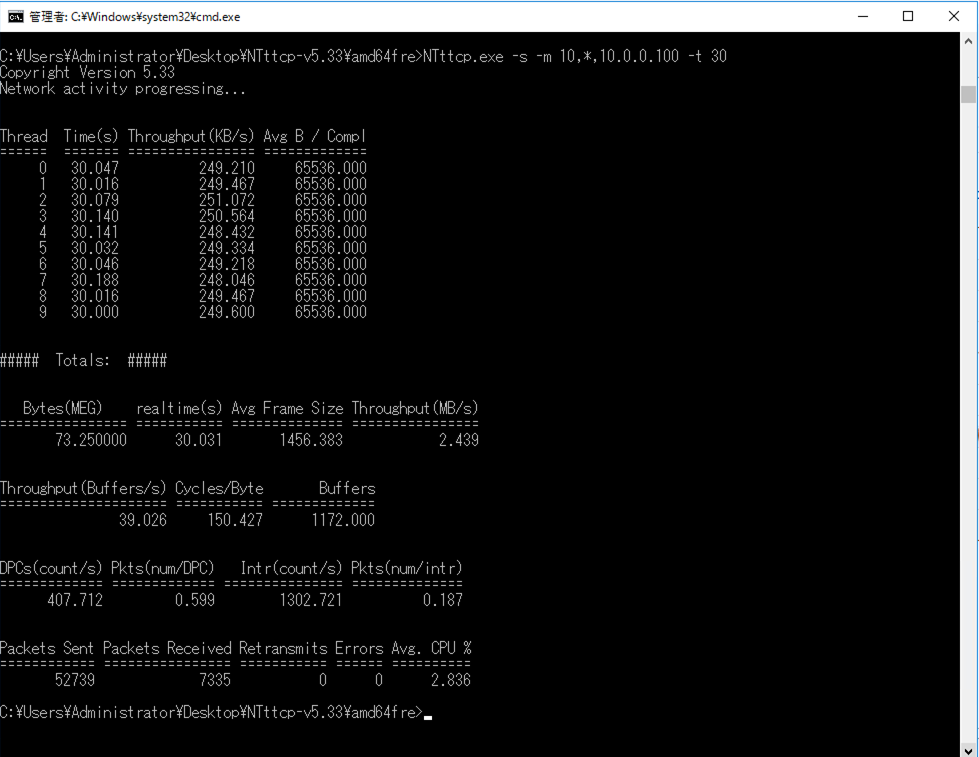

③切断時(2-Active)

NIC:Member2をvmware esxi側から切断しました。

NIC:Member1:Standby

NIC:Member2:Active->Standby

NIC:Member3:Active

NIC:Member4:Active

ThroughtPut:2.439(MB/s)≒19.5Mbps

画面確認結果はここを展開

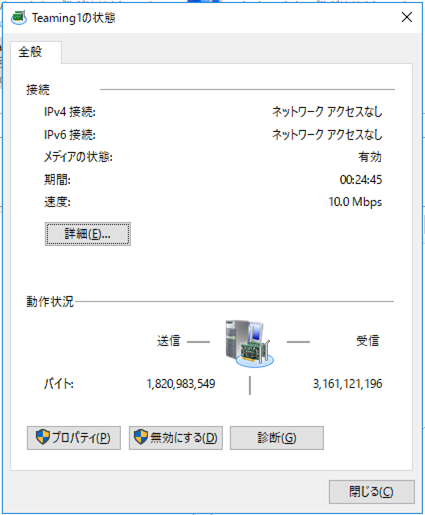

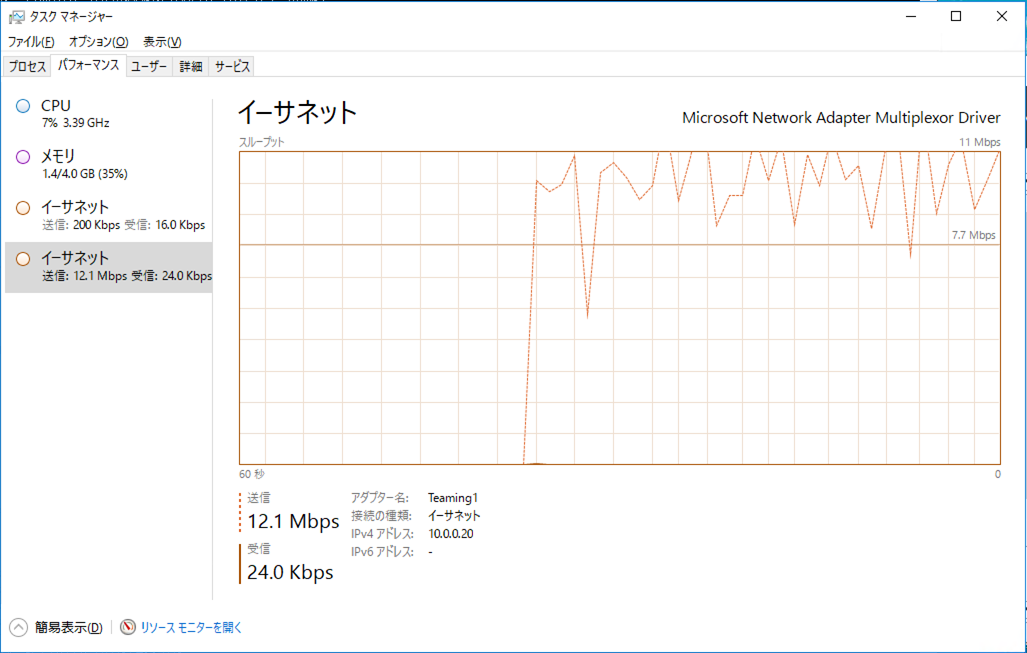

④切断時(1-Active)

NIC:Member3をvmware esxi側から切断しました。

NIC:Member1:Standby

NIC:Member2:Standby

NIC:Member3:Active->Standby

NIC:Member4:Active

ThroughtPut:1.201(MB/s)≒9.6Mbps

画面確認結果はここを展開

参考

Windows 2016/2019チーミング設定とスイッチ側リンクアグリゲーション設定の組合せについて

https://milestone-of-se.nesuke.com/nw-basic/link-aggregation/windows-teaming-and-switch-config/

NIC チーミングの設定

https://docs.microsoft.com/ja-jp/windows-server/networking/technologies/nic-teaming/nic-teaming-settings

Windows Server 2019/2016/2012R2 OS標準NIC チーミング(LBFO)設定ガイド

https://jp.fujitsu.com/platform/server/primergy/technical/construct/pdf/win2016-2012r2-lbfo-guide.pdf