はじめに

ここ数年、AIによる音声認識技術は目覚ましい進化を遂げています。しかし、英語や中国語に比べ、日本語の文字起こしは今も選択肢が限られています。Whisperが登場してから時間が経ったものの、2025年の今も「結局Whisperが一番」と感じている方も多いのではないでしょうか。

実際のところ、最新のWhisper各モデルはどこまで実用的なのでしょうか。本記事では、ニュース音声を使った検証を通して、日本語音声転写の“今”を率直に比べてみました。

「日本語の文字起こし、どれを選べばいい?」と悩んでいる方の参考になれば幸いです。

日本語文字起こしの現状と多言語との違い

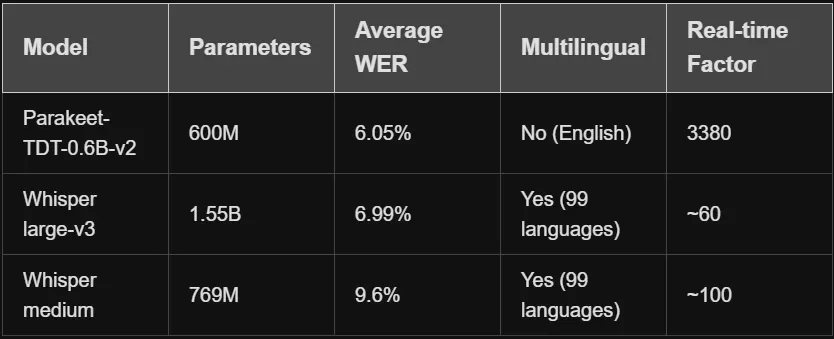

近年、音声認識(ASR)技術は英語や中国語を中心に急速に進化しています。たとえば英語では、NVIDIAの「Parakeet」など最新の高精度モデルが登場し、リアルタイムかつ高精度な文字起こしが現実となっています。一方で、中国語も大手IT企業によるASRサービスが一般化しています。

しかし、日本語では現状まだ英語や中国語ほどの選択肢がありません。Google Cloud Speech-to-TextやAmazon Transcribeなどの商用APIも日本語に対応していますが、英語ほどの精度や柔軟性は期待できません。NVIDIA Parakeetも日本語対応はされていません。

こうした中、多言語対応を強みとするOpenAIのWhisperは、日本語の文字起こし分野でも広く使われています。近年はWhisperベースの日本語特化モデルも増えつつありますが、全体としては「Whisper一強」と言える状況が続いています。

つまり、「日本語の高精度文字起こし」を求める現場では、2025年になった今もWhisper系モデルがほぼ唯一の有力な選択肢です。

今回評価対象のモデル・実装概要

モデル紹介と特徴

Whisper large-v3

OpenAIが開発した多言語対応の音声認識モデル。高精度だが、処理速度は他モデルに比べて遅め。完全なfaster-whisper APIをサポートし、beam_sizeやtemperatureなどの高度なパラメータで精度を細かく制御可能。

WhisperX

Whisperをベースに、長時間音声の処理や単語レベルのタイムスタンプ取得を可能にしたモデル。VAD(Voice Activity Detection)や強制アライメントを活用し、長時間音声の精度向上と高速化を実現。ただし、APIは簡素化されており、高度なパラメータは制限される。

kotoba-whisper-v2.0-faster (記事内ではv2.2も言及あり、ここではv2.0-fasterとして記載)

日本語特化の音声認識モデル。Whisper large-v3を蒸留し、約6.3倍の高速化を実現しつつ、精度も維持。日本語話者特化のリソースであるReazonSpeechを用いて訓練されている。完全なfaster-whisper APIをサポート。

(記事の後半で kotoba-whisper-v2.2-faster の言及とコード例があるため、そちらを優先し以下で修正します)

kotoba-whisper-v2.2-faster

日本語特化の音声認識モデル。Whisper large-v3を蒸留し高速化。日本語話者特化のリソースであるReazonSpeechを用いて訓練されている。完全なfaster-whisper APIをサポート。

コアコードの抜粋とパラメータの違い

Whisper large-v3(faster-whisperを使用)

from faster_whisper import WhisperModel

import time

# モデル初期化

model = WhisperModel("large-v3", device="cuda", compute_type="float16")

# 転写実行

start_time = time.time()

segments, info = model.transcribe(

"audio.wav",

language="ja", # 日本語指定

beam_size=10, # 高精度推論

temperature=0.0, # 確定的デコーディング

vad_filter=True, # VAD有効化

vad_parameters=dict(

min_silence_duration_ms=1000, # 1秒静音で分割

threshold=0.6 # VAD感度

)

)

# 重複除去

merged_segments = []

prev_text = ""

for segment in segments:

if segment.text != prev_text:

merged_segments.append(segment)

prev_text = segment.text

# 結果出力

processing_time = time.time() - start_time

speed_ratio = info.duration / processing_time

print(f"処理速度: {speed_ratio:.1f}x実時間")

特徴:

-

beam_size=10:高精度な推論を実現 -

temperature=0.0:確定的デコーディング -

vad_filter=True:音声活動検出で精度向上 - 完全なfaster-whisper APIサポート

WhisperX

import whisperx

import torch

import time

device = "cuda" if torch.cuda.is_available() else "cpu"

model = whisperx.load_model("large-v3", device, compute_type="float16")

start_time = time.time()

audio = whisperx.load_audio("audio.wav")

result = model.transcribe(

audio,

batch_size=6, # 小バッチ処理

language="ja" # 日本語指定

)

processing_time = time.time() - start_time

print(f"処理時間: {processing_time:.2f}秒")

特徴:

-

batch_size=6:小バッチ処理で速度・精度バランス良好 - WhisperのVAD・アライメントにより長時間音声も安定

- 分割粒度が自然で、会話・ニュースに強い

- 注意点:

beam_sizeやtemperatureは指定不可

kotoba-whisper-v2.2-faster

from faster_whisper import WhisperModel

import time

# モデル初期化

model = WhisperModel(

"RoachLin/kotoba-whisper-v2.2-faster",

device="cuda",

compute_type="float32" # 日本語特化モデルはfloat32推奨

)

# 転写実行

start_time = time.time()

segments, info = model.transcribe(

"audio.wav",

language="ja", # 日本語指定

beam_size=10, # 高精度推論

condition_on_previous_text=False, # 幻覚抑制

chunk_length=10 # 10秒チャンク処理

)

# 結果処理

segments_list = list(segments)

processing_time = time.time() - start_time

speed_ratio = info.duration / processing_time

print(f"処理速度: {speed_ratio:.1f}x実時間")

print(f"セグメント数: {len(segments_list)}")

特徴:

- 日本語特化モデル(ReazonSpeech訓練)

- 最高速度(20.7x実時間)

- 完全なfaster-whisper APIサポート

- 注意:精度は汎用モデルより劣る場合あり

モデルのインストール

Whisper large-v3

pip install faster-whisper

# 依存関係(必要に応じて):

# sudo apt install ffmpeg # Linux

# brew install ffmpeg # macOS

WhisperX

pip install whisperx

# または開発版:

# pip install git+https://github.com/m-bain/whisperx.git

# GPU使用時の追加依存関係(エラーが出る場合):

# sudo apt install libcudnn8 libcudnn8-dev # Linux

kotoba-whisper-v2.0-faster

pip install faster-whisper

# モデルは初回実行時に自動ダウンロード

注意事項

- WhisperXは高速化に特化しているため、精度制御のパラメータが制限されています

- GPU環境では、CUDAとcuDNNの互換性を確認してください

- kotoba-whisperは日本語特化ですが、実際の性能は汎用モデルを下回る場合があります

評価結果(実験と比較)

前述のコードを使用して、それぞれのモデルで音声ファイルを文字起こし。出力された文字起こし結果を比較し、精度や処理速度を評価。

ニュース素材・評価基準

本検証では、日本の経済ニュース音声データ(対外純資産に関する報道)を使用し、

「原文再現性」「分割の自然さ」「専門語の正確さ」「処理速度」を比較指標として各モデルを評価しました。

実際は複数ニュースでテストしましたが、紙幅の都合でここでは代表的な1本を掲載します。

ニュース原稿

日本が海外に持つ資産から負債を差し引いた「対外純資産」は、去年末時点で533兆円余りと6年連続で過去最高となったものの、ドイツに抜かれ1990年末以来、34年ぶりに世界2位となりました。

「対外純資産」は、日本の政府や企業、それに個人が海外に保有する金融資産となる「対外資産」から、海外の政府などが日本で保有する金融資産である「対外負債」を差し引いたものです。

財務省の発表によりますと、去年末時点での日本の対外資産は1659兆221億円と16年連続で増加しました。

日本企業によるアメリカやオランダなどへの直接投資が増えたほか、外国為替市場で円安が進み、海外で保有する資産を円に換算した際の金額が膨らみました。

また、対外負債は1125兆9721億円と6年連続で増加しました。

その結果、対外純資産は533兆500億円と、おととし末よりも60兆8613億円増えて、6年連続で過去最高を更新しました。

日本の対外純資産は、1991年末からおととし末まで世界一でしたが、円換算でドイツに抜かれ34年ぶりに2位となりました。

円換算による対外純資産は、貿易収支の黒字が続いているドイツが1位の569兆6512億円、日本に次ぐ3位は中国の516兆2809億円でした。

モデル別出力(全セグメント・そのまま)

kotoba-whisper-faster

セグメント 1: [0.00s -> 5.70s] 日本が海外に持つ資産から不採を差し引いた対外巡視産は

セグメント 2: [5.70s -> 9.46s] 去年末時点で533兆円余りと

セグメント 3: [10.00s -> 19.16s] 6年連続で過去最高となったものの、ドイツに抜かれ、1990年末以来、34年ぶりに世界2位となりました。

セグメント 4: [20.00s -> 23.64s] 対外巡資産は日本の政府や企業

セグメント 5: [23.64s -> 27.16s] それに個人が海外に保有する金融資産となる

セグメント 6: [27.16s -> 28.54s] 対外資産から

セグメント 7: [30.00s -> 39.66s] 財務省の発表によりますと、去年末時点での財務省の発表によりますと、去年末時点での日本。

セグメント 8: [40.00s -> 47.46s] 日本の対外資産は1659兆22億円と16年連続で増加しました。

セグメント 9: [50.00s -> 59.88s] アメリカやオランダなどへの直接投資が増えたほか、外国為替市場で円安が進み、海外で保有する資産を円に換算した際の金額が、

セグメント10: [60.00s -> 68.88s] また、対外被災は1125兆9721億円と6年連続で増加しました。

セグメント11: [70.00s -> 75.92s] その結果、対外準資産は533兆500億円と

セグメント12: [75.92s -> 79.98s] おととし末よりも60兆86133%

セグメント13: [80.00s -> 84.26s] 3億円連続で過去最高を更新しました。

セグメント14: [90.00s -> 93.12s] 1年末からおととし末まで世界一でしたが

セグメント15: [93.12s -> 98.02s] 円換算でドイツに抜かれ34年ぶりに2位となりました

セグメント16: [100.00s -> 109.68s] 円換算による対外巡視産は貿易収支の黒字が続いているドイツが1位の569兆6512億円

セグメント17: [110.00s -> 115.86s] 日本に次ぐ3位は中国の516兆2809億円でした

処理時間:約9秒

WhisperX

1. [00:00.03 - 00:19.35] 日本が海外に持つ資産から負債を差し引いた対外準資産は去年末時点で533兆円余りと6年連続で過去最高となったもののドイツに抜かれ1990年末以来34年ぶりに世界2位となりました

2. [00:20.67 - 00:47.57] 対外準資産は日本の政府や企業それに個人が海外に保有する金融資産となる対外資産から海外の政府などが日本で保有する金融資産である対外負債を差し引いたものです財務省の発表によりますと去年末時点での日本の対外資産は1659兆221億円と16年連続で増加しました

3. [00:48.75 - 00:58.87] 日本企業によるアメリカやオランダなどへの直接投資が増えたほか、外国為替市場で円安が進み、海外で保有する資産を円に換算した際の金額が膨らみました

4. [00:58.87 - 01:08.98] また、対外主債は1,125兆9,721億円と6年連続で増加しました

5. [01:10.87 - 01:24.57] その結果、対外準資産は533兆500億円と、おととし末よりも60兆8613億円増えて、6年連続で過去最高を更新しました

6. [01:24.57 - 01:38.28] 日本の対外準資産は、1991年末からおととし末まで世界一でしたが、円換算でドイツに抜かれ、34年ぶりに2位となりました

7. [01:40.23 - 01:56.06] 円換算による対外準資産は、貿易収支の黒字が続いているドイツが1位の569兆6512億円、日本に次ぐ3位は中国の516兆2809億円でした。

処理時間:約11秒

Whisper large-v3(faster-whisper実装)

[0.27s -> 19.17s] 日本が海外に持つ資産から負債を差し引いた対外準資産は、去年末時点で533兆円余りと、6年連続で過去最高となったものの、ドイツに抜かれ、1990年末以来、34年ぶりに世界2位となりました。

[19.17s -> 34.77s] 対外準資産は、日本の政府や企業、それに個人が海外に保有する金融資産となる対外資産から、海外の政府などが日本で保有する金融資産である対外負債を差し引いたものです。

[36.41s -> 47.43s] 財務省の発表によりますと、去年末時点での日本の対外資産は、1659兆221億円と、16年連続で増加しました。

[48.58s -> 50.94s] 日本企業によるアメリカやオランダ、

[50.96s -> 60.62s] などへの直接投資が増えたほか、外国為替市場で円安が進み、海外で保有する資産を円に換算した際の金額が膨らみました。

[62.04s -> 68.88s] また、対外負債は1125兆9721億円と、6年連続で増加しました。

[70.60s -> 80.94s] その結果、対外準資産は533兆500億円と、おととし末よりも60兆8613億円増えて、

[80.94s -> 84.26s] 6年連続で過去最高を更新しました。

[86.20s -> 98.00s] 日本の対外準資産は、1991年末からおととし末まで世界一でしたが、円換算でドイツに抜かれ、34年ぶりに2位となりました。

[100.01s -> 109.67s] 円換算による対外準資産は、貿易収支の黒字が続いているドイツが1位の569兆6512億円、

[110.41s -> 113.41s] 日本に次ぐ3位は中国の516兆612億円、

[113.43s -> 115.85s] 日本に次ぐ3位は中国の516兆2809億円でした。

処理時間:約13秒

評価分析

kotoba v2.2

総合評価:

全体の骨組みは再現できているが、情報量・専門用語・数字の細部において多くの抜けや誤認が見られる。

問題点:

・セグメント数が多く、1文ごとの断片化が顕著(3〜5秒ごとに分割され、文脈のつながりが悪い)。

・専門用語や数字の誤認が多い(例:「対外巡視産」「対外巡資産」「対外被災」などは「対外準資産」「対外負債」の誤認)。

・「533兆円余り」「1659兆22億円」など数字の細部も不正確または欠落。

・論理構成や文脈のつながりに欠落や重複が多く、「財務省の発表によりますと」などが繰り返される。

・分割が細かすぎて内容が断片化し、まとまりのある文になりにくい。

WhisperX

総合評価:

主な情報はすべて網羅されており、数字や専門的な表現、因果・対比の関係も比較的よく保たれている。

問題点:

一部の数字表現が簡略化またはやや口語的になっている。

「対外準資産」が「対外主債」「対外巡視産」など、誤認識がみられる箇所がある。

「主債」は「負債」の誤認と推測される。

「533兆500億円」といった細かい数字は正確に再現。

情報が文単位で整理されており、一覧性が高い。

Whisper large-v3

総合評価:

再現度は高く、原文をほぼ再現している。数字、専門用語、並列文、論理関係も正確に反映されている。

問題点:

文末で「中国」の数値が2度出現し、最初は「516兆612億円」となっているが、正しくは「516兆2809億円」(実際は次のセグメントで補完されており、内容の欠落ではなく分割の問題)。

同じく「対外準資産」が「対外主債」「対外巡視産」など、誤認識がみられる箇所がある。

連続性・可読性も高レベル。

比較表

| モデル | 正確性 | 分割の自然さ | 専門用語再現 | 処理速度 | 主な特徴・課題 |

|---|---|---|---|---|---|

| kotoba-whisper-faster | △(誤変換・欠落あり) | △(細切れ・冗長) | △(被災/巡視等ミス多い) | ◎(高速、2倍以上) | 軽量・日本語特化だが、誤認識目立つ |

| WhisperX | ○ | ◎(まとまり良い) | ○ | ○ | 長文も一文単位で分割、精度安定 |

| Whisper large-v3(公式) | ○ | ○ | ◎ | △(最も遅い) | 精度・専門語最強、やや分割粗い |

※他ニュース音声でも検証しましたが、紙幅の都合上、代表例のみ掲載しています。全体的な傾向はほぼ同様でした。

まとめ

本記事では、2025年時点で日本語音声転写の現場で広く使われているWhisper large-v3、その発展系であるWhisperX、そして日本語特化・高速化モデルのkotoba-whisper-fasterを実際のニュース素材で比較しました。

検証の結果、Whisper large-v3は依然として精度・専門語再現力で優れていて、WhisperXは分割の自然さとバランスの良さで、Whisper large-v3並みの精度で実務利用にも最適な仕上がりでした。kotoba-whisper-fasterは推論速度の点で大きなアドバンテージがあるものの、長文や専門的な内容では誤変換・情報欠落が見受けられました。

結論として、2025年においても「日本語ASRはWhisper系一強」の構図に大きな変化はなく、特に高精度を求める用途ではWhisper large-v3またはWhisperXが依然として最有力な選択肢と言えます。