大規模言語モデル(LLM)は、OpenAIのChatGPT、MicrosoftのBing、GoogleのBardなどの人気製品を支える技術です。しかし、従業員が会社の機密データをChatGPTに流出させたという報告は、企業におけるLLMの適切な活用について大きな疑問を投げかけています。

ChatGPTの背後にある技術を企業で利用する場合、(これらの製品が提供するシンプルなWebインターフェースの利用以外では)、次の2つの方法があります。それぞれの方法には利点と欠点があり、このブログでご紹介します。

→ Ebookダウンロード: ChatGPT、GPT-4、LLMの企業での活用について

オプション1:LLMのAPIを活用する

企業の文脈でLLMを使う最初の方法は、サービスとして提供されるモデルをAPIコールすることです。例えば、OpenAIが提供するGPT-3モデル(ChatGPTを動かすgpt-3.5-turboやgpt-4-0314モデルなど)です。

OpenAIに加え、多くの大手クラウドコンピューティング企業がこれらのサービスを提供しています。Amazon Web Services (AWS)、Google Cloud Platform (GCP)、Microsoft Azureなどです。

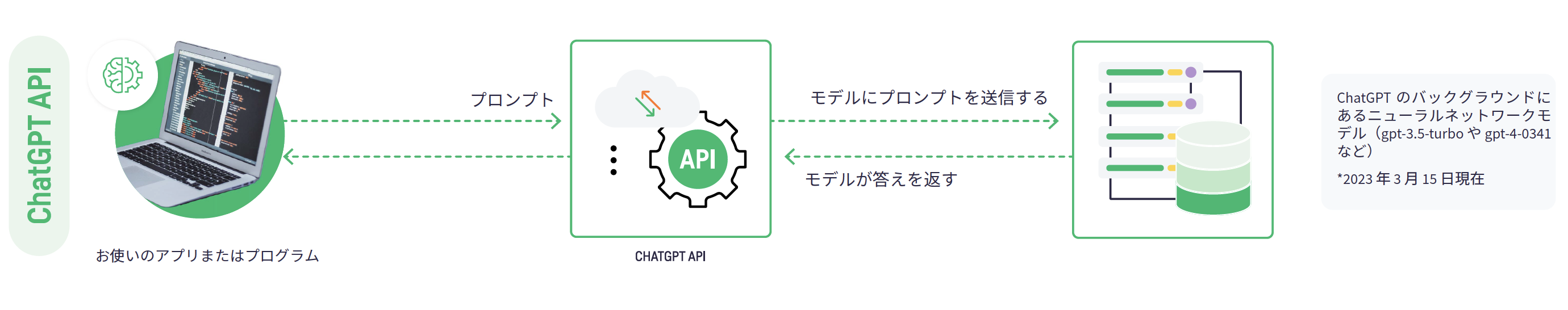

APIを呼び出すには、小さなソフトウェアプログラム、つまりスクリプトをセットアップする必要があります。このスクリプトがAPIに接続し、適切な形式のリクエストを送信します。APIはそのリクエストをモデルに送信し、モデルはそのレスポンスをAPIに返します。そして、APIはその応答を元の要求者に送ります。

APIを通して「LLM as a Service」を利用するメリット

この方法には、以下のような利点があります:

- 参入障壁が低い: APIを呼び出すのは簡単な作業です。ジュニア開発者でも数分でできるでしょう。

- より洗練されたモデル: APIの背後にあるモデルは、多くの場合、利用可能なバージョンのうち、最大かつ最も洗練されたバージョンです。そのため、より小型でシンプルなモデルよりも、幅広いトピックについてより洗練され、正確なレスポンスを提供することができます。

- 迅速な応答: 一般に、これらのモデルは比較的速い応答(数秒のオーダー)を提供できるため、リアルタイムで使用可能です。

APIを通して「LLM as a Service」を利用する際の制約

APIによるパブリックモデルの利用は、上で見たように便利で強力です。しかし、以下のような制約があるため、特定のエンタープライズ・アプリケーションには不適切な場合もあります:

- データレジデンシーとプライバシー: 公開APIでは、クエリーの内容をAPIサービスのサーバーに送信する必要があります。場合によっては、クエリーの内容は保持され、モデルのさらなる開発に使用されるかもしれません。企業は、このアーキテクチャーが、特定のユースケースにおけるデータの保存とプライバシーの義務を尊重しているかどうか、慎重に確認する必要があります。

- コストが高くなる可能性がある: 公開されているAPIのほとんどは有料サービスです。ユーザーは、クエリーの回数と送信されたテキストの量に基づいて課金されます。

- 依存性: APIのプロバイダーは、いつでもサービスを停止することができます。企業は、このようなサービスへの依存を構築するリスクを考慮し、それに耐えられるかどうかを確認する必要があります。

オプション2:オープンソースモデルをマネージド環境で運用する場合

もう一つは、オープンソースのモデルをダウンロードして、自分が管理する環境で動かす方法です。Hugging Faceのようなプラットフォームは、このようなモデルを幅広く集約しています。

API経由で公開されたモデルを使用することの欠点を考えると、このオプションは特定の企業やユースケースにとって理にかなっていると言えるでしょう。これらのモデルは、企業が所有するサーバーや、企業が管理するクラウド環境上で実行することができます。

オープンソースモデルを自己管理するメリット

このアプローチには、以下のような興味深い利点が複数あります:

- 幅広い選択肢: オープンソースのモデルは数多く存在し、それぞれに長所と短所があります。企業は、自社のニーズに最も適したモデルを選択することができます。ただし、そのためには、技術に精通し、トレードオフをどう解釈するかということが必要になります。

- コスト削減の可能性: 場合によっては、用途が限定された小型のモデルを使用することが理にかなっていることもあります。特定のユースケースに適した性能を、より低いコストで提供することができるためです。

- 独立性: オープンソースのモデルを自社で運用・管理することで、サードパーティのAPIサービスに依存することがありません。

オープンソースモデルを自己管理することのトレードオフ

オープンソースモデルを使用することには、多くの利点があります。しかし、以下の理由により、すべての組織やすべてのユースケースに適切な選択とは限りません:

- 複雑さ: LLMの設定と維持には、高度なデータサイエンスとエンジニアリングの専門知識が必要です。単純な機械学習モデルで必要とされる以上のものです。組織は、十分な専門知識を社内に有しているかどうかを評価する必要があります。さらに重要なのは、その専門家が長期的にモデルをセットアップし、維持するために必要な時間を確保できるかどうかです。

- より狭いパフォーマンス: 公開APIを通じて提供されている非常に大規模なモデルがカバーできるトピックの幅の広さは驚くべきものです。しかし、オープンソースコミュニティが提供するモデルは、一般的に小さく、用途が絞られています。

DataikuでAIを使いこなす

私たちのコアビジョンは、常に企業が最新のテクノロジーを迅速に統合できるようにすることです。この理念は、LLMについても同じです。

Dataikuは、企業でLLMを使用するための両方のアプローチをサポートします。また、エンドツーエンドのプラットフォームは、LLMを使用するために必要な幅広いフレームワークを提供します。これには、データコネクター、データ準備機能、自動化、ガバナンス機能などが含まれます。

Dataikuは、強力なGPT-3モデルファミリーを含む、人気のOpenAIテキスト補完APIとの直接的なインターフェイスを提供します。DataikuとGPT-3を使ってドキュメントをクエリーするユースケースをこちらよりご覧ください。

さらに、Dataikuは追加のディープラーニングと自然言語処理(NLP)機能を提供します。これらはLLM上に構築されており、自然言語テキストを入力とした機械学習モデルの構築を支援します。例えば、センテンスエンベッディングにより、テキストの変数を数値に変換することができます。これらの値は、視覚的な機械学習インターフェースで、分類や回帰のタスクに簡単に使用することができます。

LLM:適切なアプローチを選択する

これらのオプションはいずれも、より小さいモデルとより大きいモデルから選ぶことができます。トレードオフは、モデルを使用する際の選択肢、洗練度、コスト、複雑さといった点にあります。LLMのユースケースと適切なアプローチの選択方法について、こちらのEBOOKでさらに詳しく説明しています。