0.はじめに

大学でデータサイエンスの講義を受講している者です。

あまりにも広範囲な分野であるため"広く浅く"情報整理したいため投稿。

内容のレベルは超入門編、個人的な感情も少し入り混じった備忘録。

(齟齬がある場合はご指摘いただけると助かります。)

データサイエンス学習全体像

【データサイエンス】概要

【データサイエンス】人工知能

【データサイエンス】機械学習

【データサイエンス】ディープラーニング

【データサイエンス】分析の分類・確率分布

【データサイエンス】探索的データ分析

【データサイエンス】統計的検定

【データサイエンス】予測モデリング

【データサイエンス】自然言語処理

【アルゴリズム】パーセプトロン

【データサイエンス】機械学習における関数

【データサイエンス】確率

1.目的

単一パーセプトロンのアルゴリズムを大まかに理解する

2.名称

| 名称 | 意味合い | 使用変数 |

|---|---|---|

| 入力信号 | データ要素 | x1,x2 |

| 重み | パラメータ | w1,w2 |

| 出力 | 結果 | y |

イメージ図

3.定義

| 信号 | 結果値 |

|---|---|

| 流す場合 | 1 |

| 流さない場合 | 0 |

| 閾値θ | 結果値 |

|---|---|

| 超えた場合 | 1 |

| 超えない場合 | 0 |

4.注意点

- パラメータ(公式のようなもの)は変更することが可能

- 出力yは重みを付けて足し合わせたもの

- 出力yは決められた閾値に応じて反応=※閾値θを基準に値が変化する

5.アルゴリズム工程

| 工程 | |

|---|---|

| 1 | 仮説より信号と重みを計算をする(結果A) |

| 2 | 結果Aを閾値と比較する |

| 3 | 閾値を条件分岐しyを出力 |

| 4 | 仮説と正しいか判断する |

6.例題

6-1.問題A

次の組み合わせの場合、重みw1,w2と閾値θを求めたい

| x1 | x2 | y |

|---|---|---|

| 0 | 0 | 0 |

| 1 | 0 | 0 |

| 0 | 1 | 0 |

| 1 | 1 | 1 |

2つの入力信号共に1の場合、出力yを1。閾値θによってyの出力は0/1

無限にあるが今回はw1,w2 = 3、θ = 5の組み合わせが当てはまる

組み合わせに当てはめてみる

3×0 + 3×0 = 0, y == 0 // θ = 5のためθより小さい

3×1 + 3×0 = 3, y == 0 // θ = 5のためθより小さい

3×0 + 3×1 = 3, y == 0 // θ = 5のためθより小さい

3×1 + 3×1 = 6, y == 1 // θ = 5のためθより大きい

6-2.問題B

次の組み合わせの場合、重みw1,w2と閾値θを求めたい

| x1 | x2 | y |

|---|---|---|

| 0 | 0 | 1 |

| 1 | 0 | 1 |

| 0 | 1 | 1 |

| 1 | 1 | 0 |

出力yが問題Aの逆パターン

重みを変えずパラメータを変更することで当てはまる

w1,w2=3、θ=5の組み合わせで再び計算をする

3×0 + 3×0 = 0, y == 1 // θ = 5のためθより小さい

3×1 + 3×0 = 3, y == 1 // θ = 5のためθより小さい

3×0 + 3×1 = 3, y == 1 // θ = 5のためθより小さい

3×1 + 3×1 = 6, y == 0 // θ = 5のためθより大きい

7.結論

組み合わせによってはできないものもある

無限に組み合わせがあるため割愛

例題ではある入力に対しある出力がされるようにパラメータを調整した

機械学習ではこの調整を自動で行ってくれるようなイメージ

重みは知識となり蓄えられる

つまり回数を重ねるごとに多くの組み合わせを表現することが可能

8.多層パーセプトロン

仮説Aを式で表すと以下になる

x2 = -x1 + 5

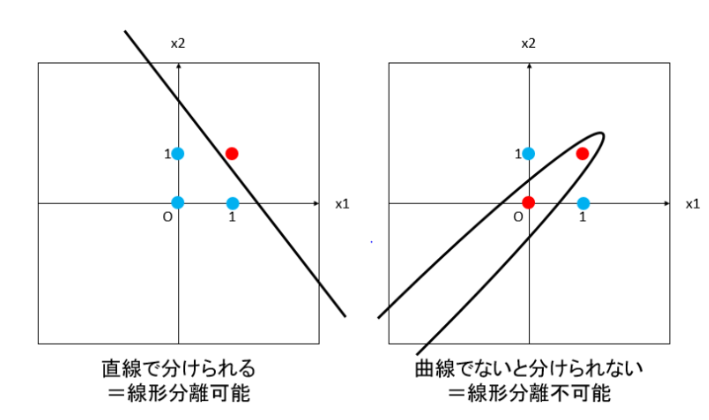

図に展開し出力yの0/1をそれぞれプロット化する

⇒ 0は〇、1は✕などと区別化してみる

式で表した部分を境界とした場合プロット〇、✕を分別することができる

だが当たり前だが組み合わせによってはできないものも存在する

そこで

複数のパーセプトロンを組み合わせることにより実現をすることができる

これが多層パーセプトロン

8-1.デメリット

- 0/1のような線形的に判断するデータしか学習できない

- 学習時間の遅延:多層パーセプトロンの発達により活用範囲は広がったが、コネクションが膨張したことによる学習時間が長くなることが考えられる

補足(2023/08/21追記)

パーセプトロンの種類

-

ANDゲート:2つの入力が1である場合、1を出力しそれ以外は0、問題AがANDゲート -

NANDゲート:2つの入力が1である場合、0を出力しそれ以外は1、問題BがNANDゲート

他にも種類がある -

ORゲート:2つの入力のうち少なくとも1つが1である場合、1を出力しそれ以外は0 -

XORゲート:2つの入力のうちどちらかが1である場合、1を出力しそれ以外は0

パーセプトロンの数値表現

x yの入力出力それぞれ組み合わせ(テーブル)をグラフにプロットする

出力0・1は線形で分けることができる

だがXORゲートは線形で分けることはできない

組み合わせは存在しないことからパーセプトロンにおいては限界である

NAND、OR、ANDゲートを組み合わせること

多層構造にすることによりXORゲート表現が可能

この構造を多層パーセプトロンと呼ぶ

おわりに

「知識が蓄えられて・・学習されて・・」と最初何のことを言ってるのか

そもそも学習とは?のレベルから参入したため「?」が絶えなかった。

今回のパーセプトロンの原理を学んだことにより機械学習の根源が見えた気がした。

引き続きアルゴリズムにおいては初歩的なものは調べていく予定

参考文献:SIOS TEC.LAB

[AI入門] ディープラーニングの仕組み ~その1:ニューラルネットワークってなに?~

最終アクセス:2023/08/21