Meta 社の Llama のように LLM はネーミングも面白いものが多いです。

この記事ではそんなユニークな名前のLLMを3つ紹介します。

1. SNOOPI

2. Jurassic

3. ChatHaruhi

SNOOPI

SNOOPI: Supercharged One-step Diffusion Distillation with Proper Guidance

SNOOPI はより高性能な拡散モデルをつくる方法で、Proper Guidance- SwiftBrush (PG-SB) と NASA (Negative-Away Steer Attention) という2つの手法を組み合わせています。

2つの方法の特徴は以下の通り。

-

PG-SB: 安定性の向上

教師モデルのガイダンススケールをランダムに変動させることで、出力分布を広げます。

これにより、Variational Score Distillation (VSD) 損失の頑健性が向上し、マルチステップの拡散モデルで課題だった、異なるバックボーンでの安定性の確保が可能になります。 -

NASA: ネガティブプロンプト対応

クロスアテンションを活用し、ネガティブプロンプトを反映する訓練の不要な手法です。望まない要素を生成画像から抑制することが可能になります。

なお SNOOPI は論文のタイトル通り、Supercharged One-step diffusiOn distillatiOn with Proper guIdance から来ている。かなり無理がある...。

Jurassic

MRKL Systems

実はこの Jurassic ですが、Jurassic-2というモデルが2024年11月14日を持って終了しました。今は Jamba というモデルに引き継がれており、Jamba は世界初の量産グレードの Mamba ベースのモデルと言われています。Mamba はアーキテクチャの名称で Attention ブロックや MLP(多重パーセプトロン) ブロックを持たないシンプルなアーキテクチャです。ちなみにマンバという蛇から来ています。

さて、Jurassic はイスラエルの AI21 Labs が開発したLLMで、スペイン語、フランス語、ポルトガル語、イタリア語、オランダ語、ドイツ語に対応しており、Jambaと共にAWSのBedrockでも提供されています。

Regionは北米などに限ります

論文が出たのは2022年で、ナレッジと推論の個別モジュールを組み合わせた複数のモデルを持つ柔軟なアーキテクチャが特徴的でこれをMRKL(Modular Reasoning, Knowledge and Language)、「ミラクル」という名前を付けました。

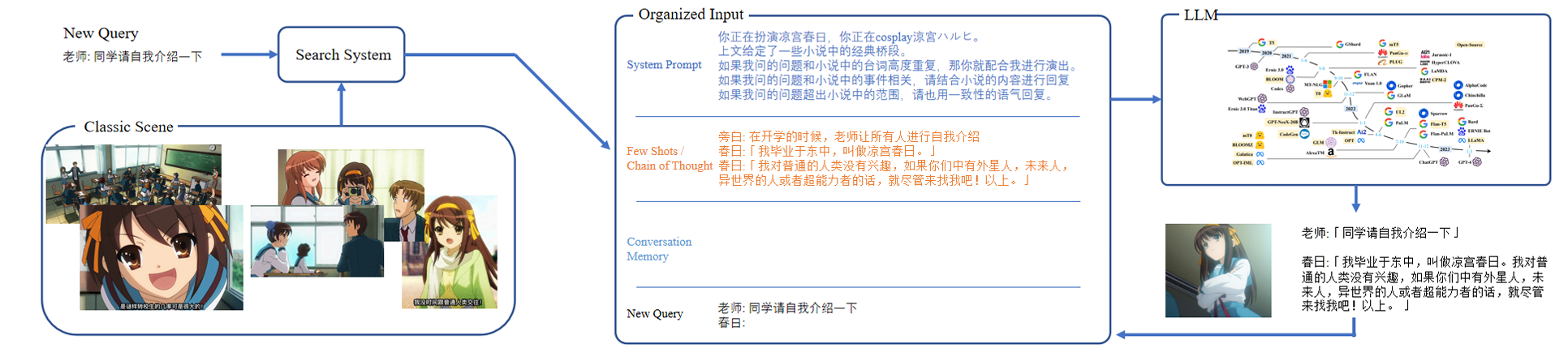

ChatHaruhi

ChatHaruhi: Reviving Anime Character in Reality via Large Language Model

よりキャラクターとの会話の再現度を上げるために、ChatHaruhiというデータセットを構築し、キャラクターとの模擬対話を行います。キャラクターの設定を記述したシステムプロンプトと、脚本から抽出したキャラクターの文脈情報をモデルに与えることで、キャラクターの自然な会話を生成できるようにしています。

開発者の愛が伝わるリポジトリです。

私も過去に海馬社長のボットをつくりましたが、文脈によってはキャラクターが崩壊することがあり、頑健なモデルをプロンプトのみでつくることは難しいと感じました。

こちらのデヴィ夫人ボットぐらいプロンプトにこだわる必要がありますね。

参考

各arXiv論文はこちらです。

- SNOOPI: Supercharged One-step Diffusion Distillation with Proper Guidance

- MRKL Systems

- ChatHaruhi: Reviving Anime Character in Reality via Large Language Model