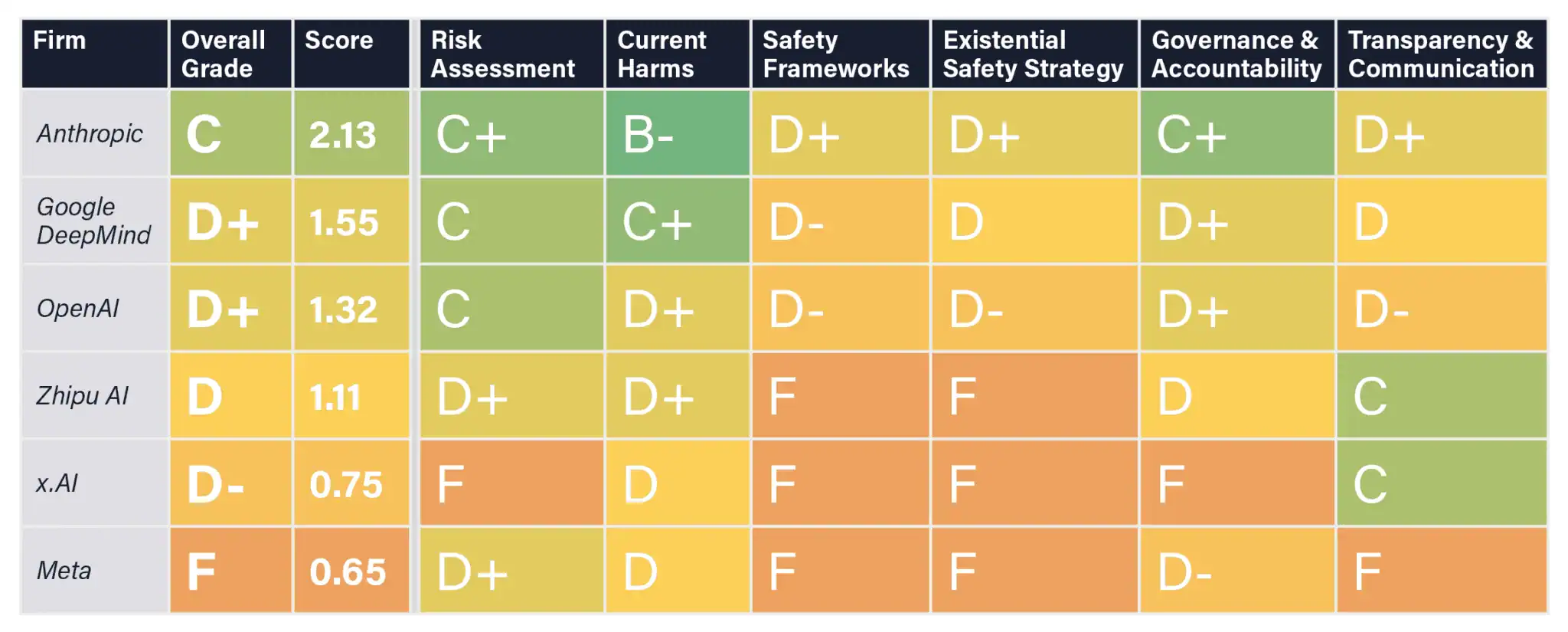

Future of Life Institute (FLI) が作成した AI安全性指標 2024 は、主要AI企業の安全性に関する取り組みを以下の6つの重要領域に基づき評価したものです。

- リスク評価

- 現在のリスク(被害)

- 安全性フレームワーク

- 存在論的安全戦略

- ガバナンスと責任

- 透明性とコミュニケーション

Panel of graders

Yoshua Bengio

Atoosa Kasirzadeh

David Krueger

Tegan Maharaj

Jessica Newman

Sneha Revanur

Stuart Russell

主な観察結果

-

モデルの脆弱性

すべての主要AIモデルが、脱獄(jailbreak)を含む敵対的攻撃に対して脆弱であることが判明。 -

不十分な安全戦略

先進的AIシステム(特にAGI)の安全性を確保するための実効的な戦略を提示した企業は存在せず。 -

透明性の欠如

多くの企業が外部監視を欠き、リスク評価の共有が十分ではない。 -

利益優先の傾向

外部規制がない場合、企業は安全対策を犠牲にして利益を優先する傾向が強い。

評価の概要

各企業は米国のGPAスケール(A+~F)で評価されました。以下に主な企業の成績を示します:

成績表

| 企業名 | 総合評価 | 特徴 |

|---|---|---|

| Anthropic | C (2.13) | 安全性に関する責任あるスケーリング方針を導入。外部監視の取り組みも評価されたが、存在論的リスクへの戦略は不十分。 |

| Google DeepMind | D+ (1.55) | Frontier Safety Frameworkを開発したが、実装が不十分で透明性にも欠ける。 |

| OpenAI | D+ (1.32) | 初期のガバナンス施策は評価されたが、包括的なリスク管理が不足している。 |

| Meta | F (0.65) | ガバナンスや安全性に著しい欠陥があり、高度なモデルのオープンソース化も問題視された。 |

改善に向けた提言

-

外部監視の強化

第三者評価機関の関与を増やし、安全性対策のモニタリングと検証を実施すべき。 -

強固なフレームワークの構築

リスクが確認された際に開発を停止する明確な基準を設定する必要がある。 -

透明性の向上

評価結果や取り組みを公開し、企業の責任を明確にする。 -

存在論的リスクへの注力

AGIや他の先進的AIシステムによるリスクを軽減するための具体的な計画を策定する。

本レポートは、現在および将来的なリスクに対処するため、AI業界全体でのガバナンスや協力の重要性を強調しています。