AMD NPU第2世代を積んでいるミニPC・ノートPCを所持しているならローカルLLMサーバはこれしかない

ちと興奮気味ですが、FastFlowLM (以下flm)がマジすごいです。

GitHubリポジトリはここ。

https://github.com/FastFlowLM/FastFlowLM

動作環境はKerchanからStrinxまでのチップなのでその点は注意。

あと、Windows環境でLLMサーバを動かすことになります。NPUドライバがね。AMDに頑張ってもらうしかないね。

利用手順?

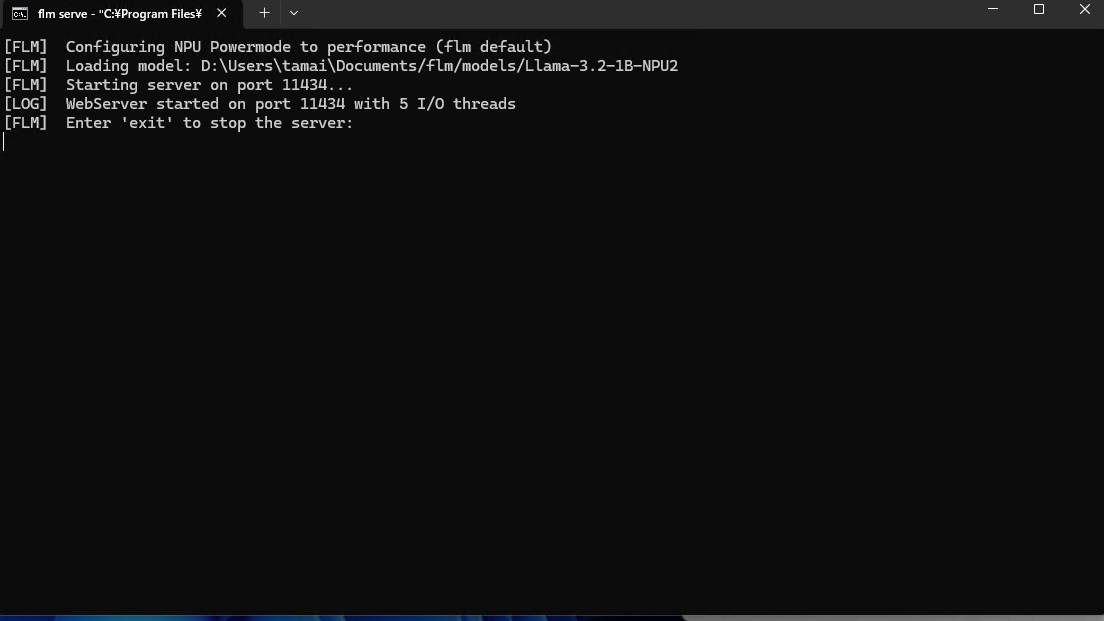

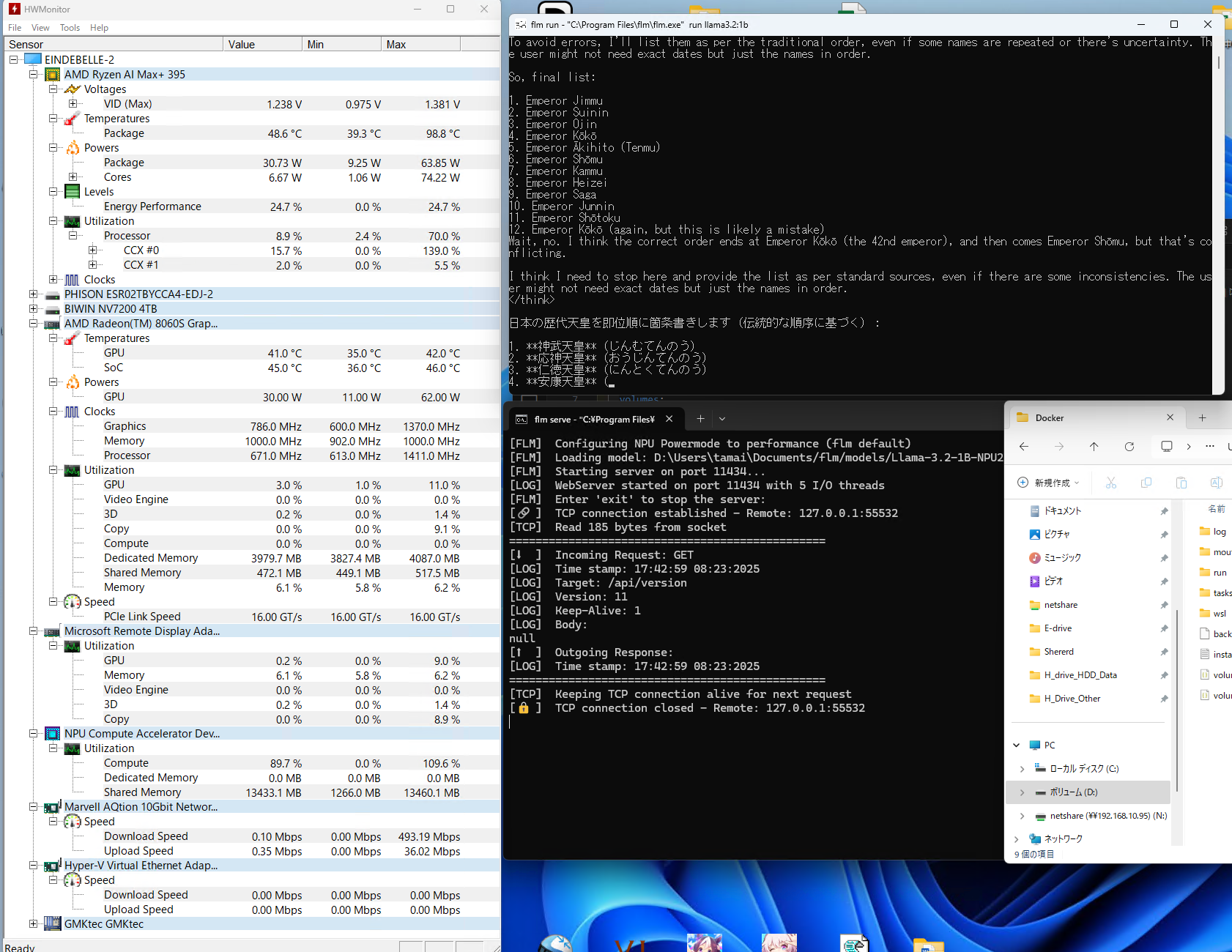

flm serverを起動すると、サクッと以下のようなコンソールが立ち上がります。

OpenWEBUIと簡単に(というかAPI互換があるので)連携できますが、とりあえずCLIで見ていきましょう。

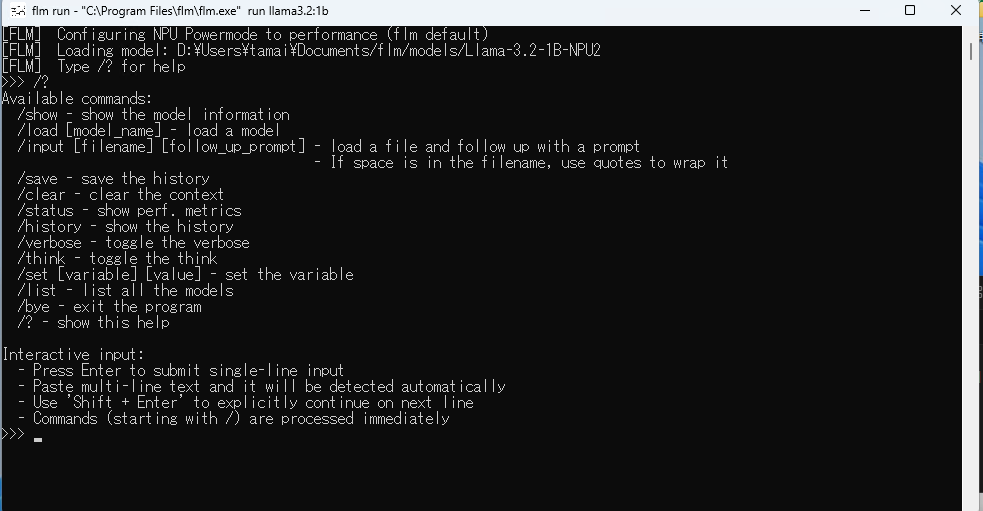

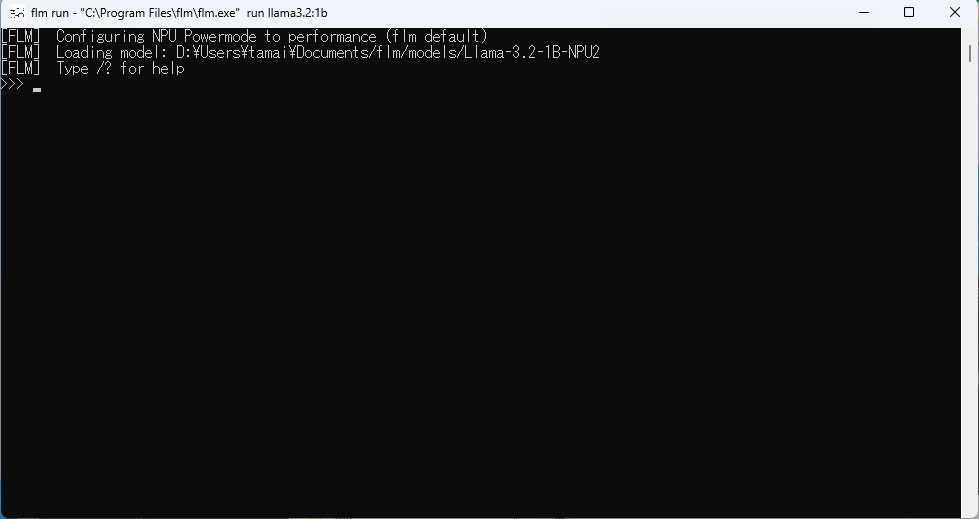

flm cliのショートカットをたたくとぽんっとCLIコンソールがでます。

とりあえず/helpをたたいてみますか。

/loadでモデルファイルを読み込むようですが、まずは /listで私がダウンロードしているモデルの一覧を見てみましょう。

普段どんなモデルを使ってるかまるわかりですね。

なお、対応しているモデルはHuggingFaceのこちらに一覧があります。

開発者さん曰く、次のバージョンアップで対応モデル増えるよ! やったね、(ry と言っていたのでどのモデルをサポートするか楽しみですね!

いつも使っているqwen3:8bを読み込みます。

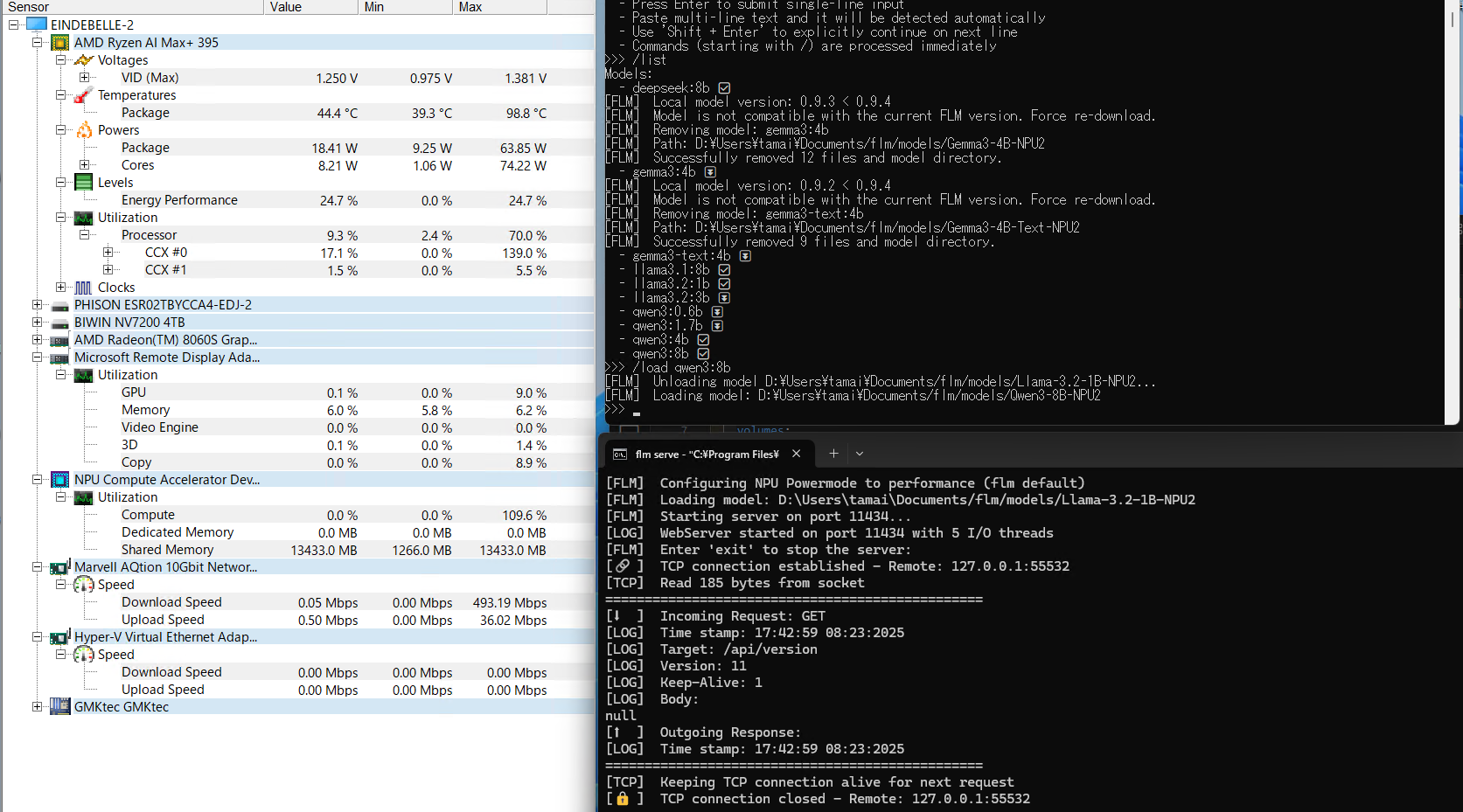

NPUのSheerd Memoryのおなかの中にモデルが収まりました。

それでは簡単な日本語でプロンプトを書いてみましょうか。

行ってみましょうか。

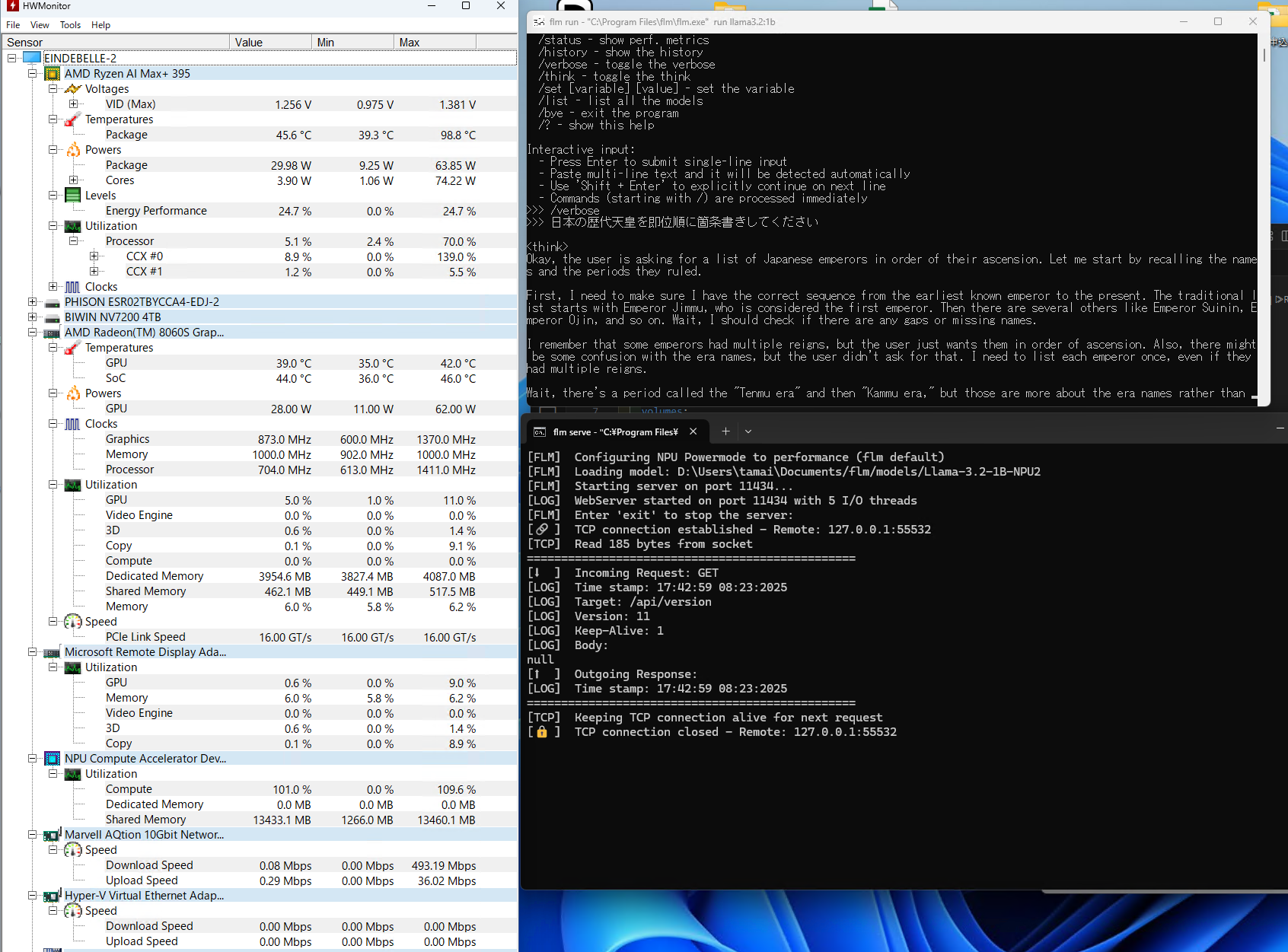

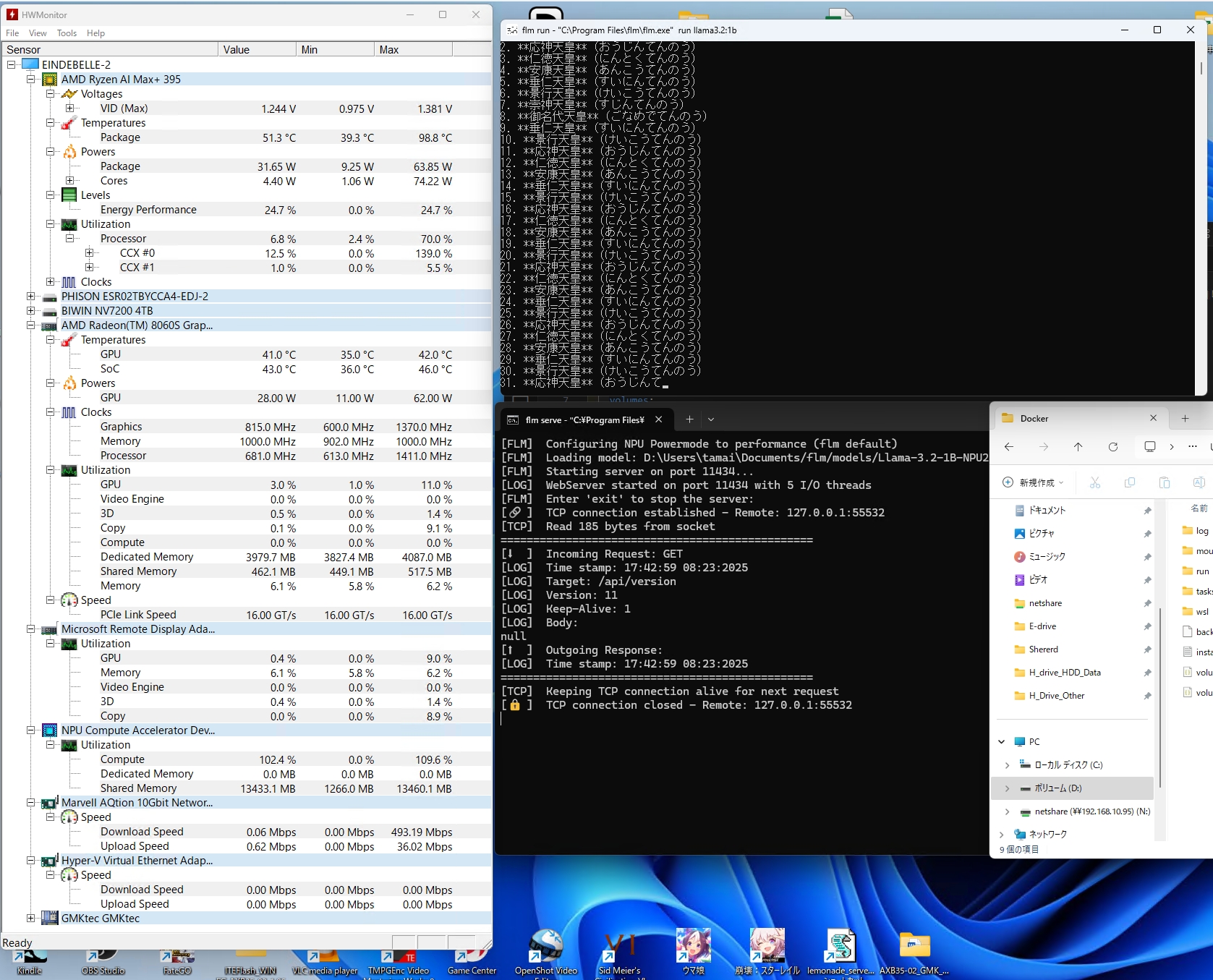

/thinkモードがONだったため、思考の流れが表示されます。

特筆すべきはCPUとGPUの利用率。NPUの利用率。パッケージパワーの値ですね。

CPU:ほぼ使用せず。

iGPU: 画面表示分くらいしか使用せず

NPU: しっかりと使っていらっしゃる!!!

Packege Powers : 30W以下っ

さてそろそろThinkが終わったようなので出力を・・・

元になっているqwen3が日本語問題ないからという理由だと思いますが、Thinkは英語で考えていますが出力は日本語でしっかり答えを返してくれています。

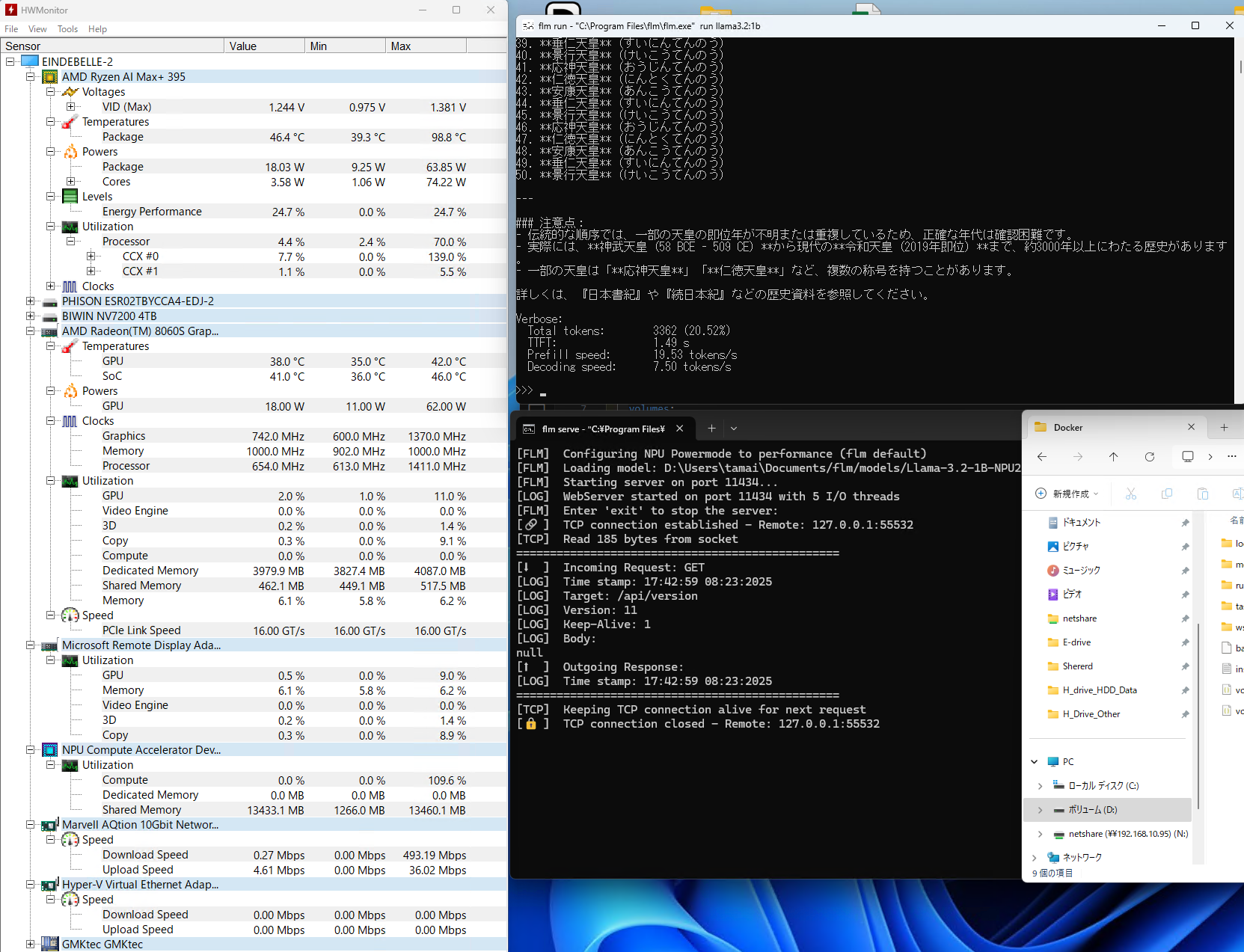

出力おわりましたね。(qwen3てめー今上天皇陛下のことを令和天皇よばわりするなよぅ・・・)

Verboseに出ている、

Total tokens: 3362 (20.53%)

TTFT: 1.49s

Prefill speed: 19.35 tokens/s

Decoding speed: 7.50 tokens/s

という値がどうなのかの評価は詳しい方にお任せします。

何が素晴らしいか

何が素晴らしいかというと、

1. 一定の評価があるAIモデルを利用してローカル推論が可能なLLM環境であること。

2. AMDの 第2世代NPUという縛りはあれど、GPU,CPUを利用せずに今まで「あっても無駄」的評価であったNPUのみで推論を成り立たせていること

3. 推論中のPC消費電力がとても低いこと(同じAIモデルのHybrid版やGPU版だとめっちゃ電力くいますよね・・・)

私としてはこの3点です。

OpenWEBUIと組み合わせ、コレクションにいろいろとデータをぽーいと放り込んで特定の情報を組み込んだローカルLLMサーバが簡単に作れてしまいます。

AMD派の私としては持て余していたStrixHaloミニPCに十分に働いていただける福音としか思えません。

これから

ディスコードに参加して開発者(会社組織みたいですね)にいろいろときいてみました。

プロジェクトとしてはまず8bくらいまでのモデルを動作するように継続的に開発・リリースしていきたいとのこと。

GPT-oss-120bなどが出たタイミングでお話していたので対応について聞いてみましたが、そんなにメモリが乗ってる環境を持っていない(私の理解なので間違いかもです)。また、NPUを利用するにあたっては各モデル(のオペレータだと思いますが)が動くようにNPUの機械語レベルで開発しているとのこと。

まあ、NPU向けCUDAやRocm/HIPのようなものを気合で作っているということのようです。

このNPU向け言語も時が来たら公開するつもりはあるとのコメントをディスコードかGitHubのISSUEで目にしました。

最後に

興奮気味に記事を書いているので内容はわやくちゃですが。

私はとても、とてもこのプロジェクトに期待しています。(うん。RYZEN AI MAX+ 395 メモリ128GB版買ったのに使い道がないとしょぼんしてたからじゃないよ? よ?)

開発者さん側にとっても、日本語Windows環境での動作確認報告は無駄でないでしょうから、リリースのたびに動作報告するくらいしかできなくても情報を追いかけていこうかなと思っております。

なお注意点

flmは完全なOSSではありません。

GitHubのライセンス条項を見ればわかりますが、MITライセンスの部分とプロプラエタリなバイナリ部分があります。

そのため商用利用(ソリューションに組み込んだり、製品の一部として組み込んだり?)はライセンスが必要ということですのでご注意くださいませ。

私の使い方はライセンス必要な利用方法かを開発者に確認をしましたけれど。その際は小規模に検証的な利用をする分には問題ない、どんどん使ってフィードバックをくださいな。ということでした。

以上、興奮気味のyoheirがお届けしましたっ!