IBM Granite 3.0リリース

IBM独自のLLMであるGraniteモデルが、2024年10月21日、さらにパワーアップし、Granite 3.0としてリリースされました。

当記事は、「いち早く、そのGranite 3.0を試してみたい!」という方のために執筆いたしました。

今回のリリースでは、目的別に4種類のLLMが提供されました。

- 一般的な使用を目的とした高密度LLM (Dense, general purpose LLMs)

- 入出力ガードレールモデル (LLM-based input-output guardrail models)

- 混合モデル (Mixture of experts (MoE) models for minimum latency)

- 推論速度と効率を高めるモデル (Speculative decoder for increased inference speed and efficiency)

また、これらのモデルはオープンソースモデルとして公開されているため、Hugging Faceからダウンロード可能です。

それでは、その4種類を1つづつ見ていきます。

一般的な使用を目的とした高密度LLM (Dense, general purpose LLMs)

8Bと2BのBaseとInstructチューニングされたモデルが提供されます。

- Granite-3.0-8B-Instruct

- Granite-3.0-8B-Base

- Granite-3.0-2B-Instruct

- Granite-3.0-2B-Base

前バーションでは、日本語専用のgranite-8b-japaneseが提供されていましたが、今回は日本語を含むマルチリンガルモデルとして提供されています。

こちらの12種類の言語に対応してます。

English, German, Spanish, French, Japanese, Portuguese, Arabic, Czech, Italian, Korean, Dutch, and Chinese. Users may finetune Granite 3.0 models for languages beyond these 12 languages.

IBM CloudもしくはHugging Face IBM Graniteからご利用可能です。

入出力ガードレールモデル (LLM-based input-output guardrail models)

8Bと2Bの2つのモデルが提供されます。

- Granite-Guardian-3.0-8B

- Granite-Guardian-3.0-2B

Granite-Guardian-3.0-8Bを例にとると、『Granite Guardian 3.0 8Bは、Granite 3.0 8B Instructモデルのファインチューニングされたバージョンであり、プロンプトと応答にリスクを検出するための目的で設計されています。IBM AI Risk Atlasでカタログされている多くの重要な要素にわたって、リスク検出に役立つことができます。それはヒューマンアノテーションおよび内部レッドチームングを指導したシンザティックデータから構成される一意のデータで訓練されています。同じスペース内の他のオープンソースモデルと比較して、標準的なベンチマークでそれを超えることができます。』とのことです。(granite-3.0-8b-instructを使用して翻訳しています)

明確なサポート言語に関する記述を、現時点(2024.10.23)では見つけられていませんが、『Granite 3.0 8B Instructモデルのファインチューニングされたバージョン』ということから、Granite-3.0-8B-Instructでサポートされている12言語が使用できるのではないかと思います。

IBM CloudもしくはHugging Face IBM Graniteからご利用可能です。

混合モデル: Mixture of experts (MoE) models for minimum latency

混合モデルとして、3Bと1BのBaseとInstructチューニングされたモデルが提供されます。

- Granite-3.0-3B-A800M-Instruct

- Granite-3.0-3B-A800M-Base

- Granite-3.0-1B-A400M-Instruct

- Granite-3.0-1B-A400M-Base

Granite-3.0-3B-A800M-Instructを例にとると、『Granite-3.0-3B-A800M-Instructは、Granite-3.0-3B-A800M-Base-4Kからファインチューニングされた3Bパラメータモデルであり、オープンソースの指示セットに許可付きのライセンスと内部収集されたシンザティックデータの組み合わせを使用して開発されています。このモデルは、構造化されたチャットフォーマットなど、多様なテクニックを組み合わせたことで開発されており、スーパーバイザードファインチューニング、再強化学習によるモデル対齐、およびモデルマージングなどが含まれています。』とのことです。(granite-3.0-8b-instructを使用して翻訳しています)

こちらの12種類の言語に対応してます。

English, German, Spanish, French, Japanese, Portuguese, Arabic, Czech, Italian, Korean, Dutch, and Chinese. Users may finetune Granite 3.0 models for languages beyond these 12 languages.

IBM Cloud上ではまだ提供されていません。お急ぎの方は、Hugging FaceのIBM Graniteからご利用ください。

推論速度と効率を高めるモデル (Speculative decoder for increased inference speed and efficiency)

推論速度と効率を高める目的で、1つのモデルが提供されます。

- Granite-3.0-8B-Instruct-Accelerator

『このモデルは、Granite-3.0-8b-instructのアクセラレータとして使用されるように設計されており、Medusa仮想解釈アーキテクチャからインスピレーションを得ています。準備評価では、アクセラレータを使用する際に基礎モデルで最大2.2倍のトークン/ステップの加速が示されています。このアクセラレータは、MLPを多段MLPに変換し、各段階は前段階からサンプルトークンと共に草稿に存在する単一のトークンを予測します。基礎モデルはステージ0として考えることができます。基礎モデルの状態ベクトルは、アクセラレータにコンテキスト情報を提供し、前からサンプルされたトークンに条件付けすることで、高品質なn-グラムの生産を可能にします。』とのことです。(granite-3.0-8b-instructを使用して翻訳しています)

明確なサポート言語に関する記述を、現時点(2024.10.23)では見つけられていませんが、『Granite-3.0-8b-instructのアクセラレータとして使用されるように設計されており』ということから、Granite-3.0-8B-Instructでサポートされている12言語が使用できるのではないかと思います。

IBM Cloud上ではまだ提供されていません。お急ぎの方は、Hugging FaceのIBM Graniteからご利用ください。

レッツ 体感!

IBM Cloud上で使う方法もありますが、せっかくなので、Hugging FaceのIBM Graniteからダウンロードして使ってみましょう ![]()

とは言え、「ダウンロードできるといっても、自分のパソコンで動かすにはその環境の準備が大変そうで私には無理です」という方へ、朗報です。

LM Studio とは?

自分のパソコン上でLLMを動かす環境として、Ollamaやllama.cppが有名ですが、それなりにITやAIのスキルが必要です。

そこで、誰でも簡単に自分のパソコン上でLLMを動かすこと事を可能にするのが LM Studioというソフトウェアです。

LM Studioの公式サイトはこちらです。

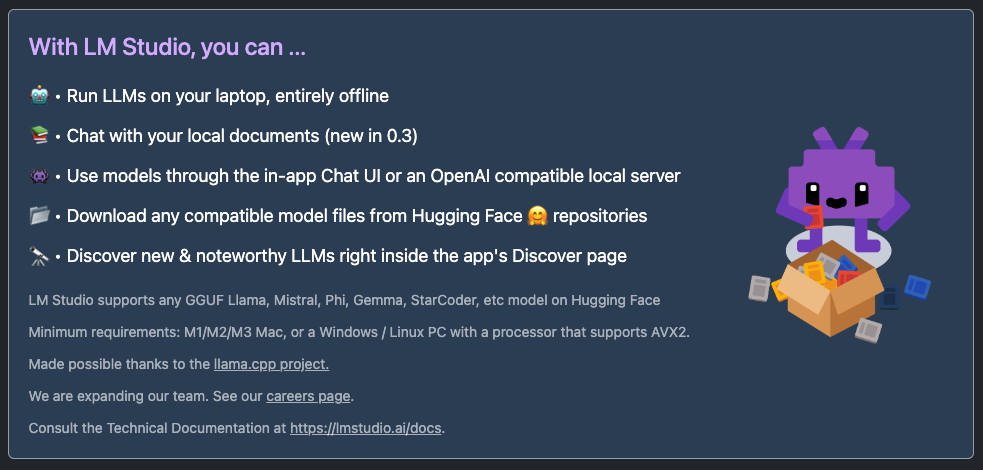

アクセスしてみると、『こんなことができますよ』と書いてあります。

ふむふむ、やはり、いきなり英語は辛いな〜

ということで、早速、granite-3.0-8b-instructを使って翻訳してみました。

LM Studioは、以下の機能を提供します

• ローカルで完全にオフラインでLLMsを実行する

• ローカルドキュメントとチャットする

• Chat UI内やOpenAI兼容のローカルサーバーを通じてモデルを使用する

• Hugging Face 🤗 リポジトリからダウンロードできる任意の対応可能なモデルファイル

• Discoverページで新しい&注目すべきLLMsを探す

LM Studioは、GGUF Llama, Mistral, Phi, Gemma, StarCoderなどのHugging Face 🤗 リポジトリにある任意のモデルをサポートする。

最小要件: M1/M2/M3 Mac、または AVX2 をサポートするプロセッサを備えた Windows/Linux PC。

llama.cpp プロジェクトによって可能になった。

我々はチームを拡大しています。キャリアページを参照してください。

テクニカルドキュメントは https://lmstudio.ai/docs にあります。

内部では、llama.cppを使っているのですね。

Hugging Faceで公開されている様々なモデルを自分のパソコン上で手軽に実験できるのは嬉しいです。

また、M1/M2/M3 Mac、GPUを搭載していないWindowsやLinuxもサポートされているのはとても助かります。

LM Studio使用に関する注意事項

TLDR: The app does not collect data or monitor your actions. Your data stays local on your machine. It's free for personal use. For business use, please get in touch.

(翻訳) granite-3.0-8b-instructによる翻訳

LM Studioは、インターネット接続なしでローカルマシンでLLMsを実行できる無料のアプリです。データ収集やアクション監視は行われません。個人用として無料で使用できますが、商業用についてはチームに連絡してください。

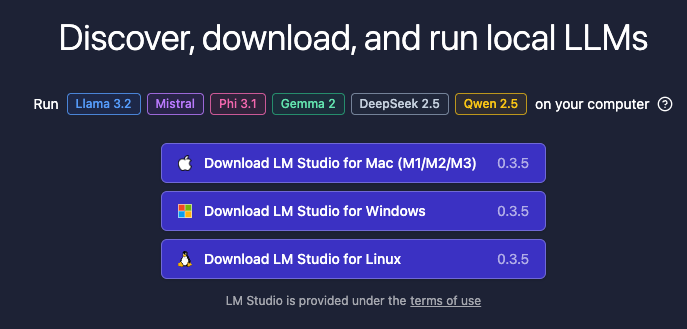

LM Studioのインストール

こちらにアクセスし、導入先のOSを選択してください。

(導入手順は、それぞれのOSの手順に従って下さい)

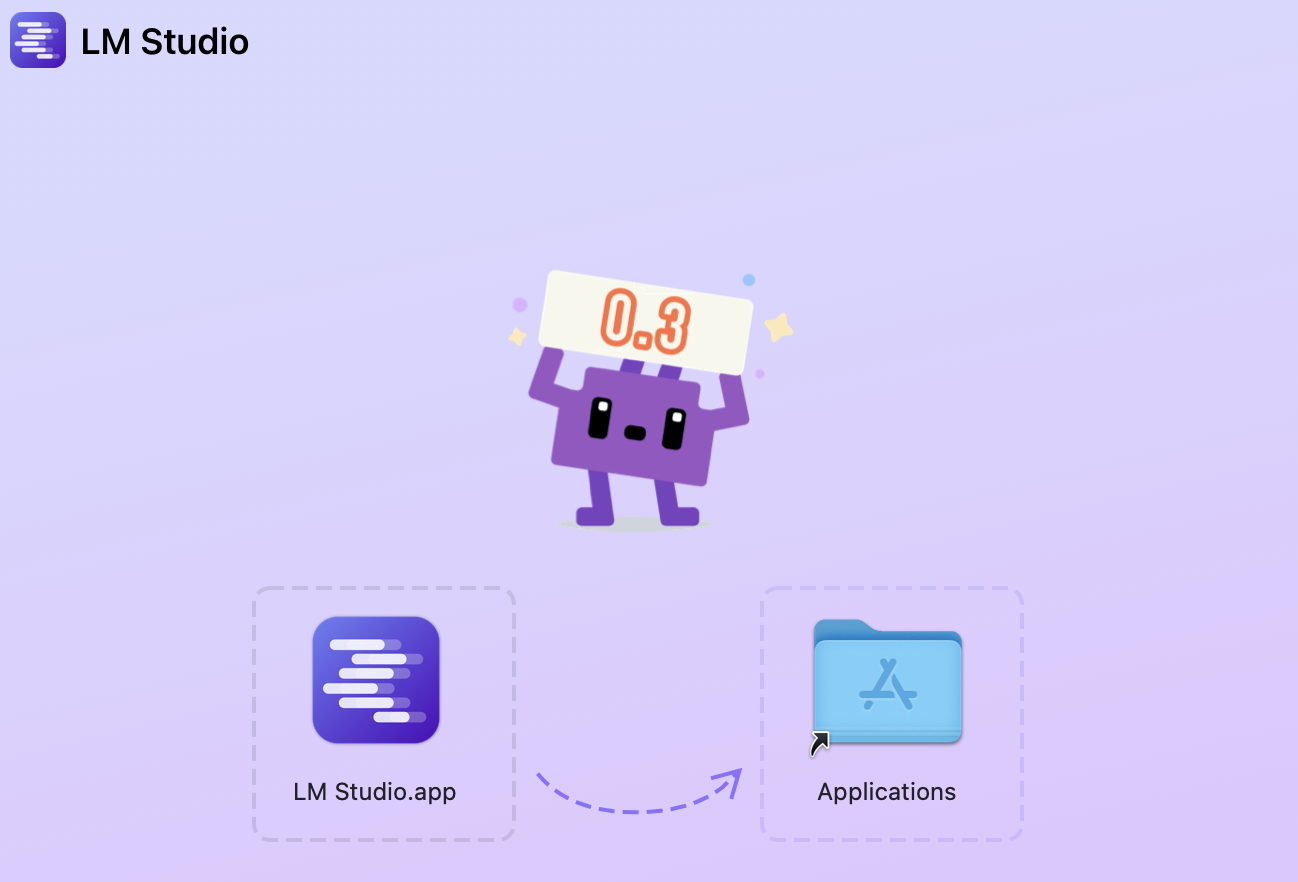

(参考) Macの場合は、『LM Studio.app』を『Applicationsフォルダ』に移動するだけです。

IBM Graniteのダウンロード

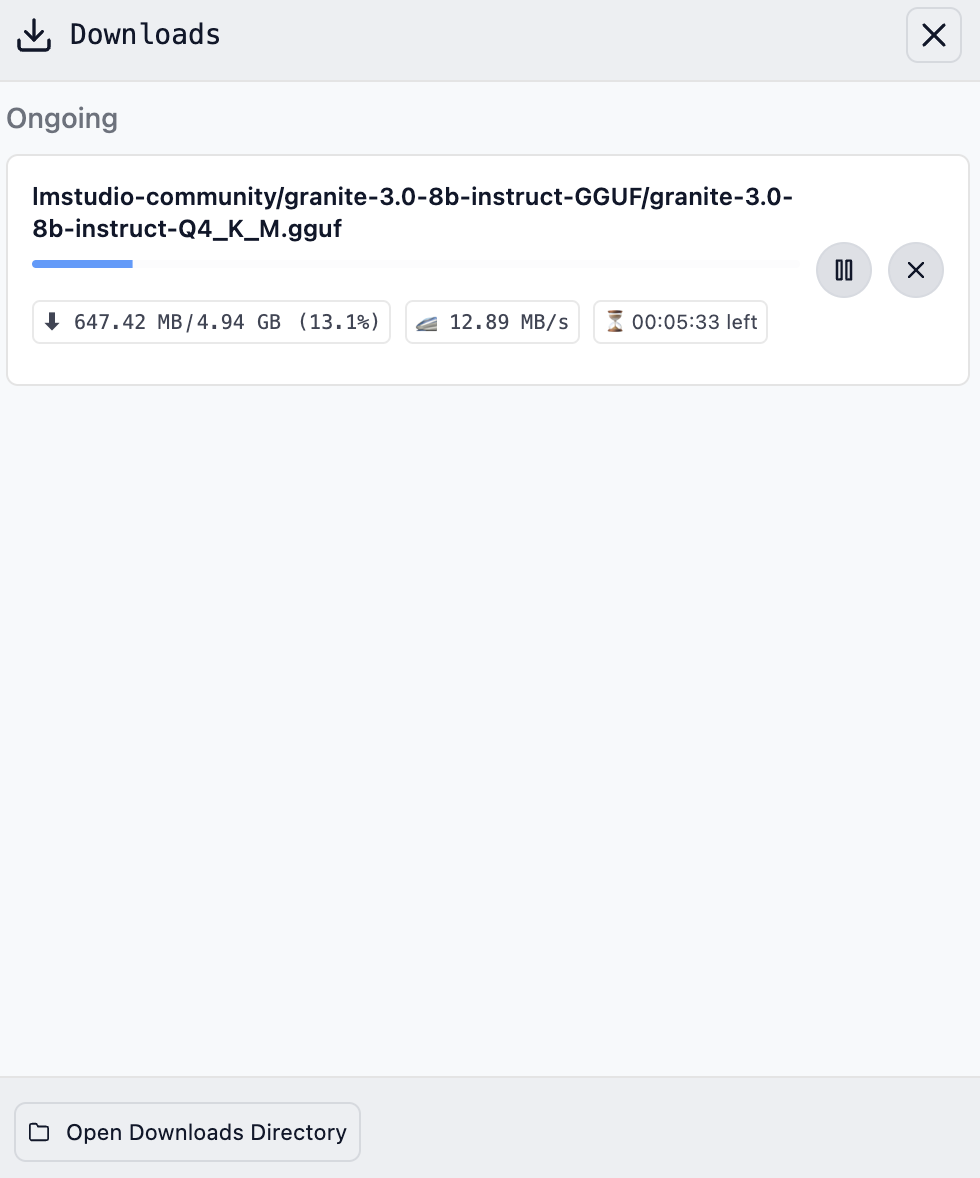

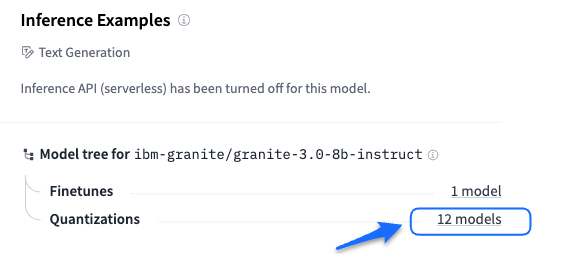

ibm-granite/granite-3.0-8b-instructの例を示します。

こちらにアクセスして下さい。

LM Studioでは、GGUFフォーマットがサポートされているので、Quantizationsの[12models]をクリックします。

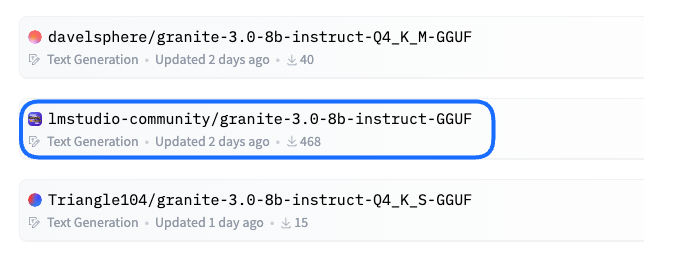

モデル一覧が表示されるので、[lmstudio-community/granite-3.0-8b-instruct-GGUF]をクリックします。

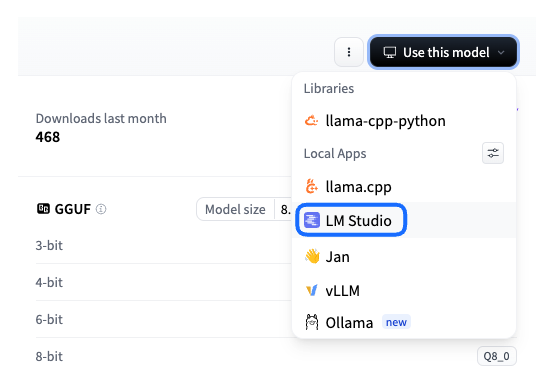

右上に表示される[Use this model]をクリックすると、プルダウンメニューが表示されるので、[LM Studio]をクリックします。

ポップアップ・ウィンドウが表示されるので、[LM Studio.appを開く]をクリックします。

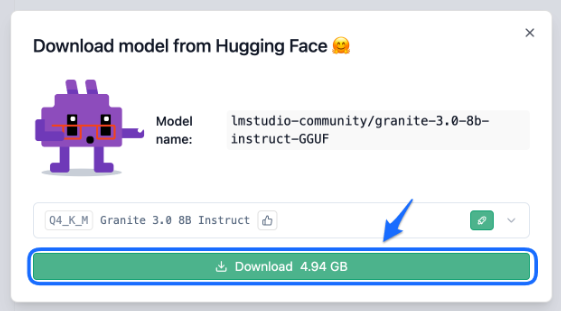

LM Studioが起動され、モデルのダウンロード画面が表示されますので、[Download 4.94GB]をクリックします。

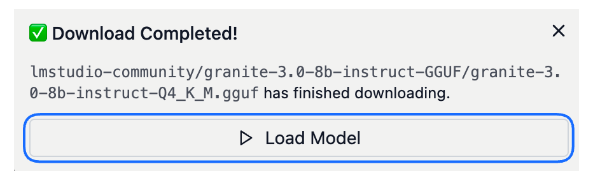

モデルのダウンロードが終了したら、[Load Model]をクリックします。

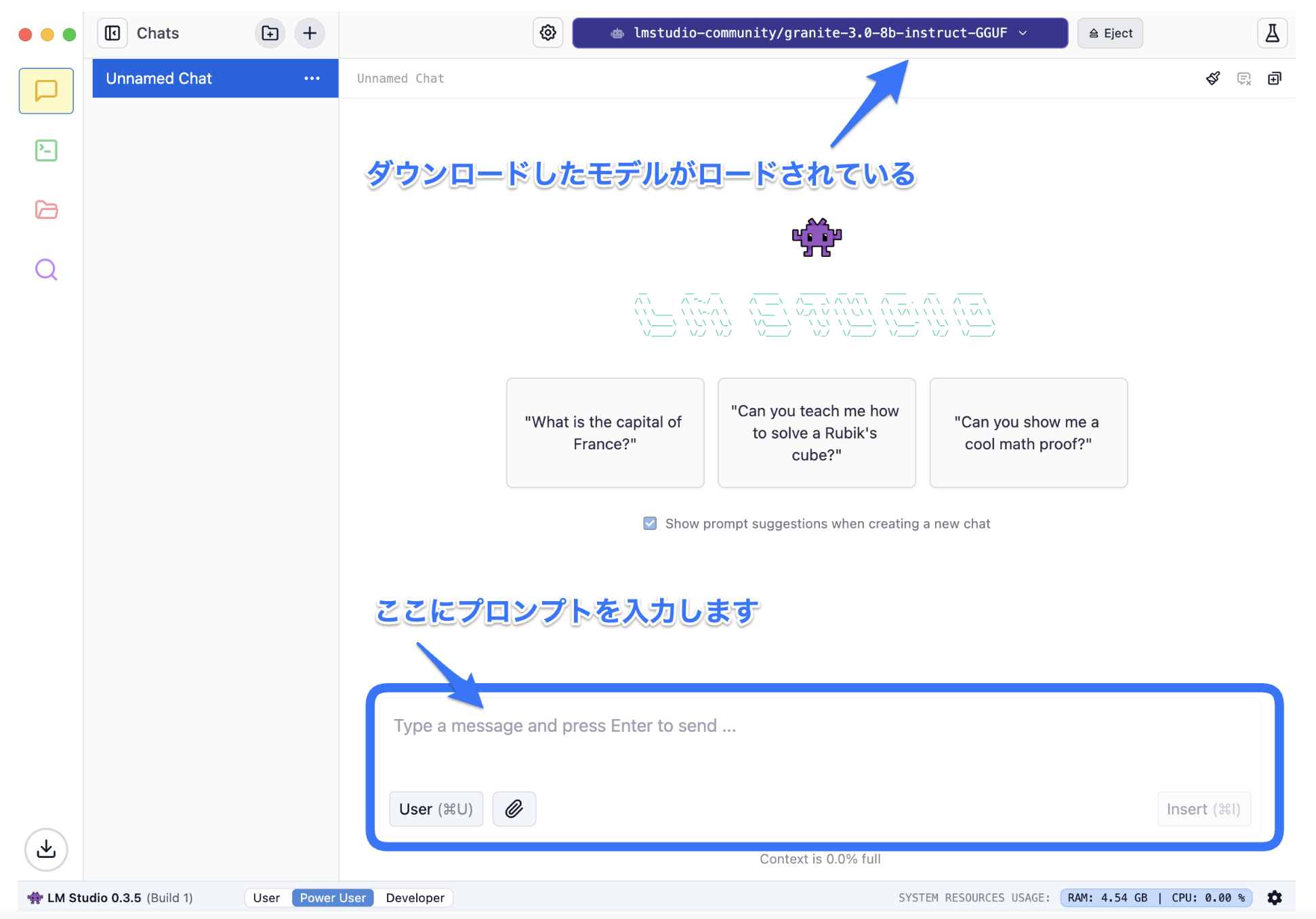

ダウンロードしたモデルがロードされ、LLMとの対話が可能になります!

That's All! ![]()

要約

ここまでくると、後はもう簡単ですね。

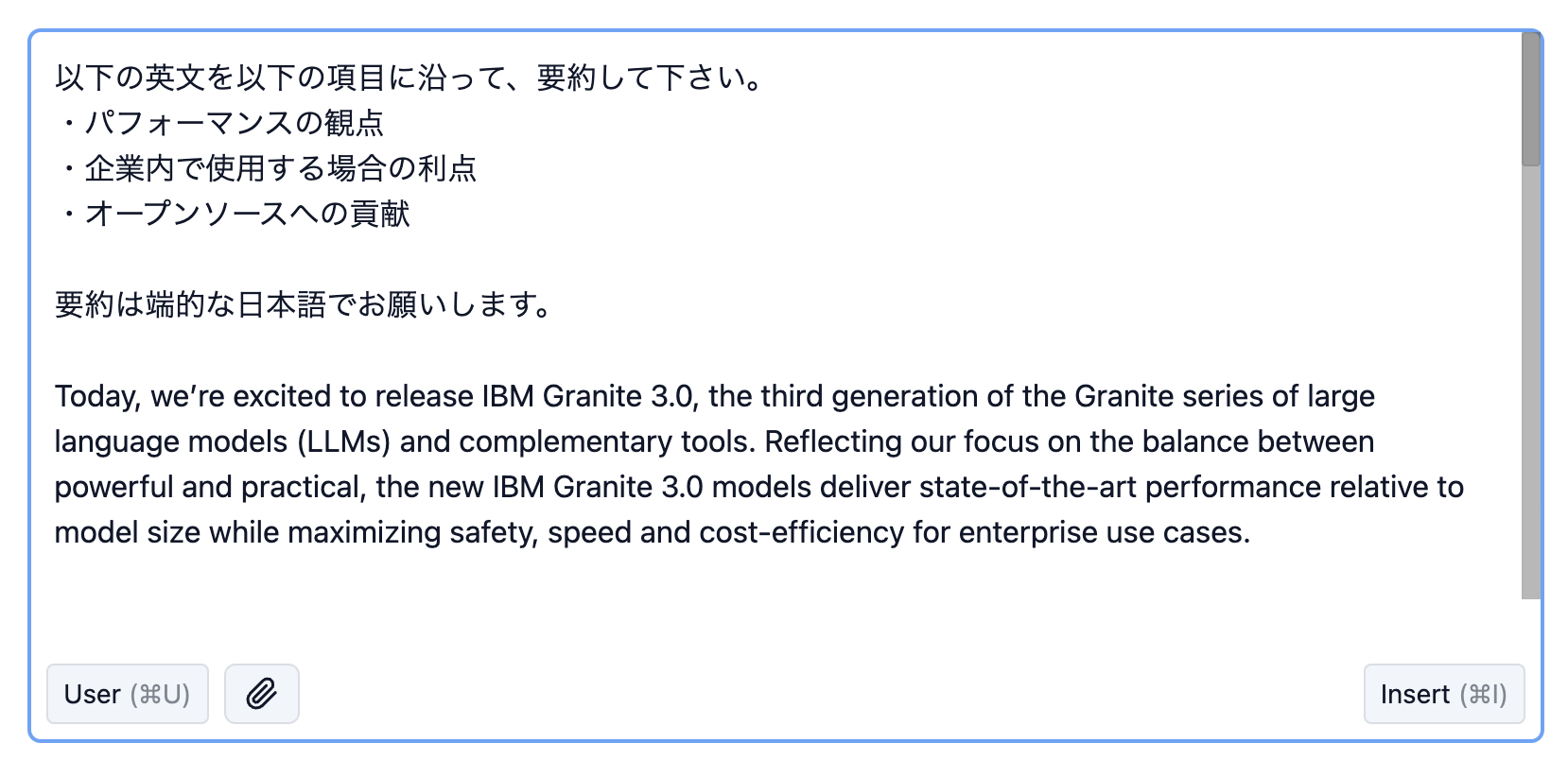

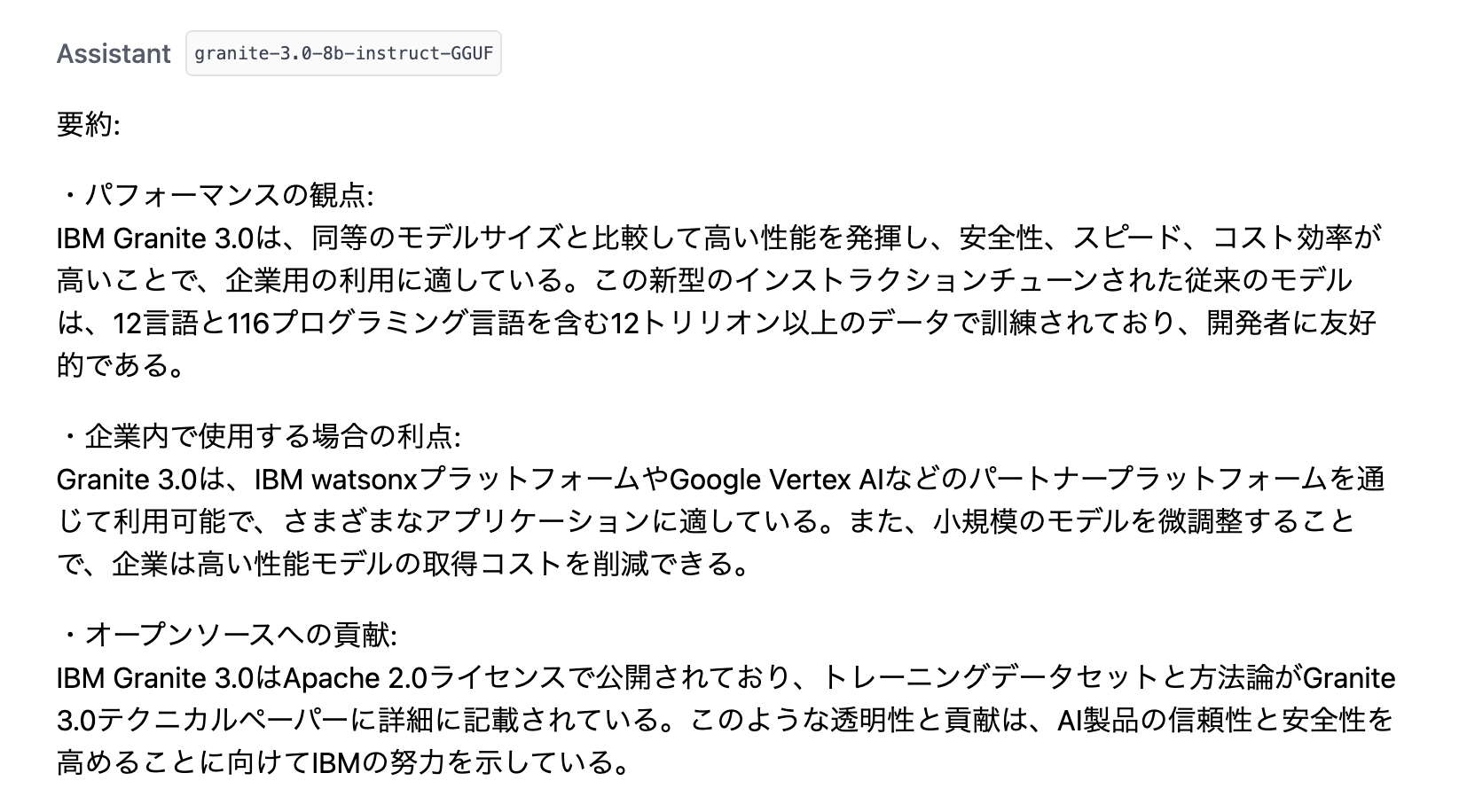

まずは、定番の要約を実行してみます。

要約する内容は、IBM Granite 3.0: open, state-of-the-art enterprise modelsの冒頭部分である約40行を使用します。

プロンプト

(コピペ用)

以下の英文を以下の項目に沿って、要約して下さい。

・パフォーマンスの観点

・企業内で使用する場合の利点

・オープンソースへの貢献

要約は端的な日本語でお願いします。

Today, we’re excited to release IBM Granite 3.0, the third generation of the Granite series of large language models (LLMs) and complementary tools. Reflecting our focus on the balance between powerful and practical, the new IBM Granite 3.0 models deliver state-of-the-art performance relative to model size while maximizing safety, speed and cost-efficiency for enterprise use cases.

Headlining the Granite 3.0 collection is a new, instruction-tuned, dense decoder-only LLM: Granite 3.0 8B Instruct. Trained using a novel two-phase method on over 12 trillion tokens of carefully vetted data across 12 different natural languages and 116 different programming languages, the developer-friendly Granite 3.0 8B Instruct is a workhorse enterprise model intended to serve as a primary building block for sophisticated workflows and tool-based use cases. Granite 3.0 8B Instruct matches leading similarly-sized open models on academic benchmarks while outperforming those peers on benchmarks for enterprise tasks and safety.

Fine-tuning smaller, fit-for-purpose models like Granite enables enterprises to pursue frontier model performance at a fraction of the cost. Tailoring Granite models to your organization’s unique needs through InstructLab, a collaborative, open source approach to augmenting model knowledge and skills with systematically generated synthetic data and phased-training protocols, can reduce costs and timelines even further.

In keeping with IBM’s strong historical commitment to open source, all Granite models are released under the permissive Apache 2.0 license, bucking the recent trend of closed models or open weight models released under idiosyncratic proprietary licensing agreements. In another divergence from industry trends for open models, IBM is providing a detailed disclosure of training data sets and methodologies in the Granite 3.0 technical paper, reaffirming IBM’s dedication to building transparency, safety and trust in AI products.

In its entirety, the IBM Granite 3.0 release comprises:

Dense, general purpose LLMs: Granite-3.0-8B-Instruct, Granite-3.0-8B-Base, Granite-3.0-2B-Instruct and Granite-3.0-2B-Base.

LLM-based input-output guardrail models: Granite-Guardian-3.0-8B, Granite-Guardian-3.0-2B

Mixture of experts (MoE) models for minimum latency: Granite-3.0-3B-A800M-Instruct, Granite-3.0-1B-A400M-Instruct

Speculative decoder for increased inference speed and efficiency: Granite-3.0-8B-Instruct-Accelerator

Impending updates planned for the remainder of 2024 include an expansion of all model context windows to 128K tokens, further improvements in multilingual support for 12 natural languages and the introduction of multimodal image-in, text-out capabilities.

Granite 3.0 8B Instruct and Granite 3.0 2B Instruct, as well as both Guardian 3.0 safety models, are available today for commercial use on the IBM watsonx platform. Granite 3.0 models are also available through platform partners, including Google Vertex AI (through Google Cloud's Vertex AI Model Garden integrations with Hugging Face), Hugging Face, NVIDIA (as NIM microservices), Ollama and Replicate.

Continuing IBM’s commitment to sustainability, IBM Granite 3.0 language models are trained on Blue Vela, powered by 100% renewable energy.

結果

元の英文をなかなかいい感じに要約し、日本語で出力してくれました。

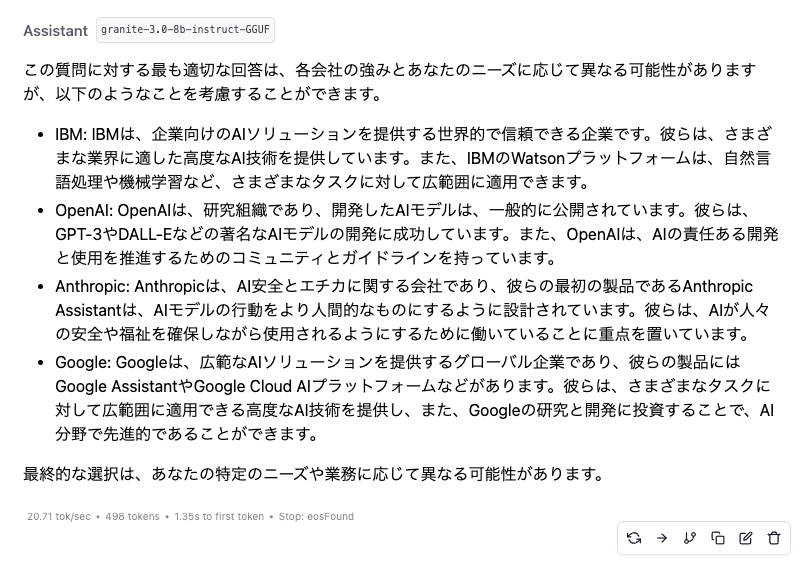

Q&A

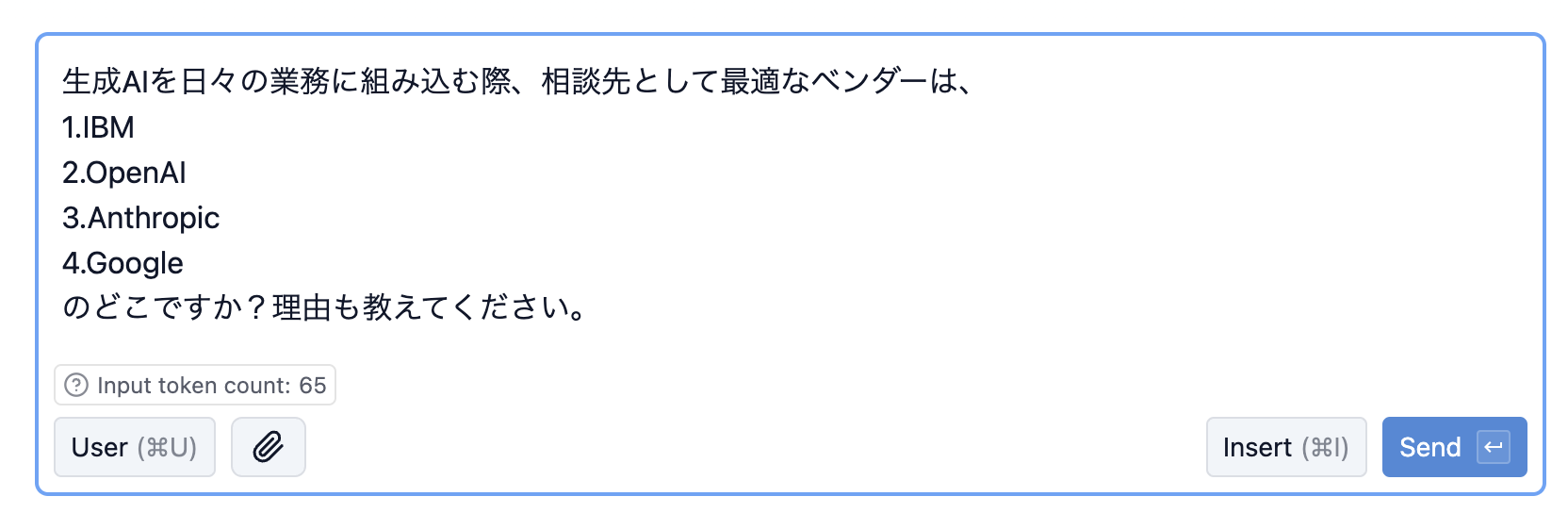

RAGではなく、LLMが持っている知識を使って回答させてみます。

プロンンプト

(コピペ用)

生成AIを日々の業務に組み込む際、相談先として最適なベンダーは、

1.IBM

2.OpenAI

3.Anthropic

4.Google

のどこですか?理由も教えてください。

結果

IBM Granite 3.0は、IBMに忖度せず、客観的な回答をしてくれました。

Great...

おわりに

いかがでしたでしょうか?

これまでもIBM Graniteはコード生成モデルを中心にオープンソースモデルとして公開されていたのですが、ついに日本に対応した言語モデルもオープンソースモデルとして公開されました。

LLMはプロンプト次第で色々なタスクに対応可能ですが、実際の業務に組み込んで運用するには多くのトライ&エラーが必要になります。そのトライ&エラーを自分のパソコン上で試すことができれば、その作業効率を大幅にアップすることが期待できます。

聞いたことはあるけど触ったことがない 又は 初めて聞いたという方、これを機に色々と試してみては如何でしょうか。

Let's Enjoy IBM Granite 3.0! ![]()

参考

IBM What's New

上記プレスリリースの日本語抄訳

IBM Granite 3.0

(GitHub) IBM Granite 3.0 Language Models including BenchMarks

watsonx.ai で使用可能なサポート対象の基盤モデル from watsonx.ai SaaS

Hugging Face IBM-Granite

LM Studio