Flink v1.11

より翻訳.機械翻訳を利用しながらのため間違いがある可能性があります.

チュートリアルではJavaのコードを取り上げます.

適宜,Scalaと読み替えてください.

Flinkを試す

ローカルインストール

以下のステップに従って,最新の安定版をダウンロードしてください.

Step1:ダウンロード

Flinkの実行には,__Java8__または__Java11__がインストールされている必要があります.

java -version

ver1.11.2をDownloadして,圧縮を解凍してください.

Step2:クラスターの起動

Flinkには,ローカルクラスタを起動するための単一のbashスクリプトが作成されています.

$ ./bin/start-cluster.sh

Starting cluster.

Starting standalonesession daemon on host.

Starting taskexecutor daemon on host.

Step3:Jobの開始

Flinkのリリースには多くのサンプルが含まれています.

これらのアプリケーションの1つを実行中のクラスタに素早くデプロイできます.

$ ./bin/flink run examples/streaming/WordCount.jar

$ tail log/flink-*-taskexecutor-*.out

(to,1)

(be,1)

(or,1)

(not,1)

(to,2)

(be,2)

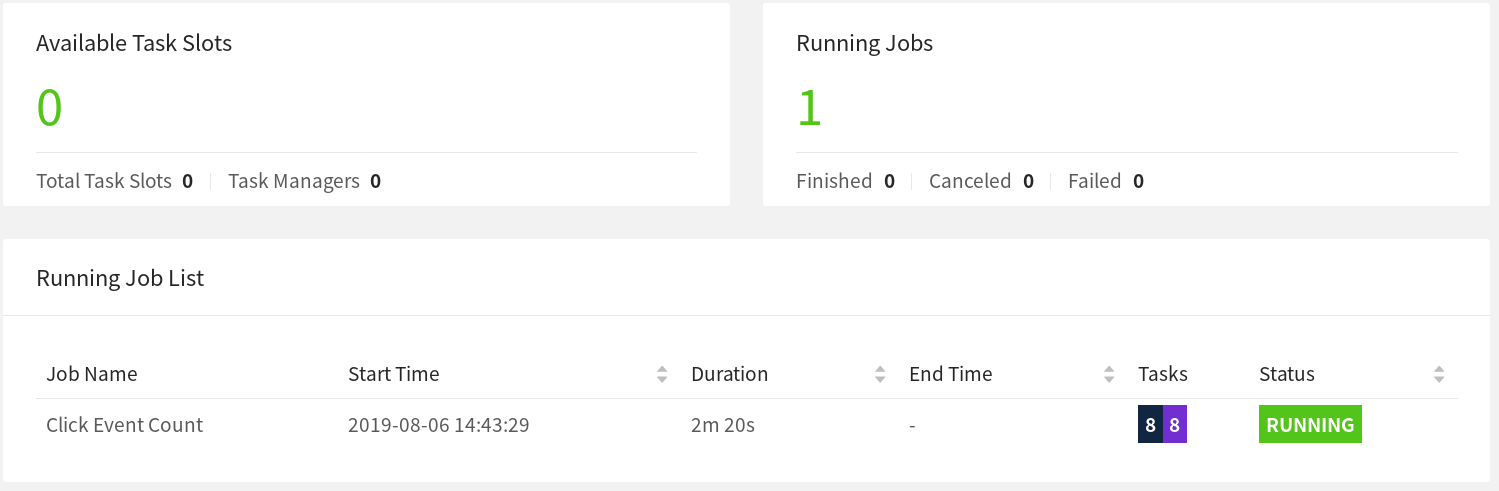

FlinkのWeb UIでクラスタの状態や実行中のジョブの状態を確認できます.

Step4:クラスターの停止

ジョブが終了したら,クラスタと実行中のコンポーネントをすぐに停止させることができます.

$ ./bin/stop-cluster.sh

Data StreamAPIによる不正検知

何を構築するのか?

クレジットカード詐欺は、デジタル時代に懸念が高まっています。

犯罪者は、詐欺を実行したり、安全でないシステムにハッキングしたりすることで、クレジットカード番号を盗みます。

盗まれた番号は、多くの場合、1ドル以下の少額の買い物をすることでテストされます。

それが成功した場合、彼らは、販売したり、自分のために保管したりできるアイテムを手に入れるために、より重要な買い物をします。

このチュートリアルでは、不審なクレジットカード取引を警告するための不正検知システムを構築します。

シンプルなルールのセットを使用して、Flinkを使用して高度なビジネスロジックを実装し、リアルタイムで行動する方法を見ることができます。

前提条件

このチュートリアルでは、JavaやScalaにある程度慣れていることを前提としていますが、他のプログラミング言語から来ている場合でも、それに沿って進むことができるはずです。

ヘルプ,行き詰まってしまいました.

行き詰ったら、コミュニティのサポートリソースをチェックしてください。

特に、Apache Flink のユーザメーリングリストは、どの Apache プロジェクトの中でも最も活発なものの一つとして常にランク付けされており、素早く助けを得るための素晴らしい方法となっています。

フォローアップの仕方

チュートリアルを進めていくには以下をインストールしたコンピュータが必要になります.

- Java 8 or 11

- Maven

NOTE: チュートリアルで紹介するコードは簡易的なものになっています.完璧なコードは一番下に記載

$ mvn archetype:generate \

-DarchetypeGroupId=org.apache.flink \

-DarchetypeArtifactId=flink-walkthrough-datastream-java \

-DarchetypeVersion=1.11.2 \

-DgroupId=frauddetection \

-DartifactId=frauddetection \

-Dversion=0.1 \

-Dpackage=spendreport \

-DinteractiveMode=false

必要に応じて,groupId, artifactId, packageを編集できます.

上記のパラメータを使用して,Mavenはチュートリアルを完了するための全ての依存関係を持つプロジェクトを含む__fraudDetection__という名前のフォルダを作成します.

プロジェクトをエディタにインポートした後、以下のコードを含むファイル FraudDetectionJob.java (またはFraudDetectionJob.scala) を見つけることができ、IDE内で直接実行できます.

データストリームを通してブレークポイントを設定してみて、どのように動作するかを理解するためにDEBUGモードでコードを実行してください。

FraudDetectionJob.java

package spendreport;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.walkthrough.common.sink.AlertSink;

import org.apache.flink.walkthrough.common.entity.Alert;

import org.apache.flink.walkthrough.common.entity.Transaction;

import org.apache.flink.walkthrough.common.source.TransactionSource;

public class FraudDetectionJob {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<Transaction> transactions = env

.addSource(new TransactionSource())

.name("transactions");

DataStream<Alert> alerts = transactions

.keyBy(Transaction::getAccountId)

.process(new FraudDetector())

.name("fraud-detector");

alerts

.addSink(new AlertSink())

.name("send-alerts");

env.execute("Fraud Detection");

}

}

FraudDetector.java

package spendreport;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.util.Collector;

import org.apache.flink.walkthrough.common.entity.Alert;

import org.apache.flink.walkthrough.common.entity.Transaction;

public class FraudDetector extends KeyedProcessFunction<Long, Transaction, Alert> {

private static final long serialVersionUID = 1L;

private static final double SMALL_AMOUNT = 1.00;

private static final double LARGE_AMOUNT = 500.00;

private static final long ONE_MINUTE = 60 * 1000;

@Override

public void processElement(

Transaction transaction,

Context context,

Collector<Alert> collector) throws Exception {

Alert alert = new Alert();

alert.setId(transaction.getAccountId());

collector.collect(alert);

}

}

コードの分解

この2つのファイルのコードを順を追って見ていきましょう.

FraudDetectionJobクラスはアプリケーションのデータフローを定義し、FraudDetectorクラスは不正トランザクションを検出する機能のビジネスロジックを定義しています。

ここでは、FraudDetectionJobクラスのメインメソッドでジョブがどのように組み立てられているかを説明します.

The Execution Environment(実行環境)

最初の行は StreamExecutionEnvironment を設定します.

The ExecutionEvironmentは、ジョブのプロパティを設定し、ソースを作成し、最終的にジョブの実行をトリガーする方法です。

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

Creating a Source(ソースの作成)

ソースは、Apache Kafka、Rabbit MQ、Apache Pulsarなどの外部システムからFlink Jobsにデータをインジェストします。

このチュートリアルでは、あなたが処理するためのクレジットカードトランザクションの無限のストリームを生成するソースを使用します。

各トランザクションには、アカウントID(accountId)、トランザクションが発生した時刻のタイムスタンプ(timestamp)、米ドルの金額(金額)が含まれています。

ソースに付けられた名前はあくまでもデバッグのためのものなので、何か問題が発生した場合、どこでエラーが発生したのかを知ることができます。

DataStream<Transaction> transactions = env

.addSource(new TransactionSource())

.name("transactions");

Partitioning Events & Detecting Fraud(イベントの分割と不正の検出)

トランザクションストリームには、多数のユーザーからの大量のトランザクションが含まれているため、複数の不正検出タスクで並行して処理する必要があります。不正行為はアカウントごとに発生するため、同じアカウントのすべてのトランザクションが、不正検知オペレータの同じ並列タスクによって処理されるようにする必要があります。

特定のキーのすべてのレコードを同じ物理タスクが処理するようにするには、DataStream#keyBy を使用してストリームを分割します。

process()呼び出しは、ストリーム内の各パーティショニングされた要素に関数を適用する演算子を追加します。

演算子は、"keyBy"(この場合はFraudDetector)がキー付きコンテキスト内で実行された直後に行うのが一般的です.

DataStream<Alert> alerts = transactions

.keyBy(Transaction::getAccountId)

.process(new FraudDetector())

.name("fraud-detector");

Outputting Results(結果を出力)

シンクは、Apache Kafka、Cassandra、AWS Kinesisなどの外部システムにDataStreamを書き込みます。

AlertSinkは、各Alertレコードを永続的なストレージに書き込むのではなく、ログレベルのinfoでログを記録するので、結果を簡単に確認することができます。

alerts.addSink(new AlertSink());

Executing the Job(ジョブの実行)

Flink アプリケーションはlazyにビルドされ、完全に形成されてから実行のためにクラスタに送られます。

ジョブの実行を開始するために StreamExecutionEnvironment#execute を呼び出し、名前を付けます。

env.execute("Fraud Detection");

The Fraud Detector(詐欺発見機)

不正検出器は、___KeyedProcessFunction___として実装されています。

そのメソッド KeyedProcessFunction#processElement は、すべてのトランザクションイベントに対して呼び出されます。

この最初のバージョンでは、すべてのトランザクションでアラートを生成しますが、これは保守的すぎると言う人もいるかもしれません。

このチュートリアルの次のステップでは、より意味のあるビジネスロジックで不正検知器を拡張していきます。

public class FraudDetector extends KeyedProcessFunction<Long, Transaction, Alert> {

private static final double SMALL_AMOUNT = 1.00;

private static final double LARGE_AMOUNT = 500.00;

private static final long ONE_MINUTE = 60 * 1000;

@Override

public void processElement(

Transaction transaction,

Context context,

Collector<Alert> collector) throws Exception {

Alert alert = new Alert();

alert.setId(transaction.getAccountId());

collector.collect(alert);

}

}

実際のアプリケーション(v1)を書く

最初のバージョンでは、詐欺検出器は、すぐに大規模なものが続く小さなトランザクションを行うすべてのアカウントのアラートを出力する必要があります。

小規模なものは1.00ドル未満のものであり、大規模なものは500ドル以上です。

あなたの詐欺検出器は、特定のアカウントのトランザクションの次のストリームを処理することを想像してみてください。

取引3と4は、0.09ドルという少額の取引の後に510ドルという多額の取引が続いているため、不正行為としてマークされるべきです。

あるいは、取引7、8、9は、0.02ドルの小額取引がすぐに大額取引の後に続くわけではないので、不正行為ではありませんが、その代わりに、パターンを崩す中間取引があります。

これを実現するには、不正検出器はイベントにまたがって情報を記憶していなければなりません。

イベントにまたがって情報を記憶するには状態/Stateが必要で、これがKeyedProcessFunctionを使用することにした理由です。

これにより、状態と時間の両方を細かく制御することができ、このウォークスルーを通して、より複雑な要件でアルゴリズムを進化させることができるようになります。

最も簡単な実装は、小さなトランザクションが処理されるたびに設定されるブーリアンフラグです。

大規模なトランザクションが発生した場合、そのアカウントにフラグが設定されているかどうかをチェックするだけです。

しかし、単にフラグをFraudDetectorクラスのメンバ変数として実装するだけではうまくいきません。

Flink は FraudDetector の同じオブジェクトインスタンスで複数のアカウントのトランザクションを処理します。

つまり、アカウント A と B が FraudDetector の同じインスタンスを介してルーティングされている場合、アカウント A のトランザクションでフラグが true に設定され、アカウント B のトランザクションで false アラートが発生する可能性があります。

もちろん、個々のキーのフラグを追跡するためにMapのようなデータ構造を使用することもできますが、単純なメンバ変数はフォールトトレラントではなく、障害が発生した場合にはすべての情報が失われます。

そのため、アプリケーションが障害から回復するために再起動しなければならない場合、不正検出器は警告を見逃す可能性があります。

これらの課題に対処するために、Flink は、通常のメンバ変数とほぼ同じくらい簡単に使用できるフォールトトレラント状態のプリミティブを提供しています。

ValueStateはキー付きステートの一形態であり、キー付きコンテキストで適用される演算子(DataStream#keyByの直後の演算子)でのみ利用可能です。

演算子のキー付き状態は、現在処理されているレコードのキーに自動的にスコープされます。

この例では、キーは現在のトランザクションのアカウント ID (keyBy() で宣言されたもの) であり、FraudDetector はアカウントごとに独立した状態を維持しています。

ValueStateは、Flinkがどのように変数を管理すべきかについてのメタデータを含むValueStateDescriptorを使用して作成されます。

状態は、関数がデータの処理を開始する前に登録しておく必要があります。

そのための正しいフックが open() メソッドです。

public class FraudDetector extends KeyedProcessFunction<Long, Transaction, Alert> {

private static final long serialVersionUID = 1L;

private transient ValueState<Boolean> flagState;

@Override

public void open(Configuration parameters) {

ValueStateDescriptor<Boolean> flagDescriptor = new ValueStateDescriptor<>(

"flag",

Types.BOOLEAN);

flagState = getRuntimeContext().getState(flagDescriptor);

}

ValueStateは、Java標準ライブラリのAtomicReferenceやAtomicLongに似たラッパークラスです。

update は状態を設定し、value は現在の値を取得し、clear はその内容を削除します。アプリケーションの開始時や ValueState#clear を呼び出した後など、特定のキーの状態が空の場合、ValueState#value は null を返します。

ValueState#valueによって返されたオブジェクトへの変更は、システムによって認識されることが保証されていないため、すべての変更はValueState#updateによって実行されなければなりません。

それ以外の場合は、フォールト トレランスは Flink が自動的に管理しているので、他の標準変数と同じように操作することができます。

以下に、フラグステートを使用して潜在的な不正トランザクションを追跡する方法の例を示します。

@Override

public void processElement(

Transaction transaction,

Context context,

Collector<Alert> collector) throws Exception {

// Get the current state for the current key

Boolean lastTransactionWasSmall = flagState.value();

// Check if the flag is set

if (lastTransactionWasSmall != null) {

if (transaction.getAmount() > LARGE_AMOUNT) {

// Output an alert downstream

Alert alert = new Alert();

alert.setId(transaction.getAccountId());

collector.collect(alert);

}

// Clean up our state

flagState.clear();

}

if (transaction.getAmount() < SMALL_AMOUNT) {

// Set the flag to true

flagState.update(true);

}

}

すべてのトランザクションについて、不正検出器はそのアカウントのフラグの状態をチェックします。

ValueStateは常に現在のキー、つまりアカウントにスコープされていることを覚えておいてください。

フラグが NULL でない場合は、そのアカウントの最後の取引が少額であったことを意味し、この取引の金額が大きい場合は、不正検知器は不正警告を出力する。

そのチェックの後、フラグ状態は無条件にクリアされる。

現在の取引が不正警告を引き起こし、パターンが終了したか、現在の取引が警告を引き起こしておらず、パターンが壊れているので再開する必要があるかのいずれかである。

最後に、トランザクションの金額が小さいかどうかをチェックします。もしそうであれば、次のイベントでチェックできるようにフラグが設定されます。

ValueStateには、実際にはunset ( null)、true、falseの3つの状態があることに注意してください。

このジョブでは、フラグがセットされているかどうかをチェックするために、unset ( null) と true のみを使用します。

不正検知器 v2.状態+時間=❤️

詐欺師は、テスト取引が気づかれる可能性を減らすために、大きな買い物をするのに時間をかけません。

例えば、詐欺検出器に1分間のタイムアウトを設定したいとします。

FlinkのKeyedProcessFunctionでは、将来のある時点でコールバックメソッドを呼び出すタイマーを設定することができます。

それでは、新しい要件を満たすようにジョブを修正する方法を見てみましょう。

- フラグがtrueに設定されているときはいつでも、未来の1分間のタイマーを設定してください。

- タイマーが作動したら、フラグの状態をクリアしてリセットします。

- フラグがクリアされた場合、タイマーはキャンセルされるべきです。

タイマーをキャンセルするには、それが何時までに設定されているかを覚えておく必要があり、覚えておくことは状態を意味します。

private transient ValueState<Boolean> flagState;

private transient ValueState<Long> timerState;

@Override

public void open(Configuration parameters) {

ValueStateDescriptor<Boolean> flagDescriptor = new ValueStateDescriptor<>(

"flag",

Types.BOOLEAN);

flagState = getRuntimeContext().getState(flagDescriptor);

ValueStateDescriptor<Long> timerDescriptor = new ValueStateDescriptor<>(

"timer-state",

Types.LONG);

timerState = getRuntimeContext().getState(timerDescriptor);

}

KeyedProcessFunction#processElementは、タイマーサービスを含むコンテキストで呼び出されます。

タイマーサービスは、現在時刻の問い合わせ、タイマーの登録、タイマーの削除などを行うことができます。

これを使えば、フラグが設定されるたびに1分先のタイマーを設定し、そのタイムスタンプをtimerStateに格納することができます。

if (transaction.getAmount() < SMALL_AMOUNT) {

// set the flag to true

flagState.update(true);

// set the timer and timer state

long timer = context.timerService().currentProcessingTime() + ONE_MINUTE;

context.timerService().registerProcessingTimeTimer(timer);

timerState.update(timer);

}

処理時間はwall clock timeであり、オペレータを動かしている機械のシステムクロックによって決定されます。

タイマーが発生すると、KeyedProcessFunction#onTimerを呼び出します。

このメソッドをオーバーライドすることで、フラグをリセットするコールバックを実装することができます。

public void onTimer(long timestamp, OnTimerContext ctx, Collector<Alert> out) {

// remove flag after 1 minute

timerState.clear();

flagState.clear();

}

最後に、タイマーをキャンセルするには、登録されているタイマーを削除して、タイマーの状態を削除する必要があります.

これをヘルパーメソッドでラップして、flagState.clear()の代わりにこのメソッドを呼び出すことができます。

private void cleanUp(Context ctx) throws Exception {

// delete timer

Long timer = timerState.value();

ctx.timerService().deleteProcessingTimeTimer(timer);

// clean up all state

timerState.clear();

flagState.clear();

}

完全に機能的で、ステートフルな分散型ストリーミングアプリケーションです!

完成したアプリケーション

package spendreport;

import org.apache.flink.api.common.state.ValueState;

import org.apache.flink.api.common.state.ValueStateDescriptor;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.util.Collector;

import org.apache.flink.walkthrough.common.entity.Alert;

import org.apache.flink.walkthrough.common.entity.Transaction;

public class FraudDetector extends KeyedProcessFunction<Long, Transaction, Alert> {

private static final long serialVersionUID = 1L;

private static final double SMALL_AMOUNT = 1.00;

private static final double LARGE_AMOUNT = 500.00;

private static final long ONE_MINUTE = 60 * 1000;

private transient ValueState<Boolean> flagState;

private transient ValueState<Long> timerState;

@Override

public void open(Configuration parameters) {

ValueStateDescriptor<Boolean> flagDescriptor = new ValueStateDescriptor<>(

"flag",

Types.BOOLEAN);

flagState = getRuntimeContext().getState(flagDescriptor);

ValueStateDescriptor<Long> timerDescriptor = new ValueStateDescriptor<>(

"timer-state",

Types.LONG);

timerState = getRuntimeContext().getState(timerDescriptor);

}

@Override

public void processElement(

Transaction transaction,

Context context,

Collector<Alert> collector) throws Exception {

// Get the current state for the current key

Boolean lastTransactionWasSmall = flagState.value();

// Check if the flag is set

if (lastTransactionWasSmall != null) {

if (transaction.getAmount() > LARGE_AMOUNT) {

//Output an alert downstream

Alert alert = new Alert();

alert.setId(transaction.getAccountId());

collector.collect(alert);

}

// Clean up our state

cleanUp(context);

}

if (transaction.getAmount() < SMALL_AMOUNT) {

// set the flag to true

flagState.update(true);

long timer = context.timerService().currentProcessingTime() + ONE_MINUTE;

context.timerService().registerProcessingTimeTimer(timer);

timerState.update(timer);

}

}

@Override

public void onTimer(long timestamp, OnTimerContext ctx, Collector<Alert> out) {

// remove flag after 1 minute

timerState.clear();

flagState.clear();

}

private void cleanUp(Context ctx) throws Exception {

// delete timer

Long timer = timerState.value();

ctx.timerService().deleteProcessingTimeTimer(timer);

// clean up all state

timerState.clear();

flagState.clear();

}

}

期待される出力

提供されたTransactionSourceを使用してこのコードを実行すると、アカウント3の不正行為の警告が表示されます。

タスクマネージャーのログに以下のような出力が表示されるはずです。

2019-08-19 14:22:06,220 INFO org.apache.flink.walkthrough.common.sink.AlertSink - Alert{id=3}

2019-08-19 14:22:11,383 INFO org.apache.flink.walkthrough.common.sink.AlertSink - Alert{id=3}

2019-08-19 14:22:16,551 INFO org.apache.flink.walkthrough.common.sink.AlertSink - Alert{id=3}

2019-08-19 14:22:21,723 INFO org.apache.flink.walkthrough.common.sink.AlertSink - Alert{id=3}

2019-08-19 14:22:26,896 INFO org.apache.flink.walkthrough.common.sink.AlertSink - Alert{id=3}

Table APIによるリアルタイムレポート

Apache Flink は、バッチ処理とストリーム処理のための統一されたリレーショナル API として Table API を提供しています。

FlinkのTable APIは、データ分析、データパイプライン、ETLアプリケーションの定義を容易にするために一般的に使用されています。

何を構築するのか

このチュートリアルでは、口座別に金融取引を追跡するリアルタイムダッシュボードの構築方法を学びます。

パイプラインでは、Kafkaからデータを読み込み、結果をGrafana経由で可視化されたMySQLに書き込みます。

前提条件

このチュートリアルでは、Java や Scala にある程度慣れていることを前提としていますが、他のプログラミング言語を使用している場合でも十分に理解できるはずです。

また、SELECT句やGROUP BY句などの基本的なリレーショナル概念に精通していることも前提としています。

ヘルプ!行き詰まっています.

行き詰ったら、コミュニティのサポートリソースをチェックしてください。

特に、Apache Flink のユーザメーリングリストは、どの Apache プロジェクトの中でも最も活発なものの一つであり、すぐに助けを得るための素晴らしい方法の一つとなっています。

チュートリアルをフォローするには

あなたがチュートリアルを行う場合,以下をインストールしたコンピュータが必要になります.

- Java 8または11

- Maven

- Docker

必要な設定ファイルは、flink-playgrounds リポジトリで入手できます。

ダウンロードしたら、IDE でプロジェクト flink-playground/table-walkthrough を開き、SpendReport というファイルに移動します。

EnvironmentSettings settings = EnvironmentSettings.newInstance().build();

TableEnvironment tEnv = TableEnvironment.create(settings);

tEnv.executeSql("CREATE TABLE transactions (\n" +

" account_id BIGINT,\n" +

" amount BIGINT,\n" +

" transaction_time TIMESTAMP(3),\n" +

" WATERMARK FOR transaction_time AS transaction_time - INTERVAL '5' SECOND\n" +

") WITH (\n" +

" 'connector' = 'kafka',\n" +

" 'topic' = 'transactions',\n" +

" 'properties.bootstrap.servers' = 'kafka:9092',\n" +

" 'format' = 'csv'\n" +

")");

tEnv.executeSql("CREATE TABLE spend_report (\n" +

" account_id BIGINT,\n" +

" log_ts TIMESTAMP(3),\n" +

" amount BIGINT\n," +

" PRIMARY KEY (account_id, log_ts) NOT ENFORCED" +

") WITH (\n" +

" 'connector' = 'jdbc',\n" +

" 'url' = 'jdbc:mysql://mysql:3306/sql-demo',\n" +

" 'table-name' = 'spend_report',\n" +

" 'driver' = 'com.mysql.jdbc.Driver',\n" +

" 'username' = 'sql-demo',\n" +

" 'password' = 'demo-sql'\n" +

")");

Table transactions = tEnv.from("transactions");

report(transactions).executeInsert("spend_report");

コードの分解

実行環境

最初の2行はTableEnvironmentを設定します。テーブル環境は、ジョブのプロパティを設定したり、バッチかストリーミング・アプリケーションかを指定したり、ソースを作成したりする方法です。

このチュートリアルでは、ストリーミング実行を使用する標準のテーブル環境を作成します。

EnvironmentSettings settings = EnvironmentSettings.newInstance().build();

TableEnvironment tEnv = TableEnvironment.create(settings);

テーブルの登録

次に、テーブルが現在のカタログに登録されており、これを使用して外部システムに接続して、バッチデータとストリーミングデータの両方を読み書きすることができます。

テーブル ソースは、データベース、キー値ストア、メッセージ キュー、ファイル システムなどの外部システムに保存されているデータへのアクセスを提供します。

テーブル シンクは、テーブルを外部ストレージ システムに送信します。ソースとシンクのタイプに応じて、CSV、JSON、Avro、またはParquetなどの異なるフォーマットをサポートしています。

tEnv.executeSql("CREATE TABLE transactions (\n" +

" account_id BIGINT,\n" +

" amount BIGINT,\n" +

" transaction_time TIMESTAMP(3),\n" +

" WATERMARK FOR transaction_time AS transaction_time - INTERVAL '5' SECOND\n" +

") WITH (\n" +

" 'connector' = 'kafka',\n" +

" 'topic' = 'transactions',\n" +

" 'properties.bootstrap.servers' = 'kafka:9092',\n" +

" 'format' = 'csv'\n" +

")");

トランザクション入力テーブルと支出レポート出力テーブルの2つのテーブルが登録されています。

transaction (transactions) テーブルでは、クレジットカードのトランザクションを読み取ることができ、アカウント ID (account_id)、タイムスタンプ (transaction_time)、米ドルの金額 (amount) が含まれています。

このテーブルは、CSV データを含むトランザクションと呼ばれる Kafka トピックの論理ビューです。

tEnv.executeSql("CREATE TABLE spend_report (\n" +

" account_id BIGINT,\n" +

" log_ts TIMESTAMP(3),\n" +

" amount BIGINT\n," +

" PRIMARY KEY (account_id, log_ts) NOT ENFORCED" +

") WITH (\n" +

" 'connector' = 'jdbc',\n" +

" 'url' = 'jdbc:mysql://mysql:3306/sql-demo',\n" +

" 'table-name' = 'spend_report',\n" +

" 'driver' = 'com.mysql.jdbc.Driver',\n" +

" 'username' = 'sql-demo',\n" +

" 'password' = 'demo-sql'\n" +

")");

2 番目のテーブル spend_report には、集計の最終結果が格納されています。

その基礎となるストレージは MySql データベースのテーブルです。

クエリ

環境を設定し、テーブルを登録したら、最初のアプリケーションを構築する準備ができました。

TableEnvironmentから入力テーブルから行を読み込み、その結果をexecuteInsertを使用して出力テーブルに書き込むことができます。

レポート関数はビジネスロジックを実装する場所です。

現在は未実装です。

Table transactions = tEnv.from("transactions");

report(transactions).executeInsert("spend_report");

テスト

このプロジェクトには、レポートのロジックを検証するセカンダリ・テスト・クラス SpendReportTest が含まれています。

これは、バッチ・モードでテーブル環境を作成します。

EnvironmentSettings settings = EnvironmentSettings.newInstance().inBatchMode().build();

TableEnvironment tEnv = TableEnvironment.create(settings);

___Flinkのユニークな特性の1つ___は、バッチとストリーミングの間で一貫したセマンティクスを提供していることです。

つまり、静的なデータセット上でバッチモードでアプリケーションを開発・テストし、ストリーミングアプリケーションとして本番環境にデプロイすることができます。

こちらも参照

これでジョブセットアップの骨格ができたので、ビジネスロジックを追加する準備ができました。

目標は、1日の各時間帯の各アカウントの総支出を表示するレポートを作成することです。

これは、タイムスタンプの列をミリ秒単位から時間単位に切り下げる必要があることを意味します。

Flinkは、純粋なSQLまたはTable APIを使用したリレーショナルアプリケーションの開発をサポートしています。

Table APIはSQLにインスパイアされた流暢なDSLで、Python、Java、Scalaで記述でき、IDEとの強力な統合をサポートしています。

SQLクエリのように、テーブルプログラムは必要なフィールドを選択し、キーでグループ化することができます。

これらの機能は、フロアや和のようなbuilt-in functionとallong、あなたはこのレポートを書くことができます。

public static Table report(Table transactions) {

return transactions.select(

$("account_id"),

$("transaction_time").floor(TimeIntervalUnit.HOUR).as("log_ts"),

$("amount"))

.groupBy($("account_id"), $("log_ts"))

.select(

$("account_id"),

$("log_ts"),

$("amount").sum().as("amount"));

}

ユーザ定義機能

Flinkには限られた数の組み込み関数が含まれており、時にはユーザー定義の関数で拡張する必要があります。

floorが事前に定義されていない場合は、自分で実装することができます。

import java.time.LocalDateTime;

import java.time.temporal.ChronoUnit;

import org.apache.flink.table.annotation.DataTypeHint;

import org.apache.flink.table.functions.ScalarFunction;

public class MyFloor extends ScalarFunction {

public @DataTypeHint("TIMESTAMP(3)") LocalDateTime eval(

@DataTypeHint("TIMESTAMP(3)") LocalDateTime timestamp) {

return timestamp.truncatedTo(ChronoUnit.HOURS);

}

}

そして、それをアプリケーションに素早く統合します。

public static Table report(Table transactions) {

return transactions.select(

$("account_id"),

call(MyFloor.class, $("transaction_time")).as("log_ts"),

$("amount"))

.groupBy($("account_id"), $("log_ts"))

.select(

$("account_id"),

$("log_ts"),

$("amount").sum().as("amount"));

}

このクエリは、トランザクションテーブルからすべてのレコードを消費し、レポートを計算し、効率的でスケーラブルな方法で結果を出力します。

この実装でテストを実行すると合格となります。

ウィンドウの追加

時間に基づいてデータをグループ化することは、データ処理における典型的な操作であり、特に無限ストリームを扱う場合にはよく行われます。時間に基づくグルーピングはウィンドウと呼ばれ、Flinkは柔軟なウィンドウのセマンティクスを提供しています。

最も基本的なタイプのウィンドウはタンブルウィンドウと呼ばれ、サイズが固定されていてバケットが重ならないものです。

public static Table report(Table transactions) {

return transactions

.window(Tumble.over(lit(1).hour()).on($("transaction_time")).as("log_ts"))

.groupBy($("account_id"), $("log_ts"))

.select(

$("account_id"),

$("log_ts").start().as("log_ts"),

$("amount").sum().as("amount"));

}

これは、アプリケーションがタイムスタンプ列に基づいて1時間のタンブリングウィンドウを使用するように定義します。

つまり、タイムスタンプが2019-06-01 01:23:47の行は、2019-06-01 01:00:00のウィンドウに置かれます。

時間に基づく集計は、他の属性とは対照的に、一般的に連続的なストリーミングアプリケーションでは時間が進むため、ユニークなものです。

フロアやあなたのUDFとは異なり、ウィンドウ関数は本質的なものであり、ランタイムが追加の最適化を適用することができます。

バッチコンテキストでは、ウィンドウはタイムスタンプ属性によってレコードをグループ化するための便利なAPIを提供します。

この実装でテストを実行しても合格します。

ストリーミングでもう一度!

これが、完全に機能的で、ステートフルな分散型ストリーミングアプリケーションです。

クエリはKafkaからのトランザクションのストリームを継続的に消費し、1時間ごとの消費量を計算し、準備が整うとすぐに結果を出力します。

入力には制限がないので、クエリは手動で停止するまで実行し続けます。

また、ジョブは時間ウィンドウベースの集約を使用するので、Flinkは特定のウィンドウにレコードが到着しないことをフレームワークが知っているときに状態をクリーンアップするなど、特定の最適化を実行することができます。

テーブルの遊び場(play ground)は完全にドッカー化されており、ストリーミングアプリケーションとしてローカルで実行可能です。

環境には、Kafka トピック、継続的データ生成器、MySql、Grafana が含まれています。

table-walkthrough フォルダ内から docker-compose スクリプトを起動します。

$ docker-compose build

$ docker-compose up -d

実行中のジョブの情報は、Flink コンソールから確認できます。

MySQLの内部から結果を探ります。

$ docker-compose exec mysql mysql -Dsql-demo -usql-demo -pdemo-sql

mysql> use sql-demo;

Database changed

mysql> select count(*) from spend_report;

+----------+

| count(*) |

+----------+

| 110 |

+----------+

最後にGrafanaに行って、完全に可視化された結果を見てみましょう

Python API

Python Table APIチュートリアル

資料を参照することで,詳細を知ることができる.

Python Table API Tutorial

*個人的に興味があるため,この部分も翻訳します.

Flink Operations Playground

Apache Flink を様々な環境に展開して運用する方法はたくさんあります。

このような多様性に関わらず、Flink クラスタの基本的な構成要素は変わりませんし、同様の運用原則が適用されます。

この遊び場では、Flink ジョブの管理と実行方法を学びます。

アプリケーションをデプロイして監視する方法、Flink がジョブの障害からどのように回復するかを体験し、アップグレードや再スケーリングなどの日常的な運用タスクを実行する方法を見ることができます。

遊び場(play ground)の解剖学

この遊び場は、長く生きている Flink セッションクラスタと Kafka クラスタで構成されています。

Flink クラスタは常にジョブマネージャと 1 つ以上の Flink タスクマネージャで構成されています。ジョブマネージャはジョブの投入、ジョブの監視、リソース管理を担当します。

Flink タスクマネージャはワーカープロセスであり、Flink ジョブを構成する実際のタスクの実行を担当します。

このプレイグラウンドでは、最初は 1 つのタスクマネージャーでスタートしますが、後から複数のタスクマネージャーにスケールアップしていきます。

さらに、このプレイグラウンドには専用のクライアントコンテナが付属しており、これを使用して Flink ジョブを最初に投入し、後から様々な運用タスクを実行します。

クライアントコンテナは Flink Cluster 自体には必要ありませんが、使いやすさのためだけに含まれています。

Kafka ClusterはZookeeperサーバーとKafka Brokerで構成されています。

プレイグラウンドが開始されると、Flink Event CountというFlinkジョブがJobManagerに投入されます。

さらに、2つのKafkaトピックの入力と出力が作成されます。

ジョブは、入力トピックからタイムスタンプとページを持つClickEventsを消費します。

イベントは、ページごとにキーが設定され、15 秒のウィンドウでカウントされます。結果は出力トピックに書き込まれます。

6 つの異なるページがあり、ページごとに 1000 クリック イベントを生成し、15 秒のウィンドウでカウントしています。

したがって、Flinkジョブの出力は、ページとウィンドウごとに1000ビューを表示する必要があります。

プレイグラウンドの開始

プレイグラウンドの環境は、ほんの数ステップで設定できます。

必要なコマンドを順を追って説明し、すべてが正しく動作していることを検証する方法を紹介します。

マシンに Docker (1.12+) と docker-compose (2.1+) がインストールされていることを想定しています。

必要な設定ファイルはflink-playgroundsリポジトリにあります。それを確認して、環境を構築してください。

git clone --branch release-1.11 https://github.com/apache/flink-playgrounds.git

cd flink-playgrounds/operations-playground

docker-compose build

docker-compose up -d

その後、以下のコマンドで実行中のDockerコンテナを検査することができます。

docker-compose ps

Name Command State Ports

-----------------------------------------------------------------------------------------------------------------------------

operations-playground_clickevent-generator_1 /docker-entrypoint.sh java ... Up 6123/tcp, 8081/tcp

operations-playground_client_1 /docker-entrypoint.sh flin ... Exit 0

operations-playground_jobmanager_1 /docker-entrypoint.sh jobm ... Up 6123/tcp, 0.0.0.0:8081->8081/tcp

operations-playground_kafka_1 start-kafka.sh Up 0.0.0.0:9094->9094/tcp

operations-playground_taskmanager_1 /docker-entrypoint.sh task ... Up 6123/tcp, 8081/tcp

operations-playground_zookeeper_1 /bin/sh -c /usr/sbin/sshd ... Up 2181/tcp, 22/tcp, 2888/tcp, 3888/tcp

これは、クライアントコンテナが正常に Flink ジョブを送信し(Exit 0)、すべてのクラスタコンポーネントとデータジェネレータが実行されていることを示しています(Up)。

呼び出すことで、プレイグラウンド環境を停止することができます。

docker-compose down -v

プレイグラウンドに入る

プレイグラウンドには、試してみたり、チェックしてみたりできるものがたくさんあります。

次の2つのセクションでは、Flink Clusterとの対話方法とFlinkの主要な機能のいくつかを紹介します。

Flink WebUI

Flink クラスタを観察するための最も自然な出発点は、http://localhost:8081 で公開されている WebUI です。

すべてがうまくいった場合、クラスタは最初は1つのTaskManagerで構成され、Click Event Countと呼ばれるジョブを実行していることがわかります。

Flink WebUIには、Flinkクラスタとそのジョブに関する多くの有用で興味深い情報(ジョブグラフ、メトリクス、チェックポイント統計、タスクマネージャのステータスなど)が含まれています。

ログ

JobManager

JobManagerのログはdocker-compose経由で調査することができます。

docker-compose logs -f jobmanager

最初の起動後、主にチェックポイントが完了するたびにログメッセージが表示されるはずです。

TaskManager

askManagerのログも同様に調査することができます。

docker-compose logs -f taskmanager

最初の起動後、主にチェックポイントが完了するたびにログメッセージが表示されるはずです。

Flink CLI

Flink CLIはクライアントコンテナ内から使用することができます。

例えば、Flink CLIのヘルプメッセージを表示するには、次のように実行します。

docker-compose run --no-deps client flink --help

Flink REST API

Flink REST API はホスト上の localhost:8081 を介して、またはクライアントコンテナから jobmanager:8081 を介して公開されます。

curl localhost:8081/jobs

Kafka Topics

Kafka Topicsに書き込まれたレコードを見ることができます.

//input topic (1000 records/s)

docker-compose exec kafka kafka-console-consumer.sh \

--bootstrap-server localhost:9092 --topic input

//output topic (24 records/min)

docker-compose exec kafka kafka-console-consumer.sh \

--bootstrap-server localhost:9092 --topic output

遊ぶ時間が来た!

FlinkとDockerコンテナの操作方法を学んだところで、私たちのプレイグラウンドで試すことができる一般的な運用タスクをいくつか見てみましょう。

これらのタスクはすべて互いに独立しています。

ほとんどのタスクはCLIとREST API経由で実行できます。

*CLIの翻訳を進めます.REST APIに適宜読み替えてください.

ランニングジョブの一覧

Command

docker-compose run --no-deps client flink list

期待される出力

Waiting for response...

------------------ Running/Restarting Jobs -------------------

16.07.2019 16:37:55 : <job-id> : Click Event Count (RUNNING)

--------------------------------------------------------------

No scheduled jobs.

JobIDは、ジョブの送信時にジョブに割り当てられ、CLIまたはREST APIを介してジョブ上でアクションを実行するために必要となります。

障害と復旧を観察する

Flink は、(部分的な)故障の下で正確な一度きりの処理を保証します。このプレイグラウンドでは、この動作を観察し、(ある程度は)検証することができます。

Step1: 出力の観察

上述したように、このプレイグラウンドのイベントは、各ウィンドウに正確に 1,000 レコードが含まれるように生成されます。

したがって、Flink がデータの損失や重複なしに TaskManager の障害から正常に復旧したことを確認するには、出力トピックを追跡して、復旧後にすべてのウィンドウが存在し、カウントが正しいことを確認することができます。

そのためには、出力トピックからの読み取りを開始し、回復後までこのコマンドを実行したままにします (ステップ 3)。

docker-compose exec kafka kafka-console-consumer.sh \

--bootstrap-server localhost:9092 --topic output

Step2: 障害の導入

部分的な障害をシミュレートするために、TaskManager を終了させることができます。

本番環境では、これは TaskManager プロセス、TaskManager マシンの損失、または単にフレームワークやユーザーコードから投げられる一時的な例外 (外部リソースが一時的に使用できなくなるなど) に対応します。

docker-compose kill taskmanager

数秒後、ジョブマネージャはタスクマネージャの損失に気付き、影響を受けたジョブをキャンセルし、すぐにリカバリーのためにジョブを再投入します。

ジョブが再起動されると、そのタスクは SCHEDULED 状態のままで、紫色の四角で示されています(以下のスクリーンショットを参照)。

注意:ジョブのタスクがSCHEDULED状態にあり、まだRUNNING状態ではないにもかかわらず、ジョブの全体的な状態はRUNNINGと表示されます。

この時点では、タスクを実行するためのリソース(タスクマネージャによって提供されるタスクスロット)がないため、ジョブのタスクは SCHEDULED 状態から RUNNING 状態に移動することができません。

新しいTaskManagerが利用可能になるまで、ジョブはキャンセルと再提出のサイクルを繰り返します。

その間、データジェネレーターはクリックイベントを入力トピックにプッシュし続けます。

これは、処理するジョブがダウンしている間にデータが生成される実際のプロダクションの設定に似ています。

Step3: 復旧

タスクマネージャーを再起動すると、ジョブマネージャーに再接続します。

docker-compose up -d taskmanager

新しいタスクマネージャが通知されると、ジョブマネージャは回復中のジョブのタスクを新たに利用可能なタスクスロットにスケジューリングします。

再起動時に、タスクは障害の前に行われた最後の成功したチェックポイントから状態を回復し、RUNNING 状態に切り替わります。

(知りたかった部分)

ジョブは、Kafkaからの入力イベント(停止中に蓄積された)の完全なバックログを迅速に処理し、ストリームの先頭に到達するまで、はるかに高い速度(24レコード/分以上)で出力を生成します。

~~~

出力では、すべてのキー(ページ)がすべての時間窓に存在し、すべてのカウントが正確に1000個であることがわかります。

[FlinkKafkaProducer](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/connectors/kafka.html#kafka-producers-and-fault-tolerance) を "at-least-once" モードで使用しているので、出力レコードが重複して表示される可能性があります。

`注意: ほとんどのプロダクションセットアップは、失敗したプロセスを自動的に再起動するために、リソースマネージャ(Kubernetes、Yarn、Mesos)に依存しています。`

#### ジョブのアップグレードと再スケーリング

Flinkジョブのアップグレードには、常に2つのステップがあります。

最初に、FlinkジョブはSavepointで優雅に停止されます。

[Savepoint](https://ci.apache.org/projects/flink/flink-docs-release-1.11/ops/state/savepoints.html)は、明確に定義されたグローバルに一貫した時点での完全なアプリケーション状態の一貫したスナップショットです(チェックポイントに似ています)。

次に、アップグレードされたFlinkジョブは、Savepointから開始されます。

この文脈では、「アップグレード」は以下のような異なる意味を持ちます。

- 設定(ジョブの並列性を含む)のアップグレード

- ジョブのトポロジーのアップグレード(オペレーターの追加・削除

- ジョブのユーザー定義機能のアップグレード

アップグレードを開始する前に、アップグレードの過程でデータが失われたり破損したりしないことを観察するために、出力トピックの尾行を開始したい場合があります。

~~~sh

docker-compose exec kafka kafka-console-consumer.sh \

--bootstrap-server localhost:9092 --topic output

~~~

CLIで翻訳します.適宜REST APIに読み替えてください.

##### Step1: Jobの停止

ジョブを優雅に停止させるには、CLIまたはREST APIの "stop "コマンドを使用する必要があります。

これにはジョブのJobIDが必要で、[実行中の全てのジョブ](https://ci.apache.org/projects/flink/flink-docs-release-1.11/try-flink/flink-operations-playground.html#listing-running-jobs)をリストアップするか、WebUIから取得できます。

JobIDがあれば、ジョブの停止に進むことができます。

___Command___

~~~bash

docker-compose run --no-deps client flink stop <job-id>

~~~

___期待される出力___

~~~bash

Suspending job "<job-id>" with a savepoint.

Savepoint completed. Path: file:<savepoint-path>

~~~

Savepointは、ローカルマシンの/tmp/flink-savepoints-directory/の下にマウントされているflink-conf.yamlで設定されたstate.savepoint.dirに保存されています。

次のステップでは、この Savepoint へのパスが必要になります。

##### Step2a:変更なしでJobを再起動する

これで、このSavepointからアップグレードしたJobを再起動することができます。

簡単にするために、何も変更せずに再起動することから始めることができます。

___Command___

~~~bash

docker-compose run --no-deps client flink run -s <savepoint-path> \

-d /opt/ClickCountJob.jar \

--bootstrap.servers kafka:9092 --checkpointing --event-time

~~~

___期待される出力___

~~~bash

Job has been submitted with JobID <job-id>

~~~

ジョブが再び実行されると、ジョブが停止中に蓄積されたバックログを処理している間、レコードがより高いレートで生成されていることが出力トピックでわかります。

さらに、アップグレード中にデータが失われていないことがわかります。

##### Step2b:並列度の異なるJobの再起動(再スケーリング

また、再起動時に別の並列性を渡すことで、このSavepointからジョブを再スケールすることもできます。

___Command___

~~~bash

docker-compose run --no-deps client flink run -p 3 -s <savepoint-path> \

-d /opt/ClickCountJob.jar \

--bootstrap.servers kafka:9092 --checkpointing --event-time

~~~

___期待される出力___

~~~bash

Starting execution of program

Job has been submitted with JobID <job-id>

~~~

現在、ジョブは再投入されていますが、並列性を高めた状態で実行するためのタスクスロットが不足しているため、開始されません(2つ利用可能、3つ必要)。このような場合には

~~~bash

docker-compose scale taskmanager=2

~~~

2つのタスクスロットを持つ2つ目のTaskManagerをFlinkクラスタに追加することができ、これは自動的にJobManagerに登録されます。

TaskManager を追加した直後に、ジョブは再び実行を開始します。

ジョブが再び「実行中」になると、出力トピックに、再スケーリング中にデータが失われていないことが表示されます。

#### ジョブのメトリクスを取得する

ジョブマネージャは、その REST API を介してシステムとユーザの[メトリクス](https://ci.apache.org/projects/flink/flink-docs-release-1.11/monitoring/metrics.html)を公開します。

エンドポイントは、これらのメトリクスのスコープに依存します。

ジョブにスコープされたメトリクスは jobs/<job-id>/metrics で一覧表示できます。

この機能を使用するには、以下の手順に従います。

___Request___

~~~bash

curl "localhost:8081/jobs/<jod-id>/metrics?get=lastCheckpointSize"

~~~

___期待される出力___

~~~json

[

{

"id": "lastCheckpointSize",

"value": "9378"

}

]

~~~

REST APIはメトリクスのクエリだけでなく、実行中のジョブのステータスに関する詳細な情報を取得することもできます。

___Request___

~~~bash

# find the vertex-id of the vertex of interest

curl localhost:8081/jobs/<jod-id>

~~~

___期待される出力___

~~~json

{

"jid": "<job-id>",

"name": "Click Event Count",

"isStoppable": false,

"state": "RUNNING",

"start-time": 1564467066026,

"end-time": -1,

"duration": 374793,

"now": 1564467440819,

"timestamps": {

"CREATED": 1564467066026,

"FINISHED": 0,

"SUSPENDED": 0,

"FAILING": 0,

"CANCELLING": 0,

"CANCELED": 0,

"RECONCILING": 0,

"RUNNING": 1564467066126,

"FAILED": 0,

"RESTARTING": 0

},

"vertices": [

{

"id": "<vertex-id>",

"name": "ClickEvent Source",

"parallelism": 2,

"status": "RUNNING",

"start-time": 1564467066423,

"end-time": -1,

"duration": 374396,

"tasks": {

"CREATED": 0,

"FINISHED": 0,

"DEPLOYING": 0,

"RUNNING": 2,

"CANCELING": 0,

"FAILED": 0,

"CANCELED": 0,

"RECONCILING": 0,

"SCHEDULED": 0

},

"metrics": {

"read-bytes": 0,

"read-bytes-complete": true,

"write-bytes": 5033461,

"write-bytes-complete": true,

"read-records": 0,

"read-records-complete": true,

"write-records": 166351,

"write-records-complete": true

}

},

{

"id": "<vertex-id>",

"name": "Timestamps/Watermarks",

"parallelism": 2,

"status": "RUNNING",

"start-time": 1564467066441,

"end-time": -1,

"duration": 374378,

"tasks": {

"CREATED": 0,

"FINISHED": 0,

"DEPLOYING": 0,

"RUNNING": 2,

"CANCELING": 0,

"FAILED": 0,

"CANCELED": 0,

"RECONCILING": 0,

"SCHEDULED": 0

},

"metrics": {

"read-bytes": 5066280,

"read-bytes-complete": true,

"write-bytes": 5033496,

"write-bytes-complete": true,

"read-records": 166349,

"read-records-complete": true,

"write-records": 166349,

"write-records-complete": true

}

},

{

"id": "<vertex-id>",

"name": "ClickEvent Counter",

"parallelism": 2,

"status": "RUNNING",

"start-time": 1564467066469,

"end-time": -1,

"duration": 374350,

"tasks": {

"CREATED": 0,

"FINISHED": 0,

"DEPLOYING": 0,

"RUNNING": 2,

"CANCELING": 0,

"FAILED": 0,

"CANCELED": 0,

"RECONCILING": 0,

"SCHEDULED": 0

},

"metrics": {

"read-bytes": 5085332,

"read-bytes-complete": true,

"write-bytes": 316,

"write-bytes-complete": true,

"read-records": 166305,

"read-records-complete": true,

"write-records": 6,

"write-records-complete": true

}

},

{

"id": "<vertex-id>",

"name": "ClickEventStatistics Sink",

"parallelism": 2,

"status": "RUNNING",

"start-time": 1564467066476,

"end-time": -1,

"duration": 374343,

"tasks": {

"CREATED": 0,

"FINISHED": 0,

"DEPLOYING": 0,

"RUNNING": 2,

"CANCELING": 0,

"FAILED": 0,

"CANCELED": 0,

"RECONCILING": 0,

"SCHEDULED": 0

},

"metrics": {

"read-bytes": 20668,

"read-bytes-complete": true,

"write-bytes": 0,

"write-bytes-complete": true,

"read-records": 6,

"read-records-complete": true,

"write-records": 0,

"write-records-complete": true

}

}

],

"status-counts": {

"CREATED": 0,

"FINISHED": 0,

"DEPLOYING": 0,

"RUNNING": 4,

"CANCELING": 0,

"FAILED": 0,

"CANCELED": 0,

"RECONCILING": 0,

"SCHEDULED": 0

},

"plan": {

"jid": "<job-id>",

"name": "Click Event Count",

"nodes": [

{

"id": "<vertex-id>",

"parallelism": 2,

"operator": "",

"operator_strategy": "",

"description": "ClickEventStatistics Sink",

"inputs": [

{

"num": 0,

"id": "<vertex-id>",

"ship_strategy": "FORWARD",

"exchange": "pipelined_bounded"

}

],

"optimizer_properties": {}

},

{

"id": "<vertex-id>",

"parallelism": 2,

"operator": "",

"operator_strategy": "",

"description": "ClickEvent Counter",

"inputs": [

{

"num": 0,

"id": "<vertex-id>",

"ship_strategy": "HASH",

"exchange": "pipelined_bounded"

}

],

"optimizer_properties": {}

},

{

"id": "<vertex-id>",

"parallelism": 2,

"operator": "",

"operator_strategy": "",

"description": "Timestamps/Watermarks",

"inputs": [

{

"num": 0,

"id": "<vertex-id>",

"ship_strategy": "FORWARD",

"exchange": "pipelined_bounded"

}

],

"optimizer_properties": {}

},

{

"id": "<vertex-id>",

"parallelism": 2,

"operator": "",

"operator_strategy": "",

"description": "ClickEvent Source",

"optimizer_properties": {}

}

]

}

}

~~~

異なるスコープのメトリクス(TaskManager メトリクスなど)のクエリ方法を含む、可能なクエリの完全なリストについては、[REST API リファレンス](https://ci.apache.org/projects/flink/flink-docs-release-1.11/monitoring/rest_api.html#api)を参照してください。

### バリエーション

クリックイベントカウントのアプリケーションは、常に--checkpointingと--event-timeプログラムの引数で起動されていたことに気がついたかもしれません。

docker-compose.yamlのクライアントコンテナのコマンドでこれらを省略することで、ジョブの動作を変更することができます。

- --checkpointingはFlinkのフォールトトレランス機構である[チェックポイント](https://ci.apache.org/projects/flink/flink-docs-release-1.11/learn-flink/fault_tolerance.html)を有効にします。これを使わずに実行して[障害とリカバリー](https://ci.apache.org/projects/flink/flink-docs-release-1.11/try-flink/flink-operations-playground.html#observing-failure--recovery)を行うと、実際にデータが失われていることがわかるはずです。

- --event-timeはジョブの[イベントタイムセマンティクス](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/event_time.html)を有効にします。無効にすると、ジョブはClickEventのタイムスタンプではなく、壁時計の時間に基づいてウィンドウにイベントを割り当てます。その結果、ウィンドウごとのイベント数は正確には1000個にはなりません。

クリックイベントカウントアプリケーションには、デフォルトではオフになっている別のオプションもあります。

このオプションは、docker-compose.yamlのクライアントコンテナのコマンドで追加することができます。

- --backpressure は、ジョブの途中に追加の演算子を追加して、偶数分の間(例えば、10:12 の間には深刻な背圧を発生させますが、10:13 の間には発生しません)には、ジョブの途中に追加の演算子を追加します。これは、outputQueueLength や outPoolUsage などのさまざまな[ネットワークメトリクス](https://ci.apache.org/projects/flink/flink-docs-release-1.11/monitoring/metrics.html#default-shuffle-service)を検査したり、WebUI で利用可能な[バックプレッシャー監視](https://ci.apache.org/projects/flink/flink-docs-release-1.11/monitoring/back_pressure.html#monitoring-back-pressure)を使用して観察することができます。

# Flinkを学ぶ

## 概要

### トレーニングの目標と範囲

このトレーニングでは、スケーラブルなストリーミングETL、アナリティクス、イベントドリブンなアプリケーションを書き始めるのに十分な内容を含んだApache Flinkの入門書を紹介しますが、多くの(最終的に重要な)詳細は省いています。

焦点は、状態と時間を管理するためのFlinkのAPIを簡単に紹介することで、これらの基本をマスターすることで、より詳細なリファレンスドキュメントから知る必要のある残りの部分をピックアップするためのより良い装備を提供することを期待しています。

各セクションの最後にあるリンクから、より詳細な情報を得ることができます。

具体的には、以下のことを学びます。

- ストリーミングデータ処理パイプラインの実装方法

- Flinkがどのようにして状態を管理しているのか、その理由

- イベント時間を使って正確な分析を一貫して計算する方法

- 継続的なストリームでイベント駆動型アプリケーションを構築する方法

- Flinkがどのようにしてフォールトトレラントでステートフルなストリーム処理を実現しているかを、正確に一度だけのセマンティクスで表現します。

このトレーニングでは、___ストリーミングデータの連続処理、イベントタイム、ステートフルストリーム処理、状態スナップショット___という4つの重要な概念に焦点を当てています。

このページでは、これらの概念を紹介します。

`注 このトレーニングには、説明されている概念の操作方法を学ぶための実践的な演習が付属しています。各セクションの最後には、関連する練習問題へのリンクがあります。`

### ストリーム処理

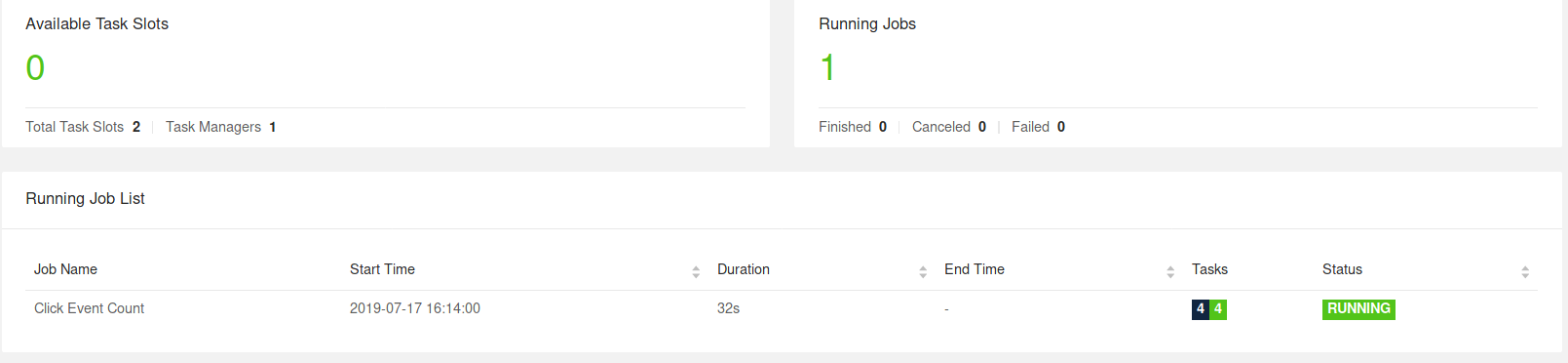

ストリームはデータの自然な生息地です。

それがウェブサーバからのイベントであれ、証券取引所からの取引であれ、工場の床にある機械からのセンサーの読み取りであれ、データはストリームの一部として作成されます。

しかし、データを分析するときには、制限されたストリームと制限されていないストリームのどちらかで処理を整理することができ、これらのパラダイムのどちらを選択するかによって、重大な結果がもたらされます。

___バッチ処理___とは、制限されたデータストリームを処理する際のパラダイムです。

この操作モードでは、結果を出す前にデータセット全体をインジェストすることができます。

つまり、例えば、データをソートしたり、グローバル統計を計算したり、入力をすべて要約した最終レポートを作成したりすることができます。

___ストリーム処理___では、データのストリームには制限がありません。

概念的には、少なくとも入力が終わることはないので、データが到着したときには継続的に処理しなければなりません。

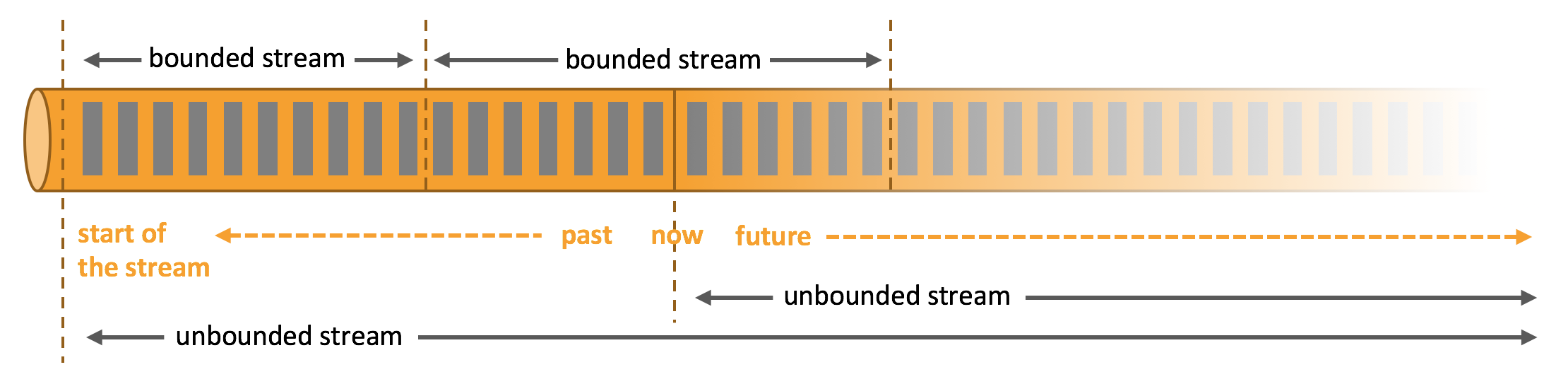

Flinkでは、アプリケーションはストリーミングデータフローで構成され、ユーザー定義の演算子によって変換されます。

これらのデータフローは、1つ以上のソースで始まり、1つ以上のシンクで終わる有向グラフを形成します。

多くの場合、プログラム内の変換とデータフロー内の演算子の間には一対一の対応関係があります。

しかし、一つの変換が複数の演算子で構成されていることもあります。

アプリケーションは、メッセージキューやApache KafkaやKinesisのような分散ログのようなストリーミングソースからリアルタイムデータを消費することがあります。

しかし、flinkは、様々なデータソースからの制限付きのヒストリカルデータを消費することもできます。

同様に、Flinkアプリケーションによって生成される結果のストリームは、シンクとして接続可能な多種多様なシステムに送ることができます。

### 並列DataFlow

Flink のプログラムは本質的に並列分散しています。

実行中、ストリームは1つまたは複数のストリームパーティションを持ち、各演算子は1つまたは複数の演算子サブタスクを持ちます。

演算子サブタスクは互いに独立しており、異なるスレッドで実行され、場合によっては異なるマシンやコンテナ上で実行されます。

演算子サブタスクの数は、その演算子の並列性を表します。

同じプログラムの異なる演算子は、異なるレベルの並列性を持つことがあります。

ストリームは、2 つの演算子間で 1 対 1 (または転送) パターン、または再配布パターンでデータを転送することができます。

- ___一対一のストリーム(One-to-one)___(例えば、上図のソースと map()演算子の間)は、要素の分割と順序を保持します。つまり、map()演算子のサブタスク[1]は、ソース演算子のサブタスク[1]が生成したのと同じ順番で同じ要素を見ることになります。

- ___ストリームの再分配(Redistributing)___(上記の map() と keyBy/window の間や keyBy/window と Sink の間のように)は、ストリームの分割を変更します。各演算子サブタスクは、選択された変換に応じて、異なるターゲットサブタスクにデータを送信します。例としては、keyBy() (キーをハッシュ化して再分割する)、broadcast()、rebalance() (ランダムに再分割する) などがあります。再分配交換では、要素間の順序は、送信サブタスクと受信サブタスクの各ペア内でのみ保持されます(例えば、map()のサブタスク[1]とkeyBy/windowのサブタスク[2])。そのため、例えば、上に示した keyBy/window と Sink 演算子の間の再分配では、異なるキーの集約結果が Sink に到達する順序に関して非決定性が導入されています。

### タイムリーなストリーム処理

ほとんどのストリーミング・アプリケーションでは、ライブ・データの処理に使用されるのと同じコードで履歴データを再処理できることが非常に重要です。

また、イベントが処理のために配信される順番ではなく、イベントが発生した順番に注意を払い、イベントのセットがいつ完了するか(または完了すべきか)を推論できるようにすることも重要です。

例えば、電子商取引や金融取引に関わる一連のイベントを考えてみましょう。

タイムリーなストリーム処理に対するこれらの要件は、データを処理する機械の時計を使用するのではなく、データストリームに記録されたイベントタイムスタンプを使用することで満たすことができます。

### ステートフルストリーム処理

Flinkの操作はステートフルにすることができます。

つまり、あるイベントがどのように処理されるかは、それ以前に発生したすべてのイベントの累積効果に依存します。

ステートは、ダッシュボードに表示する1分間のイベント数をカウントするなどの単純なものから、不正検知モデルのための機能を計算するなどの複雑なものまで、さまざまな用途に使用できます。

Flinkアプリケーションは、分散クラスタ上で並列に実行されます。

与えられた演算子の様々な並列インスタンスは独立して、別々のスレッドで実行され、一般的には異なるマシン上で実行されます。

ステートフルな演算子の並列インスタンスのセットは、実質的にシャードされたキーと値のストアです。

各並列インスタンスは、特定のキーのグループに対するイベントの処理を担当し、それらのキーの状態はローカルに保持されます。

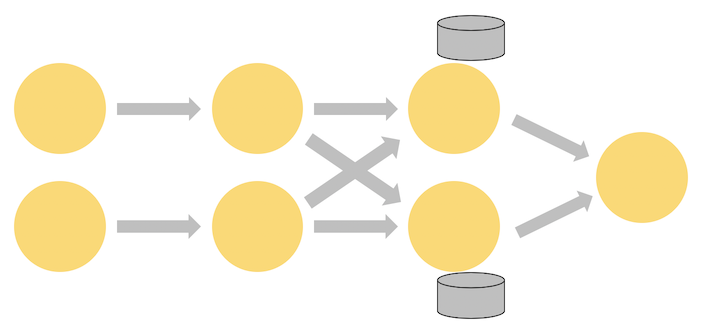

下図は、ジョブ・グラフの最初の3つの演算子の並列度が2で実行され、並列度が1のシンクで終了するジョブを示しています。

3番目の演算子はステートフルで、2番目と3番目の演算子の間で完全に接続されたネットワーク・シャッフルが発生していることがわかります。これは、ストリームを何らかのキーで分割するために行われており、一緒に処理する必要のあるすべてのイベントがそうなるようにしています。

ステートは常にローカルでアクセスされるため、Flinkアプリケーションが高いスループットと低レイテンシを実現するのに役立ちます。

ステートをJVMヒープ上に保持するか、または大きすぎる場合は、効率的に整理されたディスク上のデータ構造に保持するかを選択することができます。

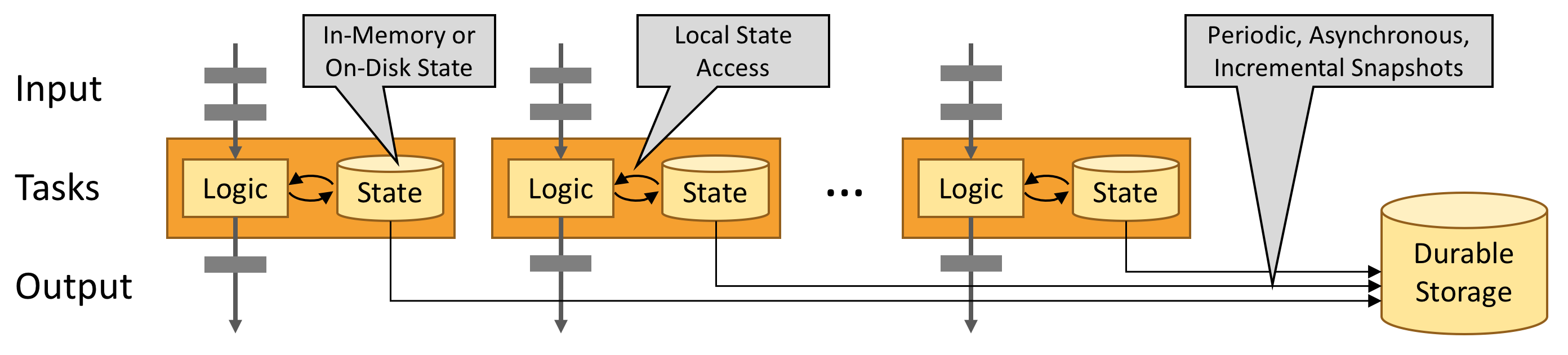

### ステートスナップショットによるフォールトトレランス

Flinkは、状態スナップショットとストリーム再生の組み合わせにより、フォールトトレラントで正確な一度きりのセマンティクスを提供することができます。

これらのスナップショットは、分散パイプラインの全体の状態をキャプチャし、入力キューへのオフセットや、その時点までのデータをインジェストした結果のジョブグラフ全体の状態を記録します。

障害が発生すると、ソースが巻き戻され、状態が復元され、処理が再開されます。

上図のように、これらの状態スナップショットは、進行中の処理を妨げることなく、非同期的にキャプチャされます。

## DataFlow APIの紹介

このトレーニングの焦点は、ストリーミングアプリケーションを書き始めることができるように、DataStream APIを幅広くカバーすることです。

### 何がストリームできるのか

FlinkのJavaとScala用のDataStream APIは、それらがシリアライズできるものなら何でもストリーミングできるようにしてくれます。

Flink独自のシリアライザは

- 基本型(String、Long、Integer、Boolean、Arrayなど)

- 複合型(タプル、POJO、Scalaのケースクラス)

上記を使用し、Flink は他のタイプでは Kryo にフォールバックします。

また、Flinkで他のシリアライザを使用することも可能です。

特に Avro はよくサポートされています。

#### JavaのタプルとPOJOs

Flinkのネイティブシリアライザは、タプルやPOJOを効率的に操作することができます。

##### Tuples

Javaの場合、Flinkは独自のTuple0からTuple25までの型を定義しています。

~~~java

Tuple2<String, Integer> person = Tuple2.of("Fred", 35);

// zero based index!

String name = person.f0;

Integer age = person.f1;

~~~

##### POJOs

Flinkは、以下の条件を満たす場合、データ型をPOJO型として認識します(そして"by-name"フィールド参照を許可します)。

- クラスがパブリックでスタンドアロンである(非静的な内部クラスがない)

- このクラスには、引数なしのパブリックなコンストラクタがあります

- クラス(およびすべてのスーパークラス)内のすべての非静的で非一過性のフィールドは、パブリック(および非最終)であるか、Java beansのゲッターとセッターの命名規則に従ったパブリックなゲッターとセッターのメソッドを持っています。

例:

~~~java

public class Person {

public String name;

public Integer age;

public Person() {};

public Person(String name, Integer age) {

. . .

};

}

Person person = new Person("Fred Flintstone", 35);

~~~

Flinkのシリアライザは[POJO型のスキーマ進化をサポートしています。](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/state/schema_evolution.html#pojo-types)

#### Scalaのタプルとケースクラス

期待通りの働きをしてくれます。

### 完全な例

この例では、人々に関する記録のストリームを入力として受け取り、成人のみを含むようにフィルタリングします。

~~~java

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.api.common.functions.FilterFunction;

public class Example {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env =

StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<Person> flintstones = env.fromElements(

new Person("Fred", 35),

new Person("Wilma", 35),

new Person("Pebbles", 2));

DataStream<Person> adults = flintstones.filter(new FilterFunction<Person>() {

@Override

public boolean filter(Person person) throws Exception {

return person.age >= 18;

}

});

adults.print();

env.execute();

}

public static class Person {

public String name;

public Integer age;

public Person() {};

public Person(String name, Integer age) {

this.name = name;

this.age = age;

};

public String toString() {

return this.name.toString() + ": age " + this.age.toString();

};

}

}

~~~

#### ストリーム実行環境

すべての Flink アプリケーションには実行環境が必要で、この例では env を使用します。

ストリーミングアプリケーションはStreamExecutionEnvironmentを使用する必要があります。

アプリケーション内で行われる DataStream API の呼び出しは、StreamExecutionEnvironment にアタッチされたジョブグラフを作成します。

env.execute() が呼び出されると、このグラフはパッケージ化されて JobManager に送られ、ジョブを並列化してタスクマネージャにスライスを配布して実行します。

ジョブの各並列スライスはタスクスロットで実行されます。

execute() を呼び出さないと、アプリケーションは実行されないことに注意してください。

この分散ランタイムは、アプリケーションがシリアライズ可能であることに依存します。

また、すべての依存関係がクラスタ内の各ノードで利用可能である必要があります。

#### 基本的なStream sources

上の例では、env.fromElements(....)を使ってDataStream<Person>を構築しています。

これは、プロトタイプやテストで使用するためのシンプルなストリームをまとめるのに便利な方法です。

また、StreamExecutionEnvironmentにはfromCollection(Collection)メソッドもあります。その代わりに、次のようにすることができます。

~~~java

List<Person> people = new ArrayList<Person>();

people.add(new Person("Fred", 35));

people.add(new Person("Wilma", 35));

people.add(new Person("Pebbles", 2));

DataStream<Person> flintstones = env.fromCollection(people);

~~~

プロトタイプを作成している間にデータをストリームに取り込むもう一つの便利な方法は、ソケットを使うことです。

~~~java

DataStream<String> lines = env.socketTextStream("localhost", 9999)

~~~

または

~~~java

DataStream<String> lines = env.readTextFile("file:///path");

~~~

実際のアプリケーションで最も一般的に使用されるデータソースは、Apache Kafka、Kinesis、様々なファイルシステムなど、高性能と耐障害性の前提条件である巻き戻しと再生を組み合わせた低レイテンシ、高スループットの並列読み取りをサポートするものです。

また、REST APIやデータベースは、ストリームエンリッチメントのために頻繁に使用されています。

#### 基本的なStream sinks

上の例では、その結果をタスクマネージャのログに出力するために Adults.print() を使用しています (IDE で実行している場合は、IDE のコンソールに表示されます)

これは、ストリームの各要素に対して toString() を呼び出します。

出力は以下のようになります。

1> フレッド:35歳

2>ウィルマ:35歳

ここで、1> と 2> は出力を生成したサブタスク(つまりスレッド)を示します。

プロダクションでは、一般的に使用されているシンクには、StreamingFileSink、様々なデータベース、そしていくつかのパブサブシステムがあります。

#### デバッグ

本番環境では、アプリケーションはリモートのクラスタまたはコンテナのセットで実行されます。

そして、障害が発生した場合、リモートで障害が発生します。

JobManager や TaskManager のログはそのような障害のデバッグに非常に役立ちますが、Flink がサポートしている IDE 内でローカルデバッグを行う方がはるかに簡単です。

ブレークポイントを設定したり、ローカル変数を調べたり、コードをステップスルーしたりすることができます。

また、Flinkのコードを覗き込むこともでき、Flinkがどのように動作するかに興味がある場合には、Flinkの内部をより詳しく知ることができます。

### ハンズオン

この時点で、シンプルなDataStreamアプリケーションのコーディングと実行を始めるのに十分な知識があります。

[flink-trainingレポ](https://github.com/apache/flink-training/tree/release-1.11)をクローンし、READMEの指示に従った後、最初のエクササイズを行います。

[ストリームのフィルタリング(ライドクレンジング)](https://github.com/apache/flink-training/tree/release-1.11/ride-cleansing)を行います。

### 続きをさらに読む

- [Flink Serialization Tuning Vol. 1: Choosing your Serializer — if you can](https://flink.apache.org/news/2020/04/15/flink-serialization-tuning-vol-1.html)

- [Anatomy of a Flink Program](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/datastream_api.html#anatomy-of-a-flink-program)

- [Data Sources](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/datastream_api.html#data-sources)

- [Data Sinks](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/datastream_api.html#data-sinks)

- [DataStream Connectors](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/connectors/)

## データパイプラインとETL

Apache Flink の非常に一般的なユースケースとしては、1つ以上のソースからデータを取得し、変換や濃縮を行い、その結果をどこかに保存する ETL (extract, transform, load) パイプラインを実装することがあります。

このセクションでは、この種のアプリケーションを実装するためにFlinkのDataStream APIを使用する方法を見ていきます。

Flinkの[TableとSQL API](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/table/)は、多くのETLユースケースに適していることに注意してください。

しかし、最終的にDataStream APIを直接使用するかどうかに関わらず、ここで紹介した基本をしっかりと理解しておくことは貴重なものになるでしょう。

### ステートレス変換

このセクションでは、ステートレス変換を実装するために使用される基本的な操作である map() と flatmap() について説明します。

このセクションの例では、[flink-trainingレポ](https://github.com/apache/flink-training/tree/release-1.11)のハンズオン演習で使用されているTaxi Rideデータに精通していることを前提としています。

#### map()

最初の演習では、タクシー乗車イベントのストリームをフィルタリングしました。

その同じコードベースには、静的メソッドGeoUtils.mapToGridCell(float lon, float lat)を提供するGeoUtilsクラスがあり、サイズが約100x100メートルの領域を参照するグリッドセルに位置(経度、緯度)をマップします。

それでは、各イベントにstartCellとendCellフィールドを追加することで、タクシー乗車オブジェクトのストリームを豊かにしてみましょう。

これらのフィールドを追加して、TaxiRideを拡張したEnrichedRideオブジェクトを作成することができます。

~~~java

public static class EnrichedRide extends TaxiRide {

public int startCell;

public int endCell;

public EnrichedRide() {}

public EnrichedRide(TaxiRide ride) {

this.rideId = ride.rideId;

this.isStart = ride.isStart;

...

this.startCell = GeoUtils.mapToGridCell(ride.startLon, ride.startLat);

this.endCell = GeoUtils.mapToGridCell(ride.endLon, ride.endLat);

}

public String toString() {

return super.toString() + "," +

Integer.toString(this.startCell) + "," +

Integer.toString(this.endCell);

}

}

~~~

そして、ストリームを変換するアプリケーションを作成することができます。

~~~java

DataStream<TaxiRide> rides = env.addSource(new TaxiRideSource(...));

DataStream<EnrichedRide> enrichedNYCRides = rides

.filter(new RideCleansingSolution.NYCFilter())

.map(new Enrichment());

enrichedNYCRides.print();

~~~

MapFunctionの利用:

~~~java

public static class Enrichment implements MapFunction<TaxiRide, EnrichedRide> {

@Override

public EnrichedRide map(TaxiRide taxiRide) throws Exception {

return new EnrichedRide(taxiRide);

}

}

~~~

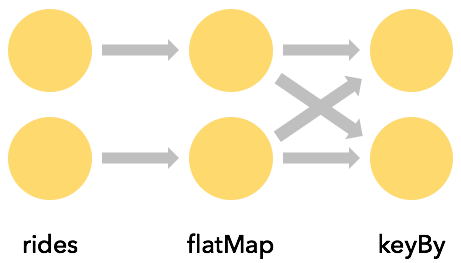

#### flatmap()

MapFunction は、一対一の変換を行う場合にのみ適しています: 入ってくる各ストリーム要素に対して、 map() は変換された要素を一つずつ出力します。

それ以外の場合は flatmap() を使用します。

~~~java

DataStream<TaxiRide> rides = env.addSource(new TaxiRideSource(...));

DataStream<EnrichedRide> enrichedNYCRides = rides

.flatMap(new NYCEnrichment());

enrichedNYCRides.print();

~~~

FlatMapFunctionとの処理:

~~~java

public static class NYCEnrichment implements FlatMapFunction<TaxiRide, EnrichedRide> {

@Override

public void flatMap(TaxiRide taxiRide, Collector<EnrichedRide> out) throws Exception {

FilterFunction<TaxiRide> valid = new RideCleansing.NYCFilter();

if (valid.filter(taxiRide)) {

out.collect(new EnrichedRide(taxiRide));

}

}

}

~~~

このインターフェイスで提供されている Collector を使用すると、flatmap() メソッドはストリーム要素を好きなだけ出力することができます。

### キー付きストリーム

#### KeyBy()

ストリームを属性の一つを中心に分割できると、その属性の同じ値を持つすべてのイベントをグループ化することができ、非常に便利なことがよくあります。

例えば、グリッドの各セルから始まる最長のタクシー乗車時間を見つけたいとします。

SQLクエリの観点から考えると、これはstartCellでGROUP BYを行うことを意味しますが、FlinkではこれはkeyBy(KeySelector)で行われます。

~~~java

rides

.flatMap(new NYCEnrichment())

.keyBy(value -> value.startCell)

~~~

keyBy のたびにネットワークシャッフルが発生し、ストリームを再分割します。

一般的に、これはシリアライズとデシリアライズに加えてネットワーク通信を伴うため、かなり高価なものになります。

上の例では、キーは "startCell "というフィールド名で指定されています。

このスタイルのキー選択には、コンパイラがキー入力に使用されるフィールドの型を推測できないという欠点があり、Flinkはキーの値をタプルとして渡してしまいます。

適切にタイプされた KeySelector を使用する方が良いでしょう。

~~~java

rides

.flatMap(new NYCEnrichment())

.keyBy(

new KeySelector<EnrichedRide, int>() {

@Override

public int getKey(EnrichedRide enrichedRide) throws Exception {

return enrichedRide.startCell;

}

})

~~~

これはラムダでより簡潔に表現することができます。

~~~java

rides

.flatMap(new NYCEnrichment())

.keyBy(enrichedRide -> enrichedRide.startCell)

~~~

#### Keysの計算

KeySelectors は、イベントからキーを抽出するだけではありません。

結果として得られるキーが決定論的であり、hashCode() や equals() の有効な実装を持っている限りは、好きなようにキーを計算することができます。

この制限により、乱数を生成したり、配列や列挙型を返す KeySelectors は除外されますが、例えばタプルや POJO を用いた複合鍵を作成することは可能です。

キーは決定論的な方法で生成されなければなりません。

なぜなら、キーはストリームレコードに添付されるのではなく、必要なときにいつでも再計算されるからです。

例えば、startCellフィールドを持つ新しいEnrichedRideクラスを作成し、それを

~~~java

keyBy(enrichedRide -> enrichedRide.startCell)

~~~

私たちは以下のようにすることができます.

~~~java

keyBy(ride -> GeoUtils.mapToGridCell(ride.startLon, ride.startLat))

~~~

#### Keys付きストリームの集約

このビットコードは、各エンドオブライドイベントの開始セルと持続時間(分単位)を含むタプルの新しいストリームを作成します。

~~~java

import org.joda.time.Interval;

DataStream<Tuple2<Integer, Minutes>> minutesByStartCell = enrichedNYCRides

.flatMap(new FlatMapFunction<EnrichedRide, Tuple2<Integer, Minutes>>() {

@Override

public void flatMap(EnrichedRide ride,

Collector<Tuple2<Integer, Minutes>> out) throws Exception {

if (!ride.isStart) {

Interval rideInterval = new Interval(ride.startTime, ride.endTime);

Minutes duration = rideInterval.toDuration().toStandardMinutes();

out.collect(new Tuple2<>(ride.startCell, duration));

}

}

});

~~~

これで、各startCellに対して、これまでに見た中で最も長いライド(その時点までのライド)だけを含むストリームを生成することが可能になりました。

キーとして使用するフィールドを表現する方法は様々です。

先ほど、EnrichedRide POJOの例を見ましたが、ここではキーとして使用するフィールドがその名前で指定されていました。

この例では、Tuple2オブジェクトを使用しており、タプル内のインデックス(0から始まる)がキーを指定するために使用されています。

~~~java

minutesByStartCell

.keyBy(value -> value.f0) // .keyBy(value -> value.startCell)

.maxBy(1) // duration

.print();

~~~

出力ストリームには、持続時間が新しい最大値に達するたびに、各キーのレコードが含まれるようになりました。

~~~

...

4> (64549,5M)

4> (46298,18M)

1> (51549,14M)

1> (53043,13M)

1> (56031,22M)

1> (50797,6M)

...

1> (50797,8M)

...

1> (50797,11M)

...

1> (50797,12M)

~~~

#### (暗黙の)状態

これは、ステートフル・ストリーミングを含むこのトレーニングの最初の例です。

ステートは透過的に処理されていますが、Flinkは各キーの最大持続時間を追跡しなければなりません。

アプリケーションにステートが関与するときはいつでも、ステートがどれだけ大きくなるかを考える必要があります。

キー空間に制限がないときはいつでも、Flinkが必要とするステートの量も同じです。

ストリームを扱う場合、一般的には、ストリーム全体ではなく、有限のウィンドウの集約という観点から考える方が理にかなっています。

#### reduce()などのアグリゲータ

上記で使用した maxBy() は、Flink の KeyedStream で利用可能なアグリゲータ関数の一例です。

また、より汎用的な reduce() 関数もあり、独自のアグリゲーションを実装することができます。

### ステートフル変換

#### なぜFlinkがステート管理に関与するか

アプリケーションはFlinkが管理に関与しなくてもステートを使用することができますが、Flinkはステートを管理するためにいくつかの魅力的な機能を提供しています.

- それはローカルです。ローカル: Flinkのステートは処理するマシンのローカルに保持され、メモリ速度でアクセスできます。

- 耐久性があります。フリンク状態は耐障害性があり、定期的に自動的にチェックポイントされ、故障時に復元されます。

- 垂直方向にスケーラブルです。ローカルディスクを追加することでスケールする埋め込み型のRocksDBインスタンスにFlinkの状態を保持することができます。

- 水平方向にスケーラブルです。クラスタの成長や縮小に応じて、フリンクの状態が再分配されます。

- クエリー可能です。Flink のステートは、[Queryable State API](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/state/queryable_state.html) を使用して外部から問い合わせることができます。

このセクションでは、キー付きステートを管理する Flink の API を使用した作業方法について説明します。

#### 豊富な機能

この時点で、FilterFunction、MapFunction、FlatMapFunction など、Flink の関数インタフェースのいくつかをすでに見てきました。

これらはすべて Single Abstract Method パターンの例です。

これらのインターフェイスのそれぞれについて、Flink はいわゆる「リッチ」バリアント、例えば RichFlatMapFunction も提供しており、以下のような追加メソッドを持っています。

- open(Configuration c)

- close()

- getRuntimeContext()

open() は、オペレータの初期化中に一度だけ呼び出されます。

これは、静的データをロードしたり、外部サービスへの接続を開いたりする機会です。

getRuntimeContext() は、潜在的に興味深いもののスイート全体へのアクセスを提供しますが、最も注目すべきは、Flink によって管理されている状態を作成してアクセスする方法です。

#### キー付き状態の例

この例では、重複排除したいイベントのストリームがあるとします。Deduplicator と呼ばれる RichFlatMapFunction を使って、それを行うアプリケーションを紹介します。

~~~java

private static class Event {

public final String key;

public final long timestamp;

...

}

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.addSource(new EventSource())

.keyBy(e -> e.key)

.flatMap(new Deduplicator())

.print();

env.execute();

}

~~~

これを達成するためには、Deduplicatorは各キーについて、そのキーのイベントが既に発生しているかどうかを何らかの方法で記憶する必要がある。

これはFlinkのキー付きステート・インターフェースを使って行う。

このようなキー付きストリームを扱う場合、Flinkは管理されている状態の各アイテムのキー/値のストアを保持します。

Flink はいくつかの異なるタイプのキー付きステートをサポートしていますが、この例では最もシンプルなもの、すなわち ValueState を使用しています。

つまり、各キーに対して、Flinkは1つのオブジェクト(この場合はBoolean型のオブジェクト)を保存することになります。

Deduplicator クラスには open() と flatMap() の 2 つのメソッドがあります。

openメソッドは、ValueStateDescriptor<Boolean>を定義することで、管理された状態の使用を確立します。

コンストラクタへの引数は、キー付き状態のこの項目の名前("keyHasBeenSeen")を指定し、これらのオブジェクトをシリアライズするために使用できる情報を提供します(この場合、Types.BOOLEAN)

~~~java

public static class Deduplicator extends RichFlatMapFunction<Event, Event> {

ValueState<Boolean> keyHasBeenSeen;

@Override

public void open(Configuration conf) {

ValueStateDescriptor<Boolean> desc = new ValueStateDescriptor<>("keyHasBeenSeen", Types.BOOLEAN);

keyHasBeenSeen = getRuntimeContext().getState(desc);

}

@Override

public void flatMap(Event event, Collector<Event> out) throws Exception {

if (keyHasBeenSeen.value() == null) {

out.collect(event);

keyHasBeenSeen.update(true);

}

}

}

~~~

flatMap メソッドが keyHasBeenSeen.value() を呼び出すと、Flink のランタイムは、コンテキスト内のキーの状態のこの部分の値を調べ、それが null である場合にのみ、イベントを出力に収集します。

また、この場合はkeyHasBeenSeenをtrueに更新します。

キーがDeduplicatorの実装では明示的に表示されていないため、このようにキー分割された状態にアクセスしたり更新したりするメカニズムは不思議に思えるかもしれません。

Flink のランタイムが RichFlatMapFunction の open メソッドを呼び出すとき、イベントは発生せず、その時点ではコンテキスト内にキーは存在しません。

しかし、flatMap メソッドを呼び出すと、処理されているイベントのキーがランタイムに提供され、Flink のステートバックエンドのどのエントリが操作されているかを判断するために舞台裏で使用されます。

分散クラスタにデプロイされた場合、この Deduplicator のインスタンスが多数存在し、それぞれが鍵空間全体の不連続なサブセットを担当することになります。

したがって、以下のような ValueState の単一の項目を見たときには

~~~java

ValueState<Boolean> keyHasBeenSeen;

~~~

これは単一のブール値ではなく、分散されたシャードされたキー/値のストアを表していることを理解してください。

#### クリアリング状態

上の例には潜在的な問題があります。

キー空間が束縛されていない場合はどうなるのでしょうか?

Flinkは、使用される個別のキーごとにBooleanのインスタンスをどこかに保存しています。

鍵のセットが制限されている場合は問題ありませんが、鍵のセットが制限されていない方法で増加しているアプリケーションでは、不要になった鍵の状態をクリアする必要があります。

これは、以下のように state オブジェクトに対して clear() を呼び出すことで行います。

~~~java

keyHasBeenSeen.clear()

~~~

例えば、指定したキーが一定期間使用されていない場合などにこれを行いたいと思うかもしれません。

これを行うためにタイマーを使用する方法については、イベント駆動型アプリケーションのセクションでProcessFunctionsについて学ぶときに説明します。

[ステートタイムトゥライブ(TTL)オプション](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/state/state.html#state-time-to-live-ttl)もあり、 ステートディスクリプタで設定することができ、 ステートが古くなった鍵の状態を自動的にクリアするタイミングを指定することができます。

#### ノンキー状態

また、キーを持たないコンテキストで管理された状態で作業することも可能です。

これは[演算子状態](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/state/state.html#operator-state)と呼ばれることもあります。

関係するインターフェースは多少異なり、ユーザー定義関数が非キー状態を必要とすることは珍しいので、ここでは取り上げません。

この機能は、ソースとシンクの実装で最もよく使われます。

### 接続されたストリーム

このようにあらかじめ定義された変換を適用するのではなく、時々、このような変換を適用します。

しきい値やルール、その他のパラメータをストリーミングすることで、変換のいくつかの側面を動的に変更できるようにしたい場合があります。

これをサポートするFlinkのパターンは、コネクテッドストリームと呼ばれるもので、1つの演算子が2つの入力ストリームを持っています。

接続されたストリームは、ストリーミング結合を実装するために使用することもできます。

#### 例

この例では、streamOfWordsからフィルタリングする必要のある単語を指定するためにコントロールストリームを使用しています。

ControlFunction と呼ばれる RichCoFlatMapFunction を接続されたストリームに適用して、これを実現しています。

~~~java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream<String> control = env.fromElements("DROP", "IGNORE").keyBy(x -> x);

DataStream<String> streamOfWords = env.fromElements("Apache", "DROP", "Flink", "IGNORE").keyBy(x -> x);

control

.connect(datastreamOfWords)

.flatMap(new ControlFunction())

.print();

env.execute();

}

~~~

接続される 2 つのストリームは、互換性のある方法でキーが設定されている必要があることに注意してください。

keyBy の役割はストリームのデータを分割することであり、キーが設定されたストリームが接続されている場合は、同じ方法で分割されている必要があります。

これにより、同じキーを持つ両方のストリームからのすべてのイベントが同じインスタンスに送信されるようになります。

さらに、例えば、そのキーで2つのストリームを結合することが可能になります。

この場合、ストリームは両方とも DataStream<String> 型で、両方のストリームのキーは文字列です。以下に示すように、この RichCoFlatMapFunction は Boolean 値をキー付きの状態で格納しており、この Boolean は 2 つのストリームで共有されています。

~~~java

public static class ControlFunction extends RichCoFlatMapFunction<String, String, String> {

private ValueState<Boolean> blocked;

@Override

public void open(Configuration config) {

blocked = getRuntimeContext().getState(new ValueStateDescriptor<>("blocked", Boolean.class));

}

@Override

public void flatMap1(String control_value, Collector<String> out) throws Exception {

blocked.update(Boolean.TRUE);

}

@Override

public void flatMap2(String data_value, Collector<String> out) throws Exception {

if (blocked.value() == null) {

out.collect(data_value);

}

}

}

~~~

RichCoFlatMapFunctionは、接続されたストリームのペアに適用できるFlatMapFunctionの一種であり、リッチ関数インタフェースへのアクセス権を持っています。

つまり、ステートフルにすることができます。

ブロックされたBooleanは、制御ストリーム上で言及されたキー(ここでは単語)を記憶するために使用されており、それらの単語はstreamOfWordsストリームからフィルタリングされています。

これがキー付きの状態であり、2つのストリーム間で共有されているため、2つのストリームは同じキー空間を共有しなければならない。

flatMap1とflatMap2は、接続された2つのストリームのそれぞれからの要素を持ってFlinkランタイムによって呼び出されます.

私たちの場合、制御ストリームからの要素はflatMap1に渡され、streamOfWordsからの要素はflatMap2に渡されます。

これは、control.connect(datastreamOfWords) で 2 つのストリームが接続される順序によって決定されました。

重要なのは、flatMap1 と flatMap2 のコールバックが呼び出される順序を制御できないということです。

これらの 2 つの入力ストリームは互いに競合しており、Flink ランタイムはどちらか一方のストリームからイベントを消費するか、または他方のストリームからイベントを消費するかについて、好きなように実行します。

タイミングや順序が重要な場合、アプリケーションが処理できるようになるまで、管理された Flink の状態でイベントをバッファリングする必要があるかもしれません。

``(注意: もし本当に必要ならば、[InputSelectable](https://ci.apache.org/projects/flink/flink-docs-release-1.11/api/java/org/apache/flink/streaming/api/operators/InputSelectable.html)インターフェイスを実装したカスタムオペレータを使用して、2入力オペレータが入力を消費する順序を限定的に制御することができます)``

### ハンズオン

このセクションに付随するハンズオンエクササイズが[「乗り物と運賃のエクササイズ」](https://github.com/apache/flink-training/tree/release-1.11/rides-and-fares)です。

### 続きを読む

- [DataStream Transformations](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/operators/#datastream-transformations)

- [Stateful Stream Processing](https://ci.apache.org/projects/flink/flink-docs-release-1.11/concepts/stateful-stream-processing.html)

## ストリーミング分析

### イベント時間とWatermarks

#### 導入

Flinkは3つの異なる___時間の概念___を明示的にサポートしています。

- イベント時間: イベントを生成(または保存)するデバイスによって記録された、イベントが発生した時間

- インジェスト時間:イベントをインジェストした瞬間にFlinkが記録したタイムスタンプ

- 処理時間:パイプライン内の特定のオペレータがイベントを処理している時間

再現性のある結果を得るためには、例えば、ある日の取引の最初の時間に到達した株価の最高値を計算する場合、イベントタイムを使用する必要があります。

この方法では、結果は計算が実行された時間に依存しません。

このようなリアルタイムアプリケーションは処理時間を使用して実行されることもありますが、その場合、結果はその時に発生したイベントではなく、その時間にたまたま処理されたイベントによって決定されます。

処理時間に基づいてアナリティクスを計算すると矛盾が生じ、履歴データの再分析や新しい実装のテストが困難になります。

#### イベント時間を使った作業

デフォルトでは、Flink は処理時間を使用します。これを変更するには、Time Characteristicを設定します。

~~~java

final StreamExecutionEnvironment env =

StreamExecutionEnvironment.getExecutionEnvironment();

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

~~~

イベントタイムを使用したい場合は、Flinkがイベントタイムの進行状況を追跡するために使用するTimestamp ExtractorとWatermark Generatorも必要になります。これについては、以下の[「Watermarksを使った作業」](https://ci.apache.org/projects/flink/flink-docs-release-1.11/learn-flink/streaming_analytics.html#working-with-watermarks)のセクションで説明しますが

まず、Watermarksとは何かを説明します。

#### Watermarks

なぜWatermarksが必要なのか、また、Watermarksがどのように機能するのか、簡単な例を見てみましょう。

この例では、以下に示すように、タイムスタンプ付きのイベントのストリームがあります。表示されている数字は、これらのイベントが実際にいつ発生したかを示すタイムスタンプです。最初に到着したイベントは時刻 4 に発生し、それより前に発生したイベント、時刻 2 に発生したイベントがそれに続いています。

··· 23 19 22 24 21 14 17 13 12 15 9 11 7 2 4 →

ストリームソーターを作ろうとしていると想像してください。

これは、到着したストリームから各イベントを処理し、同じイベントをタイムスタンプ順に並べた新しいストリームを生成するアプリケーションを意味しています。

いくつかの注意点があります。

(1) ストリームソーターが最初に見る要素は 4 ですが、ソートされたストリームの最初の要素としてすぐにリリースすることはできません。

それは順番通りに到着していないかもしれませんし、それ以前のイベントがまだ到着しているかもしれません。

実際、あなたはこのストリームの未来についての神のような知識の恩恵を受けており、あなたのストリームソーターは結果を出す前に少なくとも2が到着するまで待つべきであることがわかります。

ある程度のバッファリングと、ある程度の遅延が必要である。

(2) これを間違えると、永遠に待つことになるかもしれません。

ソーターは最初に時刻4からのイベントを見て、次に時刻2からのイベントを見ました。

タイムスタンプが2よりも小さいイベントは到着するでしょうか?あるかもしれない。

そうではないかもしれません。永遠に待っても1を見ないかもしれない。

最終的には勇気を持って、ソートされたストリームの開始点として2を放出しなければなりません。

(3) そこで必要なのは、任意のタイムスタンプ付きイベントについて、いつまでにそれより前のイベントの到着を待つのをやめるかを定義するポリシーのようなものです。

これはまさにウォーターマークが行うことであり、以前のイベントの到着を待つのをやめるタイミングを定義します。

Flinkでのイベントの時間処理は、ウォーターマークと呼ばれる特別なタイムスタンプ要素をストリームに挿入するウォーターマークジェネレータに依存しています。時刻 t の透かしは、ストリームが(おそらく)時刻 t までに完了したことを表明しています。

このストリームソーターはいつ待機を停止し、ソートされたストリームを開始するために2を押し出すべきでしょうか? 2以上のタイムスタンプを持つウォーターマークが到着したときです。

(4) ウォーターマークを生成する方法を決定するための異なるポリシーを想像するかもしれません。

各イベントは何らかの遅延を経て到着しますが、この遅延は様々なので、いくつかのイベントは他のイベントよりも遅延が大きくなります。

1つの簡単なアプローチは、これらの遅延がある最大遅延によって制限されていると仮定することです。

Flinkはこの戦略を bounded-out-of-ordererness watermarkingと呼んでいます。

ウォーターマークに対するより複雑なアプローチを想像するのは簡単ですが、ほとんどのアプリケーションでは固定遅延で十分に機能します。

#### 遅延と完全性

ウォーターマークについて考えるもう一つの方法は、ストリーミングアプリケーションの開発者であるあなたに、待ち時間と完全性の間のトレードオフをコントロールできるようにするということです。

バッチ処理とは異なり、結果を出す前に入力を完全に把握することができるという贅沢がありますが、ストリーミングでは、最終的には入力の詳細を見るのを待つのをやめて、ある種の結果を出さなければなりません。

短く制限された遅延を使って積極的にウォーターマークを設定することができ、それによって、入力についての不完全な知識を持ったまま結果を出すリスクを冒すことができます。

あるいは、より長く待って、入力ストリームのより完全な知識を持っていることを利用した結果を生成することもできます。

また、初期結果を迅速に生成し、追加の(遅い)データが処理されたときにその結果の更新を提供するハイブリッドソリューションを実装することも可能です。

これは、いくつかのアプリケーションに適したアプローチです。

#### 遅延

遅延はウォーターマークとの相対的な関係で定義されます。

ウォーターマーク(t)は、時刻tまでのストリームが完全であることを保証します。

このウォーターマークに続くイベントでタイムスタンプが≦tのものはすべて遅刻です。

#### Watermarkを使った作業

イベント時間ベースのイベント処理を実行するためには、Flink は各イベントに関連付けられた時間を知る必要があり、また、ストリームにウォーターマークを含める必要があります。

実習で使用したTaxiデータソースがこれらの詳細を処理してくれます。

これは通常、イベントからタイムスタンプを抽出し、要求に応じてウォーターマークを生成するクラスを実装することで行われます。

これを行う最も簡単な方法は、WatermarkStrategy を使用することです。

~~~java

DataStream<Event> stream = ...

WatermarkStrategy<Event> strategy = WatermarkStrategy

.<Event>forBoundedOutOfOrderness(Duration.ofSeconds(20))

.withTimestampAssigner((event, timestamp) -> event.timestamp);

DataStream<Event> withTimestampsAndWatermarks =

stream.assignTimestampsAndWatermarks(strategy);

~~~

### ウィンドウ

Flink は非常に表現力豊かなウィンドウセマンティクスを特徴としています。

このセクションでは、以下のことを学びます。

- 束縛されていないストリームの集約を計算するためにウィンドウがどのように使われているか。

- Flink がサポートしているウィンドウの種類

- ウィンドウアグリゲーションを使用したDataStreamプログラムの実装方法

#### 導入

ストリーム処理を行う際に、以下のような質問に答えるために、ストリームの限られたサブセットに集約されたアナリティクスを計算したいと考えるのは自然なことです。

- 1分間のページビュー数

- 一週間のユーザーあたりのセッション数

- センサー毎分最高温度

Flinkでウィンドウ分析を計算するには、2つの主要な抽象化に依存します。

ウィンドウにイベントを割り当てる(必要に応じて新しいウィンドウオブジェクトを作成する)ウィンドウアシグナと、ウィンドウに割り当てられたイベントに適用されるウィンドウ関数です。

FlinkのウィンドウAPIには、ウィンドウ関数を呼び出すタイミングを決定するTriggersと、ウィンドウに集められた要素を削除するEvictorの概念もあります。

基本的な形では、以下のようなキー付きストリームにウィンドウ処理を適用します。

~~~java

stream.

.keyBy(<key selector>)

.window(<window assigner>)

.reduce|aggregate|process(<window function>)

~~~

キーを持たないストリームでウィンドウ処理を使うこともできますが、この場合は並列処理にならないことに注意してください。

~~~java

stream.

.windowAll(<window assigner>)

.reduce|aggregate|process(<window function>)

~~~

#### ウィンドウアサイン

Flinkにはいくつかのウィンドウアサイザーが組み込まれており、以下のように説明されています。

これらのウィンドウアサイザーが何のために使われるかの例と、それらを指定する方法をいくつか紹介します。

- タンブリング時間ウィンドウ

- 毎分ページビュー

- TumblingEventTimeWindows.of(Time.minutes(1))

- スライディングタイムウィンドウ

- 10秒ごとに計算された毎分ページビュー

- SlidingEventTimeWindows.of(Time.minutes(1), Time.seconds(10))

- セッションウィンドウ

- セッションはセッション間のギャップが30分以上あることで定義されます

- EventTimeSessionWindows.withGap(Time.minutes(30))

時間は、Time.ミリ秒(n)、Time.秒(n)、Time.分(n)、Time.時(n)、Time.日(n)のいずれかを使用して指定することができます。

時間ベースのウィンドウアサイザ(セッションウィンドウを含む)には、イベント時間と処理時間の両方の種類があります。

これら2種類の時間ウィンドウの間には大きなトレードオフがあります。

処理時間ウィンドウでは、これらの制限を受け入れなければなりません。

- 履歴データを正しく処理できない。

- 順序外のデータを正しく扱うことができません。

- 結果は非決定論的なものになります。

- レイテンシーが低いという利点があります。

カウントベースのウィンドウを使用する場合、バッチが完了するまでウィンドウは起動しないことに注意してください。

タイムアウトして部分的なウィンドウを処理するオプションはありませんが、カスタムトリガーでそのような動作を実装することは可能です。

グローバルウィンドウアサイン機能は、すべてのイベント(同じキーで)を同じグローバルウィンドウに割り当てます。

これは、カスタムトリガーを使って独自のウィンドウ処理を行う場合にのみ有用です。

多くの場合、これが便利そうに見えるかもしれませんが、[別のセクション](https://ci.apache.org/projects/flink/flink-docs-release-1.11/learn-flink/event_driven.html#process-functions)で説明するように ProcessFunction を使用した方が良いでしょう。

#### ウィンドウ機能

ウィンドウの内容を処理する方法には、3 つの基本的なオプションがあります。

バッチとして、ウィンドウの内容を含むイテレータブルを渡す ProcessWindowFunction を使用します。

ReduceFunction や AggregateFunction を使用して、各イベントがウィンドウに割り当てられるたびに呼び出されます。

または、この2つの組み合わせで、ReduceFunctionやAggregateFunctionの事前に集約された結果は、ウィンドウがトリガされたときにProcessWindowFunctionに供給されます。

ここでは、アプローチ1と3の例を示します。それぞれの実装では、1 分間のイベントタイムウィンドウ内の各センサからピーク値を検出し、(key, end-of-window-timestamp, max_value)を含むタプルのストリームを生成します。

##### ProcessWindowFunction Example

~~~java

DataStream<SensorReading> input = ...

input

.keyBy(x -> x.key)

.window(TumblingEventTimeWindows.of(Time.minutes(1)))

.process(new MyWastefulMax());

public static class MyWastefulMax extends ProcessWindowFunction<

SensorReading, // input type

Tuple3<String, Long, Integer>, // output type

String, // key type

TimeWindow> { // window type

@Override

public void process(

String key,

Context context,

Iterable<SensorReading> events,

Collector<Tuple3<String, Long, Integer>> out) {

int max = 0;

for (SensorReading event : events) {

max = Math.max(event.value, max);

}

out.collect(Tuple3.of(key, context.window().getEnd(), max));

}

}

~~~

この実装で注意すべき点がいくつかあります。

- ウィンドウに割り当てられたすべてのイベントは、ウィンドウがトリガーされるまで、キー付きのフリンク状態でバッファリングされなければなりません。これは非常にコストがかかる可能性があります。

- ProcessWindowFunction には、ウィンドウに関する情報を含む Context オブジェクトが渡されます。そのインターフェイスは次のようになっています。

~~~java

public abstract class Context implements java.io.Serializable {

public abstract W window();

public abstract long currentProcessingTime();

public abstract long currentWatermark();

public abstract KeyedStateStore windowState();

public abstract KeyedStateStore globalState();

}

~~~

windowState および globalState は、そのキーのすべてのウィンドウについて、キーごと、ウィンドウごと、またはグローバルなキーごとの情報を保存できる場所です。

これは、例えば、現在のウィンドウに関する情報を記録しておき、後続のウィンドウを処理する際にそれを使用したい場合に便利です。

##### Incremental Aggregation Example

~~~java

DataStream<SensorReading> input = ...

input

.keyBy(x -> x.key)

.window(TumblingEventTimeWindows.of(Time.minutes(1)))

.reduce(new MyReducingMax(), new MyWindowFunction());

private static class MyReducingMax implements ReduceFunction<SensorReading> {

public SensorReading reduce(SensorReading r1, SensorReading r2) {

return r1.value() > r2.value() ? r1 : r2;

}

}

private static class MyWindowFunction extends ProcessWindowFunction<

SensorReading, Tuple3<String, Long, SensorReading>, String, TimeWindow> {

@Override

public void process(

String key,

Context context,

Iterable<SensorReading> maxReading,

Collector<Tuple3<String, Long, SensorReading>> out) {

SensorReading max = maxReading.iterator().next();

out.collect(Tuple3.of(key, context.window().getEnd(), max));

}

}

~~~

Iterable<SensorReading>は、MyReducingMaxによって計算された事前に集計された最大値である1つの読み取り値を正確に含むことに注意してください。

#### 後期のイベント

デフォルトでは、イベントタイムウィンドウを使用すると、遅いイベントは削除されます。

ウインドウ API には、これを制御するためのオプションの部分が 2 つあります。

[サイド出力](https://ci.apache.org/projects/flink/flink-docs-release-1.11/learn-flink/event_driven.html#side-outputs)と呼ばれるメカニズムを使用して、ドロップされるイベントを別の出力ストリームに収集するようにアレンジすることができます。以下にその例を示します。

~~~java

OutputTag<Event> lateTag = new OutputTag<Event>("late"){};

SingleOutputStreamOperator<Event> result = stream.

.keyBy(...)

.window(...)

.sideOutputLateData(lateTag)

.process(...);

DataStream<Event> lateStream = result.getSideOutput(lateTag);

~~~

また、許容される遅延時間の間隔を指定して、遅延イベントが適切なウィンドウに割り当てられ続けます(その状態が保持されます)。

デフォルトでは、各遅延イベントはウィンドウ関数を再度呼び出すことになります(レイトファージングと呼ばれることもあります)。

デフォルトでは、許容される遅延は0です。

言い換えれば、ウォーターマークの後ろにある要素は削除されます(またはサイド出力に送られます)。

例えば、以下のようになります。

~~~java

stream.

.keyBy(...)

.window(...)

.allowedLateness(Time.seconds(10))

.process(...);

~~~

許容される遅延がゼロよりも大きい場合、ドロップされるほど遅れているイベントのみがサイド出力に送信されます(設定されている場合)。

#### サプライズ

Flink のウィンドウズ API のいくつかの側面は、あなたが期待するような動作をしないかもしれません。

[flink-user メーリングリスト](https://flink.apache.org/community.html#mailing-list)やその他の場所でよく聞かれる質問に基づいて、あなたを驚かせるようなウィンドウに関する事実をいくつか紹介します。

##### スライドウィンドウでコピーを作成

スライディングウィンドウのアサイン機能は、たくさんのウィンドウオブジェクトを作成することができ、各イベントを関連するすべてのウィンドウにコピーします。

例えば、15分ごとに24時間の長さのスライドウィンドウがある場合、各イベントは4 * 24 = 96個のウィンドウにコピーされます。

##### タイムウィンドウはエポックに合わせて配置される

1時間の処理時間のウィンドウを使用していて、12時5分にアプリケーションを起動したからといって、最初のウィンドウが1時5分に閉じるわけではありません。

最初のウィンドウは55分間の長さで、1:00に終了します。

しかし、タンブリングウィンドウとスライディングウィンドウのアサインでは、ウィンドウの配置を変更するために使用できるオプションのオフセットパラメータが使用されていることに注意してください。

詳細は[タンブリングウィンドウ](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/operators/windows.html#tumbling-windows)と[スライディングウィンドウ](https://ci.apache.org/projects/flink/flink-docs-release-1.11/dev/stream/operators/windows.html#sliding-windows)を参照してください。

##### ウィンドウはウィンドウをフォローできます

例えば、これを行うために動作します。

~~~java

stream

.keyBy(t -> t.key)

.timeWindow(<time specification>)

.reduce(<reduce function>)

.timeWindowAll(<same time specification>)

.reduce(<same reduce function>)

~~~

Flinkのランタイムは、(ReduceFunctionやAggregateFunctionを使用していれば)この並列事前集計をしてくれると期待するかもしれませんが、そうではありません。

なぜこれが機能するかというと、タイムウィンドウによって生成されたイベントには、ウィンドウの終了時の時刻に基づいてタイムスタンプが割り当てられているからです。

ですから、例えば、1時間のウィンドウによって生成されるすべてのイベントは、1時間の終わりを示すタイムスタンプを持つことになります。

これらのイベントを消費する後続のウィンドウは、前のウィンドウと同じか、その倍数の持続時間を持つべきです。

##### Empty TimeWindowsの検索結果はありませんでした

ウィンドウは、イベントが割り当てられたときにのみ作成されます。そのため、指定された時間枠内にイベントがない場合、結果は報告されません。

##### 遅いイベントは遅いマージを引き起こす可能性があります

セッションウィンドウは、マージ可能なウィンドウの抽象化に基づいています。

各要素は最初に新しいウィンドウに割り当てられ、その後、ウィンドウ間のギャップが十分に小さくなるとウィンドウがマージされます。

このようにして、遅いイベントによって、以前に別々になった2つのセッション間のギャップを埋めることができ、遅いマージを行うことができます。

### ハンズオン

この項目に付随するハンズオンエクササイズが[「時報ヒントエクササイズ」](https://github.com/apache/flink-training/tree/release-1.11/hourly-tips)です。

### 続きを読む

- [Timely Stream Processing](https://ci.apache.org/projects/flink/flink-docs-release-1.11/concepts/timely-stream-processing.html)