最近、Transformerの著者の一人が立ち上げた日本のAIスタートアップ「Sakana AI」が、新しいLLMの作成手法”進化的モデルマージ(Evolutionary Model Merge)”を発表しました。SNSで非常に話題になりましたので、共有したいと思います。

1.レイヤーとパラメーターの組み合わせ

この手法は、既存のモデルのレイヤーとパラメーターの組み合わせを最適化することで、高性能なモデルを自動的に構築する手法です。

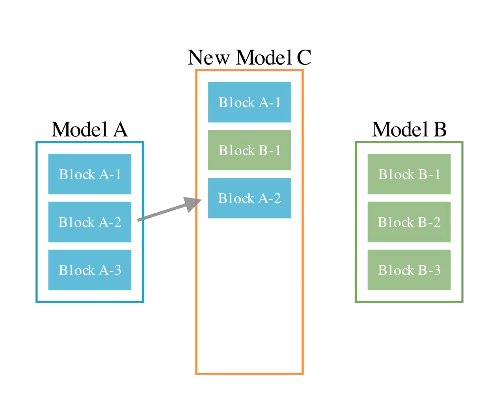

レイヤー間のマージでは、進化的アルゴリズムを用いて、複数の既存モデルから最適なレイヤーを選び出し、それらを並び替えます。下の図のようなイメージです⇩

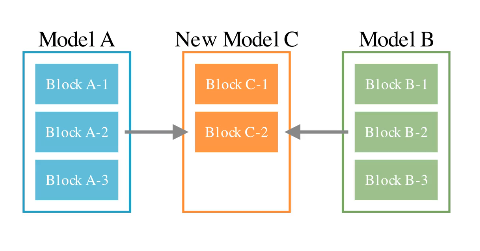

一方、パラメータのマージは、異なるモデル間の最適な重みを探して、それらを組み合わせることを指します。⇩

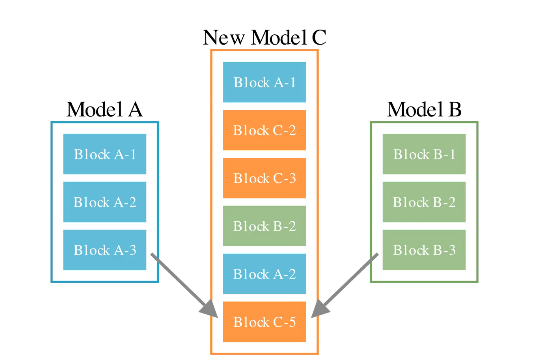

そして最後に、これら2つのマージ方法を再度組み合わせ、自動化することで、モデルを自動的に生成することができます。⇩

2.モデルの精度

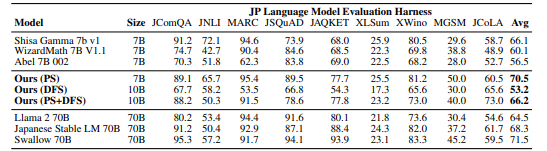

⇩はマージ後のモデルの精度です。日本語モデル「Shisa Gamma 7B v1」と英語の数学モデル「WizardMath 7B v1.1」、「Abel 7B 002」を組み合わせたところ、「Llama 2 70B」や「GPT-3.5」といった既存の高性能モデル並みのスコアを達成しました。

3.マルチモーダル間のマージ

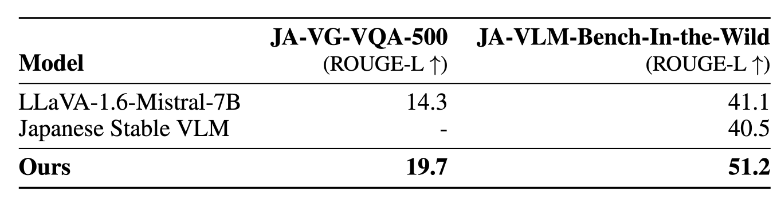

さらに、マルチモーダル間のマージも可能です。英語のマルチモーダルモデル”LLaVA”と日本語LLM”Shisa Gamma 7B v1”をマージすることで、日本語データで学習した”Japanese Stable VLM”よりも高い精度のモデルを生成できました。画像生成モデルにも同様の結果が得られました。(もちろん一切勾配ベースのトレーニングせず、単純にマージしただけです)

これら3つのモデルは、現在Hugging Faceでそのまま試すこともできます。

興味ある方試してみてください: