はじめに

こんにちは!

本記事では、弊社で生成AIを活用した社内向けチャットアプリケーションを開発・導入し、累計500万回以上の利用を達成した取り組みをご紹介します。

具体的なアーキテクチャに焦点を当てるのではなく、導入に至るプロセスや考え方などの知見を共有することで、情報システム部門やAI推進担当の方々の一助になれば幸いです。

背景・ねらい

2022年末、ChatGPTの登場により生成AIへの注目が急速に高まりました。しかし、当時の日本国内では具体的な活用事例が少なく、活用している企業の多くは生成AIをどのように業務に取り入れるべきか模索している状況でした。

一方で、今ではAI関連の記事が非常に多いですが、まだまだ工程立てて組織での利用を推進していく記事も少ないと感じます。

そのため本記事では、備忘録を兼ねて、その取り組みのプロセスと考え方を時系列に沿ってご紹介します。

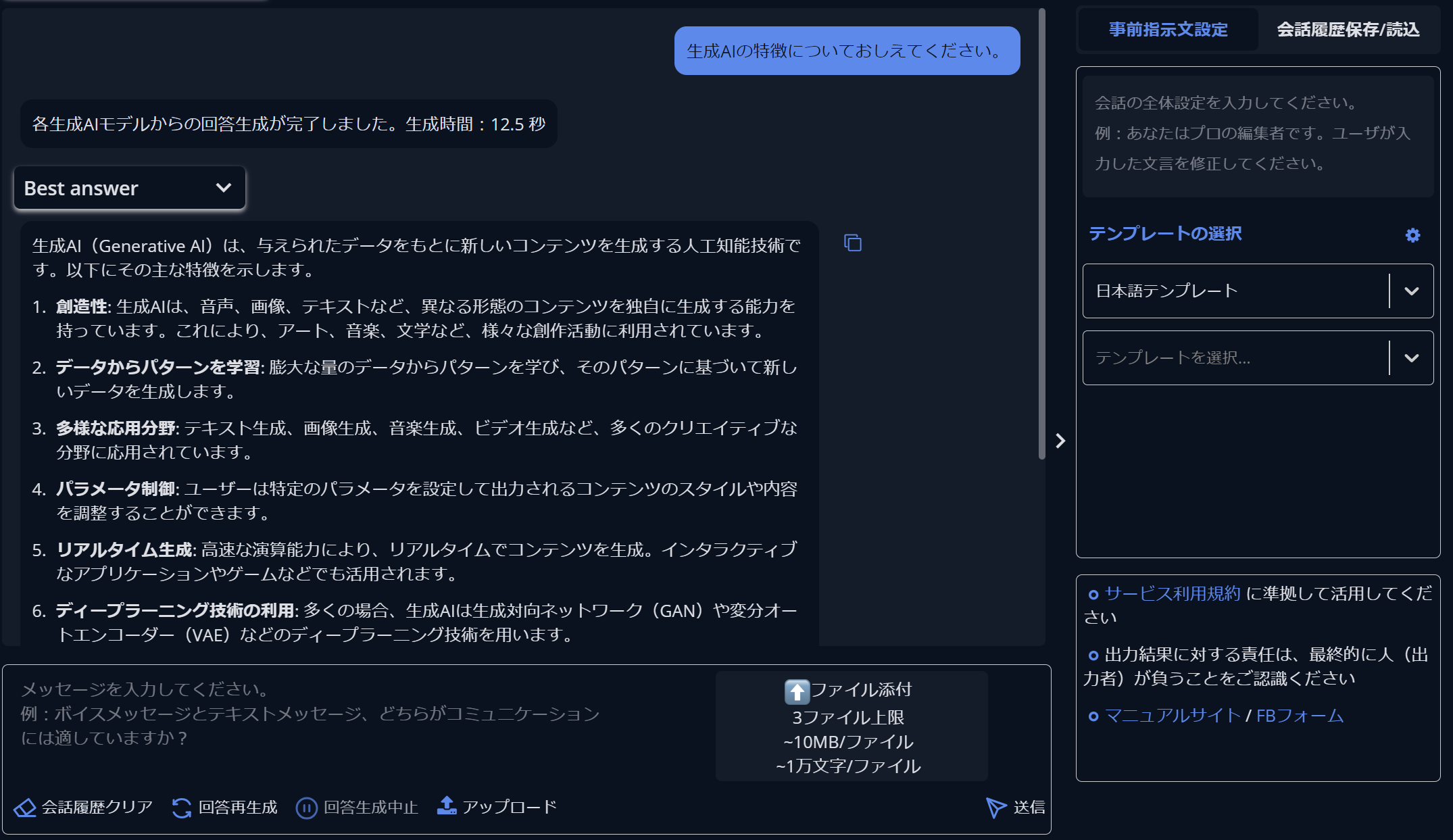

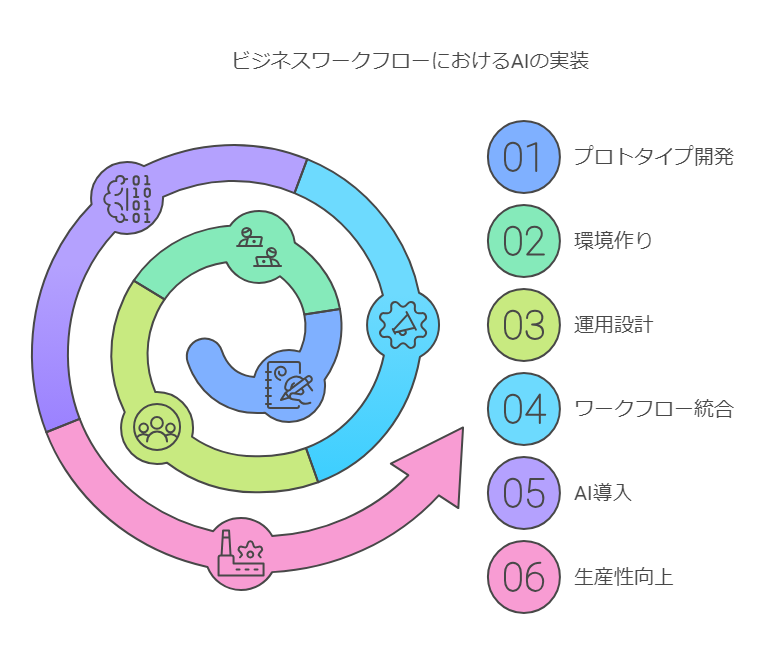

導入工程

【STEP0】プロトタイプ開発(開始1-3ヶ月後)

2022年12月、生成AIの可能性に着目し、まずはプロトタイプの開発を開始しました。

プロトタイプはローコードツールのn8nを使用して短期間で開発しました。(今ならAIで一発ですね)

デモを通じて、生成AIが特別なツールではなく、日常的にすぐ使えるものであることを実感してもらい、本格的な実装へと進むことができました。

特にそのタイミングで意識したのは、業務の効率化やコミュニケーションの促進といった実益のあるプロダクトを目指すことでした。

【STEP1】やれない・やらない理由を作りにくい環境作り(開始2-5ヶ月後)

組織での定着を成功させるためには、「やれない・やらない理由」を作りにくい環境を整え、社員一人ひとりが自分ごととして捉えて活用してもらうことが何より大切です。

そのために、以下の取り組みを行いました。

-

勉強会の実施

AIや生成AIに関する基礎知識を共有し、理解を深める場を設けました。今でこそあまりいないですが、2年近く前のWEB情報では"Chat GPT", "ChatGTP"など正確にChatGPTとスペルを記載できていないものも多かったのが印象的で、誤っている情報も多かったです。 -

ユースケースの共有とハンズオンの実施

実際に生成AIを業務でどのように活用できるかを具体的に紹介し、ハンズオンで体験してもらいました。文章の推敲から翻訳まで、日本語で指示すれば色々と出来ることを体感し、実際に体験しながら学ぶ機会を提供していくことで利用者間でもノウハウが共有されていったのは顕著な現象でした。 -

社内調整チームの初期からの巻き込み

「利便性」が上がる一方で、「セキュリティ」も大きな壁でした。セキュリティ、法務、知財部門のメンバーを早い段階からプロジェクトに参加してもらい、懸念点の解消や承認フローの策定に協力してもらいました。もちろん、それに対応できるネットワーク基盤構築も進める必要があります。 -

自社基盤利用とSaaS(Software as a Service)の検討

加えて、この工程では自社基盤利用とSaaSのどちらを採用すべきかを検討することも必要です。

SaaSのメリットとして、以下のような軸があります。- 導入の迅速性

- 初期コストの低減

- メンテナンス負荷の軽減

- ChatGPTなどの本家のサービスであれば新機能をリアルタイムで利用可能

一方で、自社開発のメリットとして、以下のような軸があります。

- 柔軟なセキュリティ要件への対応

- 業務プロセスとの適合性(特に既存業務)

- コストの長期的な最適化(特に人数が多いほどマルチLLM利用前提だとランニングコストが重い)

- 社内スキル・ナレッジの蓄積(将来的な他プロジェクトへの展開)

中長期的な観点では、ビジネスの源泉にもなるデータ活用が【STEP3】で必須になるため、検討いただくことが重要になるかと思います。

これらの取り組みが、スムーズな導入の鍵となりました。

【STEP2】導線設計と運用設計(開始3-12ヶ月後)

このSTEPでは、社員が手軽に、そして身近に使えるように設計を行いました。

-

導線のシンプル化

- チャットツールへの直接組み込み実装: 日常的に使用しているチャットツールに生成AI機能を組み込み、専用アプリをインストールする手間を省きました。

- 複数LLMの利用: 適切なモデルを自動選択する仕組みを導入し、用途やコストを時期に応じて最適なAIを活用できるようにしました。

- ファイル添付機能の追加: 画像やテキストファイルを対象に、必要なデータを簡単にアップロード・解析できるようにしました。

-

チーム制と承認フローの策定

運用上の混乱を避けるため、チームごとの利用や承認フローを明確にしました。 -

やらないことを決め、スコープを適切に絞る

開発期間の短縮とコストの削減を図るため、履歴機能の廃止や対象ファイル形式を限定するなど、機能を絞り込みました。

自前でLLMをデプロイしないAPI利用の場合、文字数(正確にはトークン)で従量課金制になるため、コストと流量制御が大規模利用では課題になるかと思います。

コストに関して、画像やPDFなどのアップロードは処理量が重いものの実業務を考えると利用は不可欠です。

一方で、履歴機能に関しては、一定の利便性を損なうものの、その場で複数回やり取りできる形であれば、永続的に残さずとも問題ないエクスポート形式で実装しました。

この決断は、コスト削減効果が大きかったので利用普及の壁を考えると必要な決断だったと思います。

流量制御についても、モデルの価格に応じて柔軟に変更できる仕様にすることで、一定回数に達したら、より安価なモデルを利用してもらうようにするなどの対策を取ってます。その際、ユーザー単位で行うことで、組織全体としての活用が損なわれない形にし、より積極的な活用が必要な場合は別の仕組みを準備してスコープアウトさせることで、要件を絞ってます。 -

コンテクストを想定した導線設計(RAGの活用)

特定の質問や社内システムに関する問い合わせには、RAG(Retrieval-Augmented Generation)を活用して必要な情報を提供できるようにしました。

この機能は問い合わせ担当を中心にスタートし、自動的に中身の返答案を考える機能とすることで、AIの利用を自然と運用に取り組む形としました。

それ以上に重要だったのが「継続的にエンハンスできる仕組みや文化を作る」ことです。マニュアルやドキュメントを可能な限りオープンにし、担当者自身が改善に参加できる環境を整えました。

生成AIの運用においては、問い合わせの定常運用を行い、定常的にサイクルを回すことで品質向上に努めております。- 回答内容とAIによる回答補完生成内容の比較: 人間の回答とAIの回答を比較(LLM as a Judge)し、精度や適切性を評価しました。

- 仕組みとデータの分析・スコアリング: 問題が仕組みにあるのか、データにあるのかを分析しました。

- 仕組みに問題がある場合: 最新の研究事例(Self-RAG, RAG Fusion)や同様の問題解決事例を参考に、システムの修正を行いました。

- データに問題がある場合: データの更新や修正を行い、適切な情報を提供できるようにしました。

このサイクルを継続的に回すことで、生成AIの精度と信頼性を日々高めています。

【STEP3】ビジネスワークフローへの組み込み(開始4-13ヶ月後)

生成AIの登場前は、入力に対して一意に定まる回答を返すシステムが主流でした。

登場後は、過去のデータに基づく確率分布から、推定できる範囲内に想定解が定まる業務のシステム化が可能になり、業務のシステム対象が大きく拡大しました。

問い合わせ回答の自動生成以外に、資料作成におけるワークフローを例として、考えると以下のようなプロセスになります。

| # | ステップ名 | 責任主体 | 実施内容 |

|---|---|---|---|

| 1 | 目的の明確化 | 人間 | 人間が資料の目的やテーマを設定 |

| 2 | 情報収集 | AIとシステム | AIとシステムが関連情報を収集・整理 |

| 3 | 構成の設計 | AI | AIが資料の構成案を提案 |

| 4 | コンテンツ作成 | AIとシステム | AIとシステムが内容を生成 |

| 5 | 視覚要素の追加 | AI | AIがグラフや図表を作成 |

| 6 | レビューと校正 | 人間 | 人間が内容をチェック・修正 |

| 7 | フィードバックの反映 | AI | AIが修正内容を反映 |

| 8 | フォーマットと仕上げ | AIと人間 | AIと人間が最終調整 |

このようにプロセスを細分化し、AIが得意な部分を最大限に活用することで、今までシステム化できなかった部分の自動化をマルチエージェントの仕組みを利用して、可能になりつつあります。

結果

これらの取り組みにより、社内では多くの社員が生成AIを活用するようになりました。

500万回という実行回数は、APIなどの自動処理を除いた、人間が実際にAIと対話した総数であり、業務効率化や生産性向上に大きく貢献しています!

最後に

企業によって導入ステップや取り組み方はさまざまですが、私個人としても「使うだけの技術」から「使いこなす技術」へと生成AIの活用を深めていくことが重要だと改めて痛感している日々です。

生成AIの本格的な活用はまだまだこれからだと思いますので、新技術を楽しみながら積極的に活用していきましょう!

この記事が、同じような課題に取り組む皆様の一助になれば幸いです。