今日は下のurl部分を進めて行きます。

教師なしアルゴリズムのクラスタリングについてのtutorialです。簡単に述べると、データ点を、その点が互いにどれだけ似ているかに基づいてグループに割り当てることです。多くの分析において地域別・年齢別・・・というようにセグメントに分けて分析していることを考えると直感的な理解ができるとおもいます。

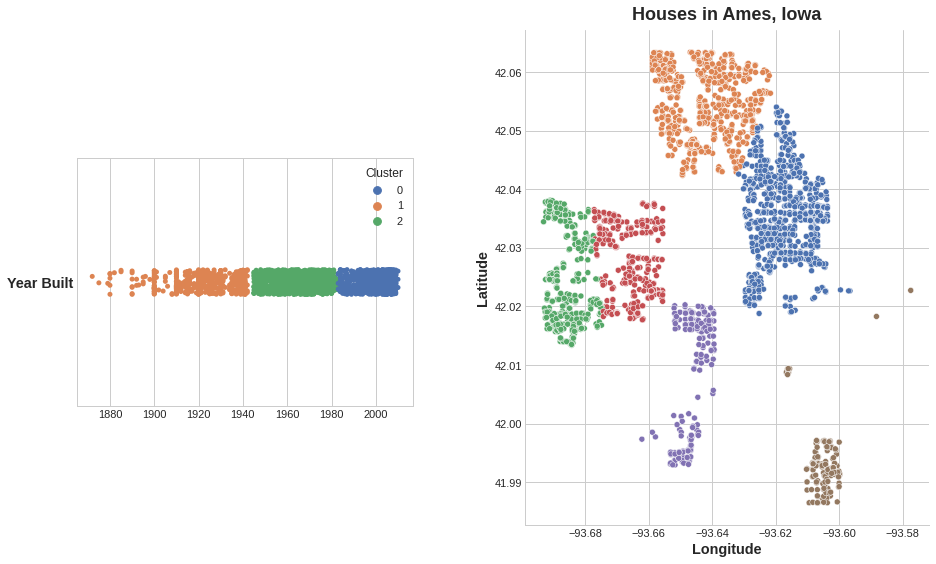

が最もビジュアライゼーションされたものでしょう。図上で近い地点にあるデータ点を同じグループにまとめる(クラスタリングする)ことができれば非常にデータを分析するのに効果的です。

この先のtutorial部分でも言及されますが実際にはN次元のデータであったりすると図示するのが困難であったり、いくつのグループに分けるのがよいかという点で苦労があります。

(tutorialでも述べられているとおり、)一般にクラスタリングアルゴリズムであったり、ハイパーパラメータ(例:先程のグループ数のようなもの)をどのようにするのかがたくさんあります。tutorialではK-means法以外は登場しませんが、クラスタリングの一覧は次のscikit-learnの一次資料を確認してください。

scikit-learnではクラスタリング法が違っていても関数呼び出しの名前部分を少し変えるだけで統一的に取り扱うことができます。データによって最適なアルゴリズムは代わり、汎用的なアルゴリズムは存在しませんので、複数の方法を試してみましょう。

クラスタリングの一般的な使用方法を下に載せると、

# Xは何らかの元データ

kmeans = KMeans(n_clusters=3)

kmeans.fit(X)

# そのほかのクラスター法の例;階層的クラスタリングモデル

model = AgglomerativeClustering(n_clusters=3)

#dataは予測したいデータ

labels = kmeans.predict(data)

print(labels)

となります。