おはようございます!

本記事はアイカツ!Advent Calendar 2018ではなく AR Advent Calendar 4日目です。

みなさんAR使ってやりたいことって何ですか?

ARをやりたいモチベーションってどこから来ますか?

モチベーション

僕は漫画やアニメが昔から大好きなので、日本が誇る空想技術をついに現実世界に具現化できる時代が来た!というモチベーションが一番強いです。

弊社meleapで開発しているHADOでも、CEO福田が子供の頃から打ちたかった「ドラゴンボール」の「かめはめ波」をAR技術を使って実現したというエピソードがあり、そういう発想に大変共感して入社した覚えがあります。

既存メディアから連想するAR技術

さて漫画やアニメから連想されるAR技術は必殺技だけではありません。

きっとARで実現されるであろう、僕が一番興味あるものの一つにライブ演出があります。

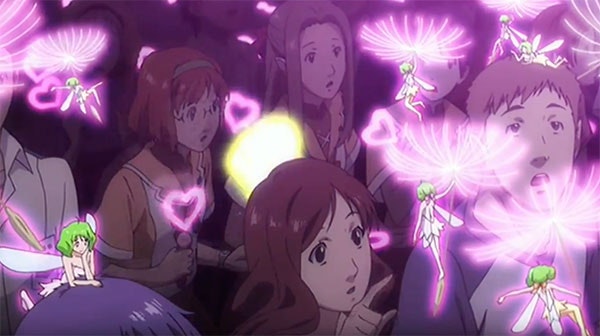

上の画像は「劇場版マクロスF~サヨナラノツバサ」でのライブシーンで、歌い手であるランカ・リーが小さな妖精になって観客の前に飛んでくる演出です。マクロスシリーズは歌をテーマにした近未来バトルアクションなのでこういった演出が多数出てきます。

アイカツ!をARで実装しよう

アニメに描かれているAR演出は他にも多くありそうですが、今回はTVアニメ「アイカツ!」で表現されている演出を題材に実際「今」のAR技術で実装するならどうするか検討してみたいと思います。

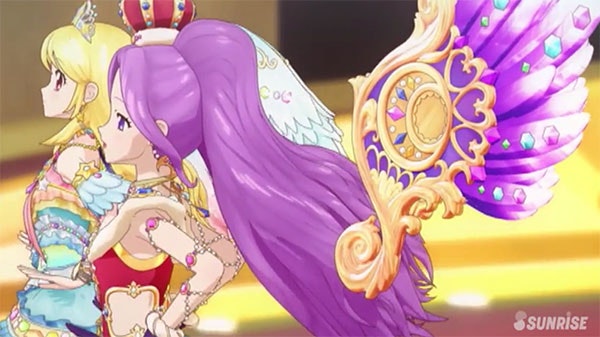

アイカツ!はタイトルの通りアイドル活動を描くアニメなのですが、ライブ演出部分はちょっと未来を先取りしたものが採用されています。

©SUNRISE/BANDAI,DENTSU,TV TOKYO

カードによるデータベース連動

©SUNRISE/BANDAI,DENTSU,TV TOKYO

©SUNRISE/BANDAI,DENTSU,TV TOKYO

アイカツ!ではアイカツカードという、衣装や演出をデータ化したものをアイカツシステムに読み込ませることでAR(設定上はVRなのかも)の衣装や演出をまとう事ができます。

このカードシステム自体はQRコードを読み取る筐体ゲームとしてゲームセンター等に設置されており(というかゲームが元です)、実際に集めたカードを読み込ませてモニタ上のキャラクターの衣装を変える仕組みになっています。

©SUNRISE/BANDAI,DENTSU,TV TOKYO

ゲームをプレイすると手に入る新衣装をその場でQRコード付きカードとして発行できます。手に入れたQRコードは次回以降のプレイで利用できます。

もしARアトラクション・ARゲームとして実装するのであればこの仕組みはそのまま使いたいですね。

©SUNRISE/BANDAI,DENTSU,TV TOKYO

現実世界と拡張世界を繋ぐ瞬間

アイカツシステムにカードを読み込ませたらゲートをくぐります。ゲートの向こうが衣装のフィッティングルームになるので、ここが現実世界と拡張世界の境界の役目を果たします。

例えばこの部屋でデバイスを装着してオペレーターによるシステム解説を挟み心理的没入感を徐々に高めるのに使えそうですね。

©SUNRISE/BANDAI,DENTSU,TV TOKYO

弊社が開発したHADO MONSTAR BATTLE〜ダンジョン・オブ・ダークネス(ハウステンボスに導入)でもARデバイスを装着する前に完全な暗闇迷路を探検させることでラスボスとの対峙に向け没入感を高めていく演出が取られています。

現実に拡張世界を繋ぎこむ瞬間の扱いは、ARコンテンツにおいて大切にしたいポイントです。

ライブステージ作り

©SUNRISE/BANDAI,DENTSU,TV TOKYO

いよいよステージ作りです。

さらっとデバイスを装着と書きましたが、どんな演出をしたいかで最適なデバイスは変わるでしょう。

複雑な演出を目指すのであれば、全身にマーカーを装着するモーキャプやOptiTrackなども候補に上がってきます。

過去の事例をあげると、NHK天才テレビくん YOUではOptiTrackを採用し、武器を振りかざす演出などを実現しています。

「天才てれびくん YOU」AR 技術を活用した特別生放送 制作の取り組み

©SUNRISE/BANDAI,DENTSU,TV TOKYO

今回の演出は演者の背後に羽根を出したり、周辺にエフェクトがついてくることをメインとしたいので

単純に演者のポジションが取れていれば十分とします。

また全体を妄想してるうちにロケーションベースのアトラクションとして成立できる可能性も感じたので、装着が簡単なiPhoneを採用します。

実装内容としてもARKitで十分実現できそうですね。

他にもOSの挙動が安定してる点や、熱に強い点、入手しやすい点などは今iPhoneを選ぶメリットだと感じています。

装着に関しては演者にもARを実感させながらライブするのであればHMDを採用しますが、ここは悩ましいですね。

本当にポジションを取れればいいだけならこっそり背中や腰に装着してカメラだけ見えてても良いでしょう。

ARKitは画像解析に加えIMUセンサーも使ってトラッキングしているので、激しすぎるダンスなどは厳しいかもしれません。

iPhoneのIMU値は強い力を掛けると比較的簡単に狂います。

ライブに付き物である照明も、特徴点が変わってしまいトラッキングの精度が落ちてしまうのが予想されるので、照明そのものはARで表現したほうがよいかもしれません。

当然真っ暗なのもNGでしょう。

もし暗闇前提でポジトラをするのでれあば光るARマーカーを要所に配置してマーカーベースのトラッキングをするのが現状最善手でしょうか??

観客視点

©SUNRISE/BANDAI,DENTSU,TV TOKYO

観客も受信機のようなものを頭に装着してます。

作中では脳波か何かで演出を感じているのでしょうか?もしくは網膜照射でしょうか?

さすがにこのあたりはまだまだ技術が程遠いので、現状で出来ることを考えると

観客がそれぞれ持ったスマホにアプリを入れて画面越しで見てもらうのが最善でしょうか。

スマホ片手にライブを見るのも興ざめなのでHMDに差し込んで没入感は高めたいですね。

オクルージョン

観客視点からは人とARの重なり(オクルージョン)も気になってきます。

超簡易実装だと、人を大雑把に包むオブジェクトにグラデーションマスクをかけて擬似的なオクルージョンにするだけでも案外いけるかもしれません。

本格的なオクルージョンについてはDepthセンサーや複眼カメラなどデバイスのAR特化が待たれるものだと考えられてきました。

がしかしFacebook(のインターン生!!)から最近素晴らしい論文が発表されました。

彼の論文ではARのオクルージョンにこれまで研究されてきたような絶対的な深度の正確さはそこまで必要無いので別の方法(ソフトエッジ検出)を取ってるらしく、モバイル端末でもOK、ディレイは116msほどしかないそうです。

こうしたComputerVisionのみでのアルゴリズムが次々と生まれてきているのでオクルージョンの解決は案外早いかもしれないですね。

通信

各デバイスへのデータ送信は現状だとローカルなWi-Fi通信がベストだと考えますが、アクセスポイント1つに付き接続出来る台数は業務用で頑張りまくっても50〜100台くらいでしょうか?

ブロック毎に隣の電波を極力遮蔽した壁を設けて混線を避けてアクセスポイントを配置する等でなんとかならないでしょうか。

正直ここが一番ネックを感じています。

また通信速度もネックになってくるので、TCPによる安全確実な通信よりもUDPによるシンプル最低限なプロトコルが求められます。

最近ではGoogleが開発してきたUDPベースのQUICプロトコルがHTTP/3になることが決まったり、そのGoogleとUnityが提携したりと、来るべき時代に向けて着々と準備が進んでいる感もあるので注目したいです。

以上で「アイカツ!」のライブをARで実装する検討は完了です。

本当はプロトタイプの実装までするつもりだったのですが、Multipeer Conectivityとかどうかな?と調べてたらそれだけで終わってしまいました。

残りは冬休みの宿題にさせてください!

こうして夢を仕様検討してみるとまだまだな技術の進歩待ちな部分もありますが、とりあえず今出来る方法でやってみるのも大切だと思うのでAR開発者の皆さん一緒にがんばりましょう。