概要

- データの発生源に近い場所でデータを処理する「エッジAIコンピューティング」が注目されている

- まず、エッジAIのおおまかな概念を理解し、実際にエッジAI端末を購入して使ってみる

- 今回はVisionWorksのFuture Trackerのデモの動作を確認する

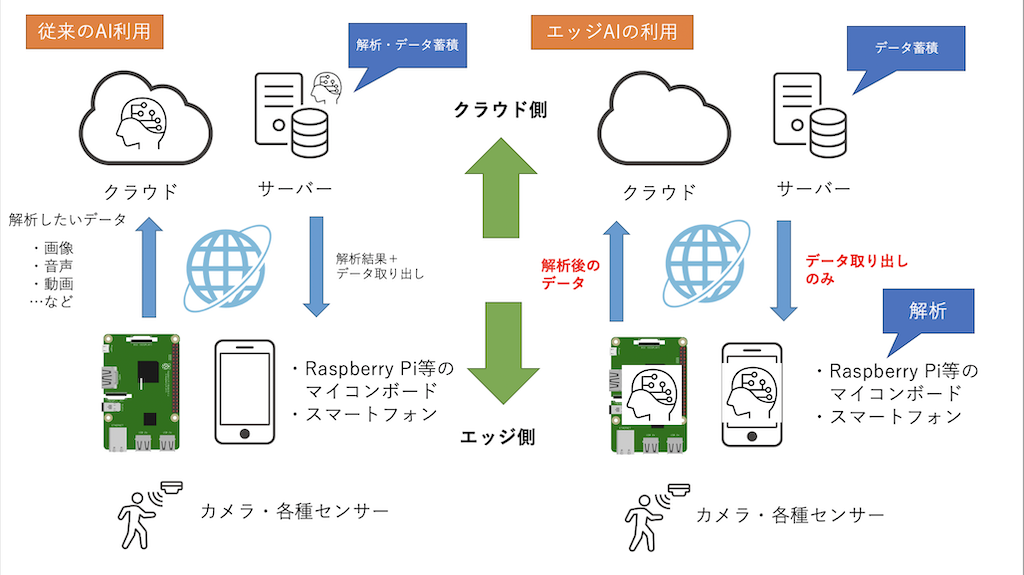

エッジAIとは何か

- 通常AI利用する場合は、センサーから収集された各種データはマイコンボードやスマホ、ネットワークを経由し

、クラウド上や従来型のサーバーで解析処理を行う - エッジAIを利用すると、センサーから収集された各種データはマイコンボードやスマホ内で解析される

用意するもの

- Jetson Nano開発者キット 2GB

- RaspberryPi4 対応 電源セット(5V 3.0A) ←Jetson Nanoにも使えます

- microSDカード(32GB以上推奨)

- HDMI接続のディスプレイ(4K推奨)

インストール

デモ環境のセットアップ

ホームディレクトリ ~/ にデモ環境をインストールする

# /usr/share/visionworks/sources/install-samples.sh ~/

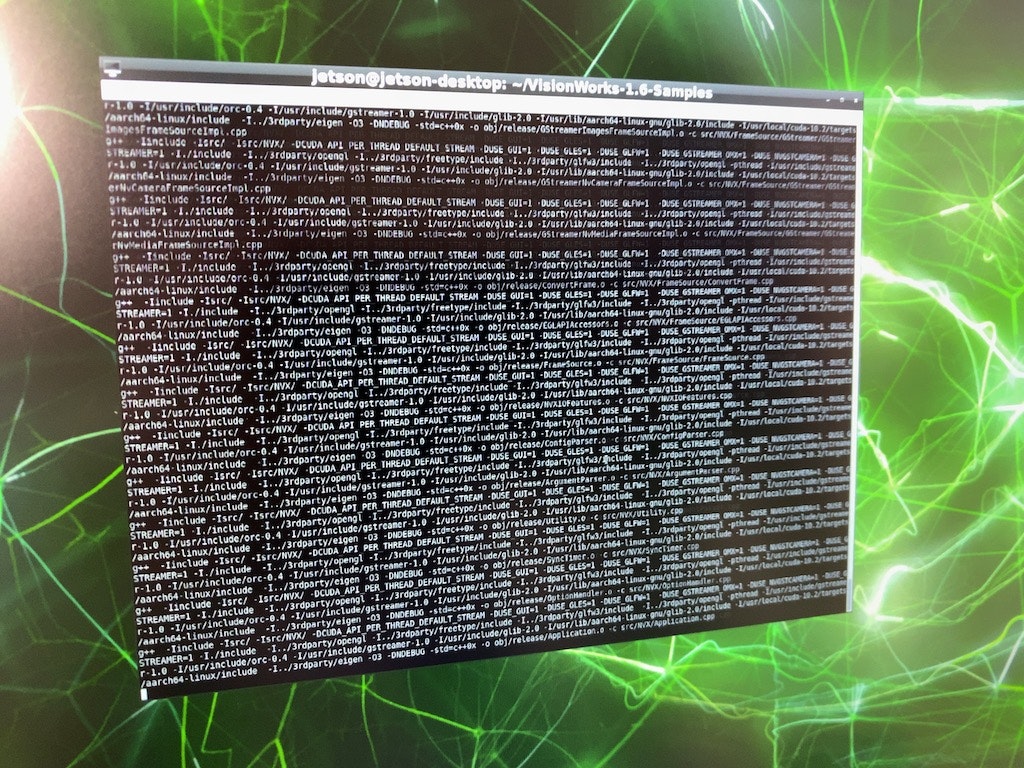

ソースコードの状態なので、そのままでは実行できません。 make コマンドでコンパイルします。

# make -j4 # add dbg=1 to make debug build

makeコマンドのオプション解説

- -j4 makeコマンドをマルチプロセッサ環境で高速化する

※この場合はジョブ数が4となります

※ #以降は、コメントです

実行ファイルのあるディレクトリに移動する

# cd bin/aarch64/linux/release/

デモを実行する

公園を散歩している人や動物に追跡するよう水色の矢印が表示されており、

動く方向に向いていることが分かります。

# ./nvx_demo_motion_estimation

任意の動画を読み込ませることもできます

# ./nvx_demo_motion_estimation --source=/home/jetson/Desktop/test.mov

自身で空撮した動画

水面が映っており、またカメラ自体も移動しているので処理が重い(20FPS程度)

検証を終えて

- ドローンを固定した場合と飛行させた場合の動作の違いを検証したい。

- 対象が小さすぎた。どの程度の大きさなら検出が上手く行われるのかを検証したい。

- 常に動きがある水面(自然物)の処理が原因で処理が重くなっていることが分かった。

- 追跡結果を操縦者にフィードバックすれば操縦の補助に利用できるかもしれない。