Open-interpreterとは

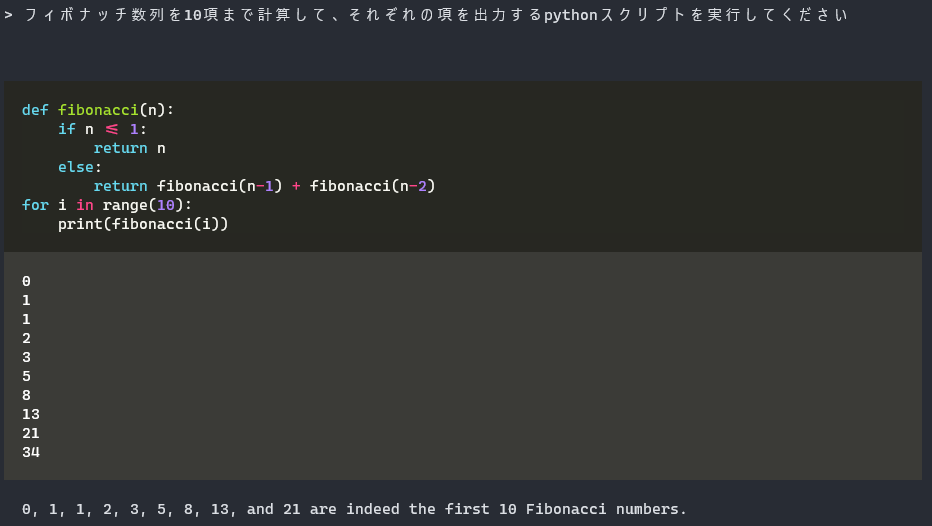

ターミナル上でLLMにプロンプトを差し出すと、命令通りにコードを書いて実行してくれるプログラム。

前提条件

- Anacondaがインストールされている

- ターミナルの使い方を知っている

インストール

$ conda create -n interpreter python=3.11

$ conda activate interpreter

$ pip install open-interpreter

$ env:FORCE_CMAKE=1; $env:CMAKE_ARGS='-DLLAMA_CUBLAS=on'

$ pip install llama-cpp-python --force-reinstall --upgrade --no-cache-dir -vv

起動

$ interpreter -y

「-y」は、コード実行の承認をスキップするオプション。つけると、勝手にコードを書いて勝手に実行するからちょっとこわい。

選択肢

[?] Parameter count (smaller is faster, larger is more capable): 7B

[?] Quality (lower is faster, higher is more capable): Low | Size: 3.01 GB, RAM usage: 5.51 GB

[?] Use GPU? (Large models might crash on GPU, but will run more quickly) (Y/n): y

基本は、GPUメモリの許容量で決めればいいと思う。Code-Llamaを使う場合のメモリ使用量の目安を表に示す。RTX 3070で7B中くらいは乗るかなといったところ(13B低は落ちた)。

| パラメータ数 | 回答の質 | 専用GPUメモリ |

|---|---|---|

| 7B | 低 | 6GB |

| 7B | 中 | 7GB |

| 7B | 高 | 10GB |

| 13B | 低 | 8GB |

| 13B | 中 | 11GB |

| 13B | 高 | 16GB |

| 34B | 低 | 16GB |

| 34B | 中 | 23GB |

| 34B | 高 | 38GB |

ちなみに34Bのモデルだと20GBのHD空容量が必要。