1. 概要

言語から画像を生成するタスク(text-to-image)では数多くのモデルが提案され入力したテキスト(prompts)から写真のような高品質な画像を、多様なバリエーションで生成することに成功している。一方、これらのモデルは与えられた学習セットの外見的な見かけを模倣したり、全く異なる文脈で特定の物体を再合成したりすることができなかった。こうした問題を”Subject-driven generation”という。

*Award Candidate: Honorable Mention (Student)

2. 新規性

提案手法では、テキストから画像へ変換する拡散モデル(Diffusion model)の”個別最適化”を実現することでSubject-driven generationを解決する方法を提案した。生成対象のわずかな画像例(Few shot examples)を入力として与え、事前学習済みのテキストから画像への変換モデルをファインチューニングし、入力で与えた特定の対象物と一意に関連付けさせるように学習を行うことで異なるシーンに特定の対象物を自然に合成することができる。

3. 実現方法

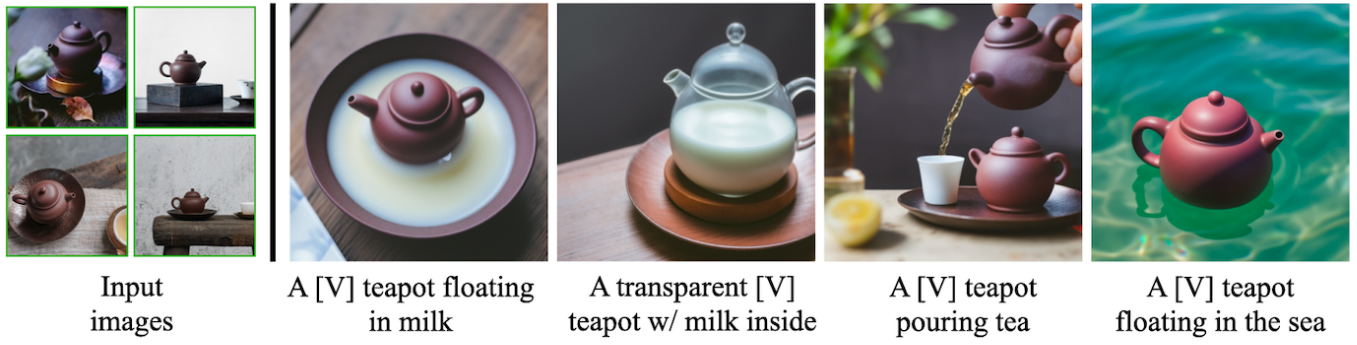

Few shot examplesとして3-5枚の画像を入力すると、一意な識別器が生成され事前学習ずみのtext-to-imageの大規模モデルが入力の対象物体でファインチューニングされる。推論時には、対象物は同一でも全く異なるシーンや文脈で画像生成することが可能になる。

ここで事前学習モデルに組み込まれた意味的な事前知識と新たに追加される個別最適化用のクラスの知識が保たれるようにロスを設計することで、参照画像には存在しない多様なシーンやポーズ、任意の視点や照明条件で対象物体を合成することが可能となった。

4. 結果

DreamBooth Dataset(30個の対象物がそれぞれ3-6枚含まれる)を公開しており、合成対象物体の特徴を保持しながらテキストによる任意視点合成やレンダリング、異なるシーンや文脈での画像合成などを実現した。

last updates: June 18 2023