1. 概要

学習ベースの画像圧縮(Learned Image Compression:LIC)では、従来の画像圧縮手法と比べて、画像の圧縮率と圧縮による画質の損失のトレードオフの関係が改善されており、畳み込みニューラルネットワーク(CNN)を用いたものとトランスフォーマーを用いたものが提案されている。一般的に、CNNを使う場合は局所的な情報集約能力に優れており、トランスフォーマーを使う場合は大局的な相関関係の抽出能力に優れている。この研究では、CNNとトランスフォーマーのそれぞれのよいところを組み合わせた手法となっている。

2. 新規性

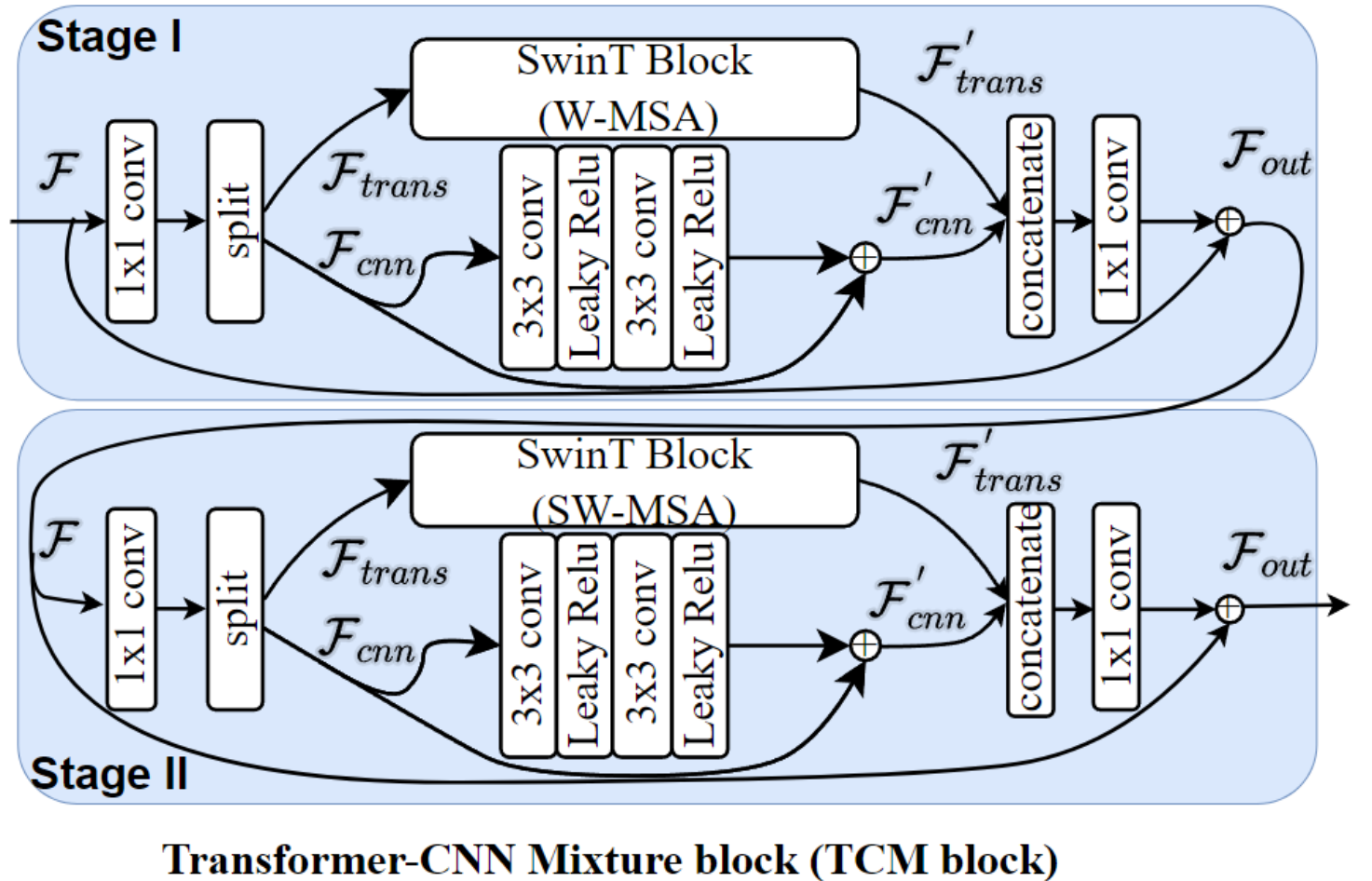

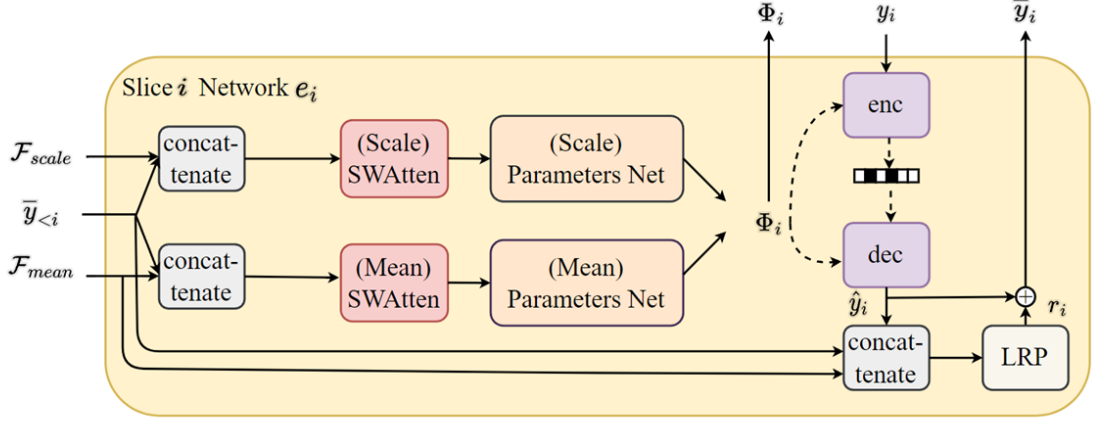

CNNの局所的なモデリング能力とトランスフォーマーの非局所的なモデリング能力を組み合わせたTCM(Transformer-CNN Mixture Blocks)を提案している。また、画像データの統計的な特性を学習してエントロピー(情報量)を推定するエントロピーモデルをアテンションとして組み込むSWAttenモジュールを提案している。

3. 実現方法

TCMブロックでは、1x1の畳み込み層を二つ持っており、トランスフォーマーとCNNのそれぞれの特徴を取得する部分と特徴をマージする部分で用いられている。2ステージ系の方がより特徴をマージしやすいとしている。

エントロピーモデルについては、チャネル単位の自己回帰モデルを採用しており、Swin-transformerをベースにしたアテンションモジュールとなっており、チャネル情報を圧縮してパラメータ削減を図っている。

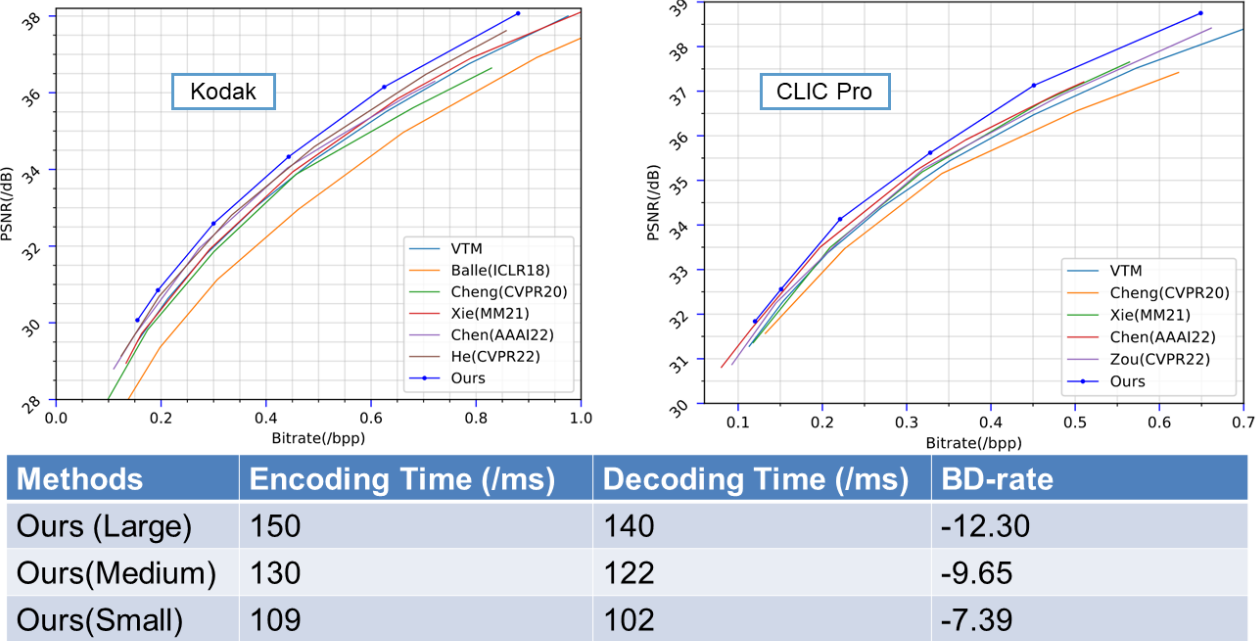

4. 結果

Kodak/Tecnick/CLIP Professional Validationの3つの解像度の異なるデータセットにおいて、既存のLIC手法と比較して画像の圧縮率と画質の損失率のパフォーマンスで向上していることを確認した。

last updates: June 30 2023