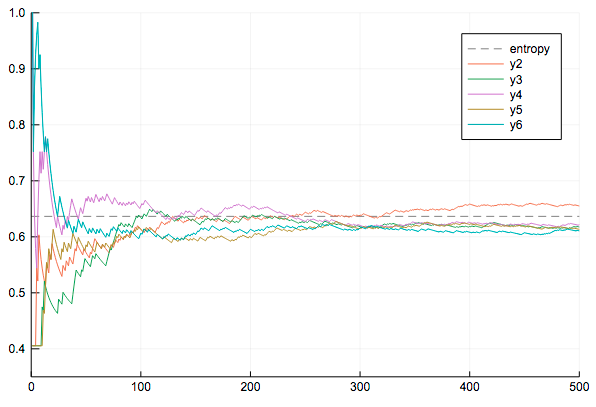

# approx. by sampling

num_trials = 5 # 試行数

num_samples = 500 # サンプル数

results = zeros(num_trials, num_samples) # 近似結果を格納

for t in 1:num_trials

seqt = rand(dist, num_samples)

for j in 1:num_samples

pj = sum(seqt[1:j])

nj = j - pj

termp = pj > 0 ? pj * log(μ) : 0

termn = nj > 0 ? nj * log(1 - μ) : 0

ej = - (termp + termn) / j

results[t, j] = ej

end

end

# 結果をプロットする

plot()

plot!([0, 500], [H, H], line=(0.5, :dash), color=:black, label="entropy")

for t in 1:num_trials

plot!(results[t, :], xlim=(0, 500), ylim=(0.35, 1.0))

end

plot!()