Cognitive ServicesのCustom VisionでAdvanced Trainingを使ってアナログメータの読み取りをやってみたら思いのほかうまくいったのでまとめておこうと思います。

Cognitive Serviceとは

Cognitive Serviceとは、機械学習等で必要となる専門的な知識があまりなくとも簡単に目的に沿ったモデルを作ったり、利用できたりするお手軽AI体験サービスです。今回はこのサービスの中の1つであるCustomVisionを使って画像分類をします。

作ったやつ

使ったもの

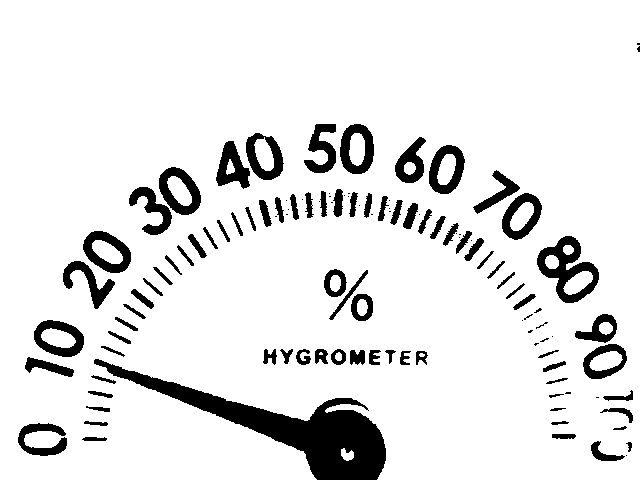

こんな感じの湿度計を使いました。ダイソーに行って買ってきました。

- 湿度計

- webカメラ

- Azureのアカウント

- Customvisionのリソース

とりあえず、これだけあればOKです。

ざっくりとした手順

- 写真を撮る(30分くらい)

- アノテーション(6時間くらい)

- Customvisionにアップロード(20分くらい)

- 学習(1時間半くらい)

それぞれの作業では、かっこの中に書いたくらいの時間使いました。厳密に計測したわけではないのでおおよそです。

アノテーションはめんどくさくて中々手が動かなかったので3日くらいに分けて作業してます。

1.写真を撮る

最終的な画像のサイズは640 * 480 pxで、解像度は96pdiです。形式はjpgです。

この湿度計は2%刻みの目盛りなので、0~100%まで目盛りの数だけ画像を撮っていきます。これで51タグ分のデータができます。1タグ当たりトレーニング用に20枚、テスト用に10枚の計30枚取得していきます。ざっと1530枚の画像が必要です。

分解するとこんな感じで、真ん中ところを回すと手動で目盛りを動かせます。黒いのはただのテープです。文字盤が接着されてなくて取れそうだったので手元にあった電子工作用の絶縁テープ貼っただけです。

1530枚もポチポチ写真撮っていくのはさすがに骨が折れるので、今回は動画を撮ってAfterEffectsを使ってJPGシーケンスとして出力しました。約3分くらいの動画で3000枚くらいの画像ができました。この辺りは工夫すればもっと簡単にやる方法があるんですかね?詳しい人教えてください。

教師データ作成用。動画撮って1フレームごとに連番の画像として出力。https://t.co/zrYCAVagLj

— shota (@Shota7Y) 2019年6月19日

こんな感じで作成できます。AfterEffectsの中で余分なところをトリミングしたり、グレースケールにしたりすると一石二鳥かもしれません。

2.アノテーション

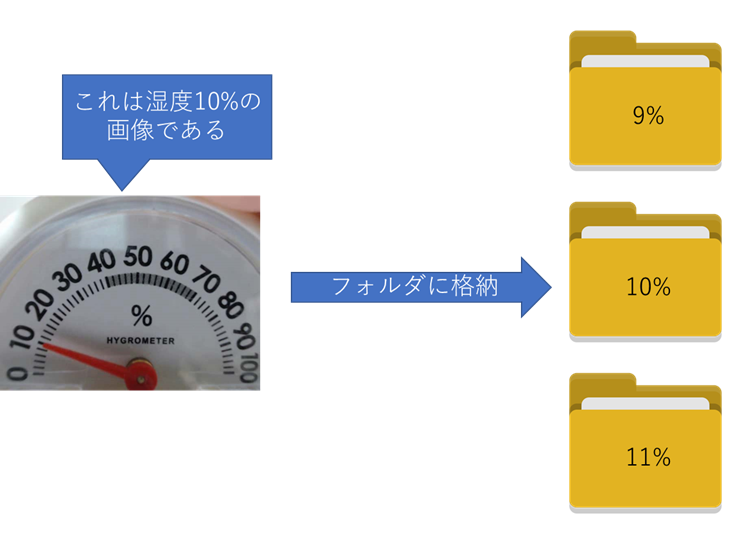

作成した3000枚の画像を1つ1つ目視で確認して、1%ごとにフォルダを分けていきます。実際には2%刻みのデータしか使いませんが、せっかく取得できたデータなので地道に頑張ってフォルダ分けしました。Deep Learningで一番めんどくさい作業ですね。

さすがに3000枚を確認していくのは面白くなくて結局3日に分けて、夜な夜なちょっとずつやってました。

3.Customvisionにアップロードする

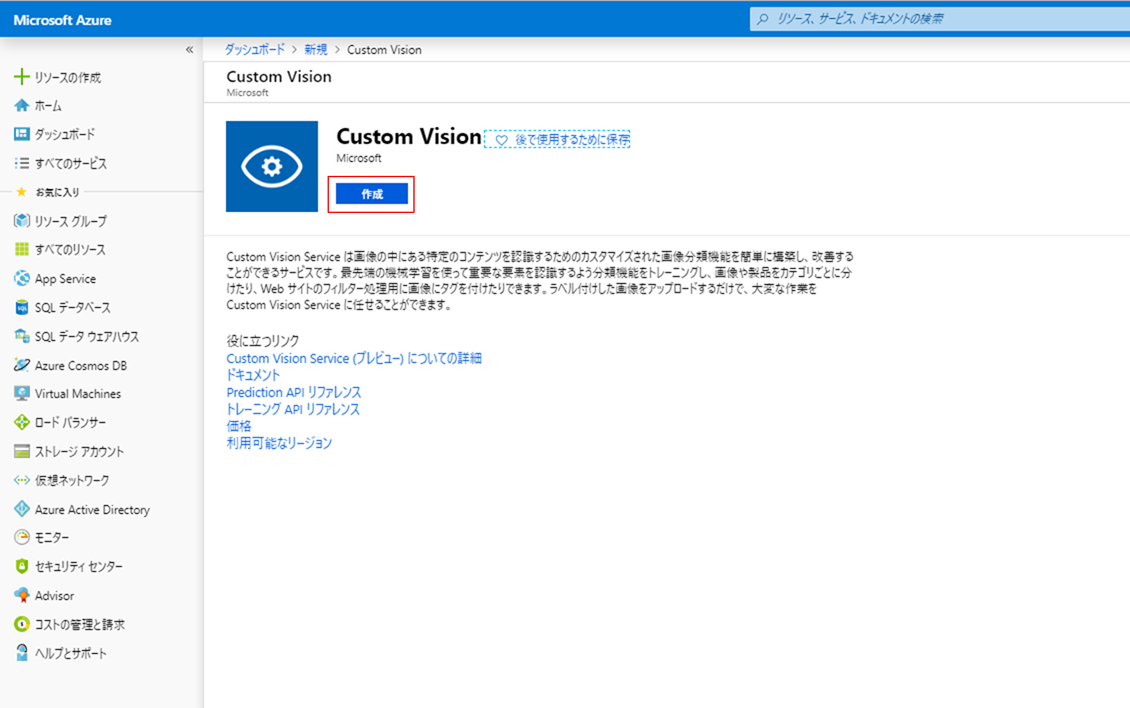

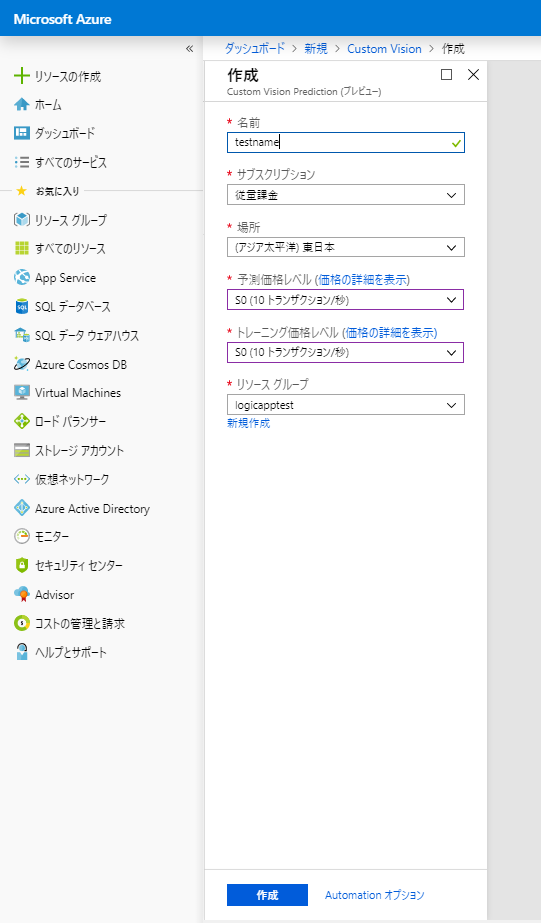

Azureでリソースを作る

- 名前:適当に

- サブスクリプション:私の場合は従量課金

- 場所:東日本

- 予測価格レベル:F0(画像はS0になってますが無料枠がある人はF0で良いです)

- トレーニング価格レベル:予測価格レベルと同じ

- リソースグループ:なければ作る。

必要な項目を入力したら作成ボタンでリソースを作成してデプロイ完了まで待ちます。

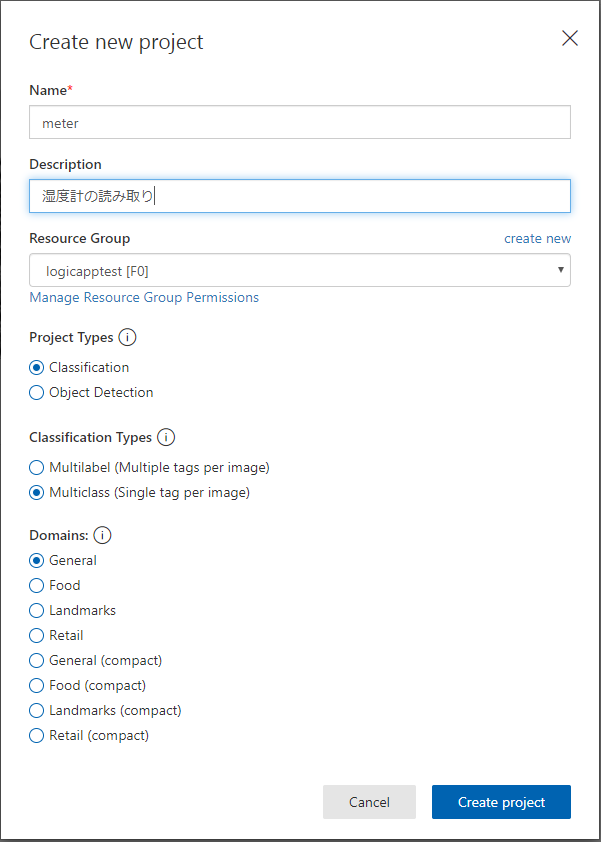

Customvisionでプロジェクトを作成

Custom Vision Home

ここにアクセスしてサインインします。

- Name:適当に

- Description:プロジェクトの説明を記載(書かなくてもよい)

- Azureでリソース作成した際のリソースグループが表示されているのでそれを選択

- Project Types:Classification(画像分類なのでこれ。もう1つは物体検出用です)

- Classification Types:General(ほかに該当しない場合はこれを選ぶ。Compactはエクスポートしてスマホやラズパイのようなエッジで使いたい場合(オフライン利用も含めて)に選択)

こんな感じに入力して「Create Project」をクリック

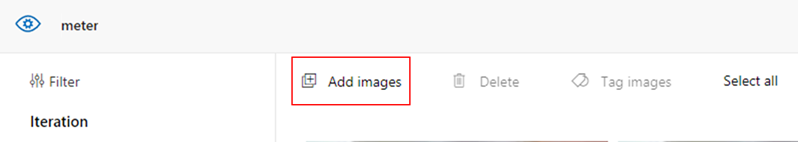

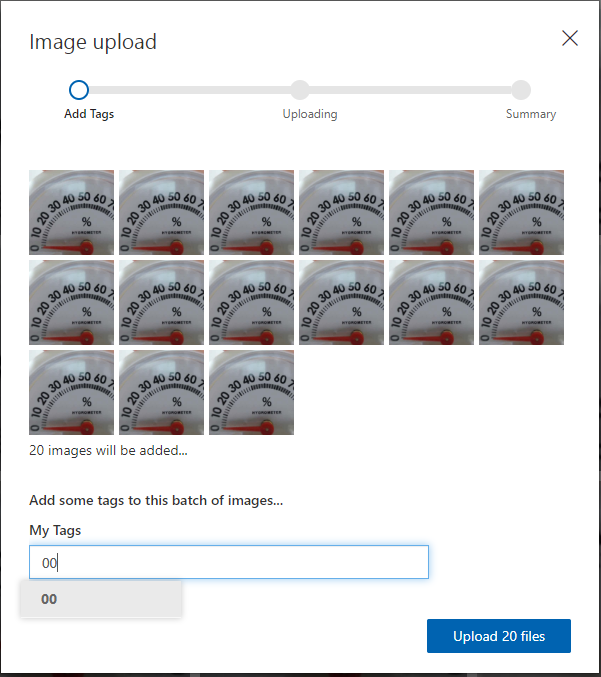

画像をアップロードしていく

画面左上の「Add images」から画像をアップロードしていく。

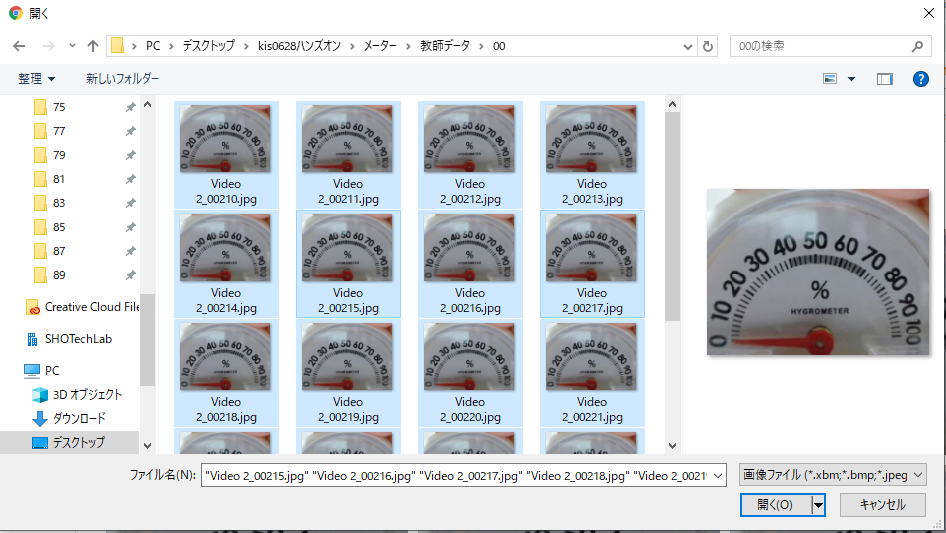

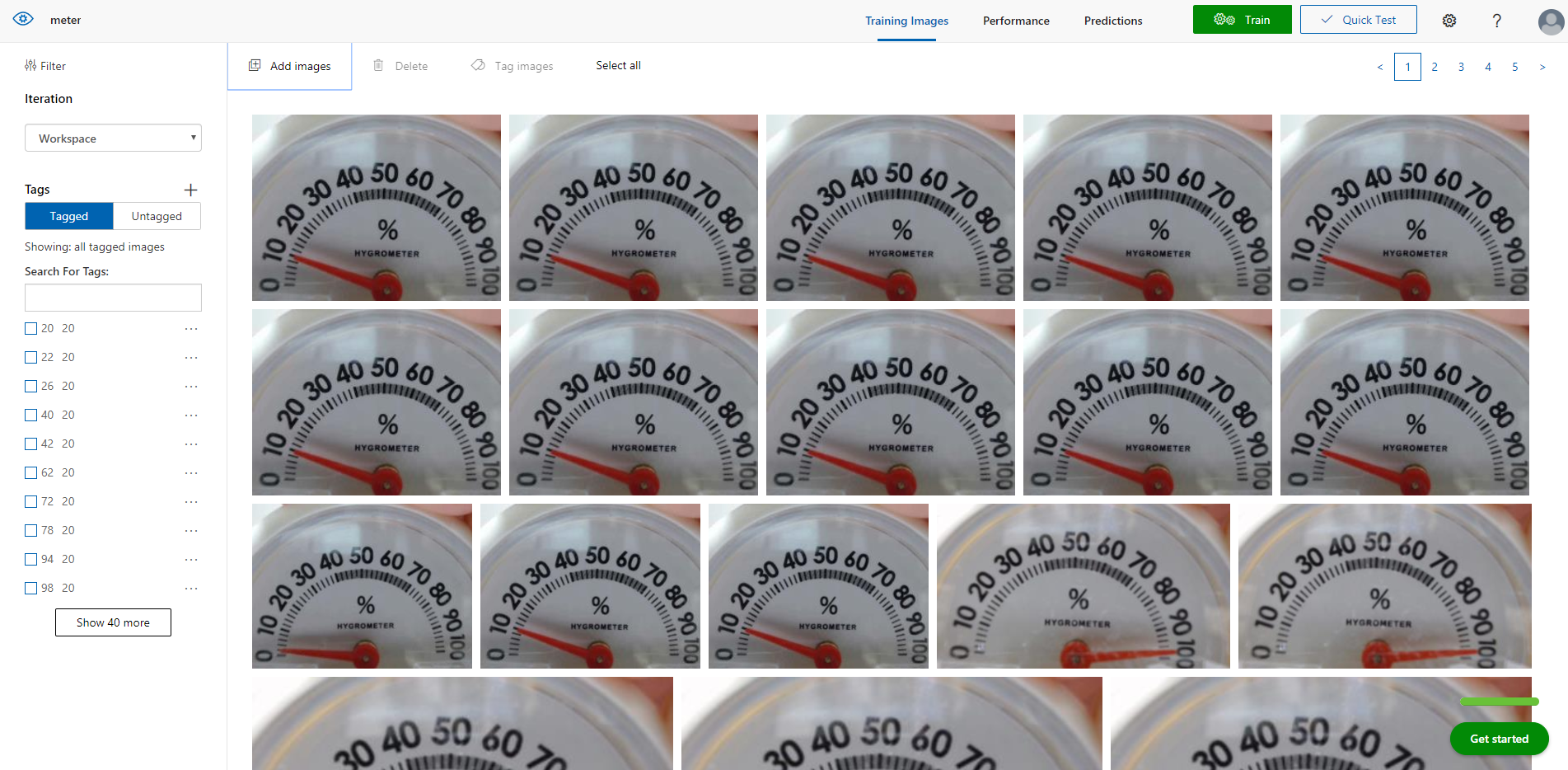

無料枠の場合、作成できるタグが50個までなので、今回は0~98%のデータを使います。

%ごとにフォルダ分けしてるので、20枚まとめて選択して「開く」

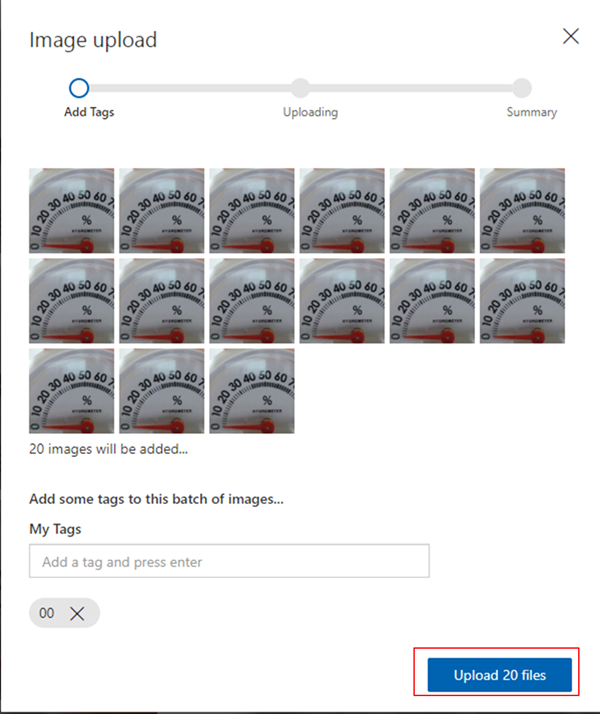

ここでタグを入力する。この画像はすべて0%なので「00」と入力してEnterキーで確定。2桁にそろえるために00と入力しているが0でもよいです。

タグが入力できていることを確認して「Upload files」をクリック。アップロードが完了したら「Done」で完了。

同じ手順でどんどん画像をアップロードしていきます。

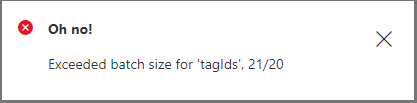

途中でこのエラーが出た場合は、画面左側のチェックボックスを外してください。ここが20を超えるとエラーが出ます。アップロードに失敗しているわけではないのでそこは安心して大丈夫です。

4.学習させる

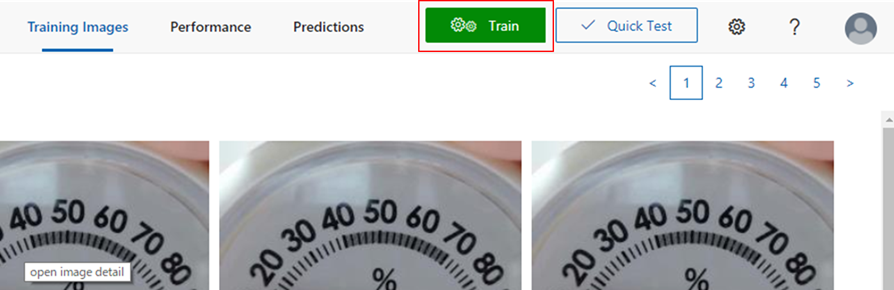

画像がアップロード出来たら画面右上の緑の「Train」ボタンをクリック。

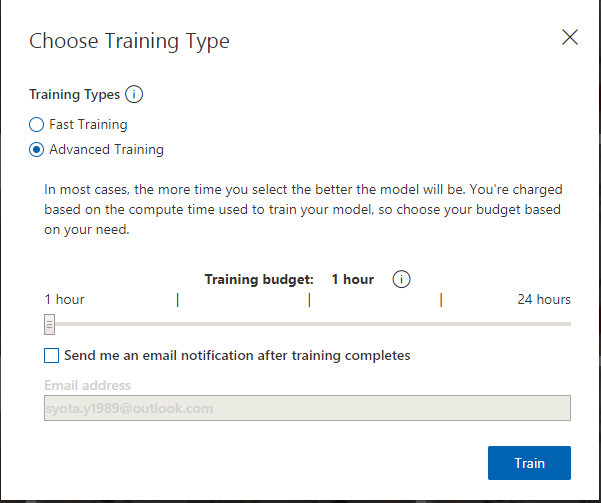

「Fast Training」を選択して「Train」ボタンをクリック。これで1~2分くらいで学習が完了しますので終わるのを待ちます。

「Advanced Training」は後から触れますので今は飛ばします。

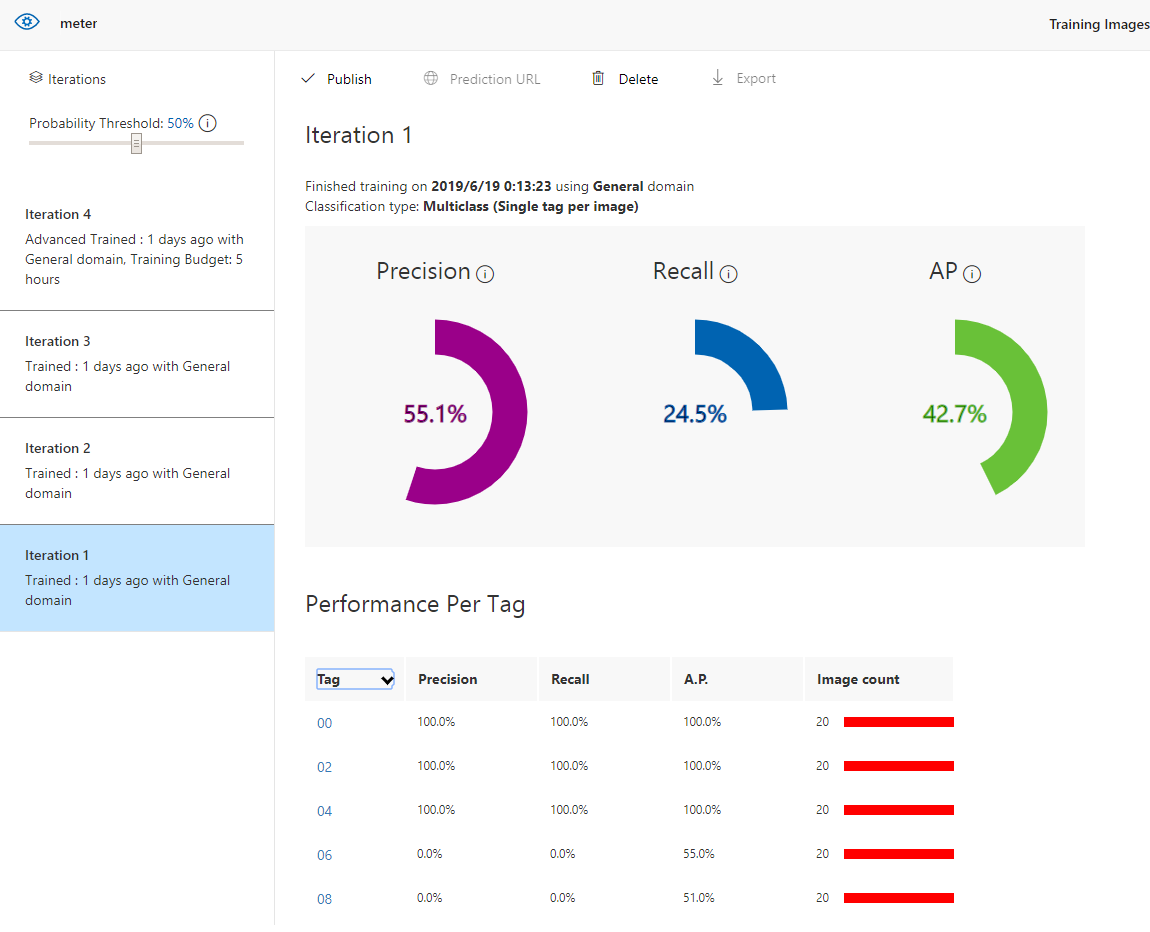

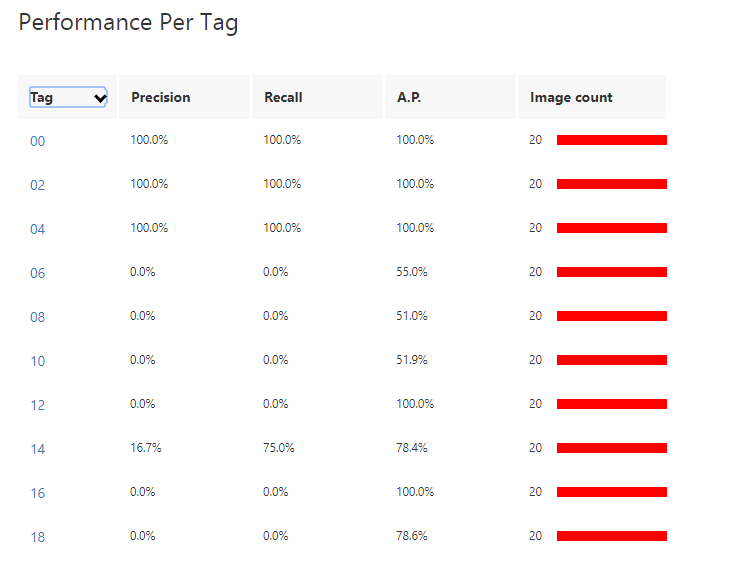

画像分類機ができました。今回の学習結果がこれです。正直よくないです。

- Precision(精度):正しかったと識別された分類の割合を示します。 たとえばあるモデルで、100 個の画像が犬として識別され、それらのうち 99 個が実際に犬であった場合、精度は 99% になります。

- Recall(再現率):正しく識別された実際の分類の割合を示します。 たとえば、実際にりんごである画像が 100 個あり、そのモデルで、80 個がりんごとして識別された場合、再現率は 80% になります。

- AP(Average Precision):閾値によって計算されたPrecisionの平均値。

※APは最近追加されたもので私も精度の平均くらいの認識しかないので、詳しい人がいれば教えてください。

一応Using the Custom Vision Service to Perform Image Classificationを見てなんとなくわかったようなわかってないようなという感じです。

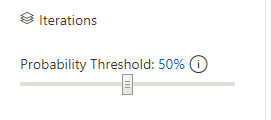

右上にあるこのスライダーは閾値で、左にスライドさせると値が小さくなり、右にスライドさせると値が大きくなります。これでPrecisionとRecallを調整できます。

| 区分 | 閾値との関係 | 閾値を上げたらどうなるか |

|---|---|---|

| Precision | 閾値を上げると上がる | 間違って分類されるものが減る。取りこぼしは増える |

| Recall | 閾値を下げると上がる | 取りこぼしは減る。間違って分類されるものも増える |

タグごとのパフォーマンスを見ると、湿度6~12%のタグについては0%でまったく検出できない状態のようです。

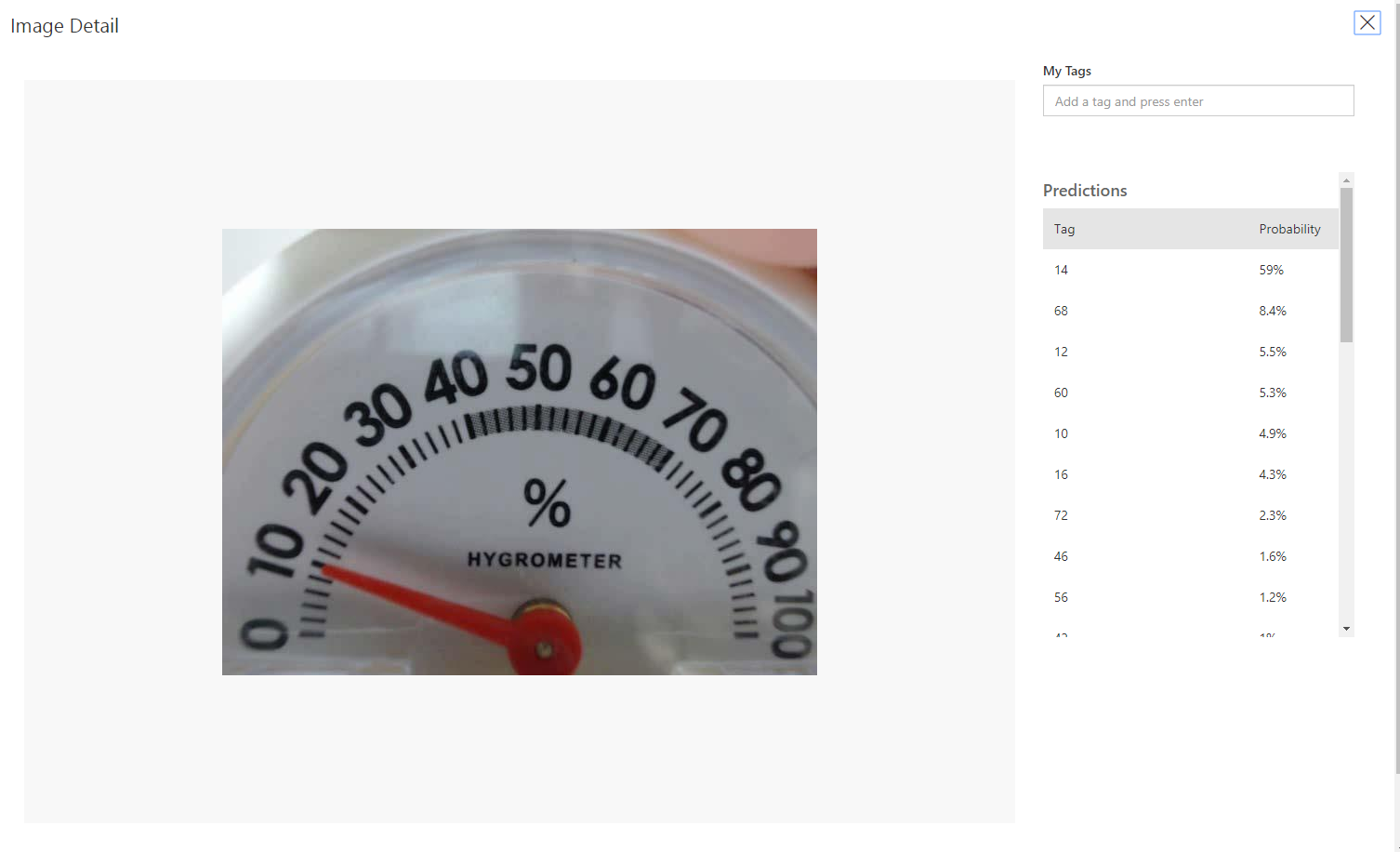

実際に湿度10%の画像をテストで読ませてみると、59%の確率で「湿度14%」だと判断しています。

湿度10%の画像を試しに10枚ちょっと追加して再度学習してみましたがこの程度では意味がなかったです。

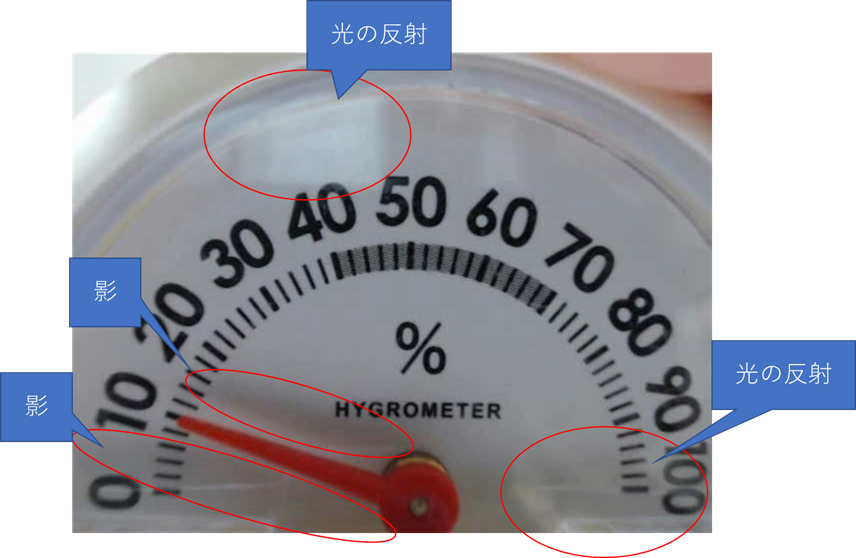

うまくいかない原因

画像処理やってる人はわかると思いますが、今回教師データに使用した画像は、このように影やプラスチックカバーの光の反射などノイズとなるものが含まれていて、学習にかけるにはあまりよろしくない状態です。

この手の画像処理では、白黒の2値化とか手法としてポピュラーなので、例えばこのようにモノクロビットマップにしてしまうと、カラーで見たときに針の影があった湿度14%あたりが黒くなっています。また、湿度0%~10%あたりまでは黒く塗りつぶされていてこれでは判断できません。

再学習

うまくいかない原因と思われる要素がこれだけとは限りませんが、少なくとも1つがわかったわけです。じゃあどうするのか?

画像分類は白黒にしてしまうとうまくいきやすいと言われているので、こうしてグレースケールを調整してこれくらいの画像にして再度教師データを用意するという手もありますが、今回は教師データを改めて用意することはしません。

Advanced Training

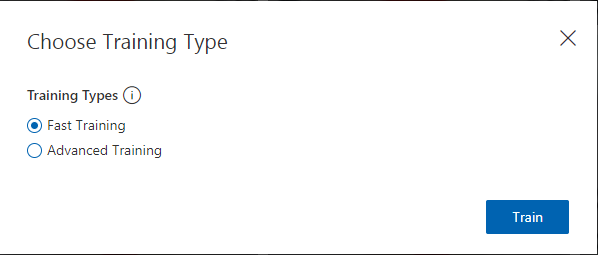

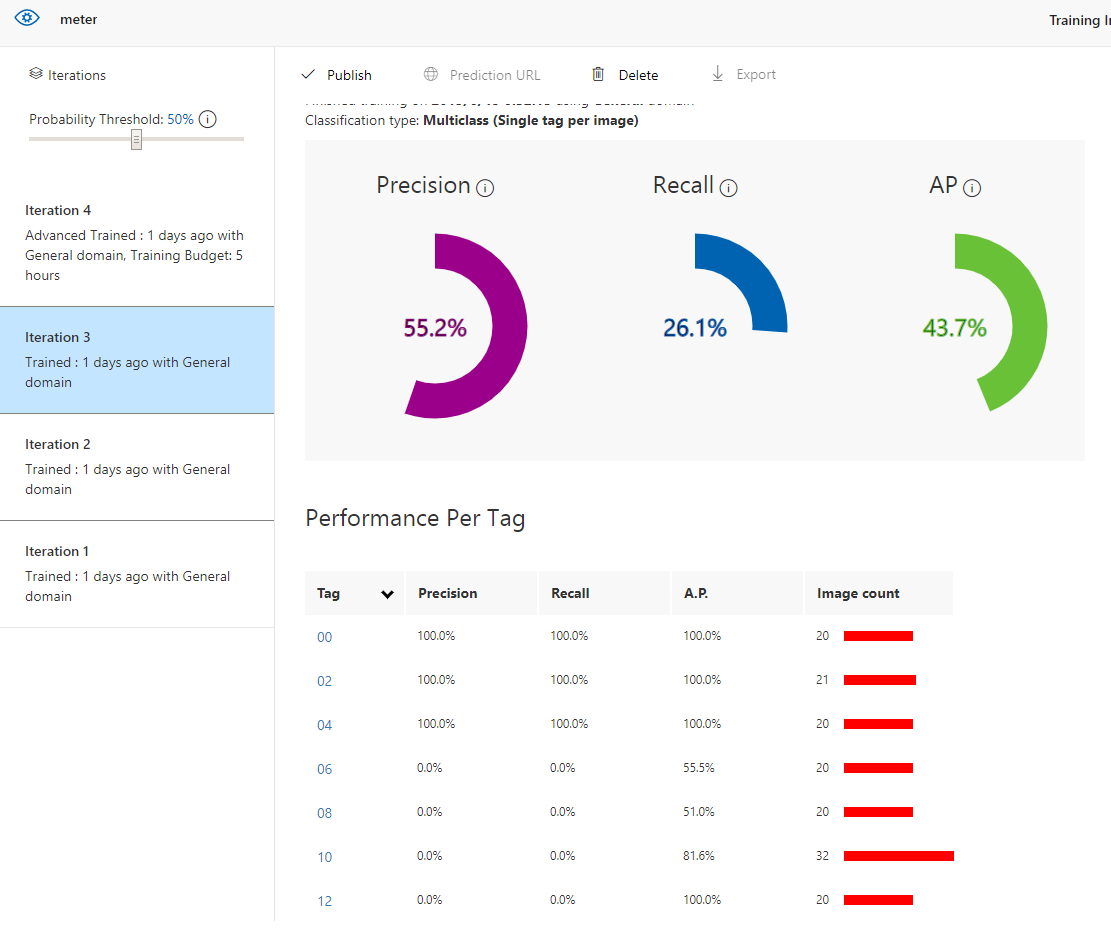

最初に学習する際は「Fast Training」を使いましたが、今度は「Advanced Training」を使用します。

これは1時間から最大で24時間まで1時間単位で学習時間を調整して学習にかけることができます。

今回は1時間を指定して学習します。ちなみにプランF0の場合、1か月最大で1時間の学習時間が無料枠として提供されています。今回はすでに何分か使用しているので、残りの時間をすべて学習時間につぎ込みます。トータル1時間になった時点で学習は強制的に完了になります。

プランS0の場合は1時間当たり2240円かかります。5時間やれば1万円ちょっとの料金です。1日回したら5万3千円ですね。ちなみに途中で止めることはできないようなので注意が必要です。(計算の途中でリソースを削除したら課金が止まるのかはわかりません)

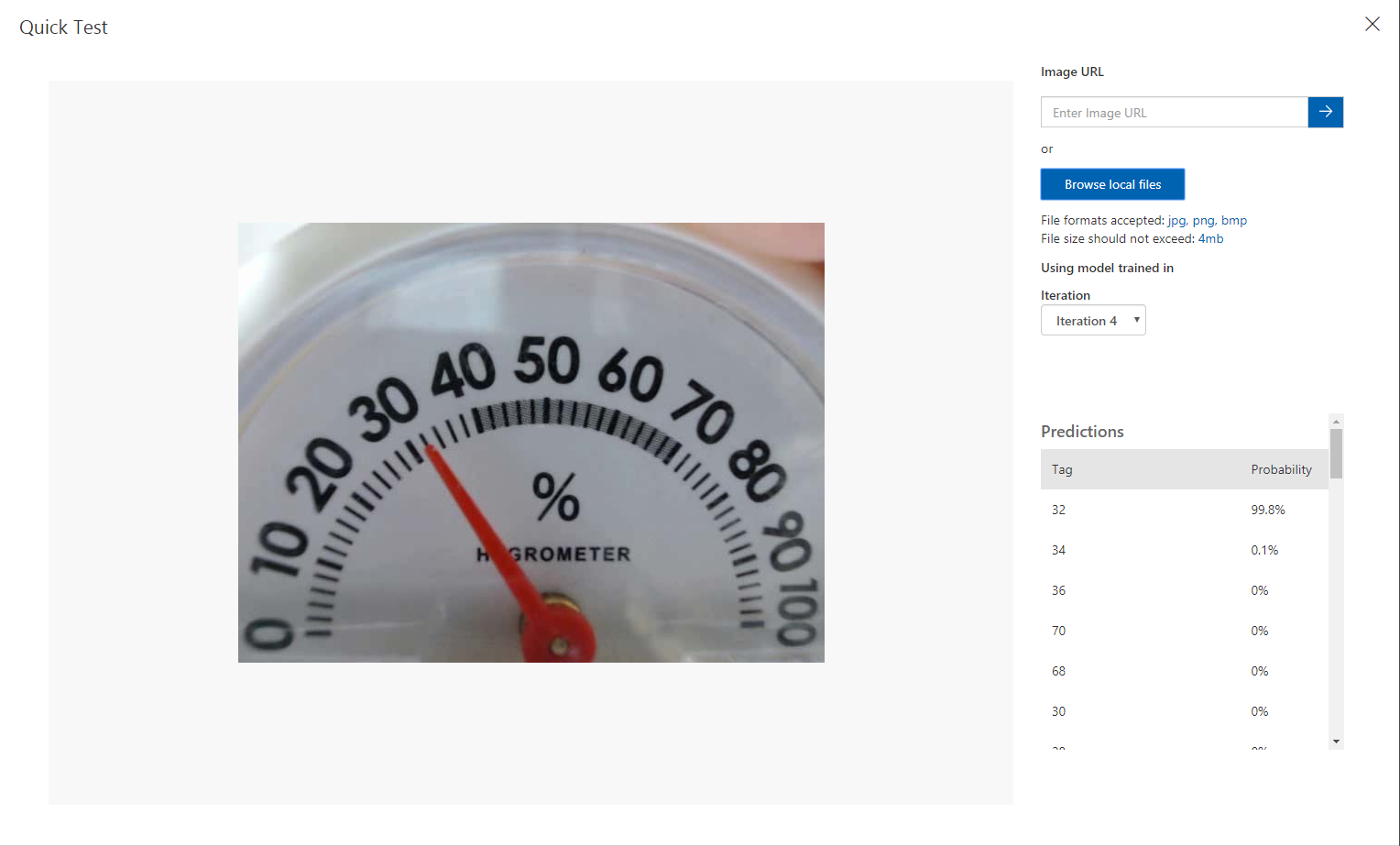

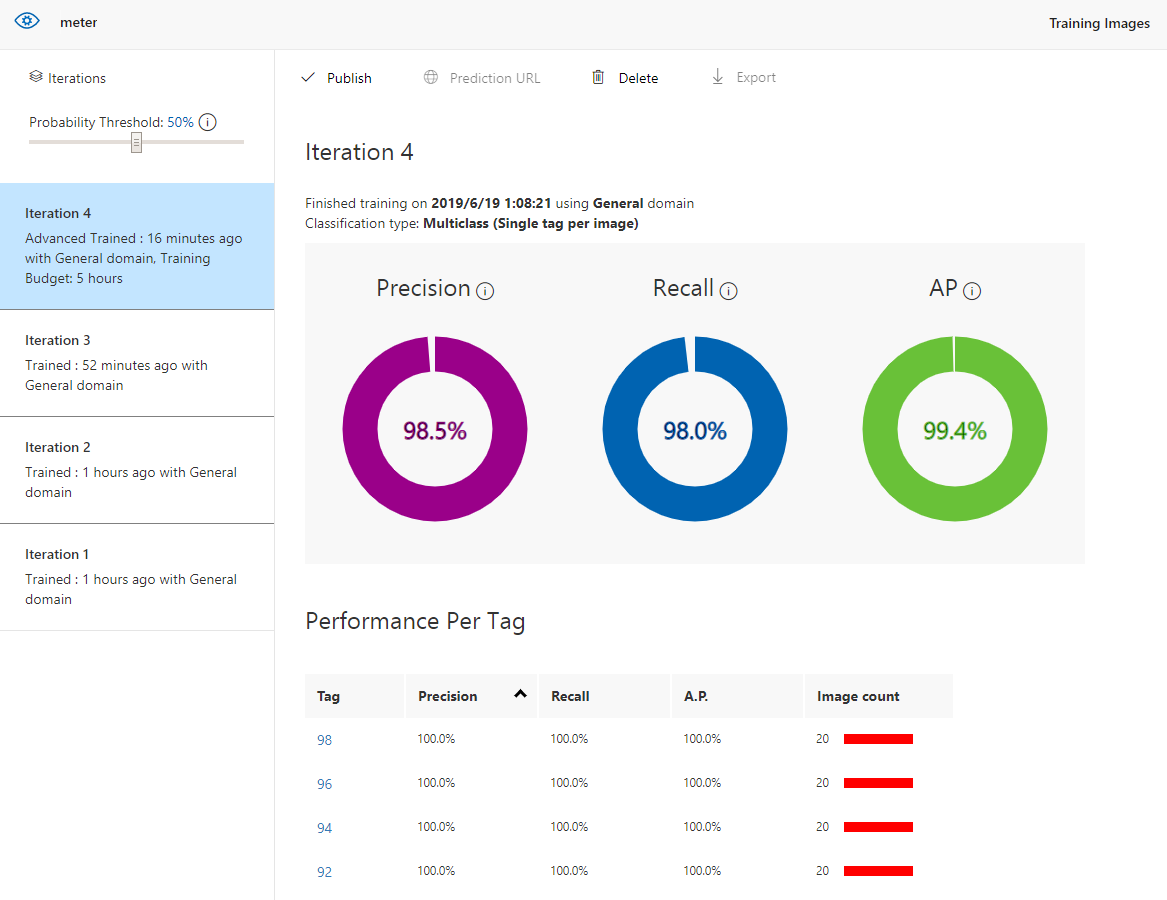

というわけで、1時間学習した結果がこちら。かなり良くなってますね。教師データは最初にアップロードした分でやってるので、2値化とかしたデータを与えたわけではないですよ。

ただ、内部的には回転を加えたり、位相をずらしたり、2値化したりと様々な分析関数にかけて、さらには都度パラメータの調整などもやっていると思われます。(ブラックボックス化されてるので正確なところはわかりません。推測です。)

逆に言えば、1分程度のFast Trainingではそれほど詳しくはやっていないということだと思います。

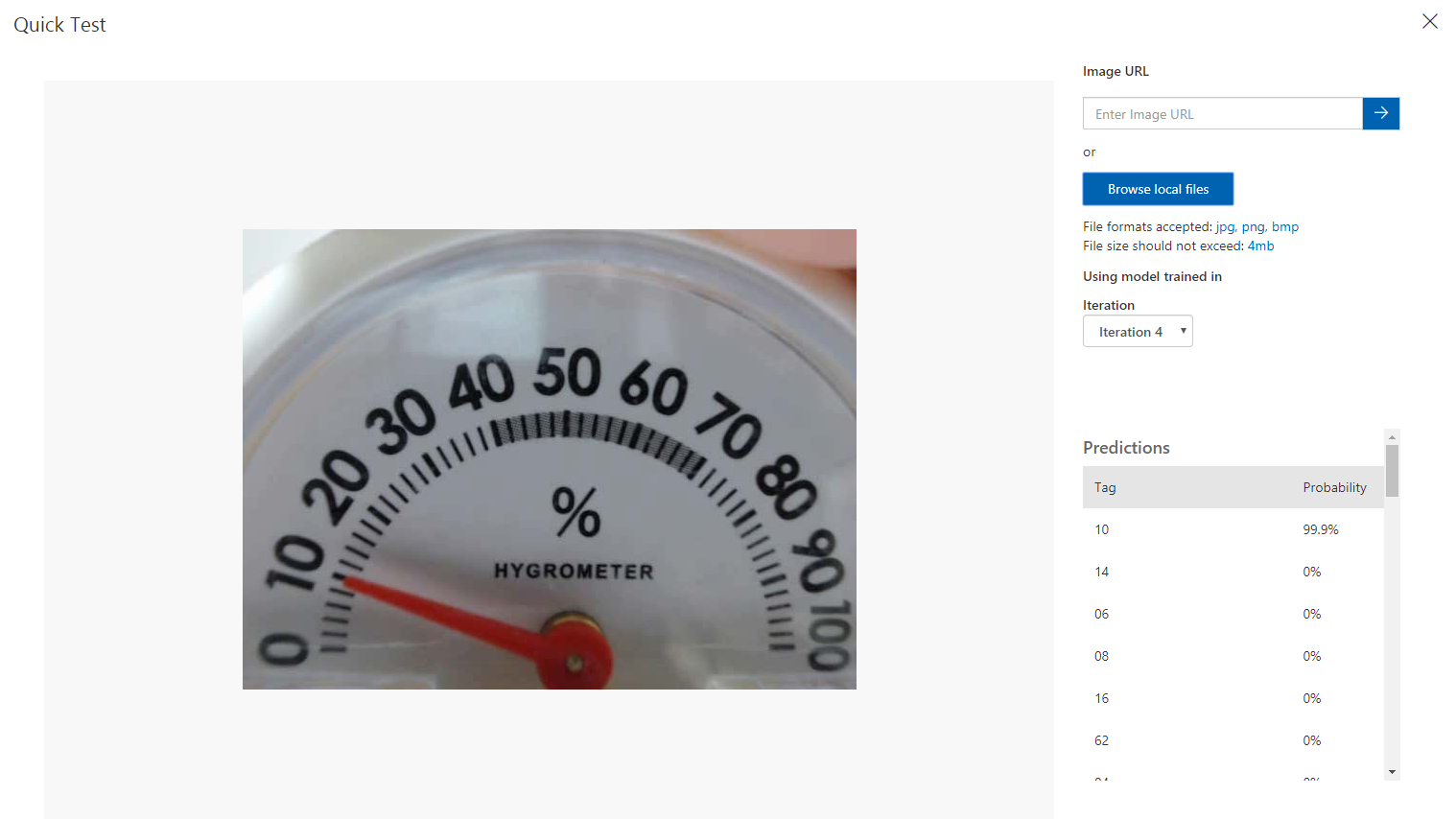

最初に「湿度14%」だと判断された画像は99.9%の確率で「湿度10%」だと判断していますね。正直劇的な改善だと思います。

アノテーションに時間がかかったとは言え、集中してやれば1日くらいやればアナログメータの読み取りは行けそうですね。類似のメータとしてはタコメータとかも行けそうですが、こういった電流計のように針の細いものでも大丈夫なのか試してみたいですね。

tensorflowとかを使って独自に開発というのも面白そうですが、こういたサービスを使うと大幅に時間が短縮できそうです。

特に、私のようにモデルを作ることよりも、そのモデルを使って何かをやることに重きを置いてる人間にはCognitive Servicesは最適だと思います。

教師データを作成する手順はどのみち必要なので、Customvisionがわずか1日くらいで検証できるのであれば、

- とりあえずCustomvisionを使ってやる

- どうやっても精度がいまいちなら自分でプログラミングする

という感じでやってみるのがよさそうですね。気軽にとりあえずやってみるというのは大事だと思いました。

あと独自で作るのはちょっと汎用性とかを持たせられそうなので、同じ推論モデルで類似のメータを読むこともできるかもしれません。汎用性を持たせようと思ったらハードルが一気に上がりそうなので、やっぱり専用で割り切ってさっと作ってしまうのが今はいいのかな。

ということで、湿度計の読み取りチャレンジでした。