飲食店情報検索システム 設計書(学習用)

🎓 学習目的のご注意

本設計書は、実際の本番運用を目的としたものではなく、若手エンジニアの学習を促進するための教材として作成されています。実際のプロジェクトでは、様々な制約条件やビジネス要件、法的要件などを考慮する必要があります。この設計書を通して、システム設計の基本的な考え方や技術選定の理由、実装のポイントを学んでいただくことを目的としています。

1. はじめに

📚 この章で学ぶこと

- 設計書の目的と対象読者について

- プロジェクトの背景と目的

- システムの全体像を把握する

🔑 重要な概念

- システム設計のゴールを明確にする

- ユーザーニーズを理解する

- システムの主要コンポーネントの概要を掴む

1.1 ドキュメントの目的

本ドキュメントは、飲食店情報検索システムの詳細な設計を記述するものです。

このドキュメントは、開発者(特に若手エンジニア)が理解しやすいよう工夫されており、システムの全体像から各コンポーネントの詳細までを説明しています。

学習目的として、システム設計のプロセスや考え方、技術選定の理由なども含め、実際の開発プロジェクトで役立つ知識を提供することを目指しています。

1.2 対象読者

- 開発チームメンバー(特に若手エンジニア)

- プログラミングの基礎知識はあるが、システム設計の経験が浅いエンジニア

- Web開発やデータ処理に興味のあるエンジニア

- プロジェクト管理者や技術リーダー

1.3 背景と目的

現在、飲食店情報は複数のウェブサイトに分散しており、ユーザーが総合的な情報を得るためには複数のサイトを閲覧する必要があります。

本システムは、これらの情報源からデータを自動的に収集し、統合された検索機能を提供することで、ユーザーの利便性を高めることを目的としています。

💡 学習ポイント

実際のプロジェクトでは、ビジネス要件を明確にすることが非常に重要です。なぜそのシステムが必要なのか、どのような問題を解決するのかを理解することで、適切な設計ができるようになります。

1.4 システム概要

本システムは以下の主要コンポーネントから構成されます:

-

データ収集バッチ:複数の情報源から飲食店データを自動的に収集するコンポーネント

- 学習レベル:中級 - API統合やデータ抽出の基本を理解している方向け

-

データストレージ:収集したデータを保存・検索するためのデータベース

- 学習レベル:基本〜中級 - RDBMSの基礎知識があれば理解可能

-

検索API:クライアントアプリケーションに検索機能を提供するAPIインターフェース

- 学習レベル:基本〜中級 - RESTful APIの基本を理解している方向け

-

モニタリング・管理機能:システムの状態監視と運用管理を行うコンポーネント

- 学習レベル:中級〜上級 - システム運用の知識がある方向け

📝 若手エンジニア向けメモ

システムは大きく分けると、「データを集める部分」「データを保存する部分」「データを提供する部分」「システムを監視する部分」の4つに分かれています。各部分の役割と相互関係を理解することが、システム設計の第一歩です。わからない用語があれば、用語集を参照してください。

1.5 学習のためのチェックポイント

- システムの目的と解決する問題を説明できる

- 4つの主要コンポーネントとその役割を説明できる

- なぜ複数の情報源からデータを収集する必要があるか理解している

- 各コンポーネントの学習レベルを確認し、自分の現在の知識レベルと比較できた

第2章:システムアーキテクチャ

📚 この章で学ぶこと

- システム全体の構成と各コンポーネントの関係

- 現代的なアーキテクチャパターンと選定基準

- 選定した技術スタックの概要

- データがシステム内をどのように流れるか

🔑 重要な概念

- アーキテクチャの分割方法

- クリーンアーキテクチャの原則

- 技術選定の考え方

- コンポーネント間の連携方法

2.1 アーキテクチャ概要

本システムは、バッチ処理とAPIサービスの2つの主要なサブシステムに分かれています。

バッチ処理はデータの収集と加工を担当し、APIサービスはクライアントからの検索リクエストを処理します。

データはリレーショナルデータベース(PostgreSQL)と検索に最適化されたNoSQLデータベース(Elasticsearch)の両方に保存されます。

💡 学習ポイント

多くのシステムでは、このように「データを収集・処理する部分」と「データを提供する部分」に分けて設計します。これにより、それぞれが独立して開発・運用できるようになります。

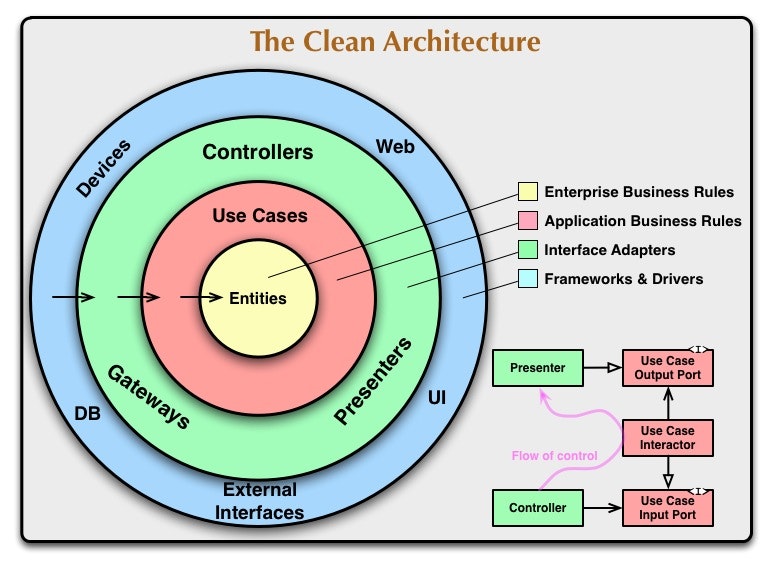

2.1.1 クリーンアーキテクチャの適用

本システムでは、ロバート・C・マーティンによって提唱されたクリーンアーキテクチャの原則を採用しています。これにより、ビジネスロジックを技術的な実装詳細から分離し、テスト容易性と保守性を向上させています。

クリーンアーキテクチャの主な特徴:

- 依存関係の方向:内側の層は外側の層を知らない(依存しない)

- 関心の分離:各層は特定の責務を持つ

- ビジネスルールの独立性:ビジネスロジックはフレームワークやUIから独立している

クリーンアーキテクチャの各層:

- エンティティ層:ビジネスの中核となるオブジェクトとルール

- ユースケース層:アプリケーション固有のビジネスルール

- インターフェースアダプター層:外部インターフェースとの連携

- フレームワーク・ドライバー層:データベース、UI、外部APIなどの技術的詳細

📝 若手エンジニア向けメモ

クリーンアーキテクチャは最初は複雑に感じるかもしれませんが、「依存関係は内側に向ける」という基本原則を覚えておくと理解しやすくなります。ビジネスロジックを中心に据え、そこから外側の技術的な詳細に向かって依存するようにします。

2.2 技術スタック

以下の表は、本システムで使用する主な技術とその選定理由の概要です。詳細な説明は6. 技術選定とその理由で行います。

| コンポーネント | 技術要素 | 選定理由(概要) | 若手エンジニア向け学習難易度 |

|---|---|---|---|

| プログラミング言語 | Python 3.10+ | 豊富なライブラリ、開発効率の高さ | ★★☆☆☆(比較的習得しやすい) |

| データ収集 | 各種Web API、データインポートツール | 公式APIを活用、安定性の確保 | ★★★☆☆(API認証やエラー処理の知識が必要) |

| データベース (一次保存) | PostgreSQL 14 | オープンソース、堅牢性、地理空間データ対応 | ★★★☆☆(SQL基礎知識が必要) |

| データベース (検索用) | Elasticsearch 8 | 全文検索、高速クエリ、スケーラビリティ | ★★★★☆(概念理解が必要) |

| API | FastAPI | 高性能、自動ドキュメント生成、非同期サポート | ★★☆☆☆(Pythonに慣れていれば習得しやすい) |

| キャッシュ | Redis | 高速インメモリキャッシュ、TTL管理の容易さ | ★★★☆☆(概念理解が必要) |

| 監視・ロギング | Prometheus, Grafana, ELK Stack | 業界標準、豊富な可視化オプション | ★★★★☆(設定やデータ分析の知識が必要) |

| インフラ | Docker, Kubernetes | コンテナ化、スケーラビリティ、環境一貫性 | ★★★☆☆(基礎概念の理解が必要) |

| CI/CD | GitHub Actions, Jenkins | 自動テスト、継続的デプロイメント | ★★★☆☆(パイプライン構築の知識が必要) |

📝 若手エンジニア向けメモ

全ての技術を最初から完璧に理解する必要はありません。「Python + FastAPI + PostgreSQL」の基本的な組み合わせから始めて、徐々に他の技術も学んでいくことをお勧めします。

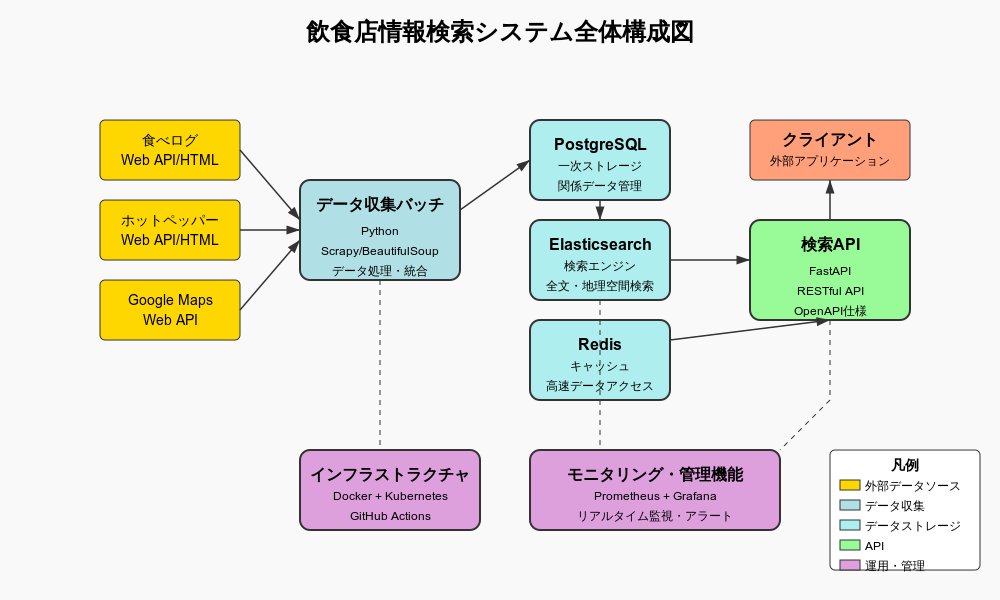

2.3 システム全体構成図

以下はシステム全体の構成図です。各コンポーネントの役割と関係性を示しています。

📋 図の補足説明

- データ収集バッチ:外部データソースからデータを定期的に収集します(左側)

- PostgreSQL:収集したデータの一次保存場所です(中央下)

- Elasticsearch:検索用にデータを最適化して保存します(中央下)

- FastAPI:クライアントからのリクエストを処理するAPIを提供します(中央)

- Redis:頻繁にアクセスされるデータをキャッシュします(中央)

- クライアント:システムを利用するユーザーインターフェースです(右側)

- 監視・管理:システム全体の状態を監視します(下部)

2.3.1 マイクロサービスvsモノリス

本システムでは、初期段階ではモノリシックなアーキテクチャを採用し、将来的にマイクロサービスへの移行を視野に入れた設計とします。この判断の理由は以下の通りです:

モノリシック構造の利点(初期段階):

- 開発の迅速性(サービス間通信の複雑さがない)

- デプロイとテストの単純さ

- チーム規模が小さい場合の適合性

- 全体の一貫性が保ちやすい

将来的なマイクロサービス化の方針:

- データ収集サービス(外部ソースとの連携)

- 検索APIサービス(ユーザー向けインターフェース)

- レコメンデーションサービス(パーソナライズ機能)

- ユーザー管理サービス(認証・認可)

💡 学習ポイント

アーキテクチャ選択は「トレードオフ」の問題です。マイクロサービスは柔軟性やスケーラビリティに優れていますが、運用の複雑さやオーバーヘッドも増加します。プロジェクトの規模、チーム構成、将来的な拡張性などを考慮して、適切なアーキテクチャを選択することが重要です。

2.4 システムコンポーネント詳細

2.4.1 データ収集バッチ

データ収集バッチは以下のサブコンポーネントで構成されます:

-

データソースモジュール:

- 各情報源に対応したデータ収集モジュール

- 共通の抽象クラス(DataSourceBase)を継承した実装

- 設定ファイルベースのデータソース定義

💡 学習ポイント

「抽象クラス」とは、共通の機能や構造を定義するための基本クラスです。これを継承することで、各データソース固有の実装が同じインターフェイスを持つようになり、コードの一貫性と再利用性が高まります。 -

バッチコア:

- スケジューラ:収集ジョブの実行スケジュールを管理

- ジョブマネージャ:実行中のジョブを管理し、状態を監視

- データプロセッサ:収集したデータの正規化と統合

-

データ取得ユーティリティ:

- API接続管理:APIキーと認証の管理

- スロットリング制御:API呼び出し頻度の最適化

- エラーハンドリング:一時的なエラーのリトライ処理

📝 若手エンジニア向けメモ

APIを利用する際は、各サービスの利用制限を遵守することが重要です。「リクエスト制御」はそのための仕組みで、一定時間に送るリクエスト数を制限します。また「リトライハンドラ」は一時的なエラーが発生した場合に自動的に再試行する仕組みです。

2.4.2 データストレージ

データストレージは以下のサブコンポーネントで構成されます:

-

一次ストレージ(PostgreSQL):

- 正規化されたデータモデル

- トランザクション整合性の確保

- 店舗、レビュー、施設情報などのリレーショナルデータ

💡 学習ポイント

「正規化」とは、データの重複を減らし、整合性を保つためにデータを整理する技術です。例えば、店舗と住所を別々のテーブルに分けることで、同じ住所を持つ複数の店舗があっても住所データが重複しないようにします。 -

検索用ストレージ(Elasticsearch):

- 全文検索に最適化されたインデックス

- 地理空間検索のためのgeoポイントデータ

- 複合クエリの高速処理

📝 若手エンジニア向けメモ

ElasticsearchはSQLデータベースとは異なり、「ドキュメント指向」のデータベースです。JSONのような形式でデータを保存し、複雑な検索条件や全文検索に強みがあります。 -

データ統合:

- 重複検出器:同一店舗の特定と統合

- データ正規化:住所、電話番号などのフォーマット統一

- データマイグレーター:PostgreSQLからElasticsearchへのデータ同期

-

キャッシュレイヤー(Redis):

- 人気検索クエリの結果キャッシュ

- セッション情報の一時保存

- レート制限の実装

💡 学習ポイント

「キャッシュ」とは、頻繁にアクセスされるデータを高速なストレージに一時的に保存する仕組みです。これにより、同じデータを何度も計算したり、データベースから取得したりする手間を省き、システム全体のパフォーマンスを向上させます。

2.4.3 検索API

検索APIは以下のサブコンポーネントで構成されます:

-

APIレイヤー:

- RESTコントローラ:HTTPリクエスト/レスポンスの処理

- 入力バリデーター:リクエストの検証

- レスポンスフォーマッター:JSONレスポンスの構築

📝 若手エンジニア向けメモ

「REST」とは、WebAPIの設計スタイルの一つで、URLとHTTPメソッド(GET/POST/PUT/DELETEなど)を使ってリソースを操作する方式です。例えば、GET /restaurants/123は店舗ID 123の情報を取得する操作を表します。 -

ビジネスロジック:

- 検索サービス:主要な検索ロジックの実装

- クエリビルダー:検索条件の構築

- フィルターサービス:検索結果のフィルタリング

-

データアクセス:

- Elasticsearch DAO:検索用データへのアクセス

- PostgreSQL DAO:詳細データの取得

- キャッシュマネージャ:キャッシュの管理

💡 学習ポイント

「DAO(Data Access Object)」とは、データベースへのアクセスを担当するオブジェクトです。これにより、ビジネスロジックとデータアクセスの責務を分離し、コードの保守性を高めることができます。

2.4.4 モニタリング・管理機能

モニタリング・管理機能は以下のサブコンポーネントで構成されます:

-

ロギングシステム:

- ログコレクター:各コンポーネントからのログ収集

- ログ分析:ログの集計と分析

-

メトリクスシステム:

- メトリクスコレクター:システム指標の収集

- ダッシュボード:リアルタイムな状態可視化

📝 若手エンジニア向けメモ

「メトリクス」とは、システムの状態を数値化した指標のことです。例えば、「1分あたりのリクエスト数」「平均応答時間」「エラー率」などがあります。これらを監視することで、システムの健全性を確認できます。 -

アラートシステム:

- アラートルール:異常検知のためのルール定義

- 通知サービス:管理者への通知

-

管理UI:

- システム状態:システム全体の状態確認

- ジョブ制御:バッチジョブの管理

- 設定管理:システム設定の変更

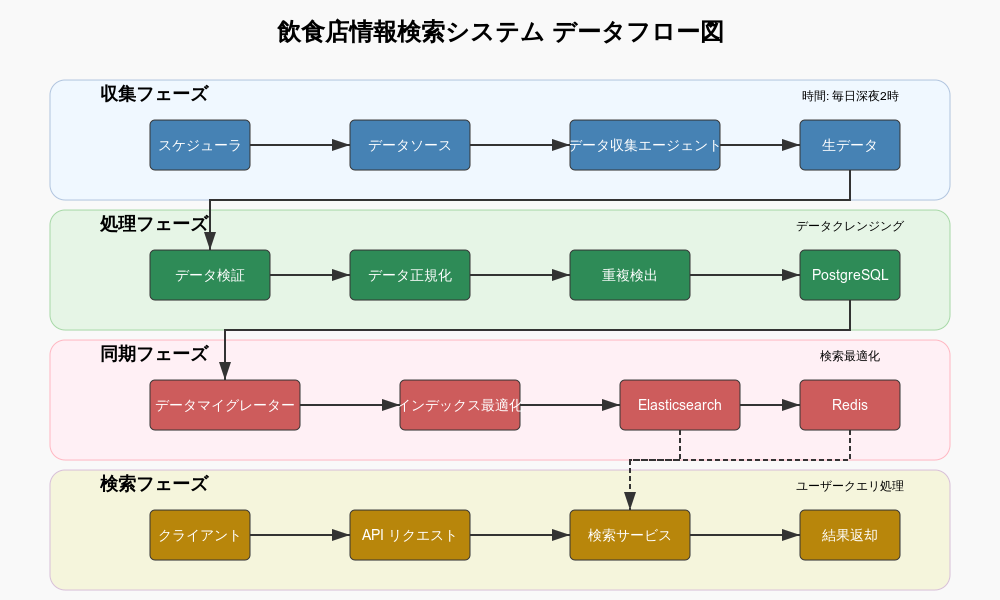

2.5 データフロー

データがシステム内でどのように流れるかを説明します。

(注: 実際の画像はプロジェクトに合わせて作成してください)

-

収集フェーズ:

- スケジューラがジョブを開始

- 各データソースからデータを収集

- 収集したデータをデータプロセッサに送信

💡 学習ポイント

バッチ処理は定期的に(例:毎日深夜)実行され、最新のデータを収集します。公式APIがある場合はそれを利用し、効率的にデータを取得します。 -

処理フェーズ:

- データプロセッサがデータを検証、正規化

- 重複検出器が同一店舗を特定

- 正規化されたデータを一次ストレージに保存

📝 若手エンジニア向けメモ

同じ店舗が異なるソースに掲載されている場合があります。「重複検出」では、店名や住所、電話番号などから同一店舗を特定し、情報を統合します。 -

同期フェーズ:

- データマイグレーターが一次ストレージから検索用ストレージにデータを同期

- インデックスの最適化と更新

💡 学習ポイント

PostgreSQLとElasticsearchで同じデータを保持しますが、形式は異なります。PostgreSQLは関係性を重視し、Elasticsearchは検索速度を重視した形式です。 -

検索フェーズ:

- クライアントからの検索リクエストをAPIが受信

- 検索サービスがクエリを構築

- Elasticsearchで検索を実行

- 結果をフォーマットしてクライアントに返却

📝 若手エンジニア向けメモ

検索リクエストは、まずRedisキャッシュをチェックし、キャッシュにない場合はElasticsearchで検索を行います。これにより、同じ検索が繰り返された場合の応答速度が向上します。

2.6 API設計アプローチ

2.6.1 APIファーストアプローチ

本システムはAPIファーストアプローチを採用しています。これは、実装の前にAPI設計を行い、それを中心に開発を進める方法です。

APIファーストの利点:

- フロントエンドとバックエンドの並行開発が可能

- API仕様書がコントラクトとなり、チーム間の認識齟齬を減少

- モックサーバーを使った早期テストが可能

- クライアント開発者にとって予測可能なインターフェース

採用ツール:

- OpenAPI (Swagger) 仕様によるAPI定義

- FastAPIによる自動ドキュメント生成とバリデーション

💡 学習ポイント

APIファーストアプローチでは、「何をどのように提供するか」を先に決めることで、開発の方向性が明確になります。また、API仕様はチーム間のコミュニケーションツールとしても機能します。

2.6.2 RESTful APIデザイン原則

APIはRESTful原則に従って設計されています:

-

リソース指向:

- URLはリソース(名詞)を表す(例:

/restaurants) - HTTPメソッドで操作を表現(GET:取得、POST:作成など)

- URLはリソース(名詞)を表す(例:

-

階層構造:

- リソース間の関係をURLで表現(例:

/restaurants/{id}/reviews)

- リソース間の関係をURLで表現(例:

-

ステートレス:

- リクエスト間で状態を保持しない

- 必要な情報は全てリクエストに含める

-

統一インターフェース:

- 一貫したリソース識別子(URL)

- 適切なHTTPステータスコード

- HAL+JSONによるハイパーメディア

2.7 若手エンジニア向け解説:システム設計のポイント

システム設計を行う際の重要なポイントをいくつか紹介します:

-

責務の分離:

- 各コンポーネントは明確な役割を持ち、その責務に集中するべきです

- 例:データ収集バッチはデータの収集と加工に専念し、検索機能は持ちません

-

疎結合と高凝集:

- コンポーネント間は疎結合(依存関係が少ない)であるべき

- 各コンポーネント内は高凝集(関連する機能が集まっている)であるべき

- これにより、変更の影響範囲を限定し、保守性を高めることができます

-

段階的な設計と実装:

- 全ての機能を一度に実装するのではなく、核となる機能から段階的に実装

- 例:まず基本的な検索機能を実装し、その後フィルタリングやソート機能を追加

-

柔軟性と拡張性:

- 将来の要件変更や機能追加に対応できる柔軟な設計を心がける

- 例:新しいデータソースの追加が容易な設計にする

-

アーキテクチャ決定記録(ADR)の活用:

- 重要な設計決定とその理由を文書化する

- 後から「なぜこの技術/アプローチを選んだのか」が分かるようにする

🔍 チェックポイント

- システムの主要コンポーネントとその役割を説明できる

- データがシステム内をどのように流れるか理解している

- 各コンポーネント間の関係性を説明できる

- システム設計の基本的なポイントを理解している

- クリーンアーキテクチャの基本原則を説明できる

第3章:クラス設計

📚 この章で学ぶこと

- オブジェクト指向設計の基本と適用方法

- 設計パターンの実践的な活用

- クラス図の読み方と活用方法

- データ収集と検索APIの主要クラスの設計

🔑 重要な概念

- クラスの責務とカプセル化

- 継承と抽象クラスの活用

- インターフェースと実装の分離

- デザインパターンの適用

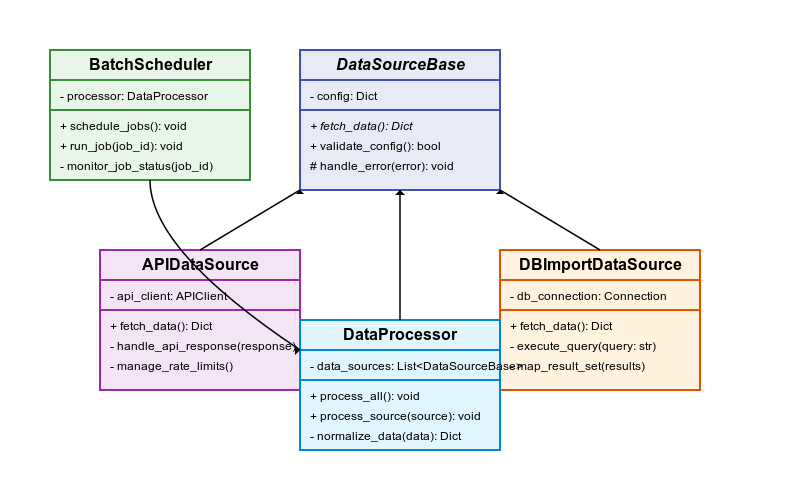

3.1 データ収集バッチのクラス図

以下はデータ収集バッチの主要クラスを示すクラス図です。

📋 クラス図の読み方

- 各ボックスは1つのクラスを表しています

- 上部にクラス名、中部に属性(変数)、下部に**操作(メソッド)**が記載されています

- 線は関係性を表し、矢印は継承や参照の方向を示しています

- 実線の矢印は「継承」、点線の矢印は「実装」または「依存」を表します

3.1.1 主要クラスの説明

DataSourceBase(抽象基底クラス)

- すべてのデータソース実装の基底クラス

- 抽象メソッド

fetch_data()を定義 - 共通の設定とエラーハンドリングを実装

APIDataSource

- API経由でデータを取得するデータソースの実装

- 認証やレート制限の管理を担当

- サブクラスでさらに特化した実装を提供

DBImportDataSource

- データベースインポート用のデータソース

- 外部データベースからのデータ取得機能

- トランザクション管理と整合性確保の仕組み

DataProcessor

- 収集したデータの処理と変換を担当

- データのクレンジングと正規化を実施

- 重複検出と統合のロジックを実装

BatchScheduler

- バッチジョブのスケジューリングを管理

- 各ジョブの依存関係とスケジュールを定義

- ジョブの実行状態を監視

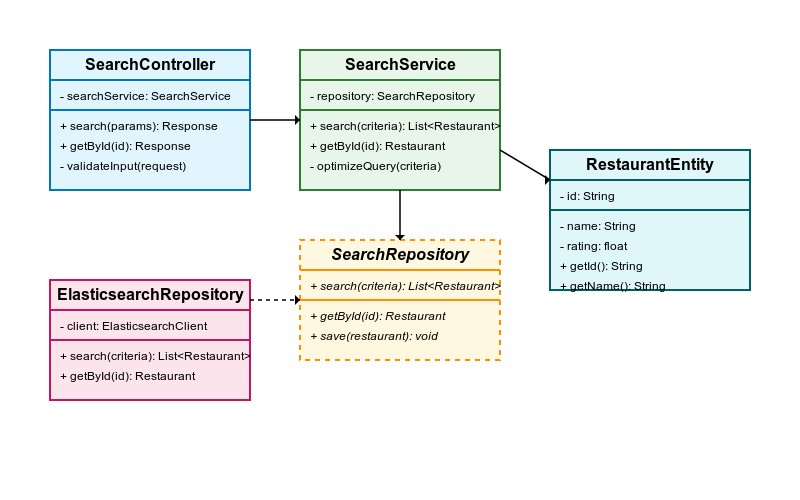

3.2 検索APIのクラス図

以下は検索APIの主要クラスを示すクラス図です。

3.2.1 主要クラスの説明

SearchController

- クライアントからのHTTPリクエストを処理

- 入力パラメータのバリデーションを実施

- ビジネスロジック層へのリクエスト転送

- レスポンスの整形と返却

SearchService

- 検索のビジネスロジックを実装

- 検索条件の解析と最適化

- 適切なリポジトリの選択とクエリ実行

- 結果のフィルタリングと加工

SearchRepository(インターフェース)

- 検索データアクセスのための抽象インターフェース

- 検索実装の詳細を隠蔽

- テスト容易性を向上させる設計

ElasticsearchRepository

- SearchRepositoryインターフェースの実装

- Elasticsearchに対する具体的なクエリ実行

- クエリビルダーパターンの活用

RestaurantEntity

- ドメインモデルとしての飲食店エンティティ

- ビジネスルールとバリデーションの実装

- 不変条件の保証

3.3 適用したデザインパターン

本システムでは、以下のデザインパターンを活用しています:

3.3.1 リポジトリパターン

データアクセスの詳細を抽象化し、ドメインロジックに集中できるようにするパターンです。

# リポジトリインターフェース

class RestaurantRepository(ABC):

@abstractmethod

def find_by_id(self, id: str) -> Optional[Restaurant]:

pass

@abstractmethod

def search(self, criteria: SearchCriteria) -> List[Restaurant]:

pass

@abstractmethod

def save(self, restaurant: Restaurant) -> str:

pass

# 具体的な実装

class PostgresRestaurantRepository(RestaurantRepository):

def __init__(self, db_session: Session):

self.db_session = db_session

def find_by_id(self, id: str) -> Optional[Restaurant]:

db_restaurant = self.db_session.query(RestaurantModel).get(id)

if not db_restaurant:

return None

return self._map_to_entity(db_restaurant)

# 他のメソッド実装...

💡 学習ポイント

リポジトリパターンを使用することで、データの永続化方法を変更しても、ビジネスロジックを変更する必要がなくなります。例えば、PostgreSQLからMongoDBに変更する場合でも、新しいリポジトリ実装を作成するだけで済みます。

3.3.2 ファクトリーパターン

オブジェクトの生成ロジックを集約し、インスタンス生成の詳細を隠蔽するパターンです。

class DataSourceFactory:

@staticmethod

def create_data_source(source_type: str, config: Dict) -> DataSourceBase:

if source_type == "api":

return APIDataSource(config)

elif source_type == "db_import":

return DBImportDataSource(config)

elif source_type == "file_import":

return FileImportDataSource(config)

else:

raise ValueError(f"Unknown data source type: {source_type}")

📝 若手エンジニア向けメモ

ファクトリーパターンは、「どのように作るか」という詳細を隠蔽し、「何を作るか」に集中できるようにします。これにより、オブジェクト生成の複雑さを管理しやすくなります。

3.3.3 ストラテジーパターン

アルゴリズムをカプセル化し、実行時に切り替え可能にするパターンです。

# 戦略インターフェース

class SearchStrategy(ABC):

@abstractmethod

def search(self, query: str, filters: Dict) -> List[Dict]:

pass

# 具体的な戦略

class KeywordSearchStrategy(SearchStrategy):

def search(self, query: str, filters: Dict) -> List[Dict]:

# キーワードベースの検索実装

return keyword_based_search(query, filters)

class SemanticSearchStrategy(SearchStrategy):

def search(self, query: str, filters: Dict) -> List[Dict]:

# 意味ベースの検索実装

return semantic_based_search(query, filters)

# コンテキスト

class SearchEngine:

def __init__(self, strategy: SearchStrategy):

self.strategy = strategy

def set_strategy(self, strategy: SearchStrategy):

self.strategy = strategy

def execute_search(self, query: str, filters: Dict) -> List[Dict]:

return self.strategy.search(query, filters)

💡 学習ポイント

ストラテジーパターンを使用することで、検索アルゴリズムを実行時に切り替えることができます。例えば、単純なキーワード検索から、より高度な意味解析による検索に切り替えることが容易になります。

3.3.4 オブザーバーパターン

オブジェクト間の一対多の依存関係を定義し、あるオブジェクトの状態が変化した際に、依存するオブジェクトに通知するパターンです。

# オブザーバーインターフェース

class JobObserver(ABC):

@abstractmethod

def update(self, job_id: str, status: str, details: Dict):

pass

# 具体的なオブザーバー

class JobLogger(JobObserver):

def update(self, job_id: str, status: str, details: Dict):

log_entry = f"Job {job_id} status changed to {status}: {details}"

logger.info(log_entry)

class JobNotifier(JobObserver):

def update(self, job_id: str, status: str, details: Dict):

if status == "failed":

send_alert(f"Job {job_id} failed", details)

# 被観測者

class BatchJob:

def __init__(self, job_id: str):

self.job_id = job_id

self.status = "pending"

self.observers = []

def add_observer(self, observer: JobObserver):

self.observers.append(observer)

def remove_observer(self, observer: JobObserver):

self.observers.remove(observer)

def set_status(self, status: str, details: Dict = None):

self.status = status

self._notify_observers(details or {})

def _notify_observers(self, details: Dict):

for observer in self.observers:

observer.update(self.job_id, self.status, details)

📝 若手エンジニア向けメモ

オブザーバーパターンは、コンポーネント間の疎結合を実現するのに役立ちます。例えば、バッチジョブの状態変化を監視して、ログ記録、メール通知、ダッシュボード更新など、複数のアクションを実行したい場合に適しています。

3.4 関数型プログラミングの活用

本システムでは、オブジェクト指向だけでなく関数型プログラミングの概念も取り入れています。特にデータ処理パイプラインでは関数型アプローチが効果的です。

3.4.1 純粋関数

副作用のない関数を作成することで、テスト容易性と可読性を向上させています。

def normalize_address(address: str) -> str:

"""住所を正規化する純粋関数"""

# 外部状態に依存せず、同じ入力に対して常に同じ出力を返す

normalized = address.strip().upper()

# 都道府県名の統一

for pref_pattern, replacement in PREFECTURE_PATTERNS:

if pref_pattern.search(normalized):

normalized = pref_pattern.sub(replacement, normalized)

break

return normalized

3.4.2 関数合成

小さな関数を組み合わせて複雑な処理を構築します。

# 小さな関数

def extract_price_text(html_fragment: str) -> str:

"""HTMLから価格テキストを抽出"""

price_pattern = re.compile(r'(\d{1,3}(,\d{3})*円)')

match = price_pattern.search(html_fragment)

return match.group(1) if match else ""

def clean_price_text(price_text: str) -> str:

"""価格テキストから数字以外を除去"""

return re.sub(r'[^\d]', '', price_text)

def parse_price(price_str: str) -> Optional[int]:

"""文字列を整数価格に変換"""

try:

return int(price_str) if price_str else None

except ValueError:

return None

# 関数合成

def extract_price(html_fragment: str) -> Optional[int]:

"""HTMLから価格を抽出して整数に変換"""

return pipe(

html_fragment,

extract_price_text,

clean_price_text,

parse_price

)

💡 学習ポイント

関数型プログラミングでは、「何をするか」に焦点を当て、「どのように状態を変更するか」ではなく「どのように値を変換するか」を考えます。これにより、コードの予測可能性と再利用性が向上します。

3.4.3 高階関数

関数を引数として受け取ったり、関数を返したりする関数を活用します。

def filter_restaurants(restaurants: List[Restaurant],

predicate: Callable[[Restaurant], bool]) -> List[Restaurant]:

"""条件に合致するレストランをフィルタリング"""

return [r for r in restaurants if predicate(r)]

# 使用例

open_restaurants = filter_restaurants(

all_restaurants,

lambda r: r.is_open(current_time)

)

high_rated_restaurants = filter_restaurants(

all_restaurants,

lambda r: r.rating >= 4.0

)

3.5 若手エンジニア向け解説:クラス設計の基本

3.5.1 オブジェクト指向設計の基本原則

-

単一責任の原則(SRP):

- 一つのクラスは一つの責任を持つべき

- 例:

APIDataSourceはAPI経由のデータ取得のみを担当

💡 学習ポイント

クラスが複数の責任を持つと、一つの責任に関する変更が他の責任にも影響を与える可能性があります。責任を分離することで、変更の影響範囲を限定できます。 -

開放/閉鎖の原則(OCP):

- クラスは拡張に対して開かれ、修正に対して閉じられているべき

- 例:新しいデータソースを追加する場合、既存のコードを修正せずに

DataSourceBaseを継承した新クラスを追加するだけでよい

-

リスコフの置換原則(LSP):

- サブクラスはそのスーパークラスの代わりに使えるべき

- 例:

APIDataSourceやDBImportDataSourceは、DataSourceBase型の変数に代入して使用できる

-

インターフェイス分離の原則(ISP):

- クライアントは自分が使わないインターフェイスに依存すべきでない

- 例:検索サービスは検索機能のみを提供するインターフェイスを持つ

-

依存性逆転の原則(DIP):

- 高レベルモジュールは低レベルモジュールに依存すべきでない

- 例:検索サービスはElasticsearch具体実装ではなく、検索インターフェイスに依存する

3.5.2 クラス設計の実践ポイント

-

抽象クラスとインターフェイスの使い分け:

- 抽象クラス:いくつかの実装を含み、共通の機能を提供する場合

- インターフェイス:実装を含まず、単にメソッドの契約を定義する場合

📝 若手エンジニア向けメモ

Pythonでは、abcモジュールを使って抽象クラスを定義します。@abstractmethodデコレータで抽象メソッドを指定することで、サブクラスでの実装を強制できます。 -

依存性注入の活用:

- クラス内部で依存オブジェクトを直接生成せず、外部から注入する

- これにより、テストや機能拡張が容易になる

# 良くない例 class SearchService: def __init__(self): self.repository = ElasticsearchRepository() # 直接依存 # 良い例 class SearchService: def __init__(self, repository: SearchRepository): self.repository = repository # 依存を注入 -

適切な粒度でのクラス分割:

- 大きすぎるクラスは責任が多くなり、理解や保守が難しくなる

- 小さすぎるクラスは過度に複雑になる可能性がある

- 機能的なまとまりを考慮して適切な粒度を決定する

-

継承よりコンポジション:

- 継承は「is-a」関係(サブクラスはスーパークラスの一種)を表現

- コンポジションは「has-a」関係(クラスが他のクラスのインスタンスを持つ)を表現

- 多くの場合、継承よりもコンポジションの方が柔軟性が高い

💡 学習ポイント

例えば、SearchServiceが検索リポジトリを継承するのではなく、検索リポジトリのインスタンスを持つ(コンポジション)方が、後から検索リポジトリを入れ替えやすくなります。

3.5.3 効果的なクラス設計のためのTIPS

-

役割・責任・協調(RRC)モデル:

- 各クラスの役割(Role)を明確にする

- 各クラスの責任(Responsibility)を定義する

- クラス間の協調(Collaboration)方法を設計する

-

テスト駆動開発(TDD)の活用:

- テストを先に書くことで、使いやすいインターフェースを設計できる

- コードの品質と保守性が向上する

-

ドメイン駆動設計(DDD)の考慮:

- ユビキタス言語の採用(コードとビジネス用語の一致)

- ドメインモデルの適切な境界設定

- ドメイン知識のコードへの反映

🔍 チェックポイント

- オブジェクト指向設計の基本原則を説明できる

- クラス図の基本的な読み方を理解している

- データ収集バッチと検索APIの主要クラスとその関係を説明できる

- 適切なクラス設計の実践ポイントを理解している

- デザインパターンの基本的な適用方法を理解している

第4章:機能要件

📚 この章で学ぶこと

- システムが提供すべき具体的な機能

- 各機能の詳細仕様と実装方針

- 機能要件の考え方と記述方法

- ユーザーストーリーとジョブストーリーの作成方法

🔑 重要な概念

- 機能要件の抽出と優先順位付け

- 機能の詳細化と仕様の記述

- 各機能間の関連性と依存関係

- ユーザー中心設計(UCD)の考え方

4.1 データ収集機能

4.1.1 データ収集対象

以下の情報源からデータを収集します:

-

公式Web API(必須):

- 飲食店情報API

- 地図サービスAPI

- ユーザーレビューAPI

- 予約情報API

-

データベースインポート(必須):

- 飲食店マスターデータ

- 地域情報データ

- 営業時間データ

-

定期データフィード(オプション):

- 飲食店情報CSVフィード

- メニュー情報XMLフィード

- 特典情報JSONフィード

💡 学習ポイント

実際のプロジェクトでは、情報源の信頼性とデータの質を重視します。可能な限り公式に提供されているAPIやデータフィードを利用することで、安定した品質のデータを取得できます。

4.1.2 収集データ項目

以下のデータ項目を収集します:

-

基本情報:

- 店名(必須)

- 住所(必須)

- 電話番号

- 営業時間

- 定休日

- 公式サイトURL

-

料理情報:

- 料理ジャンル(必須)

- 価格帯

- メニュー情報(可能な場合)

- 支払い方法

-

評価情報:

- 総合評価(星評価など)

- レビュー数

- 個別レビュー(最新10件程度)

-

施設情報:

- 座席数

- 個室有無

- 禁煙/喫煙情報

- 駐車場有無

- Wi-Fi有無

- その他設備情報

-

メタデータ:

- データソース(収集元)

- 最終更新日時

- ソースURL

- 信頼性スコア

📝 若手エンジニア向けメモ

収集項目を明確に定義することで、データ構造の設計がしやすくなります。また、必須項目と任意項目を区別することで、データの整合性を保ちやすくなります。

4.1.3 収集スケジュール

データ収集は以下のスケジュールで実行されます:

- 基本実行頻度:毎日深夜2:00

- 差分更新方式:前回からの変更データのみを検出して更新

- 初回実行:全データの初期収集(時間がかかるため週末に実行)

- 手動実行:管理UIからの手動トリガーも可能

💡 学習ポイント

バッチ処理は、深夜など負荷の少ない時間帯に実行するのが一般的です。また、毎回全データを収集するのではなく、差分更新を行うことで効率化できます。

4.1.4 ロバストネス要件

データ収集の安定性を確保するための機能:

-

エラーハンドリング:

- 一時的なエラーの自動リトライ

- 指数バックオフアルゴリズム

- 永続的なエラーの記録と通知

-

APIクライアント:

- レート制限の遵守

- アクセストークンの管理

- エラーレスポンスの適切な処理

4.2 データ処理・ストレージ機能

4.2.1 データ検証と正規化

収集したデータに対して以下の処理を行います:

-

データ検証:

- スキーマ検証

- 必須項目の確認

- データ型チェック

- 異常値検出

📝 若手エンジニア向けメモ

データ検証は、不正なデータがシステムに入り込むのを防ぐ最初の防衛線です。例えば、電話番号が数字とハイフンのみで構成されているか、郵便番号が正しい形式かなどをチェックします。 -

データ正規化:

- 住所の正規化(都道府県、市区町村、番地などの分離)

- 電話番号の正規化(ハイフン統一など)

- 営業時間の構造化(開始時間、終了時間の分離)

- 料理ジャンルの標準化(サイト間での表記揺れ対応)

💡 学習ポイント

異なるソースから収集したデータは、同じ情報でも表記が異なる場合があります。例えば、「イタリアン」と「イタリア料理」は同じカテゴリを指しますが、表記が違います。これらを統一することで、検索や集計が正確になります。

4.2.2 重複検出と統合

同一店舗の特定と情報統合のための処理:

-

重複検出アルゴリズム:

- 店名の類似度計算(レーベンシュタイン距離など)

- 位置情報の近接性評価(地理的距離)

- 電話番号の一致確認

- 複合スコアリングによる判定

📝 若手エンジニア向けメモ

レーベンシュタイン距離とは、2つの文字列がどれだけ似ているかを数値化する方法の一つです。例えば、「すし太郎」と「寿司太郎」は表記は違いますが、類似度が高いと判断できます。 -

情報統合ルール:

- 情報源の信頼性による優先順位付け

- 最新データの優先

- 詳細度の高いデータの優先

- 矛盾するデータの解決戦略

💡 学習ポイント

同一店舗の情報を統合する際は、単純にデータを結合するだけでなく、どの情報を優先するかのルールが必要です。例えば、公式サイトからの情報は口コミサイトからの情報より優先するなどの判断基準を設けます。

4.2.3 データベーススキーマ

PostgreSQL(一次ストレージ):

restaurants テーブル(店舗情報)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意の店舗ID |

| name | VARCHAR(255) | NOT NULL | 店舗名 |

| address_id | INTEGER | FOREIGN KEY | 住所ID(addresses テーブル参照) |

| phone | VARCHAR(20) | NULL | 電話番号 |

| website | VARCHAR(255) | NULL | 公式サイトURL |

| rating | DECIMAL(3,1) | NULL | 総合評価スコア |

| price_range | VARCHAR(20) | NULL | 価格帯 |

| created_at | TIMESTAMP | DEFAULT CURRENT_TIMESTAMP | レコード作成日時 |

| updated_at | TIMESTAMP | DEFAULT CURRENT_TIMESTAMP | レコード最終更新日時 |

addresses テーブル(住所情報)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意の住所ID |

| prefecture | VARCHAR(20) | NOT NULL | 都道府県 |

| city | VARCHAR(50) | NOT NULL | 市区町村 |

| district | VARCHAR(50) | NULL | 地区・丁目 |

| street_address | VARCHAR(255) | NULL | 番地 |

| building | VARCHAR(255) | NULL | ビル名・建物名 |

| postal_code | VARCHAR(10) | NULL | 郵便番号 |

| latitude | DECIMAL(10,7) | NULL | 緯度 |

| longitude | DECIMAL(10,7) | NULL | 経度 |

business_hours テーブル(営業時間)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意の営業時間ID |

| restaurant_id | INTEGER | FOREIGN KEY | 店舗ID(restaurants テーブル参照) |

| day_of_week | INTEGER | NOT NULL | 曜日(0:日曜日 〜 6:土曜日) |

| open_time | TIME | NULL | 開店時間 |

| close_time | TIME | NULL | 閉店時間 |

| is_closed | BOOLEAN | DEFAULT FALSE | 休業日フラグ |

cuisine_types テーブル(料理ジャンル)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意のジャンルID |

| name | VARCHAR(50) | UNIQUE NOT NULL | 料理ジャンル名 |

restaurant_cuisine_types テーブル(店舗-料理ジャンル関連)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| restaurant_id | INTEGER | FOREIGN KEY | 店舗ID(restaurants テーブル参照) |

| cuisine_type_id | INTEGER | FOREIGN KEY | 料理ジャンルID(cuisine_types テーブル参照) |

facilities テーブル(施設情報)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意の施設ID |

| name | VARCHAR(50) | UNIQUE NOT NULL | 施設・設備名 |

| category | VARCHAR(20) | NOT NULL | 施設カテゴリ |

restaurant_facilities テーブル(店舗-施設関連)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| restaurant_id | INTEGER | FOREIGN KEY | 店舗ID(restaurants テーブル参照) |

| facility_id | INTEGER | FOREIGN KEY | 施設ID(facilities テーブル参照) |

reviews テーブル(レビュー情報)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意のレビューID |

| restaurant_id | INTEGER | FOREIGN KEY | 店舗ID(restaurants テーブル参照) |

| source | VARCHAR(50) | NOT NULL | レビュー元サイト |

| author | VARCHAR(100) | NULL | レビュー投稿者 |

| rating | DECIMAL(3,1) | NULL | レビュー評価点 |

| content | TEXT | NULL | レビュー本文 |

| review_date | TIMESTAMP | NULL | レビュー日時 |

| created_at | TIMESTAMP | DEFAULT CURRENT_TIMESTAMP | レコード作成日時 |

sources テーブル(データ収集元情報)

| カラム名 | データ型 | 制約 | 説明 |

|---|---|---|---|

| id | SERIAL | PRIMARY KEY | 一意のソースID |

| restaurant_id | INTEGER | FOREIGN KEY | 店舗ID(restaurants テーブル参照) |

| source_name | VARCHAR(50) | NOT NULL | データ収集元サイト名 |

| source_url | VARCHAR(255) | NULL | 収集元URL |

| source_id | VARCHAR(100) | NULL | 収集元サイトでの店舗ID |

| last_updated | TIMESTAMP | NULL | 最終更新日時 |

| reliability_score | DECIMAL(3,2) | NULL | データ信頼性スコア |

📝 若手エンジニア向けメモ

テーブル設計では、正規化によってデータを適切に分割し、関連テーブルを外部キー(FOREIGN KEY)で結びつけます。例えば、住所情報は別テーブル(addresses)に保存し、restaurants テーブルからは address_id で参照しています。

Elasticsearch(検索用ストレージ):

{

"mappings": {

"properties": {

"id": { "type": "keyword" },

"name": {

"type": "text",

"analyzer": "kuromoji",

"fields": {

"keyword": { "type": "keyword" }

}

},

"address": {

"properties": {

"full": { "type": "text" },

"prefecture": { "type": "keyword" },

"city": { "type": "keyword" },

"district": { "type": "keyword" },

"street_address": { "type": "text" },

"building": { "type": "text" }

}

},

"location": { "type": "geo_point" },

"phone": { "type": "keyword" },

"business_hours": {

"properties": {

"day_of_week": { "type": "integer" },

"open_time": { "type": "keyword" },

"close_time": { "type": "keyword" },

"is_closed": { "type": "boolean" }

}

},

"holidays": { "type": "keyword" },

"cuisine_types": { "type": "keyword" },

"price_range": {

"properties": {

"min": { "type": "integer" },

"max": { "type": "integer" },

"text": { "type": "keyword" }

}

},

"rating": { "type": "float" },

"review_count": { "type": "integer" },

"facilities": { "type": "keyword" },

"sources": {

"properties": {

"name": { "type": "keyword" },

"url": { "type": "keyword" },

"last_updated": { "type": "date" }

}

},

"created_at": { "type": "date" },

"updated_at": { "type": "date" }

}

},

"settings": {

"analysis": {

"analyzer": {

"kuromoji": {

"type": "custom",

"tokenizer": "kuromoji_tokenizer",

"filter": ["kuromoji_baseform", "kuromoji_part_of_speech"]

}

}

}

}

}

💡 学習ポイント

Elasticsearchでは、検索に最適化したスキーマ設計を行います。例えば、text型は全文検索用、keyword型は完全一致検索用です。また、日本語テキスト用のkuromoji解析器を使用することで、日本語の検索精度を向上させます。

4.3 検索API機能

4.3.1 APIエンドポイント

本システムのAPIは以下のエンドポイントを提供します:

-

検索API:

GET /api/v1/restaurants/search- 多様な条件での飲食店検索

-

詳細情報API:

GET /api/v1/restaurants/{id}- 特定の飲食店の詳細情報取得

-

フィルター情報API:

GET /api/v1/filters- 利用可能なフィルター条件の取得

-

ヘルスチェックAPI:

GET /api/v1/health- APIの状態確認

-

ドキュメントAPI:

GET /docs- OpenAPI仕様によるAPIドキュメント

📝 若手エンジニア向けメモ

RESTful APIでは、リソース(この場合は restaurants)を中心に設計し、HTTPメソッド(GET/POST/PUT/DELETEなど)を使って操作を表現します。パス変数({id}など)やクエリパラメータを使って、操作対象や条件を指定します。

4.3.2 検索パラメータ

検索APIでは以下のパラメータを受け付けます:

{

"keyword": "ピザ 新宿", // フリーテキスト検索

"location": { // 位置情報

"latitude": 35.6895,

"longitude": 139.6917,

"address": "東京都新宿区",

"area": "新宿"

},

"radius": 2.0, // 検索半径(km)

"cuisine_types": ["イタリアン", "ピザ"], // 料理ジャンル

"price_range": { // 価格帯

"min": 1000,

"max": 5000

},

"min_rating": 3.5, // 最低評価点

"open_now": true, // 現在営業中

"date_time": "2023-09-01T19:00:00", // 指定日時の空席検索

"facilities": ["個室あり", "駐車場あり"], // 施設条件

"page": 1, // ページ番号

"page_size": 20, // 1ページの表示件数

"sort_by": "rating_desc" // ソート条件

}

💡 学習ポイント

検索機能では、ユーザーが様々な条件で検索できるよう、十分なパラメータを用意することが重要です。同時に、全てのパラメータを必須にするのではなく、オプショナルにすることで、シンプルな検索から複雑な検索まで柔軟に対応できます。

4.3.3 レスポンス形式

検索結果は以下のJSON形式で返されます:

{

"meta": {

"total_results": 235,

"page": 1,

"page_size": 20,

"next_cursor": "eyJpZCI6MTIzNDV9"

},

"filters": {

"cuisine_types": ["イタリアン", "ピザ", "フレンチ", "和食", ...],

"facilities": ["個室あり", "駐車場あり", "禁煙席あり", ...],

"areas": ["新宿", "渋谷", "池袋", ...]

},

"items": [

{

"id": "12345",

"name": "ピザレストラン新宿",

"address": "東京都新宿区歌舞伎町1-2-3",

"distance": 0.8,

"cuisine_types": ["イタリアン", "ピザ"],

"price_range": {"min": 2000, "max": 3000, "text": "¥¥"},

"rating": 4.2,

"review_count": 128,

"open_status": "営業中 (22:00まで)",

"photo_url": "https://example.com/photos/12345.jpg",

"facilities": ["禁煙席あり", "Wi-Fi有り"],

"sources": ["公式サイト", "マップデータ"]

},

// 他の検索結果...

]

}

📝 若手エンジニア向けメモ

レスポンスには、検索結果(items)だけでなく、メタ情報(総件数、ページ情報など)やフィルター情報も含めることで、クライアント側での表示や次の操作をしやすくします。

詳細情報APIのレスポンスはさらに多くの情報を含みます:

{

"id": "12345",

"name": "ピザレストラン新宿",

"address": {

"full": "東京都新宿区歌舞伎町1-2-3 レストランビル2F",

"prefecture": "東京都",

"city": "新宿区",

"district": "歌舞伎町",

"street_address": "1-2-3",

"building": "レストランビル2F",

"postal_code": "160-0021"

},

"location": {"latitude": 35.6935, "longitude": 139.7035},

"phone": "03-1234-5678",

"website": "https://example.com/restaurant",

"cuisine_types": ["イタリアン", "ピザ"],

"price_range": {"min": 2000, "max": 3000, "text": "¥¥"},

"business_hours": [

{"day": "月", "open": "11:30", "close": "22:00"},

{"day": "火", "open": "11:30", "close": "22:00"},

// 他の曜日...

],

"holidays": ["毎週水曜日", "第3木曜日"],

"rating": 4.2,

"reviews": [

{

"source": "tabelog",

"author": "グルメ太郎",

"rating": 4.0,

"content": "ピザが美味しかったです。特にマルゲリータがおすすめです。",

"date": "2023-08-15"

},

// 他のレビュー...

],

"facilities": [

{"name": "禁煙席", "available": true},

{"name": "個室", "available": true, "detail": "6名までの個室あり"},

{"name": "駐車場", "available": false},

// 他の施設情報...

],

"photos": [

{"url": "https://example.com/photos/12345_1.jpg", "type": "外観"},

{"url": "https://example.com/photos/12345_2.jpg", "type": "料理"},

// 他の写真...

],

"sources": [

{"name": "tabelog", "url": "https://tabelog.com/restaurant/12345", "last_updated": "2023-08-20"},

{"name": "hotpepper", "url": "https://hotpepper.jp/restaurant/67890", "last_updated": "2023-08-15"}

],

"created_at": "2023-07-01T00:00:00Z",

"updated_at": "2023-08-20T15:30:45Z"

}

4.3.4 エラーハンドリング

APIは以下の形式でエラーレスポンスを返します:

{

"error": {

"code": "INVALID_PARAMETER",

"message": "Invalid parameter: radius must be between 0.5 and 10.0",

"details": {"parameter": "radius", "constraint": "0.5 <= radius <= 10.0"},

"request_id": "req-123456",

"timestamp": "2023-09-01T10:15:30Z"

}

}

主なエラーコード:

-

INVALID_PARAMETER: パラメータが不正 -

RESOURCE_NOT_FOUND: リソースが見つからない -

INTERNAL_ERROR: 内部エラー -

SERVICE_UNAVAILABLE: サービス一時停止中 -

RATE_LIMIT_EXCEEDED: レート制限超過

💡 学習ポイント

良いAPIは、エラーが発生した場合に明確な情報を提供します。エラーコード、メッセージ、詳細情報を含めることで、クライアント側でエラーを適切に処理できるようになります。

4.3.5 認証・認可

APIへのアクセスは以下の認証方式で保護されます:

-

APIキー認証:

- ヘッダー:

X-API-Key: {api_key} - シンプルかつ使いやすい認証方式

- ヘッダー:

-

JWT認証(拡張機能):

- Bearer トークン:

Authorization: Bearer {token} - ユーザー認証と権限管理に対応

- Bearer トークン:

-

レート制限:

- 基本制限: 60リクエスト/分

- 拡張プラン: 300リクエスト/分

- ヘッダーで残りリクエスト数を通知

📝 若手エンジニア向けメモ

APIキーはシンプルな認証方法ですが、漏洩すると誰でもそのキーを使えてしまうため、機密性の高いシステムではOAuth2などのより高度な認証方式を検討すべきです。また、レート制限を設けることで、サービスの安定性を確保できます。

4.4 モニタリング・管理機能

4.4.1 ロギング機能

システム全体のログは以下の方針で収集・管理されます:

-

ログレベル:

- DEBUG: 開発時の詳細情報

- INFO: 通常の操作情報

- WARNING: 潜在的な問題

- ERROR: エラー(手動対応が必要)

- CRITICAL: 重大なエラー(即時対応が必要)

-

ログ形式:

- JSON形式(構造化ログ)

- タイムスタンプ、レベル、コンポーネント名、メッセージを含む

- リクエストIDによる追跡可能性

💡 学習ポイント

構造化ログ(JSON形式など)を使用すると、ログの解析や検索が容易になります。また、リクエストIDのような追跡子を含めることで、複数のシステムを跨ぐ処理の追跡が可能になります。 -

ログストレージ:

- ローテーション: 日次、100MB上限

- 保存期間: 90日

- 集中ストレージへの転送

4.4.2 メトリクス収集

システムのパフォーマンスと状態を監視するための指標:

-

システムメトリクス:

- CPU使用率

- メモリ使用率

- ディスク使用率

- ネットワークトラフィック

-

アプリケーションメトリクス:

- リクエスト数(エンドポイント別)

- レスポンス時間の分布

- エラー率

- キャッシュヒット率

📝 若手エンジニア向けメモ

メトリクスは、システムの健全性を数値で表します。例えば、「レスポンス時間が急に長くなった」「エラー率が上昇した」などの異常を早期に検知できるようになります。 -

ビジネスメトリクス:

- 収集店舗数

- 更新レコード数

- 検索クエリパターン

- 人気のフィルター条件

4.4.3 アラート設定

異常を検知し、通知するためのアラート:

-

データ収集アラート:

- 連続失敗(3回以上)

- 収集量の異常減少(前日比30%以上減)

- 処理時間の異常(2時間以上)

-

APIアラート:

- 高エラー率(5%以上)

- 低レスポンス(平均3秒以上)

- 高負荷(90%以上のCPU使用率)

💡 学習ポイント

アラートは「ノイズ」と「見逃し」のバランスが重要です。あまりに敏感に設定すると頻繁に通知が来て無視されるようになり、逆に鈍感すぎると重要な問題を見逃す可能性があります。 -

ストレージアラート:

- ディスク容量警告(80%以上)

- データベース接続エラー

- インデックス更新失敗

-

通知チャネル:

- Eメール

- Slack

- SMS(重大な問題のみ)

4.4.4 管理インターフェース

システム管理者向けの管理UI:

-

ダッシュボード:

- システム状態の概要

- 主要メトリクスのグラフ

- アラート履歴

-

ジョブ管理:

- データ収集ジョブの状態確認

- ジョブの手動実行

- ジョブの一時停止/再開

📝 若手エンジニア向けメモ

管理インターフェースは、システムの状態を可視化し、必要な操作を行うための重要なツールです。特にバッチ処理のような自動実行されるジョブでは、状態確認や手動制御の機能が重要になります。 -

設定管理:

- データソースの管理

- システムパラメータの調整

- API設定の変更

-

ログビューワー:

- ログの検索と閲覧

- エラーの詳細確認

- トラブルシューティング支援

4.5 ユーザーストーリーとジョブストーリー

機能要件を具体的なユーザーシナリオとして表現することで、開発の焦点を明確にします。

4.5.1 ユーザーストーリー

ユーザーストーリーは「誰が、何をしたいのか、なぜそれをしたいのか」という形で表現します。

-

基本検索:

利用者として、料理のジャンルや地域で飲食店を検索したい。そうすることで、自分の好みや現在地に合った店舗を素早く見つけられるから。

-

詳細条件検索:

細かい希望条件を持つ利用者として、予算、設備(個室、禁煙席など)、営業時間などの詳細条件で飲食店を絞り込みたい。そうすることで、自分のニーズに完全に合致した店舗を見つけられるから。

-

現在地ベース検索:

外出中の利用者として、現在地から近い飲食店を検索したい。そうすることで、すぐに行ける場所の選択肢を知ることができるから。

-

評価ベース検索:

初めて訪れる地域の利用者として、評価の高い飲食店を見つけたい。そうすることで、品質の高いサービスを受けられる可能性を高められるから。

-

営業状況確認:

今すぐ食事したい利用者として、現在営業中の飲食店を検索したい。そうすることで、開店している店舗だけを表示し、時間を無駄にしないようにしたいから。

4.5.2 ジョブストーリー

ジョブストーリーは「状況、動機、期待する成果」というフレームワークで表現します。

-

急いで食事する場所を探す:

会議が長引いて時間がないとき、近くの評判の良い店ですぐに食事をしたい。そうすれば、次の予定に遅れることなく、満足のいく食事ができるから。

-

特別な日のレストランを探す:

記念日や重要な商談のとき、予算と目的に合った雰囲気の良いレストランを見つけたい。そうすれば、大切な機会を素晴らしい食事体験で演出できるから。

-

食事の前に設備を確認する:

子連れや車で出かけるとき、必要な設備(子供椅子、駐車場など)がある飲食店を探したい。そうすれば、到着後にトラブルなく快適に食事ができるから。

-

好みのジャンルで新しい店を発見する:

いつも同じ店ばかり行っていて飽きたとき、自分の好みのジャンルで未訪問の高評価の店を見つけたい。そうすれば、新しい食体験を楽しみながらも失敗のリスクを減らせるから。

-

予算内でグループでの食事場所を決める:

複数人での会食を計画するとき、予算内で全員の好みに合った店を見つけたい。そうすれば、グループ全体が満足できる選択ができるから。

4.6 若手エンジニア向け解説:機能要件の考え方

機能要件は「システムが何をするべきか」を定義するもので、システム設計の基礎となります。以下のポイントを押さえましょう:

-

ユーザー視点と運用視点の両方を考慮する:

- ユーザーが直接使う機能(検索APIなど)

- 運用に必要な機能(モニタリング、管理機能など)

- どちらも重要な機能要件です

-

優先順位をつける:

- 必須機能(Must Have)

- あると良い機能(Nice to Have)

- 将来的に検討する機能(Future Consideration)

- 限られたリソースの中で、重要な機能から実装していくことが大切です

-

詳細度のバランス:

- 詳細すぎると柔軟性が失われる

- 抽象的すぎると実装方針が定まらない

- 適切なレベルの詳細度で記述することが重要です

-

検証可能性:

- 要件が満たされたかどうかを判断できるよう、具体的かつ測定可能な形で記述する

- 例:「検索は高速であること」より「90%の検索リクエストが500ms以内に完了すること」の方が検証しやすい

-

ユーザーストーリーやジョブストーリーの活用:

- 抽象的な機能要件を具体的なシナリオに落とし込む

- 実装の目的と価値を明確にする

- チーム全体での認識共有を促進する

🔍 チェックポイント

- データ収集機能の主要な要素(対象、項目、スケジュール)を説明できる

- データ処理・ストレージ機能の役割と重要性を理解している

- 検索API機能の設計(エンドポイント、パラメータ、レスポンス形式など)を説明できる

- モニタリング・管理機能の必要性と主要コンポーネントを理解している

- ユーザーストーリーとジョブストーリーの違いと作成方法を説明できる

第5章:非機能要件

📚 この章で学ぶこと

- パフォーマンス、可用性、セキュリティなどの非機能要件

- システムの品質特性を定義する方法

- 非機能要件が実装に与える影響

- クラウドネイティブ環境での非機能要件

🔑 重要な概念

- 非機能要件の種類と重要性

- 要件の具体的な数値化

- トレードオフの考慮

- SLO (Service Level Objectives) の設定

5.1 パフォーマンス要件

5.1.1 レスポンスタイム

-

検索API:

- 平均レスポンス時間: 500ms以内

- 95パーセンタイル: 3秒以内

- 最大許容時間: 10秒

💡 学習ポイント

パフォーマンス要件では、平均値だけでなく、パーセンタイル値(例:95%のリクエストが何秒以内に完了するか)も重要です。これにより、一部のユーザーが極端に遅い応答を受けることを防げます。 -

詳細情報API:

- 平均レスポンス時間: 300ms以内

- 95パーセンタイル: 1秒以内

- 最大許容時間: 3秒

5.1.2 スループット

-

検索API:

- 平常時: 50リクエスト/秒

- ピーク時: 100リクエスト/秒

- バースト耐性: 200リクエスト/秒(短時間)

📝 若手エンジニア向けメモ

スループットは、システムが単位時間あたりに処理できるリクエスト数です。平常時だけでなく、イベントなどでアクセスが集中する「ピーク時」や、一時的なアクセス急増(「バースト」)にも対応できるよう設計することが重要です。 -

データ収集バッチ:

- データソースの制限を考慮

- 1ソースあたり5-20リクエスト/分

- 並列処理で効率化

5.1.3 容量要件

-

店舗数:

- 初期フェーズ: 約10万店舗

- 将来拡張: 最大100万店舗

-

ストレージ容量:

- PostgreSQL: 初期20GB、年間成長5GB

- Elasticsearch: 初期30GB、年間成長10GB

- ログ: 月間5GB

💡 学習ポイント

容量計画では、初期段階だけでなく、将来の成長も考慮することが重要です。データ量の増加に伴い、パフォーマンスが低下したり、ストレージが不足したりしないよう、余裕を持った設計が必要です。

5.2 可用性要件

5.2.1 稼働率

-

検索API:

- 目標稼働率: 99.9%(月間ダウンタイム43分以内)

- 計画メンテナンス: 月1回、深夜2時-4時

📝 若手エンジニア向けメモ

99.9%の稼働率(「スリーナイン」と呼ばれます)は、月に約43分のダウンタイムが許容されることを意味します。稼働率の数字が1桁増えるごとに(99.9%→99.99%など)、実現の難易度とコストは大幅に上昇します。 -

バッチ処理:

- 成功率: 95%以上

- 失敗時の自動リトライ

- 手動リカバリー手段の提供

5.2.2 障害回復

-

復旧時間目標(RTO):

- 検索API: 1時間以内

- バッチ処理: 4時間以内

-

復旧ポイント目標(RPO):

- データベース: 24時間以内

- ログ: 72時間以内

💡 学習ポイント

RTOとRPOは災害復旧計画の重要な指標です。RTOは「どれだけ早くシステムを復旧させるか」、RPOは「どの時点までのデータを復旧させるか」を表します。例えば、RPOが24時間なら、最大で24時間前のデータまで戻る可能性があることを意味します。

5.2.3 障害対策

-

単一障害点の排除:

- コンポーネント間の疎結合

- 冗長化(予算制約内で段階的に実装)

-

デグラデーション戦略:

- 一部データソースの障害時も検索機能を維持

- キャッシュを活用した縮退運転

- 非重要機能の一時停止

📝 若手エンジニア向けメモ

「デグラデーション(縮退)」とは、システムの一部が障害を起こした場合でも、重要な機能を維持するための戦略です。例えば、データベースに問題が発生しても、キャッシュを活用して基本的な検索機能を提供するなどの対応が考えられます。

5.3 セキュリティ要件

5.3.1 認証・認可

-

API認証:

- APIキー認証

- IPアドレス制限(オプション)

-

管理インターフェース:

- ユーザー名/パスワード認証

- 多要素認証(将来実装)

- ロールベースアクセス制御

💡 学習ポイント

セキュリティは「多層防御」の考え方が重要です。単一の防御策ではなく、複数の防御層を設けることで、一つの層が破られても次の層で防御できるようにします。

5.3.2 データ保護

-

通信の暗号化:

- すべてのエンドポイントでHTTPS使用

- TLS 1.2以上を要求

-

データの暗号化:

- 個人情報は保存時に暗号化

- 秘密情報(APIキーなど)は暗号化

📝 若手エンジニア向けメモ

データ保護では、「転送中のデータ」と「保存中のデータ」の両方を考慮する必要があります。HTTPSによる通信の暗号化と、データベースでの暗号化の両方が重要です。 -

アクセス制御:

- 最小権限の原則

- ロールベースのアクセス管理

5.3.3 脆弱性対策

-

入力検証:

- すべてのユーザー入力の検証

- SQLインジェクション対策

- クロスサイトスクリプティング(XSS)対策

💡 学習ポイント

入力検証は、セキュリティの基本です。外部から入ってくるデータは全て「信頼できない」と考え、適切に検証・サニタイズすることが重要です。特にSQLインジェクションやXSS(クロスサイトスクリプティング)などの一般的な攻撃に対する対策は必須です。 -

依存パッケージ管理:

- 定期的な脆弱性スキャン

- セキュリティアップデートの適用

-

ログ監査:

- セキュリティイベントのログ記録

- アクセスログの定期レビュー

5.3.4 OWASP Top 10対応

OWASPが定めるWebアプリケーションの主要な脆弱性に対する対策:

-

インジェクション対策:

- パラメータ化クエリの使用

- ORMの適切な活用

- ユーザー入力の厳格なバリデーション

-

認証とセッション管理:

- 安全なパスワードハッシュ(bcrypt)

- セッショントークンの安全な管理

- アカウントロックアウト機能

-

クロスサイトスクリプティング(XSS)対策:

- 出力エンコーディング

- Content Security Policy (CSP)の実装

- XSS-Filterヘッダーの設定

-

安全でないオブジェクト参照の防止:

- 適切なアクセス制御チェック

- ユーザー固有の識別子の使用

-

セキュリティ設定のハードニング:

- セキュアなHTTPヘッダー設定

- 不要なサービス・機能の無効化

- エラーメッセージの最小化

📝 若手エンジニア向けメモ

OWASPはWebアプリケーションセキュリティの標準的なガイドラインを提供する非営利団体です。OWASP Top 10は、最も重大で一般的なWebアプリケーションのセキュリティリスクをリストアップしたものであり、セキュア開発の基本として考慮すべき項目です。

5.4 拡張性・保守性要件

5.4.1 水平スケーラビリティ

-

APIサーバー:

- ステートレス設計

- 複数インスタンスによる負荷分散

- オートスケーリング対応(将来実装)

📝 若手エンジニア向けメモ

「ステートレス設計」とは、各リクエストが独立して処理され、サーバーがクライアントの状態を保持しない設計のことです。これにより、複数のサーバーでリクエストを処理することが容易になり、水平スケーリング(サーバー数を増やすこと)が可能になります。 -

バッチ処理:

- ワーカーの並列処理

- ジョブの分散実行

- 処理単位の分割

5.4.2 垂直スケーラビリティ

-

データベース:

- リソース増強の簡易化

- 段階的なアップグレードパス

- パフォーマンスチューニング容易性

💡 学習ポイント

「垂直スケーリング」とは、サーバーのスペック(CPU、メモリなど)を向上させることです。水平スケーリングと比べて実装は簡単ですが、単一サーバーの限界があります。両方のスケーリング方法をバランスよく考慮することが重要です。 -

検索エンジン:

- インデックス設計の最適化

- クエリパフォーマンスの監視と改善

- シャーディング対応(将来実装)

5.4.3 コード保守性

-

モジュール化:

- 責務の明確な分離

- インターフェースによる疎結合

- 単一責任の原則

📝 若手エンジニア向けメモ

「単一責任の原則」とは、「クラスを変更する理由は1つだけであるべき」という原則です。つまり、1つのクラスは1つの責任だけを持つべきです。これにより、コードの変更が他の部分に影響を与えにくくなります。 -

テスト容易性:

- 単体テストのカバレッジ

- モックによる外部依存の分離

- 自動テスト環境

-

設定管理:

- 環境変数による設定

- 設定ファイルの外部化

- ランタイム設定変更機能

5.4.4 クラウドネイティブ対応

クラウド環境で効果的に運用するための要件:

-

コンテナ化:

- Dockerコンテナによるパッケージング

- 環境の一貫性確保

- 依存関係の明確な管理

-

オーケストレーション:

- Kubernetesによるコンテナ管理

- 自動スケーリング設定

- ヘルスチェックと自動回復

-

GitOps:

- 宣言的インフラ定義

- バージョン管理されたインフラ設定

- 継続的デリバリーパイプライン

💡 学習ポイント

クラウドネイティブアプリケーションは、クラウド環境の特性(スケーラビリティ、弾力性、自動化など)を最大限に活用するように設計されています。コンテナ化とオーケストレーション技術を採用することで、環境間の一貫性を確保し、効率的なデプロイメントとスケーリングが可能になります。

5.5 運用性要件

5.5.1 監視と可観測性

-

観測データの収集:

- メトリクス収集(システム性能、ビジネスKPI)

- 分散トレーシング

- 構造化ログ

- イベント

-

ダッシュボード:

- リアルタイムモニタリング

- カスタマイズ可能なビュー

- アラート状態の可視化

-

アラート設定:

- 異常検知ベースのアラート

- 通知チャネルの多様性

- エスカレーションポリシー

5.5.2 運用自動化

-

自動化された運用タスク:

- バックアップと復元

- パッチ適用

- スケーリング操作

-

ランブック:

- 標準操作手順の文書化

- 障害対応マニュアル

- 定期的な訓練と改善

-

デプロイメント自動化:

- CI/CDパイプライン

- カナリアリリース

- 自動ロールバック機能

📝 若手エンジニア向けメモ

運用自動化は、人的ミスを減らし、運用効率を高めるために重要です。繰り返し行われる作業は自動化し、オペレーターはより価値の高い問題解決や改善活動に集中できるようにするのが理想的です。

5.6 SREアプローチによる品質目標

Google発祥のSRE(Site Reliability Engineering)の概念を取り入れた目標設定:

5.6.1 SLI (Service Level Indicators)

サービスの健全性を測定する指標:

- 可用性:成功したリクエストの割合

- レイテンシ:リクエスト処理にかかる時間

- 処理量:システムが処理できるリクエスト数

- エラー率:エラーが発生したリクエストの割合

5.6.2 SLO (Service Level Objectives)

SLIに対する目標値:

- 可用性SLO:30日間で99.9%のリクエストが成功すること

- レイテンシSLO:95%のリクエストが500ms以内に完了すること

- エラー率SLO:エラー率が0.1%を超えないこと

5.6.3 エラーバジェット

SLOを達成するために許容されるエラーの量:

- 計算方法:(1 - SLO) × 総リクエスト数

- 活用方法:エラーバジェットが残っている場合は新機能のリリースを加速、枯渇している場合は安定性向上に注力

💡 学習ポイント

SREアプローチでは、「100%の可用性を目指す」のではなく、「99.9%などの具体的な目標を定め、それを確実に達成する」という考え方をします。これにより、信頼性向上のための取り組みと、新機能開発のスピードのバランスを取ることができます。

5.7 若手エンジニア向け解説:非機能要件の重要性

非機能要件は、システムが「どのようにうまく動作するか」を定義するもので、ユーザー体験や運用効率に大きく影響します。以下のポイントを押さえましょう:

-

非機能要件は早期に検討する:

- 後からの変更が困難なことが多い

- アーキテクチャ選定に大きく影響する

- 開発初期から意識することが重要

-

具体的な数値で定義する:

- 「高性能」ではなく「平均応答時間500ms以内」など

- 測定可能な形で記述することで、要件達成の判断が容易になる

-

トレードオフを理解する:

- 高可用性と低コストはトレードオフの関係にある

- 高性能と実装の容易さはトレードオフの関係にある

- 全ての要件を最高レベルで満たすことは現実的でない場合が多い

-

段階的な実装計画を立てる:

- まずは基本的な要件を満たす

- その後、優先度の高い要件から段階的に強化する

- コストと効果のバランスを考慮する

-

定期的な見直しを行う:

- ユーザー数やデータ量の増加に伴う要件変更

- 新しい技術や手法の採用による改善可能性

- ビジネス要件の変化に応じた優先順位の調整

📝 若手エンジニア向けメモ

非機能要件は「目に見えにくい」ため、軽視されがちですが、システムの成功には機能要件と同等かそれ以上に重要です。特に、スケーラビリティやセキュリティの問題は、利用者が増えてから対応しようとすると、大幅な設計変更が必要になることがあります。

🔍 チェックポイント

- パフォーマンス要件の主要な指標(レスポンスタイム、スループット、容量)を説明できる

- 可用性要件の重要性と主要な指標(稼働率、RTO、RPO)を理解している

- セキュリティ要件の基本的な考え方と主要な対策を説明できる

- 拡張性・保守性要件がシステムの長期的な健全性にどう貢献するか理解している

- SREアプローチの基本概念(SLI、SLO、エラーバジェット)を説明できる

第6章:技術選定とその理由

📚 この章で学ぶこと

- システムに適した技術を選定する方法

- 各技術の長所と短所の比較

- 技術選定がシステム全体に与える影響

- 技術選定の意思決定プロセス

🔑 重要な概念

- 要件に基づいた技術選定の考え方

- 技術の成熟度とコミュニティの活発さの重要性

- チームの技術力との相性

- 将来の拡張性と保守性の考慮

6.1 技術選定の基本方針

本プロジェクトでは、以下の基本方針に基づいて技術を選定しました:

-

機能要件と非機能要件の充足:

- システム要件を満たす技術力を持っていること

- スケーラビリティ、パフォーマンス要件を満たせること

-

チームのスキルセットとの整合性:

- チームのスキルと経験に合った技術を優先

- 学習曲線と導入コストの考慮

-

コミュニティとエコシステム:

- 活発なコミュニティサポートの有無

- 充実したドキュメンテーション

- サードパーティライブラリの充実度

-

将来の拡張性:

- 将来のビジネス要件変化に対応できる柔軟性

- 新技術への移行容易性

-

コストと制約:

- ライセンスコストと運用コスト

- 組織のポリシーやコンプライアンス要件

💡 学習ポイント

技術選定は単に「流行りのもの」や「好み」で選ぶのではなく、プロジェクトの特性やチームの状況を考慮した戦略的な意思決定です。短期的な生産性だけでなく、長期的な保守性も重要な判断基準となります。

6.2 プログラミング言語:Python

選定理由:

- 豊富なライブラリエコシステム(データ処理、API開発、機械学習など)

- 開発速度の高さと可読性の良さ

- チーム内の技術スキルとの親和性

- 豊富なドキュメントとコミュニティサポート

- Web API開発からデータ処理まで幅広く対応可能

💡 学習ポイント

プログラミング言語の選定では、言語自体の特性だけでなく、ライブラリのエコシステムやチームの習熟度も重要な要素です。Pythonは特にデータ処理や機械学習の分野で強力なライブラリが豊富です。

代替検討:

- Node.js: 非同期処理に強いが、データ処理ライブラリがPythonほど充実していない

- Java: 堅牢だが開発速度が遅く、ボイラープレートコードが多い

- Go: 高性能だが、ライブラリエコシステムがPythonほど充実していない

📝 若手エンジニア向けメモ

どの言語も一長一短があります。例えば、Javaは型安全性が高く大規模開発に向いていますが、開発スピードは遅くなりがちです。Pythonは開発が速い反面、大規模になると型の問題などが出てくることがあります。プロジェクトの性質に合った言語を選びましょう。

6.2.1 意思決定プロセスの例

Pythonを選定するに至った意思決定プロセスを簡略化したADR(Architecture Decision Record)形式で示します:

# ADR-001: プログラミング言語としてPythonを選定

## ステータス

承認済み

## コンテキスト

- サービスには高速な開発サイクルが求められている

- データ処理とWeb API両方の機能が必要

- チームの多くのメンバーがPythonに習熟している

- 将来的な機械学習機能の追加可能性がある

## 決定

プロジェクトの主要言語としてPython 3.10+を採用する

## 代替案

- Node.js: Web APIに強いが、データ処理・機械学習のエコシステムが弱い

- Java: 型安全性に優れるが、開発速度が遅く、ボイラープレートコードが多い

- Go: パフォーマンスに優れるが、チームのスキルセットとの一致度が低い

## 判断基準

1. 機能要件の充足(重み: 30%): Python - 5/5, Node.js - 3/5, Java - 4/5, Go - 3/5

2. 開発効率(重み: 25%): Python - 5/5, Node.js - 4/5, Java - 2/5, Go - 3/5

3. チームスキル(重み: 20%): Python - 4/5, Node.js - 3/5, Java - 3/5, Go - 1/5

4. エコシステム(重み: 15%): Python - 5/5, Node.js - 4/5, Java - 5/5, Go - 3/5

5. 将来性(重み: 10%): Python - 4/5, Node.js - 4/5, Java - 3/5, Go - 5/5

加重平均スコア:

- Python: 4.7/5

- Node.js: 3.6/5

- Java: 3.35/5

- Go: 2.8/5

## 結果

Pythonが最も高いスコアを得た。特に、データ処理能力と開発効率の点で優位性が高い。

## 影響

- 型の安全性については、型ヒントとmypyを活用して補強する

- 高負荷部分は必要に応じてC拡張やGo/Rustでの実装を検討する

- パフォーマンスクリティカルな部分では非同期処理(asyncio)を活用する

📝 若手エンジニア向けメモ

ADR(Architecture Decision Record)は、重要な技術的意思決定を記録するための軽量な方法です。「なぜその決定をしたのか」を将来のチームメンバーが理解できるよう、コンテキスト、検討した選択肢、判断基準、予想される影響などを記録します。

6.3 データベース(一次ストレージ):PostgreSQL

選定理由:

- オープンソースでありながら高度な機能と安定性

- リレーショナルモデルによるデータ整合性の確保

- JSON型によるスキーマの柔軟性

- PostGISによる地理空間データのサポート

- 豊富なインデックスオプションと高度なクエリ機能

💡 学習ポイント

PostgreSQLは、オープンソースのリレーショナルデータベースの中でも特に機能が豊富です。特に地理空間データの処理能力(PostGIS)や、JSON型のサポートなど、NoSQLデータベースの利点も一部取り入れています。

代替検討:

- MySQL: シンプルだが、PostgreSQLより高度な機能が少ない

- MongoDB: 柔軟なスキーマだが、トランザクション整合性が弱い

- SQLite: 軽量だが、同時接続性能が低く大規模データに不向き

📝 若手エンジニア向けメモ

データベース選定では、データの構造(構造化データか非構造化データか)、トランザクションの重要性、スケーラビリティの要件などを考慮します。本システムでは、店舗情報のような構造化データを扱い、データの整合性が重要なため、リレーショナルデータベースが適しています。

6.4 データベース(検索ストレージ):Elasticsearch

選定理由:

- 全文検索に最適化されたアーキテクチャ

- 地理空間検索のネイティブサポート

- スケーラビリティとクラスタリング機能

- 複雑なクエリとフィルタリングの柔軟性

- 速度と機能のバランスの良さ

💡 学習ポイント

Elasticsearchは「検索」に特化したデータベースで、インデックスの構造や検索アルゴリズムが全文検索や複雑なクエリに最適化されています。また、分散システムとして設計されており、スケーラビリティにも優れています。

代替検討:

- Solr: 機能的に似ているが、構成が複雑

- Algolia: マネージドサービスで簡単だが、コストが高い

- PostgreSQLの全文検索: シンプルだが、複雑な検索や大量データには不向き

📝 若手エンジニア向けメモ

PostgreSQLにも全文検索機能はありますが、複雑な検索条件や大量のデータになると性能が不足する場合があります。Elasticsearchはそのような場合に威力を発揮しますが、運用の複雑さやリソース要件が高いというデメリットもあります。

6.5 API:FastAPI

選定理由:

- 高パフォーマンス(ASGIベース、Uvicornとの組み合わせ)

- 自動APIドキュメント生成(OpenAPI/Swagger対応)

- 型ヒントによる開発時の安全性向上

- 非同期処理のネイティブサポート

- データバリデーション機能の組み込み

💡 学習ポイント

FastAPIは比較的新しいフレームワークですが、パフォーマンスが高く、開発体験が優れていることから急速に人気を集めています。特に型ヒントを活用した自動バリデーションや、OpenAPI仕様に基づく自動ドキュメント生成など、開発効率を高める機能が充実しています。

代替検討:

- Flask: シンプルだが、FastAPIより低パフォーマンス

- Django: 多機能だが、APIのみの用途には過剰

- Express.js(Node.js): 非同期に強いが、チームのPython経験を活かせない

📝 若手エンジニア向けメモ

Webフレームワークの選択では、プロジェクトの規模や要件に合ったものを選ぶことが重要です。小規模なAPIならFlaskでも十分ですが、大規模なシステムや高いパフォーマンスが求められる場合はFastAPIやDjangoが適しています。また、チームの習熟度も重要な要素です。

6.6 キャッシュ:Redis

選定理由:

- 高速インメモリデータストア

- 多様なデータ構造のサポート

- キーの有効期限(TTL)管理の簡便さ

- パブリッシュ/サブスクライブ機能

- 豊富なクライアントライブラリ

💡 学習ポイント

Redisは単なるキャッシュ以上の機能を持つ「データ構造サーバー」です。文字列だけでなく、リスト、セット、ハッシュ、ソート済みセットなど多様なデータ構造をサポートしており、これらを活用することで複雑なデータ操作も効率的に行えます。

代替検討:

- Memcached: シンプルだが、Redisより機能が限定的

- ローカルメモリキャッシュ: 分散環境での一貫性に課題

- Hazelcast: 機能豊富だが設定が複雑

📝 若手エンジニア向けメモ

キャッシュを導入する目的は主にパフォーマンス向上ですが、「キャッシュの一貫性」という課題も考慮する必要があります。データが更新された場合、キャッシュも適切に更新または無効化しないと、古いデータが表示されてしまう可能性があります。

6.7 コンテナ技術:Docker & Kubernetes

選定理由:

- 環境の一貫性確保

- デプロイメントの簡素化

- スケーリングの柔軟性

- ロールバックの容易さ

- マイクロサービスアーキテクチャへの将来的な移行の容易さ

💡 学習ポイント

コンテナ技術は、アプリケーションとその依存関係を1つのパッケージにまとめることで、「開発環境では動くのに本番環境では動かない」という問題を解決します。また、Kubernetesのようなオーケストレーションツールを利用することで、複数のコンテナの管理やスケーリングを自動化できます。

代替検討:

- 仮想マシン(VM): リソース効率が低く、起動が遅い

- サーバーレス(AWS Lambda等): 特定の用途には適しているが、長時間実行プロセスには不向き

- 直接ホスト上にデプロイ: シンプルだが、環境差異や依存関係の問題がある

📝 若手エンジニア向けメモ

Dockerは開発環境と本番環境の「一貫性」を確保するのに非常に役立ちます。「自分のPCでは動くのに本番環境では動かない」という問題を大幅に減らせます。Kubernetesは複雑ですが、システムの成長に伴い、スケーリングや可用性の管理が容易になるという大きなメリットがあります。

6.8 CI/CD:GitHub Actions

選定理由:

- GitHubとの緊密な統合

- シンプルな設定ファイル(YAML)

- マトリックスビルドのサポート

- 豊富な事前構築されたアクション

- エコシステムの成長と活発なコミュニティ

💡 学習ポイント

CI/CD(継続的インテグレーション/継続的デリバリー)は、コードの変更をテスト、ビルド、デプロイするプロセスを自動化する方法です。これにより、品質確保と迅速なデプロイメントの両立が可能になります。

代替検討:

- Jenkins: 高度にカスタマイズ可能だが、設定が複雑

- CircleCI: クラウドベースで使いやすいが、固有の構文を学ぶ必要がある

- GitLab CI: GitLabと統合されているが、本プロジェクトではGitHubを使用

📝 若手エンジニア向けメモ

CI/CDツールは「手動作業を減らし、ヒューマンエラーを防ぐ」という大きなメリットがあります。テストの実行忘れやデプロイミスなどを防ぎ、開発チームは機能開発に集中できるようになります。

6.9 モニタリング:Prometheus + Grafana

選定理由:

- Prometheus: メトリクス収集と保存に最適化

- Grafana: 柔軟性の高い可視化ダッシュボード

- アラート機能の統合

- 幅広いエクスポーターの利用可能性

- オープンソースコミュニティの活発さ

💡 学習ポイント

Prometheusは「プル型」のモニタリングシステムで、定期的に監視対象からメトリクスを取得します。これにより、シンプルな構成と高い信頼性を実現しています。Grafanaはそのデータを視覚化するツールで、様々なデータソースに対応しています。

代替検討:

- ELK Stack: ログ解析に強いが、メトリクス特化ではない

- Datadog: 高機能だが有料

- カスタム監視: 開発コストが高い

📝 若手エンジニア向けメモ

モニタリングは「何を、どのように監視するか」を明確にすることが重要です。CPU使用率やメモリ使用率などの基本的なシステムメトリクスだけでなく、アプリケーション固有のメトリクス(リクエスト数、エラー率など)も監視することで、問題の早期発見と対応が可能になります。

6.10 インフラストラクチャ: AWS

選定理由:

- 幅広いサービスの提供

- スケーラビリティと柔軟性

- セキュリティ機能の充実

- マネージドサービスによる運用負荷の軽減

- 豊富なドキュメントとサポート

主要サービス:

- EC2: アプリケーションサーバー

- RDS for PostgreSQL: リレーショナルデータベース

- Amazon Elasticsearch Service: 検索エンジン

- ElastiCache: Redisキャッシュ

- EKS: Kubernetesクラスター管理

- S3: 静的リソースとバックアップストレージ

- CloudWatch: 監視とアラート

- Route53: DNS管理

- Certificate Manager: SSL証明書管理

💡 学習ポイント

クラウドプロバイダーの選択は、単に技術的な理由だけでなく、ビジネス要件(コスト、規制コンプライアンス、既存システムとの統合等)も考慮して行います。AWSは幅広いサービスとグローバルなインフラストラクチャを提供しており、多くのユースケースに対応できます。

代替検討:

- Google Cloud Platform (GCP): Kubernetesに強みがあるが、AWSより日本での導入実績が少ない

- Microsoft Azure: Microsoftエコシステムとの統合に優れるが、特定のサービスではAWSより機能が限定的

- オンプレミス: 完全な制御が可能だが、初期コストと運用コストが高い

📝 若手エンジニア向けメモ

クラウドサービスでは「従量課金」モデルが一般的ですが、プランニングが不足していると予想外のコストが発生する可能性があります。リソースの自動スケーリングには上限を設定したり、不要なリソースは自動的にシャットダウンするなどの対策が重要です。また、マネージドサービス(RDS、ElastiCacheなど)は、自前で構築・運用するよりも効率的に使えることが多いです。

6.11 若手エンジニア向け解説:技術選定の考え方

技術選定は、プロジェクトの成否を左右する重要な決断です。以下のポイントを考慮して技術を選定しましょう:

-

要件との適合性:

- 機能要件と非機能要件を満たせるか

- 特に重要な要件(例:パフォーマンス、セキュリティ)に対応できるか

- 将来的な要件変更にも対応できる柔軟性があるか

-

チームの技術力との相性:

- チームがすでに習熟している技術か

- 学習コストは許容範囲内か

- サポートやリソースは十分に得られるか

-

技術の成熟度とコミュニティ:

- 十分に実績のある技術か

- 活発なコミュニティとサポートがあるか

- ドキュメントや学習リソースは充実しているか

-

コストと制約:

- ライセンス費用や運用コストは予算内か

- ハードウェア要件は満たせるか

- 既存システムとの統合は容易か

-

長期的な展望:

- 技術の将来性はどうか

- ベンダーロックインのリスクはないか

- スケーラビリティと拡張性は確保できるか

6.11.1 技術選定の意思決定プロセス

-

要件の明確化:

- 機能要件と非機能要件を文書化

- 優先順位を決定

- 技術選定に影響する制約条件を特定

-

選択肢の洗い出し:

- 候補技術のリストを作成

- 各技術の基本情報を収集

- 明らかに不適切な選択肢を早期に除外

-

評価基準の設定:

- 重要な基準を特定(パフォーマンス、スケーラビリティ、学習曲線など)

- 基準ごとの重み付けを決定

- 評価方法を定義(スコアリングなど)

-

詳細評価:

- 各技術の長所・短所を分析

- 必要に応じてプロトタイプ作成

- 評価基準に基づいてスコアリング

-

意思決定と文書化:

- 評価結果に基づいて決定

- 決定理由を含む技術選定文書を作成(ADRなど)

- ステークホルダーとの共有と合意形成

💡 学習ポイント

「最新・最先端」の技術が常に最適というわけではありません。プロジェクトの性質、チームの状況、時間的制約などを総合的に考慮して、バランスの良い選択をすることが重要です。特に若手エンジニアが多いチームでは、学習コストと安定性を重視するとよいでしょう。

🔍 チェックポイント

- 各技術の選定理由と代替技術の比較を説明できる

- 技術選定の考え方と重要な要素を理解している

- チームの状況に合わせた技術選定の方法を説明できる

- 技術選定がプロジェクトの成功にどう影響するか理解している

- ADRなどの意思決定プロセスの文書化方法を理解している

第7章:開発・テスト計画

📚 この章で学ぶこと

- アジャイル開発プロセスの実践方法

- 効率的な開発環境の構築方法

- 効果的なテスト戦略の立案

- デプロイメントと運用の計画

- 若手エンジニア向けの学習アプローチ

🔑 重要な概念

- アジャイル開発のプラクティス

- テスト駆動開発(TDD)と継続的インテグレーション

- DevOpsの考え方

- 段階的な学習と実装

7.1 開発プロセス

7.1.1 アジャイル開発方法論の採用

本プロジェクトでは、柔軟性と迅速な価値提供を重視し、スクラムをベースにしたアジャイル開発方法論を採用します。

スクラムフレームワークの実践:

- スプリント: 2週間のタイムボックス

- スプリントプランニング: スプリントの開始時に行い、作業項目を決定

- デイリースタンドアップ: 15分間の日次ミーティング

- スプリントレビュー: スプリント終了時に成果物をデモ

- スプリントレトロスペクティブ: プロセス改善のための振り返り

💡 学習ポイント

アジャイル開発は、変化に対応しながら価値を継続的に提供するための方法論です。「計画通りにすべてを実行する」のではなく、「計画を継続的に見直しながら進める」というマインドセットが重要です。

プロダクトバックログの管理:

- ユーザーストーリー形式での要件記述

- 優先順位付けと見積もり

- バックログリファインメントの定期実施

カンバンボードの活用:

- 「To Do」「In Progress」「Review」「Done」の基本レーン

- WIP(Work In Progress)制限の実施

- 視覚的な進捗管理

📝 若手エンジニア向けメモ

WIP制限とは、「進行中の作業数を制限する」という考え方です。多数のタスクを同時進行させるよりも、少数のタスクに集中して完了させていく方が、全体としての効率が高まります。マルチタスキングによるコンテキストスイッチのコストを減らすことができます。

7.1.2 ユーザーストーリーマッピング

ユーザーストーリーは単なる機能リストではなく、ユーザージャーニーに沿って構造化します。

-

バックボーン(主要活動)の特定:

- 「飲食店を検索する」

- 「検索結果をフィルタリングする」

- 「店舗詳細を確認する」

-

ストーリーの階層化:

- エピック: 大きな機能群(例: 「検索機能」)

- ストーリー: 実装可能な単位(例: 「キーワードで検索する」)

- タスク: 開発作業(例: 「検索APIエンドポイント実装」)

-

リリース計画への活用:

- MVP(Minimum Viable Product)の特定

- 段階的なリリース計画

- 優先順位の可視化

💡 学習ポイント

ユーザーストーリーマッピングは、「機能のリスト」ではなく「ユーザーの体験」に焦点を当てた要件整理の手法です。これにより、「技術的には完成しているがユーザーには価値がない」という状況を避け、各リリースが意味のある価値を提供できるようになります。

7.1.3 イテレーティブな開発アプローチ

段階的に機能を拡充していくアプローチを採用します。

リリースの段階計画:

-

フェーズ1(MVP): 8週間

- 基本的な検索機能

- 店舗詳細表示

- シンプルなフィルタリング

-

フェーズ2: 6週間

- 高度な検索機能(複合条件)

- レビュー情報の統合

- 検索結果のソートオプション

-

フェーズ3: 8週間

- 位置情報を活用した検索

- レコメンデーション機能

- 外部サービス連携

📝 若手エンジニア向けメモ

MVPとは「実用最小限の製品(Minimum Viable Product)」のことで、核となる価値を提供できる最小限の機能セットを意味します。まずはMVPをリリースし、ユーザーフィードバックを得ながら改善していくことで、無駄な機能開発を避け、本当に必要な機能に集中できます。

7.2 開発環境

7.2.1 ローカル開発環境

開発者のローカル環境は以下の構成とします:

-

Docker Compose:

- PostgreSQL、Elasticsearch、Redisコンテナ

- API開発用のPythonコンテナ

- バッチ開発用のPythonコンテナ

- ローカル開発用の軽量K8s(Minikube/K3s)

💡 学習ポイント

Dockerを使用することで、「自分のPCでは動くのに他の環境では動かない」という問題を解消できます。全ての開発者が同じ環境で開発することで、環境差異によるバグを防止できます。 -

開発ツール:

- VSCode/PyCharm(IDE)

- Git(バージョン管理)

- pre-commit hooks(コードスタイル、リンターの自動実行)

- pytest(テスト実行)

📝 若手エンジニア向けメモ

pre-commit hooksは、コミット前に自動的にコードのチェックを行うツールです。コードスタイルの統一やリンターによるバグの早期発見など、コード品質を維持するのに役立ちます。最初は面倒に感じるかもしれませんが、長期的には大きなメリットがあります。

7.2.2 共有開発環境

チーム共有の開発環境:

-

構成:

- 開発環境(dev): 最新のコードを継続的にデプロイ

- テスト環境(staging): リリース候補のテスト用

- CI/CD用インフラ(GitHub Actions + セルフホストランナー)

- 共有データベースインスタンス

💡 学習ポイント

共有開発環境は、チームメンバー全員が同じ環境でテストできる場を提供します。ローカル環境では再現が難しい問題の検証や、複数人での統合テストに役立ちます。 -

データ管理:

- 匿名化された本番データのサンプル

- テスト用データセットの共有

- データリセット機能

7.2.3 DevOpsプラクティス

開発と運用の統合を促進するDevOpsプラクティスを導入します:

-

インフラストラクチャ・アズ・コード(IaC):

- Terraform による AWS リソース管理

- Kubernetes マニフェストによるコンテナ構成管理

- Helmチャートの活用

-

GitOps ワークフロー:

- Gitリポジトリを真実の源泉(Source of Truth)とする

- 環境設定の変更もプルリクエストで管理

- 変更の自動適用(ArgoCD など)

-

継続的インテグレーション(CI):

- 自動テスト実行

- コード品質チェック

- セキュリティスキャン

-

継続的デリバリー(CD):

- 開発環境への自動デプロイ

- ステージング環境への承認ベースデプロイ

- カナリアリリースの実施

📝 若手エンジニア向けメモ

DevOpsは「Development(開発)」と「Operations(運用)」を融合させた考え方です。従来は分離していた開発チームと運用チームの壁を取り払い、協力して品質の高いソフトウェアを素早くリリースし続けることを目指します。自動化や標準化によって、人的ミスを減らし、デプロイの頻度と信頼性を高めることができます。

7.3 テスト戦略

7.3.1 テスト駆動開発(TDD)

コア機能の開発ではTDDアプローチを採用します:

- 赤: まず失敗するテストを書く

- 緑: テストを通す最小限のコードを書く

- リファクタリング: コードを改善しながらテストを通し続ける

# TDDの例: 検索サービスのテスト

def test_search_by_keyword_returns_matching_restaurants():

# 1. 前提条件のセットアップ

repository = MockRestaurantRepository()

repository.add(Restaurant(id="1", name="ラーメン太郎", cuisine_type="ラーメン"))

repository.add(Restaurant(id="2", name="寿司花子", cuisine_type="寿司"))

search_service = SearchService(repository)

# 2. テスト対象の機能実行

results = search_service.search(keyword="ラーメン")

# 3. 期待される結果の検証

assert len(results) == 1

assert results[0].id == "1"

assert results[0].name == "ラーメン太郎"

💡 学習ポイント

TDDは「テストを先に書く」ことで、明確な要件定義と設計を促進します。また、自動テストによる早期のフィードバックにより、バグの早期発見と修正が可能になります。さらに、必要最小限のコードを書く習慣が身につき、シンプルで保守性の高いコードにつながります。

7.3.2 テストピラミッド

テストの種類とバランスを考慮したテスト戦略を実施します:

-

ユニットテスト(基盤: 多数):

- 個々のクラス、メソッド、関数の検証

- モックを使用した外部依存の分離

- 高速な実行と迅速なフィードバック

-

統合テスト(中間層: 中程度):

- コンポーネント間の連携検証

- 実際のデータベースとの連携

- エンドポイントごとの機能検証

-

E2Eテスト(頂点: 少数):

- 実際のユーザーフローの検証

- UI自動テスト(フロントエンド開発時)

- 本番に近い環境での実行

📝 若手エンジニア向けメモ

テストピラミッドは、テストの種類とその割合に関するベストプラクティスです。ベースとなる「ユニットテスト」を多く、頂点の「E2Eテスト」を少なく設計することで、テスト実行速度と信頼性のバランスを取ります。E2Eテストは実行に時間がかかり、不安定になりがちですが、ユーザーの視点からシステム全体を検証できる重要なテストです。

7.3.3 コード品質の確保

自動化されたコード品質チェックを導入します:

-

静的解析:

- pylint/flake8: コードスタイルとバグの可能性チェック

- mypy: 型チェック

- bandit: セキュリティ脆弱性チェック

-

コードカバレッジ:

- pytest-cov: テストカバレッジ計測

- 目標カバレッジ: ビジネスロジック95%、その他80%以上

- プルリクエスト時のカバレッジチェック

-

コードレビュー:

- プルリクエストベースのレビュー

- コードオーナーによる承認フロー

- レビューチェックリストの活用

# GitHub Actions での品質チェック例

name: Code Quality Checks

on:

pull_request:

branches: [ main, develop ]

jobs:

quality:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python

uses: actions/setup-python@v4

with:

python-version: '3.10'

- name: Install dependencies

run: |

python -m pip install --upgrade pip

pip install -r requirements-dev.txt

- name: Lint with flake8

run: flake8 .

- name: Type check with mypy

run: mypy .

- name: Security check with bandit

run: bandit -r .

- name: Run tests and check coverage

run: |

pytest --cov=app --cov-report=xml

coverage report --fail-under=80

💡 学習ポイント

静的解析ツールは、コードを実行せずに潜在的な問題を見つける強力な手段です。これらのツールをCI/CDパイプラインに組み込むことで、問題のあるコードがリポジトリに入り込むのを防ぎ、コードベースの品質を維持できます。また、型チェックなどは実行時エラーを事前に発見するのに役立ちます。

7.4 デプロイメント戦略

7.4.1 環境構成

段階的なデプロイメント環境:

-

開発環境(dev):

- 目的: 開発中の機能テスト

- データ: 匿名化した本番データのサブセット

- 更新頻度: 頻繁(1日複数回)

- アクセス: 開発チームのみ

📝 若手エンジニア向けメモ

開発環境は、新機能の開発やバグ修正のためのテスト環境です。本番環境との差異を最小限に抑えつつも、開発の自由度を確保するバランスが重要です。また、本番データを使用する場合は、個人情報などの機密データを適切に匿名化することが必須です。 -

ステージング環境(staging):

- 目的: リリース前の最終確認

- データ: 本番に近いデータセット

- 更新頻度: リリース前(週1-2回)

- アクセス: 開発チームとQAチーム

-

本番環境(production):

- 目的: 実サービス提供

- データ: 実データ

- 更新頻度: 計画的(月1-2回)

- アクセス: 厳格に制限

7.4.2 デプロイメント手法

安全で効率的なデプロイメントを実現する手法:

-

ブルー/グリーンデプロイメント:

- 2つの同一環境(ブルーとグリーン)を用意

- 片方に新バージョンをデプロイ

- テスト後にトラフィックを切り替え

- 問題発生時は即座に元の環境に戻せる

-

カナリアリリース:

- トラフィックの一部(例: 10%)だけを新バージョンに流す

- 段階的に新バージョンへのトラフィックを増やす

- 問題があれば早期に発見でき、影響範囲も限定的

💡 学習ポイント

従来の「ビッグバンリリース」(一度に全ての環境を新バージョンに切り替える)と比較して、ブルー/グリーンデプロイメントやカナリアリリースは、リスクを分散し、問題発生時の影響を最小化できます。特に本番環境での予期せぬ問題に対して素早く対応できる点が大きな利点です。

7.4.3 リリース管理

リリースプロセスの標準化と品質確保:

-

リリース計画:

- スプリントごとのリリース候補の特定

- リリースノートの作成

- 依存関係の確認

-

リリース前チェックリスト:

- 全テストの合格確認

- パフォーマンステストの実施

- セキュリティチェックの完了

- ドキュメントの更新

-

リリース後の検証:

- リリース直後のモニタリング強化

- カナリアリリースの段階的進行

- ロールバック手順の準備

📝 若手エンジニア向けメモ

リリース管理は、「作ったものを安全に届ける」プロセスです。いくら良い機能を開発しても、リリース時にトラブルが発生しては意味がありません。リリース計画の立案、事前確認、リリース実行、事後確認という一連のプロセスを標準化することで、安定したリリースが可能になります。

7.5 運用計画

7.5.1 日常運用

日々の運用タスク:

-

監視:

- ダッシュボード確認(1日2回)

- アラート対応(随時)

- パフォーマンス傾向分析(週1回)

-

バックアップ:

- データベース: 日次フルバックアップ + 時間単位増分

- 設定ファイル: 変更時バックアップ

- ログ: 週次アーカイブ

💡 学習ポイント

バックアップは取るだけでなく、「リストア(復元)」のテストも定期的に行うことが重要です。実際の障害時にバックアップからの復旧ができなければ、バックアップの意味がありません。 -

定期メンテナンス:

- OS/ミドルウェアパッチ適用(月1回)

- 不要データのクリーンアップ(月1回)

- パフォーマンス分析と改善(隔月)

7.5.2 障害対応

障害発生時の対応手順:

-

検知:

- 自動アラート

- ユーザー報告

- 定期チェック

📝 若手エンジニア向けメモ

障害は早期発見が重要です。ユーザーからの報告を待つのではなく、監視システムによる自動検知を目指しましょう。「ユーザーより先に問題を知る」ことがベストです。 -

初期対応:

- 影響範囲の評価

- 一時的な緩和策の実施

- 関係者への通知

💡 学習ポイント

初期対応では、まず影響範囲を把握し、可能な限り迅速に影響を最小化する「緩和策」を講じることが重要です。例えば、問題のあるサーバーを一時的に切り離す、キャッシュを活用するなどの対応が考えられます。 -

根本解決:

- 原因分析

- 修正実施

- 確認テスト

-

事後処理:

- 障害報告書作成(ポストモーテム)

- 再発防止策の実施

- 監視・アラートの見直し

7.5.3 SRE(Site Reliability Engineering)のプラクティス

信頼性の高いサービス運用のためのSREプラクティス:

-

SLO (Service Level Objectives)の設定と追跡:

- 可用性、レイテンシ、エラー率などの目標値

- エラーバジェットの概念の導入

-

障害対応の自動化:

- Runbook の整備

- 自動修復の仕組み導入

- ChatOps によるオペレーション効率化

-

継続的な改善:

- ポストモーテム文化の醸成

- 「非難なし」の原則

- 再発防止に重点を置く

💡 学習ポイント

SREは、Googleが提唱したサービスの信頼性を向上させるための考え方と実践手法です。従来の「運用」をソフトウェアエンジニアリングの視点で捉え直し、自動化や定量的分析を重視します。特に「エラーバジェット」という考え方は、信頼性と革新のバランスを取るための有効な手段です。

7.6 若手エンジニア向け:段階的な学習アプローチ

本システムは複雑ですが、段階的に学習することで理解を深めながら進めることができます。以下に、若手エンジニア向けの学習ステップを示します。

7.6.1 基礎フェーズ(1-2ヶ月)

目標: システムの基本的な構造と主要技術の理解

学習内容:

- Python基礎とFastAPI入門

- PostgreSQLの基本操作

- RESTful APIの概念理解

- Gitによるバージョン管理

📝 実践タスク例

- 簡単なCRUD操作を行うAPIエンドポイントの実装

- PostgreSQLを使ったデータベース操作

- Gitを使ったコード管理と簡単なプルリクエスト

7.6.2 応用フェーズ(2-3ヶ月)

目標: システムの主要コンポーネントの実装と連携

学習内容:

- API開発の応用(パラメータ検証、エラーハンドリング)

- Elasticsearchによる検索実装

- ユニットテストとテスト駆動開発

- Docker基礎

📝 実践タスク例

- APIの拡張と改善

- Elasticsearchを使った検索機能の実装

- 作成したコードのユニットテスト作成

- Dockerを使った開発環境の構築

7.6.3 発展フェーズ(3-6ヶ月)

目標: システム全体の理解と高度な機能の実装

学習内容:

- 高度なAPI機能(キャッシュ、非同期処理)

- Redis キャッシュの活用

- パフォーマンスチューニング

- CI/CDとDevOpsの実践

📝 実践タスク例

- Redisを使ったキャッシュ機能の導入

- APIのパフォーマンス最適化

- GitHub Actionsを使ったCI/CDの構築

- Kubernetes上での展開

7.6.4 学習のコツ

-

小さく始めて継続する:

- 「1日30分」など、無理のない範囲から始める

- 習慣化のために同じ時間帯に学習する

- 小さな成功体験を積み重ねる

-

アクティブラーニング:

- 受動的な読書ではなく、実際にコードを書く

- 疑問点を実験で確かめる

- 「分かった気」にならずに実践する

-

チームでの学び合い:

- わからないことは先輩に質問する

- 学んだことを他のメンバーと共有する

- コードレビューを積極的に活用する

💡 学習ポイント

学習の進捗は人それぞれです。自分のペースで着実に進めることが大切です。また、全ての技術を深く理解する必要はなく、必要な部分から優先的に学んでいくことが効率的です。

7.7 アジャイル開発とウォーターフォール開発の比較

プロジェクトの特性に応じた開発手法の選択のために、主要な開発方法論の比較を行います。

7.7.1 開発手法の特徴

| 特徴 | アジャイル | ウォーターフォール |

|---|---|---|

| 開発サイクル | 反復的、インクリメンタル | 線形、シーケンシャル |

| 要件の柔軟性 | 変更に対応 | 最初に固定 |

| 顧客フィードバック | 頻繁(スプリントごと) | 主に開発後 |

| ドキュメンテーション | 必要最小限 | 包括的 |

| リスク管理 | 早期発見・対応 | 前工程での予測 |

| 適したプロジェクト | 変化が予想される、革新的 | 要件が明確、規制が厳しい |

| チーム構成 | 小規模、クロスファンクショナル | 専門性に基づく分業 |

7.7.2 ハイブリッドアプローチ

実際のプロジェクトでは、両方の手法の長所を取り入れたハイブリッドアプローチが有効な場合もあります:

- 計画段階: 要件の明確化、大まかなアーキテクチャ設計など、ウォーターフォール的なアプローチ

- 実装段階: 機能ごとの反復的な開発、定期的なレビューなど、アジャイル的なアプローチ

- リリース段階: 体系的なテスト、ドキュメント整備など、ウォーターフォール的なアプローチ

📝 若手エンジニア向けメモ

どの開発手法が「正しい」ということはなく、プロジェクトの性質(規模、複雑さ、要件の明確さ、リスク許容度など)に合わせて適切な手法を選択または組み合わせることが重要です。また、手法自体よりも、チームの協働やコミュニケーションといった原則を重視することで、どの手法でも成功確率を高められます。

7.7.3 本プロジェクトでのアジャイル採用理由

本プロジェクトでアジャイルを採用した主な理由:

- 要件の不確実性: ユーザーニーズが全て明確でなく、フィードバックを取り入れながら進化させる必要がある

- 技術的な探索: いくつかの技術選択や実装アプローチは実際に試しながら評価する必要がある

- 早期価値提供: コア機能から段階的にリリースすることで、早期に価値を提供し、フィードバックを得たい

- チーム構成: 小規模な横断的チームで柔軟に協力しながら開発を進める体制に適している

🔍 チェックポイント

- アジャイル開発のプラクティスと利点を説明できる

- テストピラミッドの考え方と各テストレベルの目的を理解している

- CI/CDパイプラインの構成要素と利点を説明できる

- デプロイメント手法(ブルー/グリーン、カナリア)の違いを理解している

- 若手エンジニアとしての段階的な学習アプローチを計画できる

第8章:技術的な考慮事項

📚 この章で学ぶこと

- データ収集APIの効率的な利用方法

- データ処理とストレージの最適化テクニック

- 検索パフォーマンスを向上させる方法

- 運用管理を容易にするアプローチ

🔑 重要な概念

- APIアクセスの最適化

- データの正規化と統合

- 検索インデックスの最適化

- 監視とロギングの重要性

8.1 データ収集の効率化と安定性

8.1.1 API利用の最適化

外部APIを安定して効率的に利用するための戦略:

-

レート制限の遵守:

- APIごとの制限に合わせた呼び出し頻度の調整

- バースト制限と時間枠制限の両方を考慮

- トークンバケットアルゴリズムの実装

💡 学習ポイント

トークンバケットアルゴリズムは、API呼び出しのレート制限を実装する効果的な方法です。一定の間隔でバケットにトークンが追加され、各API呼び出しでトークンを消費します。バケットが空になると、トークンが追加されるまで待機します。 -

エラー処理:

- 一時的なエラーの自動リトライ

- 指数バックオフアルゴリズム

- 永続的なエラーの記録と通知

# 指数バックオフを用いたAPIリクエスト例

def fetch_with_retry(url, max_retries=5, base_delay=1, max_delay=60):

retries = 0

while retries < max_retries:

try:

response = requests.get(url, timeout=10)

response.raise_for_status()

return response.json()

except (requests.exceptions.RequestException, ValueError) as e:

retries += 1

if retries >= max_retries:

logger.error(f"Failed after {max_retries} attempts: {url}")

raise MaxRetriesExceeded(f"Failed after {max_retries} attempts") from e

# 指数バックオフ計算 (1, 2, 4, 8, 16...)

delay = min(base_delay * (2 ** (retries - 1)), max_delay)

# ランダム要素の追加 (±30%)

jitter = random.uniform(0.7, 1.3)

sleep_time = delay * jitter

logger.warning(f"Retry {retries}/{max_retries} after {sleep_time:.2f}s due to: {e}")

time.sleep(sleep_time)

-

認証管理:

- APIキーやトークンの安全な保管

- トークン更新の自動化

- 複数アカウントでの負荷分散(必要な場合)

8.1.2 バッチ処理の効率化

バッチ処理の最適化手法:

-

並列処理:

- マルチスレッドまたはマルチプロセス

- 非同期I/O(asyncio)の活用

- タスクキューシステム(Celery等)の活用

📝 若手エンジニア向けメモ

並列処理は処理速度を向上させますが、適切なタスク分割とリソース管理が重要です。特にI/O待ちの多いタスク(APIリクエストなど)では、非同期処理が効果的です。 -

バッチサイズの最適化:

- メモリ使用量とスループットのバランス

- 変動するデータ量への対応

- 処理の進捗を追跡可能な粒度

-

障害復旧:

- チェックポイント機能

- 再開可能な設計

- トランザクション整合性の確保

8.2 データ処理とストレージ

8.2.1 データ検証と正規化

収集したデータに対して以下の処理を行います:

-

データ検証:

- スキーマ検証

- 必須項目の確認

- データ型チェック

- 異常値検出

📝 若手エンジニア向けメモ

データ検証は、不正なデータがシステムに入り込むのを防ぐ最初の防衛線です。例えば、電話番号が数字とハイフンのみで構成されているか、郵便番号が正しい形式かなどをチェックします。 -

データ正規化:

- 住所の正規化(都道府県、市区町村、番地などの分離)

- 電話番号の正規化(ハイフン統一など)

- 営業時間の構造化(開始時間、終了時間の分離)

- 料理ジャンルの標準化(表記揺れ対応)

💡 学習ポイント

異なるソースから収集したデータは、同じ情報でも表記が異なる場合があります。例えば、「イタリアン」と「イタリア料理」は同じカテゴリを指しますが、表記が違います。これらを統一することで、検索や集計が正確になります。

8.2.2 重複検出と統合

同一店舗の特定と情報統合のための処理:

-

重複検出アルゴリズム:

- 店名の類似度計算(レーベンシュタイン距離など)

- 位置情報の近接性評価(地理的距離)

- 電話番号の一致確認

- 複合スコアリングによる判定

📝 若手エンジニア向けメモ

レーベンシュタイン距離とは、2つの文字列がどれだけ似ているかを数値化する方法の一つです。例えば、「すし太郎」と「寿司太郎」は表記は違いますが、類似度が高いと判断できます。 -

情報統合ルール:

- 情報源の信頼性による優先順位付け

- 最新データの優先

- 詳細度の高いデータの優先

- 矛盾するデータの解決戦略

8.2.3 データベース最適化

パフォーマンスとスケーラビリティを確保するためのデータベース設計:

-

インデックス戦略:

- 検索クエリに適したインデックス設計

- 複合インデックスの活用

- インデックス更新オーバーヘッドの考慮

💡 学習ポイント

インデックスは検索を高速化しますが、書き込み時のオーバーヘッドも増加させます。よく使われる検索条件に合わせてインデックスを設計し、不要なインデックスは作成しないことが重要です。 -

パーティショニング:

- 地域別または時間別のデータ分割

- クエリパフォーマンスの向上

- メンテナンス性の向上

-

読み取りレプリケーション:

- 読み取り負荷の分散

- 地理的な冗長性

- レプリケーション遅延の考慮

8.3 検索パフォーマンスの最適化

8.3.1 Elasticsearchインデックス設計

効率的な検索を実現するためのElasticsearchインデックス設計:

-

インデックス戦略:

- 季節や地域に基づくシャーディング

- 適切なシャード数の設定

- レプリカによる冗長性と読み取りパフォーマンスの向上

📝 若手エンジニア向けメモ

Elasticsearchのインデックスは、内部的に「シャード」と呼ばれる単位に分割されます。適切なシャード数とサイズの設定が、パフォーマンスに大きく影響します。シャードが多すぎると管理オーバーヘッドが増加し、少なすぎると並列処理の恩恵を受けられません。 -

マッピング最適化:

- フィールドタイプの最適化

- 解析器の適切な選択

- マルチフィールド定義(例:同じデータに対して全文検索用と完全一致検索用の両方のフィールドを定義)

// 店名フィールドのマルチフィールド定義例

"name": {

"type": "text",

"analyzer": "kuromoji",

"fields": {

"keyword": {

"type": "keyword"

}

}

}

8.3.2 クエリ最適化

検索クエリの効率化方法:

-

クエリ構造の最適化:

- フィルターコンテキストの活用(bool/filter)

- クエリ文字列の事前解析と最適化

- 複合条件の効率的な構築

💡 学習ポイント

Elasticsearchでは、「クエリコンテキスト」と「フィルターコンテキスト」という2つの検索モードがあります。スコアリング(関連度計算)が必要ない条件は、フィルターコンテキストで記述することで、パフォーマンスが向上し、結果もキャッシュされやすくなります。 -

ページネーション最適化:

- search_after方式の採用(深いページ対応)

- カーソルベースのページネーション

- 最大結果数の制限(10,000件)

-

集約クエリの最適化:

- ファセット検索の効率的な実装

- 適切なバケットサイズ

- キャッシュの活用

8.3.3 キャッシュ戦略

Redisを使った効果的なキャッシュ戦略:

-

キャッシュレベル:

- クエリレベル: 同一検索条件の結果をキャッシュ

- エンティティレベル: 頻繁にアクセスされる個別店舗情報

- 計算値レベル: 集計結果や導出データ

-

TTL(生存時間)設定:

- 人気検索クエリ: 1時間

- 店舗詳細情報: 24時間

- ランキングデータ: 12時間

- メタデータ: 48時間

📝 若手エンジニア向けメモ

キャッシュの「鮮度」と「ヒット率」はトレードオフの関係にあります。TTL(Time To Live)を短くすると最新データが反映されやすくなりますが、キャッシュミスが増えてデータベースへの負荷が高まります。逆に長くすると古いデータが表示される可能性がありますが、キャッシュヒット率が向上します。 -

キャッシュ無効化戦略:

- 更新イベントに基づく選択的無効化

- パターンベースの無効化(プレフィックス指定)

- 定期的な全キャッシュ更新(深夜)

8.4 運用管理の容易性

8.4.1 ログ収集と分析

効果的なログ管理戦略:

-

ログ構造:

- JSON形式の構造化ログ

- 標準フィールド(タイムスタンプ、レベル、コンポーネントなど)

- コンテキスト情報(リクエストID、ユーザーIDなど)

- 詳細エラー情報(スタックトレースなど)

💡 学習ポイント

構造化ログ(特にJSON形式)は、後からの検索や分析が容易です。例えば、特定のユーザーに関するログだけを抽出したり、エラーレベルごとに集計したりといった操作が簡単になります。また、リクエストIDのような「相関ID」を各ログに含めることで、複数のコンポーネントを跨ぐ一連の処理を追跡することができます。 -

集中ログ管理:

- ELK(Elasticsearch, Logstash, Kibana)スタックの活用

- ログの集約と検索機能

- ダッシュボードによる可視化

-

ログの活用方法:

- パターン分析によるシステム診断

- 異常検知のためのベースライン確立

- ユーザー行動分析への応用

8.4.2 メトリクス収集

システムのパフォーマンスと状態を監視するためのメトリクス収集:

-

収集すべきメトリクス:

- インフラメトリクス(CPU, メモリ, ディスク, ネットワーク)

- アプリケーションメトリクス(レスポンス時間, エラー率, リクエスト数)

- ビジネスメトリクス(ユーザーアクション, 機能利用状況)

-

監視ダッシュボード:

- リアルタイムモニタリング

- トレンド分析

- アラート状態の可視化

📝 若手エンジニア向けメモ

メトリクスは、システムの健全性を数値で表します。例えば、「レスポンス時間が急に長くなった」「エラー率が上昇した」などの異常を早期に検知できるようになります。また、時系列データとして蓄積することで、システムの変化を追跡し、将来の傾向を予測することも可能になります。

8.4.3 コンテナ監視

コンテナ環境でのモニタリング:

-

Kubernetes監視:

- ノードとポッドの健全性

- リソース使用率

- オートスケーリングイベント

-

サービスメッシュ:

- サービス間通信の監視

- トレーシングの実装

- トラフィック制御

-

DevOpsツールの連携:

- CI/CDパイプラインとの連携

- 障害検知時の自動ロールバック

- セルフヒーリング機能

8.4.4 セキュリティ監視

セキュリティの継続的な監視と対応:

-

脆弱性スキャン:

- コードスキャン(SAST)

- コンテナイメージスキャン

- 依存パッケージのセキュリティ監視

-

異常検知:

- 異常なアクセスパターンの検出

- 権限昇格の監視

- データ流出の兆候検知

-

インシデント対応:

- セキュリティイベントの自動分類

- インシデント対応ワークフローの自動化

- セキュリティチームとの連携

8.5 若手エンジニア向け解説:実装時の注意点

システムを実装する際に、若手エンジニアが特に注意すべきポイントをいくつか紹介します:

8.5.1 コードの品質

-

シンプルさを重視する:

- 複雑な解決策より、理解しやすいシンプルな解決策を選ぶ

- 「賢すぎる」コードは保守が難しくなりがち

- 「今日の賢いコードは明日のレガシーコード」という格言を覚えておく

-

ドキュメントとコメント:

- コードは「何をしているか」、コメントは「なぜそうしているか」を説明

- 複雑なロジックには必ずコメントを残す

- 関数やクラスには適切なドキュメント文字列を記述

-

エラー処理:

- 例外は具体的に捕捉し、漠然とした except: は避ける

- エラーメッセージは具体的かつ有用な情報を含める

- ユーザーに表示するエラーと内部ログは区別する

# 良くない例 try: data = process_data() except: print("Error occurred") # 良い例 try: data = process_data() except ValueError as e: logger.error(f"Invalid data format: {e}") return {"error": "データの形式が不正です"} except IOError as e: logger.error(f"Failed to read data: {e}") return {"error": "データの読み込みに失敗しました"}

8.5.2 パフォーマンスの考慮

-

早すぎる最適化を避ける:

- まずは正しく動作するコードを書く

- 実際にボトルネックが特定された部分のみ最適化する

- プロファイリングツールを活用して問題箇所を特定する

-

メモリ使用量に注意:

- 大量のデータを扱う場合は、ストリーミング処理を検討

- 不要なオブジェクトは適切に解放する

- 特に長時間実行するバッチ処理ではメモリリークに注意

-

データベースアクセスの最適化:

- 必要最小限のデータだけを取得する(全カラムの取得を避ける)

- 適切なインデックスを設定する

- N+1問題を避ける(ループ内でのデータベースクエリ)

# 良くない例(N+1問題) restaurants = db.query(Restaurant).all() for restaurant in restaurants: reviews = db.query(Review).filter(Review.restaurant_id == restaurant.id).all() # レビュー処理... # 良い例(ジョインを使用) restaurants_with_reviews = db.query(Restaurant).join(Review).all()

8.5.3 セキュリティの基本

-

ユーザー入力の検証:

- すべての入力データをバリデーションする

- クライアント側の検証だけでなく、サーバー側でも必ず検証する

- パラメータ化されたクエリを使用してSQLインジェクションを防ぐ

-

機密情報の管理:

- パスワードやAPIキーなどをハードコーディングしない

- 環境変数や設定ファイルを使用する

- バージョン管理システムに機密情報をコミットしない

-

適切な権限管理:

- 最小権限の原則に従う

- データベースアクセスやAPIアクセスに適切な権限制限を設ける

- デフォルトで「拒否」し、必要な権限のみを明示的に許可する

8.5.4 デバッグとトラブルシューティング

-

効果的なロギング:

- 適切なログレベルを使い分ける(DEBUG, INFO, WARNING, ERROR, CRITICAL)

- コンテキスト情報を含めたログメッセージを残す

- 機密情報はログに残さない

-

段階的なデバッグ:

- 問題を小さく分割して一つずつ解決する

- 仮説を立ててテストするアプローチを取る

- デバッグツール(pdb, ipdb など)の活用

-

リグレッションテスト:

- バグ修正後は、同じバグが再発しないことを確認するテストを追加

- 「これは直ったはず」と思い込まず、必ず検証する

- 自動テストでカバーできない場合は、手順書を残す

💡 学習ポイント

コーディングは技術的なスキルだけでなく、「職人技」の側面もあります。良いコードを書くには経験が必要ですが、先人の知恵(設計パターン、ベストプラクティスなど)を学ぶことで近道ができます。また、他の人のコードを読むことも非常に効果的な学習方法です。

📝 若手エンジニア向けメモ

完璧なコードを書こうとして身動きが取れなくなるよりも、まずは「動くコード」を書き、それを徐々に改善していく方がはるかに効率的です。また、わからないことを質問することは決して恥ではありません。むしろ、質問しないことの方が長期的には問題を引き起こします。

🔍 チェックポイント

- API利用の最適化方法(レート制限、エラー処理など)を理解している

- データ処理とストレージの最適化テクニックを説明できる

- Elasticsearchでのインデックス設計とクエリ最適化のポイントを理解している

- ログ収集とメトリクス監視の重要性と実装方法を説明できる

- コード品質、パフォーマンス、セキュリティの基本的な考慮事項を理解している

第9章:将来の拡張性

📚 この章で学ぶこと

- システムの長期的な成長と進化の計画

- 機能と容量の両面での拡張性の確保方法

- 技術的な負債を最小限に抑えるアプローチ

- マイクロサービスへの段階的移行戦略

🔑 重要な概念

- スケーラブルなアーキテクチャ設計

- 段階的な機能拡張のプランニング

- 技術的な柔軟性と変更容易性

- ドメイン駆動設計による境界の明確化

9.1 機能拡張ロードマップ

将来的に実装を検討している機能:

-

フェーズ2:

- 予約状況の表示と連携

- メニュー情報の拡充

- モバイルアプリ対応のAPI拡張

📝 若手エンジニア向けメモ

機能拡張は、ユーザーの需要や技術的な実現可能性を考慮して計画することが重要です。また、各フェーズで追加する機能は、互いに関連性があるものをグループ化すると、開発効率や一貫性の面でメリットがあります。例えば、予約機能とメニュー情報は、ユーザーが予約する際の判断材料として関連性が高いです。 -

フェーズ3:

- パーソナライズされたレコメンデーション機能

- ソーシャルサインインと口コミ機能

- 高度な検索フィルター(アレルギー対応、席タイプなど)

💡 学習ポイント

大きな機能追加(例:レコメンデーション機能)は、アーキテクチャやデータモデルに大きな影響を与える可能性があります。そのため、初期設計の段階から、そのような拡張の可能性を考慮しておくことが重要です。例えば、ユーザープロファイルや行動履歴をモデル化できるような柔軟なデータ構造を採用しておくと良いでしょう。 -

フェーズ4:

- 他業種(宿泊施設、観光スポットなど)への拡大

- AI搭載チャットインターフェース

- APIマーケットプレイス(サードパーティ開発者向け)

📝 若手エンジニア向けメモ

長期的な拡張計画は、ビジョンを持って進めることが大切ですが、市場やユーザーニーズの変化に応じて柔軟に調整する準備も必要です。また、各フェーズの終了時には、次のフェーズの内容を見直し、優先順位を再評価するプロセスを設けることをお勧めします。

9.1.1 機能拡張の設計原則

新機能追加時に考慮すべき設計原則:

-

既存機能との整合性:

- 一貫したユーザー体験

- 統一された用語と概念

- 相互運用性の確保

-

拡張ポイントの活用:

- プラグインアーキテクチャの利用

- 設定による機能拡張

- フィーチャーフラグの活用

-

段階的リリース:

- A/Bテストによる検証

- カナリアリリースの活用

- フィードバックループの確立

💡 学習ポイント