タイトルのとおりです。クラウドソーシングにおける報酬設定について。

MTurkを中心に進めていきますが、他のプラットフォームでの考え方にも大体共通かと思っています。

合わせて読みたい過去記事:

TL;DR

今回とて長編の記事となってしまったので、結論から言うと、

最低賃金をベースに、時給換算して考える

ことを基本とします。

MTurkに関しては、米国の最低賃金7.25 USD/hを基準に、HITの所要時間から最低単価を計算します。例えば所要時間が5分なら、1HITあたりの金額は

\$7.25 \times \frac{5}{60} \approx \$0.60

となります。あくまで最低単価の一般的な相場であり、下限値の基準であることに注意してください。

もし人によって作業時間に大きい差が開く恐れがあったり、タスクが専門性を伴うなどの場合、より高めに設定することは歓迎されます。

現状

クラウドソーシングを使う時に大半の人が持つ疑問の一つとして、「タスク単価っていくらがいいの?」があると思います。プラットフォーム側で自動で調節してくれればいいものの、これがなかなか難しい問題で、それぞれの作られたタスクで「これが適切な単価だ!」という明確な基準がありません。タスク・ワーカーいずれにも多様性を伴い、一律には決まらないからです。

2021年1月現在、多くのクラウドソーシングプラットフォームにおいてワーカーは"Independent contractor (独立した契約者)"として扱われており、労働基準法の外にあるため、タスク単価をいくらに設定しようがルール違反みたいなことはありません。

そこで、リクエスタの立場としては安ければ安いほど嬉しいわけなので、実際に時給換算して数ドルとか、下手すると更に1ドルにすら満たないタスクは色んなプラットフォームで多く見受けられます。

一方、低報酬なタスクが生まれてしまう原因は必ずしも故意とも限りません。そもそも単価設定の知識がないために適当に設定してしまったり、予算と集めたいデータ規模から逆算してしまったりすることも考えられるし、知識はあっても自分のタスクに必要な労力(=所要時間)を見積もり誤ってしまうケースもあります1。

理由はどうあれ、ワーカーの搾取は避けなければなりません。クラウドソーシング市場の健全性を考えれば言わずもがなですが、今までの様々な研究成果からはリクエスタのデメリットに繋がる要素もいくつも指摘されてきていますので、いずれにせよタスク単価の設計は怠らずにしっかり行うのが吉です。そのためには、報酬額の相場感を正しく理解し、自分のタスクに適切に反映させていけるようになることが大切です。

コラム(私見): 「クラウドソーシングは安い」への勘違い

「クラウドソーシングを用いることでコストを安く抑えられます」的な文言をあちこちで聞きますが、誤用されていることが多いように感じます。その言葉自体は正しい場合もあるのですが、タスク単価を(不当に)安く設定していいという理解は間違いだと思います。

例えば、ある程度事前知識が必要な機械学習のデータラベリングタスクで、それも数万・数十万サンプルと欲しい場合。方法の1つとしては、ラベリング能力のある専門家を雇うことが挙げられると思います。そのとき、

- 専門性や一人への負担などを考え、ある程度高めに設定された報酬

- 1〜数人しか雇わない場合、雇用主側がラベリング結果を二重チェックする人件費

- 派遣会社などから来た人であれば、紹介手数料

- データセットができるまでの何週間、何ヶ月により遅延したプロジェクト進捗(によるビジネスの遅れ)

などなど色々経費がかかるものです。

でもクラウドソーシングのうまい使い方を知っていれば、例えば専門性が必要なラベリングタスクをサブタスクに分解し、素人でも作業可能な内容に噛み砕いてタスクを再設計することで、クラウドソーシングを用いた場合でも負けないぐらいの精度で、(しかも短期間で)手に入れることが可能となりうる2んです。このとき、必要な経費は

- 平均的(かつ倫理的)なワーカー報酬によるラベリング費用

だけで済むということです。

このように、クラウドソーシングを"うまく"利用することで**「結果として」**低コストで済む可能性は十分にあるのですが、手軽に操作可能となっている目先の「タスク単価」を安くできると短絡的に解釈してしまっているケースが多いのでは...と思います。

※関連して、コンペ型のWinner-takes-all形式もどうなの?とか思ったりします

報酬額の計算方法

基本的な考え方

冒頭でも書いた通り、MTurkでは米国の最低賃金である7.25 USD/hが最低ボーダーであるべきとされています。

リクエスタ側とワーカー側双方の国籍・居住国に多様性がある中で一体いくらが適正なのかというのは、公正取引だとかをはじめ色々な難しい議論を伴うため一概には言えないのですが、少なくとも研究者の間ではこれが保証されるべきスタンダードと見なされているようです345。米国基準である主な理由としては、

- ワーカーの多数派が米国在住者(2017年11月時点では、米国在住者が75%、ついでインド在住者が16%6)

- 次にワーカー人口が多いインドよりも物価が高い(高い方に合わせる)

- MTurkが報酬支払いの通貨として米ドルを採用している

など、色々な理由があるのだと思います。

ちなみに参考までに、近年人気が出てきたProlificというプラットフォームでは、**£5.00 ($6.50)**を下限値、**£7.50/h ($9.60/h)**を推奨値としており、タスク単価計算ツールで金額シミュレーションが簡単にできるように公式でサポートしているようです。いずれにせよ、このぐらいの価格帯であることをまず知っておきましょう。

報酬額計算4ステップ

実際にHITへ値段をつけるときは、以下の手順で行うといいのではと思います。

①作ったHITを自分でやってみる

まず、Sandboxを使うなどして、実際のワーカーと同じUIを用いていくつかのHITをSubmitし、かかる時間を測定しましょう。この時、作業手順・注意事項などに目を通す時間や、ウェブページを読み込む際に生じうるおおよその時間も考慮します。

②測定した作業時間に少し上乗せする

自分が作ったHITは自分が一番良く知っているので、作業時間が短めである可能性が高いからです。上乗せする幅は、私は大体大雑把にやってしまうのですが、おおよその分散を意識しながら決めるといいと思います。

③時給換算で最低賃金を下回らない金額を算出する

何のことはない算数です。

(タスク単価下限額) = (最低賃金時給) \times \frac{(推定\text{HIT}所要時間)}{60(分)}

平均30秒(バッファで+15秒)で終わる文章書き起こしHITなら

7.25 \times \frac{0.5+0.25}{60} \approx \$0.09 / \text{HIT}

平均10分(バッファで+3分)で終わるアンケートHITなら

7.25 \times \frac{10+3}{60} \approx \$1.57 / \text{HIT}

とかになります。

④少ない数のHITを投げてみて、適宜修正する

上記の見積もりがズレてる可能性があるので、試しに5~10HITぐらい投げてみましょう。ワーカーの作業時間をチェックして、想定した所要時間より長ければ金額を上げるべきだし、逆に短かった場合も、(明確な意図がない限り)$50/hとか払い続ける必要はありません。

ここで投げるHITはできるだけ小さい数に収めたいところですが、あまり少なすぎても全体の統計が見えてこないので適宜調整しましょう。

低報酬のデメリット

そうは言っても、べつにもっと安くてよくない?いっぱいデータ必要なんだよ!

と一瞬でも思ってしまう気持ちは否定しません。実際、少しぐらい安くたって数自体は割とすんなり集まるんです。

でも残念、実は相応のデメリットは返ってきますので、やはり自分のためにも適正報酬にするのが吉です。

①アカウントに悪評が立つ

間接的にですが、賢い・効率の良いワーカーほど集まりにくくなります。

詳しくはいつか別記事で書きたいのですが、ワーカー同士がタスクやリクエスターの評判を交換しているコミュニティサイトがいくつか存在します。目ぼしいものだけでも、

などが挙げられます。色々特徴が違うのですが、主に上2つはワーカーの点数評価(報酬妥当性、コミュニケーションなどの複数軸)+口コミと、その測定・投稿・閲覧をしやすくするツールの提供などにより、ワーカーの必須サービスとして市民権を得ています。後者2つはRedditなので掲示板的側面が強く、もっと周辺情報の共有や議論も含めた交流の場として、こちらも多くのユーザーがいます。

実際にワーカーとなって作業してみると分かるのですが、MTurkでオール自力で安定して稼いでいくのは本当に至難の業(というか競争が激しくて実質不可能)な状態で、その中で生き残っていくためにはこうしたコミュニティで積極的に情報を仕入れ、より良いリクエスタ・良いタスクを選んでいくしかない7のだそうです。

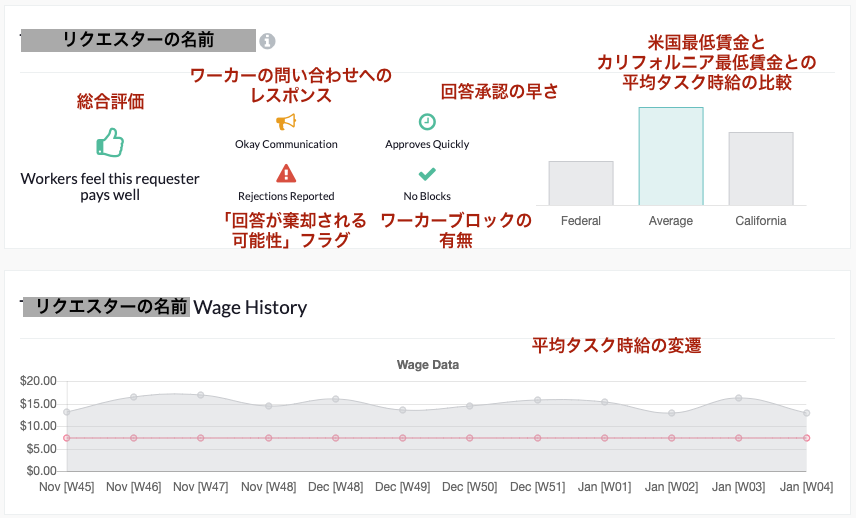

こうした状況の是非はさておき、そんな世界なので、ひとたびHITを投げれば口コミがどんどん蓄積されていきます。TurkerViewを例に挙げると、

リクエスターのサマリーはこんな感じで見られるようになっていて、ちゃんとお金を支払ってくれるリクエスターなのかどうかが実績から一目瞭然です。

これに加え、下にスクロールしていくと一人ひとりのワーカーの詳細な口コミや、実際にかかった時間から算出した時給などが見られるようになっています。詳しくは是非ログインして色々チェックしてみてください。

先程触れたように、ワーカー作業に慣れた人ほどこうした手段を使い、評判の良いリクエスター・タスクから選択していきます。さらに、こうしたサービスのユーザーはどんどん増えています。つまりタスクの報酬が不当に低くなってしまうと、、結果は簡単に想像できますね。

②選択バイアスが生じる

単に①の結果そうなるという話でもあるのですが。

Six Silbermanらの声明8によると、低報酬タスクでは集まったワーカーが正しい母集団を代表するワーカーとならない可能性があるとのことです。特にアンケートタスクのようなHITは玄人ワーカーの多くに好まれないことが知られており、その理由はやはり労力に見合う報酬額であることが少ないからです。もちろんフェアな報酬額に設定することでそういったワーカーも集められる見込みがありますが、そうでなければ、せっかくアンケートを行ったのに被験者グループに偏りが生じてしまうということになります。

③多数の低報酬タスクを全体に投げるより、少数の高報酬タスクを限定的に投げるほうが精度が良い

同じくSix Silbermanらの声明8をもとにしています。

同じ予算を使うなら、高報酬のタスクを律儀に投げていくより、低報酬のタスクの回答をより多く集めて、事後的に目視チェックなり品質保証アルゴリズムを適用するなりしたほうが精度が良くなるのでは?という疑問が生まれるかもしれません。実際に、タスクの報酬をどんどん上げていっても精度は上がらないと報告した研究9もあります。しかし、これはワーカー全体へ投げるタスクの報酬を単に上げていった場合の話で、別の方法で効果的にお金をかけるのであれば話は違ってきます。

MTurkにはQualificationと呼ばれる、事前テスト結果から判断した適正に基づいてワーカーをフィルタリングし、それ以外のワーカーにはタスクを閲覧or開始できないようにする機能があります。当然集められるワーカー数の分母は限られるし、事前テストを行うための追加の費用はかかるのですが、その分パフォーマンスが保証されたワーカーを狙って集められるため、結果的に同じ値段をかけた場合の集めたデータセットは比較的精度が高くなるのだそうです10。

おわりに

色々言いましたが、まずはMTurkなら最低賃金($7.25/h)を基準に!です。

ただ、これは日本と米国の最低賃金がそこまで大きく違わない(または日本のほうが高い)から言えることなんですが...(今更

仮にそうじゃない場合はどうなの?っていうのは、また別の機会で。

-

Responsible Research with Crowds: Pay Crowdworkers at Least Minimum Wage - https://mags.acm.org/communications/march_2018/?folio=39&&pg=41#pg41 ↩

-

Storia: Summarizing Social Media Content based on Narrative Theory using Crowdsourcing - https://dl.acm.org/doi/abs/10.1145/2818048.2820072 ↩

-

Stories We Tell About Labor: Turkopticon and the Trouble with "Design" - https://dl.acm.org/doi/10.1145/2858036.2858592 ↩

-

A Data-Driven Analysis of Workers' Earnings on Amazon Mechanical Turk - https://dl.acm.org/doi/abs/10.1145/3173574.3174023 ↩

-

Fair Work: Crowd Work Minimum Wage with One Line of Code - https://ojs.aaai.org/index.php/HCOMP/article/view/5283 ↩

-

Demographics and Dynamics of Mechanical Turk Workers - https://www.ipeirotis.com/wp-content/uploads/2017/12/wsdmf074-difallahA.pdf ↩

-

The Internet Is Enabling a New Kind of Poorly Paid Hell - https://www.theatlantic.com/business/archive/2018/01/amazon-mechanical-turk/551192/ ↩

-

Stop citing Ross et al. 2010, “Who are the crowdworkers?” - https://medium.com/@silberman/stop-citing-ross-et-al-2010-who-are-the-crowdworkers-b3b9b1e8d300 ↩ ↩2

-

Financial incentives and the "performance of crowds" - https://dl.acm.org/doi/10.1145/1600150.1600175 ↩

-

The Myth of Low Cost, High Quality on Amazon's Mechanical Turk - https://www.reddit.com/r/TurkerNation/comments/9nxjmj/the_myth_of_low_cost_high_quality_on_amazons/ ↩