もう10月のことですが、AI・人工知能 EXPO 2022 秋の展示会で見学したことをまとめたいと思います。学会ではなく、業界の展示会なので、AI技術自体の発展より、既存のAIと技術を使って何の課題を解決できるか、どんなビジネスモデルがあるかがテーマです。

考察

AI・人工知能の展示会とはいえ、必ずしも出展企業はAI領域の専門会社なわけではありません。出展コンテンツも必ずしもAIがコアなわけではありません(例えば法人向けのクラウドストレージサービスのDirectCloud)。

AIはあくまで業務の一環、サービスの一部、目的を実現するための一つの手段にすぎません。多くの使い道はルールベースで自動化しにくい部分(言い換えればルールやパターンを人でまとめにくい部分)をAIでできるだけ自動化することです(例えば顔認識と帳票のテキスト化)。この観点からすると、現状業界でのAIはほとんど情報システムの一種だけです。

下記のYouTube動画でおっしゃっていた感想がとても参考になります。

出展企業といえば、自社製品に注力する企業(例えばチャットボットのChat Plusとパワポ自動生成のPIP-Maker)があれば、AI技術を持ってあらゆる分野の委託開発かソリューションを提供する企業もあります。後者にはAIの専門会社(例えばViZO社)があれば、AI以外の領域にも多く携わる会社(例えばマクニカ社)もあります。

ほとんどのコンテンツは法人向け(2B)です。

拝見したコンテンツ

脳波を利用するサービス

脳波でのアノテーション

サービス:InnerEye Sense I

AIを作るには学習データは不可欠です。しかし、学習データにアノテーション(ラベル)をつけることはとても大変な手作業です。そこで、マクニカ社はInnerEye社と連携して、脳波でアノテーションする仕組みを開発しました。この仕組みを展示会の現場で体験しました。

展示会で体験したのは画像分類モデルを学習させるために、画像データにラベルをつけるプログラムです。作業者は下図の脳波計を頭につけます。

この脳波計はEEG(Electroencephalogram)といいます。実は研究室で脳波を正しく計測するためには、より高精度な別種類の脳波計が使われますが、頭に専用のジェルをつける必要があるそうです。サービス化に便利ではないため、EEGというデバイスが開発されました。EEGはヘッドホン型やシール型などいくつかのタイプがありますが、展示会で体験したのは上図左側の高性能ヘッドセット型です。自分の脳波を測ってモニターに表示させるため、同意書にサインをしました。

アノテーションのプログラムが始まったら、モニター上にさまざまな画像が高速で連続に表示されます。ターゲット種類の画像が表示されたら、脳内に意識的にカウントしなければなりません。それでプログラムが脳波の変化を検知し、画像に自動的にラベルをつける仕組みです。

しかし、展示会で体験したところ、画像表示中に脳内にちゃんとカウントしていなかったかもしれないので、ラベリング結果は間違えることが多いです。脳内活動はコントロールしにくいので、精度の向上はまだ課題ですね。

とはいえ、脳波でのラベリングはいいアイディアだと思います。実際に運用するときに、工場の作業員が現場の作業をやるついでにEEGをつけるのが想定されるので、もしかしたら精度はもっと高いです。

生体信号(脳波など)によるAI自動作曲技術

brAInMelody(ブレインメロディー)は音楽生成と聴取者(ユーザー)の生体信号を同期しながら学習することでユーザーのアクティブ、リラックスなどのメンタルを調整する楽曲生成ソリューションです。即ち、脳波などの生体信号が入力で、楽曲が出力です。

残念ながら、展示会現場では事情があり、実際に体験できませんでした。

コントローラ不要のゲーム

サービス:非接触型AIゲーム! 体の動きをトラッキングしてゲームをプレイ

手足の動きで遊ぶゲームといえば、VRゲームやリングフィットなどがあげられます。これらのゲームには一般的にコントローラやKinectなどの専用設備が必要です。そこで、ViZO社は普通のカメラだけでトラッキングできるゲームを開発しました。

実は展示会の前に筆者も会社で同じ仕組みのゲームを一本開発しました。Webカメラで撮った画像を一フレームずつOpenPoseが解析し、画像中の人の関節の座標を抽出する仕組みです。下記はOpenPoseで実装したゲームの一例です。

その画像解析にAIモデルが入っているので、ラグを感じました。そのラグをできるだけ抑えるために、実はまたデバイスの工夫(当時筆者の場合はハイスペックのGPUマシン、ViZO社の場合はSTBという専用機)が必要で、VRとリングフィットより一般ユーザーには向いていないです。ただ非接触型なので、イベント会場には向いています。

お掃除×プロジェクションマッピング

東京農工大学の中山悠研究室のプロジェクトです。この取り組みで掃除は楽しくなります。下図が示したように、床に画像がプロジェクトから投影されます。掃除のやり方の指示として、画像に色々な矢印が表示します。矢印の指示に従って掃除すれば、矢印は消えます。

筆者の推測ですが、投影画像の指示に従って掃除したかどうかはAIで判断しているかもしれません。掃除だけでなく、広い意味で行動支援という分野に使える仕組みです。

センサによってユーザの行動を認識し、その結果に応じてプロジェクタの投影光を変化させ、ユーザの行動を視覚的にサポートするような仕組みです。

この研究室は光の利用に力を入れているようです。行動支援のほか、例えば電磁波通信の代わりに、可視光シグナルで水中通信すること、ドローンで畑の状態を監視することにも取り組んでいるそうです。

チャットボット

サービス:

ウェブサイトや社内の事務にチャットボットを導入することで、問い合わせの応対にスタッフの作業を大幅に削減できます。セールスに導入する場合、顧客にとって問い合わせは気軽にでき、企業にとって売り上げアップも期待できそうです。

チャットボットを導入するときに、カスタマイズとナレッジデータベース管理などいろいろな作業が必要です。それらの作業をチャットボット会社がサポートしてくれます。さらに、音声認識、音声合成、テキスト解析と画像認識の技術を組み合わせ、家電修理等に特化したボットでユーザーの問い合わせによりスムーズに対応できそうです。

データ分析

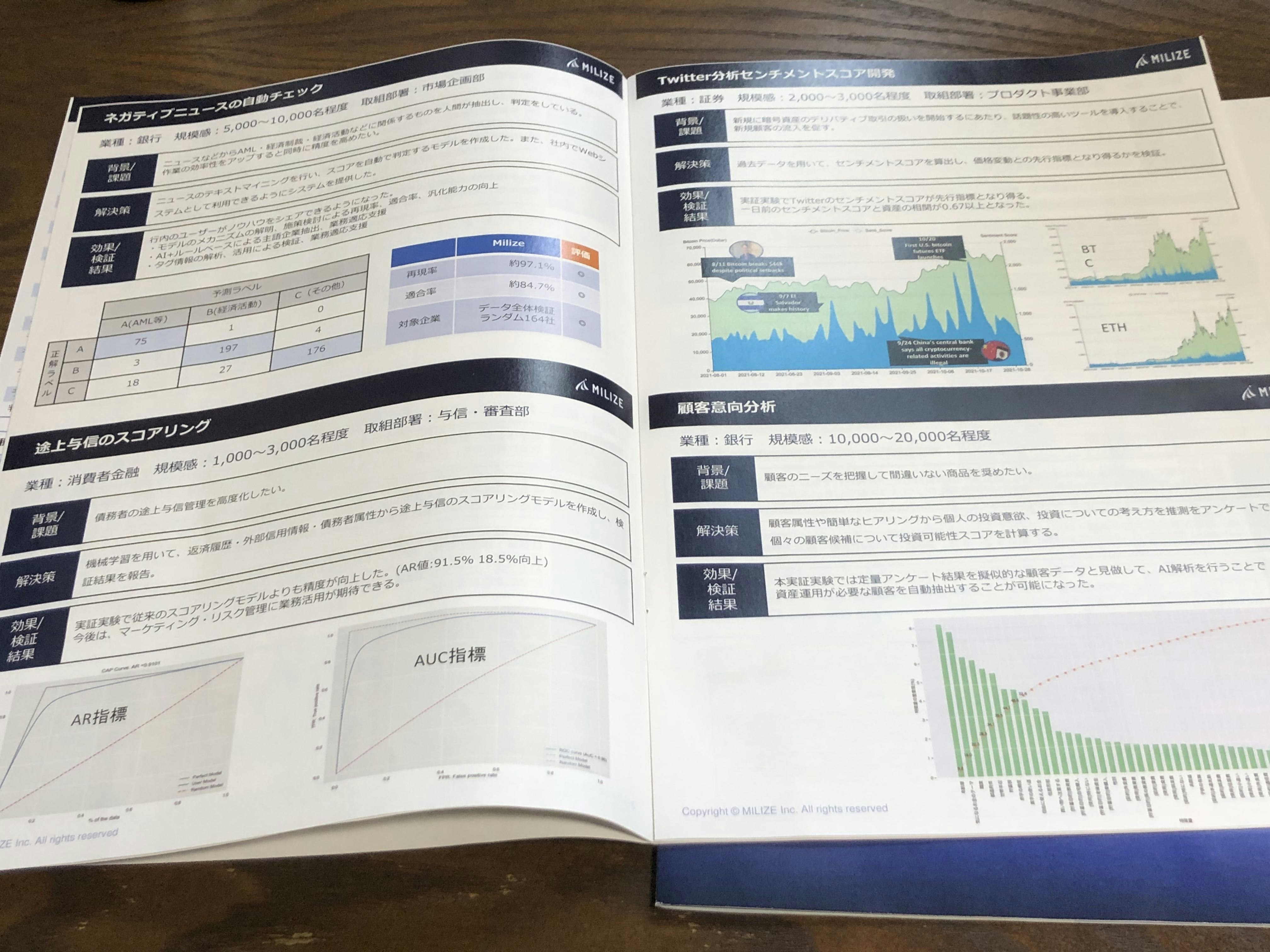

サービス:MIRIZE

データ分析で予測タスクをやる専門会社です。例えば為替、株価と業務量の予測があげられます。予測以外、一部判定タスク(例えばパチンコ台判定)もやっています。顧客は主に銀行、保険と証券のような金融法人ですが、配送会社などの他業者にもサービスを提供しています。個人顧客にも株価と仮想通貨価格の予測、家計とライフプランのAIサービスを提供しているようです。

データの量と質は結果に大きく影響します。そこで、自社の提携している有償データが一つの強みかもしれません。

AI学校(金融機関向け)も運営しています。

会場でもらった資料(多分ホームページも)はデータ分析がどのようにビジネスに役に立つかについてとても参考になります。

他のデータサービス

Data Alchemistは物理学と化学分野の研究者に

Material Platform for Data Science (MPDS)という材料の物性データベースを提供します。

ハードウェア

AIモデルの学習を高速化にするハードウェアのことです。

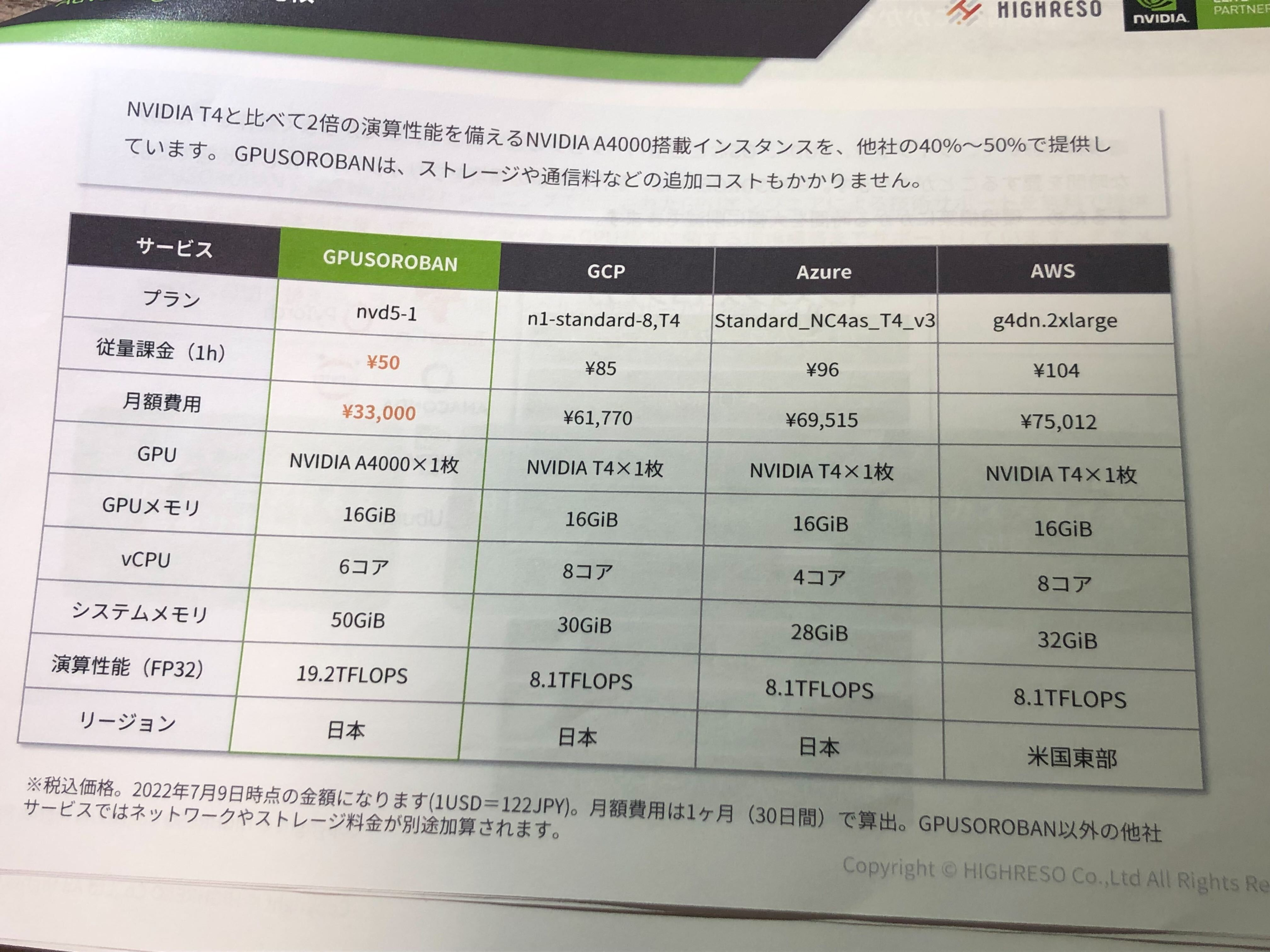

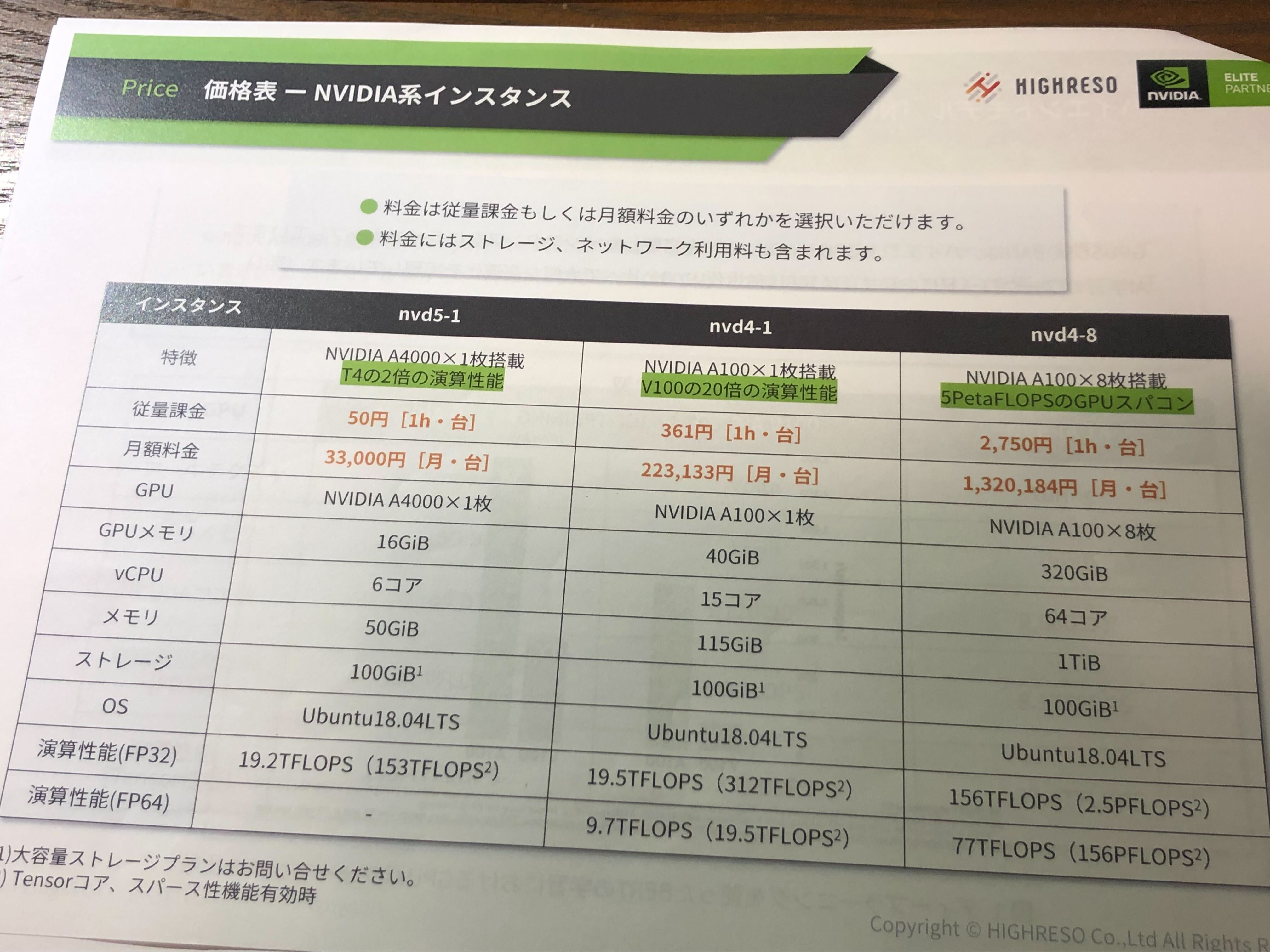

GPUソリューション

AIモデルの学習には一般的にGPUが使われます。GPUは物理のマシンを買うのも、AWSなどのクラウドサービスを使うのも高価です。しかも、クラウドサービスを使う場合は、日本リージョンにあるGPUインスタンスはまだ少ないです。現時点GCPに日本リージョンのGPUインスタンスはさらにありません。この原因で、リソースが割り当てられない、アクセスに遅延が大きいという問題はよくあります。

そこで、HIGHRESO社はコスパの高いGPUクラウドサービスを提供します。下図は展示会でもらったスペックと価格表の資料です。一見確かにGCPより安そうです。

同社はクラウドレンダリングとリモートワークステーションのサービスも提供しているようです。

AIプロセッサー

Intel社のHabana® Gaudi® AIプロセッサーがあげられます。特徴として

- テンソル演算と行列積演算の両方にハードウェアで対応する

- Transformerの効率的な学習がサポートされている

- Amazon EC2 DL1 インスタンスに搭載されている

- TensorFlowやPyTorchを基に書いたソースコードは移植しやすい

実績:

タンパク質の二次構造予測(BERT-Largeモデル)の学習にV100より22%(1 epoch 5.9秒ー>4.6秒)、

医用画像の疾患分類(CheXNetモデル)にV100より18%(1 epoch 1047.7秒ー>859.1秒)

の高速化が確認できました。

AI搭載IoT

サービス:Gravio

カメラとセンサーでのデータ収集、データ処理、監視、データによるアクション実行と外部クラウド連携を一貫に提供するIoTソリューションです。カメラ画像からの推論にAIが稼働します。例えば顔認識、人数検出と車両検出のAIはすでにGravioに搭載されています。そのほか、顧客がGoogle Vision AIで作成された画像推論モデルもソリューションに組み込めます。

カメラAIとセンサーを統合利用することで、より汎用的なシステムを構築でき、色々な場面に活用できます。例えば顔認証カメラAI、人感センサーとCO₂センサーなどでの病院見守りシステムの事例があげられます。

このようなシステムはかなり複雑だと思われるかもしれませんが、ノーコードで使用場面にカスタマイズできるのがGravioの一番大きな特徴です。しかも金額的には個人向けの安いプランがあります。

省エネ型人工知能

Green AI Challengeは総務省委託研究課題「脳の仕組みに倣った省エネ型人工知能関連技術の開発・実証事業」に基づいて実施されているプロジェクトです。

現代主流のAI技術として、ニューラルネットワークはすでに脳の仕組みに倣っている仕組みだと思われますが、このプロジェクトでは脳の振る舞いに倣った「ゆらぎ学習」が開発されました。工学的には熱ゆらぎの誤作動を抑えるため、膨大なエネルギーを費やします。しかし、ヒト脳ではむしろ”ゆらぎ”を利用して、アトラクタで状態を緩やかに定義し、柔軟で省エネに制御し、認知機能を実現しています。

YGAPというゆらぎ学習データ分析プラットフォームはGitHubにて公開されています。

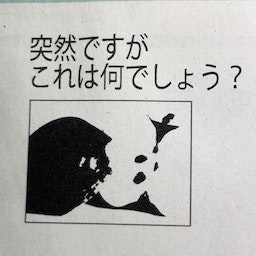

展示会でもらったチラシの例ですが、下図の隠し絵に対して、従来AIは右半分にある二つの黒い点を”目”と思い、「動物」と答えます。

ヒトの脳はリンゴと正しく認識できると思われます。

帳票テキスト化

サービス:DirectCloud

法人向けのクラウドストレージサービスですが、大量の帳票をテキストデータ化する機能にOCR技術が使われています。

議事録文字起こし

サービス:UreTell

録画・録音データから自動で文字起こしをするサービスです。音声認識技術がコアだと思います。

メタバースと関わりがある内容

こちらは一部メタバース総合展に出展された内容ですが、AI技術を利用していると思います。

パワポ動画の自動生成

サービス:PIP-Maker

パワポを入力し、アバターでそのパワポを説明する動画が作成されるサービスです。

一見AI技術とあまり関係なさそうですが、パワポ解説のセリフをアバターに読み上げさせるには音声合成技術が使われます。

バーチャルヒューマン

サービス:クレオン

写真1枚と録音30秒で、ユーザーご自分の顔、体と音声のバーチャルヒューマンを作れる技術が基盤です。この技術に基づいて、いくつかのサービスが提供されます。例えば

- 撮影することなく、映像の主人公を自分の顔と声に置き換える

- 希望する人物の顔と声を持つAIチャットボットを作る

- 映像人物に本人の声で多言語を話させる(従来の場合、映像の声を多言語化するには声優さんを切り替えないといけない)一方、人物の口動き発話言語に合わせる

録音30秒だけでターゲット人物の声で多言語の音声が合成できるのはVoice Cloning技術を使っているかもしれません。クレオンさんのデモを体験していませんでしたが、筆者自身の知見からすると、Voice Cloningではターゲット人物の発話特徴(本人らしさ)と音質の良好さは一部落ちるかもしれません。

3D & 4Dスキャン

Prefered Networks社のリアルの物体をスキャンして3Dモデルを生成する3Dスキャン技術は業界中に有名かと思いますが、今回注目させたのは4Dスキャン技術です。

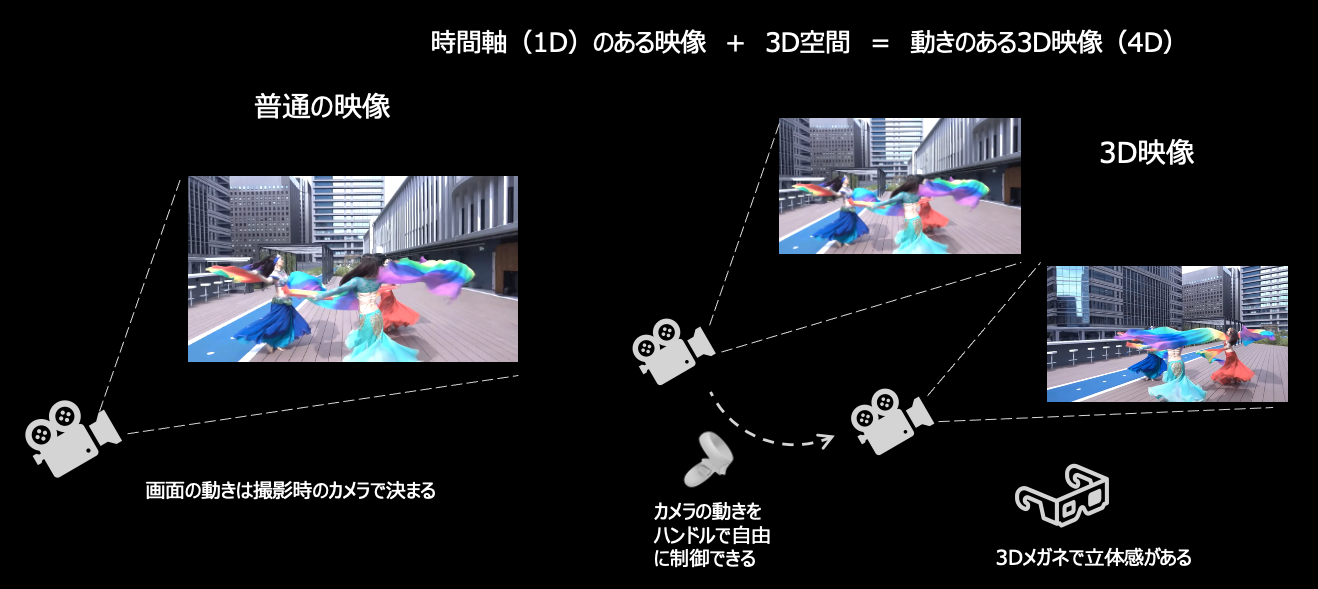

4Dスキャンとは時間軸のある映像に、3D空間を与えて、動きのある空間映像として復元することです。普通の映像だと、画面の動きは撮影時のカメラで決まります。映像を見る観客はそのまま見るしかできません。それに引き替えて、空間映像の場合、映像が流れる時に、カメラの向きと位置をハンドルで自由にコントロールできます。

例えばこの画面でいうと、赤い服の人をもっとはっきり見たいですが、青色の人の邪魔でよく見れないです。その場合、ハンドルを動かしてカメラを調整すればいいです。それだけでなく、カメラをその人に近づけて細かく見ることもできます。しかも3Dメガネをかけて見る映像なので、立体感があります。

フォント提案アプリ

Fontworks社が開発された人工知能6号はユーザーがアップロードした画像に相応しい印象語とフォントを提案できます。