Azure AI Studioことはじめ

Azure AI StudioがGenerally Availableになりました。Buildの発表からもこれからはAIのプロジェクト向けの開発環境はこちらを使ってね感がひしひしと感じられます。

でもマイクロソフトの新しい技術にありがちで、実際の使ってる人の触ってみたレポがあまりないので、ちょうどTrainingがあったので触ってみます。

いきなりドキュメントを読むのが辛い人にはTrainingは最高のスタートですね!

参考リンク

Azure AI Studioとは

参考リンクからの抜粋。

- AI プロジェクトを作成して管理する:Azure AI Studio では、すべての AI プロジェクトに対して一元化されたハブが提供されるため、リソースの管理、チーム メンバーとの共同作業、ワークフローの効率化を行うことができます。

- 生成 AI アプリケーションを開発する:コンテンツを生成したり、独自のプロンプト フローを構築したりできるアプリケーションの開発が目的の場合は、Azure AI Studio の生成 AI 機能が不可欠です。

- 使用可能な AI モデルを調べる:Azure AI Studio のモデル カタログで、OpenAI、Microsoft、Hugging Face などのさまざまな AI モデルを試します。

- 検索拡張生成 (RAG) を活用する:取得と生成の力を組み合わせる必要があるプロジェクトの場合、Azure AI Studio の RAG 機能により、生成されたコンテンツの品質と関連性が向上します。

- AI モデルを監視し評価する:Azure AI Studio には、プロンプト フローと AI モデルの評価と監視のための堅牢なツールが用意されており、望ましいパフォーマンス メトリックを確実に満たします。

- Azure サービスと統合します。AI アプリケーションが他の Azure サービスとシームレスに連携する必要がある場合、Azure AI Studio は簡単に統合できるため、複雑で多面的なプロジェクト向けに多用途に使用できます。

- 責任を持ってビルドする:Azure AI Studio では、AI の責任ある使用に重点を置いており、アプリケーションが倫理的な標準とベスト プラクティスに準拠していることを確認するためのガイダンスとツールを提供します。

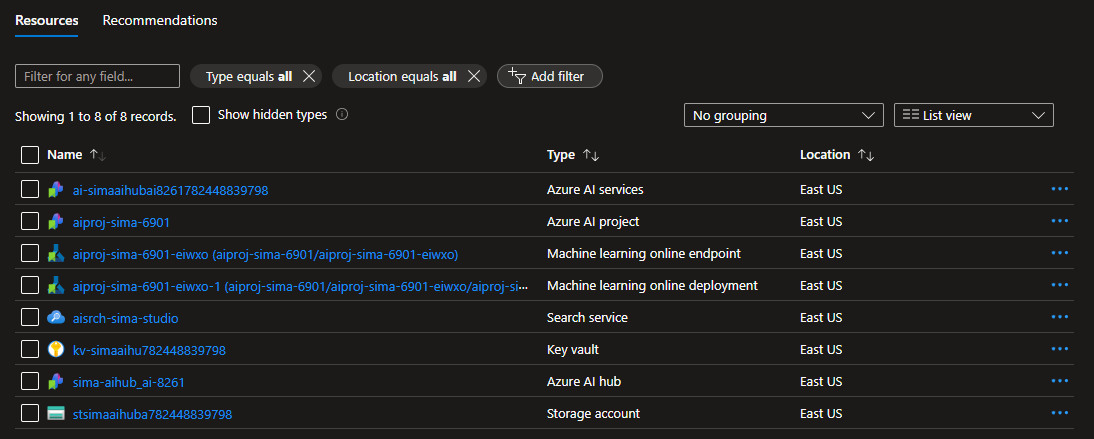

最低限以下のようなものがデプロイされる。

- コアとなる AI ハブ リソースに加え、補助的なサービスを提供するその他の Azure リソースが作成されます。 次のような方法があります。

- ストレージ アカウント。AI プロジェクトのデータがセキュリティで保護された方法で格納されます。

- キー コンテナー。外部リソースへのアクセスに使われる資格情報と、その他の機密性の高い値がセキュリティで保護されます。

コンテナー レジストリ。AI ソリューションで使われる Docker イメージを格納します。- Application Insights リソース。使用状況とパフォーマンスのメトリックを記録します。

- アプリケーションに生成 AI モデルを提供する Azure OpenAI Service リソース。

LLMアプリの開発ライフサイクル

①目標を定義する

②サンプル データセットを収集

③基本的なプロンプトを作成する

④フローを設計する

⑤実験する

⑤評価・調整する

⑥デプロイする

⑦監視する

これらのことがAzure AI Studioから全部できるようになるらしい。

先に結論

個人的に触ってみた感触だとStudio自体はGAになったかもしれないが、2024年6月現在では個別の機能がまだPreviewらしく不安定さを感じる。また、個々のStudioやAzure Portalから実施するより機能が限られている。

このStudioからAI開発の全てができる、というコンセプトはわからないではないが、精度を追い求めるとカスタマイズが必要になり、そうするとGUIからだと辛い気がする。結局インデクシングの際にキーワード抽出や翻訳やいろんな前処理・エンリッチメント処理を挟む必要がある。そういう意味でRAGをどう組むかはデータ次第だけど、そのうえでLangChainのようなライブラリからRAGを使うのが良い気がする。

やっぱりファイルアップロードしただけで、はいRAGできあがりーという甘い世界ではないのだ。

ただ、トレースログが見やすかったり、Prompt FlowからRAGの評価が簡単にできたり、使ってみたいなという機能もあった。Azure AI Studioの外で個々にリソースを作って、それを後から接続することもできるらしいので、Prompt FlowのRAG Evaluationなどポイントを絞って利用するのが今の時点ではベストだと考える。

とりあえず触ってみる

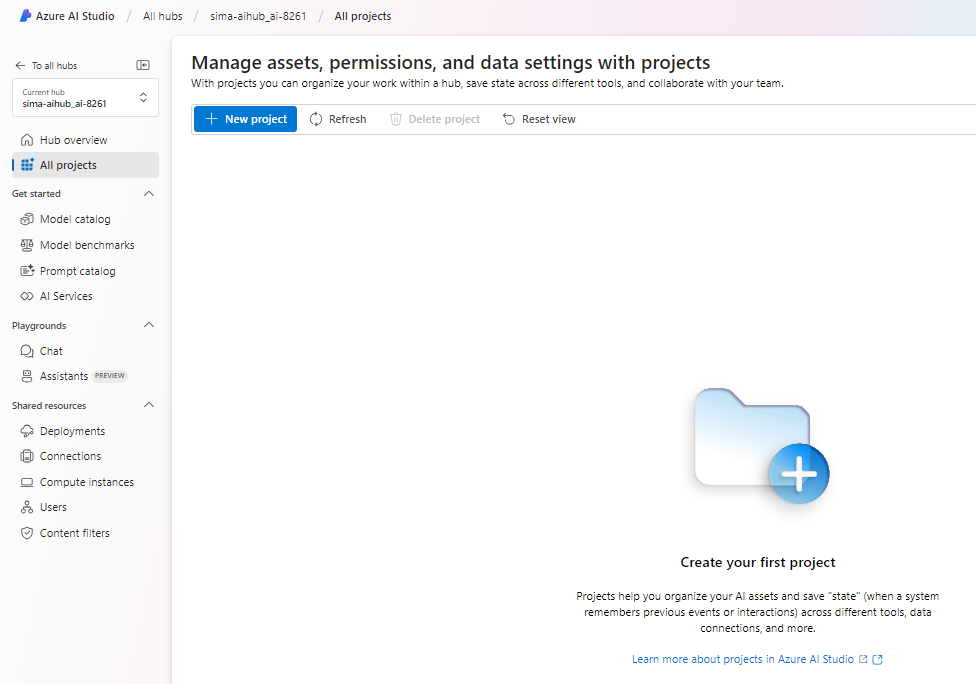

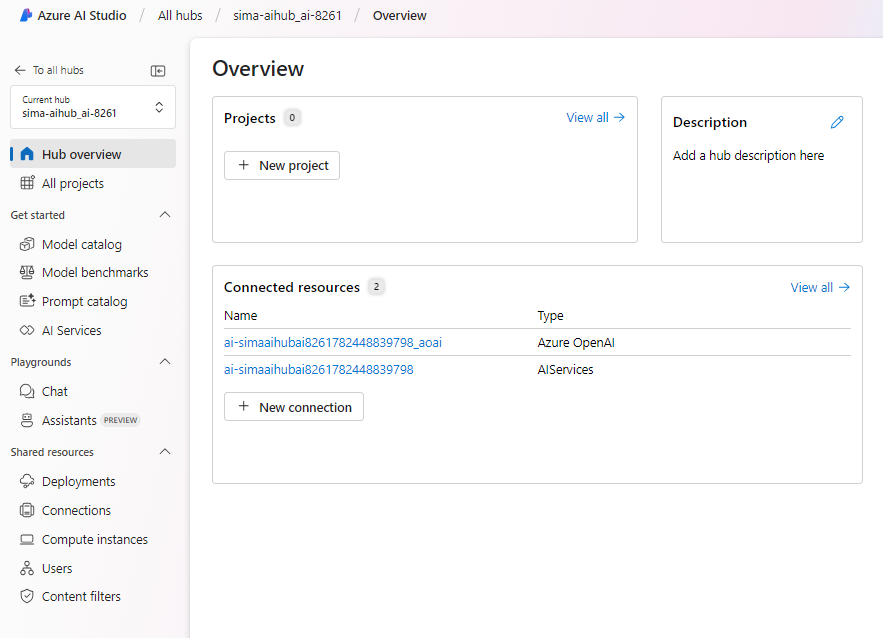

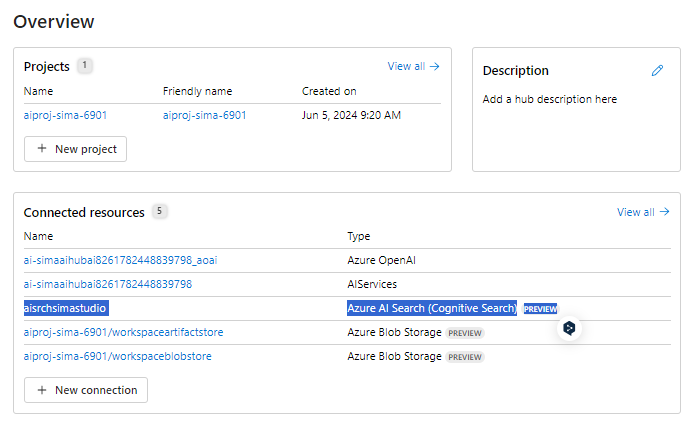

まずはAll Hubs > AIHubを作る。Azure AI Searchとの接続は後回し。

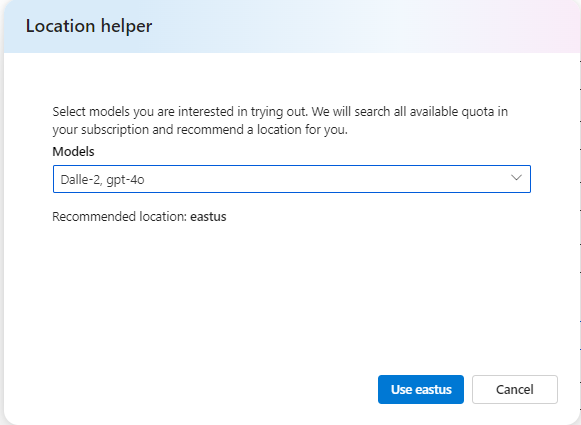

Location Helperというのがあり、Modelを選択するとどのLocationにすればいいかがわかるようになっていた。便利だが、DallE-3tとかが載ってない。

Portalから見るとこんな感じ。(AI SearchやMachine Learningは後で接続した・されたもの。)

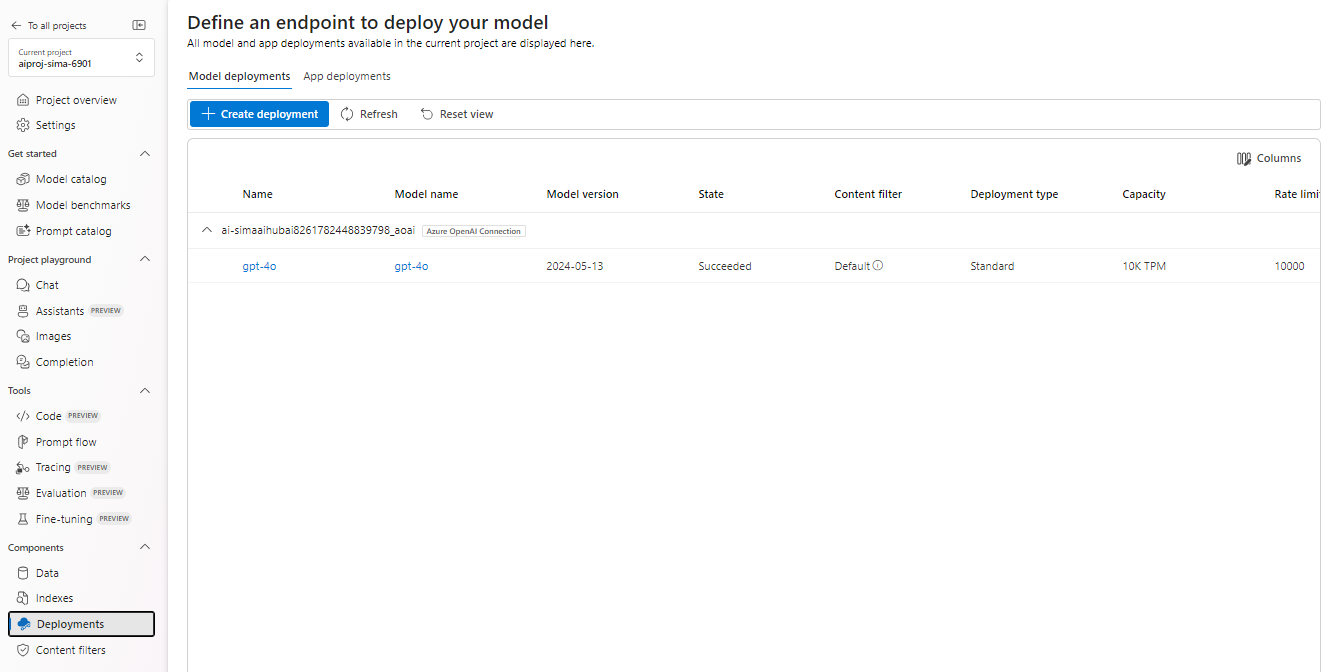

DeploymentsからモデルをDeployする。この辺Azure OpenAI Studioに似てる、というかもうそのままでは。

もうAzure Open AI Studioはいらない子なのか?という思いがよぎる。

Prompt Flowで各リソースを組み合わせて開発してみる

Azure AI Studioからプロンプトフローという技術でMachine Learningと組み合わせてLLMアプリ開発を行う。Machine Learning Studioの機能が合体しているぽい。(あまりMachine Learningは使ったことがないので想像です。)

Prompt Flow

Prompt Flow=処理パイプラインのようにとらえればいい。

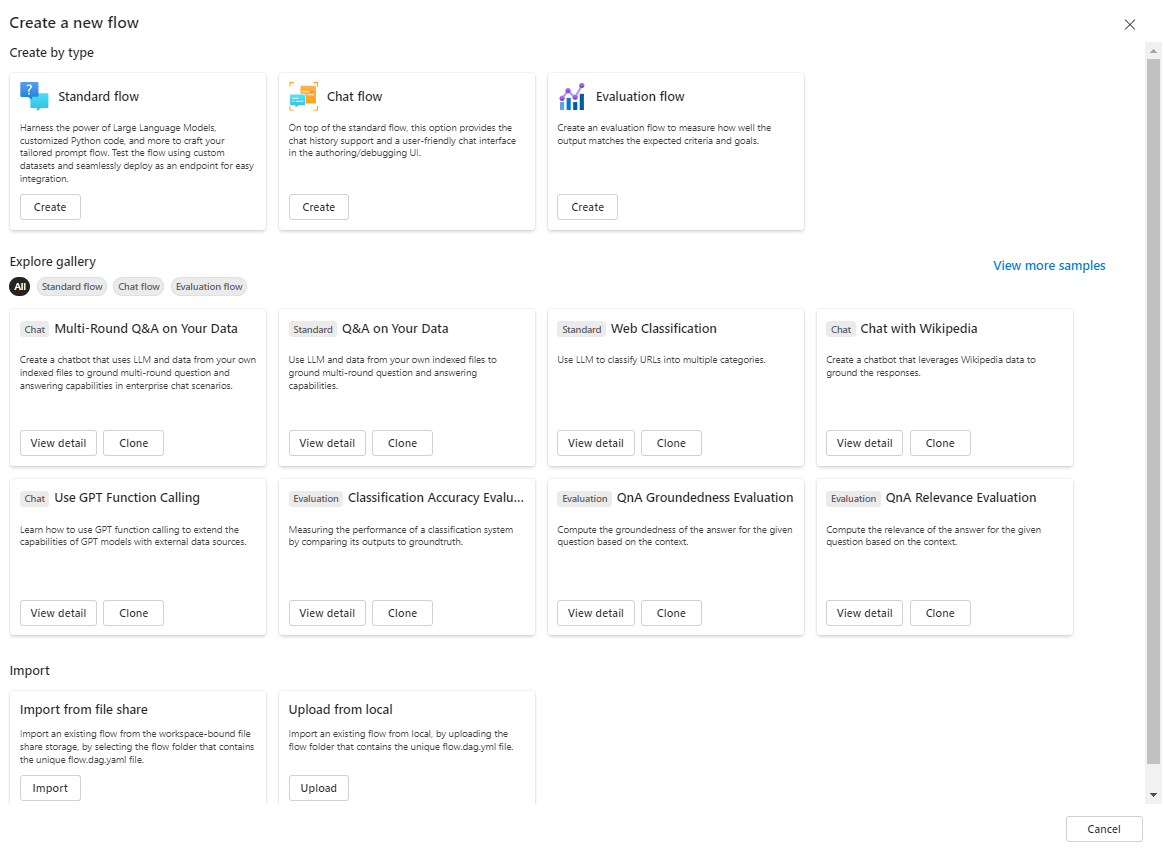

Prompt Flowの種類は以下の通り。

- 標準フロー: 一般的な LLM ベースのアプリケーション開発に最適で、多目的に使用することができるさまざまなツールを提供します。

- チャット フロー: 会話型アプリケーション向けに設計されており、チャット関連機能のサポートが強化されています。

- 評価フロー: パフォーマンス評価に重点を置き、以前の実行に関するフィードバックを通じて、モデルまたはアプリケーションの分析と改善をすることができます。

利用可能なツールは以下の通り。

- LLM ツール:大規模言語モデルを使用して、カスタム プロンプトを作成することができるようにします。

- Python ツール:カスタム Python スクリプトの実行を許可します。

- プロンプト ツール:複雑なシナリオまたは他のツールとの統合用に、文字列としてプロンプトを用意します。

- 独自カスタムツール

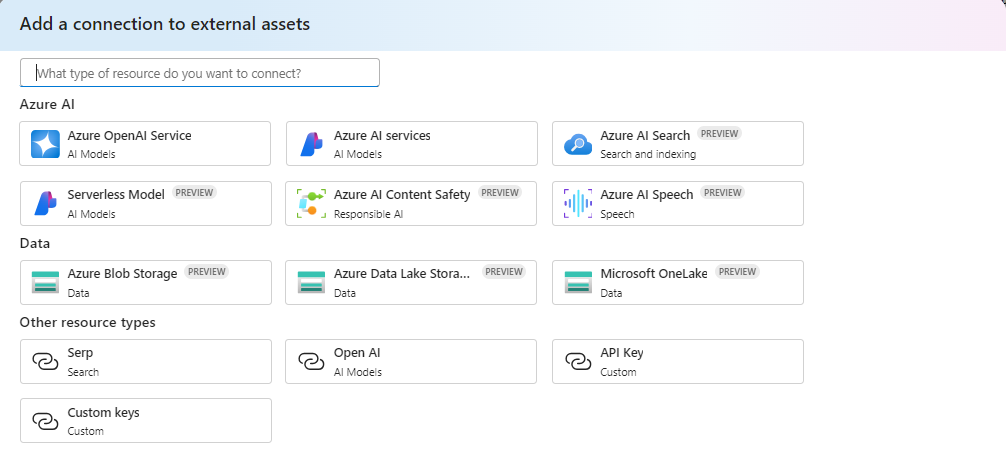

外部ツールを扱うためにはConnectionから必要なリソースを定義しておく。

New Connectionを見るとこれらのものが接続できる。

裏ではコンピューティングリソースとランタイム(必要なパッケージとライブラリ)環境が自動的に起動するらしい。

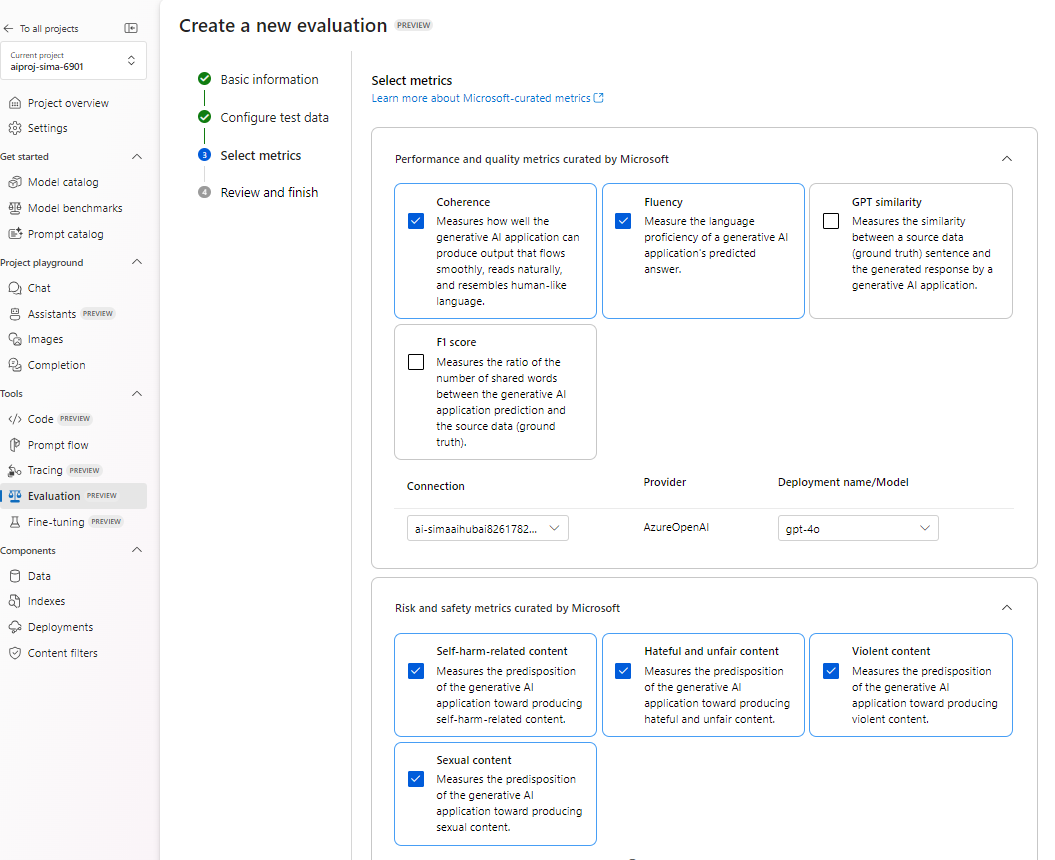

評価

Prompt Flowの評価機能により、LLMアプリのパフォーマンスを評価できる。「LLM 予測と期待される応答または "グラウンド トゥルース" 応答を比較して正確性と関連性を測定」とある通り、よくある事前定義したQ&AとLLMアプリの応答を比較するということができる。

以下のような項目を評価できる。

groundedness: LLM アプリケーションの出力と入力ソースまたはデータベースの一致度を測定します。

"関連性": LLM アプリケーションの出力が与えられた入力にどの程度関連しているかを評価します。

"一貫性": LLM アプリケーションのテキストの論理フローと読みやすさを評価します。

"流暢性": LLM アプリケーションの出力の文法的および言語的な正確性を評価します。

"類似性": LLM アプリケーションの出力とグラウンド トゥルースの間のコンテキストとセマンティックの一致を定量化します。

Prompt Flowを触ってみる

ちゃんとしたレポートは以下のような素晴らしい記事を参照してください。

いろんなTemplateがあるが、まずはStandardを触ってみる。

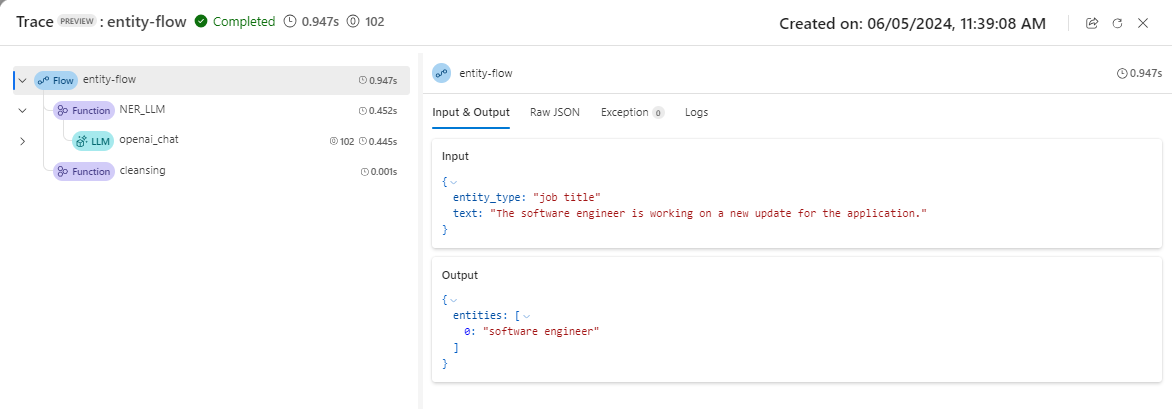

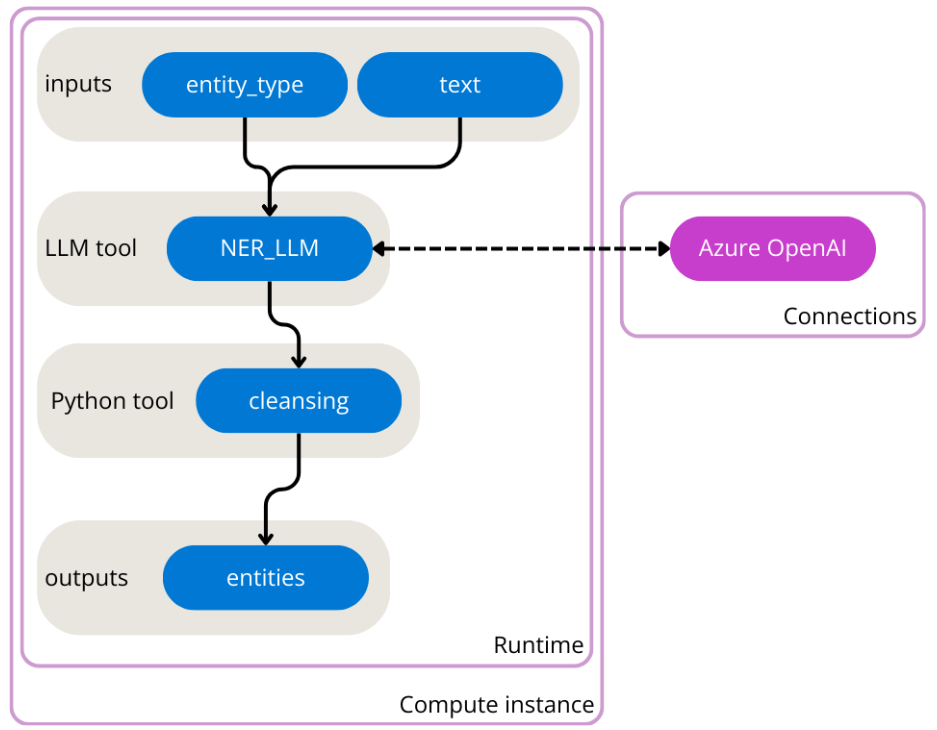

例えばこんなエンティティ抽出処理を実行したい。

2つのInputとエンティティ抽出と1つの出力がある。(NERとはNatural Entity Recognitionの略らしい。)

裏ではYaml形式で書かれている。OpenAIにはエンティティタイプとしてjob-titleを抽出してと投げている。

id: template_standard_flow

name: Template Standard Flow

inputs:

entity_type:

type: string

is_chat_input: false

text:

type: string

is_chat_input: false

outputs:

entities:

type: string

reference: ${cleansing.output}

nodes:

- name: NER_LLM

type: llm

source:

type: code

path: joke.jinja2

inputs:

deployment_name: gpt-4o

temperature: 1

top_p: 1

max_tokens: 256

entity_type: ${inputs.entity_type}

text: ${inputs.text}

provider: AzureOpenAI

connection: ai-simaaihubai8261782448839798_aoai

api: chat

module: promptflow.tools.aoai

use_variants: false

- name: cleansing

type: python

source:

type: code

path: echo.py

inputs:

entities_str: ${NER_LLM.output}

use_variants: false

node_variants: {}

environment:

python_requirements_txt: requirements.txt

裏ではVMが起動しているらしい。1時間アイドルでシャットダウンする。

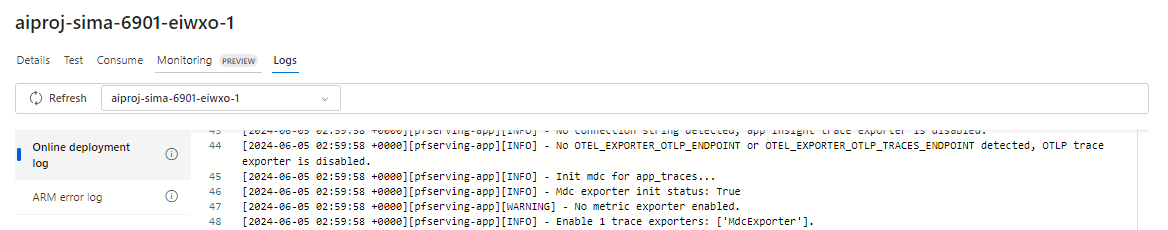

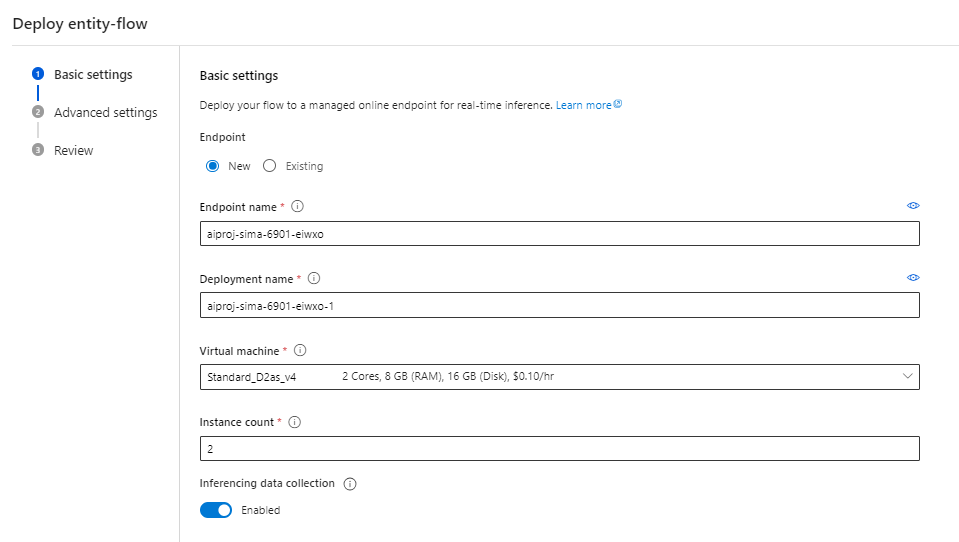

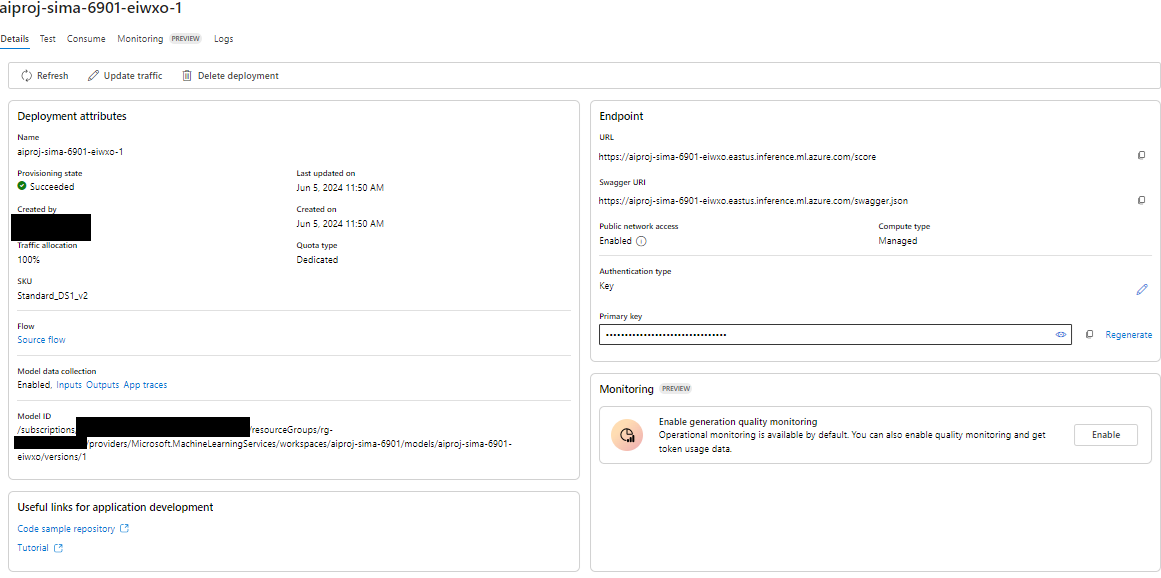

ボタン1つでWebにEndpointをDeployもできる。これはVMが立つらしい。

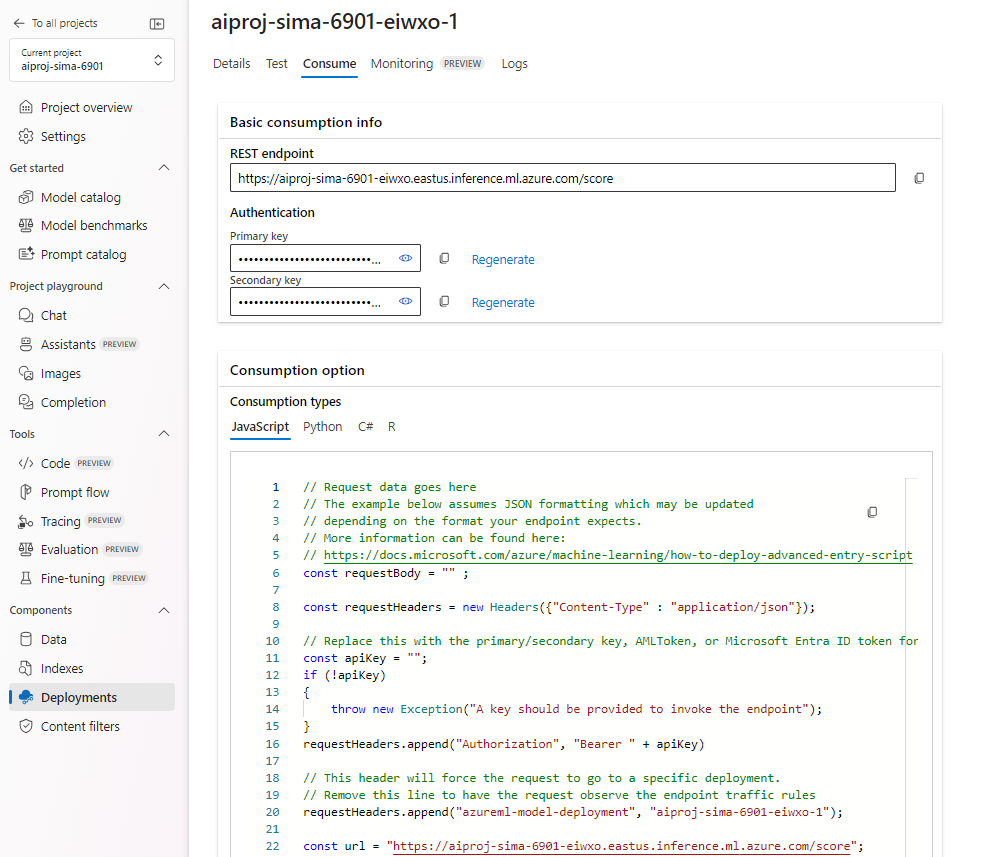

キー認証がついている。Swagger Endpointとかもあるらしい。(キー認証があるため、普通に叩いたら拒否された。。後で開く。)

Endpointにリクエストを投げるためのサンプルコードとか。

モニタリング機能もある。下で作ったEvaluationとも連携できるぽい。

でもこのDeployしたEndpointのポータルには停止ボタンがないんだけど、、起動しっぱなし??Azure Portalを見てもVMは立っていなかった。裏でAzure側が管理しているらしい。

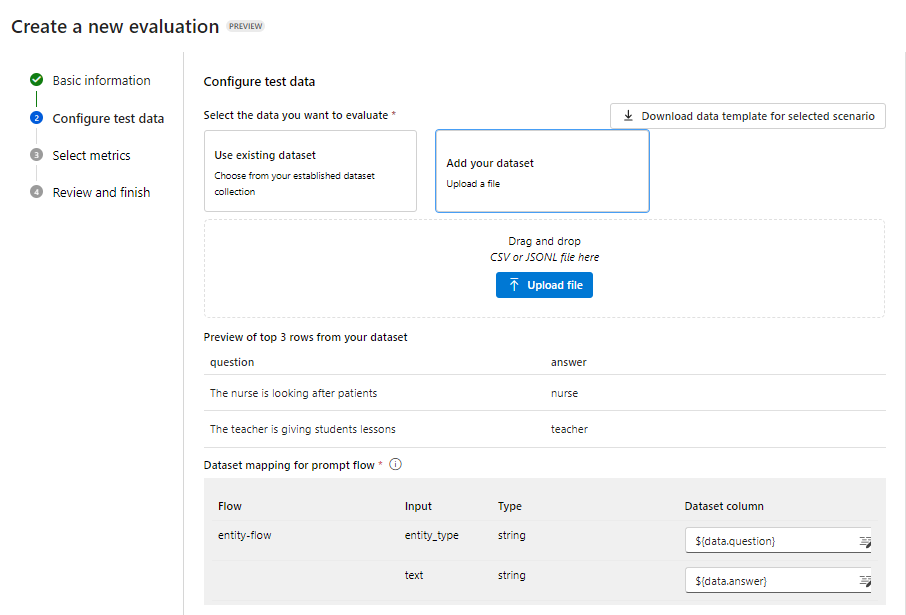

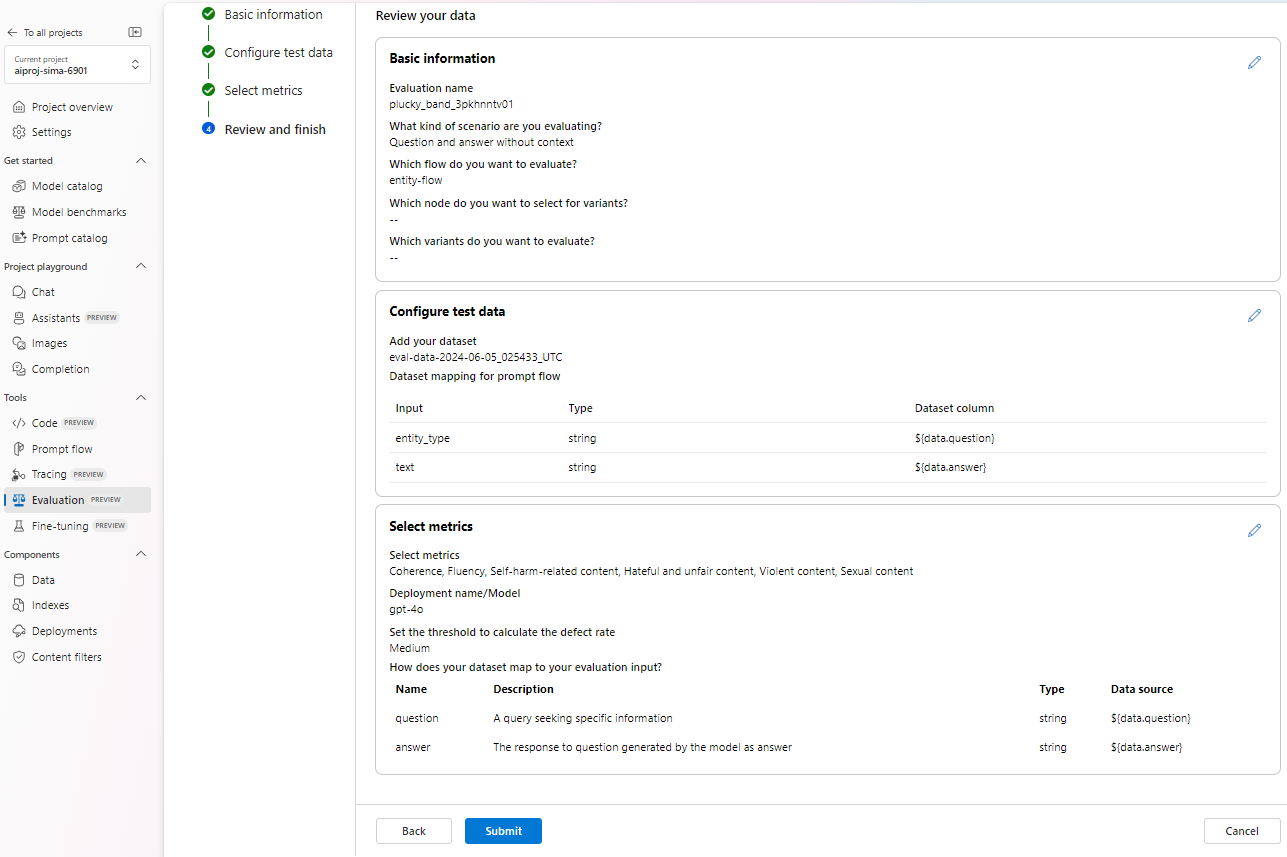

Prompt Flowの評価

テストデータはDownload data templateからダウンロードし、超適当に作ってみた。jsonl形式?というらしい。CSVでもいいぽいけど。

{"question":"The nurse is looking after patients","answer":"nurse"}

{"question":"The teacher is giving students lessons","answer":"teacher"}

どんな指標を計測するかをチェック。今回は単純なのでRAGはなし。

Prompt FlowにRAGを組み込む

Project > Dataから自分のデータをアップロード。

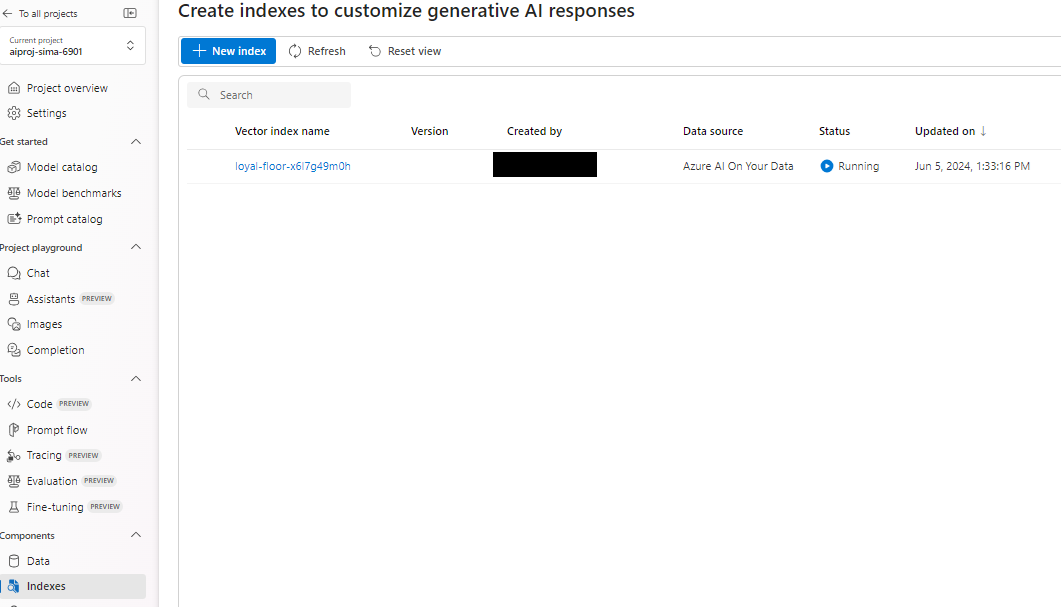

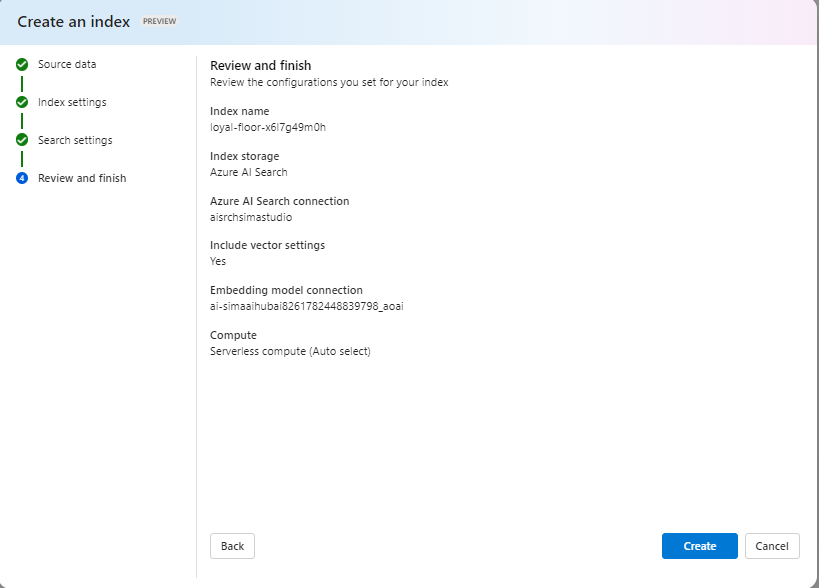

Project > IndexesからAzure AI Searchへインデックスデータを格納。Azure AI SerchのImport and VectorizeをAzure AI Studioからやっているイメージか。

(でもPreviewだったり、結局スキルとか使えないし、Portalからやるより機能が限られているでなんだかなーという気分になったのは否めない。OverlapとかChunkも詳細設定できないしね。こういう細かいのをやりたければプログラム書いたり、それぞれ個別のStudioやPortalを使えということなんだろうなと感じる。)

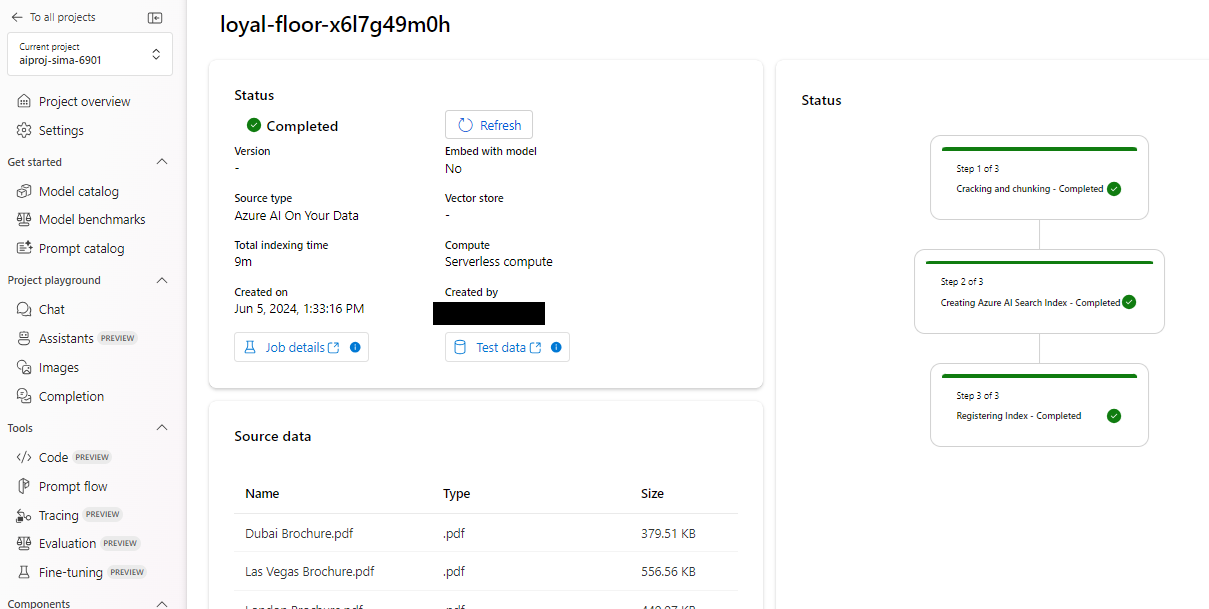

インデクシング完了。て、Data Source Type見て気づいたけど、これ結局Azure AI On Your Dataそのものなのね。

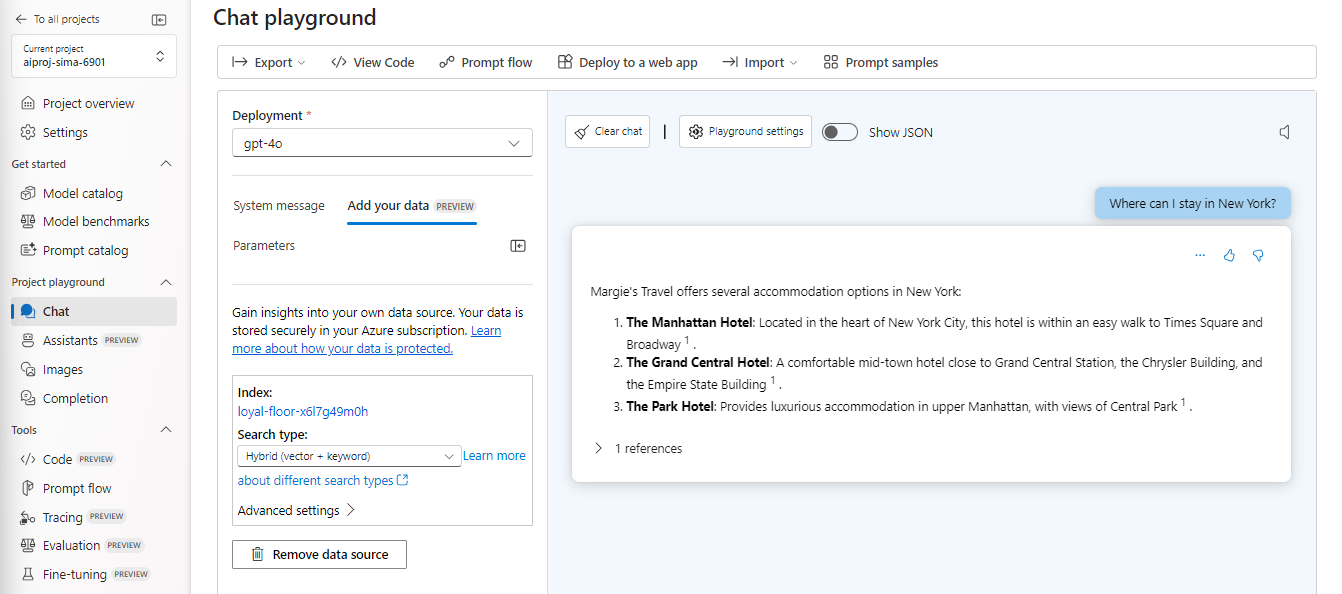

ここでもOpenAI StudioのAdd your Dataができる。

Prompt Flowで「Multi-Round Q&A on Your Data」というのを使う。

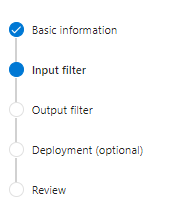

Content Filter

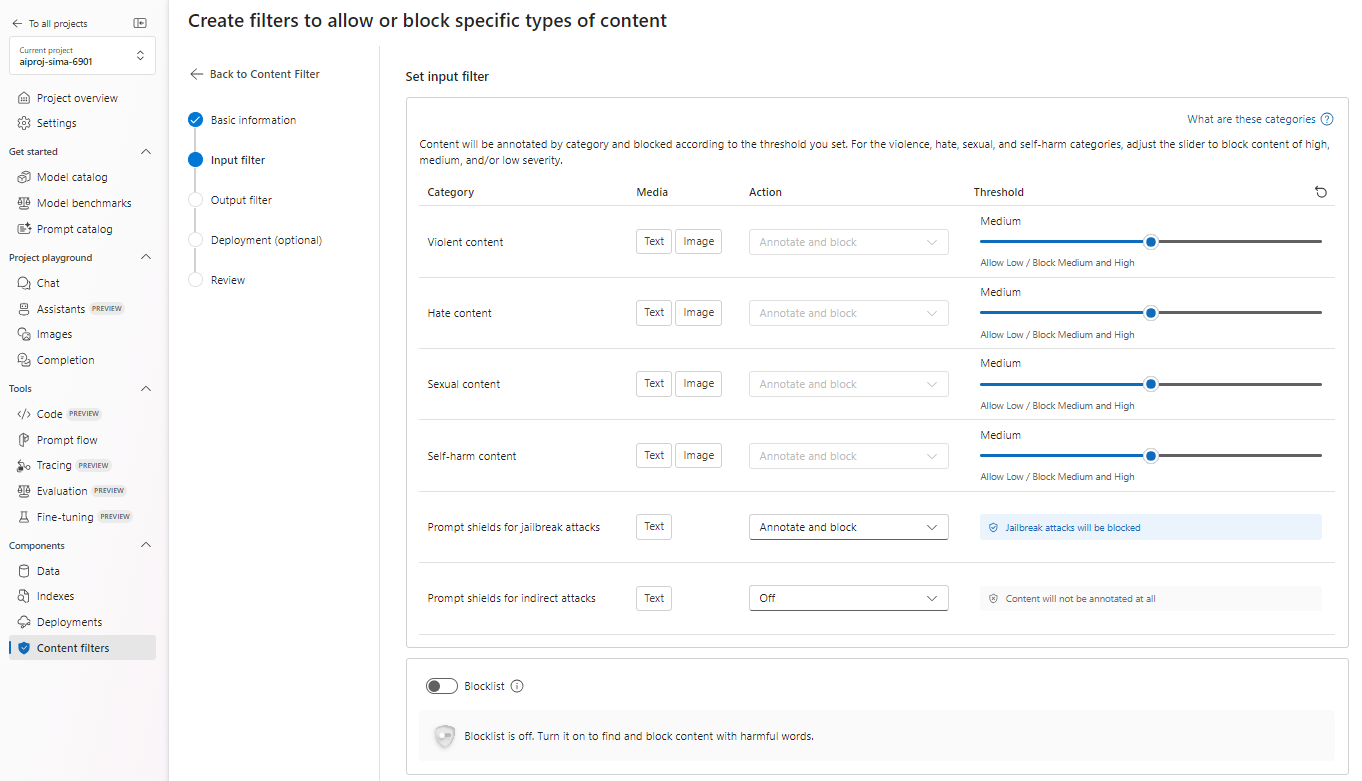

Responsible AI上必須のContent Filter、自分好みにカスタマイズできる。

この辺のカテゴリ。

ヘイト:差別や侮蔑を表す言葉。

性的:性的に露骨な表現、乱暴な表現。

暴力:暴力を描写、擁護、賛美する言葉。

自傷行為:自傷行為を描写または助長する言葉。

と、、ここでAzure AI Studioがエラーを吐いてしまいContent Filterを作ることができなかった。やっぱりPreviewだからかまだ不安定さを感じる。

ただContent Filterって触ったことなかったなと思い、Azure OpenAI Studioからやってみることにする。なので以下はAzure AI Studioは関係ない。でもおそらく大体同じ事ができると思ってよいのではないか、多分。

Content Filterについては長くなったのでこちらにまとめました。