こんにちは。スキルアップAI編集部です。近年、多くのAIモデルが開発されています。開発されたモデルは非常に高性能である一方、複雑で理解が難しいものも多く存在します。そのため、「AIがなぜそのような判断を下したのか」を人間が理解できるように説明できるXAI技術が重要視されています。

本記事では、XAIの意味や代表的な手法、メリット、導入課題、活用事例、おすすめの学習方法などについて紹介します。

<目次>

- XAI(説明可能なAI)とは

- XAIが重要視されている背景

- XAIを活用するメリット

- XAI導入に向けての課題

- XAIの主な手法

- XAIに関する技術ツールの紹介

- XAIの活用事例

- XAIに関するおすすめ論文

- XAIを学習する方法

- XAIに関するよくある質問

- まとめ

スキルアップAIでは、AI関連のスキル・知識を無料で学べる勉強会をライブ配信しています。ぜひチェックしてみてください。

XAI(説明可能なAI)とは

XAIとは、「Explainable AI」の略称で、AIの振る舞いをあらゆる観点から理解し、信頼できるようにすることを目的とする技術の総称です。日本語では「説明可能なAI」と呼ばれ、出力結果に至った経緯や判断の根拠を説明できるAIを指します。

大阪大学産業科学研究所の原聡氏は、XAIを以下のように定義しています。

機械学習モデルの出力に加えて、その出力を補助する追加の情報(モデルの解釈、判断根拠の説明など)を出力する技術一般および研究分野全体を指す

原 聡, 【記事更新】私のブックマーク「説明可能AI」(Explainable AI), https://www.ai-gakkai.or.jp/my-bookmark_vol34-no4/ (2019) より引用

近年、AIの社会実装が進んでいますが、AIの判断基準や根拠が不明確だと、「ユーザ向けに実用化できない」といった問題が生じる場合があります。 そのため、AIがなぜその出力をしたのかを人間が理解できるように説明できること(説明可能性)が重要視されており、機械学習モデルから予測を説明する付加情報を得る技術が必要とされています。

XAIの歴史

XAIという言葉が社会的に使われ始めたのは、2017年にアメリカの国防高等研究計画局(DARPA)がAIの説明可能性に関する研究プロジェクトを発表したころからです。AIの説明可能性に関する論文自体は2017年以前から存在していましたが、このプロジェクトをきっかけに、XAIが盛んに研究されるようになりました。

その後、日本でもXAIが重要視されるようになりました。

2018年に内閣府は「人工知能技術戦略実行計画」という人工知能技術戦略の実行計画を発表しました。その中で「説明できるAI技術の開発」が研究開発の施策として挙げられ、2025年度中にXAIの技術開発を達成することが目標だと明記されています。

同じく2018年に総務省が発表した「AI利活用原則案」では、「透明性の原則」が原則の一つとして挙げられ、その中に「判断結果の説明可能性に留意する」ことが明記されました。

また、文部科学省が発表した2020年度の研究戦略目標では、「信頼されるAI」が掲げられ、その中でも説明可能性について言及されています。

XAIが重要視されている背景

従来のAIは、予測や認識の性能が高いとしても、誤った判断をしてしまった場合、原因の究明が難しいという問題があります。これは、予測や認識の判断根拠を説明することが苦手であり、なぜ誤った判断をしたのかの説明をすることが困難だからです。 そのため、判断根拠の説明をできないことが、AIに対する不信感を生み導入への阻害要因となっています。

特に、近年よく用いられるニューラルネットワークなどの深層学習モデルは、高い予測性能を示す一方で、モデルが非常に複雑であるため、基本的に出力結果の判断根拠が解釈しにくいことが問題視されています。

そのためブラックボックス性が高く、AI技術の社会への適用を難しくしている要因の1つとされています。逆に、出力結果に至るまでの過程や根拠を説明できるようなモデルは、ホワイトボックスであるといえます。

また、「説明可能性」と似た概念に「解釈性(解釈可能性)」があります。

解釈性は機械学習モデルの判断過程を人間が解釈可能であるかどうか、その程度を表します。ブラックボックス化したモデルは解釈性が低く、ホワイトボックス化したモデルは解釈性が高いといえます。

このような背景から、機械学習モデルを脱ブラックボックス化(=ホワイトボックス化)する社会的なニーズが高まってきており、XAIが重要視されています。

AIを取り巻く問題

AIを取り巻く問題として、2つの事例を紹介します。

1つ目の事例として、2015年にGoogle Photosがアフリカ系女性の写真に「ゴリラ」とラベル付けしてしまった問題があります。 ここで気になる点は、写真のどの部分を見てゴリラと予測してしまったのかということです。

参考:「Google Photosが黒人をゴリラと認識した事件で開発者が謝罪」

2つ目に、Microsoftが開発したツイッターボット「Tay」が、一部ユーザによる悪意ある調教の結果、倫理的に問題がある発言をするようになった事例があります。

どのようなデータが原因で、またどのような過程を経てこのような状況になってしまったのかの説明ができず、Tayは停止されました。

ここでは「なぜこのような出力がされてしまったのか」や「この出力に関連する訓練データはどれか」などが気になる点として挙げられます。

参考:「Microsoftの人工知能が「クソフェミニストは地獄で焼かれろ」「ヒトラーは正しかった」など問題発言連発で炎上し活動停止」

XAIを活用するメリット

XAIを活用するメリットは下記の3つです。

- AIの判断過程を検証できる

- AIモデルを適切に改善していくことができる

- エンドユーザの信頼を獲得できる

それぞれのポイントを具体的に解説します。

AIの判断過程を検証できる

XAIを活用することで、モデルがデータのどの特徴量を重視して判断をしたのかという判断過程を検証できます。

例えばAIが医療診断を行う場合、医者や患者にAIの出力に対する納得感を与えたり、判断過程が妥当かどうか医者が検証して誤診を防ぐことができます。

このように、「AIがなぜその判断を行ったのか」という判断基準や過程は検証されるべきであり、説明可能性はAI導入成功への一要素となります。

AIモデルを適切に改善していくことができる

XAIにおける判断過程の理解や分析によって、アルゴリズムをよりよいものへと改善することができます。

結果、モデルがどのように判断を行っているのか、どのように改善するべきかをビジネスで関わる人たちに説明しやすくなり、実務で活用する上でのメリットにもなります。

エンドユーザの信頼を獲得できる

AIの予測の根拠を説明できないことが、ユーザのAIに対する不信感の一因になっています。

もしAIの説明可能性を担保できれば、ユーザがAIの判断に納得感をもつことができるようになります。

XAIを活用して予測の根拠を説明できるようにすることで、エンドユーザの信頼を獲得できます。

XAI導入に向けての課題

反対に、XAIを導入する際には下記4つの課題も発生します。

- 個別企業だけでは研究開発が難しい

- AIの回答がすべて正しいとは限らない

- 判断根拠を説明できるが、モデルやデータ自体の修正までは対応できない

- 導入コスト・計算コストがかかる

個別企業だけでは研究開発が難しい

XAIは世界的に研究されている大きな分野で、対象や目的に応じてさまざまなアプローチがあるので、個別企業だけでは研究開発をカバーしきれないという問題があります。

AIの回答がすべて正しいとは限らない

AIの回答がすべて正しいとは限りません。不適切な振る舞いをする可能性も十分にあります。

XAIの結果を「AIの回答がすべて正しい」という前提で解釈すると、説明を誤ってしまいます。説明の信頼性に関しては今もなお議論が続いている状況です。

判断根拠を説明できるが、モデルやデータ自体の修正までは対応できない

第1章で提示した定義の通り、XAIはあくまで「予測に対する説明・付加情報」を得ることまでしかできません。

XAIを利用することで、TayやGoogle Photosのような事例の原因の究明には役立ちますが、「どのようにモデルやデータを修正すべきか」という点までは教えてくれません。

モデルやデータの修正に関しては、モデルの再学習やデータの検証など別のアプローチが必要になります。

導入コスト・計算コストがかかる

XAIは予測に対する説明・付加情報を与えるため、導入コストや計算コストがかかります。

XAI導入には、手元のモデル/データで事前検証(=PoC)が必要です。数多く存在するXAIの手法の選定や、追加のパッケージなどをインストールする際のコストがかかります。

また、モデル作成・予測に加えて、XAI用の計算リソースが必要になります。誤差逆伝播を利用するGrad-CAMなど計算コストがそれなりにかかる方法が多く、手法によっては説明用のモデルを追加で学習する必要があります。

XAIの主な手法

XAIの主な手法は説明の対象の観点で、大域的な説明(Global Explanation)と局所的な説明(Local Explanation)に分けられます。

大域的な説明(Global Explanation)

大域的な説明とは、ニューラルネットワークなどの複雑なモデルを、決定木や線形モデルといった解釈性の高いモデルで近似し、モデルの予測過程を提示する方法のことです。

大域的な説明は、モデルの中身やデータ全体の傾向をどうにかして解釈したい場合に用いられます。

例えば、線形モデルで近似することでモデルが判断の際にどの特徴量を重視しているかといった全体的な傾向が分かります。

局所的な説明(Local Explanation)

局所的な説明とは、あるひとつのデータに着目し、そのデータの予測結果に寄与する特徴量やその予測結果に関連が深い学習データなどを提示する方法のことです。

局所的な説明は、モデルの中身は説明できなくても、データごとに予測の根拠を知りたい場合に用いられます。

具体的には、データごとの予測結果に寄与する特徴量や予測結果に関連する学習データを提示する方法などがあります。

スキルアップAIでは、AI関連のスキル・知識を無料で学べる勉強会をライブ配信しています。ぜひチェックしてみてください。

XAIに関する技術ツールの紹介

ここでは、XAIに関する技術ツールを2つ紹介します。

What-If Tool

What-If Toolは、Googleが開発したデータ可視化のライブラリです。予測結果の可視化や、後述するSHAP値の確認などの多彩な機能をインタラクティブに使用することができます。

また、データのある特徴量を変えた時のモデルの変化などもコードを書かずに確認できます。

SHAP

SHAPはSHapley Additive exPlanationsの略で、モデルの予測結果にして「なぜそのように予測したか」を解析する局所的な説明手法です。予測結果に対して、どの説明変数が大きく寄与したかを明らかにします。

SHAPは、「ゲーム理論」という学問分野で研究されてきたShapley値(ゲーム理論において協力によって得られた利得を各プレイヤーへ公正に分配する方法の一案)をベースとしています。

SHAPの論文著者によるライブラリの実装が公開されているため、簡単にSHAP値の計算を行うことができます。

XAIの活用事例

以下で、実際にXAIを活用した企業の事例を3つ紹介します。

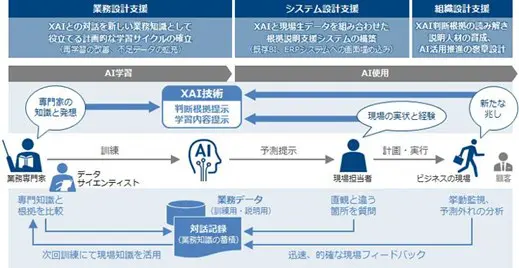

事例1. XAIを活用したAI導入・運用支援サービス(株式会社日立コンサルティング)

日立コンサルティングは、XAIを活用することで、重要な意思決定の可視化や高度化を支援するコンサルティングサービスを提供しています。

AI導入の際の概念検証(PoC;Proof of Concept)と本番環境との差異の原因特定などを行うことができます。

事例2. XAIによる意思決定支援(日本電気株式会社(NEC))

NECは、XAIを「ホワイトボックス型AI」と称しており、因果分析やインバリアント分析といった独自のXAI技術を開発してホワイトボックス型AIの導入を支援しています。故障検知・需要予測・検診結果予測などに応用されています。

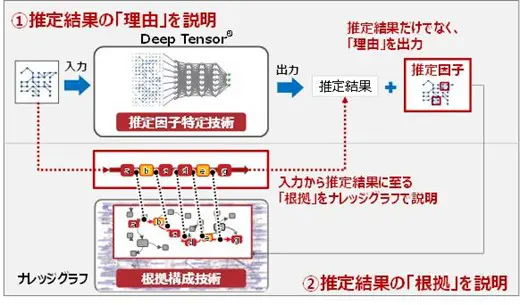

事例3. XAIによる予測根拠の可視化技術(株式会社富士通研究所、富士通株式会社)

富士通研究所と富士通は、グラフ構造(変数間の依存関係)を学習する深層学習モデルに対し、推論根拠となった変数をグラフとして表示する独自技術を開発しました。

XAIに関するおすすめ論文

Score-CAM: Score-Weighted Visual Explanations for Convolutional Neural Networks

この論文で提案されている「Score-CAM」は、CNNの予測において、画像のどの部分が識別に重要だったかを可視化する手法です。

「Grad-CAM」などの従来の手法では勾配計算が必要でしたが、勾配計算を使うと入力の微小な変化によって結果が大きく変わるため、勾配計算に依存しない手法として「Score-CAM」が提案されました。Grad-CAMなどの従来の手法より説明の精度(ノイズの少なさ)が向上しました。

Score-CAM: Score-Weighted Visual Explanations for Convolutional Neural Networks

Generating Visual Explanations

この論文で提案されているGVE(Generating Visual Explanations)という手法では、画像の予測と同時に「なぜそのように予測したか」の説明文を作ります。

論文中では鳥類の画像分類のデータセットが使われており、「This is a {分類クラス名} because {説明文}.」というテンプレートに従って説明文を生成する手法が提案されました。

前半の{クラス名}の部分は、画像分類のCNNを、後半の{説明文}の部分は、文章生成のLSTMを用いることで取得します。

画像を説明する適切な文章を生成するために、強化学習のテクニックも使用されています。

Generating Visual Explanations

Understanding Black-box Predictions via Influence Functions

この論文で提案されたのは、学習におけるデータごとの重要度を測るための手法です。

学習データのうち、どれが識別に重要であったかを突き止めることでモデルの振る舞いを理解します。

基本的なアイデアとしては、対象のデータxの重要度を計算するために、xを含めて学習した場合のモデルと、xを含めず学習した場合のモデルを学習し、予測値の差を取ります。

このアイデアは本質的ではありますが、1回の評価ごとにモデルの再学習が必要になります。

影響関数という手法を導入することで、複数回の学習を行わなくてもデータの重要度を算出することに成功しています。

Understanding Black-box Predictions via Influence Functions

XAIを学習する方法

XAIのおすすめの学習方法を紹介します。

書籍

1. XAI(説明可能なAI)

XAIが重要視されるようになった背景からXAIの代表的な技術までを体系的に学ぶことができる、XAIの入門書籍です。本記事でも言及したSHAPやGrad-CAMなど、代表的なXAIの手法について分かりやすく解説されています。

また、ハンズオンを通じていくつかの主要ライブラリを動かしながら学習することができます。

『大坪直樹, 中江俊博「XAI(説明可能なAI)」,リックテレコム,2021』

2. 機械学習を解釈する技術〜予測力と説明力を両立する実践テクニック

この書籍では、予測精度と解釈性のトレードオフを克服するための手法について、実務において特に有用と考えるものを著者が厳選して紹介しています。モデルの解釈手法を体系的に学ぶことができます。

ハンズオンが付属しており、サンプルコードはgithubで公開されています。

『森下 光之助「機械学習を解釈する技術〜予測力と説明力を両立する実践テクニック」,技術評論社,2021』

テキスト資料

Interp>retable Machine Learningは、機械学習の結果を解釈し、可視化するための方法がまとめられた教科書です。Webサイトで公開されているため、誰でも無料で閲覧できます。

原著は英語になりますが、日本語訳されたものも公開されています(やや古いため、少しバージョンが異なる可能性があります)。

講座

「現場で使える XAI(Explainable AI)講座」は、機械学習モデルの説明可能性に関する社会の要請と最新の研究動向を学び、ハンズオンを通して What-if Tools、SHAP、Grad-CAMといったXAI技術の使用方法を学ぶことができます。

さらに、ビジネスへの応用を想定した実践的なワークを経て、理論を実務へ応用するためのスキルを身に付けることができます。

講座の一部をトライアル版として無料で視聴することもできます。講座の雰囲気やわかりやすさを体験できますので、ぜひお試しください。

また、スキルアップAIでは、AI関連のスキル・知識を無料で学べる勉強会をライブ配信しています。ぜひチェックしてみてください。

XAIに関するよくある質問

最後に、XAIに関するよくある質問とその回答を紹介します。

Q. XAI(説明可能なAI)とは何ですか?

XAIとは、「Explainable AI」の略称で、AIの振る舞いをあらゆる観点から理解し、信頼できるようにすることを目的とする技術の総称です。

Q. XAI(説明可能なAI)はなぜ重要なのですか?

近年よく用いられる深層学習モデルなどは複雑なため、その判断根拠を理解するのが困難であるという性質(ブラックボックス性)があります。

AIのビジネス利用の促進のためには、機械学習モデルのブラックボックス性の緩和が必要なためXAIの取り組みが重要視されています。

Q. XAI(説明可能なAI)のメリットは何ですか?

XAIを導入することで、モデルの判断過程を検証できます。また、判断結果だけでなく判断理由なども添えることで、AIに対するエンドユーザの信頼を獲得するのに役立ちます。

まとめ

この記事では、XAIの意味や代表的な手法、メリット、導入課題、活用事例、おすすめの学習方法などを紹介しました。

今後さまざまなAIモデルが開発されていく中で、その判断理由を理解・説明するXAIの技術はますます重要になります。特に、ビジネスでAIを利用する場合は、エンドユーザの信頼を得るためにXAIについて考慮することは必須になっていくと予想されます。

XAIについての知識を深めるために、ぜひ本記事を参考にしてみてください。

☆☆☆

スキルアップAIのメールマガジンでは会社のお知らせや講座に関するお得な情報を配信しています。配信を希望される方はこちら

また、SNSでも様々なコンテンツをお届けしています。興味を持った方は是非チェックしてください♪

Twitterはこちら

Facebookはこちら

LinkedInはこちら

スキルアップAI公式YouTube AIビジネスチャンネルはこちら