WEBサイトをPDF化したかった

WEBスクレイピングしてPDFにしようとしてた最中に下記記事を見つけた。

ChatGPTだけで動くプログラムが作成できるようなので最高じゃん!で真似をした。

記事は1年前のものなので、違いも出ているのではと思ってプロンプトの勉強もだし、せっかくなのでメモ。

※あと、私はpython素人なのでそこも元記事とは差分

コピペしてchatGPTと対話

Q.あなたはchatGPT-4ですか?

ChatGPT:

はい、私はChatGPT-4ベースのアシスタントです。どのようにお手伝いしましょうか? 😊

Q.あなたはプログラマです。ウェブスクレイピング→情報をPDF保存の自動化ツール開発はどのような案件がひつようでしょうか?

ChatGPT:

ウェブスクレイピング→情報をPDF保存の自動化ツールを開発する際には、以下のような案件が必要になります。案件に応じた具体的な要件やツールを検討することが重要です。

1. 案件内容の定義

目標とする情報:

- スクレイピング対象のウェブサイト (例: ニュースサイト、ECサイト、データベース)

- 収集したい情報の種類 (例: 記事のタイトル・本文、価格情報、画像、日付)

出力形式:

- PDFのデザインと構造 (例: テキストの順序、表のフォーマット、画像の配置)

2. 技術要件

プログラミング言語:

- 一般的な選択肢: Python (強力なライブラリ群)

- ウェブスクレイピング: BeautifulSoup, Scrapy, Selenium

- PDF生成: ReportLab, WeasyPrint, FPDF, PyPDF2

フレームワークやライブラリ:

- スクレイピングに必要な認証や動的コンテンツの対応

- Selenium(JavaScript対応が必要な場合)

- APIが提供されている場合は、APIの利用が最善。

- PDF生成ツール

- シンプルなドキュメント: FPDF、ReportLab

- CSSスタイル対応のレイアウト: WeasyPrint

3. 業務要件

法的・倫理的制約:

- ウェブスクレイピングの対象サイトの利用規約確認

- データ使用に関する規制や著作権への配慮

自動化の要件:

- 定期的な実行 (例: 毎日、毎週)

- エラー処理(ウェブサイト構造変更やネットワークエラーへの対応)

4. 機能要件

必須機能:

- ウェブスクレイピング

- URLリストのインポート

- 動的ページの処理(必要に応じて)

- データ処理

- 不要なデータのフィルタリング

- 必要な情報のフォーマット

- PDF生成

- 収集データを整形してPDF化

- 画像や表の対応

- 保存と出力

- ローカル保存(フォルダ分けなど)

- クラウドサービス連携(例: Google DriveやDropbox)

- エラーログと通知

- エラー発生時のログ記録

- 必要に応じてメールやチャットツールで通知

5. 開発とテスト

スケジュール:

- 設計フェーズ: 1-2週間

- プロトタイプ作成: 2-3週間

- 本開発とテスト: 3-5週間

テスト内容:

- サンプルデータを使った動作確認

- ウェブサイト構造変更への対応テスト

- 大量データのスクレイピング・PDF化パフォーマンス確認

6. 運用・保守

- 定期的なコード更新(スクレイピング対象のウェブサイトが変更された場合)

- ユーザーからのフィードバックを反映した改善

- データバックアップ管理

具体的な案件を進める際には、対象のウェブサイトや求められる出力内容に応じて要件をさらに詳細化します。案件詳細があればそれに基づいてさらに具体的な設計や実装方法を提案できます!

Q.上記をユースケースでPlantUMLで表現して頂けますか

ChatGPT:

以下は、ウェブスクレイピングからPDF保存までのユースケースをPlantUMLで表現する例です。

@startuml

actor User

actor Website as TargetWebsite

rectangle "Web Scraping to PDF Tool" {

usecase "Input Target URLs" as UC1

usecase "Scrape Data" as UC2

usecase "Format Data" as UC3

usecase "Generate PDF" as UC4

usecase "Save or Upload PDF" as UC5

usecase "Handle Errors" as UC6

}

User --> UC1

UC1 --> UC2

UC2 --> UC3

UC3 --> UC4

UC4 --> UC5

UC2 <-- TargetWebsite : Fetch Data

UC2 --> UC6 : On Failure

UC3 --> UC6 : On Failure

UC5 --> UC6 : On Failure

@enduml

ユースケース説明:

- Input Target URLs (UC1): ユーザーがスクレイピング対象のURLリストを入力します。

- Scrape Data (UC2): ツールが指定されたウェブサイトからデータを取得します。

- Format Data (UC3): スクレイピングしたデータをPDF用に整形します。

- Generate PDF (UC4): 整形済みデータをPDF形式に変換します。

- Save or Upload PDF (UC5): 生成したPDFをローカルに保存、またはクラウドにアップロードします。

- Handle Errors (UC6): スクレイピングやPDF生成中のエラーを記録し、通知します。

これを実行すると、ユースケース図が生成されます。このPlantUMLコードを使ってユースケース図を視覚化してください。

Q.上記をシーケンス図でPlantUMLで出力して頂けますか

ChatGPT:

以下は、ウェブスクレイピングからPDF保存までのシーケンス図をPlantUMLで表現した例です。

@startuml

actor User

participant "Web Scraping Tool" as Tool

participant "Target Website" as Website

participant "PDF Generator" as PDFGen

participant "Storage Service" as Storage

User -> Tool: Input Target URLs

Tool -> Website: Fetch Data from URLs

Website --> Tool: Return Data

Tool -> Tool: Process and Format Data

alt Data Fetch Failure

Tool -> User: Notify Error

else Format Failure

Tool -> User: Notify Error

end

Tool -> PDFGen: Generate PDF

PDFGen --> Tool: Return PDF

alt PDF Generation Failure

Tool -> User: Notify Error

else Success

Tool -> Storage: Save or Upload PDF

Storage --> Tool: Acknowledge Save

Tool -> User: Notify Success

end

@enduml

シーケンス図説明

-

Input Target URLs

- ユーザーがスクレイピング対象のURLをツールに提供します。

-

Fetch Data

- ツールが対象ウェブサイトにアクセスしてデータを取得します。

-

Return Data

- ウェブサイトから取得したデータがツールに返されます。

-

Process and Format Data

- ツールがデータをPDFに適した形式に整形します。

-

Error Handling

- データ取得や整形中にエラーが発生した場合、ユーザーに通知します。

-

Generate PDF

- 整形済みデータを基にPDFを生成します。

-

Save or Upload PDF

- 生成されたPDFを保存またはアップロードします。

-

Notify User

- 成功または失敗をユーザーに通知します。

このコードをPlantUMLエディタにコピーして実行することで、視覚的なシーケンス図を生成できます。

- 成功または失敗をユーザーに通知します。

Q.上記を元にクラス図をPlantUMLで記述頂けますか

ChatGPT:

以下は、ウェブスクレイピングからPDF保存までの処理をクラス図で表現したPlantUMLコードです。

@startuml

class WebScrapingTool {

+ inputURLs(urls: List<String>): void

+ fetchData(): List<Data>

+ processData(rawData: List<Data>): ProcessedData

+ handleError(error: String): void

}

class TargetWebsite {

+ fetchContent(url: String): Data

}

class PDFGenerator {

+ generatePDF(data: ProcessedData): PDFFile

}

class StorageService {

+ saveFile(file: PDFFile, location: String): void

+ uploadFile(file: PDFFile, cloudPath: String): void

}

class Data {

- rawContent: String

+ getContent(): String

}

class ProcessedData {

- formattedContent: String

+ getFormattedContent(): String

}

class PDFFile {

- content: Binary

+ getFile(): Binary

}

WebScrapingTool --> TargetWebsite : fetches

WebScrapingTool --> PDFGenerator : processes data

WebScrapingTool --> StorageService : saves/uploads PDF

WebScrapingTool --> Data : extracts raw data

WebScrapingTool --> ProcessedData : formats raw data

PDFGenerator --> PDFFile : generates

StorageService --> PDFFile : handles

@enduml

クラス図説明

- WebScrapingTool:

- メインのツールクラス。

- URL入力、データ取得、データ処理、エラーハンドリングを担当。

- TargetWebsite:

- ウェブサイトからコンテンツを取得するクラス。

- PDFGenerator:

- 整形済みデータを基にPDFを生成するクラス。

- StorageService:

- PDFファイルをローカルストレージまたはクラウドサービスに保存・アップロードするクラス。

- Data:

- ウェブサイトから取得した生データを格納するクラス。

- ProcessedData:

- 整形後のデータを格納するクラス。

- PDFFile:

- 生成されたPDFファイルを表現するクラス。

このクラス図をPlantUMLエディタで実行すると、クラス間の関係や責務が視覚化されます。

- 生成されたPDFファイルを表現するクラス。

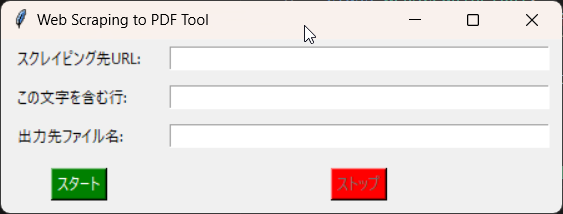

Q.あなたはプログラマです。上記のクラス図を元にPythonで実装をお願い致します。入力としてウインドウに①スクレイピング先のURLと②この文字を含む行を取り出す③出力先ファイル名の入力欄とスクレイピングの「スタート」「ストップ」のボタンをつけてください。

ChatGPT:

以下は、Pythonを使用して、ウェブスクレイピングとPDF生成のGUIアプリケーションを実装するコードです。このコードはtkinterを使ってGUIを構築し、requestsとBeautifulSoupでスクレイピングを行い、fpdfでPDFを生成します。

必要なライブラリ

以下のライブラリが必要です。事前にインストールしてください。

pip install requests beautifulsoup4 fpdf

Pythonコード

import tkinter as tk

from tkinter import messagebox, filedialog

import requests

from bs4 import BeautifulSoup

from fpdf import FPDF

import threading

class WebScrapingTool:

def __init__(self, root):

self.root = root

self.root.title("Web Scraping to PDF Tool")

# GUI Elements

tk.Label(root, text="スクレイピング先URL:").grid(row=0, column=0, padx=10, pady=5, sticky="w")

self.url_entry = tk.Entry(root, width=50)

self.url_entry.grid(row=0, column=1, padx=10, pady=5)

tk.Label(root, text="この文字を含む行:").grid(row=1, column=0, padx=10, pady=5, sticky="w")

self.keyword_entry = tk.Entry(root, width=50)

self.keyword_entry.grid(row=1, column=1, padx=10, pady=5)

tk.Label(root, text="出力先ファイル名:").grid(row=2, column=0, padx=10, pady=5, sticky="w")

self.output_entry = tk.Entry(root, width=50)

self.output_entry.grid(row=2, column=1, padx=10, pady=5)

self.start_button = tk.Button(root, text="スタート", command=self.start_scraping, bg="green", fg="white")

self.start_button.grid(row=3, column=0, padx=10, pady=10)

self.stop_button = tk.Button(root, text="ストップ", command=self.stop_scraping, bg="red", fg="white", state="disabled")

self.stop_button.grid(row=3, column=1, padx=10, pady=10)

# Thread control

self.running = False

self.scraping_thread = None

def start_scraping(self):

url = self.url_entry.get()

keyword = self.keyword_entry.get()

output_file = self.output_entry.get()

if not url or not keyword or not output_file:

messagebox.showerror("エラー", "全ての入力欄を埋めてください。")

return

self.running = True

self.start_button.config(state="disabled")

self.stop_button.config(state="normal")

# Start the scraping process in a separate thread

self.scraping_thread = threading.Thread(target=self.scrape_data, args=(url, keyword, output_file))

self.scraping_thread.start()

def stop_scraping(self):

self.running = False

messagebox.showinfo("情報", "スクレイピングを停止しました。")

def scrape_data(self, url, keyword, output_file):

try:

response = requests.get(url)

response.raise_for_status()

soup = BeautifulSoup(response.text, "html.parser")

# Extract lines containing the keyword

lines = []

for element in soup.stripped_strings:

if keyword in element and self.running:

lines.append(element)

if not lines:

messagebox.showinfo("情報", "指定した文字を含む行が見つかりませんでした。")

else:

self.generate_pdf(lines, output_file)

messagebox.showinfo("成功", f"PDFを生成しました: {output_file}")

except Exception as e:

messagebox.showerror("エラー", f"エラーが発生しました: {str(e)}")

finally:

self.running = False

self.start_button.config(state="normal")

self.stop_button.config(state="disabled")

def generate_pdf(self, lines, output_file):

pdf = FPDF()

pdf.set_auto_page_break(auto=True, margin=15)

pdf.add_page()

pdf.set_font("Arial", size=12)

for line in lines:

pdf.cell(0, 10, txt=line, ln=True)

pdf.output(output_file)

def main():

root = tk.Tk()

app = WebScrapingTool(root)

root.mainloop()

if __name__ == "__main__":

main()

機能の流れ

- GUIで入力:

- スクレイピング対象のURL。

- 抽出条件(指定した文字を含む行)。

- PDFの出力先ファイル名。

- スタートボタン:

- スクレイピングを開始。

- 指定された文字列を含む行を取得。

- ストップボタン:

- スクレイピングを途中停止可能。

- PDF生成:

- 抽出したデータをPDFに整形して保存。

実行方法

-

このコードをPythonスクリプト(例: scraping_to_pdf.py)として保存。

-

ターミナルで実行

python scraping_to_pdf.py -

GUIで必要な情報を入力してツールを使用してください。

カスタマイズが必要であれば、遠慮なくお知らせください!

Q.実行したらエラーになりました。

No module named 'requests'

File "C:\Users\idtrm\vscode\scacyba\testpython\testpython\pdfscraper.py", line 3, in

import requests

ModuleNotFoundError: No module named 'requests'

ChatGPT:

エラーの原因は、Pythonのrequestsライブラリがインストールされていないことです。この問題を解決するには、以下の手順を実行してください。

解決方法

- requestsライブラリのインストール

ターミナルまたはコマンドプロンプトで以下のコマンドを実行して、requestsライブラリをインストールします。

bash:

pip install requests - 他の必要なライブラリの確認

スクリプトには以下のライブラリも使用されています。必要に応じてインストールしてください。

bash

pip install beautifulsoup4 fpdf - 再実行

ライブラリのインストールが完了したら、再度スクリプトを実行してください。

注意点

- 環境によっては、pipではなくpip3を使用する必要があります。

bash:

pip3 install requests - 仮想環境を使用している場合は、仮想環境をアクティブにしてからコマンドを実行してください。

もし問題が引き続き発生する場合は、エラーメッセージを教えてください。追加でサポートします!

Q.

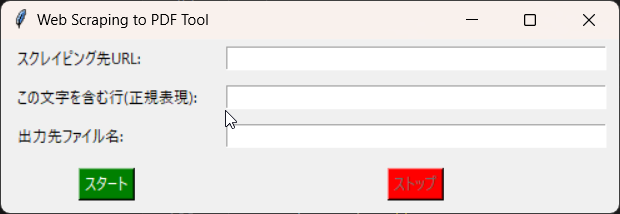

1.この文字を含む行は正規表現が使えるようにしてください。

2.PDFが文字化けしています。

ご指摘ありがとうございます!以下の2点を改善します。

1. この文字を含む行で正規表現を利用可能にする

- reモジュールを使用して正規表現検索に対応させます。

2. PDFの文字化けを防ぐ

- fpdfはデフォルトでUTF-8をサポートしないため、文字化けが発生します。日本語などマルチバイト文字に対応するには、フォント埋め込みが必要です。

- 日本語フォント(例: Noto Sans JP)のTrueTypeフォント(.ttfファイル)を使用します。

以下は修正版のコードです。

修正版コード

import tkinter as tk

from tkinter import messagebox, filedialog

import requests

from bs4 import BeautifulSoup

from fpdf import FPDF

import threading

import re # 正規表現用

class WebScrapingTool:

def __init__(self, root):

self.root = root

self.root.title("Web Scraping to PDF Tool")

# GUI Elements

tk.Label(root, text="スクレイピング先URL:").grid(row=0, column=0, padx=10, pady=5, sticky="w")

self.url_entry = tk.Entry(root, width=50)

self.url_entry.grid(row=0, column=1, padx=10, pady=5)

tk.Label(root, text="この文字を含む行(正規表現):").grid(row=1, column=0, padx=10, pady=5, sticky="w")

self.keyword_entry = tk.Entry(root, width=50)

self.keyword_entry.grid(row=1, column=1, padx=10, pady=5)

tk.Label(root, text="出力先ファイル名:").grid(row=2, column=0, padx=10, pady=5, sticky="w")

self.output_entry = tk.Entry(root, width=50)

self.output_entry.grid(row=2, column=1, padx=10, pady=5)

self.start_button = tk.Button(root, text="スタート", command=self.start_scraping, bg="green", fg="white")

self.start_button.grid(row=3, column=0, padx=10, pady=10)

self.stop_button = tk.Button(root, text="ストップ", command=self.stop_scraping, bg="red", fg="white", state="disabled")

self.stop_button.grid(row=3, column=1, padx=10, pady=10)

# Thread control

self.running = False

self.scraping_thread = None

def start_scraping(self):

url = self.url_entry.get()

keyword = self.keyword_entry.get()

output_file = self.output_entry.get()

if not url or not keyword or not output_file:

messagebox.showerror("エラー", "全ての入力欄を埋めてください。")

return

self.running = True

self.start_button.config(state="disabled")

self.stop_button.config(state="normal")

# Start the scraping process in a separate thread

self.scraping_thread = threading.Thread(target=self.scrape_data, args=(url, keyword, output_file))

self.scraping_thread.start()

def stop_scraping(self):

self.running = False

messagebox.showinfo("情報", "スクレイピングを停止しました。")

def scrape_data(self, url, keyword, output_file):

try:

response = requests.get(url)

response.raise_for_status()

soup = BeautifulSoup(response.text, "html.parser")

# Extract lines matching the regular expression

lines = []

pattern = re.compile(keyword)

for element in soup.stripped_strings:

if pattern.search(element) and self.running:

lines.append(element)

if not lines:

messagebox.showinfo("情報", "指定した条件に一致する行が見つかりませんでした。")

else:

self.generate_pdf(lines, output_file)

messagebox.showinfo("成功", f"PDFを生成しました: {output_file}")

except Exception as e:

messagebox.showerror("エラー", f"エラーが発生しました: {str(e)}")

finally:

self.running = False

self.start_button.config(state="normal")

self.stop_button.config(state="disabled")

def generate_pdf(self, lines, output_file):

pdf = FPDF()

pdf.set_auto_page_break(auto=True, margin=15)

pdf.add_page()

# Add Japanese font (TrueType Font required)

pdf.add_font("NotoSans", "", "NotoSansJP-Regular.ttf", uni=True)

pdf.set_font("NotoSans", size=12)

for line in lines:

pdf.multi_cell(0, 10, line)

pdf.output(output_file)

def main():

root = tk.Tk()

app = WebScrapingTool(root)

root.mainloop()

if __name__ == "__main__":

main()

必要なフォントファイルの準備

- 日本語フォントのダウンロード

- Noto Sans JP などのフォントをダウンロードしてください。

- フォントファイルの配置

- フォントファイル(例: NotoSansJP-Regular.ttf)をスクリプトと同じフォルダに配置します。

改善点

- 正規表現対応

- 入力欄で指定された正規表現に一致する行を抽出します。

- PDF文字化け防止

- FPDF.add_fontメソッドで日本語フォントを埋め込み、UTF-8対応を実現。

実行方法

- 修正版コードを保存します。

- 必要なフォントを準備してスクリプトと同じフォルダに配置します。

- スクリプトを実行し、正規表現を含むデータでPDFを作成してください。

不明点やさらなる改善が必要であればお気軽にお知らせください!

※まだ文字化けしてたのでPDFの先頭あたりを貼り付け

Q.下記のように文字化けします。

ã«ã¹ã¿ã ãã¡ã¦ã³ããª| ãã§ãããã¯ã»ãã³ã³ãã¯ã¿ã¼æ ªå¼ä¼ç¤¾

ãã¼ã

ä¼æ¥æ å ±

æ¡ç¨æ å ±

ãç¥ãã

ã«ã¹ã¿ã ãã¡ã¦ã³ããª

ãªãªã¸ãã«ãã¡ã¦ã³ããª

ãã§ãããã¯ã®SiCåå°ä½

å質ãç°å¢ã»å®å ¨ã社ä¼ã¸ã®åçµã

これは、PDF生成時にテキストが適切にエンコードされていないことが原因です。FPDFライブラリでは、UTF-8を直接サポートしていないため、日本語などのマルチバイト文字を扱うには特別な設定が必要です。

以下の手順で問題を修正します。

修正版コード(文字化け修正)

以下のコードは、文字化けを防ぐためにFPDF.add_fontを使ってTrueTypeフォントを適切に設定しています。

import tkinter as tk

from tkinter import messagebox

import requests

from bs4 import BeautifulSoup

from fpdf import FPDF

import threading

import re

class WebScrapingTool:

def __init__(self, root):

self.root = root

self.root.title("Web Scraping to PDF Tool")

# GUI Elements

tk.Label(root, text="スクレイピング先URL:").grid(row=0, column=0, padx=10, pady=5, sticky="w")

self.url_entry = tk.Entry(root, width=50)

self.url_entry.grid(row=0, column=1, padx=10, pady=5)

tk.Label(root, text="この文字を含む行(正規表現):").grid(row=1, column=0, padx=10, pady=5, sticky="w")

self.keyword_entry = tk.Entry(root, width=50)

self.keyword_entry.grid(row=1, column=1, padx=10, pady=5)

tk.Label(root, text="出力先ファイル名:").grid(row=2, column=0, padx=10, pady=5, sticky="w")

self.output_entry = tk.Entry(root, width=50)

self.output_entry.grid(row=2, column=1, padx=10, pady=5)

self.start_button = tk.Button(root, text="スタート", command=self.start_scraping, bg="green", fg="white")

self.start_button.grid(row=3, column=0, padx=10, pady=10)

self.stop_button = tk.Button(root, text="ストップ", command=self.stop_scraping, bg="red", fg="white", state="disabled")

self.stop_button.grid(row=3, column=1, padx=10, pady=10)

# Thread control

self.running = False

self.scraping_thread = None

def start_scraping(self):

url = self.url_entry.get()

keyword = self.keyword_entry.get()

output_file = self.output_entry.get()

if not url or not keyword or not output_file:

messagebox.showerror("エラー", "全ての入力欄を埋めてください。")

return

self.running = True

self.start_button.config(state="disabled")

self.stop_button.config(state="normal")

# Start the scraping process in a separate thread

self.scraping_thread = threading.Thread(target=self.scrape_data, args=(url, keyword, output_file))

self.scraping_thread.start()

def stop_scraping(self):

self.running = False

messagebox.showinfo("情報", "スクレイピングを停止しました。")

def scrape_data(self, url, keyword, output_file):

try:

response = requests.get(url)

response.raise_for_status()

soup = BeautifulSoup(response.text, "html.parser")

# Extract lines matching the regular expression

lines = []

pattern = re.compile(keyword)

for element in soup.stripped_strings:

if pattern.search(element) and self.running:

lines.append(element)

if not lines:

messagebox.showinfo("情報", "指定した条件に一致する行が見つかりませんでした。")

else:

self.generate_pdf(lines, output_file)

messagebox.showinfo("成功", f"PDFを生成しました: {output_file}")

except Exception as e:

messagebox.showerror("エラー", f"エラーが発生しました: {str(e)}")

finally:

self.running = False

self.start_button.config(state="normal")

self.stop_button.config(state="disabled")

def generate_pdf(self, lines, output_file):

pdf = FPDF()

pdf.add_page()

# Add Japanese font (TrueType Font required)

pdf.add_font("NotoSans", "", "NotoSansJP-Regular.ttf", uni=True)

pdf.set_font("NotoSans", size=12)

for line in lines:

pdf.multi_cell(0, 10, line)

pdf.output(output_file, "F")

def main():

root = tk.Tk()

app = WebScrapingTool(root)

root.mainloop()

if __name__ == "__main__":

main()

変更点

- 日本語フォントの追加:

- FPDF.add_fontを使用して、日本語対応フォント(例: NotoSansJP-Regular.ttf)を追加しました。

- フォントファイルをスクリプトと同じディレクトリに配置してください。

- UTF-8対応のPDF生成:

- フォントが日本語を正しく扱えるようにuni=Trueを指定。

- 正規表現の対応:

- 正規表現に基づいて一致するテキストを抽出します。

必要な手順

- Noto Sans JP フォントをダウンロードします。

- フォントファイル(NotoSansJP-Regular.ttf)をスクリプトと同じディレクトリに保存します。

- スクリプトを実行して、PDFが正しく生成されることを確認します。

これで文字化けが解消されるはずです。引き続き問題がある場合はお知らせください!

※まだ文字化けしてたのでPDFの先頭あたりを貼り付け

Q.まだ文字化けします

ã«ã¹ã¿ã ãã¡ã¦ã³ããª| ãã§ãããã¯ã»ãã³ã³ãã¯ã¿ã¼æ ªå¼ä¼ç¤¾

ãã¼ã

ä¼æ¥æ å ±

æ¡ç¨æ å ±

ãç¥ãã

ã«ã¹ã¿ã ãã¡ã¦ã³ããª

ãªãªã¸ãã«ãã¡ã¦ã³ããª

ãã§ãããã¯ã®SiCåå°ä½

å質ãç°å¢ã»å®å ¨ã社ä¼ã¸ã®åçµã¿

ãååã

ãã©ã¤ãã·ã¼ããªã·ã¼

ãã§ãããã¯ã»ãã³ã³ãã¯ã¿ã¼æ ªå¼ä¼ç¤¾

ãã§ãããã¯ã»ãã³ã³ãã¯ã¿ã¼æ ªå¼ä¼ç¤¾

Language

English

|

ä¸æ

ãã¼ã

ä¼æ¥æ å

ChatGPT:

文字化けが発生する原因として、HTMLページの文字エンコーディングが適切に処理されていない可能性があります。通常、スクレイピングしたデータのエンコーディングはBeautifulSoupで自動的に推定されますが、失敗する場合もあります。この問題を修正するため、以下の手順で文字エンコーディングを明示的に指定します。

修正版コード

以下は、レスポンスのエンコーディングを明示的に設定し、文字化けを防止したコードです。

import tkinter as tk

from tkinter import messagebox

import requests

from bs4 import BeautifulSoup

from fpdf import FPDF

import threading

import re

class WebScrapingTool:

def __init__(self, root):

self.root = root

self.root.title("Web Scraping to PDF Tool")

# GUI Elements

tk.Label(root, text="スクレイピング先URL:").grid(row=0, column=0, padx=10, pady=5, sticky="w")

self.url_entry = tk.Entry(root, width=50)

self.url_entry.grid(row=0, column=1, padx=10, pady=5)

tk.Label(root, text="この文字を含む行(正規表現):").grid(row=1, column=0, padx=10, pady=5, sticky="w")

self.keyword_entry = tk.Entry(root, width=50)

self.keyword_entry.grid(row=1, column=1, padx=10, pady=5)

tk.Label(root, text="出力先ファイル名:").grid(row=2, column=0, padx=10, pady=5, sticky="w")

self.output_entry = tk.Entry(root, width=50)

self.output_entry.grid(row=2, column=1, padx=10, pady=5)

self.start_button = tk.Button(root, text="スタート", command=self.start_scraping, bg="green", fg="white")

self.start_button.grid(row=3, column=0, padx=10, pady=10)

self.stop_button = tk.Button(root, text="ストップ", command=self.stop_scraping, bg="red", fg="white", state="disabled")

self.stop_button.grid(row=3, column=1, padx=10, pady=10)

# Thread control

self.running = False

self.scraping_thread = None

def start_scraping(self):

url = self.url_entry.get()

keyword = self.keyword_entry.get()

output_file = self.output_entry.get()

if not url or not keyword or not output_file:

messagebox.showerror("エラー", "全ての入力欄を埋めてください。")

return

self.running = True

self.start_button.config(state="disabled")

self.stop_button.config(state="normal")

# Start the scraping process in a separate thread

self.scraping_thread = threading.Thread(target=self.scrape_data, args=(url, keyword, output_file))

self.scraping_thread.start()

def stop_scraping(self):

self.running = False

messagebox.showinfo("情報", "スクレイピングを停止しました。")

def scrape_data(self, url, keyword, output_file):

try:

response = requests.get(url)

response.raise_for_status()

# 明示的にエンコーディングを設定

response.encoding = response.apparent_encoding

soup = BeautifulSoup(response.text, "html.parser")

# Extract lines matching the regular expression

lines = []

pattern = re.compile(keyword)

for element in soup.stripped_strings:

if pattern.search(element) and self.running:

lines.append(element)

if not lines:

messagebox.showinfo("情報", "指定した条件に一致する行が見つかりませんでした。")

else:

self.generate_pdf(lines, output_file)

messagebox.showinfo("成功", f"PDFを生成しました: {output_file}")

except Exception as e:

messagebox.showerror("エラー", f"エラーが発生しました: {str(e)}")

finally:

self.running = False

self.start_button.config(state="normal")

self.stop_button.config(state="disabled")

def generate_pdf(self, lines, output_file):

pdf = FPDF()

pdf.add_page()

# Add Japanese font (TrueType Font required)

pdf.add_font("NotoSans", "", "NotoSansJP-Regular.ttf", uni=True)

pdf.set_font("NotoSans", size=12)

for line in lines:

pdf.multi_cell(0, 10, line)

pdf.output(output_file, "F")

def main():

root = tk.Tk()

app = WebScrapingTool(root)

root.mainloop()

if __name__ == "__main__":

main()

修正ポイント

- エンコーディングの設定:

- レスポンスのresponse.encodingをresponse.apparent_encodingに設定することで、文字化けを防ぎます。

- 日本語フォントの設定:

- 日本語フォントが適切に利用されていることを確認してください(例: NotoSansJP-Regular.ttf)。

必要な手順

- コードを修正し、再度実行します。

- エンコーディングが正しく設定されることで、PDFの文字化けが解消されるはずです。

これでも解決しない場合は、スクレイピング対象のURLや文字列の形式についてもう少し詳しく教えていただければ、さらに調査します。

まとめ

上記でいったん期待した程度のものが得られた。

元記事を真似するだけだったのだが、私がPython素人だったのでそこもChatGPTにフォローしてもらえたので有能だった。

正規表現に対応するところはちょっと欲が出てやってしまった。が、うまくいってよかった!

→この記事以前でも、いろいろ試す中でプロンプトの内容が悪く(だと思っている。日本語的には正しいのだが)、いったん変なコードが出力されると軌道修正できないことがよくあったので、たまたまうまくいったという理解でいる。

→この場合、新しいチャットを開始してやり直ししかないのかな。。。