2025年2月に発表されたプロンプト最適化の研究

最近仕事で扱った参考文献が面白かったので、メモにしておきます。

タイトル「Intent-based Prompt Calibration: Enhancing prompt optimization with synthetic boundary cases」という論文の内容です。

和訳すると、

「意図に基づくプロンプト調整: 合成された境界事例を用いたプロンプト最適化の強化」

「Intent-based Prompt Calibration(IPC)」 という新しい手法、

大規模言語モデルの性能を最大限に引き出し、ユーザーの意図に沿ったプロンプトを自動的に最適化する手法を提案しています。

IPCを日本語で言うと「意図ベースのプロンプト最適化」、

特にAIが誤解しやすいケース(境界事例)を作成し、それを学習させることで、より正確で意図に沿った回答を引き出せるようにします。この辺りがIPCの大きな特徴かもしれません。

めっちゃ簡単に言うと、「AIへの指示を賢く調整して、もっと的確な答えを得られるようにする仕組み」ということっぽいですね。

IPCの概要

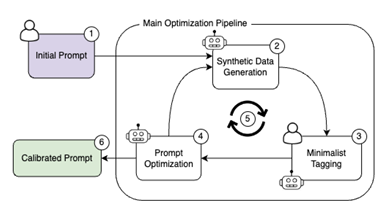

IPCは、ユーザーが"初期プロンプト"を提供し、その初期プロンプトに対して"合成データ"を生成しプロンプトの性能を評価します。

LLMがその性能評価に基づいて、"新たなプロンプト"を提案するというプロセスを繰り返します。

このプロセスの繰り返しにより、よりユーザーの意図に適したプロンプトが生成されるというわけです。特に、「境界事例・モデルが誤りやすいケースを"合成データ"として生成し、それに基づいてプロンプトを最適化する点」が特徴的です。

論文内の実験では、従来の最先端手法を上回る性能を示したそうで、またシステムの各主要コンポーネントの有効性も検証されています。他タスクへの適応も簡単になっているようです。

詳細は以下Github

IPCを使用するための詳細な情報やコードは、以下のGitHubリポジトリ「AutoPrompt」にて公開されています。

詳細な使用手順や依存関係については、リポジトリ内のREADME.mdやドキュメントをご参照ください。

AutoPromptを活用することで、手動でのプロンプトエンジニアリングの手間を大幅に削減し、モデルの性能を効果的に向上させることが期待できます。

プロンプトエンジニアリングとの違い

最初にこれを見た時にプロンプトエンジニアリングの進化系っぽいイメージがありました。

正確に言うと、part-ofの関係になります。

プロンプトエンジニアリング は、大規模言語モデルから適切な出力を得るために、プロンプトを設計・最適化する技術全般を指します。これは人間が手動で試行錯誤しながらプロンプトを調整することが一般的です。

一方、IPCは、プロンプトエンジニアリングの中でも「自動化」に焦点を当てたアプローチです。特に、境界事例を合成し、それを利用してプロンプトを最適化することで、ユーザーの意図に沿ったより良い出力を得ることを目的としています。

広義的にIPCはプロンプトエンジニアリングの一部でありますが、特に「最適化手法の自動化」に分類されます。つまり、プロンプトエンジニアリングが広い概念であり、IPCはその中の高度な自動化技術の一つという位置づけになります。

| 項目 | プロンプトエンジニアリング | IPC |

|---|---|---|

| 定義 | AIの出力を最適化するためにプロンプトを設計・調整する技術全般 | プロンプトを合成データと自動最適化アルゴリズムを用いて調整する手法 |

| アプローチ | 手動 or 半自動(人が試行錯誤) | 自動(合成データを活用しAIが調整) |

| 目的 | 適切なAIの応答を引き出す | 境界事例を考慮しつつプロンプトを最適化 |

| 特徴 | 試行錯誤しながら調整 | AIが最適化プロセスを主導 |

Pythonで使用する手順

AutoPromptのIPC(Intent-based Prompt Calibration)機能をPythonで使用するには、以下の手順を参考にしてください。

1. リポジトリのクローンと依存関係のインストール

まず、AutoPromptのリポジトリをローカル環境にクローンし、必要な依存関係をインストールします。

git clone https://github.com/Eladlev/AutoPrompt.git

cd AutoPrompt

Pythonのバージョンは3.10以下が推奨されています。

2. LLM(大規模言語モデル)の設定

config/llm_env.ymlファイル内のopenai_api_keyに、OpenAIのAPIキーを設定します。APIキーの取得方法については、OpenAIの公式サイトを参照してください。

推奨モデルはGPT-4ですが、他のモデルやプロバイダーもサポートされています。

3. アノテーション手法の選択

プロジェクトに適したアノテーション手法を選択します。人間が介入する方法(Argillaの使用)や、LLMをアノテーターとして設定する方法があります。

4. パイプラインの実行

設定が完了したら、以下のコマンドでパイプラインを実行し、プロンプトの最適化を開始します。

python run_pipeline.py

このコマンドは、デフォルトの設定に基づいてプロンプトの最適化を行います。詳細な使用例や追加のオプションについては、README.md内の「Prompt optimization examples」セクションを参照してください。

引用

以下関連文書も置いておきます。