前回の記事ではYOLO V3のKeras版をWatson Studioで動かして、学習済みモデルを使用した物体検出をやってみました。今回はこのモデルを自前の画像で学習させて任意のモノを検出するカスタム物体検出に挑戦します。大きな流れとしては以下のようになります。

-

教師データの作成

検出したい物体をアノテーションツールで学習させて教師データを作成します -

YOLOモデルの学習

Watson StudioのDLaaS(Deep Learning as a Service)機能を使ってYOLOモデルを学習します -

物体検出

作成したモデルを使ってカスタム物体検出を実行します

今回も学習のためのコードは以下のものを参考にしています。

https://github.com/experiencor/keras-yolo3

1. 教師データの作成

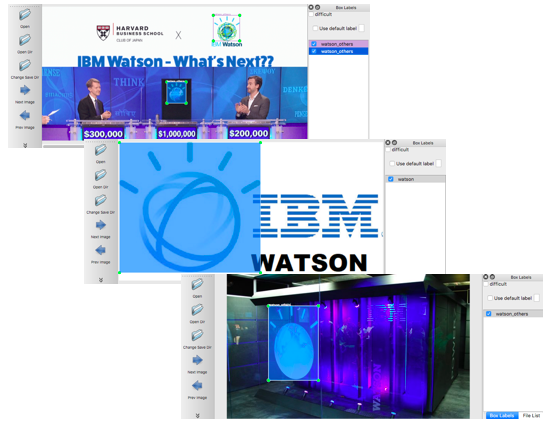

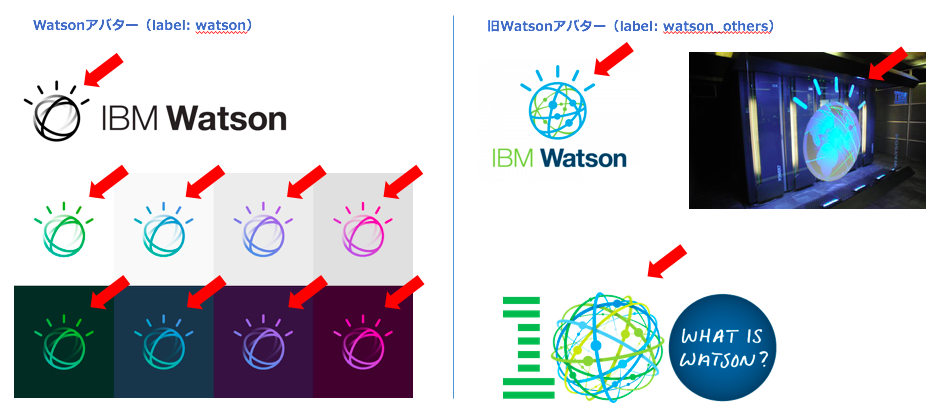

今回は以下のような「IBM Watson」のアバターを新旧の区別も含めて検出できるか試してみたいと思います。

まずは、画像のアノテーションツールを使ってロゴを学習させていきます。画像のアノテーションツールはさまざまものがありますが、私はlabelImgを使用しました。導入手順はリンク先の他、色々なところで紹介されているので割愛します。学習のための画像をWeb等で収集した上で、labelImg で watson および watson_others をアノテーションしていきます。アノテーション結果は Pascal VOC 形式で出力します。

学習で使用した画像とアノテーション結果をGitに置いているので、引き続きの手順はこちらをgit clone して使用します。

git clone https://github.com/schiyoda/YOLOV3-Keras-Custom.git

labelImg の 「Open Dir」メニューで images フォルダーを、「Change Save Dir」で annotations フォルダー指定することで、アノテーションした結果を参照可能です。

2. YOLOモデルの学習

アノテーションしたデータを使用してYOLOモデルをWatson StudioのDLaaS機能で学習します。

学習済み重みデータの取得

学習を早く完了されるために、学習済み重みデータを取得します。以下リンク先より backend.h5 ファイルを train フォルダにダウンロードします。

https://1drv.ms/u/s!ApLdDEW3ut5fgQXa7GzSlG-mdza6

http://www.mediafire.com/file/l1b96fk7j18yi7v/backend.h5

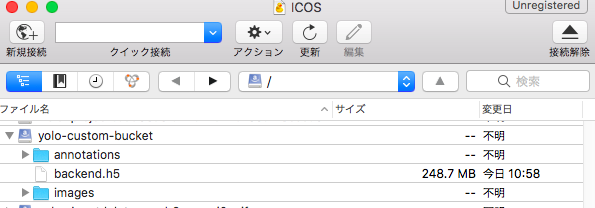

学習用のデータのアップロード

ICOS(IBM Cloud Object Storage)にバケットを作成した上で、学習用のデータをアップロードします。バケットの作成は以下等を参照してください。

アップロード後のフォルダ構成は以下のようになっています。

学習の実行

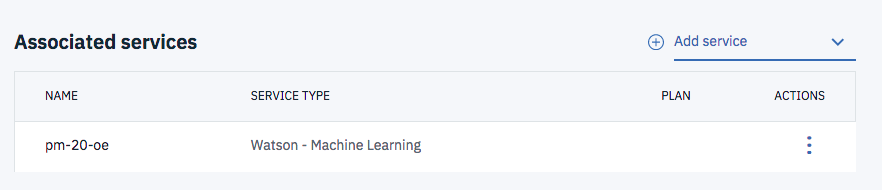

Watson Studioで適当なプロジェクトを作成します。プロジェクトのSettingsタブからWatson Machine Learningのサービスを紐付けておきます。

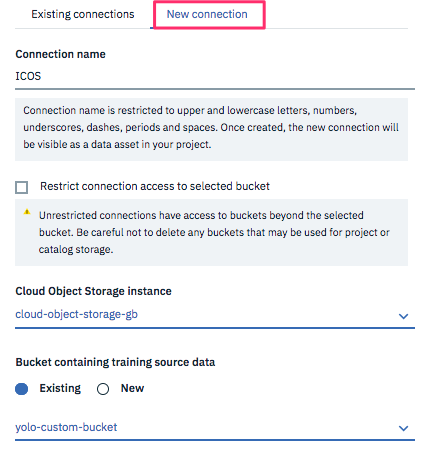

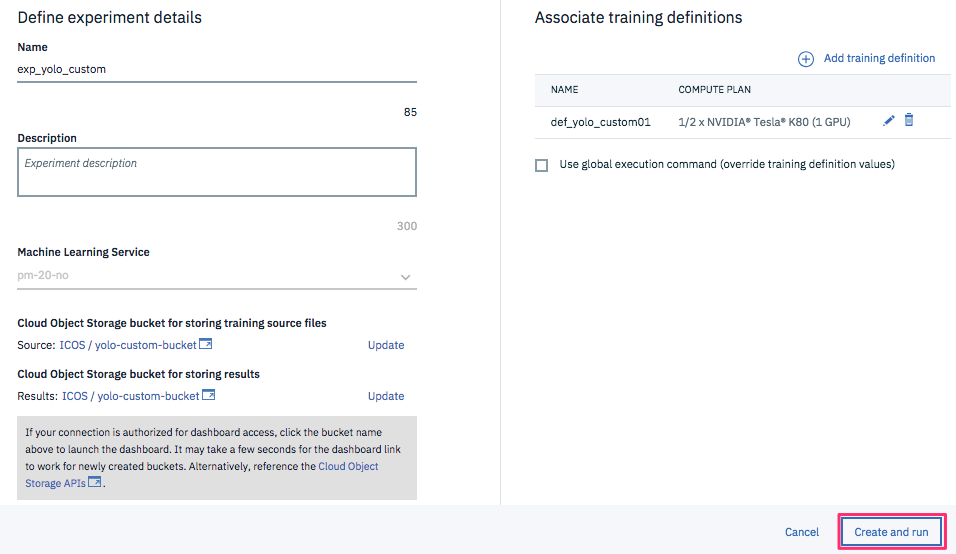

プロジェクトのページに戻り、新規 Experiment を作成します。

Cloud Object Storage bucket for storing training source files、Cloud Object Storage bucket for storing results には先ほど学習用のデータをアップロードしたバケットを指定します。

をクリックし、training definition を作成します。

をクリックし、training definition を作成します。

- Name: 適当な名前を入力

- Training source code: Gitからダウンロードした zip ファイル(yolov3-keras-custom.zip)

- Framework: tensorflow 1.5

- Execution command:

pip install opencv-python-headless && python train.py -c config.json

- Compute plan: K80 (1 GPU)

今回は watson/watson_others というラベルで学習させていますが、別のデータで学習させたい場合は、zip ファイル中の config.json の以下のフィールドを変更してください。

"labels": ["watson","watson_others"]

設定が完了したら以下の画面で Create and run をクリックし、学習を開始します。

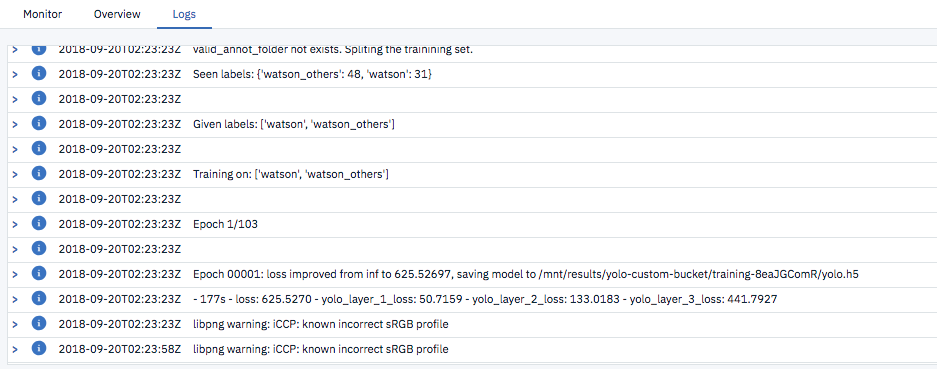

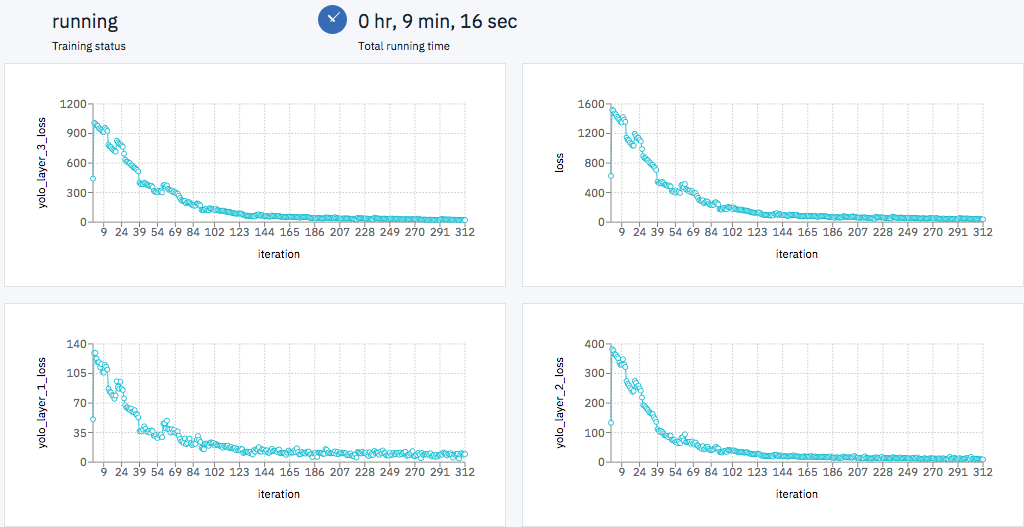

学習が開始すると、以下のよう学習曲線や実行のログや参照可能です。

3. 物体検出

モデルのデプロイ

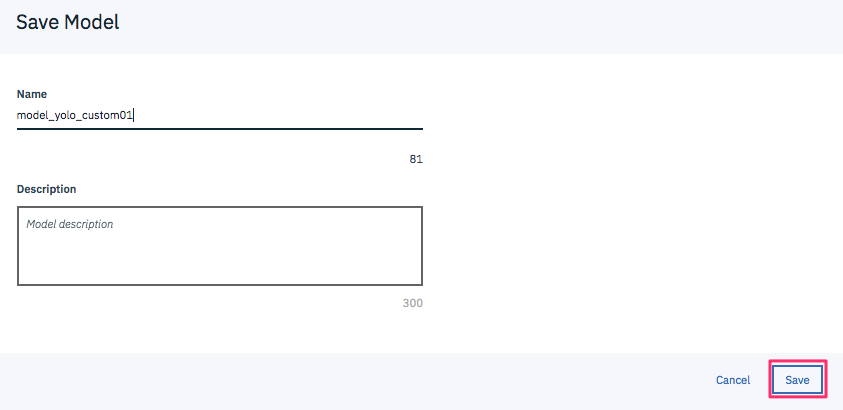

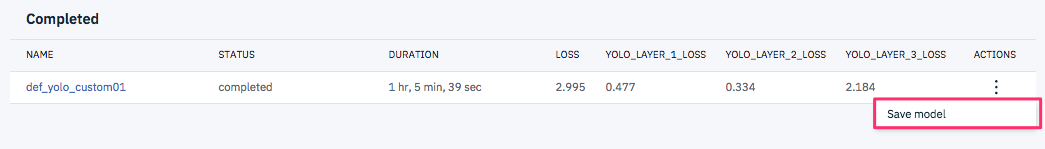

学習が完了(Completed)したら、モデルを保存(Save model)します。

プロジェクトのページに戻ると Watson Machine Learning models にモデルが保管されたことが分かるので、モデル名をクリックします。

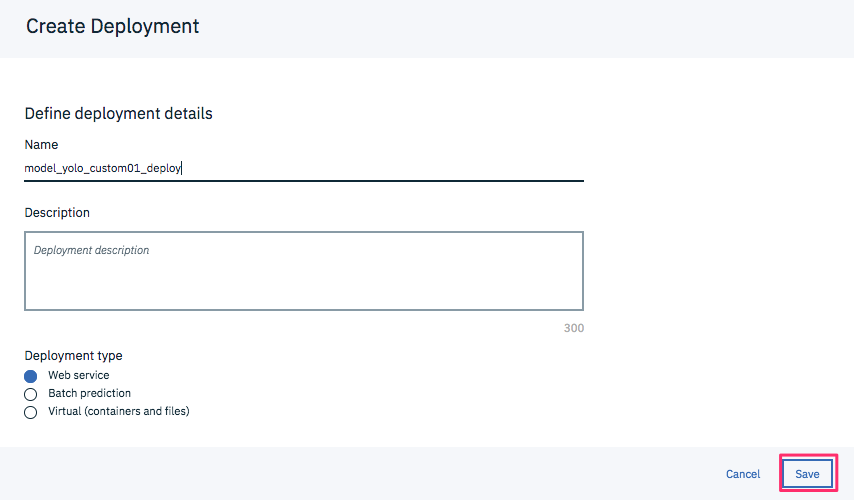

Deployments タブから Add Deployment をクリックし、適当な名前をつけてSave します。

STATUS が DEPLOY_SUCCESS となったらデプロイ完了です。

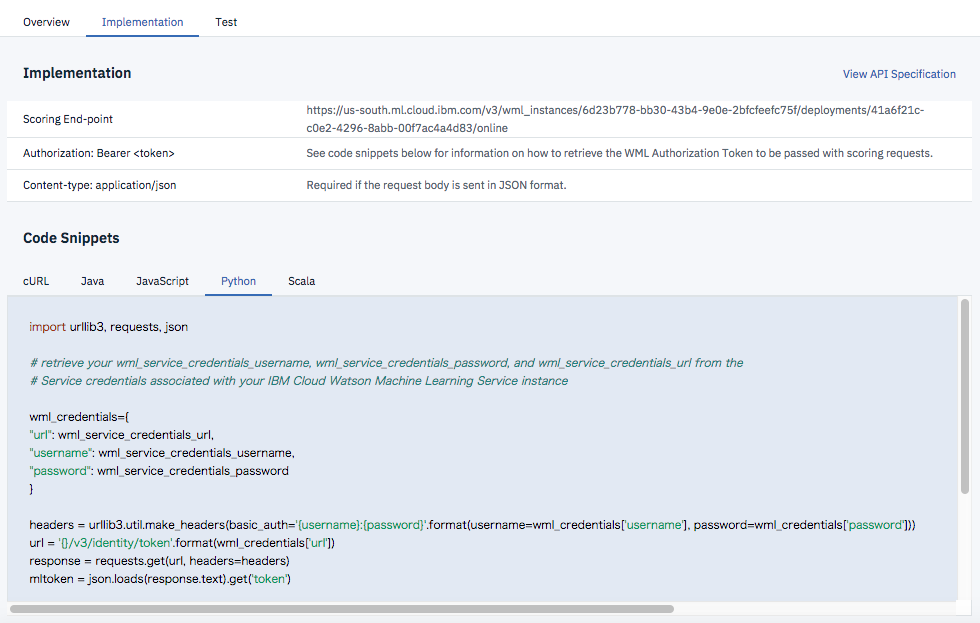

デプロイすると、モデルを呼び出すための Scoring End Point やアプリ作成に使えるCode Snippetが生成されます。

物体検出のテスト

Watson Studioでプロジェクトを作成して、以下リンク先から Notebook を作成します。

https://github.com/schiyoda/YOLOV3-Keras-Custom/blob/master/yolov3_keras_custom.ipynb

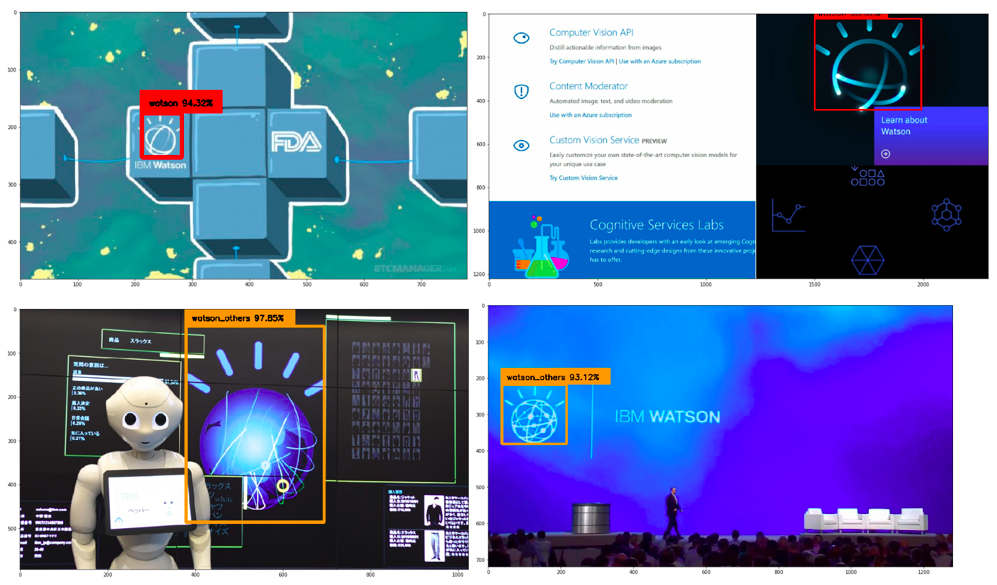

Notebookでは上記のCode SnippetでデプロイしたWebサービスをコールして物体検出を実行します。いくつかの画像で試してみると以下のように物体検出できることが確認できました。