はじめに

説明可能なAI(Explainable AI, XAI)とは、AIが出した答えや意思決定プロセスに対して、人間が理解しやすい形で説明する技術やプロセスのことをいう。

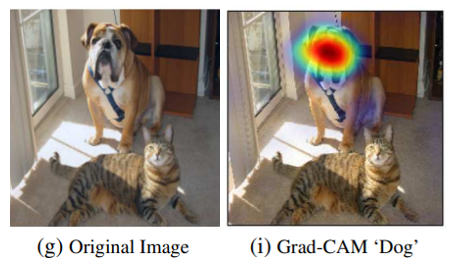

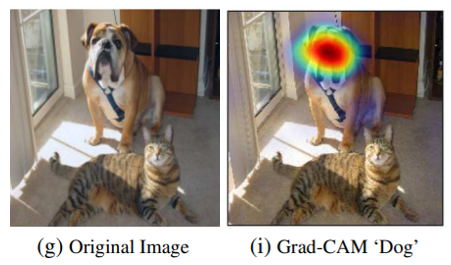

例えば、画像認識の分野ではAIモデルが画像のどの部分に着目して予測を出しているのか可視化する技術が存在する。以下の例では、AIが画像を見て犬と判断する場合は犬の顔に着目していることが読み取れる。

今回はXAIの説明範囲や活用方法などXAIの概要についてまとめる。

XAIの説明範囲

XAIによるAIの説明は大局説明と局所説明に大別することができる。それぞれについて説明する。

大局説明とは

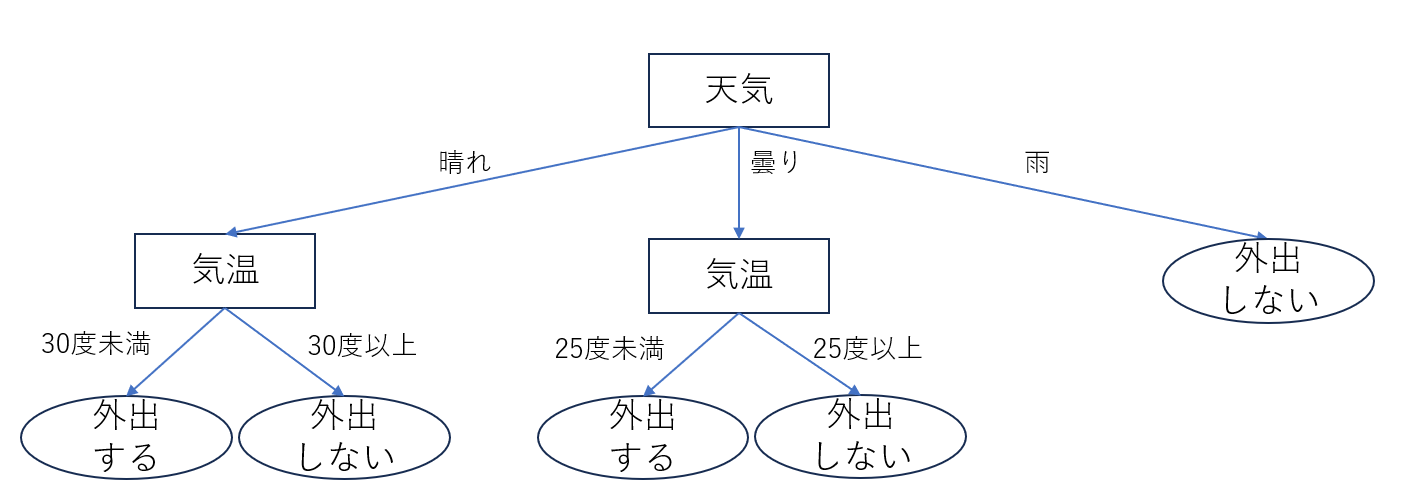

大局説明とは、AIモデル全体の振る舞いや決定ロジックを理解するための説明である。AIモデルの判断ロジックを可視化したり、特徴量ごとの予測に対する重要性を算出する技術は大局説明に当たる。

例えば、決定木は意志決定のプロセスを可視化することができるため大局説明をしているといえる。

また、LASSO回帰では回帰式において特徴量に乗じる係数の値によって予測に対する特徴量の重要度を評価することもできる。そのため、LASSO回帰でも大局的説明ができると考えることができる。

このように大局的説明ではモデルの全体的な振る舞いを把握することができる。

大局説明の活用方法

大局説明の活用方法は以下が挙げられる。

- モデルの改善と最適化

- 透明性の確保

モデルの改善と最適化

AIモデルに重要な特徴量を把握することで、不要または誤解を招く特徴量を排除することができる。これにより、モデルのパフォーマンスを向上させるとともに、過学習を防ぐことが可能になる。

透明性の確保

AIモデルがどのような特徴量やパターンに基づいて決定を下すのかを理解することで、意思決定プロセスの透明性を確保する。

例えば、科学研究にAIを活用する場合、AIの意思決定プロセスを理解することで、人間が実験計画を立てる時に役立てることができる。意思決定をサポートするAIシステムでは大局説明は特に重要である。

局所説明とは

局所説明とは、与えられる1つの事例(入力データ)に対する予測過程を説明することである。局所説明は特定の予測に焦点を当てて、その個別の事例についてAIモデルがどのようにして結論に至ったのかを説明する。

例えば、上述のAIモデルが画像のどこに着目しているかを可視化する技術(Grad-CAM)は局所説明に当たる。

※ [1]のfig.1より一部抜粋

このように各々の予測に対して、AIがどう判断をしたのかの説明が局所説明である。

局所説明の活用方法

局所説明の活用方法は以下が挙げられる。

- 予測の妥当性検証

- 意図とは異なる学習の見直し

予測の妥当性検証

先に挙げたGrad-CAMの事例では犬の顔に焦点を当てて"犬"と予測をしているため信頼できる予測と考えることができる。

一方で、犬とは関係のない領域を着目して"犬"と出力していた場合、たとえ予測が当たっていたとしても予測の信頼性は低いと判断できる。

このように局所説明を行うことによって、予測が妥当かどうかを検証することが可能となる。

意図とは異なる学習の見直し

局所説明を応用することで、AIモデルの学習が適切に行われたかどうかを検証することができる。

例えば、上述のGrad-CAMの例で、窓を見て犬と判断していたのであれば、訓練データに犬と窓がセットになった画像が多すぎるのではと推測できる。

これにより、学習データを見直すことができる。このように局所説明は予測の妥当性だけなく、学習の妥当性についても示唆を得ることができる。

敵対性攻撃に対するXAIの活用

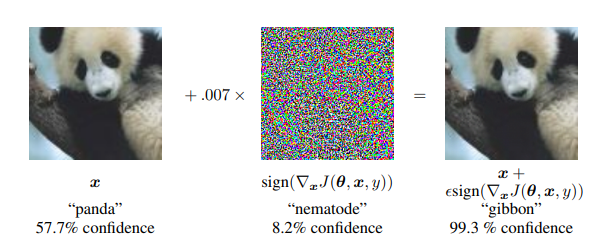

AIについて懸念されている問題の1つに敵対性攻撃がある。例えば、パンダの画像にノイズとなるデータを加えることで、テナガザルと誤認識する事例が報告されている[3]。

パンタの画像であればそこまで問題ないかもしれないが、自動運転の分野で画像を誤認識をするように攻撃されたら安全性に大きな懸念がでる。

XAIを活用することで、敵対的に操作された個々の事例の理解や、AIモデルの意思決定プロセスの妥当性を理解することで敵対性攻撃を検知できる可能性がある。

このようにXAIは敵対性攻撃の防御戦略の一部として有効に機能する可能性がある。

おわりに

今回はXAIの概要について記載した。具体的なXAIの手法については次回以降の記事で少しずつ執筆していこうと思う。

何か間違いがあれば、コメントで気軽にご指摘ください。

参考文献

[1] Ramprasaath R. Selvaraju, et al.; Proceedings of the IEEE International Conference on Computer Vision (ICCV), 2017, pp. 618-626

[2] XAI(説明可能なAI)--そのとき人工知能はどう考えたのか?

[3] https://arxiv.org/pdf/1412.6572.pdf

関連記事