目次

[1.はじめに](#1-はじめに) [2.インストールと起動](#2-インストールと起動) [3.画面の説明](#3-画面の説明) [4.キャラクター選択と追加](#4-キャラクター選択と追加) [5.フェイスチャンネルマッピング](#5-フェイスチャンネルマッピング) [6.顔認識の設定](#6-顔認識の設定) [7.ソフト全般の設定](#7-ソフト全般の設定) [8.モーションのショートカットキー登録](#8-モーションのショートカットキー登録) [9.運用](#9-運用) [10.追記事項](#10-追記事項) [11.終わりに](#11-終わりに)1. はじめに

この記事は顔認識精度が異常に高いフェイストラッキングソフト「VUP」の導入から初期設定、運用までのマニュアルです。

最近話題になっている「VTube Studio」や「Animaze」とは異なり、最新型のスマートフォン等は必要なく、Webカメラのみで気軽に3DモデルやLive2Dを動かすことができます。また無料でダウンロードできるため、バーチャルYoutuberを試しに動かしてみたい人にも最適です。

※上記は自分のツイートより抜粋

※上記は自分のツイートより抜粋

対応機材

顔認識:Webカメラ、Android

全身認識:Noitom,Xsens,FoHeart,光学,IKINEMAOrion,Kinect

上半身認識:HTCVR、RealSense

手認識:Leapmotion,Hi5

今回は最初の導入及び試験運用ができる状態まで行くことを目標にしているため、ほとんどの人が使うであろう重要項目のみに絞って説明しています。

これを見ている企業勢のスタッフの方はご連絡ください。この記事は基本的には個人勢が気軽に始められるように書いているため、企業による運用や機材に関しては個別にTwitterにて対応させていただきます。

2. インストールと起動

Steamにて「VUP」と検索or以下URLにアクセス

https://store.steampowered.com/app/1207050/VUPVTuber_Maker_Animation_MMDLive2D__facial_capture/#app_reviews_hash

起動するとログイン画面が起動するので右上の言語設定で日本語に変更後、「steamでログイン」

を選択。VUPオンリーのアカウントにしたい場合は下記サインアップ手順を踏むこと。

※ver1.0.0以前にアカウント作った方は以前の登録情報のままログインできる。steamログインから入ると別アカウントとしてアカウントが作られる。

アカウント名(ログイン時使用),セーフコード(数字のみ),ニックネーム,パスワードを入力する。

作成したら最初の画面に戻り、アカウント名とパスワードを入力してログインを押す。ここの画面は固まりやすいので注意。

利用規約についてはコピペができないため、ここから各自翻訳し同意にチェックをすること。

3. 画面の説明

設定ウインドウは

左から

・キャラクター

・ライブ

・ショートカットキー

・シーン

・カメラ

の五つのタブがある。

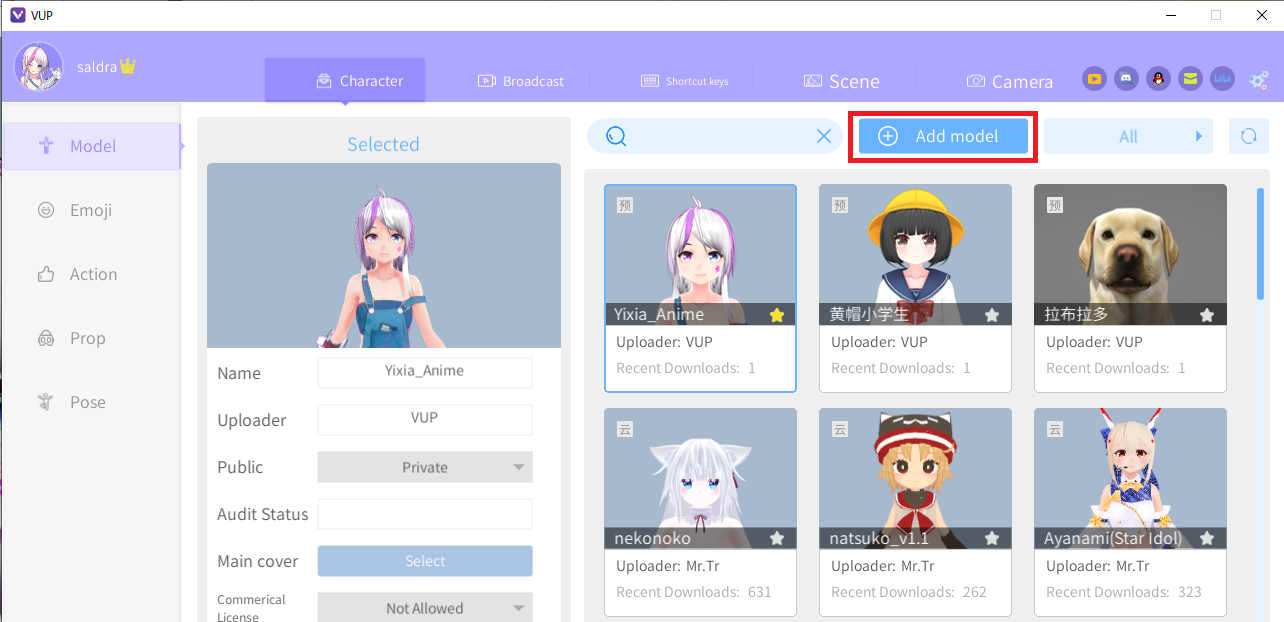

4. キャラクター選択と追加

Characterタブに変更し、モデル追加ボタンを選択し、該当ファイルを読み込む。Live2Dならmodel3.json、3Dモデルならvrm。

3Dモデルの場合ファイル読み込み後、後述するフェイスチャンネルマッピングの項目が出てくる。後で設定するため今回はそのままSaveを選択する。

しばらく経つと表示ウインドウに適用される。

※注意!

Live2Dはmoc3形式のみ対応という報告があったため、うまくいかなかったら形式を確認すること。5. フェイスチャンネルマッピング

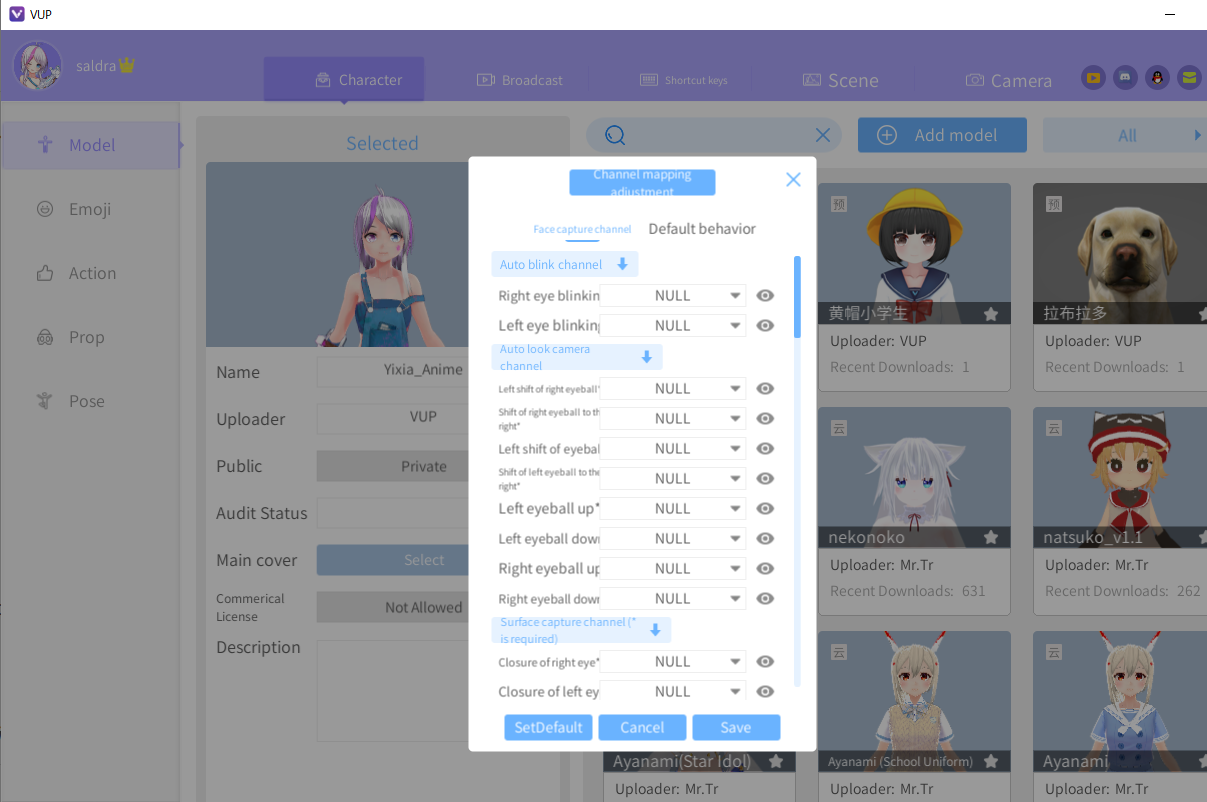

3D勢のみ必須。2D勢は不要。

キャラクタータブで、使いたいキャラクターにカーソルをあわせると右下に顔マークが出てくる。

これをクリックすると表情の調整ができる。

Auto blink channel

Auto look camera channel

Surface capture channel

Sound capture channel

の四つのグループがある。今回はSurface capture channelを編集する。

デフォルトのVRoidが対応している表情を抜き出すと以下の三つ。

Closure of right eye 右目を閉じる

closure of left eye 左目を閉じる

Open mouth 口を開ける

この三つに対応した表情を当てはめる。NULLの部分をクリックして

Closure of right eye →Face.M_中略_EYE_Joy_L

closure of left eye →Face.M_中略_EYE_Joy_R

Open mouth →Face.M_中略_Fcl_MTH_A

に変更する。

この時表示ウインドウに見本と使っているモデルの比較があるので、同じ表情になっているか確認すること。

下記はシェイプキー設定について具体的に解説した記事。

シェイプキー設定リスト

6. 顔認識の設定

(2D、3Dともに必要)

ライブタブのカメラ顔のキャプチャをONにして各種設定を変更する。

頭部の動きをトラッキングしたい場合は頭部回転、頭部の動きから上半身も動かしたい場合は上半身回転をONにする。

7. ソフト全般の設定

ウインドウ右上の歯車アイコンを選択するとソフト全般の設定に移行する。

日本語に変えたい人はここで日本語に変えること。

1.0.0以前のバージョンのインポート情報、設定を引継ぐ場合は「古いファイルディレクトリの移行」を選択する。

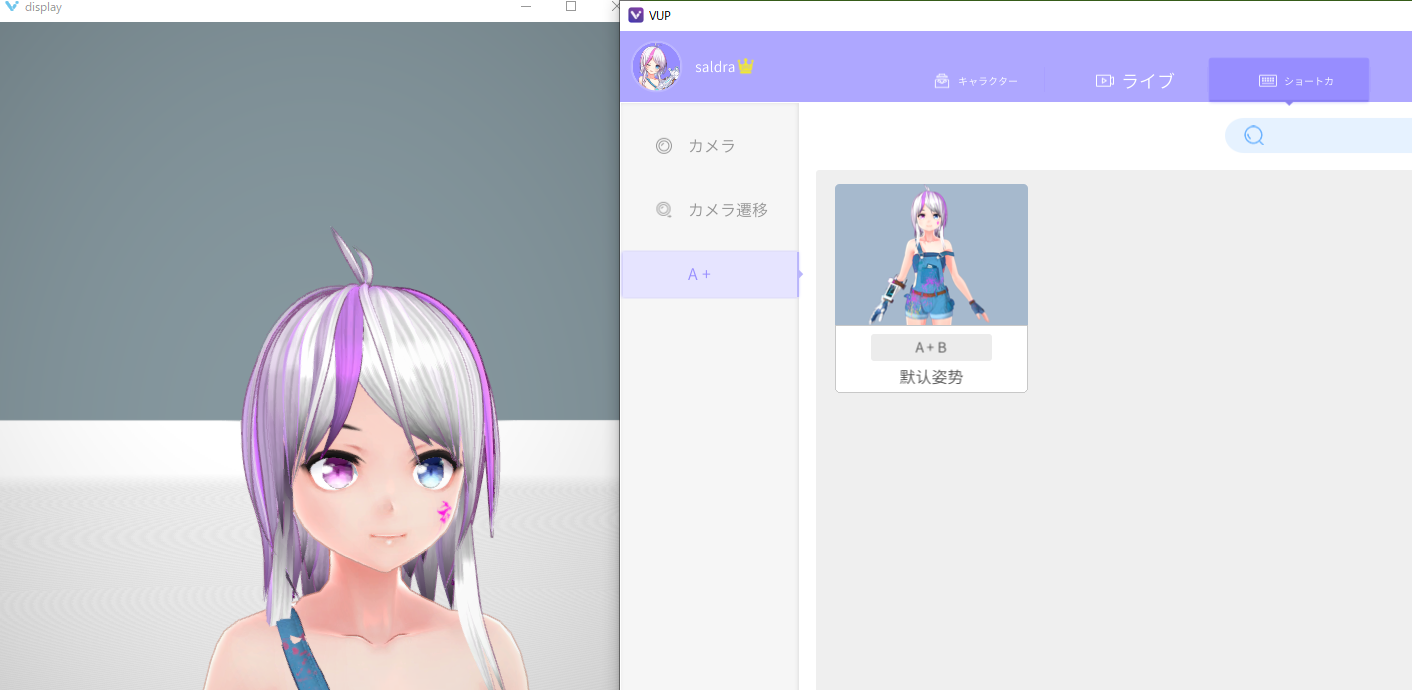

8. モーションのショートカットキー登録

手を振る、御辞儀をするといったモーションはキャラクタータブのアクション項目をクリックすると行うことができる。

毎回ここを押すのは実用的ではないため、ショートカットキー登録を行う。

ショートカット作成を選択するとアルファベットの組み合わせを指定することができるようになる。ここに好きな組み合わせを記入する。

今回はAとBを登録した。これでAとBを押すと指定したモーションが実行されるようになる。

自分で登録した組み合わせはショートカットキータブで確認できる。

# 9. 運用

# 9. 運用

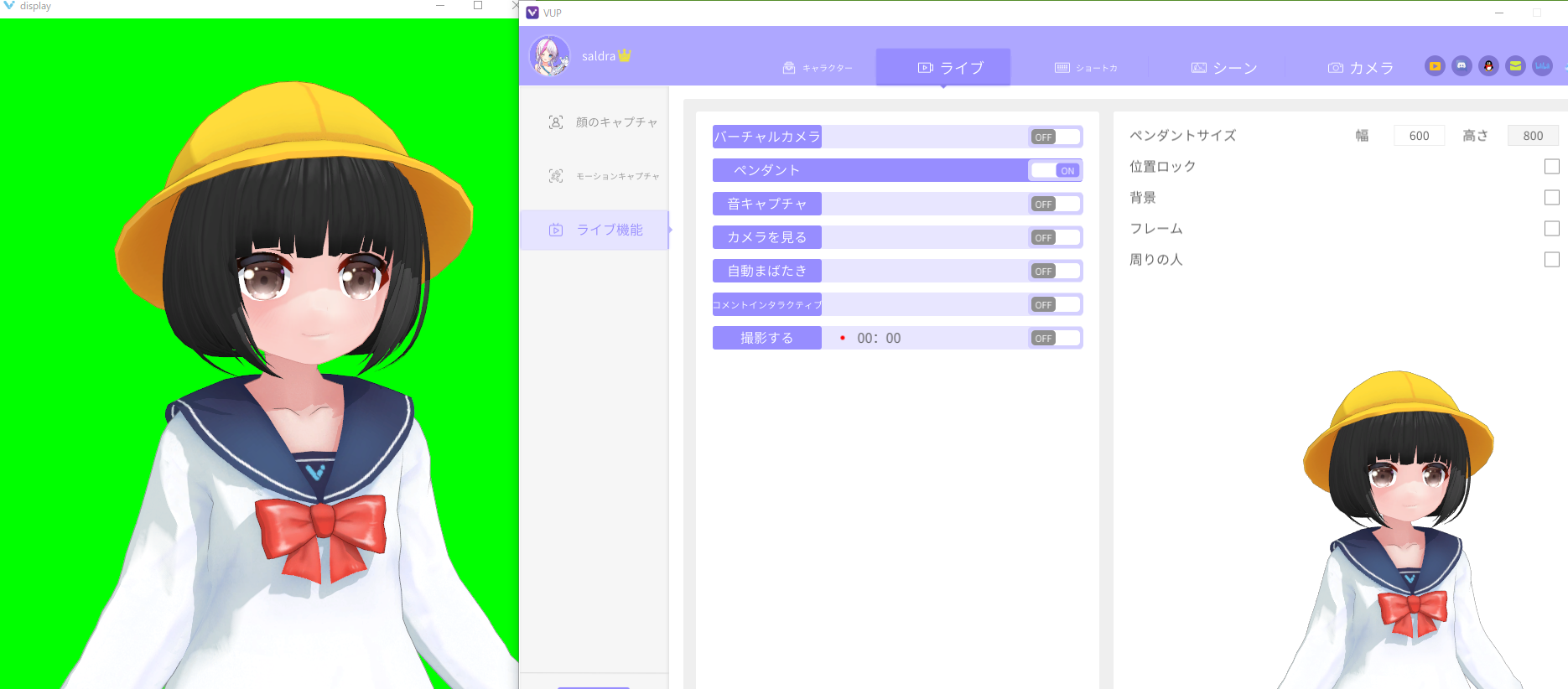

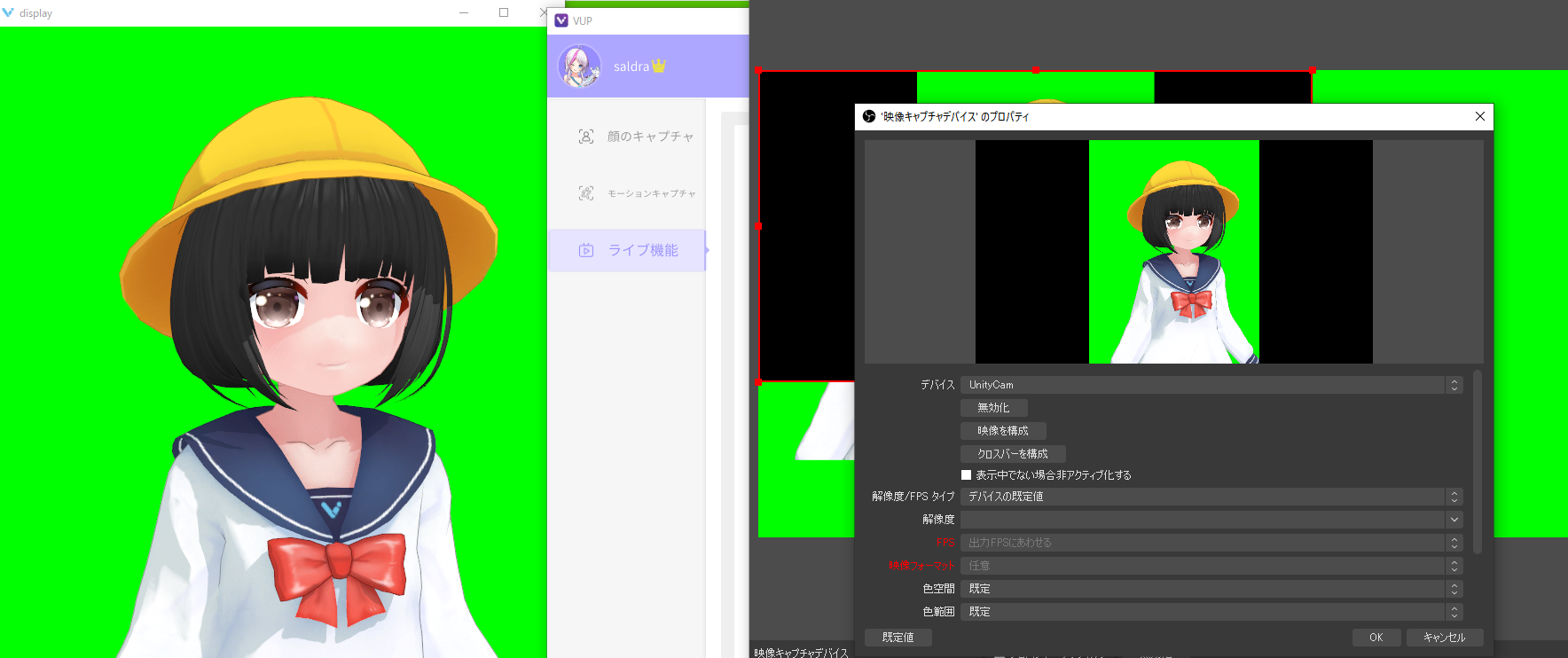

設定ウインドウの左バーからシーンを選択、シーンタブのグリーンバックを選択。

OBSにて「ゲームキャプチャ」を選択、クロマキーでグリーンバックを抜く。

※ウインドウキャプチャだと最小化した時にトラッキングが止まる模様、ゲームキャプチャに必ずしておくこと。

またPendant機能を使うことでグリーンバックにせず直接表示させることも可能。

ライブタブのライブ設定からペンダント機能をオンにし、各種設定を自分好みに変える。

また仮想カメラ機能を用いることも可能。ライブタブのライブ設定からバーチャルカメラをONにし、インストールを行う。

インストール後、OBSであれば「映像キャプチャデバイス」から「UnityCam」、Discordの場合は「ビデオ」を「UnityCam」にすること。下記はOBSの例。

LeapMotionを使ったハンドトラッキング、全身トラッキング、Androidでのフェイストラッキング等、本格的に運用したい人で、どんな機材が使えるか等が気になる人はこれを参考のこと。

Unityで制作したワールドを背景として使用したい場合はこの記事を参考にすること。

10. 追記事項

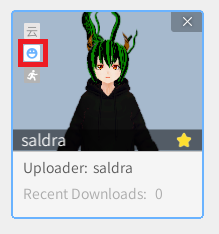

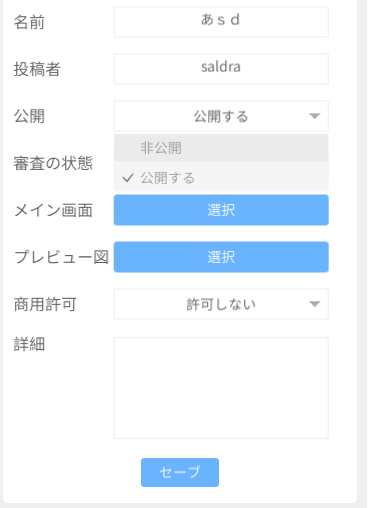

キャラクタータブにあるクラウド化ボタンについて

下記画像の赤枠にあるクラウド化ボタンを押すと「本」から「云」になる。「云」状態にするとモデル設定で「公開」を選べるようになる。

「公開する」を選択しセーブを押すと、そのモデルを公開していいかの審査が行われる。

審査に通過すると他のユーザーもそのモデルを使用できるようになる。

11. 終わりに

余計なことはそんなに呟かないので是非Twitterをフォローして動向をチェックしてくれると嬉しいです。

協力

モデル提供:雑煮さん