はじめに

Orchestrate and operationalize Synapse Notebooks and Spark Job Definitions from Azure Data Factory

ということでData Factory から Synapse Spark Notebook の実行ができるようになったそうなので試してみます。

これができると、Data Factory を起点にSynapse 上のSpark処理も回せます。これまでは、Data Factory からSynapse PipelineをAPIでトリガーする必要がありました。

準備

synapse側の準備をしておきます。

サーバーレス Apache Spark プールを作成する を参考にSpark Poolを作成しておきます。

notebookを作成します。どんな内容でもいいですが、今回はナレッジセンターから Azure Open Datasets を利用するサンプルを使います。

今回は Data Factory からnotebookを実行するわけですが、その際にdata lakeへの読み書きはData Factory の権限で実行されます。

必要に応じて、利用するストレージにData Factory に ストレージ Blob データ共同作成者などの権限を振ります。

Synapse Workspace の権限で実行したい場合はマネージドIDを利用したSpark Session 構成をするのですが、ADF からの実行ではうまくいきませんでした。

手順

Data Factory からの接続の構成

冒頭のURLの手順に従います。

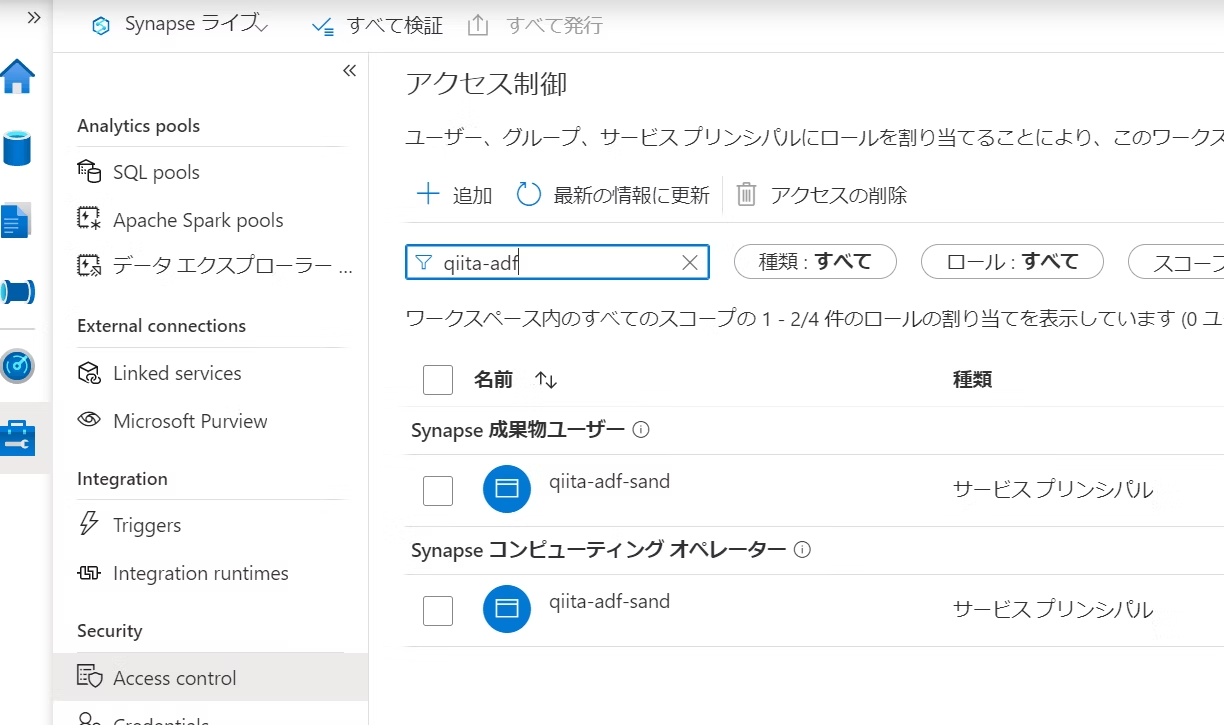

1.Synapse Studio 上で Data Factory を Synapse コンピューティングオペレーター、および、成果物ユーザーロールに追加します。

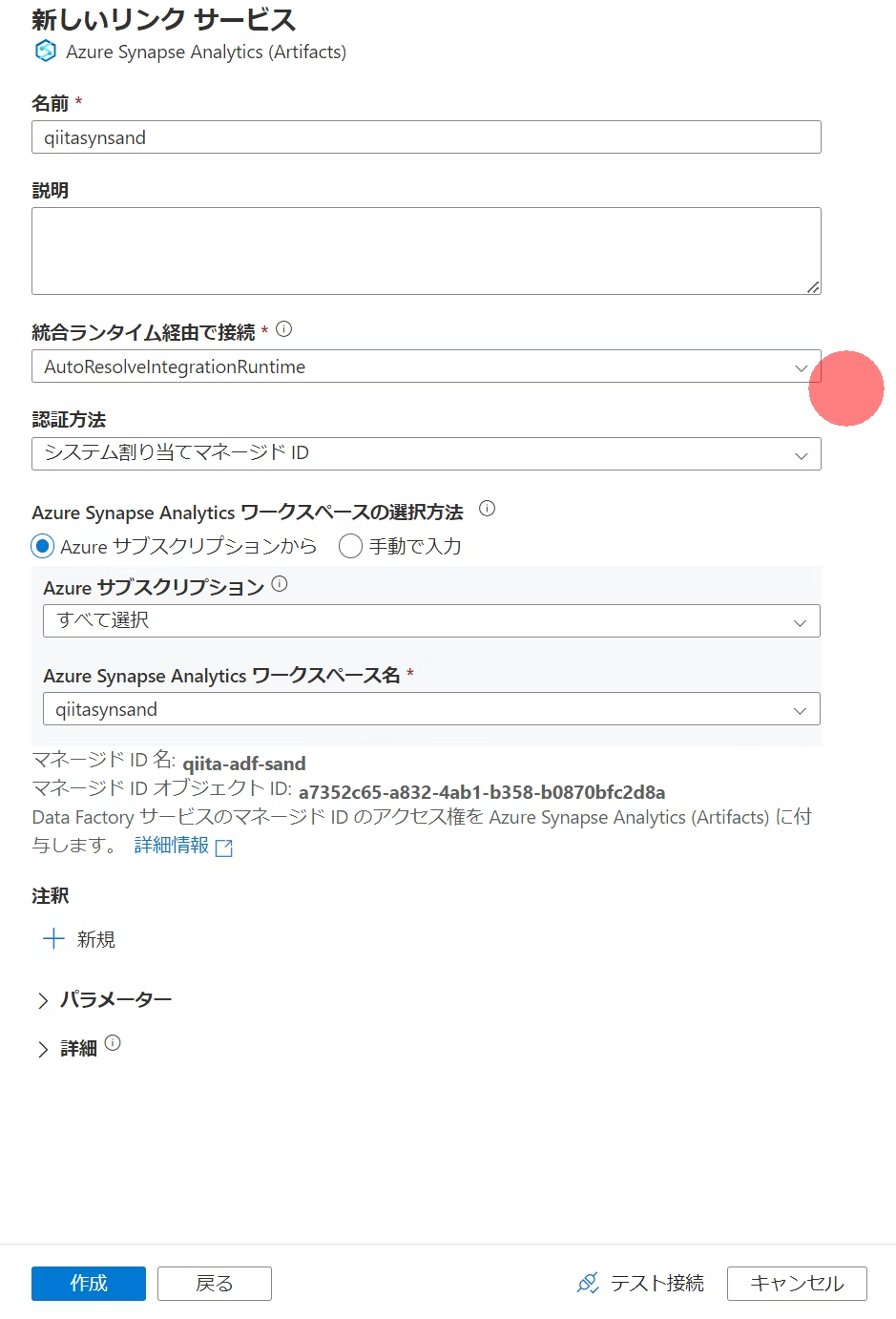

2.Data Factory Studio上でリンクサービスを作成します。

リンクサービスのタブをコンピューティングに変更すると Azure Synapse Analytics が表示されます。

ワークスペースを選択して作成します。

作成完了したら発行しておきます。

Synapse Workspace が パブリックの場合(Azure サービスを許可する状態も含む)

このように、 Synapse Workspace にファイアウォールがかかっていないような状況でのテストからはじめてみます。

1.パイプラインを構成します。

ノートブックアクティビティを配置します。

配置後、対象ノートブックのあるワークスペースを設定し、

現時点だと一覧がうまく読み込めませんでしたが、動的なコンテンツの追加から直接入力することにします

ノートブック名を入力し、あとは省略してしまいます。ちなみに開くをクリックすると Synapse Studio 別タブで開きました

2.実行確認します。

デバッグ実行してみます。Spark Pool の起動に数分かかるはずです。

Synapse Studio からはApache Spark アプリケーションの実行が確認できます。

成功しました。

Synapse Workspace が ファイアウォール設定済

ここから少し実践的に Synapse Workspace にファイアウォール設定をします。私のクライアントIPからしか接続できなくしました。

そのまま実行するとエラーになります。Data Factory が接続に利用するAzure統合ランタイムはIPが特定できないためです。

結論から言うと、現時点では、セルフホステッド統合ランタイムおよびManaged Vnetの利用はできませんでした。

セルフホステッド統合ランタイムはリンクサービス内で候補になりません。

後者のManaged Vnet の利用を試してみます。

1.Managed Vnet Azure IRを構成する

Data Factory 上で 新しい統合ランタイムをセットアップします。

Azureを選択

仮想ネットワークを有効化

作成

2.マネージドプライベートエンドポイントを作成します。

Synapse Analytics を選択後、サブリソースをdevで作成します。

Azure Portal 上で Synapse Workspace からプライベートエンドポイント接続セクションにて承認します。

コメントはなんでもよし

Data Factory 上からも承認状態の更新が確認できるまで待ちます。

3.Data Factoryのリンクサービスで統合ランタイムを先ほど作成したものに変更します。

4.実行します。

が、失敗します。

現時点では Azure Synapse Analytics (Artifacts)のリンクサービスはManaged Private Endpointに対応していないようでした。(対応していれば、マネージドプライベートエンドポイントの情報が出ます。)

所感

プライベートな Synapse Workspace への対応がまだっぽいじょうたいであることがちょっと扱いづらいので今後の更新に期待するやつですね。