エンジニアとして働き初めて2年、当たり前すぎて気にもとめてなかったのですが

ふと「ビットとバイトってなんぞや?」と思いましたので調べてみました。

業務の中、また日常生活でも登場するビットとバイト。

なんとなくデータの容量を表しているんだろうなー程度できちんと理解している人って少ないのではないでしょうか。

ビットとバイトとは

ビットやバイトはデータの記憶容量などを表すときに用いられる表現です。

そしてビットはコンピュータ内部における情報表現の最小単位とされており、

コンピュータの世界では、**1バイト(Byte)= 8ビット(bit)と定義されています。

コンピューターでは、2進法と呼ばれるすべてのデータを0と1の2つの数字の組み合わせで表現し計算していますので、1ビットでは"0"または"1"**が格納されています。

情報表現数

上記で説明したように1ビットでは**“0”または“1”が格納されています。

ですので表現できる情報の数は、"2"**となります。 同じように2進法に則ると、2ビットでは、"00","01","10","11"の4種類の情報表現が可能となります。

この情報の表現できる数を情報表現数と呼びます。

1ビットでは2種類、2ビットでは4種類というのは、21=2種類、22=4種類と求めたもので、nビットにおける情報表現数は、2n種類となります。

補助単位

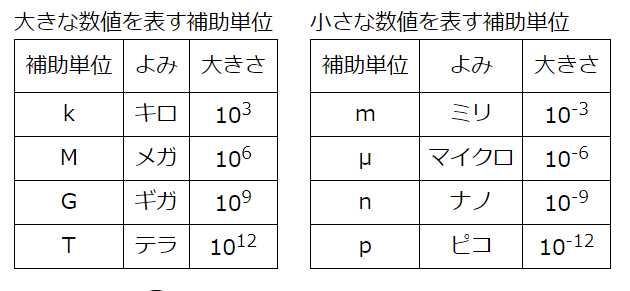

日常生活において1000gを1k表現したり、1,000mlを1lと表現したりするかと思います。

この"k"や"m"のような数値の倍率を表すものを補助単位と呼びます。

普段目にしているKB(キロバイト)MB(メガバイト)GB(ギガバイト)TB(テラバイト)はこれら

補助単位を用いた表現だったんですねぇ。

ちなみに書く補助単位の関係はこんな感じです。

KB(キロバイト):1024B(バイト)のこと

MB(メガバイト):1024KBのこと

GB(ギガバイト):1024MBのこと

TB(テラバイト):1024GBのこと

おわりに

当たり前ですが今までなんとなくしか理解できていなかったのでなんかスッキリしました。

疲れたマン