この記事は、Filip Piekniewski氏のブログ記事AI And The Ludic Fallacy の翻訳です。なお、この記事は。2016年11月15日、ドナルド・トランプが大統領選挙に勝利した直後の時期に書かれたものです。

お遊びの誤り

私はナシーム・ニコラス・タレブの本を楽しみ、また、経済への理論的なアプローチの誤った考え --マイルドに言えば-- を指摘する彼のスタイルを好んでいる。彼の中核的なアイデアの1つとして「お遊びの誤り」がある。現実世界の状況に対する、ゲームのアナロジーの適用 (誤用) を意味する。この誤りは、現実は理解不能なほど複雑であるため、研究 (あるいは他のあらゆる精神的活動) の領域が、典型的には何らかのモデル世界に制限される場合が多いという事実に由来する。そのモデルが「ゲーム」であり、そこではあらゆる規則が既知である (と想定される)。 モデルを用いて現実の何らかの側面についての結論を引き出すのであるが、その結論はモデル世界から引き出されたものであり、モデル世界の不確実性は本質的に結論にも引き継がれるという事実は忘れられてしまう。たとえばもし、過去の事例に基づいて、ある特定の候補者が選挙で勝利すると所与の世論調査結果から予測した場合、暗黙のうちに「過去の事例」から根本的には何も変化しないと想定しているということになる。けれども、もしもモデルの外側の世界で変化が起きていたとすれば、私の予測はほぼ完璧な無用の長物となるだろう (たとえ、モデルから引き出された「確信度」が良い数値であったとしても)。最近のアメリカ大統領選挙は、実世界におけるこの好例であると言えるだろう。

人工知能

それでは、人工知能のコンテキストで: 我々はデータセットのみを、議論領域 (古典的な用語で、ライトヒルレポート以来あまり使用されることはない) のみを用いて、モデルを現実にさらすことはめったにない。データセットは現実に由来しているものの、機械学習の結果はデータセットの領域に留まることが多く、現実に引き戻して検証することは少ない。(この興味深い論文を参照)

金融のコンテキストでは、予期せぬ株式市場のクラッシュがモデルの限界を思い知らせてくれるように、AIにとってのリアリティチェックは、ロボティクスである。ロボティクスにおいては、現実に向けて動作する必要があり、データセット中のほんの数パーセントのエラーですら災害を引き起こす場合がある。結論として、ロボティクス向けAIの最も困難な問題は、最も基本的な知覚と動作のタスクである。モラベックのパラドックスとしてまとめられている通りだ。

「コンピュータに、知能テストで大人のレベルの成績を取らせたりチェッカーをプレイさせることは比較的たやすい。困難、あるいは不可能なのは、知覚と動作に関して1歳児のスキルをコンピュータに与えることである。」

私は、これはまさに「お遊びの誤り」であると主張したい: AIとゲームで遊ぶことはできるが、最も基本的な知覚/運動の能力を備えさせることはできない。

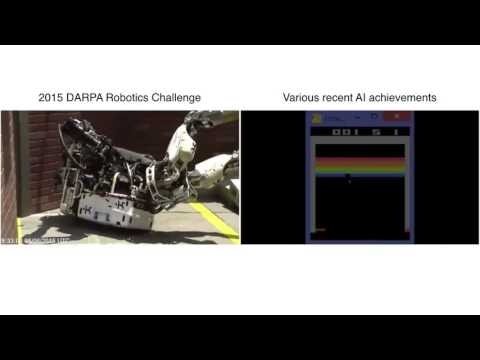

明らかに問題なのは、制約の無いロボットの事例においては、現実がどのように見えるかについて膨大な前提を置くことができないため、我々はシステムを騙せないということである - これが、今日ほとんどのロボットが極めて限定された工場環境にしか存在しない理由だ。ハンス・モラベックがこのパラドックスを最初に述べたのは1988年であり、何十年も昔のことである (コンピューティングとAIにおいては太古の昔である)、それゆえ、読者はこのパラドックスはもはや適用されないと考えているかもしれない。そう考える人のために、私は短いビデオクリップをまとめておいた (スピーカーをオンにすればもっと楽しめるだろう)

動画の選択にはややバイアスがあることは認めよう。けれども、本質的にはこの通りである。左側が最新のロボティクス (2015年のDARPAチャレンジ) であり、右側が最新の「AI」である。モラベックが彼のパラドックスを述べて以来ほぼ30年が経過しており、コンピュータは何億倍も高速になり、カメラは何百万倍も正確になり、そして…何も変化していない。今のところ、我々はいくつかのアタリのTVゲームと囲碁を、強化学習を使った「AI」とプレイできるのみである。

AIの冬

AIは、「AIの冬」として知られる周期的なハイプと破裂のサイクルによっても知られており、それはいくらか株式市場のクラッシュにも似ている。 (完全な歴史のレビューには私の過去記事を参照)。けれども、共通していることは、AIハイプの波が「議論領域」から抜け出し現実という岩石に襲われると、典型的には不況が訪れるということだ。60年代のハイプサイクルにとっては、その現実はロシア語から英語への正確な翻訳が不可能であるということだった。直近の破裂は2003年ごろに起こり、その原因はCAPTCHAであった。それでは、今回は何になるのだろうか?

自動運転車

私の予想では、自動運転車が現在のAIハイプを破壊するだろう。私が言っているのは、運転支援ではなく、完全な (レベル5の) 自律性を指している。 これだけが多くの企業が巨額の投資を行なった事例であるからだ。誤解しないでほしい。私は自動運転車を持ちたいと考えているし、過去の私の研究全体が、自動運転に関する根本的な問題の1つを扱うものであった。けれども同時に、AI分野で働く他の人々を見て、彼らがモデルの領域に閉じ込もり、問題を見ようとしないことを知って驚愕しているのだ!中核的な観察は以下の通り: 自動運転車は、制限のない環境で動作するロボティックデバイスである。おそらく、公道は制限された領域であるとは見なせないだろう。なぜならば、現実には路上では文字通り何でも起こりうるからだ。それ以外にも、過去に議論した通りいくつかの問題がある。けれども、根本的な問題は、AIを統計的パターンマッチャーとして構築し続けていることである。そのため、既存のAIは本質的に既知の物体しか扱えず、外れ値 (新たな未知の物体) を予測し、識別し、適切に反応することはできない。

それを踏まえた上で、私が思うに、適切な問題を実際に解決し、AIにアプローチするための異なる方法を広く提案するのにはふさわしい時期であると思う。要約すれば、あらゆるコーナーケースを記憶させるのではなく、定常的なものごと - 物理学 - を学ばせるという方法だ。問題は、ひとたびAIの冬がやってくると、AI研究者の誰もが等しく破裂するということだ。たとえ、私のように事前警告を発していた者であっても。