この記事は、人工知能研究者 Filip Piekniewski氏のブログ記事 "AI Circus, Mid 2019 Update" の翻訳です。なお、これは彼のブログ記事 "AI Winter Is Well On Its Way" (拙訳:人工知能の冬は確実に近付いている) へのフォロー記事として書かれたものです。

AIサーカス - 2019年中間アップデート

前書き

バイラルを起こした私の記事「AIの冬は近づいている」 および関連記事を投稿してからほぼ1年が経過した。その記事で私は全般的なAIの状況について定期的にアップデートを投稿すると約束した。6ヶ月ほど前に1件投稿したが、これがまた別の投稿となる。最近もたくさんのことが起こっているが、何一つとして私の考えを変えることはなかった - AIバブルは破裂しつつある。あらゆる破裂しつつあるバブルと同様に、我々は最終段階にいて、失うべきものを最も多く持っている人々が、最も途方もない自信を抱いて、考えられる限りのガラクタを集めている。それは更に頭の悪い人間を騙してお金を奪うための究極的な戦略である。しかし、何が起こってきたかを見ていこう。

マジメな話題

最初に、コミカルではない話題から始めよう。3人のディープラーニング創始者 - ジェフリー・ヒントン、ヨシュア・ベンジオとヤン・ルカン - は、チューリング賞を受賞した。コンピュータサイエンス分野で最も権威のある賞である。私がこの判断に何らかの疑問を呈するだろうと考えていた読者は、がっかりするかもしれない。ディープラーニングはチューリング賞を受けるに値すると私は考えている。個人的な意見として、一つやや悪い後味を残しているのは、ユルゲン・シュミットフーバーが受賞者から除外されていたことだ。シュミットフーバーに何を望むかを考えてほしい - 彼が時として厄介者であることに私は同意したくなるけれども - この分野への彼の貢献は否定しがたい。

ところで、この3人はいくぶん静かであった。ようやくヒントンもツイッターに参加したけれども、謙虚な姿勢で、誤っているまたは過剰に楽観的であると感じることは何もツイートしなかった。ヤン・ルカンは時々FAIR [Facebook人工知能研究所] での自分の研究を宣伝することはあったけれども、珍しいことは何もなかった。ベンジオも同様で、彼はソーシャルメディア上で積極的に活動していない。

他の私のお気に入りの人々も静かであった。フェイフェイ・リーは、昨年の秋グーグルクラウドでのサバティカルを終え、スタンフォード大学のポジションに復帰した。アンドリュー・ングはいつになく静かであった: おそらく、最近赤子が生まれたからだと思う - 彼と奥さんを心から祝福したい。2ヶ月前、私自身にも子供が生まれ、その喜びがどれほどであるかを感じている。しかし、子供は彼の週90時間労働をジャマするかもしれないし、必然的なAIシンギュラリティを遅延させるかもしれないと認識するだろう。

過去数ヶ月のAI分野における最もバカバカしいイベントは、Open AIとテスラに関するものであった。

コミカルな話題

Open AI - 汎用人工知能についての問題の解決、およびその発見を一般大衆に開かれたものとし、利益を追求する一部の悪しき企業に独占させないというミッションを掲げた非営利組織 - は、2月に文章生成モデル GPT-2 をリリースした。誰もが驚いたことに、Open AIは悪用の可能性があると述べ訓練されたモデルの重みを公表しなかったため、研究者とAI関係者の間で当然の論争を引き起こした。。このような人たちが、どうして自分のことを「オープン」であると主張できるのか分からない。未だに彼らはモデルの重要な部分を公表していない (ところで、私に言わせれば、Open AIがすべてのモデルを公表しない限り、GPT-2 が単に "機械仕掛けのトルコ人" [AIシステムに見せかけた人間] を使って実装されたものであるかどうか判断できない)。GPT-2 が妥当に見える文章を生成したとしても、どのようにフェイクニュースやスパムの生成に悪用できるのか、娯楽を超えた何らかの目的に実際に使用できるのかどうかは分からない。

ともかく、もはやオープンではないように見える最近の Open AIは、利益を上げるためのアイデアを考え出したようだ。イエス - 21世紀のプロメテウスとなるはずであった組織、人類全体にAIという炎を与えるために尽力する無私で公平な研究者たちの修道院は、もはやオープンではなく今や営利団体と化した。しかし、ちょっと待ってほしい。Open AIは未だに途方もないミッションを掲げている。というのは、その利益には上限が設定されているからだ - すべての投資家は、投資額の100倍までしか受け取れない。すばらしい。ここで、私が思いつく唯一の背景事情としては、Open AIはもはや非営利団体として資金調達ができないからなのでないかと思う。

同社はこれまでのところ一切の利益を上げておらず、どれほど想像力を働かせてもスタートアップのような組織には見えない (むしろ研究機関のように見える) ことは、一旦棚に上げておこう。ここで、次の記事にまとめられているサム・アルトマンの驚嘆すべきインタビューを見てみよう - かつてベンチャーキャピタルのYコンビネータを経営し、現在 (もはやオープンではない) Open AIのCEOとなった、ベイエリアで広い人脈を持つやり手 - は、今回のハイプサイクル中の最高のセリフを提供している。全体を読んだり見たりするようあらゆる人に勧めたいが、しかしここで最高の部分を引用しよう:

例えば、OpenAIがどのように収益を上げることを計画しているのか(私たちは、成果の一部にライセンスを設定するのかを知りたいと思っていた)という質問に、アルトマン氏は「正直な答は『まだ何もない』ということです。私たちはいかなる収益も上げたことがありませんし、現段階では収益を上げる計画もありません。一体どうすれば、いつの日か収益を上げられるようになるのかがわからないのです」と答えている。

アルトマン氏は続けて、次のように述べた「私たちは投資家の皆さんに『もし汎用人工知能を開発できたら、それに対して投資家の皆さんにリターンを行う方法を考えて欲しいと依頼するつもりです』という、厳しくない約束をしているのです」。聴衆が爆笑したときに(なにしろ彼が真剣なのだとは思えなかったのだ)、アルトマン氏はこれはまるでドラマの「シリコンバレー」のエピソードのように聞こえるかもしれないと言いつつも「もちろん笑っていいんですよ。全然構いません。でも、それは本当に私が信じていることなのです」と付け加えた。

(訳はtechcrunchの記事より引用)

イェイ。ここに何を加えればよいのか分からない。収益を上げる方法を考案することは、AGIを考案することよりもはるかにたやすいはずであると私は確信している。しかし、ハイプバブルのねじくれたロジックの中ではそうではない。単純に言えば、提案はこうだ: 私たちはAGIを作成できると信じています。しかし、根拠は本当に何もありません。しかし、私はそれが可能だと本当に強く信じているのです、もしも私たちに数億ドルを投資していただければ。

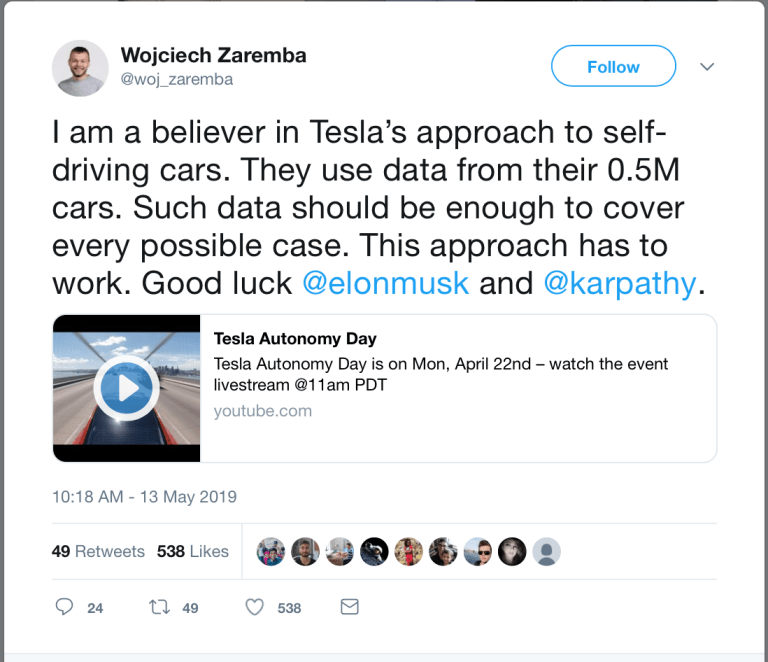

私もこのように信じられたら良いのにと思う。しかし、残念なことに、私にはできない。そして、私が思うにOpen AIは完全なる詐欺と化した。この判断は、Open AI関係者のツイートを読んだことにより更に強化された。たとえばこれだ:

(私は自動運転車へのテスラのアプローチの信者である。テスラは50万台もの車からのデータを利用している。それほどのデータはあらゆる可能性のあるケースをカバーするのに十分だろう。このアプローチは機能するはずだ。グッドラック、イーロン・マスクとアンドレイ・カーパシー)

(私は自動運転車へのテスラのアプローチの信者である。テスラは50万台もの車からのデータを利用している。それほどのデータはあらゆる可能性のあるケースをカバーするのに十分だろう。このアプローチは機能するはずだ。グッドラック、イーロン・マスクとアンドレイ・カーパシー)

Wojciech Zaremba 氏、NYUにいた当時は非常に理性的であった男 (私は2015年に彼と何件かメールを交わしたことがある) は、今や「信者」と化した。上記のツイートにはとんでもない誤りが含まれている。データと現実についていくらか理解があり、科学者としての誠実さを備えた人間がこんなことを言うとは想像することさえ難しい。けれども、これが頭が良いとされる人々がベイエリアのエコーチャンバーで信じていることであり、AI分野の何千人という新入生が盲目的に従っていることなのだ。

具体的に言おう: 上述のアプローチ (私は、"アプローチ" という言葉が何を意味するのかすら正確に分からない) が機能しない可能性がある理由は無数にある。(そしてそのアプローチが実際に機能していないことを示す根拠も豊富にある) 一つの可能性: そのようなあらゆるデータを持っていたとしても、そのデータはバイアスがかかっている可能性がとても高い。なぜなら、人々は明確にエッジケース [事故] を回避するから。別の可能性: エッジケースは極めてスパースな集合であり、統計的には「非エッジケース」に圧倒されるだろう。ディープラーニングは、すべてのデータポイントについて総損失を単純に最適化するだろうが、稀な事例を完全に消し去ってしまうだろう。また、各々の稀な事例が、損失関数をチューニングし再調整するために個別のデータを必要とするかもしれない。

また別の理由は、50万台のテスラ車が路上にあったとして、それらのテスラ車がすべての運転データを取得していたとしても (実際にはそうではない)、すべてのエッジケースをカバーするにはまったく充分ではないかもしれない。もしも、エッジケースがロングテールであり非定常である場合には。 (このような事例を想像する別の方法。あらゆる入手可能な歴史的な株式市場データでモデルを訓練して、それを実際のお金を使って動作させたとすると、おそらく想像以上の速さで破産するだろう)。別の理由としては、路上の人間がからむエッジケースの集合は、路上の自動運転車のエッジケースとは異なっており、また常に変化していくからだ。

別の、おそらく最も明白ではない理由としては、彼らが利用している特定のディープネットが、必要となることを表現するための表現力を持たないかもしれないということだ。(そのディープネットを訓練するために必要となるあらゆるデータが存在すると仮定しても)。パーセプトロンは、80年代から知られている万能の近似器 [universal approximators] ではあるが、それでもImageNetの問題を解くためには、収束速度を早めるための多数の技法と十分な数の訓練可能なパラメーターと合わせて、非常にスペシフィックな、畳み込みニューラルネットワークと呼ばれるファインチューニングされたアーキテクチャを必要とする。今日でさえ、汎用の全結合多層パーセプトロンをただ単に持ってきても、望みのタスクを何でも学習できるわけではない。たとえ、膨大なデータを持っていたとしても。

最後に、これらすべてが原則的には可能であるとしても、テスラ車の中に搭載されたコンピュータで実行可能であるのかはまだはっきりしない。自動運転分野の他社は、車両にLIDAR [レーザー式距離計] を備えている。それは高価であるけれども、テスラがAIで解決しようとしている問題の大部分を解決する (たとえば、障害物回避や走行可能性推定など)。最高級のゲーミングGPUは、最新のテスラ車のハードウェアよりもはるかに高い計算力を持っているけれども、我々が知る限りでは誰も完全な自律性に近付いてすらいない。このように、テスラの自律性へのアプローチが働かない理由はすぐに挙げられる。高給取りのデータサイエンティストなら誰でも、ボトルのウォッカを飲んだ直後でさえこのような理由を暗唱できるべきである。

テスラのオートノミー・デイについて言えば、2020年には100万台のテスラ製自律タクシーが存在するだろうというかなり大胆な宣言が出されたものの、私の意見ではその可能性はゼロである。既に私はイーロン・マスクと彼の狂った約束やアイデアについての見解を述べた。この記事ではあまり多くを費したくはない (率直に言えば、テスラファンを引きつけたくない。自分のファンタジー世界に留まっていてほしい)。しかし、今年の初めに興味深い発展が見られたため、別の視点からテスラにフォーカスを当てよう。MITの科学者、レックス・フリードマンはある研究を公表したのだが、そこで彼は (何名かの共著者と共に)、 ヒューマン・マシン・インタラクションの膨大な文献に反して、オートパイロットを使用しているドライバーは、集中して注意力を保った状態にあると主張した。この研究の公開自体にちょっとした論争が伴っていた - そもそも、フリードマンはジャーナリストにこのリリースを報道するよう促していたからだ。アニマ・アナンドクマー (Nvidiaのリサーチディレクター) といった研究者たちは、何らかの派手な宣伝を行う前に研究を査読に提出するよう彼を説得しようとしたのだが、ごくわずかでも彼のアプローチに批判的であった人々と同じくTwitter上でレックスにブロックされてしまった。 (このフリードマンという人は相当なうぬぼれ屋に違いあるまい)。研究がニュースのヘッドラインとなると (強調しておこう: 査読されていない論文)、フリードマン (テスラのファンであることを広く公言している) は、テスラもマスクもこの (テスラに好意的な) 研究に関わっていないとツイートした。その後で彼はツイートを削除し、そして誠実性に関する何かをツイートした (おそらく、これが疑問を持たれるものだということを彼が正しく感じ取ったからだろう)。しかしながら、2週間後に彼はイーロン・マスクと一緒にポッドキャストに出演するよう招待され、彼自身もジョー・ローガンに招かれた。両方のチャンスを使って彼は恥知らずな自己アピールを行なったのだが、それは彼が常時行なっていることである。

ここでは論文自体の詳細には立ち入らない。しかし、デューク大学のヒューマンマシンインタラクション教授、ミッシー・カミングスの優れたポッドキャストのインタビューで、このMITの研究がさまざまな観点から完全に欠陥のあるものであると説明されていることを読者に示しておこう。

とは言え、上述のすべての発展を考慮に入れて、私はレックス・フリードマンを、2019年のAIシーンの最大の道化として公式にノミネートしたいと思う。今はまだ年の半ばでコンペは継続中であるが、私が思うに彼が優勝する見込みはかなり大きいと思う。

テスラに関しては、NTSB [アメリカ国家運輸安全委員会] は、フロリダ州での死亡事故についての予備報告書を公開した。(誰にとっても驚きではないが) この事故には実際にオートパイロットが関わっていたことを示している。少なくとも4番目の文書化されたオートパイロットによる死亡事故であり、有名なジョシュア・ブラウンの事故と驚くほどに類似した状況であった。おそらくこれは大きな全体像の中ではささいな問題かもしれないが、キャデラックの類似の運転支援システム - スーパークルーズ - は、この記事の執筆時点において、1件たりとも死亡事故を起こしていない (また、システムの欠陥によって起こったと見える事故すら起きていない) のである。微妙な違いとして、スーパークルーズはドライバーの監視システムを備えており、それによりドライバーが注意力を保っていることを保証する。一方で、テスラはそうではない。これらすべてが、フリードマンの研究が…"そういうもの"であることを示す逸話的な根拠である。

別のニュースでは、前回のAIの冬についてのアップデート記事から、2社のAI/ロボティクス企業が事業を停止した - JiboとAnkiである。Jibo社は、個人的にとりわけ興味深い事例であった。Indiegogo [注:クラウドファンディング用サイト] での彼らのキャンペーンを目にした瞬間から、私はこの会社がどう終わるのか分かっていたからだ。MIT研究者、シンシア・ブリジールが創業したこのプロジェクトは、即座に信用を得て、当時でも現在でも実現不可能な機能の実現を約束し、およそ7200万ドルを調達した (そして燃焼させた)。私は現在MITで一体何が起こっているのか分からない。まず、シンシア・ブリジール - 自称ロボティクスの専門家が、ほとんどが設計図の上にすら存在しないJiboの奇跡を約束し、そしてレックス・フリードマンは自分自身を笑い者にしている。 (しかし、MITの名誉のために言っておけば、彼は雇われの研究科学者であり、MITの卒業生ではない。)

その他には、[カナダ] オンタリオ州政府は、AIへの支出削減を決定したと伝えられている。その中にはヒントンのベクター・インスティチュートも含まれており、AI界隈でちょっとした怒りを引き起した。これは、来たるべき冬の最初の深刻な凍傷にすぎない。これに怒っている人々全員は、暖かい服装とおそらく新たな仕事を探すことを勧めたい。

まとめ

2019年半ばのAIの状況はこのようなものである。私が予期してきた通り、シーンはますますバカげたものとなり、実質的にピエロのショーとなった。我々はすぐに、AIバブルのすべてが実際にジョークであったと学ぶであろうと思う。それは私がこのブログの最初期から言ってきたことである。