MacでPySparkをPyCharmで開発する方法について記載します。

概要

- SparkをMacにインストール

- PyCharmプロジェクトからPySparkを実行できるように設定します。

前提条件:

| 項 | 備考 |

|---|---|

| python3.7 | 私はPyCharmのプロジェクトにanacondaの仮想環境を使用しています。 |

| Java8 | |

| Homebrew |

1. Sparkのインストール

terminalで実行

$ brew install apache-spark

Updating Homebrew...

==> Downloading https://www.apache.org/dyn/closer.lua?path=spark/spark-2.4.5/spark-2.4.5-bin-hadoop2.7.tgz

==> Downloading from http://us.mirrors.quenda.co/apache/spark/spark-2.4.5/spark-2.4.5-bin-hadoop2.7.tgz

######################################################################## 100.0%

/usr/local/Cellar/apache-spark/2.4.5: 1,059 files, 250.9MB, built in 1 minute 45 seconds

環境変数の設定

.bash_profileに以下を追記します。

SPARK_HOMEのpathは上記のSparkの結果を参照してください。

$ echo 'SPARK_HOME="/usr/local/Cellar/apache-spark/2.4.5/libexec"' >> ~/.bash_profile

$ echo 'export PATH=$PATH:$SPARK_HOME/bin' >> ~/.bash_profile

2. PyCharmの設定

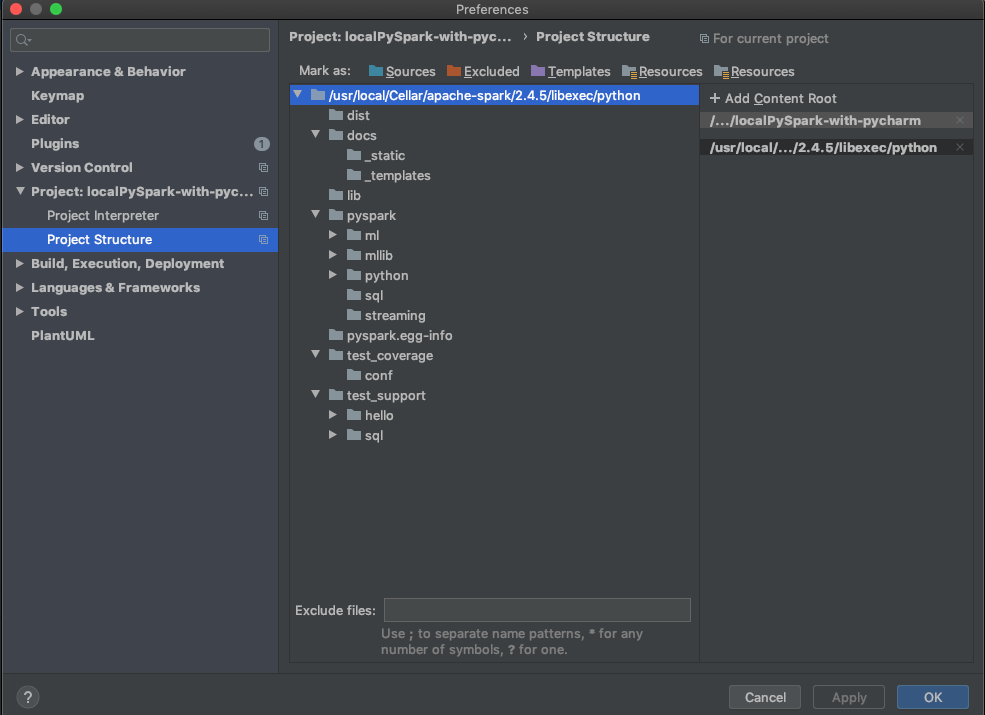

PyCharmのプロジェクトを開いて、[Preferences]->[Project Structure]-> [+ Add Content Root]で以下のpathを設定します。

"2.4.5"のバージョンは上記を参考に入力してください。

/usr/local/Cellar/apache-spark/2.4.5/libexec/python

画面の右上にある[+ Add Content Root]で設定します。

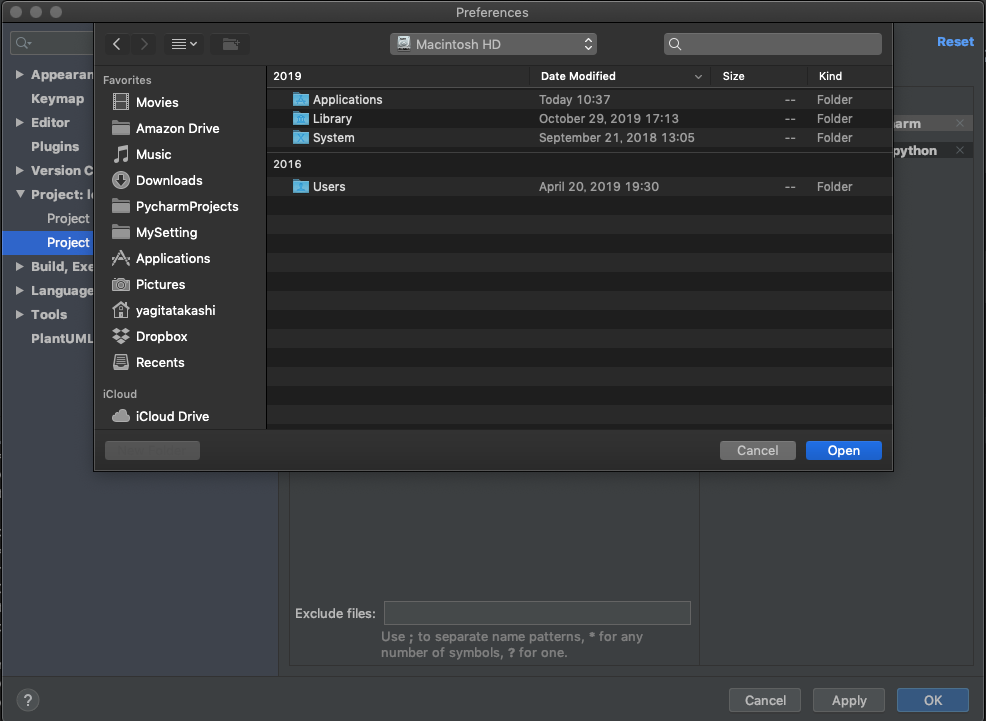

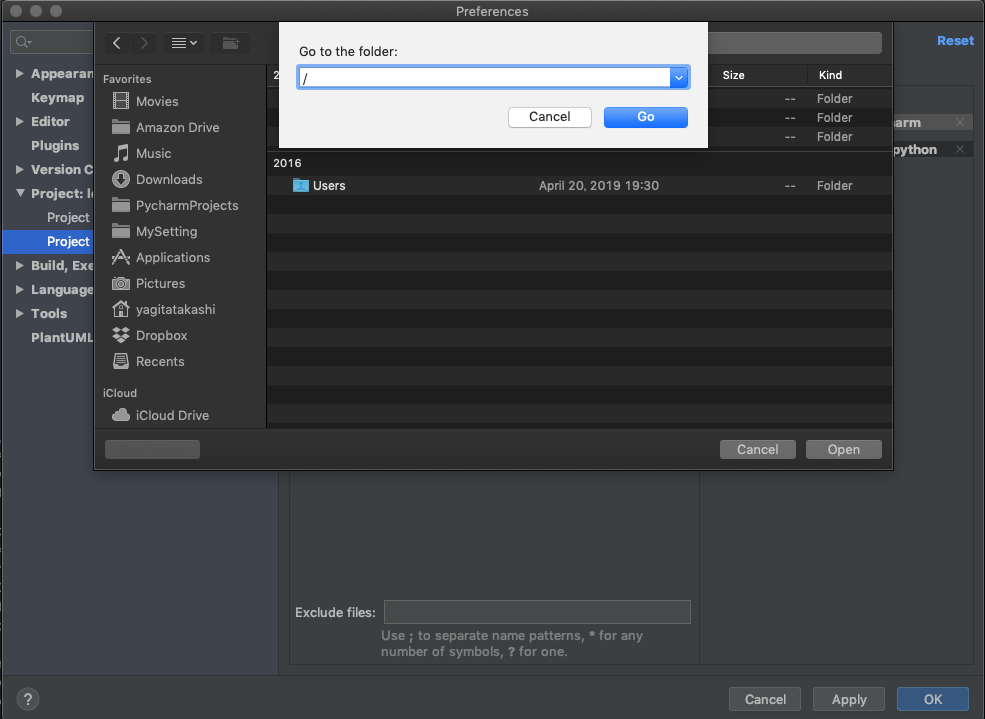

[+ Add Content Root]でダイアログが表示されますが"/usr/local/・・・"を指定する方法は、"Macintosh HD"を選択した状態で、'/'のキーを入力すると

'Go to the folder:'が表示されるので、ここで上記のpathを入力してください。

PyCharmプロジェクトの再起動

PyCharmプロジェクトがSparkに接続するには、プロジェクトの再起動が必要になります。PyCharmを閉じて、再起動するとSparkに接続できます。

開発

これでpysparkが使えるようになります。

import pyspark

また、PyCharm Professional版であれば、Jupyter Notebookが使えますので、PyCharm + Jupyter Notebook + Sparkで開発することができます。

PyCharm + Jupyter Notebookは以下を参考にするとよいでしょう。

はじめてのPyCharm + Jupyter Notebook(その1)