きっかけ

IT技術が発達し、ますます便利になった社会。僕は便利さを享受しつつも、日常を味わって生きていきたいと思っています。

目指すは

ITの利便性×日常の輝き。

そこで普段Notionでつけている日記という「データベース」を活用して、何か面白いことができないかと考えました (楽しいことを追い求める精神、大事)。

概要

やることは

NotionのDBをPythonスクリプトで形態素分析し、Google Sheetsに書き出し。

それをNotion上に埋め込みで表示する

です。

ただ解説するだけではつまらないので、技術的なことにも触れながら説明していこうと思います。便利なテンプレート付き。

所要時間は40~60分を想定しています。

注) 2025年7月にリポジトリではなく、タグでの公開としました。

Webアプリケーション版での公開も検討しているところです。

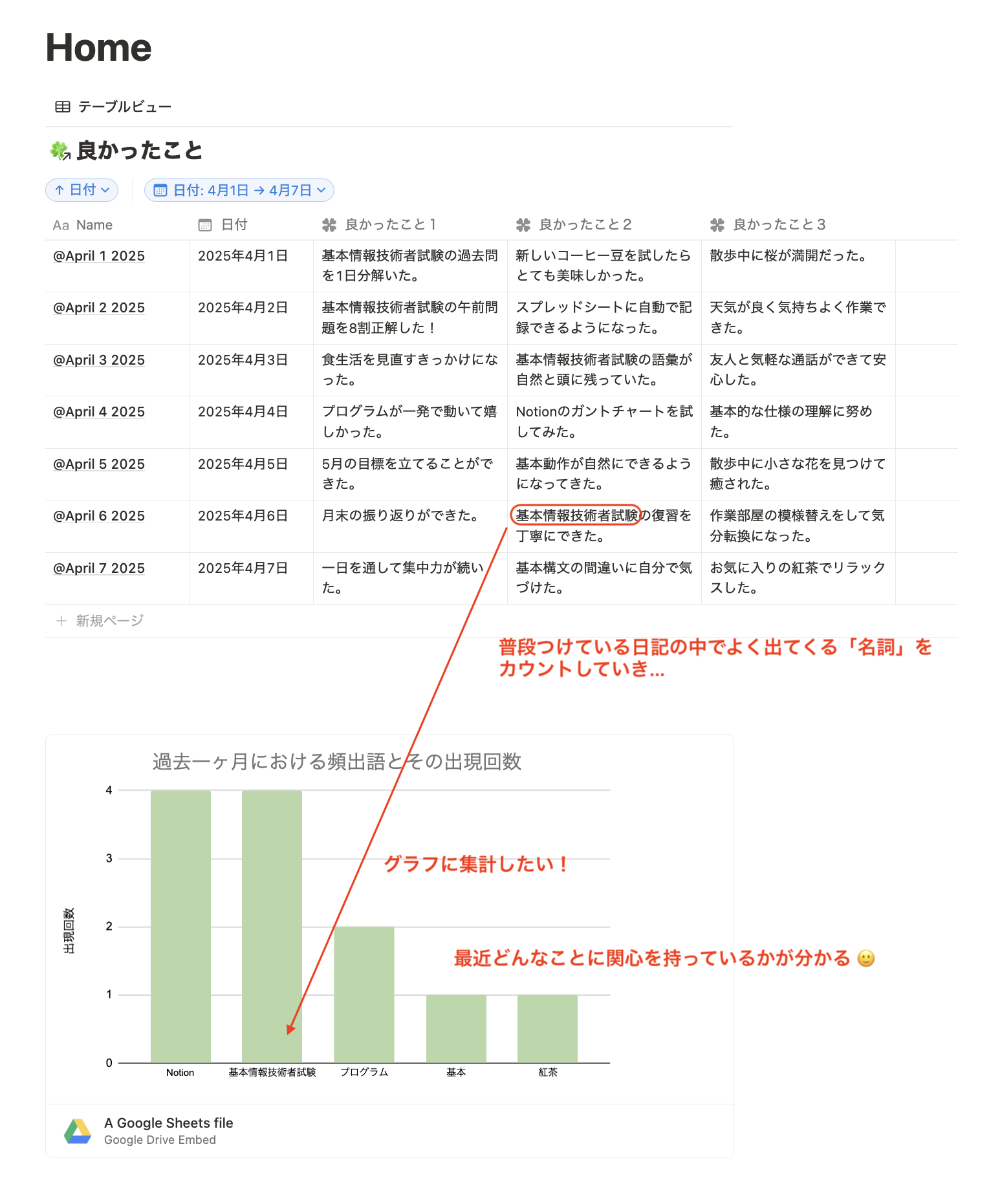

作りたいもののイメージ

成果物についてもイメージを共有しておきましょう。最終的にこのようなものを作ります。

Notionのセットアップ

それでは初めていきましょう。まずは主役のNotionのページのセットアップから。Notionアカウントの取得は省きます。下のテンプレートをご自身のページとして複製してください (右上の「複製」ボタンから)。

それからGoogle Sheetsを埋め込むためのページもご自身で作っておきましょう。

Notionインテグレーションの作成

続いてNotion APIの有効化です。「Notion インテグレーション」を作成する必要があります。

- 以下のページにアクセス

- ログインができていない場合は自分のNotionアカウントでログイン

- 「新しいインテグレーション」を選択し、

- インテグレーション名は分かりやすいように名前をつける

- 関連ワークスペースはテンプレートをコピーしたものをトグルから選択

- 種類は「内部」でOK

- 「内部インテグレーションシークレット」から トークンを表示 → コピー

Python環境のセットアップ

以下がPythonで形態素解析を行うためのソースコードです。コードの内容についてはREADMEに書いてあるので見てみてください。こちらをgit cloneしていただくか、ZIPファイルをダウンロードする形でご自身のローカル環境に持ってきてください。

VSCodeでconfig→.envを開き、こちらに先ほどNotionインテグレーションで手に入れたトークンをペーストしてください。

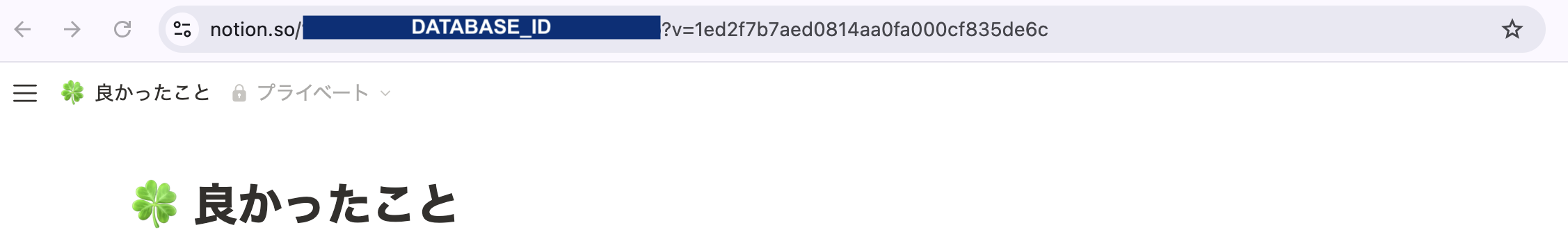

それから一段下、DATABASE_IDも必要です。Notionの「良かったこと」データベースに進んでいただき、リンクをコピーします。

https://www.notion.so/(DATABSE_ID)?v=...

というフォーマットになっていると思うので、(DATABASE_ID)の部分を抜き出してDATABASE_IDに書き込んでおきます。

ユーザー辞書の登録

例えば「基本情報技術者試験」という言葉が複数登場するとします。特に工夫をせず名詞を抽出すようとすると「基本」「情報」だけで取り出される可能性が高いです。

そこでcustom_dict/user.csvを作り、ユーザー辞書を登録します。するとここに書かれた後は一語として認識されます。

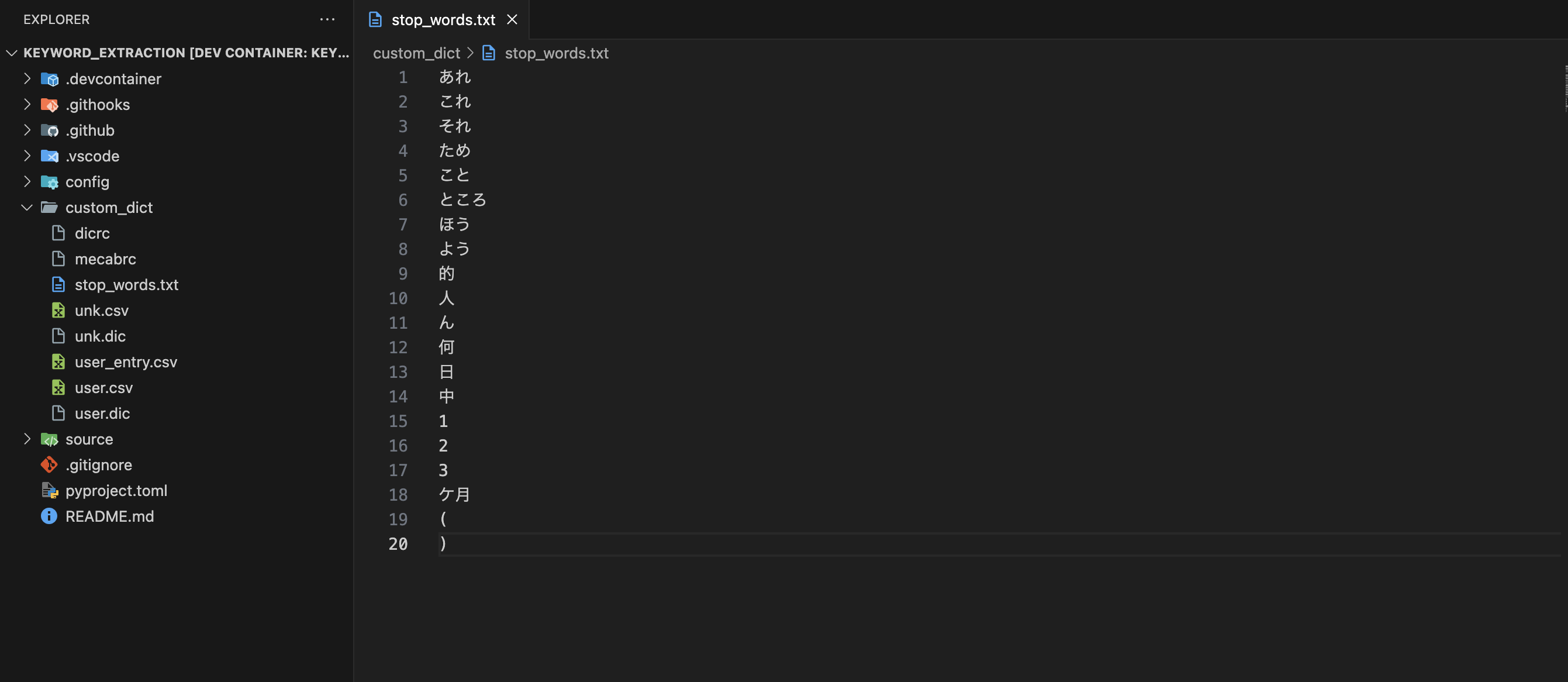

ストップワードの登録

「これ」「こと」「もの」

これらが頻出語として抽出されてしまうとなんとも言えない気持ちになります。

そう言った語はcustom_dict/stop_words.txtを作って登録しておきましょう。

READMEにある程度リストアップはしていますが、不要な語を見かけたらその都度追加していくことをお勧めします。

Google SheetsへのAPIを取得する

それでは最難関 (とは言っても面倒なだけですが)、GCPへの登録に移ります。GCP (Google Cloud Platform)とは、各種Goolgeアプリケーションに関する設定を細かく行えるプラットフォームです。Googleアカウントを持っていればアクセスできます。

普段Google SheetsやGoogle Driveを使っていても辿り着けないような深い層へのアクセスができます。その一つが今回利用するGoogle SheetsへのAPIの取得です。これが無いとせっかく言語解析を行なってもグラフに書き込む手段がありません...

-

Google Cloud Consoleへアクセス

- Googleアカウントでログインします (アカウントの作成については省きます)

- GCPへ登録する

- 「無料トライアルを試す」を選択します

※ この後クレジットカードの登録があるのですが、「フルアカウントを有効化」設定を追加で行わない限り、課金されることはないので大丈夫です (よほど沢山APIを呼び出さなければ問題ない)。おそらく資源を無駄に多く利用されないための処置だと思われます。 - 国は日本を選択

- 本人確認で住所・クレジットカード情報を入力

- 「無料トライアルを試す」を選択します

- 登録が完了したら、画面左上の「プロジェクトを選択」をクリック

- 新しいプロジェクトを作成

- 任意のプロジェクト名を入力

- 作成

- Google Sheets API を有効化

- 左上メニュー → 「API とサービス」→「ライブラリ」

- 「Google Sheets API」を検索

- 「有効にする」ボタンをクリック

- サービスアカウントを作成

- 左上メニュー → 「IAMと管理」→「サービスアカウント」

- 「サービスアカウントを作成」

- 任意の名前(例:sheets-access-account)

- 「作成して続行」

- ロールは「プロジェクト > 編集者」または「制限付きビューア」など適切なものを選択

- 「完了」

- サービスアカウントの鍵(JSON)を作成・ダウンロード

- 作成したサービスアカウントをクリック

- 「キー」タブを開く

- 「鍵を追加」→「新しい鍵を作成」

- キータイプ:「JSON」を選択し「作成」

-

credentials.jsonというファイルが自動的にダウンロードされるので、このファイルを プロジェクト内のconfigに配置

スプレッドシートの準備

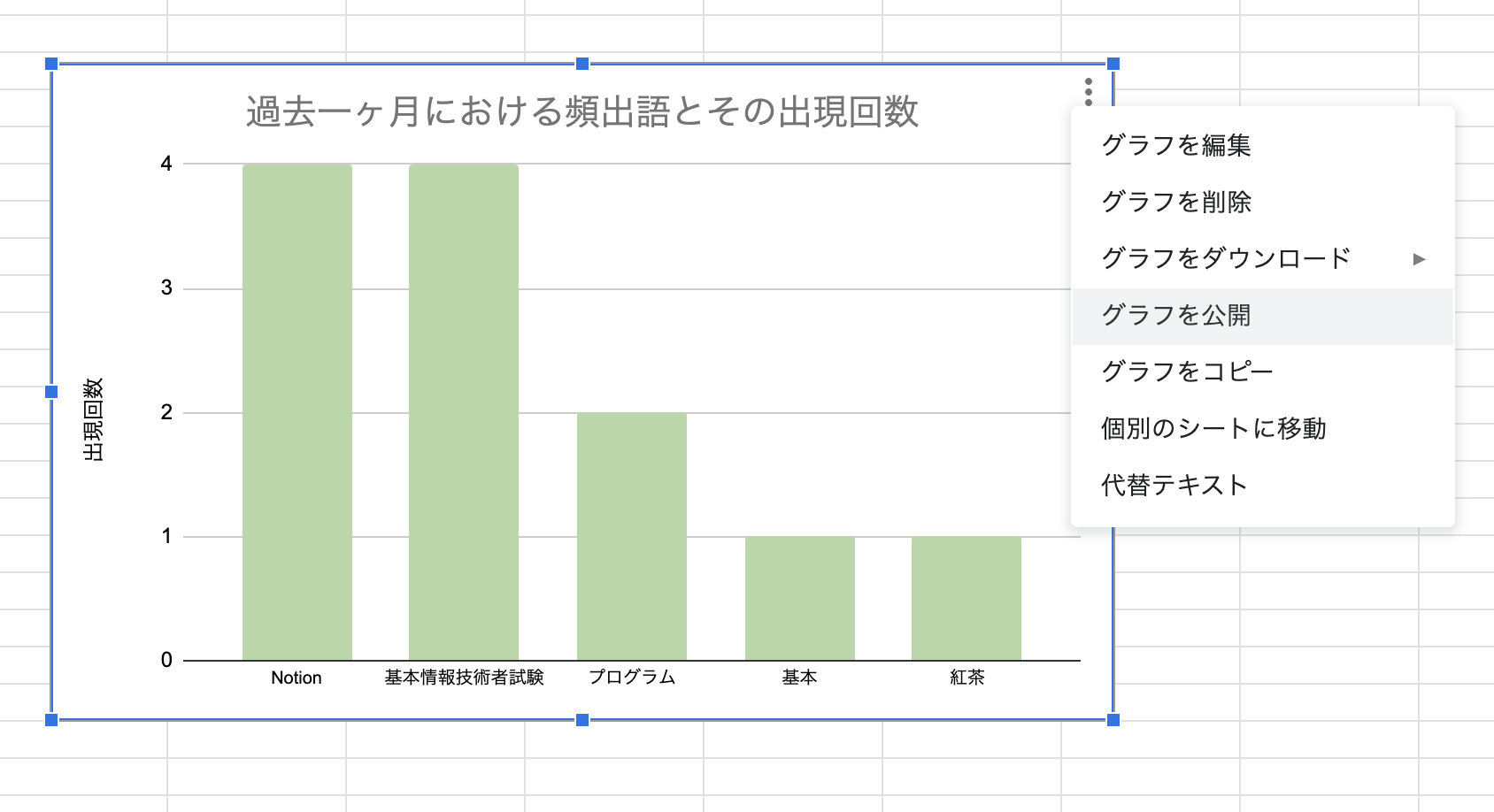

これでGoogleアプリケーションへのAPIが獲得できたので、スプレッドシートの用意に移ります。ここまで大変だったと思うのでテンプレートを用意しておきました (このくらい簡単ではありますが...)。

Keyword Extraction (Google Sheets)

こちらもご自身のGoogleアカウントにコピーしてください。特に設定を行う必要はありません。

コピーができたら、グラフへのリンクを取得しておきましょう。グラフの右上の3点印をクリック→「グラフを公開」→「公開する」→ 出てきたリンクをコピー、です。

最初のNotionの「Google Sheetsを埋め込むためのページ」に戻ります。/embedで「埋め込み」を選択、リンクを貼り付けてGoogle Sheetsを埋め込みます。これで全ての準備が整いました。

いよいよ言語解析

お疲れ様でした。後は以下のコマンドを叩くだけです。

python3 source/main.py

まとめ

QiitaやX、Instagramのタグの便利さに気付かされました。

直感的に「この言葉、多そうだな」という言葉でも機械的にやろうとするとそれなりに労力が必要です。

ここまでご覧いただき、ありがとうございました。

日記をつける習慣があれば、ご自身のデータでも試してみてください。

💡 この記事の制作にはかなりの試行錯誤と時間をかけました。

少しでも「役に立った」と思った方は、いいねやストックいただけると励みになります!