はじめのはじめに

この記事は、ABEJA Platformを用いて、Deep Learningのモデルを運用するためのステップ1となります。モデルの運用までは通常は、

- 初期実験

- チューニング

- 運用フェーズ

のフローから成ります。例えば、「手の位置を認識しよう」としたら、まずは既存のgithubをベースにして試す、上手くいかなければフルスクラッチでモデルを作成します。ある程度モデルが動くことが分かりましたら、パラメータのチューニングを行います。最後に、実運用に進み、失敗したデータも含めて継続的に学習を回します。

ここでは、クイックに既存の学習モデルを動かすための方法を紹介します。

はじめに

githubには膨大なDeep Learningの資産があり、これを用いることで、開発を大幅に加速することができます。githubにある多くのコードは、独自のアノテーションフォーマットで前提として構成されており、以前紹介したプラットフォームのデータ形式と異なります(プラットフォームのデータ形式で学習データを用意する例)。そのため、これまでの解説で紹介した方法ではgithubの資産をそのまま使うことはできません。

ABEJA Platformでは学習ジョブとノートブックのストレージが共有化されており、ノートブックの領域に置いたデータを学習ジョブから利用できます。これによって、データ形式によらない学習が実行できます。すなわち、既存のgithubの学習コードのデータのパスを修正するだけで、手軽に既存のgithubの学習ジョブを走らせることができます。

ジョブは学習が終わったら自動で終了しますので、自身でAWSインスタンスを借りて終了させる必要もなく、当然ながら手元の計算環境を占有することもありません。並列でジョブを回すこともできるため、PoCをする際の強力なツールとなります。さらに、ここで実験が終了してから、データのフォーマットを書き換えることで、アノテーションツールとの連携や、継続的な運用へ繋げることができるようになります。

本記事では、既存のgithubコードを用いてplatformで簡単に学習する手順について解説します。

今回のターゲット

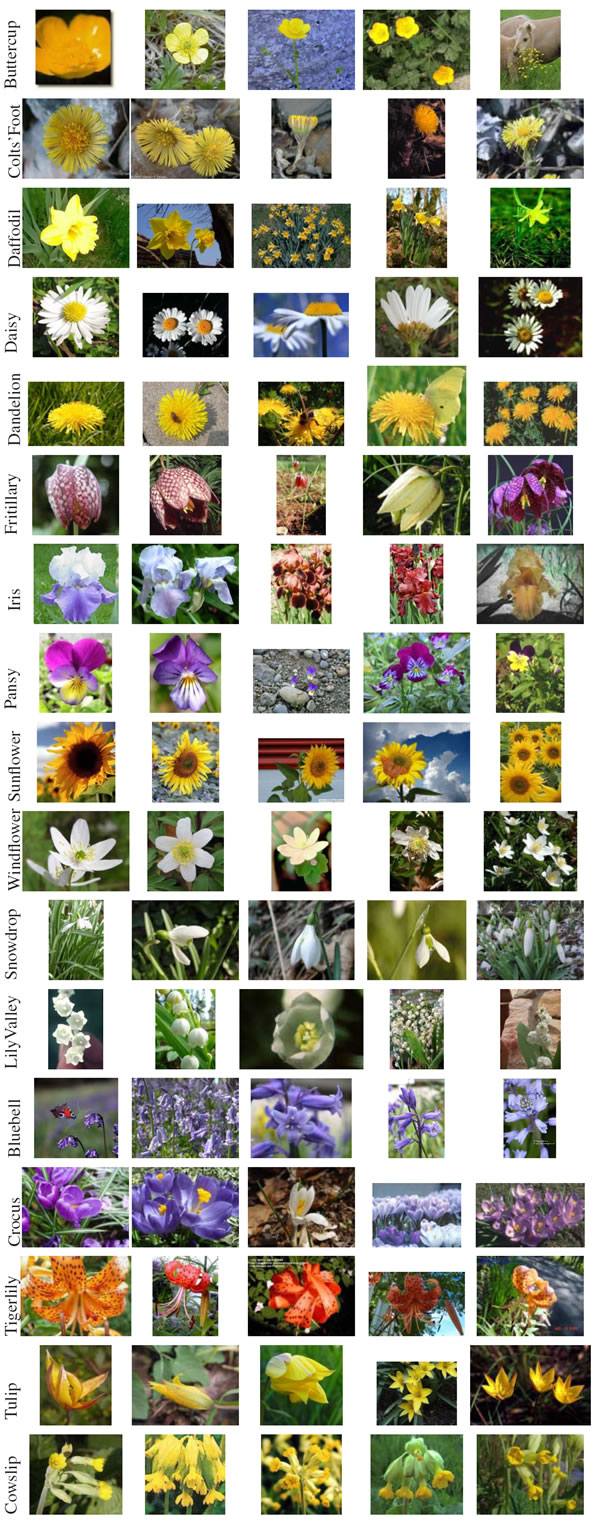

この記事では、花の画像データセットであるFlowers17データセットを用いて、17種類の花の画像の分類を行なっていきます。

画像のサンプルはこちらです。

手順

概要

大まかには以下の4つの手順から成ります。複雑な手順に見えますが、大まかには前処理をして、動作確認をし、パスを書き換えるだけです。

- 作業環境の準備

- データの準備・前処理

- 学習コードのテスト実施

- ABEJA Platformに学習ジョブを投入

作業環境の準備

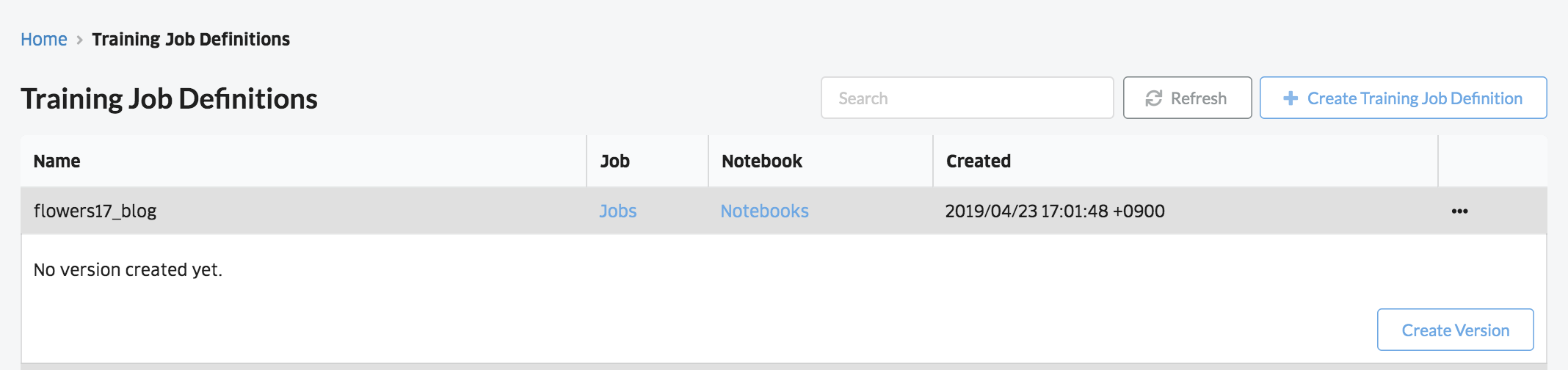

はじめに作業をするためのジョブを作ります。上記で述べた作業用ノートブックは、ジョブに紐づいています。そこで、まずはジョブの作成からはじめます。ジョブの作成は、左のメニューからJob Definitionを選択し、右上のCreate Training Job Definitionボタンを押し、ジョブを作成します。

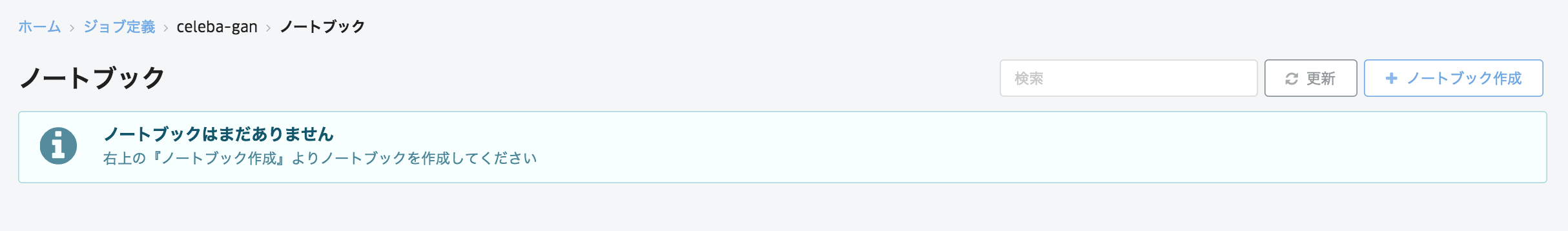

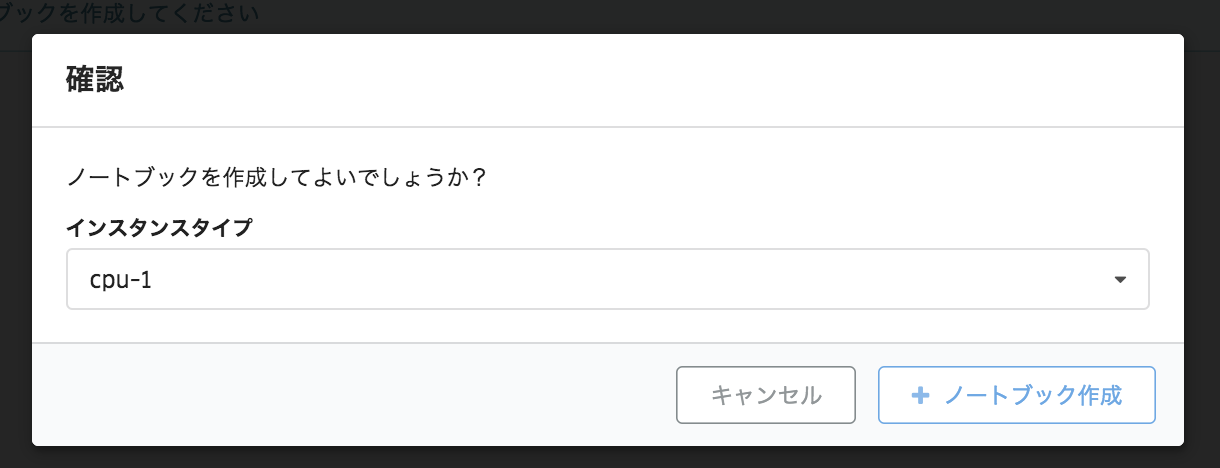

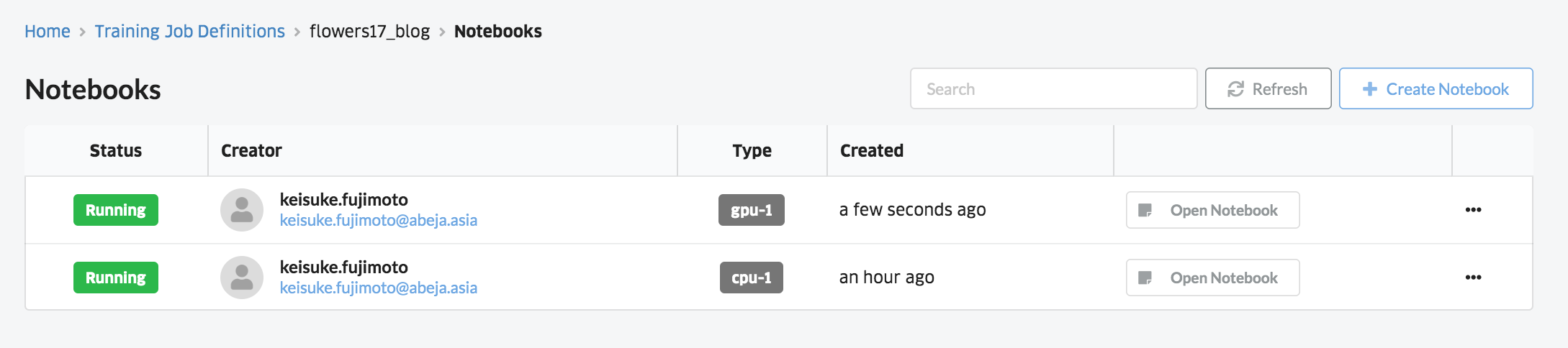

ジョブを作成すると、指定した名前のBoxができます。そこからNoteboosを指定することで、ノートブックの画面に移動できます。右上のCreate Notebookを選択するとノートブックを作成できます。ここでは、データを展開するだけですのでcpu-1インスタンスを選択しておきます。

以上で、ノートブックが作成されます。Open Notebookを選択すると、Jupyter notebookの画面に進みます。

データの準備・前処理

ここまでに、作業用のノートブックの作成を行いました。ここからは、データの準備を行なっていきましょう。まずは、ノートブックに画像データを持って来ましょう。Webページから手元のPCに一度データを落としてからノートブックの機能を用いてアップロードするか、直接Webページからダウンロードします。ここでは、Webページからダウンロードしましょう。Notebookの右上のメニューのNewからPython3を選ぶと新しいノートブックを作成できます。ここにダウンロードのコードを書いていきましょう。

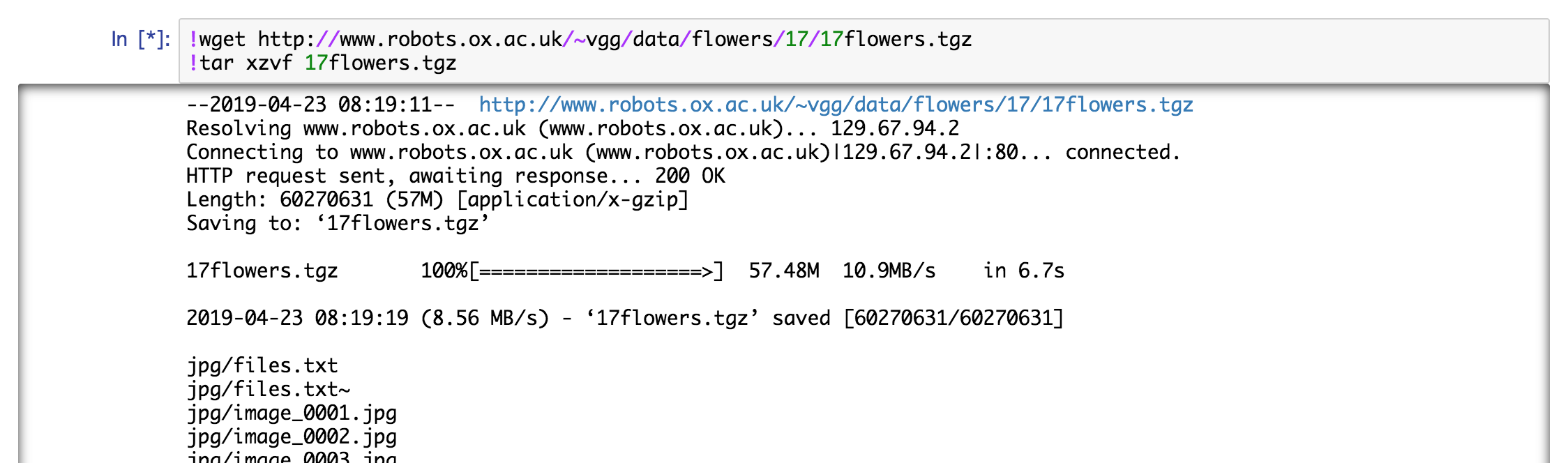

ダウンロードとデータの展開コードは以下となります。ノートブックに下記を移してRunボタンで実行しましょう。数分程度待つとデータが生成されます。

!wget http://www.robots.ox.ac.uk/~vgg/data/flowers/17/17flowers.tgz

!tar xzvf 17flowers.tgz

実行中の画面は以下のようになります。

Flowers17データセットは画像のサイズが不定なので、前処理でデータのサイズを固定します。新しいノートブックを作成して、前処理のスクリプトを動かしましょう。画像を開いて、サイズを64x64に変換して保存します。保存先としてimagesディレクトリを作成します。以下を実行すると、imagesディレクトリに元のjpgディレクトリと同じファイル名でリサイズ済みのファイルが保存されます。

import os

import glob

from PIL import Image

os.makedirs('images', exist_ok=True)

files = glob.glob('jpg/*.jpg')

for f in files:

img = Image.open(f)

img = img.resize((64, 64))

target = os.path.join('images', os.path.basename(f))

img.save(target)

学習コードの確認

まずはテストのため、ノートブック上で学習を実行してみましょう。ここでは、最初のステップとして、以下のリポジトリの学習コードを使います。

https://github.com/peisuke/flowers17_recognition.chainer

学習のテストでは、jupyter notebookのターミナルに進み、学習のコードを落としましょう。ノートブックのトップからNew→Terminalを選択します。

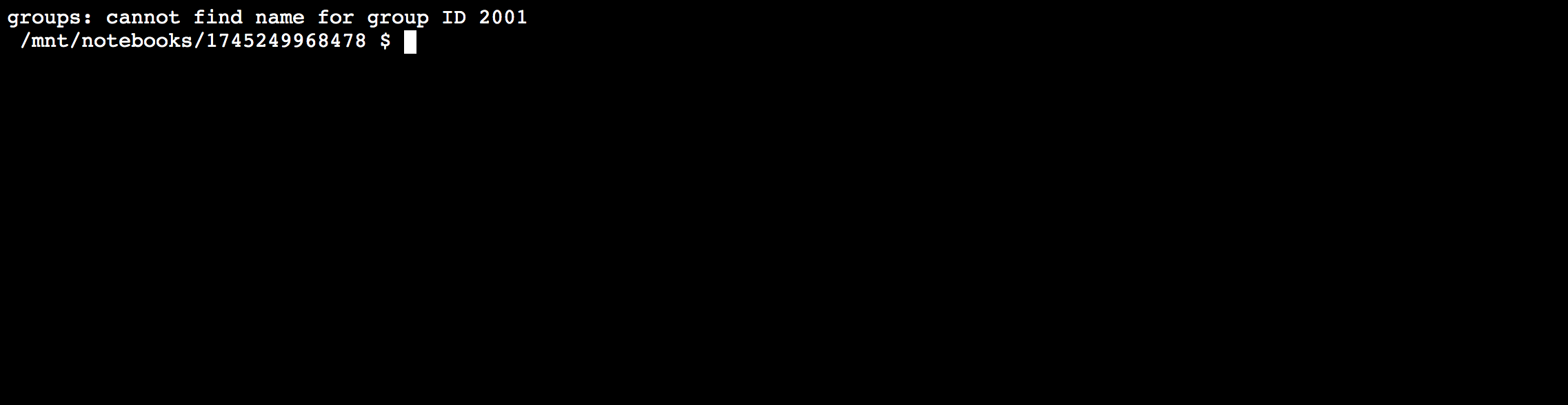

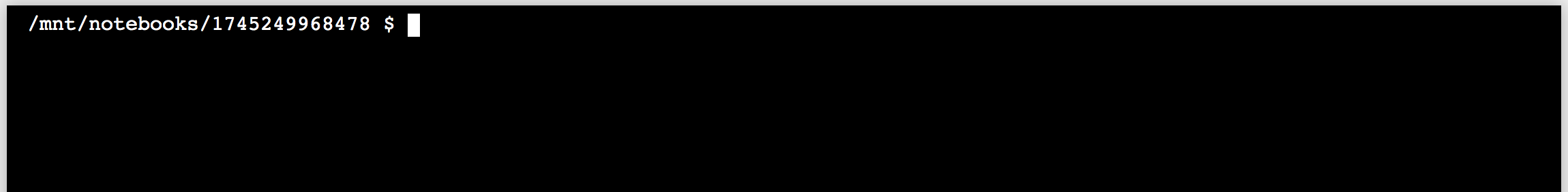

すると、以下のような黒い画面が表れます。

この画面上で先ほどのgithubのリポジトリをcloneします。

git clone https://github.com/peisuke/flowers17_recognition.chainer.git

すると、元のノートブック上に以下のようにflowers17_recognition.chainerディレクトリが作成されます。

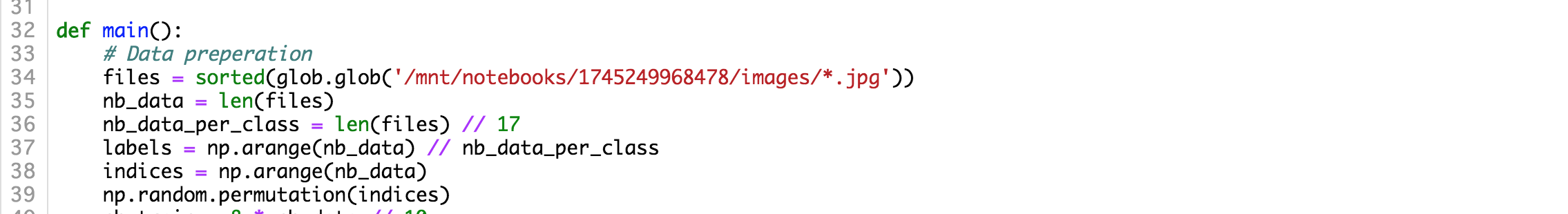

次に作成されたモデルを実行してみます。flowers17_recognition.chainer/trainを開いてソースコードを眺めてみましょう。34行目に画像のディレクトリを指定するコードが見つかると思います。

一旦は、このデータを参照する形として実行してみましょう。

・・・と上記画面で数分間止まると思います。画像全部に対して、1周分学習されるまでは何も表示されないので、エラーが出ないのだけ確認して、ここで終了しておきましょう。終了はCtrl+Cです。

テスト学習の実行

さて、精度は分かりませんが、ここまでで学習が走ることを確認できました。では一旦モデルが動作するかどうかを確認するために、GPUで実行してみましょう。Platformのノートブックの選択画面から、今度はgpu-1でノートブックを作成しましょう。

さて、また先程と同様に、ターミナルを開いてgithubからモデルをcloneして来ましょう。

git clone https://github.com/peisuke/flowers17_recognition.chainer.git

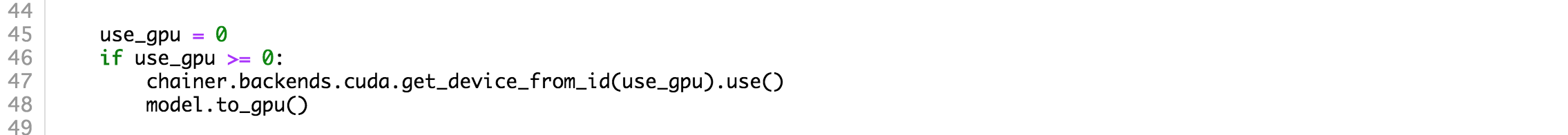

次にノートブックの画面に戻り、flowers17_recognition.chainer/train.pyを編集します。まずはgpuで動くようにgpu=-1となっている所をgpu=0に修正します。

また、データの位置を修正しましょう。データは先ほどのCPUのノートブックのIDのディレクトリに入っています。CPUのノートブックのIDはターミナル上から確認できます。ここでは、1745249968478とします。

この場合、/mnt/notebooks/1745249968478/imagesに画像データが格納されている事になります。そこで、train.pyの34行目の画像格納位置を変更します。変更後は必ずファイルを保存しましょう。

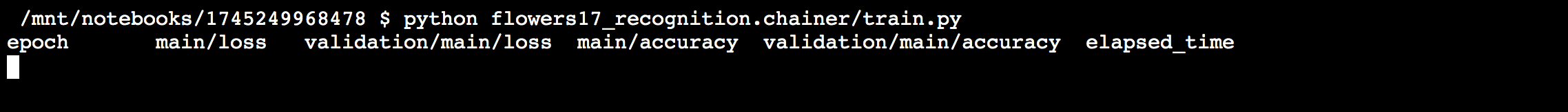

さて、再度モデルを実行していきましょう。同様にターミナルを開いて、実行します。

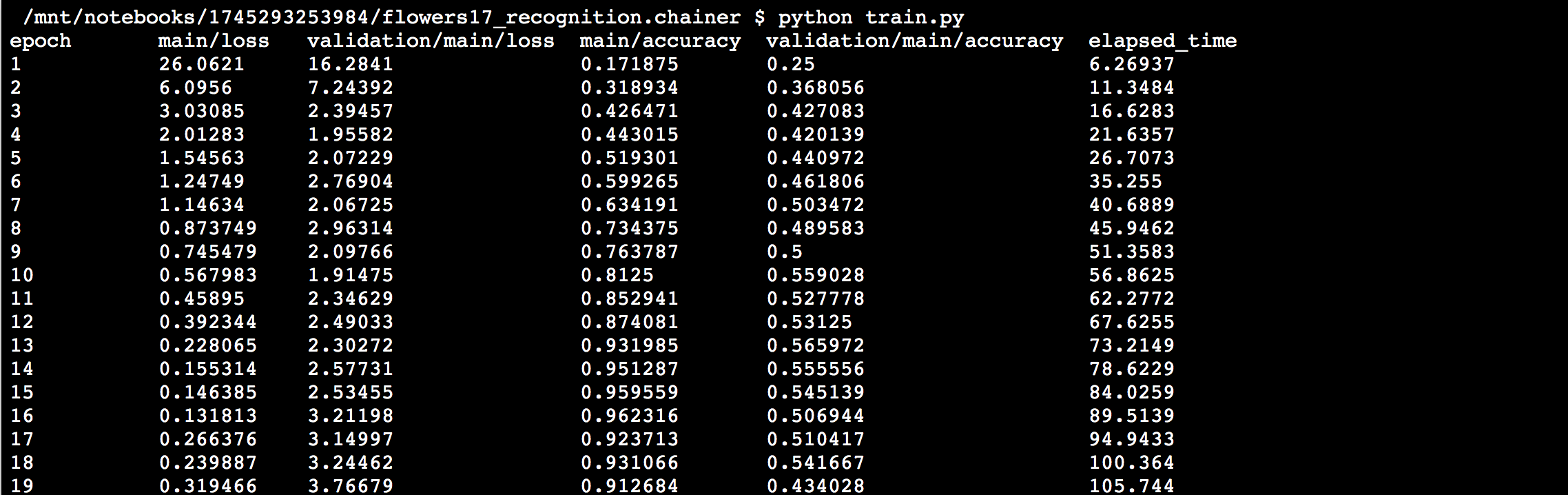

このような感じで実行できました。

ジョブの立ち上げ

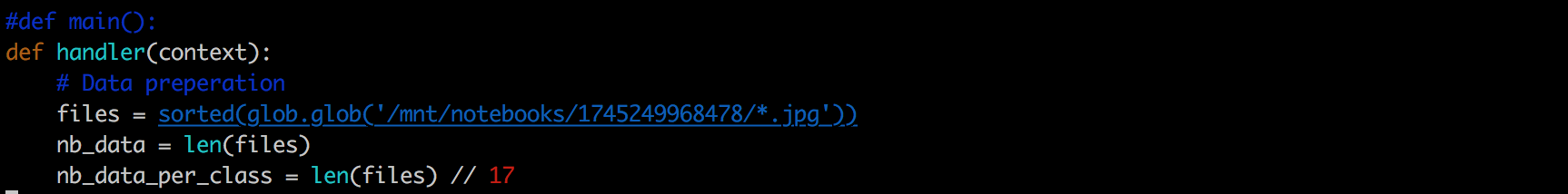

では、プラットフォームにジョブを作っていきましょう。ジョブを作ると言っても、先ほどのコードを少しだけ終始&zip化してプラットフォームに送るだけです。まずは、ローカルの環境にgithubを落として来ましょう。また、train.pyを先程と同様に修正します。続いて、エントリポイントを修正します。プラットフォームは、contextを引数としたhandler関数からスタートするので、main()を修正します。

続いて、コードをzipに纏めます。

$ zip -r archive.zip *

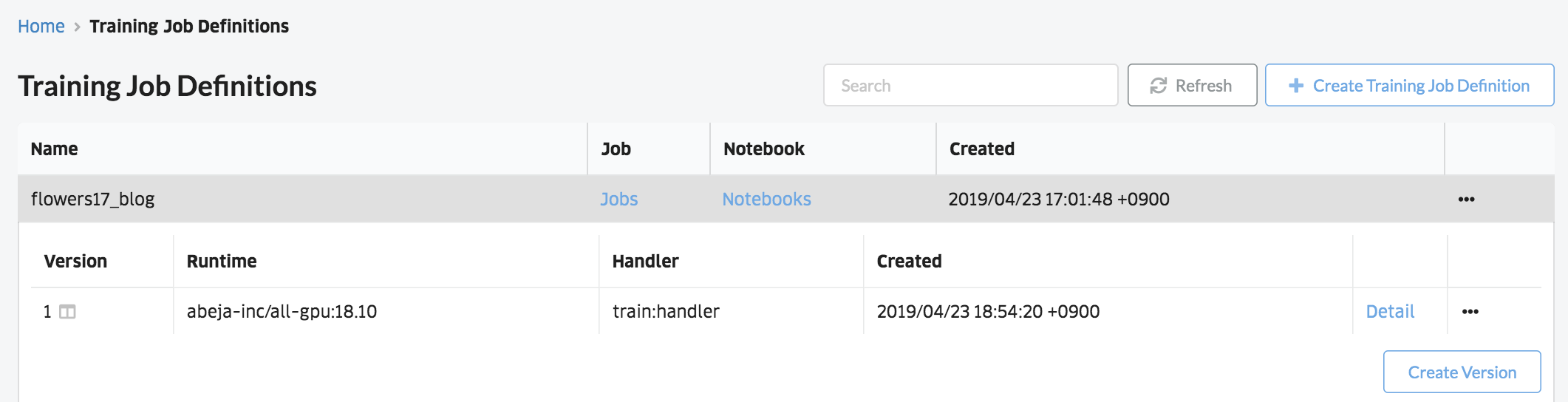

とすると、zipファイルができます。JOBのダッシュボード上からCreate Versionを選択し、Handlerの項目にtrain:handlerを設定します。これはtrain.pyのhandler関数から開始されることを意味します。続いて、下のSOURCE CODEから先程作成したarchive.zipをアップロードし、Job Versionを作成します。以下のように新しいバージョンが作成されます。

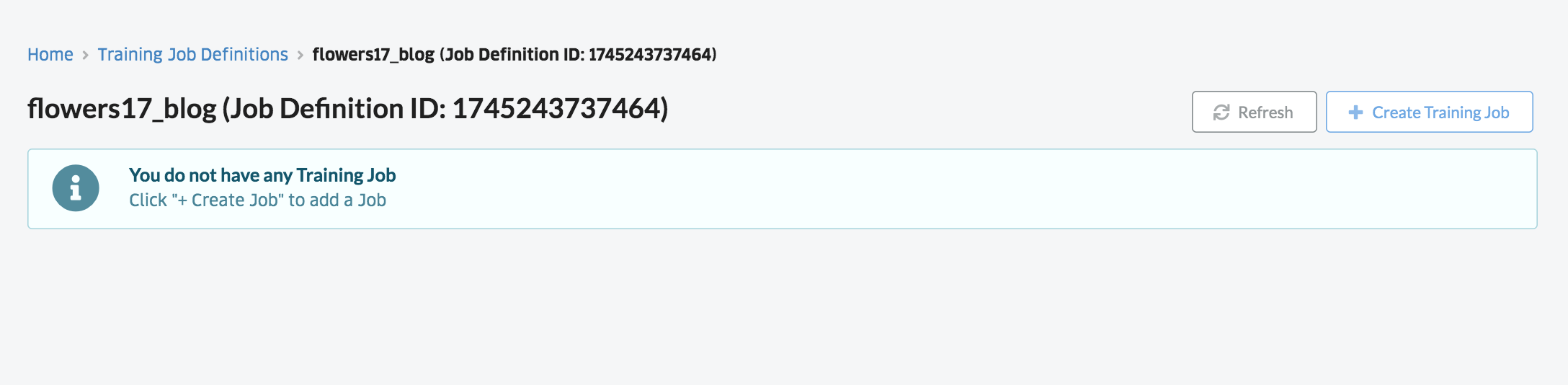

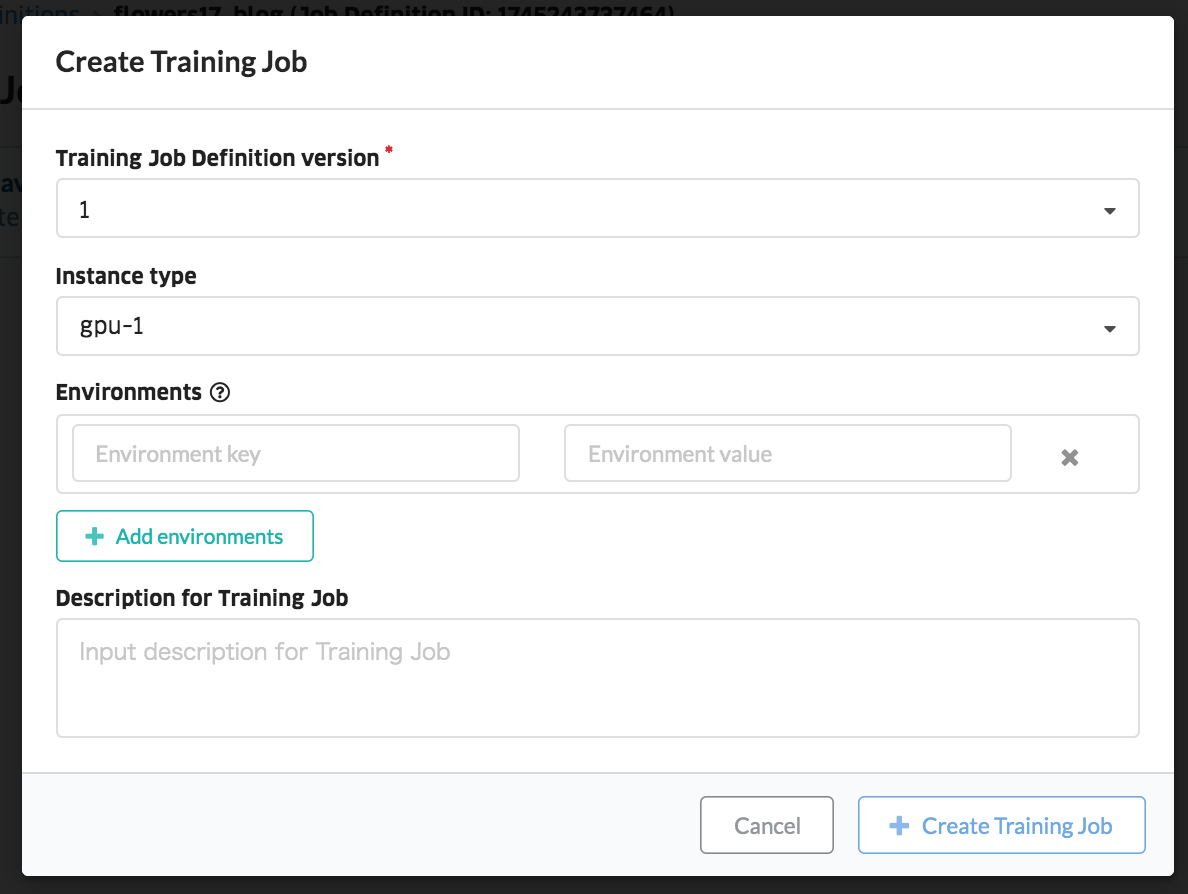

Jobsをクリックし、右上のCreate Training Jobを選択し、先程作成したJob versionとGPUの種類を選び、Create Training Jobを用いて、ジョブを立ち上げます。

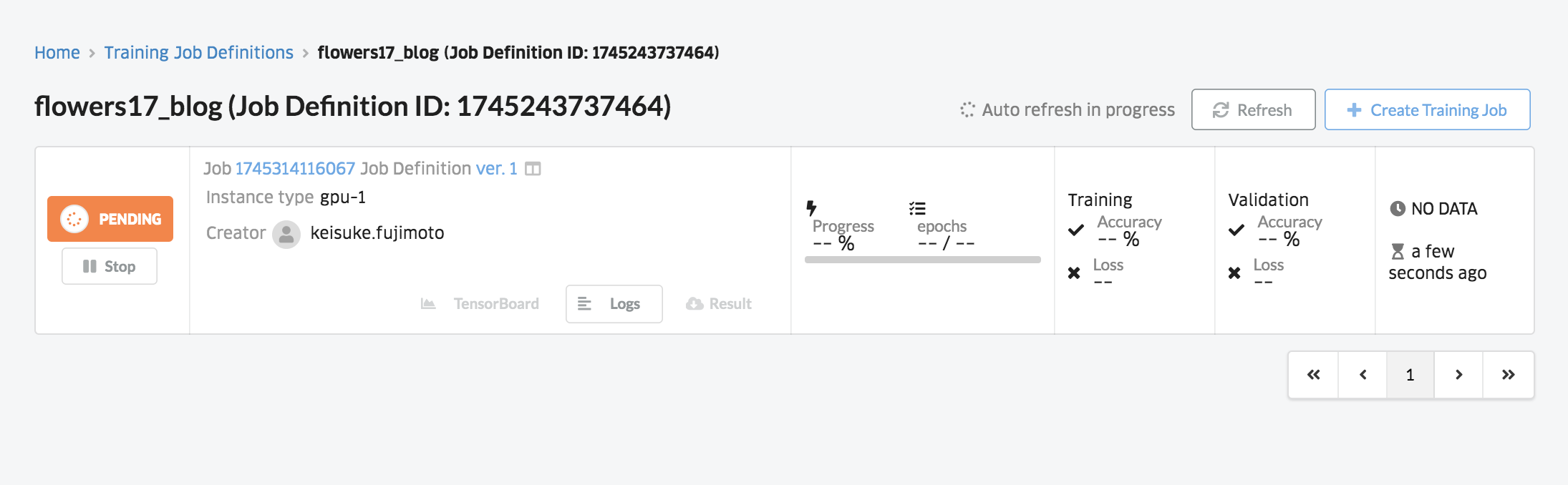

すると、以下のようにジョブの待ち状態になります。

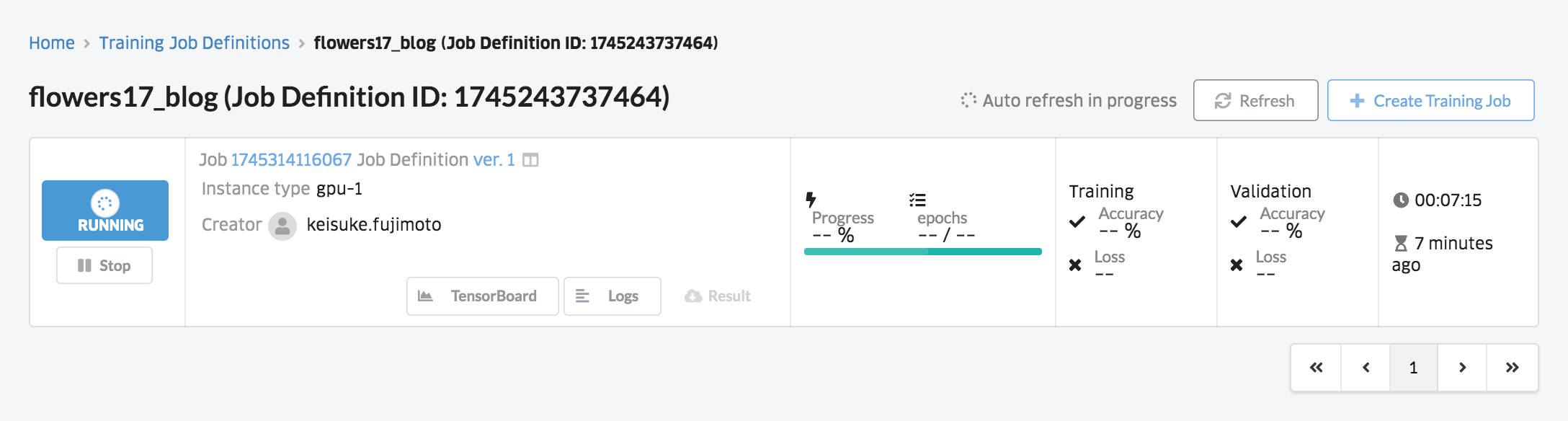

しばらくすると、以下のように学習がスタートします。Logsから学習状況や精度を確認できます。なお、ダッシュボードとの連携コードは書いていないので、画面上に進捗状況や精度などは表示されません。

追記:ジョブの立ち上げ(CLI版)

ジョブを立ち上げるのに、わざわざzipをダウンロードするのは面倒です。ABEJA CLIを用いることで、より簡単にジョブを作成できます。jupyterのターミナル上からCLIを用いる事ができます。まずは、クレデンシャルを設定しましょう。

$ abeja configure

abeja-platform-user : {User-ID}

personal-access-token: {Token}

organization-name : {Organization-ID or Organization-Name}

続いてジョブの立ち上げです。まずは、以下のようにyamlファイルを作成します。ファイル名はtraining.ymlです。

name: {Job-name}

handler: train:handler

image: abeja-inc/all-gpu:18.10

設定ができたならば、バージョンの作成とジョブを立ち上げましょう!

$ abeja training create-version

$ abeja training create-job

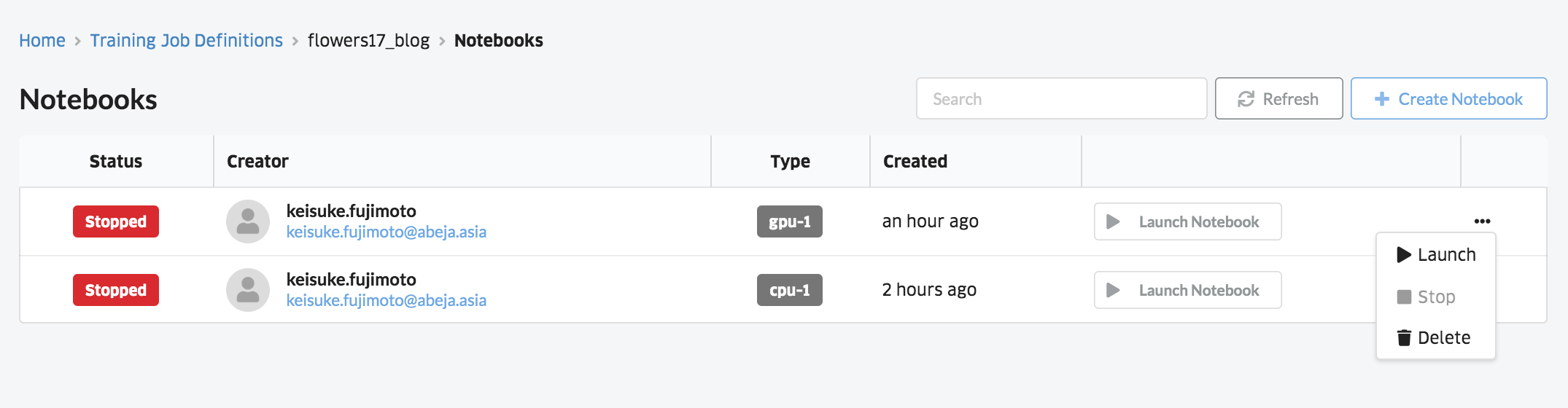

片付け

使用したノートブックは落としておきましょう。ノートブックのダッシュボードからノートブックを停止します。

まとめ

以上のようにnotebookにデータをアップロードすれば、trainingコードのデータのパスをそこに指定するだけど、既存の学習コードがそのまま動作することを確認できました。今回はチュートリアルということもあり、非常に簡単なモデルで実験をしました。実際に実験をする際には、ここからパラメータをチューニングして精度を上げる必要があります。次回は、精度を上げる手順について、ご紹介しようと思います。