はじめに

株式会社NTTデータ デザイン&テクノロジーコンサルティング事業本部 の nttd-saitouyun です。

最近はDatabricksを勉強してみたいという話をよく聞くようになってきました。その中で必ずと言っていいほど話題に上がるのが「認定資格」です。

「難しいの?」「実用的なの?」「AWSの試験と何が違うの?」「ラーニングパスは?」等々、様々な質問を受けてきました。今回はDatabricksの全7認定(2024年4月時点)に合格した経験から認定試験の全体像について記載します。

注意

- 難易度や実用性等の評価はあくまで主観となりますのでご注意ください。目線としてはデータエンジニアに近いと思います

- 本文中に、AWS Certified Data Analytics – Specialty (DAS)について言及する記載がありますが、4/8に試験としては廃止されています。すでに当該資格をお持ちの方に向けた情報となります。新しく資格を取得される方は、AWS Certified Data Engineer - Associateをご検討ください

- 2024年4月時点の情報を元に記載しています

Databricksの資格について

Databricksには大きく分けて、「Accreditations」と「Certifications」の2種類の資格があり、デジタルバッジの形が少し違っています。「★」の数が難易度を表しているのは共通です。

Accreditations

トレーニングコースを修了することで認定を受ける資格です。バッジの形が丸っこいです。

Databricks Academy に登録すると、さまざまなトレーニングコースをe-Learning形式で受講することができます。後述する「Certifications」の準備のコースもあります。

動画の視聴やコース内のクイズに回答をして進めていきます。トレーニングを修了するとデジタルバッチを受け取ることができます。

Certifications

試験に合格することで認定を受ける資格です。バッジの形はやや縦長です。

試験はデータ利活用の役割ごとに、データアナリスト、データエンジニア、MLエンジニア(データサイエンティスト)、スペシャリティ(領域特化)の4つのカテゴリが分かれています。出題範囲はカテゴリごとに重複する部分もあります。この辺りは後述します。

試験は Webassessor に登録することで申し込みができます。

残念ながら今のところは自宅でのWebテストのみで、テストセンターでの受験はできませんのでご注意ください。

注意

この「Accreditations」と「Certifications」ですが、日本語にしてしまうと区別がつかないので混乱しないようにしましょう。本書では「Certifications」について言及します。

英語のページ ↓

日本語のページ ↓

認定資格の全体像について

各試験の話に入る前に資格の全体像を見ていきます。

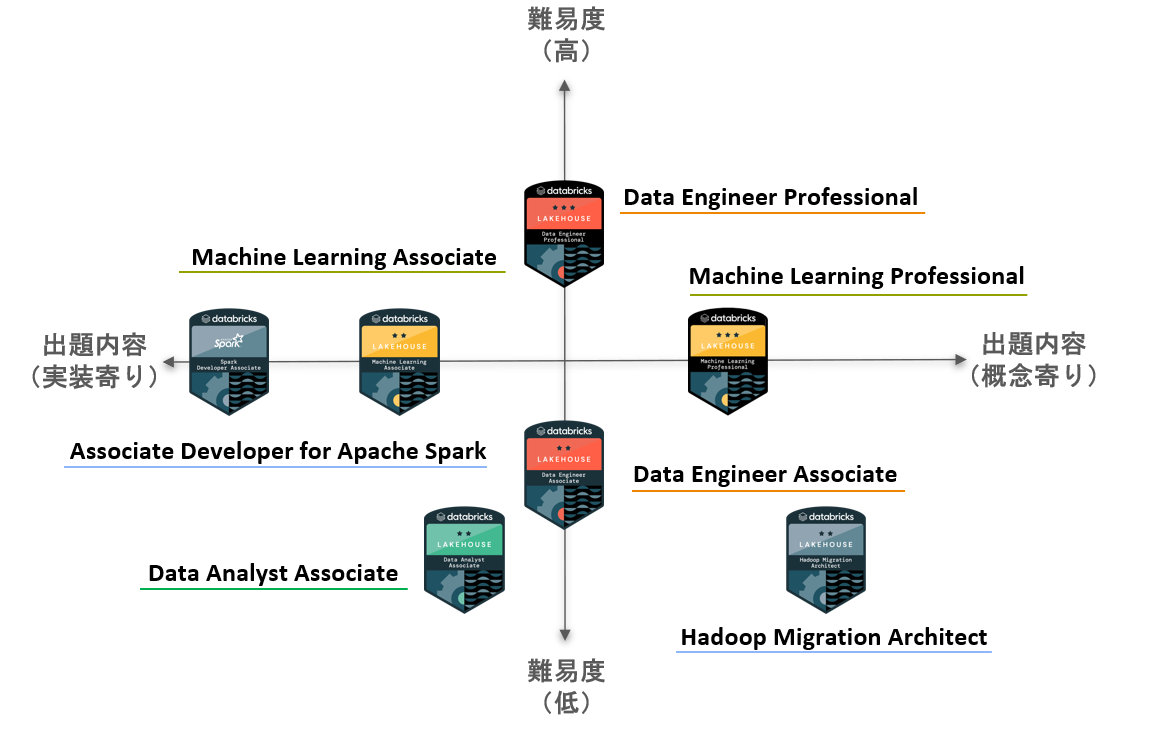

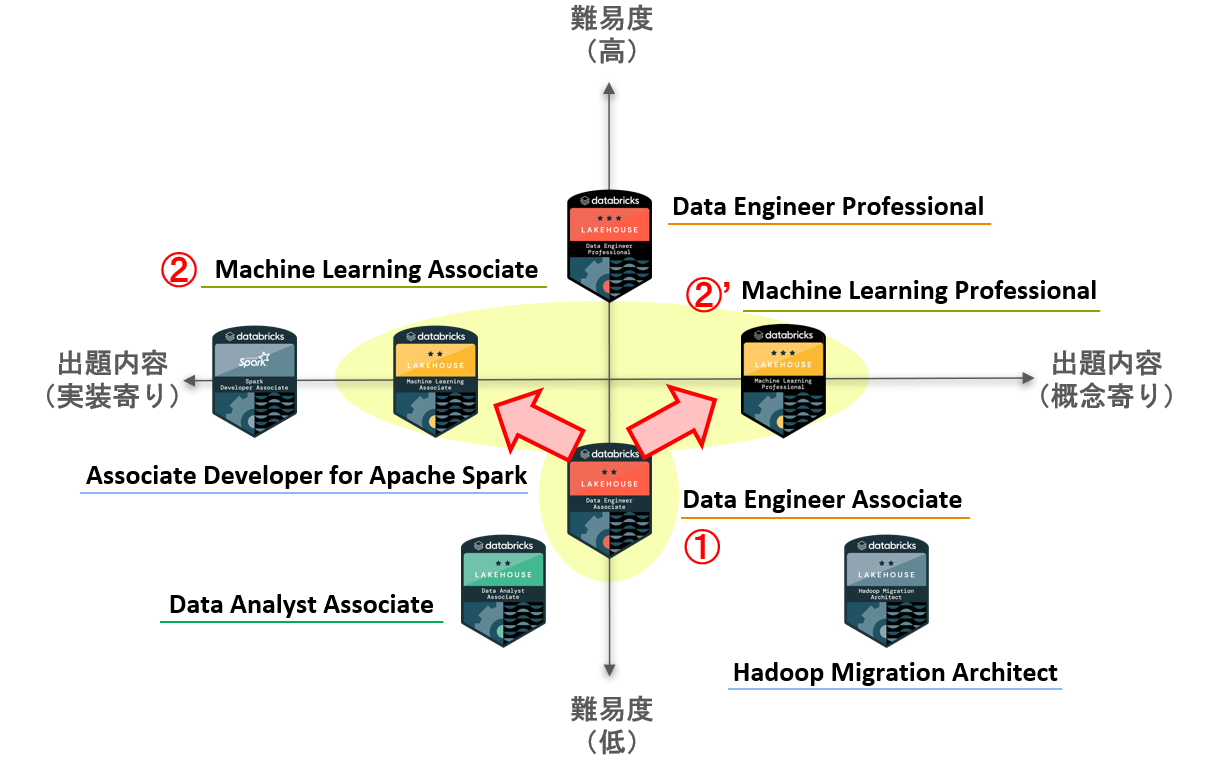

難易度-出題内容

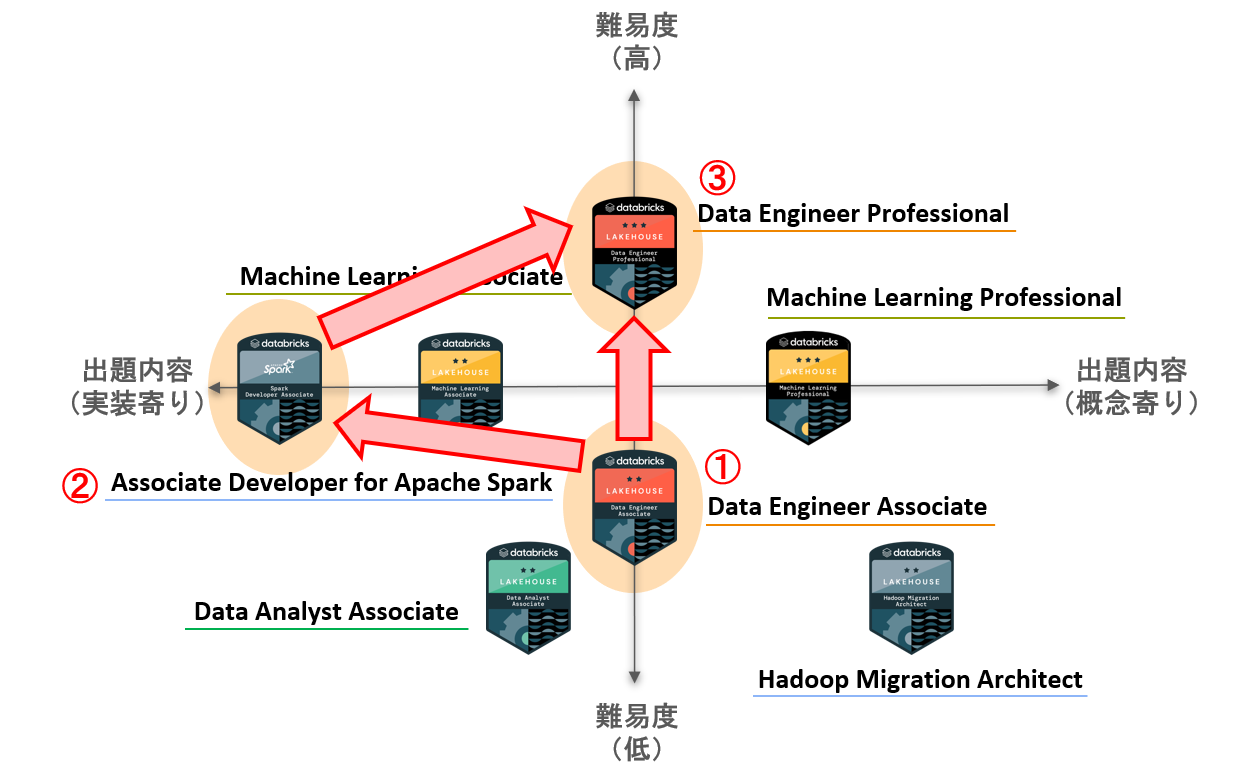

よく「実用的か?」という質問を受けますが、実用的かどうかは受験者のロールに依存するのではないでしょうか。

アーキテクトのように、システムによる課題解決やシステム全体の機能配置を検討するのであれば、「データレイクハウスアーキテクチャ」「MLOps」などのより概念寄りの理解が必要になりますし、実際にデータパイプラインやAIモデルの開発を行うようなエンジニアはよく使うAPIやコマンドなどの実装寄りの知識のほうが役に立つと感じるのではないかと思います。

かなり主観はあると思いますが、この難易度(高↔低)と出題内容(実装↔概念)についてマップしてみると以下のようになるのではないかと思います。

個々の認定資格について

それでは各試験について見ていきます。本記事は「どの試験があるのか?」「どのような試験を受けたら良いのか?」という疑問をお持ちの方に向けたものです。

各試験に合格する方法は、様々な方が記載している「合格体験記」をご覧ください。

データエンジニア

以下のロールを想定したカテゴリです。

データエンジニアは、Databricks プラットフォームとその機能を使用して、バッチおよびストリーミングデータパイプラインの設計、開発、テスト、保守を行います。

データエンジニア アソシエイト / Databricks Certified Data Engineer Associate

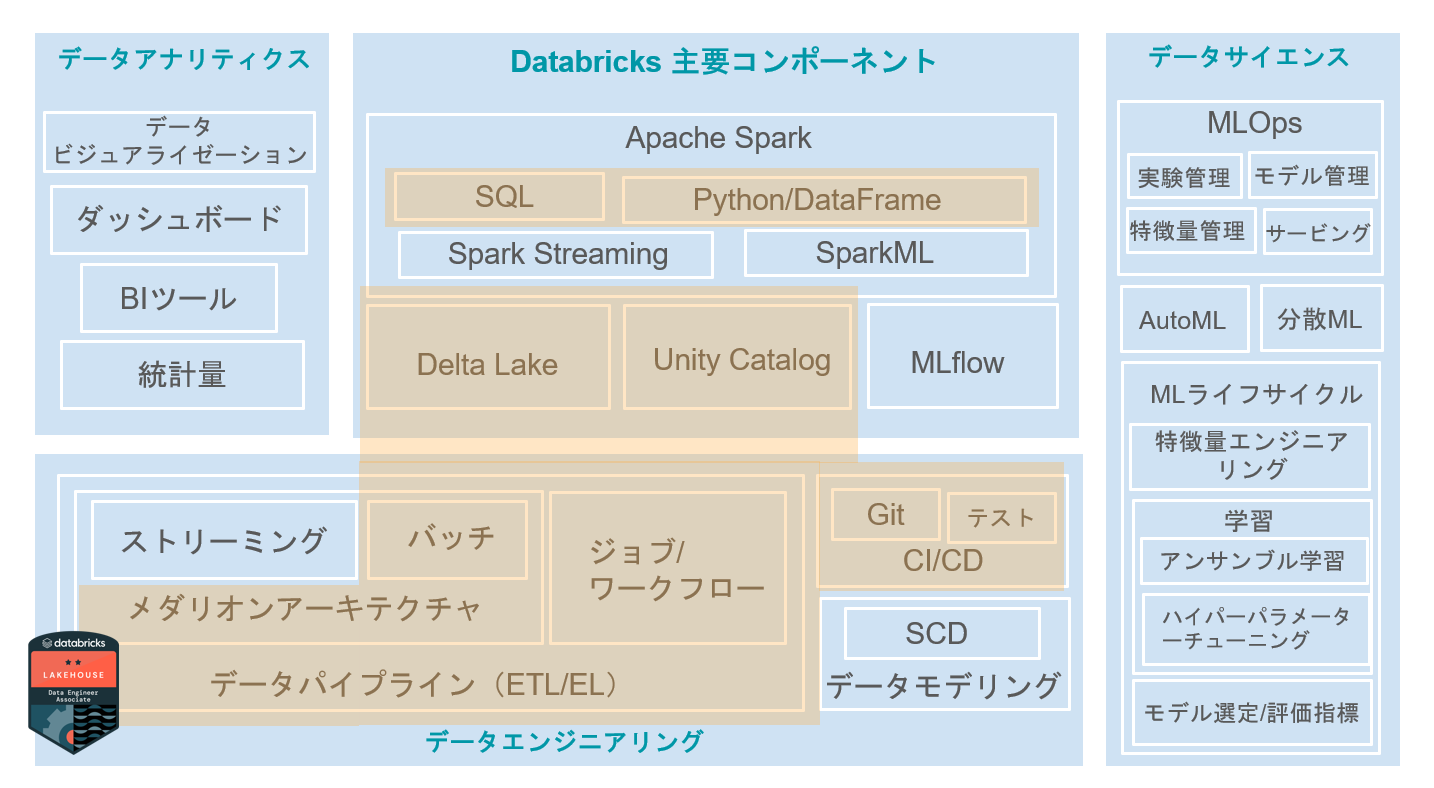

データレイクハウス、Apache Spark、Delta Lake、Unity Catalog などの Databricks を構成する基礎的な概念やコンポーネントやデータエンジニアリングの基礎(バッチのデータパイプライン、データガバナンスなど)を学ぶことができます。

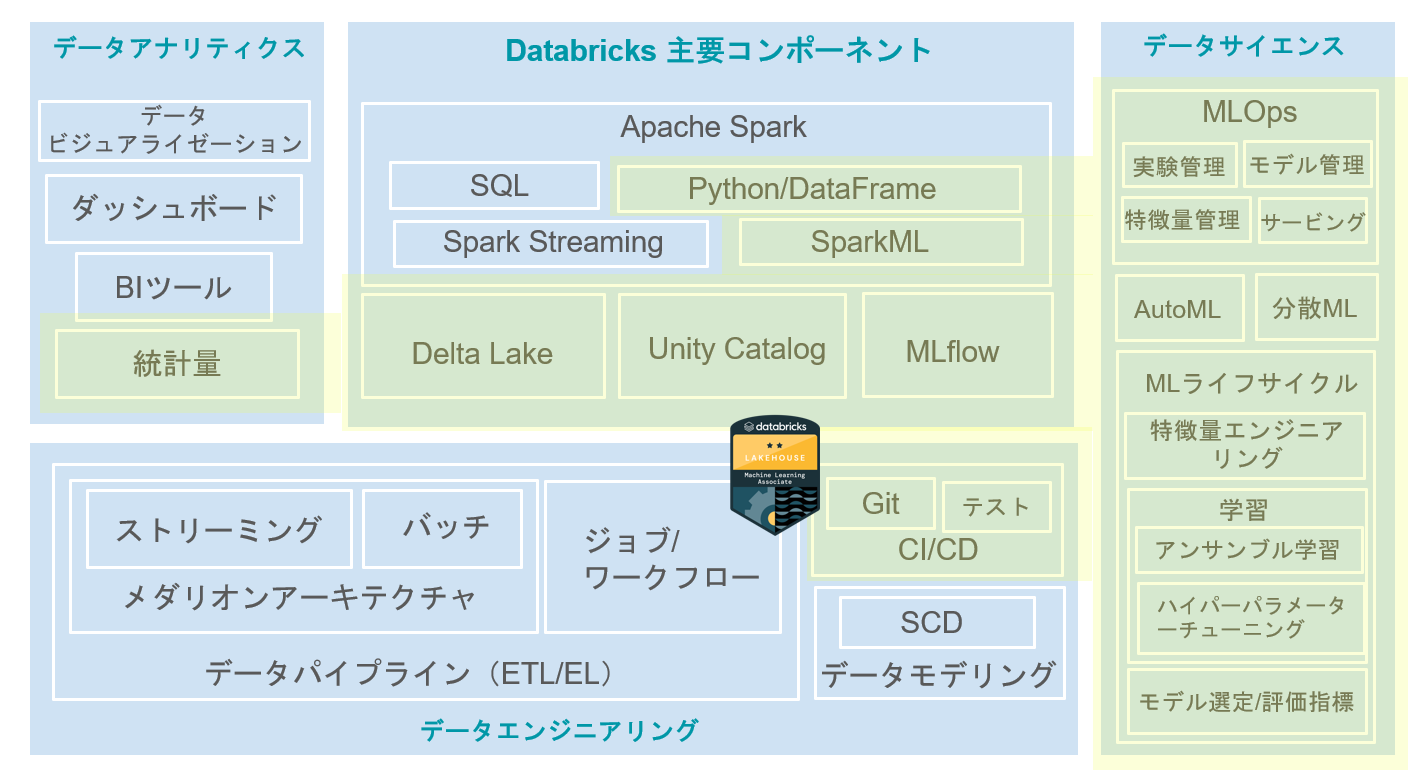

キーワードベースで出題される内容がパッとイメージできるような図を以下に作成してみました。

※この図は網羅性や出題内容を保証するものではない点についてご注意ください。詳細は各試験の「Exam Guide」を確認してください。以降も同様です。

主観ですが、難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★★☆☆☆ |

| 英文の難易度 | ★★☆☆☆ ↓ ☆☆☆☆☆(日本語で受験可能になりました) |

| 学習のしやすさ | ★★★★★ |

| ロール別のおすすめ度 | |

| データエンジニア | ★★★★★ |

| データアナリスト | ★★★☆☆ |

| データサイエンティスト | ★★☆☆☆ |

| インフラエンジニア | ★★★★☆ |

「トレーニングやサンプル問題など情報量が多い」「試験が日本語で受けられる」など学習がしやすく、Databricksの基礎を身につけられるため、データエンジニアでなくても、まずはこの試験を受けることをおすすめします。

データエンジニア プロフェショナル / Databricks Certified Data Engineer Professional

アソシエイトの内容に加えて、チューニングやリアルタイム処理など高度な内容が出題されます。また、データモデリングなど範囲も広くなっています。(しれっとMLflowも範囲に入っています。)

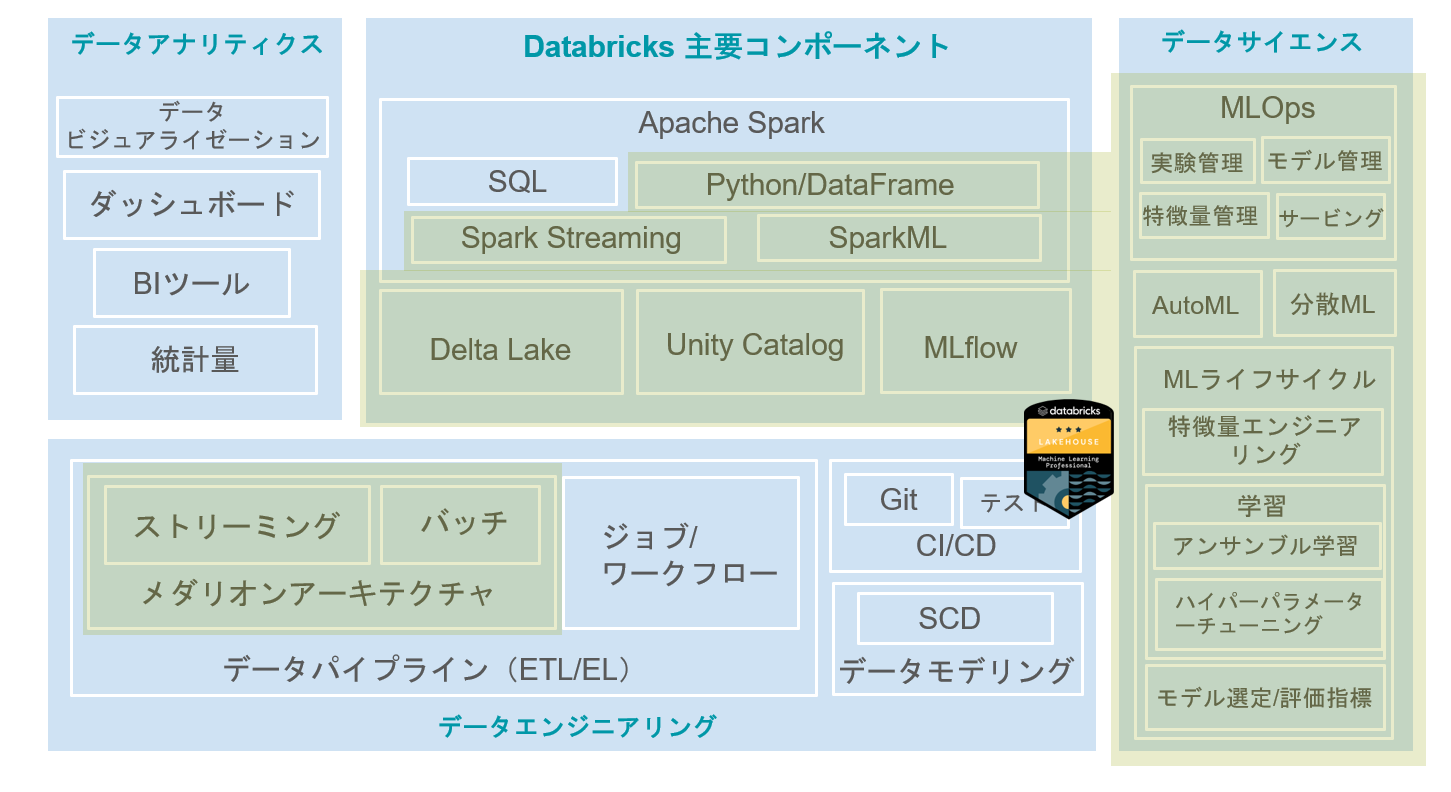

大まかなカバー範囲は以下の通りです。データパイプラインは、バッチに加えてリアルタイム処理に関するものが多く出題されます。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★★★★★ |

| 英文の難易度 | ★★★★★ |

| 学習のしやすさ | ★★★☆☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★★★★★ |

| データアナリスト | ★☆☆☆☆ |

| データサイエンティスト | ★☆☆☆☆ |

| インフラエンジニア | ★★★☆☆ |

プロフェッショナルなので内容も難しいのですが、それ以上に英語が難しいです。問題文が長めの英文なので、最後まで問題を読み切るだけで時間がギリギリでした。間違いなく最難関の資格なので準備をしっかりして挑みましょう!しっかり対策すれば合格は可能です。

AWS DAS との違い

パブリッククラウドの試験にも、データエンジニアリングの試験はあります。ここでは、AWS DASとの違いを記載します。

AWS DASでは要件に基づいて、「どのようなサービスを利用するのか?」「サービスを組み合わせるのか?」というアーキテクチャ(サービスの機能や連携性)に関する出題が多いです。

一方、Databricksのデータエンジニア系の資格は、よりアプリケーション寄りで、どのように「データパイプラインを構築するのか?」「テーブルを設計するのか?」という観点が多く出題されます。

よって、出題されるレイヤが違うため、Databricksのデータエンジニア系の資格は、AWS Glue や Amazon EMR で Spark や Delta Lake を使う上でも有用です。よって、やる気がある人は両方にチャレンジするのがいいのではないでしょうか。(AWS DAS を取ったものの、Spark のことよくわかっていないって方、意外と多いのでは!?)

データアナリスト

以下のロールを想定したカテゴリです。

Databricks SQL サービスを使用して初歩的なデータ分析タスクを完了する能力を評価します。

データアナリスト アソシエイト / Databricks Certified Data Analyst Associate

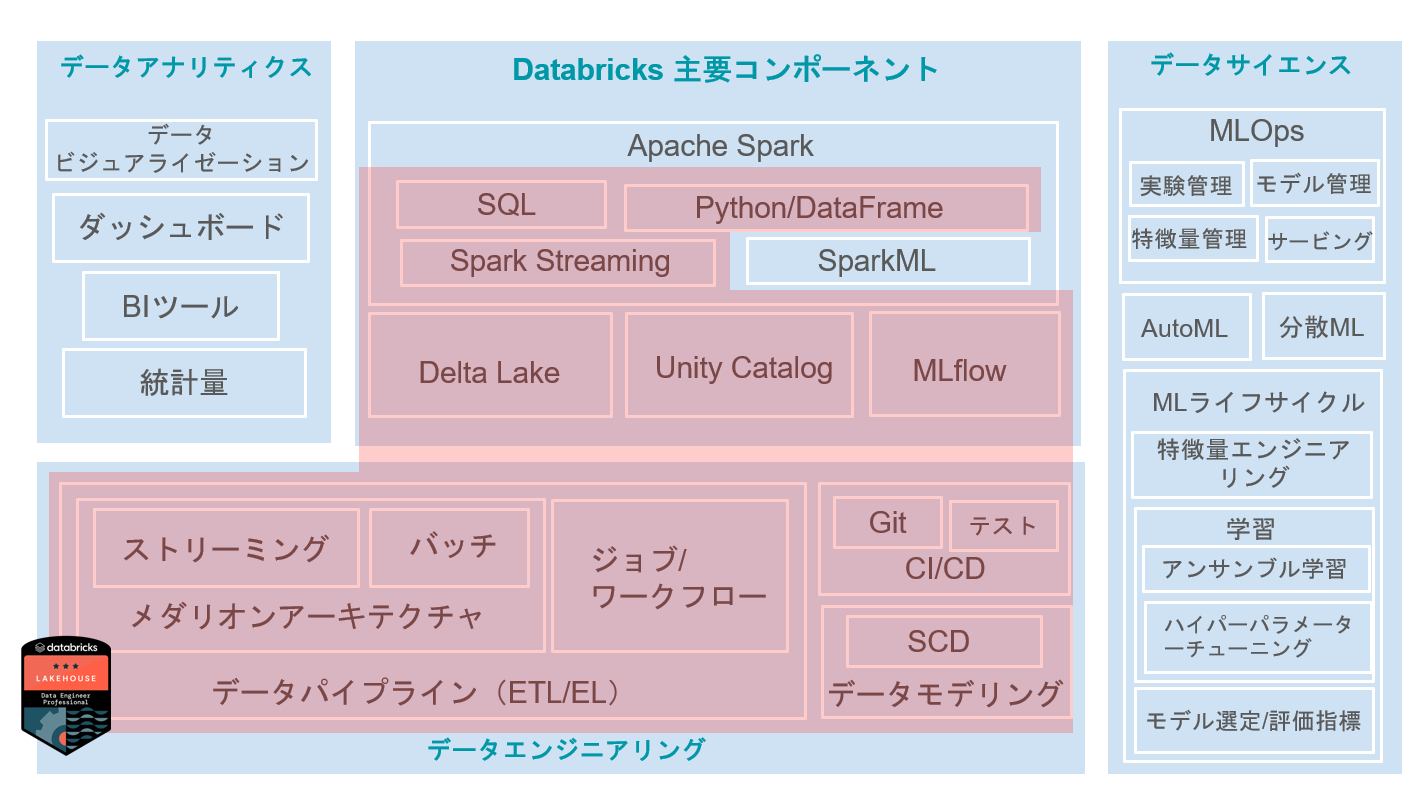

主にSQLを用いたデータ解析やデータビジュアライゼーションに関する知識が問われます。

大まかなカバー範囲は以下の通りです。基礎統計量の理解(平均と中央値の違いなど)、適切なグラフを使ったデータの表現方法やダッシュボードの開発・運用に関する知識が中心です。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★☆☆☆☆ |

| 英文の難易度 | ★★☆☆☆ |

| 学習のしやすさ | ★★★☆☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★★★☆☆ |

| データアナリスト | ★★★★★ |

| データサイエンティスト | ★★☆☆☆ |

| インフラエンジニア | ★★★☆☆ |

SQLに関する問題が多く出るので、事前にデータベース系の資格を持っているとだいぶ楽になると思います。データエンジニア・アソシエイトと重複する領域が多いので、合格された方は受けてみるといいのではないでしょうか。

データサイエンティスト / ML Data Scientist

以下のロールを想定したカテゴリです。

機械学習エンジニアは、Databricks Machine Learning とその機能を使用して、機械学習モデルやパイプラインの開発、デプロイ、テスト、保守を行います。

ML エンジニア アソシエイト / Databricks Certified Machine Learning Associate

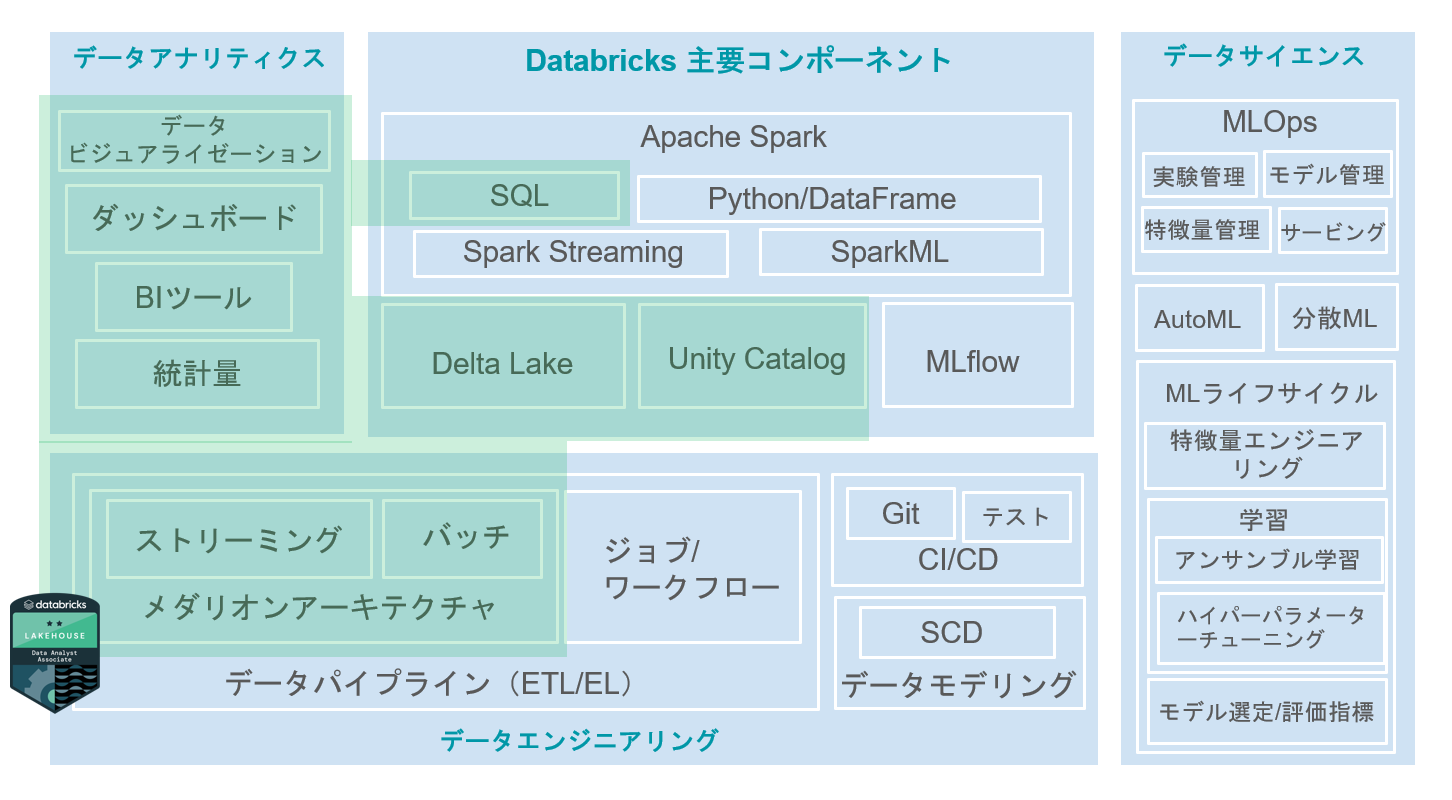

Databricks上で機械学習を行う上での一通りの知識が問われます。特に、MLflowに関するコードレベルの操作がたくさん出題されます。別名MLflow試験と呼ばれているらしい・・・(笑)

大まかなカバー範囲は以下の通りです。Databricks(主にSparkMLとMLflow)を活用して、MLOpsの概念を意識しながら、機械学習ライフサイクルを回すための知識が「実装レベル」の知識が問われます。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★★★☆☆ |

| 英文の難易度 | ★★★★☆ |

| 学習のしやすさ | ★★★☆☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★☆☆☆☆ |

| データアナリスト | ☆☆☆☆☆ |

| データサイエンティスト | ★★★★★ |

| インフラエンジニア | ★☆☆☆☆ |

アンサンブル学習におけるバギングやブースティングの一般的な機械学習アルゴリズムの出題もされます。私はデータエンジニアを専門としているので、この辺りの理解から始めたので時間がかかりました。あとは、トレーニングで提供されるノートブックのコードを1行1行意味を理解することが重要です。

ML エンジニア プロフェッショナル / Databricks Certified Machine Learning Professional

Databricks上で機械学習を行う上での一通りの知識が問われますが、アソシエイトと違って実装レベルではなく、MLOpsなどの概念レベルの出題が多いです。

大まかなカバー範囲は以下の通りです。アソシエイトとほとんど範囲が同じです。概念と実装は表裏一体なので、一度に2つ勉強すると効率がよいです。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★★★☆☆ |

| 英文の難易度 | ★★★☆☆ |

| 学習のしやすさ | ★★★☆☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★★☆☆☆ |

| データアナリスト | ☆☆☆☆☆ |

| データサイエンティスト | ★★★★★ |

| インフラエンジニア | ★★☆☆☆ |

データエンジニア・プロフェッショナルと比較して問題文も短いため受けやすい試験です。また、MLOpsの概念は、データエンジニア、インフラエンジニアにも関係するためぜひチャレンジしていただきたいです。

AWS MLSとの違い

パブリッククラウドの試験にも、機械学習の試験はあります。ここでは、AWS MLSとの違いを記載します。

一般的な機械学習の知識やMLOpsの知識が問われる点は共通です。

AWS MLSは、学習済みモデルのAPI(Amazon Rekognition、Amazon Transcribeなど)を活用したアーキテクチャに関する問題や、IAM や EC2 インタンスなどのややインフラレイヤの知識も問われます。

一方、Databricks の機械学習系の資格は、よりアプリケーション寄りで、SparkML を使った機械学習パイプラインの使い方や MLflow を活用した実験管理、モデル管理などが問われます。

もしかすると、純粋なデータサイエンティストはDatabricksの資格の方が取りやすいのかもしれません。

専門認定

Apache Spark 開発者 / Databricks Certified Associate Developer for Apache Spark

Spark の分散処理の仕組みやデータ処理のコードレベルでの知識を問われます。言語は Python か Scala を選べます。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★★★☆☆ |

| 英文の難易度 | ★★★★☆ |

| 学習のしやすさ | ★★★☆☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★★★★★ |

| データアナリスト | ★★☆☆☆ |

| データサイエンティスト | ★★★☆☆ |

| インフラエンジニア | ★★★☆☆ |

「その他」扱いなのですが、Spark の 仕組みや DataFrameの処理をコードレベルで学習できるよい試験だと個人的には思っています。Databricks 上で Python を扱う人には受けてほしい試験です。

Hadoop マイグレーションアーキテクト / Databricks Certified Hadoop Migration Architect

HadoopのエコシステムからDatabricksにマイグレーションする手法が問われます。

難易度やおすすめ度は以下の通りです。

| 項目 | 評価 |

|---|---|

| 難易度 | |

| 試験の難易度 | ★☆☆☆☆ |

| 英文の難易度 | ★☆☆☆☆ |

| 学習のしやすさ | ★★★★☆ |

| ロール別のおすすめ度 | |

| データエンジニア | ★☆☆☆☆ |

| データアナリスト | ☆☆☆☆☆ |

| データサイエンティスト | ☆☆☆☆☆ |

| インフラエンジニア | ★★★☆☆ |

Hadoopマイグレーションを行うインフラエンジニア向けの試験です。勉強しておいて損はないですが、知識が活きるかは案件次第かなと思います。

ラーニングパス

それでは上記の情報を踏まえて、ロール別にどのように資格を取得していくとよいのか、ラーニングパスとしてまとめてみました。参考になれば幸いです!

データエンジニア向け

Data Engineer Associate からスタートし、Databricksの基本コンポーネント、データエンジニアリングの基礎を理解します。その後、Associate Developer for Apache Spark で Spark の分散処理の理解や DataFrame 操作の習熟度を高めます。

ここまでやれば、おおよそ実案件でもデータパイプラインの設計から構築をできるようになっているのではないでしょうか。

その後、Data Engineer Professional の学習を通じて、リアルタイム処理など、より高度かつ多様なデータパイプラインの知識を身につけます。

Associate Developer for Apache Spark はかなり実装よりの試験であるため、ご自身のロールによっては、スキップしても良いかもしれません。

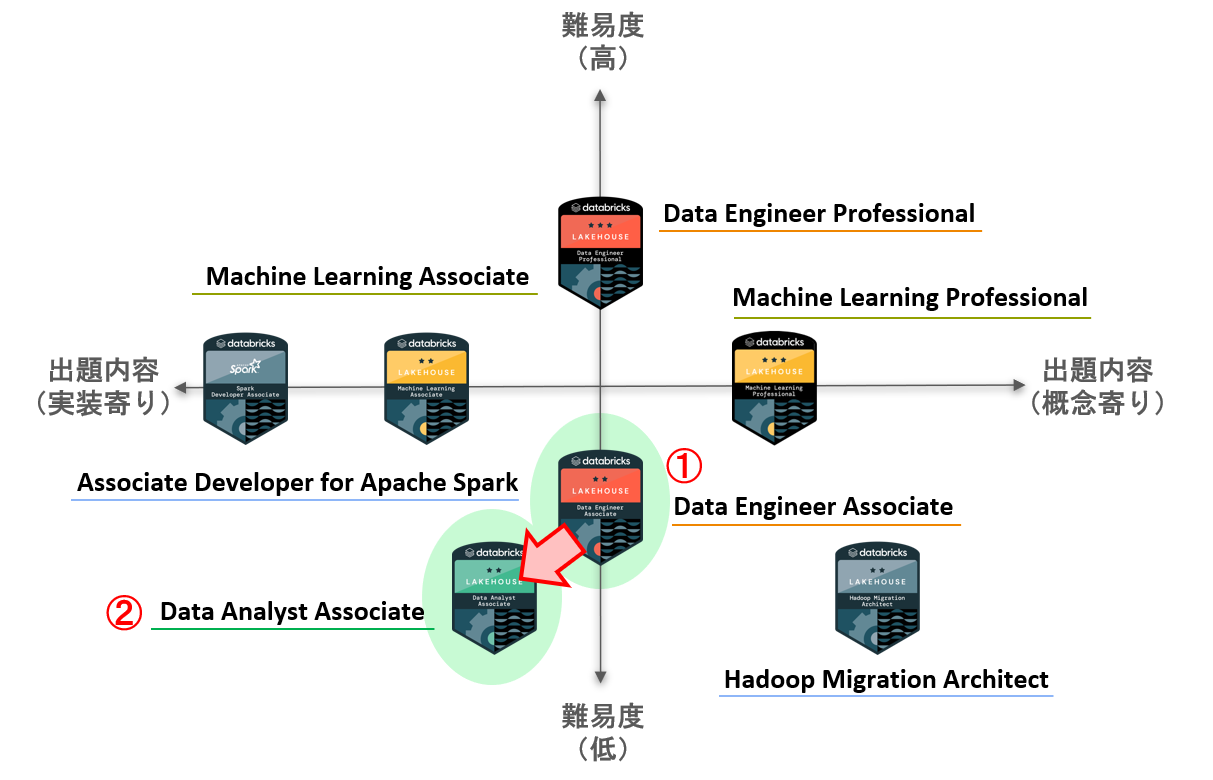

データアナリスト

これは悩みました。「Data Analyst Associate の方が、難易度が低いのになぜ後なのか?」と思った方もいらっしゃると思います。

もちろん、Data Analyst Associate から受けていただいてもいいのですが、学習のしやすいさを考慮すると、Data Engineer Associate から始めた方がスムーズなのではないかと思い、このようなパスにしました。

Data Analyst Associate の試験が日本語化されたり、試験の情報が増えてきたら、Data Analyst Associate を最初に受けても良いと思います。

データサイエンティスト

Data Engineer Associate から始まるのは、データアナリストの項目で述べたとおり、学習のしやすさが理由です。ただ、Machine Learning 系の試験は、SparkML、MLflow、MLOpsがメインであるため、データアナリストほど Data Engineer Associate を経由するメリットは多くないかもしれません。スキップも可能だと思います。

また、Machine Learning の Associate と Professional にあまり難易度の差がないこと、重複した内容が出題されることから、可能であれば、Associate と Professional のトレーニングを一気に受け、同時に試験を受けると効率的だと思います。

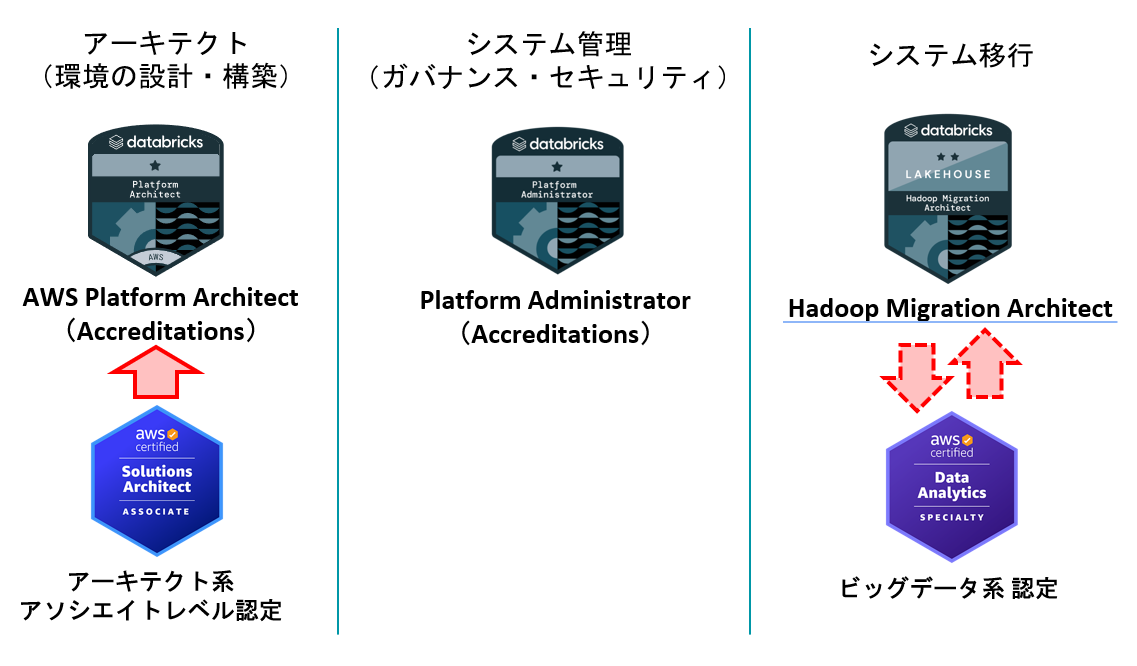

インフラエンジニア

インフラエンジニアは難しいです。資格が「移行」しかありません。よって、Accreditations を含めて考えました。

環境の構築をするのであれば、クラウドでの構築が前提となるため、各パブリッククラウドのアーキテクト系のアソシエイトを取得する必要があります。AWSだと、EC2、S3、VPC、IAM、KMSなどの基礎的なサービスの知識を身につける必要があります。その後、Platform Architect の Accreditations で Databricks における環境の設計・構築の知識を身につけましょう。

環境の管理をするのであれば、Platform Administrator の Accreditations を取得しましょう。Unity Catalog を活用したセキュリティ・ガバナンスの知識を身につけることができます。

Hadoop/Sparkのエコシステムやサービスから環境移行する場合は、Hadoop Migration Architect を受けましょう。Hadoop/Sparkのエコシステムに関する知識を問われるため、パブリッククラウドのビッグデータ系の資格を持っていると有利です。

ただ、上記だけでは正直心許ないので、データエンジニアのラーニングパスも進めることをオススメします。

レイクハウス人材へ

ここまでロール別にラーンングパスを記載しましたが、データエンジニア ⇔ データサイエンティストなど、ぜひ複数のラーニングパスにチャレンジしてください。

データエンジニアとデータサイエンティストは共同で作業するケースが多いですが、実はお互いの業務内容を理解していないケースも多いのではないでしょうか?

Databricks の良さは、データレイクハウスアーキテクチャにより、データを扱う様々なロール(ペルソナ)の人が1つのプラットフォームを使えることだと思うので、資格をきっかけにお互いの理解を深めることができるとより勉強する意味も増すと思います。

ぜひ、データエンジニアリング、データアナリスト、データサイエンス複数のラーニングパスを修了したレイクハウス人材を目指してみてください!

※レイクハウス人材は私の造語で一般用語ではないのでご注意を!

おわりに

いかがでしたでしょうか?

主観が強めでしたが、Databricksの認定試験を体系的にまとめてみました。

みなさまの学習の助けになれば幸いです。(役に立ったら「いいね」していただけますとうれしいです!)

Databricks は、Generative AI Fundamentals という Accreditations や Generative AI Engineer Learning Pathway というラーニングパスとトレーニングも公開しているため、GenAIに関する資格のリリースも時間の問題かなと思います。資格がリリースされたら受けてみようと思います!

Databricks の認定は、データエンジニアリングや機械学習の数少ない実用的な認定だと思いますので、ぜひチャレンジください!!

仲間募集

NTTデータ デザイン&テクノロジーコンサルティング事業本部 では、以下の職種を募集しています。

1. クラウド技術を活用したデータ分析プラットフォームの開発・構築(ITアーキテクト/クラウドエンジニア)

クラウド/プラットフォーム技術の知見に基づき、DWH、BI、ETL領域におけるソリューション開発を推進します。https://enterprise-aiiot.nttdata.com/recruitment/career_sp/cloud_engineer

2. データサイエンス領域(データサイエンティスト/データアナリスト)

データ活用/情報処理/AI/BI/統計学などの情報科学を活用し、よりデータサイエンスの観点から、データ分析プロジェクトのリーダーとしてお客様のDX/デジタルサクセスを推進します。https://enterprise-aiiot.nttdata.com/recruitment/career_sp/datascientist

3.お客様のAI活用の成功を推進するAIサクセスマネージャー

DataRobotをはじめとしたAIソリューションやサービスを使って、 お客様のAIプロジェクトを成功させ、ビジネス価値を創出するための活動を実施し、 お客様内でのAI活用を拡大、NTTデータが提供するAIソリューションの利用継続を推進していただく人材を募集しています。4.DX/デジタルサクセスを推進するデータサイエンティスト《管理職/管理職候補》

データ分析プロジェクトのリーダとして、正確な課題の把握、適切な評価指標の設定、分析計画策定や適切な分析手法や技術の評価・選定といったデータ活用の具現化、高度化を行い分析結果の見える化・お客様の納得感醸成を行うことで、ビジネス成果・価値を出すアクションへとつなげることができるデータサイエンティスト人材を募集しています。ソリューション紹介

Trusted Data Foundationについて

~データ資産を分析活用するための環境をオールインワンで提供するソリューション~https://enterprise-aiiot.nttdata.com/tdf/

最新のクラウド技術を採用して弊社が独自に設計したリファレンスアーキテクチャ(Datalake+DWH+AI/BI)を顧客要件に合わせてカスタマイズして提供します。

可視化、機械学習、DeepLearningなどデータ資産を分析活用するための環境がオールインワンで用意されており、これまでとは別次元の量と質のデータを用いてアジリティ高くDX推進を実現できます。

NTTデータとDatabricksについて

NTTデータは、お客様企業のデジタル変革・DXの成功に向けて、「databricks」のソリューションの提供に加え、情報活用戦略の立案から、AI技術の活用も含めたアナリティクス、分析基盤構築・運用、分析業務のアウトソースまで、ワンストップの支援を提供いたします。TDF-AM(Trusted Data Foundation - Analytics Managed Service)について

~データ活用基盤の段階的な拡張支援(Quick Start) と保守運用のマネジメント(Analytics Managed)をご提供することでお客様のDXを成功に導く、データ活用プラットフォームサービス~https://enterprise-aiiot.nttdata.com/service/tdf/tdf_am

TDF-AMは、データ活用をQuickに始めることができ、データ活用の成熟度に応じて段階的に環境を拡張します。プラットフォームの保守運用はNTTデータが一括で実施し、お客様は成果創出に専念することが可能です。また、日々最新のテクノロジーをキャッチアップし、常に活用しやすい環境を提供します。なお、ご要望に応じて上流のコンサルティングフェーズからAI/BIなどのデータ活用支援に至るまで、End to Endで課題解決に向けて伴走することも可能です。

NTTデータとSnowflakeについて

NTTデータでは、Snowflake Inc.とソリューションパートナー契約を締結し、クラウド・データプラットフォーム「Snowflake」の導入・構築、および活用支援を開始しています。 NTTデータではこれまでも、独自ノウハウに基づき、ビッグデータ・AIなど領域に係る市場競争力のあるさまざまなソリューションパートナーとともにエコシステムを形成し、お客さまのビジネス変革を導いてきました。 Snowflakeは、これら先端テクノロジーとのエコシステムの形成に強みがあり、NTTデータはこれらを組み合わせることでお客さまに最適なインテグレーションをご提供いたします。NTTデータとInformaticaについて

データ連携や処理方式を専門領域として10年以上取り組んできたプロ集団であるNTTデータは、データマネジメント領域でグローバルでの高い評価を得ているInformatica社とパートナーシップを結び、サービス強化を推進しています。NTTデータとTableauについて

ビジュアル分析プラットフォームのTableauと2014年にパートナー契約を締結し、自社の経営ダッシュボード基盤への採用や独自のコンピテンシーセンターの設置などの取り組みを進めてきました。さらに2019年度にはSalesforceとワンストップでのサービスを提供開始するなど、積極的にビジネスを展開しています。これまでPartner of the Year, Japanを4年連続で受賞しており、2021年にはアジア太平洋地域で最もビジネスに貢献したパートナーとして表彰されました。

また、2020年度からは、Tableauを活用したデータ活用促進のコンサルティングや導入サービスの他、AI活用やデータマネジメント整備など、お客さまの企業全体のデータ活用民主化を成功させるためのノウハウ・方法論を体系化した「デジタルサクセス」プログラムを提供開始しています。

NTTデータとAlteryxについて

Alteryxは、業務ユーザーからIT部門まで誰でも使えるセルフサービス分析プラットフォームです。 Alteryx導入の豊富な実績を持つNTTデータは、最高位にあたるAlteryx Premiumパートナーとしてお客さまをご支援します。導入時のプロフェッショナル支援など独自メニューを整備し、特定の業種によらない多くのお客さまに、Alteryxを活用したサービスの強化・拡充を提供します。