はじめに

株式会社NTTデータ Data & Intelligence事業部 の nttd-saitouyun です。

昨年12月の AWS re:Invent 2022 にて、以下の「for Apache Spark」機能が発表されました。

- Amazon Redshift integration for Apache Spark

- Amazon Athena for Apache Spark

Amazon DataZoneなど他にも目玉はあるものの、re:Inventで「for Apache Spark」という名がついた機能が2つも発表されていることには意味があると考え、本記事では、なぜ今「for Apache Spark」なのかについて考察してみました。

「for Apache Spark」について

Apache Spark とは

Apache Sparkは、大規模なデータに対してオンメモリで高速に分散処理を行うオープンソースのフレームワークです。大量データの高速な処理から、機械学習等の分析業務への適用など幅広く利用されています。NTTデータには、Apache Sparkのコントリビューターが多数在籍しています。

以下のような特徴があり、現在においても非常に人気のあるソフトウェアです。

- クラウドによりHadoopクラスタなど分散処理環境を簡単に構築できるようになった。

- データから価値を創出するために、ビッグデータ処理のニーズが増えている。

- PythonやSQLなど様々なAPIで容易に利用できる。

AWSにおける Apache Spark

分析、機械学習サービスを中心として、多くのサービスでApache Sparkが利用できます。細かい点には触れませんが、概要を記載します。

AWS Glue

AWS Glueは、サーバレスのETLサービスです。大規模データの処理に、Apache Sparkの処理をサーバレスに実行することができます。

Amazon EMR

Amazon EMRは、Apache SparkやApache Hiveなどの分散処理環境を簡単に構築できるサービスです。Apache Sparkのクラスタをクラウド環境に容易に構築することができます。

Amazon SageMaker

Amazon SageMakerは、機械学習モデル構築の様々な機能を提供するサービスです。Apache Sparkを使ったデータ処理の結果を使って、機械学習モデルの作成ができます。また、Spark ML(Apache Sparkの機械学習ライブラリ)を使って構築した機械学習モデルのサービングも可能です。

Amazon Ahtena [NEW]

Amazon Athenaは、Amazon S3で構築されたデータレイクや様々なデータソース上にある大規模データに対して、サーバレスにインタラクティブにクエリを実行できるサービスです。

re:Invent 2022にて、Amazon Athena for Apache Sparkという機能が発表され、SQL以外にPythonによる処理が実施可能になりました。

以前は、SQLを使用してAmazon S3の大規模データをクエリするサービスだったので、進歩が著しいです。

Amazon Redshift [NEW]

Amazon Redshiftは、データウェアハウスサービスです。

re:Invent 2022にて、Amazon Redshift Integration for Apache Sparkという機能が発表され、上述した、Amazon EMR、AWS Glue、Amazon SageMakerのSparkの処理からRedshift上のデータを読み書きを容易に実施できるようになりました。(これまでは3rd Party製のコネクタが必要でした。)

Databricks on AWS

AWS上でApache Sparkを利用する選択肢として、これまで紹介したAWSマネージドサービス以外に、Databricksがあります。

Databricksとは、Apache Sparkの創始者であるマテイ・ザハリア氏と共に、アリ・ゴディシ氏が立ち上げた会社です。「AIとデータの民主化」をミッションとしています。Apache Spark、MLflow、Delta LakeといったOSSを組み合わせた、統合データ分析プラットフォームを提供しています。

なぜ 「for Apache Spark」なのか

では、なぜ今「for Apache Spark」なのかについて考察していきます。

SQL「+ Python」

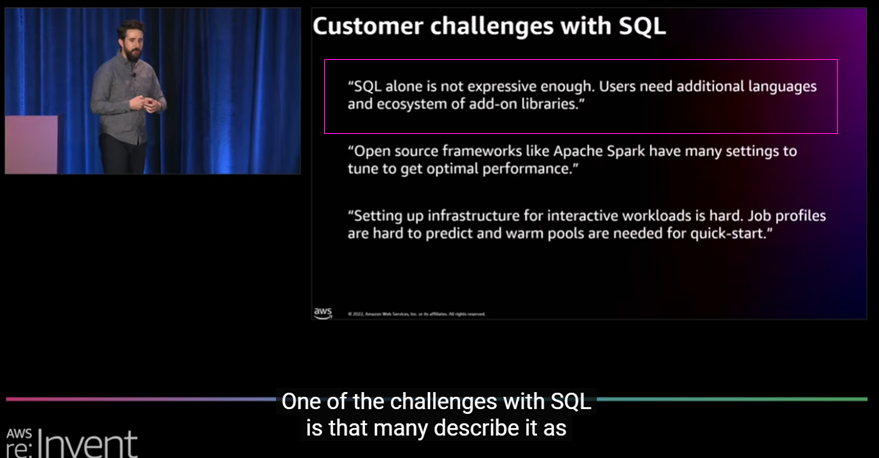

この疑問を持ちながら、re:Inventのセッションを回っていたところ、Athenaの新機能セッションで1つの解が示されていました。それは、「SQLだけでは複雑な処理を表現しきれない」ことです。

※キャプチャはAWS re:Invent 2022 - What’s new in Amazon Athena (ANT208)より取得

これは、SQLが不要になるといっているわけではなく、状況によっては物足りないケースが増えてきているということを表しています。例えば、

- 処理対象のデータが構造化データから準構造化データ・非構造化データまで広がっている。

- データ処理にAPI(例えば、Amazon SageMakerによる推論処理)を呼び出したり、データ加工処理内容が高度化している。

- 特徴量エンジニアリング(機械学習の前処理)などSQLでは実施が難しいデータ加工処理が増えている。

などがあると思います。

この課題に対して、外部ライブラリなども利用でき、より豊富なAPIがあるPythonが使われています。

Pythonのケイパビリティを大規模データ処理に適用するために、Apache Sparkが利用されているようです。

スケーラブルPythonの種類

Pythonのケイパビリティを大規模データ処理にApache Sparkが使われると言いましたが、他のソフトウェアではできないのでしょうか?

あります。それが「Ray」です。

そして、同じくre:Inventで、AWS Glue for Rayの発表がありました。

そして、re:Inventから数か月後、DatabricksからもRayの対応が発表されました。

Announcing Ray support on Databricks and Apache Spark Clusters

一般的には、データ処理のワークロードではApache Sparkが強く、機械学習のワークロードではRayが強いと言われています。

DWHサービスの傾向

上記の説明によって、Amazon AthenaやAmazon Redshiftの「for Apache Spark」対応の説明はできそうです。

では、他のDWHサービスはどうでしょうか?

GCPでは、BigQueryにApache Sparkを統合したBigLakeが2022年4月に発表されています。

また、Snowflakeでは、SnowparkというPythonをはじめとするSQL以外の言語でデータ処理や機械学習が可能なAPIを2021年に公開しています。

これらのように、AWS以外でも同じような傾向があることが分かります。

多様化するデータの種類や機械学習などのユースケースの多様化に合わせて、DWHサービスはこれまでデータレイクサービスが得意としていた機能を取り込む形で進化しているのではないかと思います。

データレイクサービスの傾向

では、反対にAWS GlueやAmazon EMRなどのデータレイクサービスにはどのような傾向があるのでしょうか?

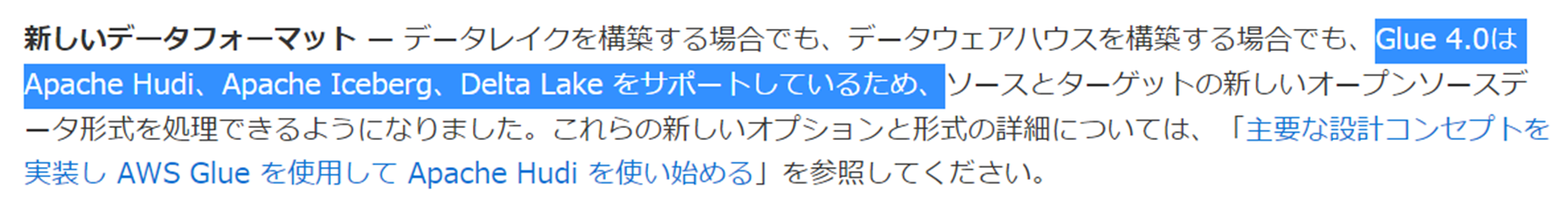

同じくre:Inventで発表されたGlue 4.0では、Apache Hudi、Apache Iceberg、Delta Lake などのACIDトランザクションやタイムトラベル機能をサポートするストレージフォーマットへの対応が行われています。

EMRにおいても最新のランタイム6.9.0において、同様のストレージフォーマットがサポートされています。

- Amazon EMR 6.8 が Apache Hudi 0.11.1 および Apache Iceberg 0.14.0 をサポート

- Delta Lake - Amazon EMR: Amazon EMR リリース 6.9.0 以降、デルタレイクテーブルを含む Amazon EMR クラスターで Apache Spark 3.x を使用できます。

さらに、Athenaも、Athena ACID トランザクションの使用を確認すると同様であることがわかります。

そもそも、これらのストレージフォーマットの対応以前では、Lake FormationのGoverned tablesがこれらのACIDトランザクションやタイムトラベル機能を実現していました。

以上のように、データレイクサービスは、ACIDトランザクションやタイムトラベルといったDWHサービスが持っている機能を取り込む形で進化しているようにみえます。

データエンジニアリングのトレンド

「for Apache Spark」を出発点に様々なサービスのアップデート内容を考察してきました。

ここまでみてきた通り、DWHサービスとデータレイクサービスは互いに足りない機能を補うように機能拡張しているように見えます。今後、これらのサービスはどのように進化していくのでしょうか?

DWH + データレイク = データレイクハウス

1つの解として考えられるのが、「データレイクハウス」です。

データレイクハウスは、Databricks社が提唱したDWHとデータレイクの良いところ採りをした新しいデータ基盤プラットフォームの考え方です。データレイクとデータウェアハウスの造語です。

この考え方は、AWSなど他社にまで広がっており、Gartner Hype Cycle for Data Managementにもキーワードとして扱われています。

このデータレイクハウスアーキテクチャのように、多種多様で様々な規模のデータの処理や、アナリティクスやビジネスインテリジェンスから機械学習といった様々なユースケースに対応できるようなケイパビリティを持ったデータ基盤がトレンドとなっているのではないでしょうか。

データレイクハスに関する参考情報

よりデータレイクハウスを詳しく知りたい方向けに参考情報を記載します。

データウェアハウスの父と称されるビル・インモン(Bill Inmon)氏による著書が出版されています。(権威のある情報源ですが、難しくもあります。)

- Building the Data Lakehouse

- The Data Lakehouse Architecture

- Rise of the Data Lakehouse

AWS においてもレイクハウスについて、次のような情報が公開されています。

筆者もデータレイクハウスに関する解説記事を記載しています。興味があればご覧ください。

より洗練されたデータレイクハウスへ

データレイクハウスアーキテクチャは、これまでもDWHサービスとデータレイクサービスを組み合わせることで実現できました。例えば、R Amazon RedshiftとAWS Glueを併用するケースです。このアーキテクチャでも幅広いデータ処理や分析ユースケースに対応することができますが、両サービス間のデータの移動コストやガバナンス・セキュリティをそれぞれのサービスで実現しなければならないなど、課題も残ります。

この課題を解決するために、Amazon Athena for Apache Sparkのように1つのサービスでレイクハウスを実現できるようになったり、Amazon Redshift integration for Apache SparkのようにデータレイクとDWHの継ぎ目を減らすような機能アップデートがなされているのではないでしょうか。

おわりに

いかがでしたでしょうか?

「for Apache Spark」を出発点に、re:Inventで発表されたアナリティクスサービスの様々なアップデートに触れて、その裏にあるトレンドを考察してみました。 そして、トレンドの1つであるデータレイクハウスについて紹介を行いました。

データエンジニアリング領域は、技術進歩が激しい領域なので、今後も各サービスのアップデートからは目が離せません!

トレンドを知り、新機能を有効に活用して、データをより価値あるものにしていきましょう!!

仲間募集中!

NTTデータ Data&Intelligence事業部 では、以下の職種を募集しています。

1. 「クラウド技術を活用したデータ分析プラットフォームの開発・構築(ITアーキテクト/クラウドエンジニア)」の募集

クラウド/プラットフォーム技術の知見に基づき、ITアーキテクトまたはPMとして、DWH、BI、ETL領域における、ソリューション開発の推進や、コンサルティング工程のシステムグランドデザイン策定時におけるアーキテクト観点からの検討を行う人材を募集しています。2. AI/データ活用を実践する「クラウド・ソリューションアーキテクト」の募集

AI/データ活用を実践する「クラウド・ソリューションアーキテクト」として、クラウド先進テクノロジーを積極活用し、お客様のビジネス価値創出活動を実践。AI/データ活用の基本構想立案コンサルティングからクラウドプラットフォーム提供・活用を支援しています。お客様のAI・データ活用を支援するクラウド・ソリューション提案、アーキテクチャ設計・構築・継続活用支援(フルマネージドサービス提供)、および最新クラウドサービスに関する調査・検証で、クラウド分析基盤ソリューションのメニュー拡充を実施する人材を募集します。また、取り扱う主なソリューションについては、以下のページも参照ください。