こんにちは。AIアシスタント Advent Calendar 2018の7日目を担当します、里山と申します。

普段はビデオマーケットという会社でVODサービスの事業責任者とVP of Engineeringをしています。

ひとつ言わせてください。

「このカレンダー、過疎ってないか?」

AIアシスタントの幕開けたばかりの今、個々の情熱で業界を盛り上げましょう!

まだまだ空いている日があるので、是非どなたか書いていただけると嬉しいです。

Googleアシスタントの特徴は「多様なデバイス形態」

Googleアシスタントの大きな特徴のひとつは、様々なデバイスで利用できることが挙げられます。

Androidアプリ/iOSアプリ/Android TV/Google Home(スマートスピーカー)/Google Home Hub(スマートディスプレイ)などなど、導入されているデバイスは多種多様です。今年5月のGoogle I/Oでは、5億台のデバイスに搭載されているとの発表がありました。

アシスタントアプリの開発者目線で考えると、デバイスの種類が増えるとそれにともなって様々なレスポンスの形を考える必要があります。例えば、Google Homeには画面はありませんが、スマホやTV、スマートディスプレイには画面があります。また、マナーを要する場では画面は利用できても音声を利用できない場面もあるでしょう。ユーザの様々な要求に対応するのがAIアシスタントであるならば、ユーザの利用文脈に沿ったレスポンスの形を提供できなければなりません。

ユーザ文脈に沿ったレスポンスを提供するための、Googleによるひとつの回答が「マルチモーダル」という考え方です。

Google I/Oで発表された内容をおさらいしてみます。

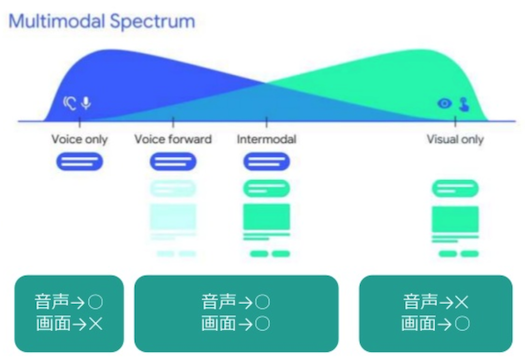

MultiModal Spectrum

これはGoogle I/O 2018で発表された、Googleアシスタントのためのデザインフレームワークです。

インタラクションに基づいてデバイスを分類するのに役立ちます。

例えば上記の図ですと、

片側の端にはGoogle Homeのような聞いたり話したりする必要がある音声専用デバイスがあり、「Voice-only devices」と呼ばれます。もう片側の端には音声をミュートしたPCやスマホ、スマートウォッチのような音声が利用できない、見たりタッチしたりする必要のある画面専用デバイスがあり、「Visual only devices」と呼ばれます。

そしてその間にあるのが、Googleがマルチモーダルデバイスと呼んでいるものです。

カーナビやスマートディスプレイは、画面がありますが、音声優先の利用用途のデバイスで、「Voice forward devices」と呼ばれます。ミュートしていないスマホやPCは、スマホや画面をミックスして利用することが想定されるデバイスで、「Intermodal devices」と呼ばれます。

| 用途 | 呼び方 | デバイス |

|---|---|---|

| 音声専用 | Voice-only devices | Google Homeなど |

| 画面専用 | Visual only devices | ミュートしたPCやスマートディスプレイ、ウォッチ |

| 音声優先 | Voice forward devices | カーナビやスマートディスプレイ |

| 混合利用 | Intermodal devices | スマホやPC |

音声は、会話形式の入力としてはとても自然で、ITの知識も必要なく、どのような年齢層でも利用できる利点があります。一方で、お店でメニューを見るような場合、メニューのすべてを音声で聞いて頭で覚えておき、それから選ぶのは大変です。目で「スキャン」したほうが自然な行動でしょう。音声と画面は文脈にあわせて、返し方を比較する必要性があります。

Googleアシスタントのレスポンス構成

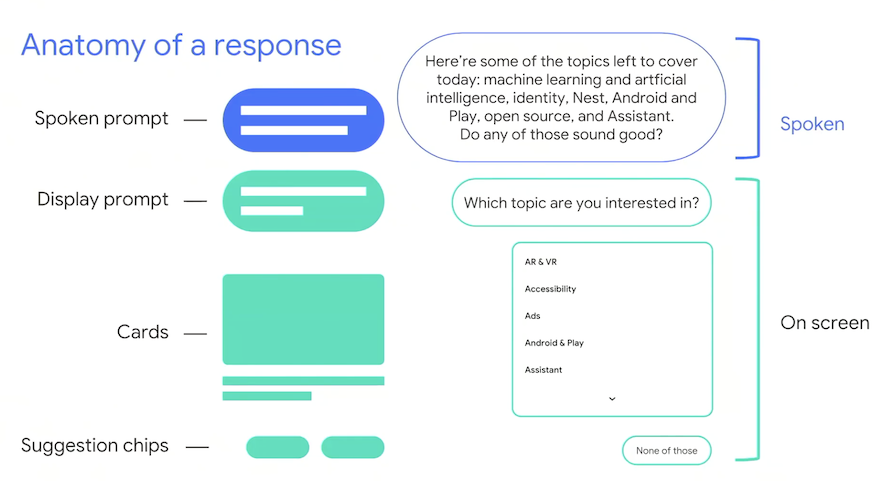

こちらもGoogle I/Oからですが、Googleアシスタントのレスポンス構成は以下のように分離されます。

ユーザの文脈に合わせて自然な会話にしていくためには、会話のターン毎に、Visual Componentを含むすべての方法を検討する必要があります。例えば、prompt、cards, suggestion chipsなどです。例えば、上記の例ですと、Spoken promptですべて話しているトピックを画面上ではリストで表示し、何も興味ない場合はsuggestion chipsに誘導しています。

その後、Multimodal Spectrumのデバイス分類に合わせてマッピングしていきます。

以上、Googleの「マルチモーダル」の考え方を整理してみました。

上記のようにしてデバイスごとの体験を考えていくと、割と抜けなく、有意義に会話のレスポンス設計ができる気がしています。

表示制御自体は、以下のように、音声と画面の利用可否などで判断します。

Actions on Googleでは、Surface Capabilitiesで確認します。以下がサポートされているかを確認すると良いでしょう。

(当たり前のことなので割愛します。)

・actions.capability.AUDIO_OUTPUT

・actions.capability.SCREEN_OUTPUT

最近のレスポンスまわりの変更点や気づいたところ

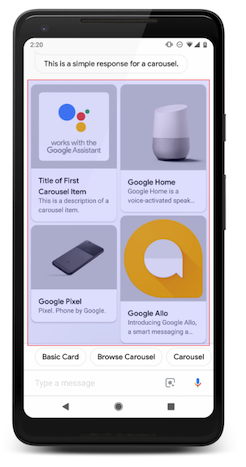

スマホでCarouselがタイルの縦並びに

最近コミュニティでの会話の中で知ってびっくりしたのですが、RichResponseの「Carousel」が、タイル型で縦に並ぶようなUIに変更されていました。Actions on GoogleのResponsesのページでも以下の画像に差し替わっていました。

Carouselって水平方向スクロールするものという概念が覆されたんですが、これもCarouselと呼んで良いのでしょうか?

また、説明書きのところには以下の文言も書いています。

While they are visually compelling, carousels are limited in their utility in a multimodal interface. This is because they are hard to interact with as a voice interface (for that, we favor lists). Refer to the guidelines section of the carousels to learn more.

視覚的には魅力的ですが、カルーセルはマルチモーダルインターフェイスでの使用には限界があり、これは、音声インターフェイスとしての相互作用が難しいためだそうです。

先程まで展開してきたマルチモーダルの考え方で言うと、おそらく、画面に表示されるアイテムの数が少ないため「Voice-forward」端末などでは、タッチの回数が増えるなど、利用が難しいのではないかと考えられます。

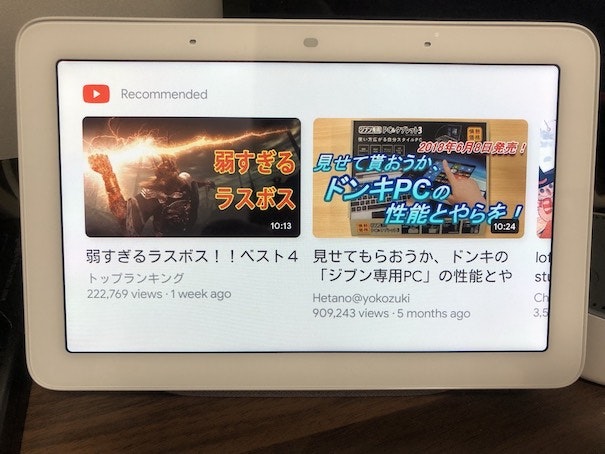

スマートディスプレイでは水平方向のCarousel

シミュレータのスマートディスプレイSurfaceでCarouselを動かしてみました。

スマートディスプレイ上では、Carouselは水平方向表示のままです。

そもそも上下のスクロールが想定されていないようにも感じます。

スマートディスプレイではDisplay promptが表示されない

Google I/OのYouTubeを見て気づいたのですが、スマートディスプレイではDisplay promptの表示が想定されていないようです。

これもシミュレータ上で試してみました。

スマホでは、以下のように、「Listを表示します」という、SimpleResponseのテキストが表示されていることがわかります。

しかし、スマートディスプレイモードでは、表示されていないことがわかります。

このあたりも、マルチモーダルの考え方を明確にする意図を感じます。

おわび

ブログを書く前は、スマートディスプレイの実機検証をしようと考えていましたが、業務多忙につき、検証までにはいたらず、机上の話の展開になってしまいましたことをお詫びします。。。

Google Home Hubを手に入れたのですが、現状は、日本語の呼びかけはできず、英語のみとなっています。しかしながら、YouTubeなどを見ると、日本語の表示自体には対応していて、なかなか楽しく使っております。

ちなみに、これもCarouselですね。気づいたのですが「OK Google, Next.」で触らずにスライドできます。

最後に

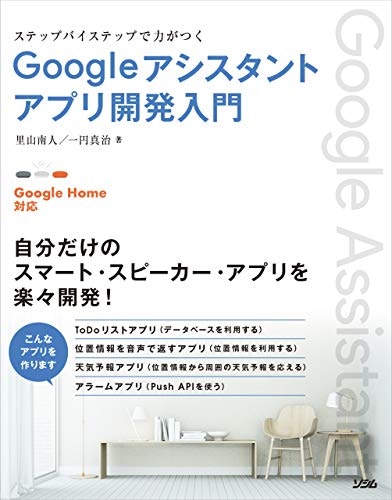

9月にヤフーの一円くんと共著でGoogleアシスタントの入門書を出版しました。

初心者〜中級者に向けて丁寧に解説していますので、気になった方は是非お手にとってみてください!