2023年7月9日から14日にかけて、トロントで開催されたACL2023 (The 61st Annual Meeting of the Association for Computational Linguistics) に聴講参加しました。

今回は、自然言語処理に関する最先端の研究動向を調査する目的と、他の研究者の方とのネットワーキングを目的に、初めてACLを現地で聴講することとなりました。せっかく現地参加する機会に恵まれましたので、現地での雰囲気や印象も交えながら会議について紹介したいと思います。

ACLとは

計算言語学会(Association for Computational Linguistics)の名を冠する国際会議で、計算言語学・自然言語処理分野におけるトップカンファレンスとして知られており、毎年開催されています。新型コロナウイルスのパンデミック以降、ACLでもバーチャル開催のみの形式で会議が開催されていましたが、昨年のACL2022からオンサイトとバーチャルのハイブリッドで参加ができるようになりました。ハイブリッド形式の会議は、今年で2回目となります。

ACL2023の概要

投稿論文の傾向と所感

※詳細はProgram Chairs’ Report on Peer Review at ACL 2023をご覧ください。

投稿件数は4,559件(昨年度3,378件)となり、過去最多の投稿件数だったそうです。そのうちMain trackへの採択率は20.73%(昨年度20.75%)とのことでした。これに加え、査読プールへの投稿・レビューを介したACL Rolling Review(ARR)と呼ばれる仕組みによる投稿も305件あり、計4,864件の論文が投稿されたことになります。

投稿件数は昨年度と比べ1,000件近くの増加傾向が見られ、現地会場も会期中は常に盛況でした。会期中は6つのOralセッションと80件近くのIn-Person Posterセッションが同時並行で流れており、どのセッション会場でどんな発表が行われているのか見当がつかないくらい大規模なものでした。ちなみに、現地で配布されたプログラム一覧も百科事典並みに分厚かったです。

ARRでの投稿分を除いた分野別の投稿数とその割合について、ACL2023にて特に投稿が多い分野は以下の通りでした(全体4,559件)。

- NLP Applications 354件 (7.8%)

- Machine Learning for NLP 313件 (6.9%)

- Information Extraction 279件 (6.1%)

- Dialogue and Interactive Systems 269件 (5.9%)

- Large Language Models 252件 (5.5%)

今年からLarge Language Modelsのセッションが新設され、会場でも常に多くの人が聴講に集まっており、LLMブームをひしひしと感じました。また、昨年のACL2022にて最も投稿割合が大きかった分野はMachine Learning for NLP(12.6%)、次点でInformation Extraction(8.8%)という傾向でしたが、ACL2023ではこれらを差し置いてNLP Applicationに投稿が集まったようです。会場を回った印象としても、ヘルスケアや語学学習のためのNLPといった、様々な分野への応用を見据えた発表をよく目にした気がします。

TransformerやLLMといった手法・モデルが計算機で言語を処理するデファクトスタンダードとなった今、これらモデルの出力の制御や解釈、様々なドメインやタスクに対してどのように活用していくのか、といった点に研究のメインストリームが移りつつあるのではという印象を抱きました。

印象に残ったチュートリアル

ACL2023では計6本のチュートリアルが開催されていましたが、今回は Akari Asai, Sewon Min, Zexuan Zhong, Danqi Chen のチュートリアル “Retrieval-based Language Models and Applications” について紹介します。

ChatGPTに代表されるLLMは、学習する過程で様々な情報をパラメータに落とし込んでいます。しかし、そのパラメータ量ゆえに計算コストが非常に大きい点や、最新の情報を取り入れることができない点、事実に反する出力(Hallucination)をする可能性がある点、などの課題があります。このチュートリアルでは、これらの課題を解決する1つの方法として、外部知識や文書を参照することでLLM内部にエンコードされていない知識を補うことのできるRetrieval-based LMs(検索ベースの言語モデル)について取り上げ、基礎的な部分から最新の学習・応用研究の事例まで網羅的に紹介されていました。

LLMはその性能の高さや人間らしい文章が生成できる点から私も非常に興味を持っている一方で、上記のような課題がネックで使いづらいなあという印象も抱いていました。このチュートリアルで紹介されていた研究事例は、LLMの使いづらさを緩和して実応用に繋げるための手がかりになると思いました。

余談ですが、このチュートリアルは非常に多くの聴講者が集まり、会場はほぼ満席の状態だったのですが、不具合のためか空調が効いておらず、色々な意味で熱気を帯びたチュートリアルでした(代わりに、業務用の巨大なサーキュレータが用意されていました)。

本会議

基調講演

ACL2023では2件の基調講演が行われました。

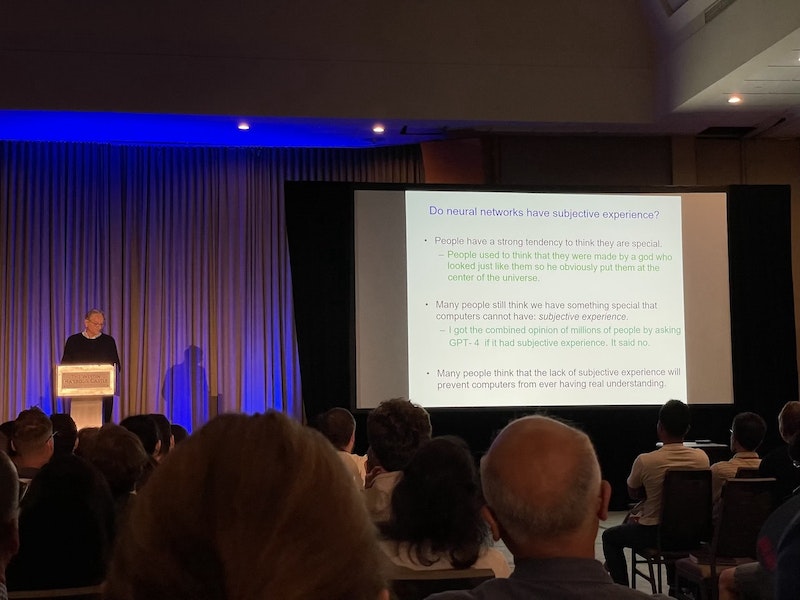

そのうちの1件は、深層学習の生みの親とも言えるGeoffrey Hintonの基調講演でした。朝一番、かつ最もキャパシティのある会場での公演だったのですが早々に席が埋まり、注目度の高さが伺えました。

内容としては、ニューラルネットワーク言語モデルによる言語理解とその歴史について、生物学的な知性とデジタルな知性との違いについて、マルチモーダルLLMが(人間と同じように)主観的な経験をすることができるのかについて、の3点について取り上げていました。全体を通じて「人間のように、LLMも言語・知識を理解しているのではないか?」「理解は人間固有のものではないのではないか?」ということを提言している公演であったと私は解釈しました。

質疑応答では多くの研究者がマイクに殺到し、「言語を理解することとはそもそも何か?」「LLMには無く、人間のみが持つ特性があるのではないか?」などといった、個人的にはACLらしさを感じる質問が数多く寄せられ、議論が行われていた点が印象に残りました。

印象に残った口頭・ポスター発表

会期中は主に私の興味領域(情報抽出・機械学習手法・解釈性)に関連しそうなセッション・ポスター発表を聴講していました。その中で、個人的に気になった・面白いと思った研究を順不同で紹介します。まだまだ追いきれていないので、他にも面白い研究があればコメントで教えていただけますと嬉しいです。

Efficient Long-Text Understanding with Short-Text Models(Maor Ivgiら)

エンコーダ・デコーダの構造を持つ言語モデルで長いテキストを処理する手法を提案した研究。入力のトークン列を、ある程度の長さのチャンクで区切ったものをそれぞれエンコードし、デコード時には各チャンクのエンコード結果を1つにまとめものをデコーダに入力する。簡単な実装で既存のBARTやT5の性能が向上。

Are Layout-Infused Language Models Robust to Layout Distribution Shifts? A Case Study with Scientific Documents(Catherine Chenら)

LayoutLM等の文書のレイアウト情報を考慮できる言語モデルが、学習データに含まれないレイアウトで作られた文書に対してどれほど頑健なのかを調査した研究。レイアウト情報を考慮しない言語モデルよりも、レイアウト情報を考慮できる言語モデルは未知のレイアウト文書に対して性能が低いことが示され、学習データに含まれるレイアウト情報に過剰適合している可能性が示唆された。一方、10件の未知のレイアウト文書を用いて言語モデルをfine-tuningすると、性能が大きく改善することも示された。

Incorporating Attribution Importance for Improving Faithfulness Metrics(Zhixue Zhaoら)

モデルに入力された各トークンの重要度(Attentionスコア、勾配、など)に基づいてトークンの埋め込みをマスクし、モデルの振る舞いを解釈する手法を提案した研究。入力系列から重要なトークンを保持・削除した際の振る舞いを観測する手法と比べて、ストップワード等のトークンに重要度が大きく付与されてしまった場合にも影響を緩和することができる、保持・削除するトークンの個数を事前定義する必要がない、といったメリットがある。

Learning to Imagine: Visually-Augmented Natural Language Generation(Tianyi Tangら)

エンコーダ・デコーダの構造を持つ言語モデルにて、合成画像を活用することでテキスト生成の性能が向上することを検証した研究。入力テキストのエンコード結果と、入力テキストを基にStable Diffusionで合成した画像視覚情報をクロスアテンションで組み合わせた表現からデコードを行う手法を提案。事前学習時には、クロスアテンション以外のパラメータを凍結し、画像を基にノイズを含むキャプションを復元するタスクから重みを学習している。

蛇足ですが、同僚が同じような発想から取り組んだ検証がありますので、もし興味があればこちらもご覧ください。

MM-SHAP: A Performance-agnostic Metric for Measuring Multimodal Contributions in Vision and Language Models & Tasks(Letitia Parcalabescuら)

マルチモーダルモデルにデータを入力した時、どのモダリティがモデルの予測に寄与しているのかを表す指標を提案した研究。モダリティ別の寄与度を求める既存手法では、入力データからあるモダリティの情報を削除した時のモデルの振る舞いを観測することで、モダリティ毎の寄与度を求めているが、モデルが誤った予測をした場合にモダリティの寄与度がゼロとなってしまう問題がある。MM-SHAPでは、モダリティ毎に入力のシャープレイ値とその絶対値の総和を求め、その相対的な割合を各モーダルの寄与度とすることで上記の問題を解決した。

印象に残ったワークショップ

今回は、”The 1st Workshop on Matching From Unstructured and Structured Data (MATCHING)” に参加しました。このワークショップは、2つの異なるデータ集合から共通する項目を見つけ出すタスクに着目しています。

聴講した中でも、Pegah Jandaghi, Jay PujaraのIdentifying Quantifiably Verifiable Statements from Textの発表が気になったので少し紹介します。この研究は、テキスト中の数値に関する関係性を信頼できるデータソースと比較・検証する、というタスクを提案しています。例えば、「欧州のガス需要は2015年以降増加しているが、その主な理由はオランダの生産量の減少である」という文章に対して、ガスの消費量に関する表データから「欧州のガス需要の増加」の正誤を検証する、ガスの生産量に関する表データから「オランダの生産量の減少」の正誤を検証する、といった具合です。まだ取り組み始めたばかりの研究のようでしたが、実利につながるようなタスク設定にとても興味を持ちました。続報が楽しみです。

現地の雰囲気

Oral presentation会場の様子です。人気のセッションでは席に座れず、床に座って聴講している人も多く見受けられました。

Welcome receptionでは、国内外で活躍している多くの日本人研究者の方たちとお話しすることができました。論文や学会・研究会の運営委員で名前をよく見かける方々と直接お会いできたのが個人的にはACL2023のハイライトです。

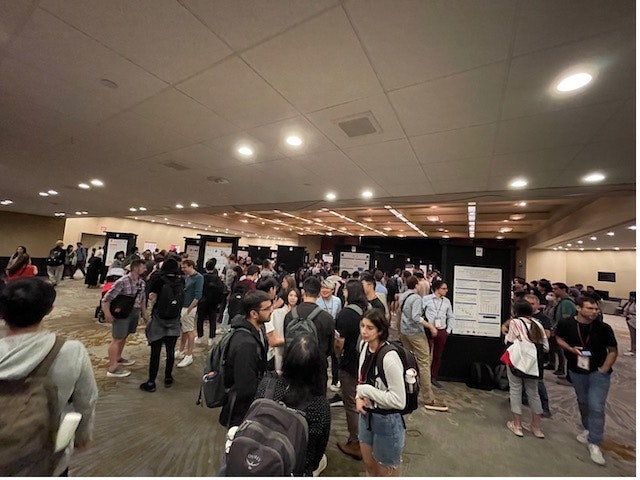

Poster Session会場には会期中常に多くの人が集まっていました。ポスターの件数も多く、目当ての発表を探し出すのも一苦労でした。

ACL2023の現地参加者にはCNタワーもしくはRipley's Aquarium of Canadaのチケットが配られました。スキマ時間でCNタワーに上りましたが、展望台から眺めるトロントの高層ビル群やオンタリオ湖はとても綺麗でした。

おわりに

参加する前は、言葉の壁や知り合いがいない孤独感からあれこれ色々心配していましたが、いざ始まるとあっという間に過ぎ去っていった一週間でした。現地参加できたことで、学会のお祭りのような雰囲気や、他の研究者との活発なディスカッション・コミュニケーションを楽しむことができ、非常に良い機会に恵まれました。バーチャルでの聴講は移動の負担がなく、出張と比べると気軽に参加ができて良いのですが、やはり現地参加ならではの良さ・楽しさがあることを改めて実感しました。

国内外の様々な方との交流を経て、私自身も大きく刺激を受けました。今回のACL2023で仲良くしてくださった皆さんへのお礼と、今回の経験を糧に今後も精進して参りますという抱負をもって、レポートを締めたいと思います。