私が所属するAiritech株式会社のSynthetic Monitoring サービスでは、ElasticsearchのMachine LearningとWatcher機能を利用して、Webサイトの性能改善、劣化の自動検知及び通知を実現しています。

通知の設定は、Wathcerを使い実現するのですが、今のElasticsearchのVersionで実現するにはかなり大変です。

そこで、通知を管理できるKibanaプラグインを開発してOSSとして公開しました。

今日はその「es-ml-alert-plugin」を紹介します。

X-Pack Machine Learning及びWatcherとは

本題に入る前に、X-Pack Machine Learning(以下X-Pack ML)とWatcherの紹介です。

X-Pack MLは、Elasticsearch上で動作する有償のプラグインで、機械学習による時系列データの異常値検知機能を提供するものです。

最大の売りは、機械学習の知識がなくても、異常検知が使えます!という点で、UIから設定するだけで、異常検知が利用できます。

※参考

・X-Pack ML紹介ブログ ・X-Pack ML紹介動画

WatcherもElasticsearch上で動作する有償のプラグインの一つです。定期的にElasticsearchにクエリを行い、結果に応じて通知することが可能になります。

以下の動画が使い方を詳しく教えてくれます。

・Watcherの使い方1

・Watcherの使い方2

・Watcherの使い方3

・・・結構、大変な作業だと思ってもらえるかと思います。

6.xからはKibanaのUIもサポートされたので、閾値超過のジョブ設定は楽になりました。

が、X-Pack Machine Learning用のアラートを書こうかと思うと、まだまだ難しい。

そこで、プラグインの出番です。

es-ml-alert-pluginはどんな時に使うOSSなのか?

以下のユースケースで便利に使えるOSSです。

- X-Pack Machine Learningのリアルタイム異常値検知機能を使って、解析したい

- 異常を検知したら、リアルタイムに通知を飛ばしたい

メールとかSlackで通知! - 通知内容に、ML JobやDashboardへのリンクURLを入れて、解析をスムーズに行えるようにしたい

ちなみに自前で設定を作成すると、以下のような設定を作ることとなります。

X-Pack Watcherによる異常検知アラート設定

{

"trigger": {

"schedule": {

"cron": "0 * * * * ?"

}

},

"input": {

"search": {

"request": {

"search_type": "query_then_fetch",

"indices": [

".ml-anomalies-*"

],

"types": [],

"body": {

"sort": [

{

"timestamp": {

"order": "asc"

}

}

],

"query": {

"bool": {

"must": [

{

"match": {

"result_type": "record"

}

},

{

"match": {

"job_id": "{{ctx.metadata.job_id}}"

}

},

{

"range": {

"record_score": {

"gt": "{{ctx.metadata.threshold}}"

}

}

},

{

"range": {

"timestamp": {

"from": "now-{{ctx.metadata.detect_interval}}-{{ctx.metadata.ml_process_time}}",

"to": "now-{{ctx.metadata.ml_process_time}}"

}

}

}

]

}

}

}

}

}

},

"condition": {

"compare": {

"ctx.payload.hits.total": {

"gt": 0

}

}

},

"actions": {

"notify_slack": {

"transform": {

"script": {

"id": "create_partition_notify_for_slack"

}

},

"slack": {

"message": {

"to": [

"#elastic-notify"

],

"text": "Elasticsearch ML Anomaly Detection",

"attachments": [

{

"color": "{{ctx.payload.severityColor}}",

"title": "{{ctx.payload.severity}}",

"text": "{{ctx.payload.message}}"

}

]

}

}

}

},

"metadata": {

"quate": "'",

"link_dashboards": [

{

"id": "AWAAR4Z1hIAnOgqnarfW",

"title": "Performance-Monitoring-Timeseries-hcperf"

}

],

"subject": "Webサイトの性能が改善しました。",

"kibana_display_term": 28800,

"detect_interval": "7d",

"description": "Webサイトの性能が改善した際に通知します。",

"threshold": 75,

"locale": "Asia/Tokyo",

"kibana_url": "http://localhost:15601/",

"alert_type": "mla",

"ml_process_time": "28924s",

"double_quate": "\"",

"job_id": "improve-perf",

"compareOption": {

"compareType": "gte",

"operator": "≧"

},

"filterByActualValue": false,

"date_format": "yyyy/MM/dd HH:mm:ss",

"link_saved_searches": [

{

"id": "53f0e7c0-ead5-11e7-b520-6b73813f8f5b",

"title": "Performance-Result-Summary"

}

],

"actualValueThreshold": 0.5

}

}

長い・・・。

これを作成、管理するのはかなり大変です。

そこでこのような設定追加をUIのみでできるようにしたのが、es-ml-alert-pluginです!

es-ml-alert-pluginの使い方

インストール

以下からお使いのElasticsearchのVersionに合う媒体をdownloadしてインストールします。

sudo bin/kibana-plugin install file://<path to plugin>/es_ml_alert-x.x.x_y.y.y.zip

.\bin\kibana-plugin install file://<path to plugin>/es_ml_alert-x.x.x_y.y.y.zip

ML用アラート通知の設定

インストール後にKibanaを起動すると、メニューに「Ml Alert」と表示されます。

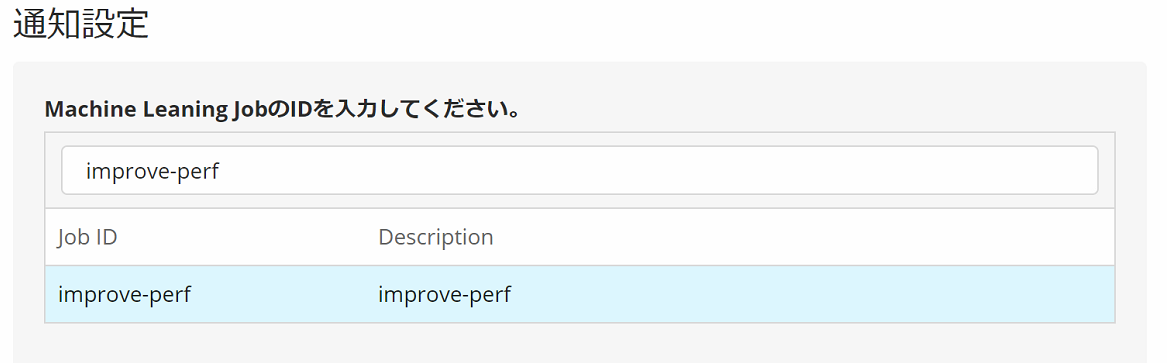

「Ml Alert」を選択すると、設定画面が表示されます。アラート通知したいX-Pack MLのJobを選択してください。

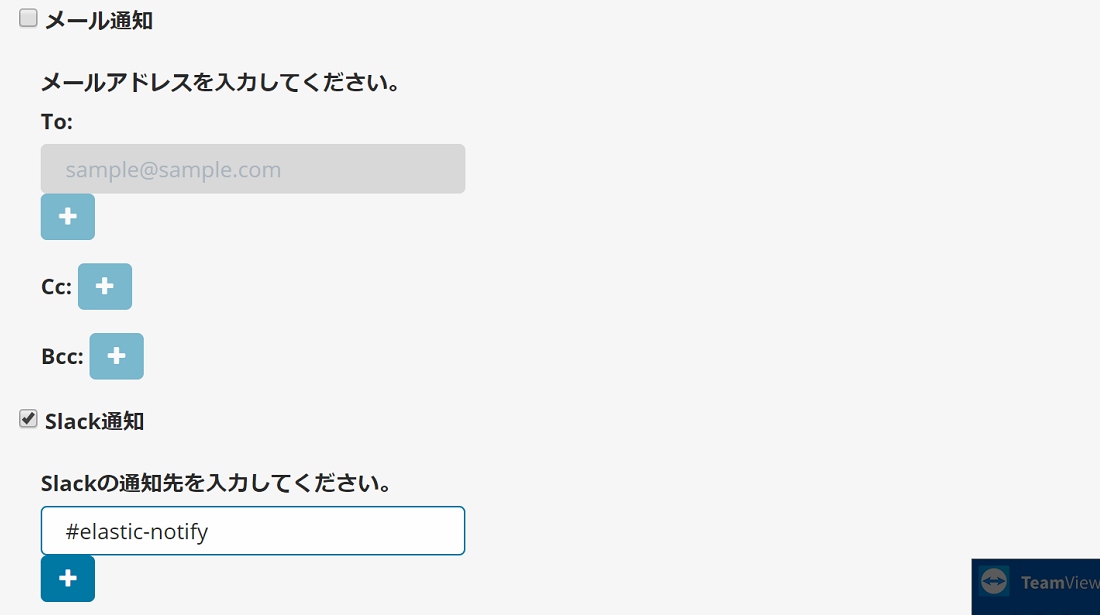

次は、通知先の設定です。

(※あらかじめelasticsearch.ymlに通知を飛ばすためのアカウント設定を実施しておく必要があります。)

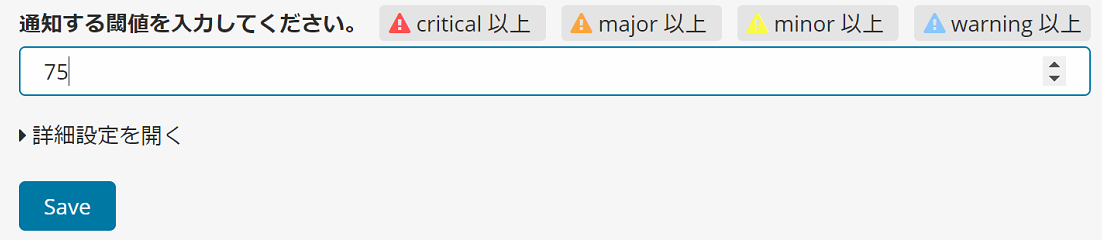

最後に通知条件を設定します。

こちらの図ではCriticalな異常のみ検知するように設定しています。

保存ボタンを押下すれば完了です!これでリアルタイムに検知した異常値に対し、指定した方法でアラートが飛びます。

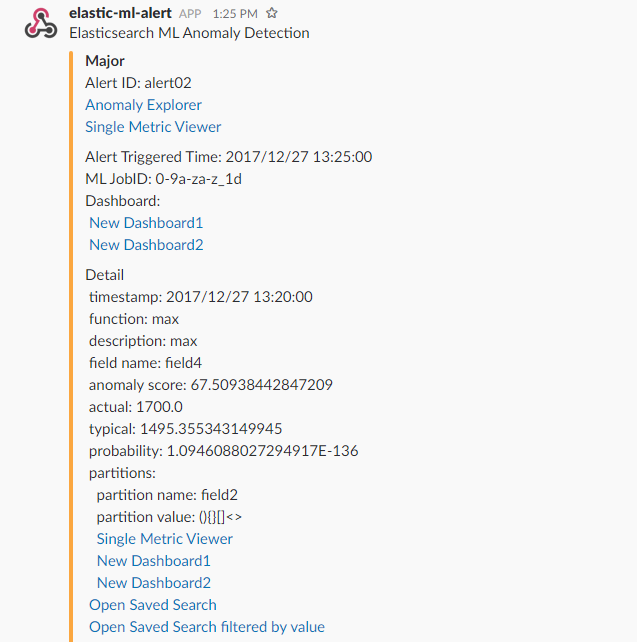

以下はSlackで通知したときのサンプルです。

リアルタイムにML jobへのリンクも含んだSlack通知が飛ぶようになります。

この通知には、「Anomaly Explorer」や「Single Metric Viewer」へのリンクも自動で追加します。

リンクを押下すると検知した異常値に絞り込んだ画面を表示できます。

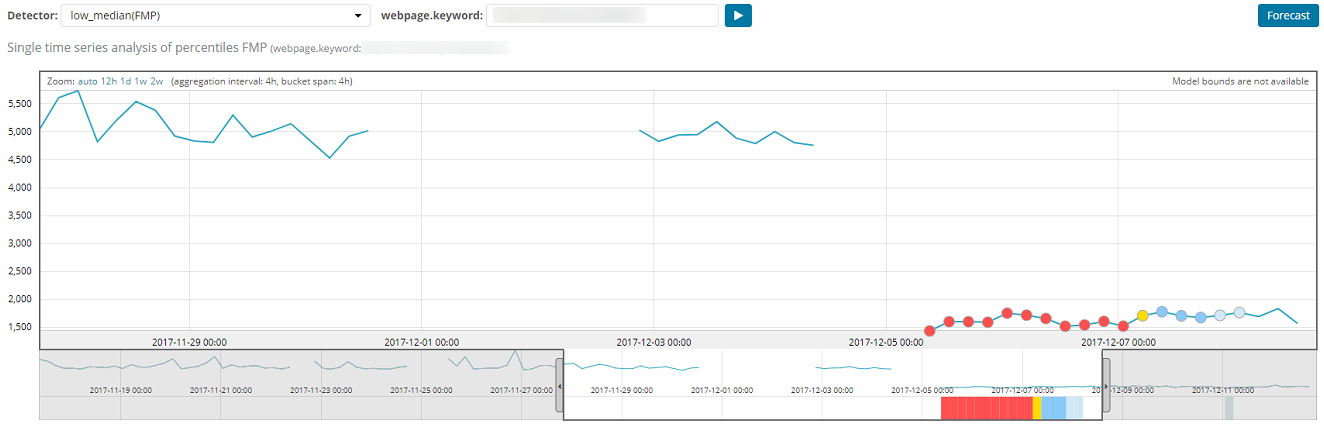

こちらは、Slack通知のリンクから遷移した「Single Metric Viewer」の例です。

異常値を検知した系列にのみ絞り込んで表示しています。

このようにWatcher用のjson定義を自分で書くことなく、UIで設定するだけでWatcherによるリアルタイムアラート通知を実現することができました。

便利なオプションを追加で設定

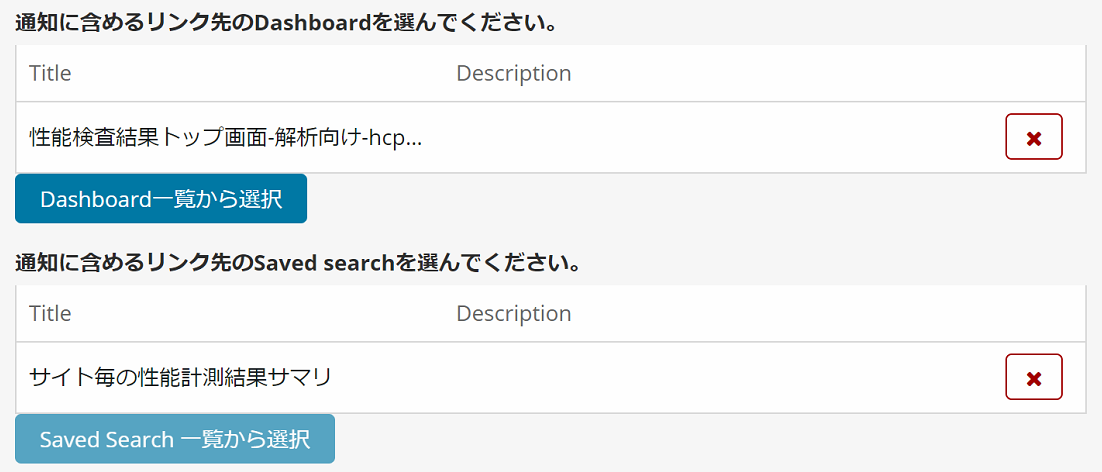

通知内容にDashboardやSaved Searchのリンクを追加する。

Slackに通知する際に、通知内容に異常を検知したJobへのリンクや、関連した値を可視化したDashboardへのリンクを含めると、通知から解析の流れがスムーズにできます。

そこで、設定画面の下部に注目してください。

リンクしたいDashboardやSaved Search設定を追加できるボタンがあります。

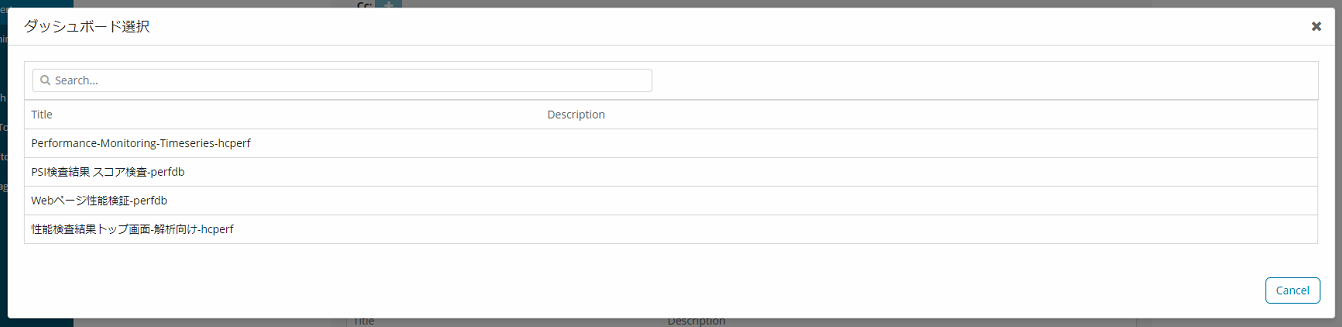

「Dashboard一覧から選択」ボタン押下時の画面です。リンクしたいDashboardを選択します。

これで、Slackやメール通知内容に、追加したDashboardやSaved Searchへのリンクが入ります。

ちなみにSplit DataをJob設定で追加している場合は、異常検知した際の条件値で、DashboardやSaved Search画面を絞り込んだ状態で開きます。

異常が起きている値、期間にのみ絞った画面表示とすることで、解析を効率化できます。

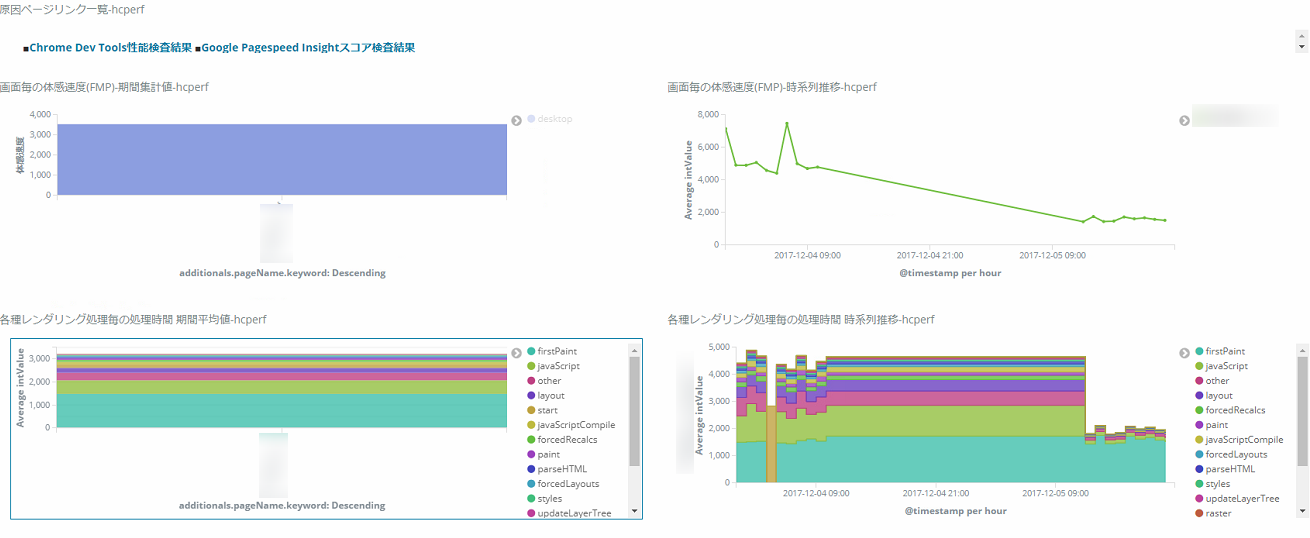

以下は異常値検知したWebページに絞り込んだDashboardをクリックした場合の画面表示です。

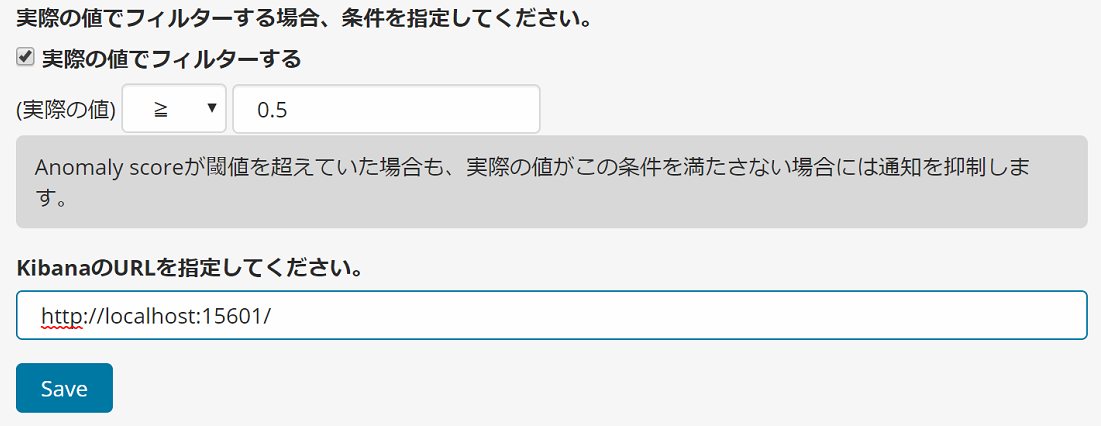

異常検知スコアだけでなく、実際の測定値も通知条件に含める。

X-Pack MLの出力するSeverity(Anomaly Score)は実際の値の大小に関係がなく、通常の値からどれくらいの変動があったかで評価が決まります。

例えばWebパフォーマンス計測結果が0.1秒から0.2秒に変わったことも、1秒が2秒に変わったこともどちらも2倍ということで、同じ異常値となってしまいます。

前者はネットワーク遅延などにより頻繁に発生するので、コンテンツの問題で発生する後者が埋もれてしまいます。

このような場合、アラート時に異常検知スコアだけでなく、計測結果が0.5秒以上といったように、実値による条件も一緒に設定することで、見なくてよい検知結果の通知を出さないようにすることができます。

しかし、Kibanaのジョブ設定ではSeverity(Anomaly Score)でしか判定できません。

そこでプラグインで対応しました。

設定画面の「詳細設定」を選択すると、「実際の値でフィルターする場合」の設定があるので、こちらに閾値としたい値を入れます。

これで、異常検知スコアが高いかつ、実値が0.5以上の場合にのみ、通知が飛ぶようになります。

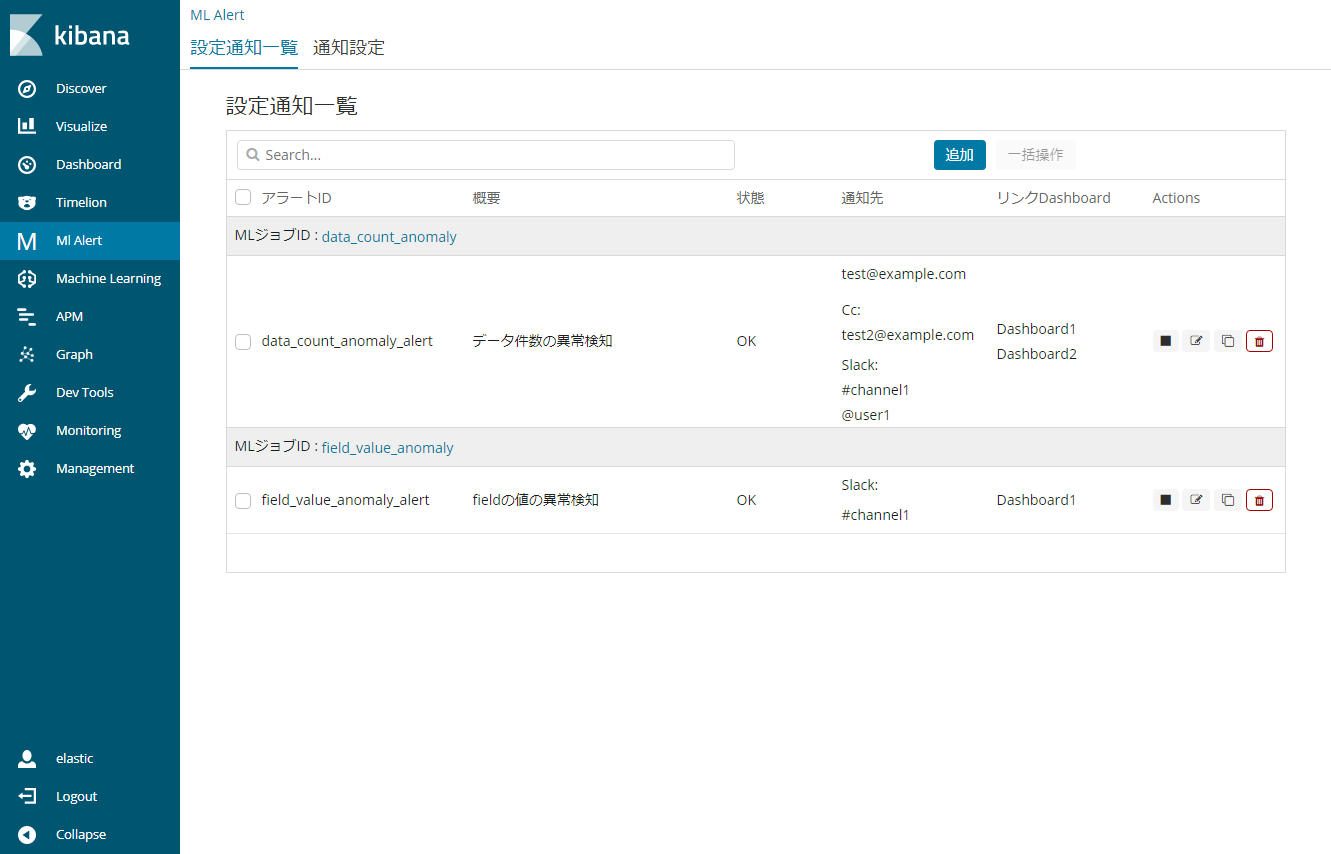

管理機能の利用

作成したアラート通知を管理するにあたって、以下のような設定変更がしたくなることがあります。

- どのJobに対して作成した通知か確認したい。

- 可視化Dashboardを追加したので、通知先に追加したい。

- 新しくProjectのメンバが入ってきたのでアラート通知先に追加したい。

このような運用時に必要となる機能も追加しています。

一覧機能

このように、どのML jobに対してアラートを作ったかを確認しながら管理ができます。

Watcher用の管理画面では、このようなカテゴリごとの表示ができないので、管理時に便利です。

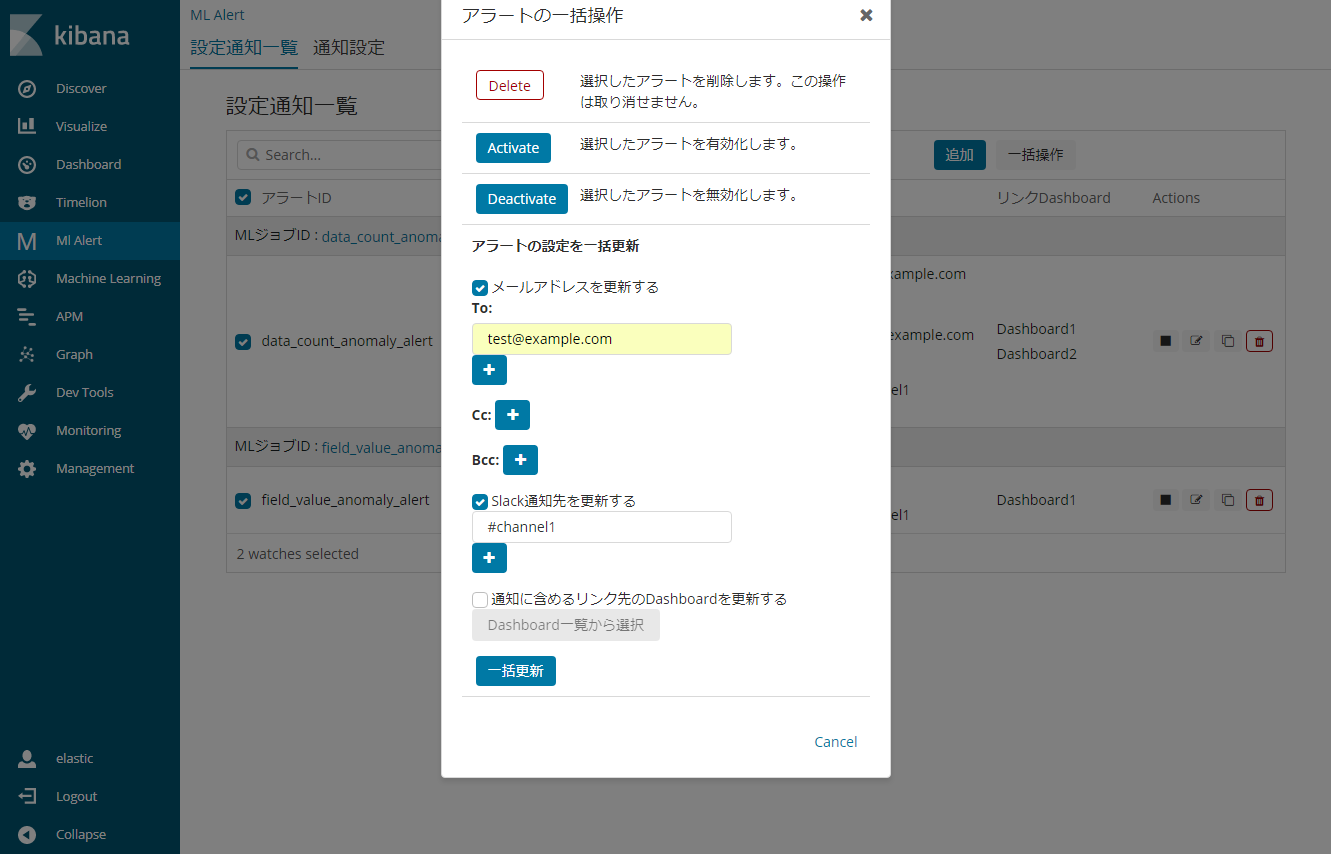

一括編集機能

複数のアラート通知に対し、まとめて編集や、Activate Deactivateなどを実施することができます。

可視化Dashboardを追加した後には、関係するアラート通知にまとめてリンク先に追加する必要があります。

一括編集を使えば選択したアラート通知にまとめてリンク先の追加ができるのでラクチンです。

アラート通知先も同じようにまとめて追加できます。

今後の改善予定

通知先がSlackとメールだけの対応となっているので、LINE連携や、その他のプラットフォームとの連携ができるように改善したいと思っています。

また先日Elstic{on} Tokyoにて、X-Pack MLチームリーダのSophie Changさんに見せたところ、

「いいね」もらったので、英語対応したいと思っています。

こんな機能あったらほしいというものがあれば、githubのissueを上げてもらえるとうれしいです。

最後に

最後までお読みいただきありがとうございました。

X-Pack MLを使っているけど、アラート通知設定が大変と思っている人たちの助けになるようなプラグイン提供できるように、これからも改善していこうと思っています。

今年のブログ投稿もこれで最後かな。

では、みなさん、よいお年を!