備忘録的にDifyとAzure OpenAIの連携メモです。

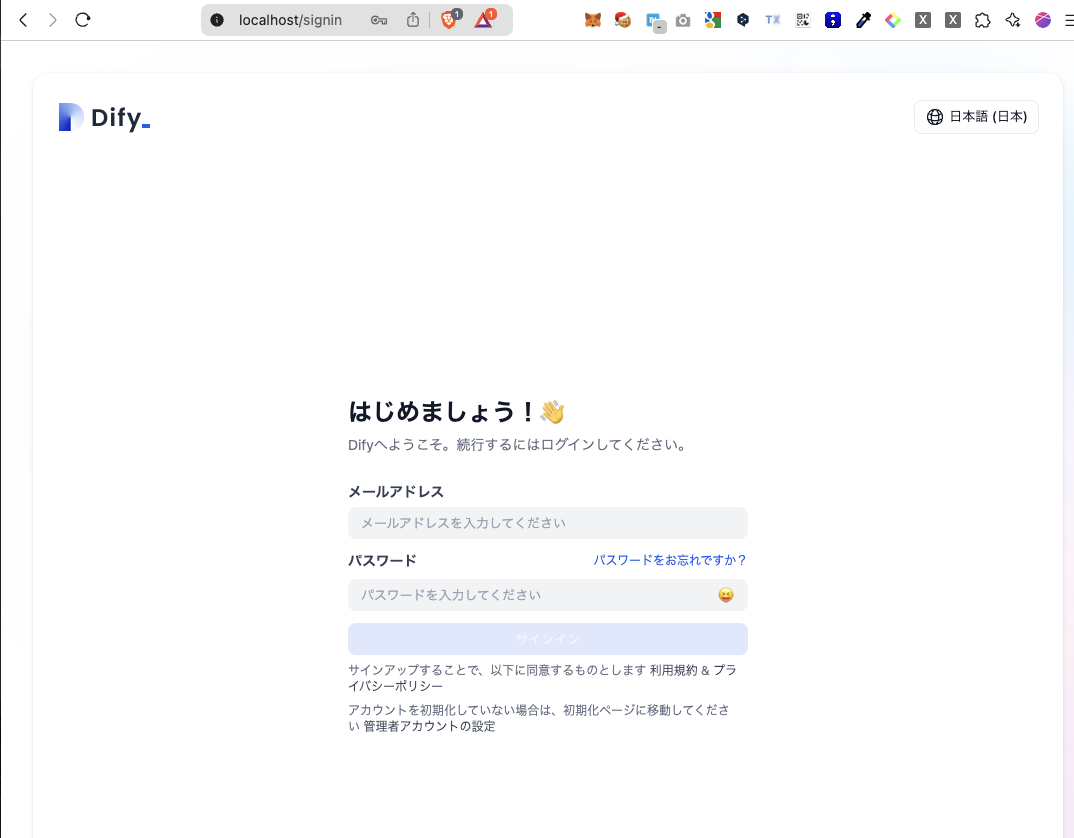

ローカルでDifyを試すまで

MacにDockerを入れてdocker-composeで起動

こちらのリポジトリからcloneしてくる

dockerフォルダがあるのでその中でdocker compose up -d

$ cd docker

$ docker compose up -d

これでローカル起動はOK

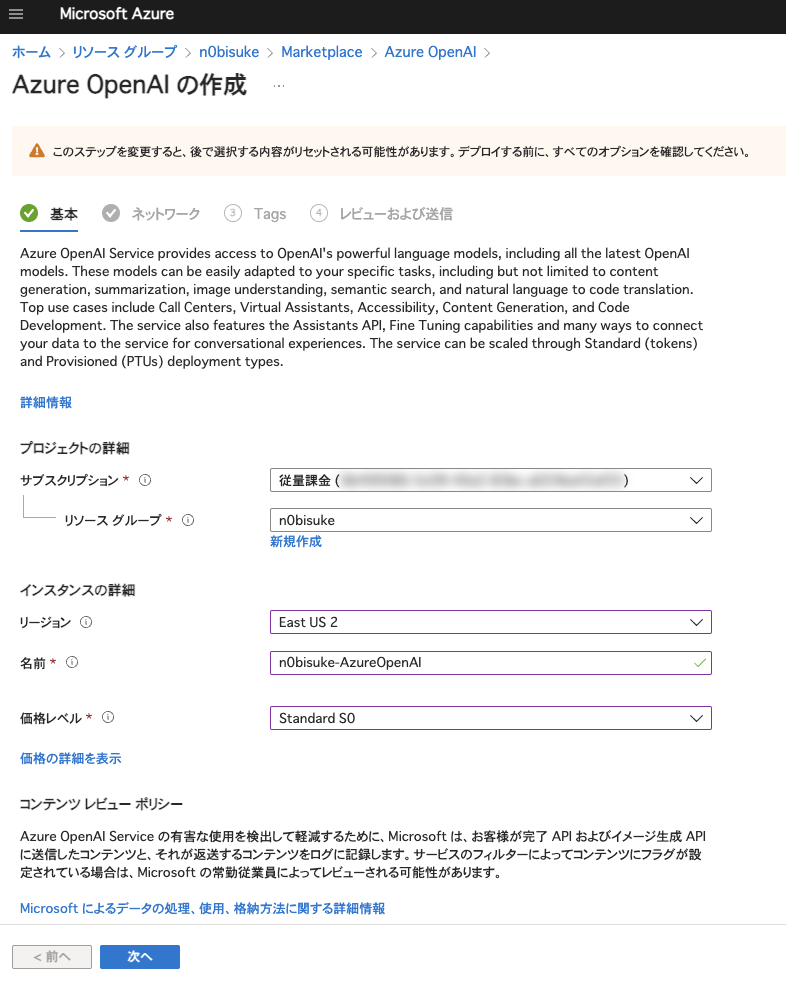

Azure OpenAIでモデル準備

Azureのポータルで作成

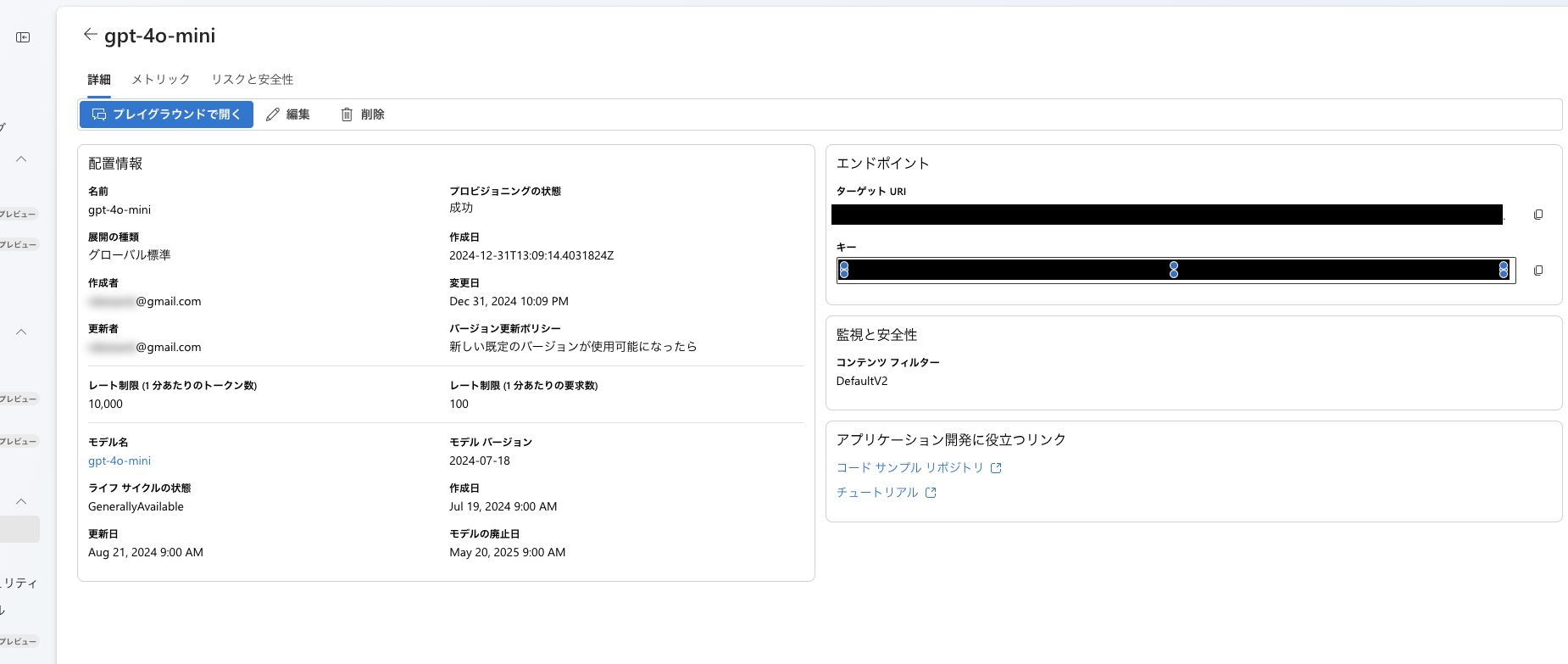

- モデルを作成してデプロイ gpt-4o-miniを指定してみました。

APIキー とエンドポイントURL が表示されるのでそれを控えておく

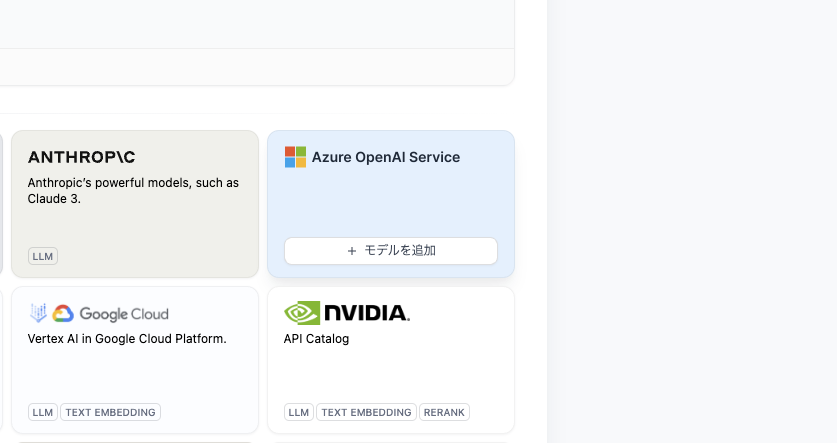

Dify側で設定

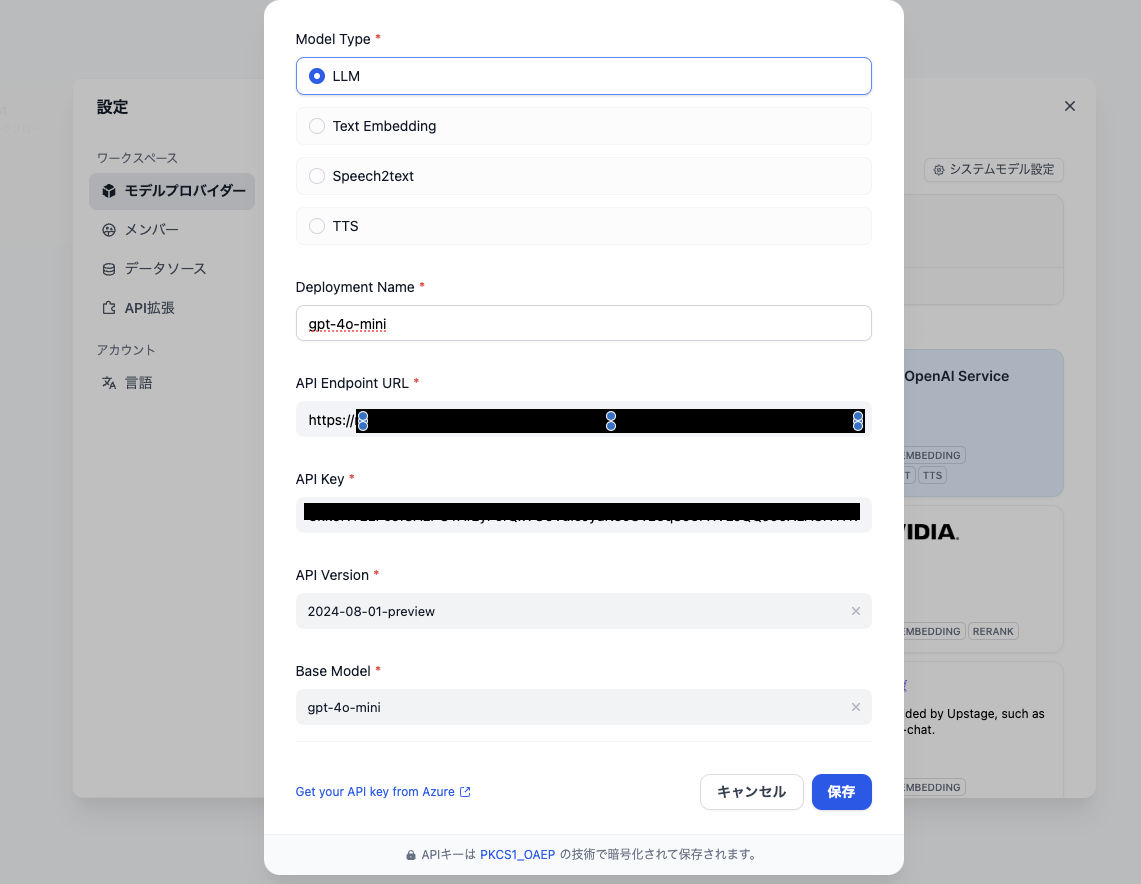

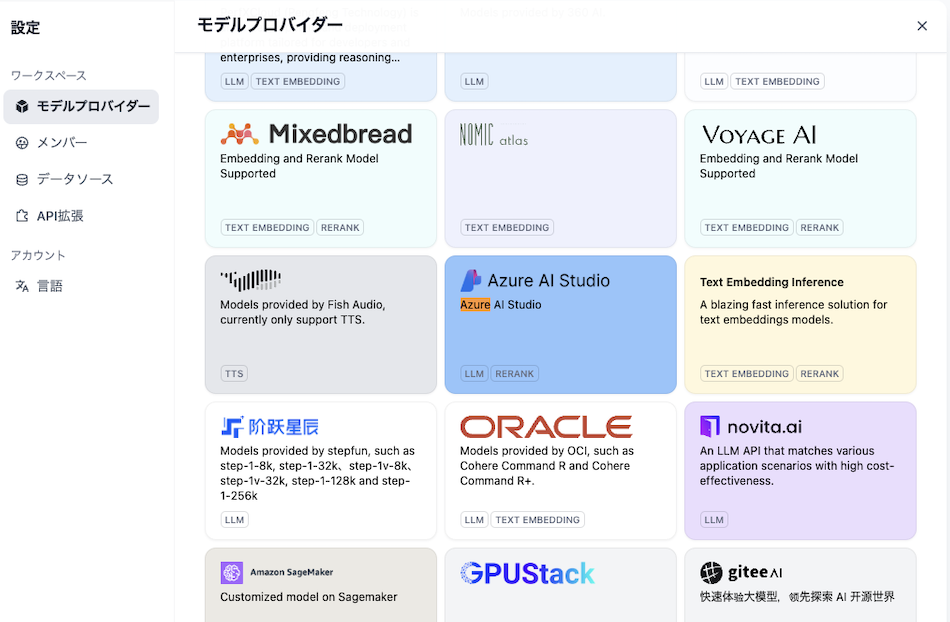

Difyの画面から、設定 -> モデルプロバイダーからモデルを追加。

Azure OpenAI Serviceを見つけて追加します。

API VersionはデプロイしたときのURLに書いてあります。?api-version=2024-08-01-previewなどがURLについてます。

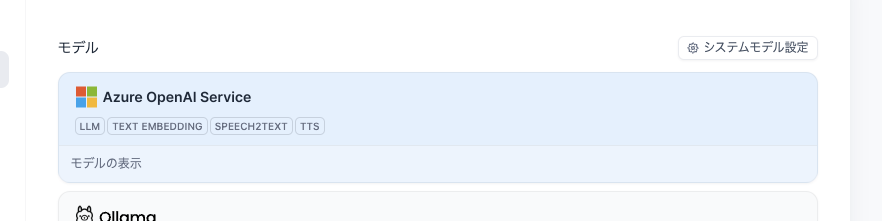

無事に追加できるとモデル一覧に表示されます。

Difyのワークフローで使う

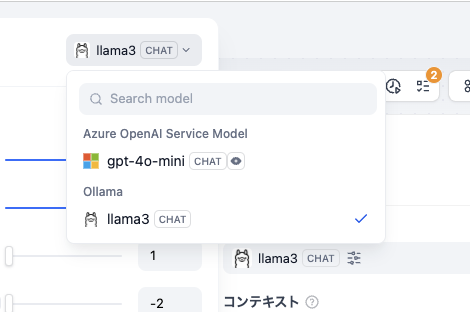

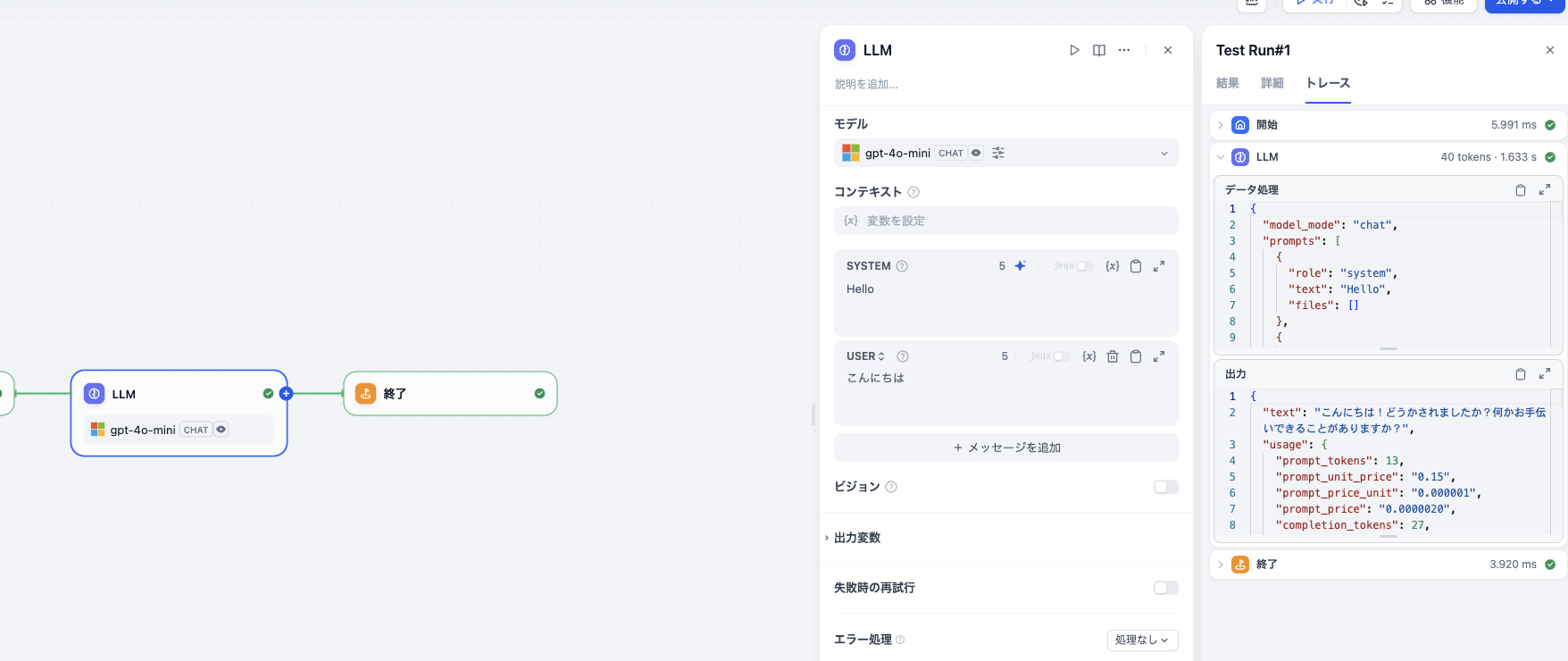

追加が無事にできるとワークフローではLLMモジュールで利用できます。

あとは通常Difyを使う感じでLLMモジュールとして利用できます。

まとめ

ローカルDifyとAzure OpenAIを接続できました。Azureのクレジット+ローカルDifyでやる人には良さそう。

蛇足

ちなみにAzure AI StudioのモデルプロバイダーではAPIキーとエンドポイントなど入れてもエラーがでたので何かがちがうっぽい...?

関係ないけどAzure Web AppsのコンテナデプロイでDify使いたいけど上手くいかない...

この辺試した方いたら教えてくれるとうれしいです。